Você está ansioso para explorar as capacidades dos modelos de linguagem avançados da Meta, como o Llama, sem gastar um centavo? Neste guia detalhado, vamos apresentar dois métodos práticos para usar a API do Llama gratuitamente: aproveitando o OpenRouter e o Together AI.

O Que É a API do Llama?

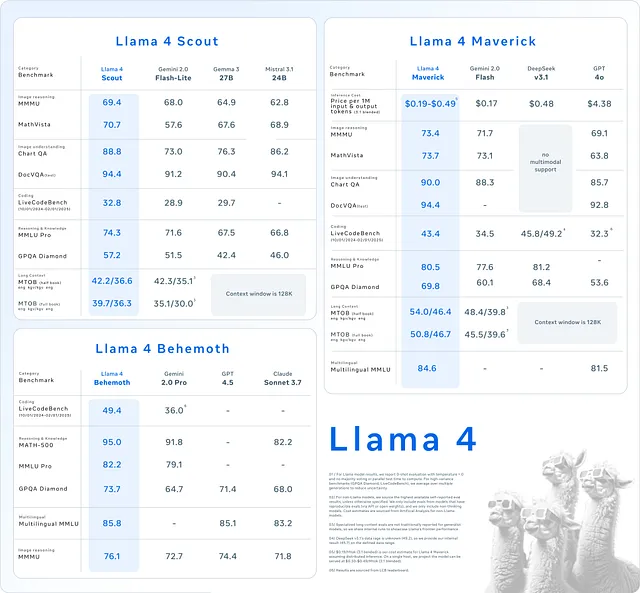

A API do Llama fornece acesso à família de modelos de linguagem da Meta, incluindo Llama 3 e Llama 4. Esses modelos se destacam em tarefas como geração de texto, compreensão contextual e até mesmo aplicações multimodais envolvendo imagens. Desenvolvedores usam a API do Llama para impulsionar aplicações que vão desde chatbots até ferramentas de geração de conteúdo, tudo sem a necessidade de treinar modelos do zero.

Embora esses modelos sejam impressionantes, acessá-los geralmente envolve custos — a menos que você saiba onde procurar. Felizmente, plataformas como OpenRouter e Together AI oferecem acesso gratuito a certos modelos Llama. Neste guia, abordaremos ambos os métodos, completos com instruções passo a passo e exemplos de código para você começar.

Por Que Escolher a API do Llama?

Antes de mergulharmos nos métodos, vamos considerar por que a API do Llama se destaca. Primeiro, ela oferece processamento de linguagem de ponta, permitindo que as aplicações produzam texto coerente e semelhante ao humano. Em seguida, versões mais recentes como o Llama 4 introduzem recursos multimodais, permitindo que o modelo lide tanto com texto quanto com imagens — uma virada de jogo para projetos inovadores. Finalmente, usar a API economiza tempo e recursos em comparação com a construção de modelos personalizados.

Com isso em mente, vamos explorar como acessar a API do Llama gratuitamente.

Método 1: Usando o OpenRouter para Acessar a API do Llama Gratuitamente

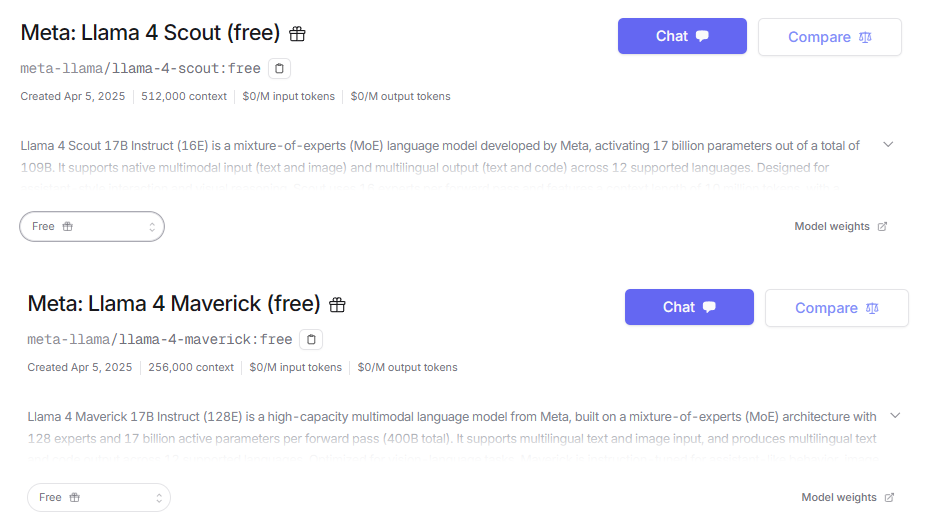

O OpenRouter serve como uma plataforma de API unificada, concedendo acesso a mais de 300 modelos de IA, incluindo a série Llama da Meta. O melhor de tudo, ele oferece um nível gratuito que inclui modelos como Llama 4 Maverick e Llama 4 Scout. Isso torna o OpenRouter um ponto de partida ideal para desenvolvedores que buscam acesso gratuito à IA de ponta.

Passo 1: Cadastre-se e Obtenha uma Chave de API

Para começar, você precisa de uma conta OpenRouter e uma chave de API. Siga estes passos:

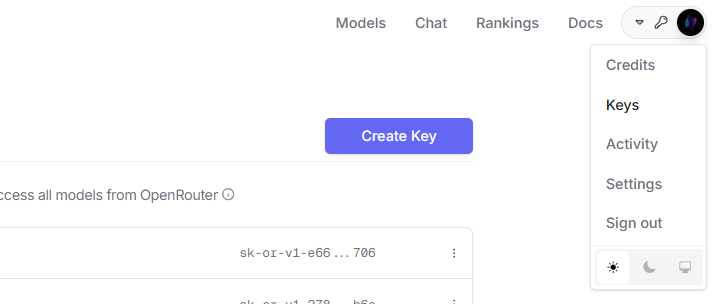

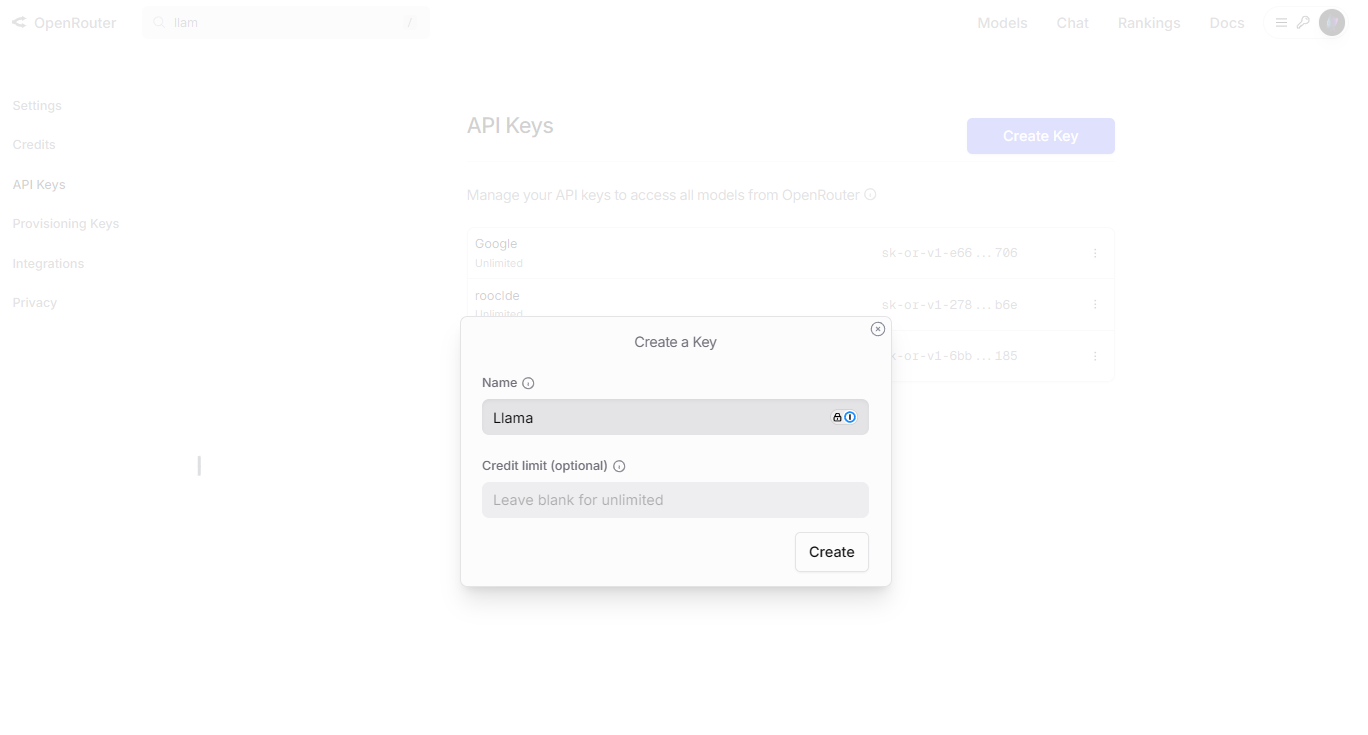

Navegue até o site do OpenRouter e clique em "Sign Up" (Cadastrar). Faça login e, em seguida, vá para a seção "API Keys" (Chaves de API) no seu painel.

Clique em "Create Key" (Criar Chave), nomeie-a (por exemplo, "Chave Gratuita Llama") e copie a chave com segurança.

Passo 2: Configure Seu Ambiente

Você precisará de uma linguagem de programação e uma biblioteca cliente HTTP para interagir com a API. Usaremos Python com a biblioteca requests. Instale-a se ainda não o fez:

pip install requests

Passo 3: Envie Sua Primeira Requisição

Agora, vamos escrever um script Python para gerar texto usando o modelo Llama 4 Scout via OpenRouter:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://openrouter.ai/api/v1/chat/completions"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "meta-llama/llama-4-scout:free",

"messages": [

{"role": "user", "content": "Describe the Llama API in one sentence."}

],

"max_tokens": 50

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["choices"][0]["message"]["content"])

else:

print(f"Error: Request failed with status {response.status_code}")

Este script envia um prompt para o modelo Llama 4 Scout e imprime a resposta. Ajuste max_tokens para controlar o comprimento da saída.

Passo 4: Experimente Recursos

O OpenRouter suporta personalização. Por exemplo, ajuste o parâmetro temperature para modificar a criatividade da resposta, ou explore as capacidades multimodais com modelos como Llama 4 Maverick. Verifique a página de modelos do OpenRouter para detalhes sobre as opções disponíveis.

Método 2: Usando o Together AI para Acessar a API do Llama Gratuitamente

O Together AI é outra plataforma que hospeda modelos Llama, oferecendo acesso gratuito a modelos Llama 3 como o Llama 3.2 11B. No entanto, note que o Llama 4 não é gratuito no Together AI no momento — apenas planos pagos o desbloqueiam. Se o Llama 3 atende às suas necessidades, este método funciona bem.

Passo 1: Registre-se e Obtenha uma Chave de API

Comece configurando uma conta Together AI:

Visite o site do Together AI e vá para a seção "API Keys" (Chaves de API) e gere uma nova chave.

Salve a chave com segurança para usar em suas requisições.

Passo 2: Prepare Seu Ambiente

Assim como no OpenRouter, usaremos Python e requests. Instale-o se necessário:

pip install requests

Passo 3: Faça Uma Chamada de API

Aqui está um script Python para gerar texto com o modelo Llama 3 no Together AI:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://api.together.xyz/inference"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "llama-3-2-11b-free",

"prompt": "What does the Llama API do?",

"max_tokens": 50,

"temperature": 0.7

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["output"]["text"])

else:

print(f"Error: Request failed with status {response.status_code}")

Este script consulta o modelo Llama 3 e exibe a saída. A configuração temperature equilibra criatividade e coerência.

Passo 4: Conheça os Limites

O nível gratuito do Together AI tem restrições, como limites de taxa e sem acesso ao Llama 4. Revise a página de modelos do Together AI para entender o que está disponível e planejar de acordo.

Otimizando Sua Experiência com a API do Llama

Para maximizar seu sucesso com a API do Llama, adote estas práticas:

- Crie Prompts Precisos: Prompts claros produzem melhores resultados. Teste variações para refinar as saídas.

- Monitore o Uso: Acompanhe suas chamadas de API via painéis do OpenRouter ou Together AI para permanecer dentro dos limites do nível gratuito.

- Gerencie Erros: Adicione blocos try-except em seu código para lidar com falhas de forma elegante.

- Cacheie Respostas: Armazene resultados de consultas frequentes para reduzir o uso da API e acelerar sua aplicação.

Esses passos garantem eficiência e confiabilidade em seus projetos.

Solução de Problemas Comuns

Problemas podem surgir ao usar a API do Llama. Veja como corrigi-los:

- 401 Unauthorized: Verifique se sua chave de API está correta e incluída nos cabeçalhos.

- 429 Too Many Requests: Você atingiu o limite de taxa — espere ou atualize seu plano.

- Invalid Model: Confirme se o nome do modelo corresponde à documentação do provedor.

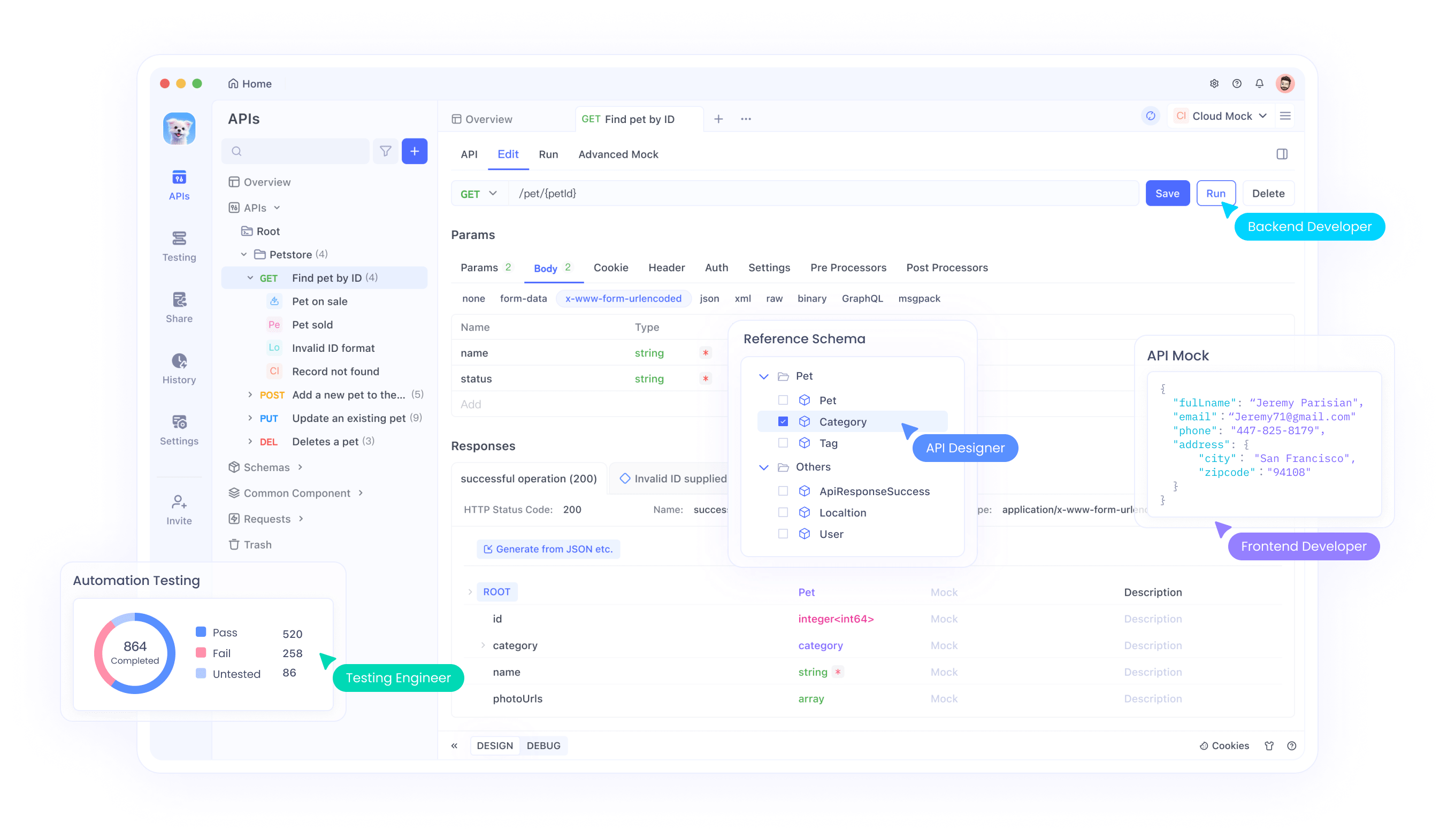

- Bad Payload: Verifique sua sintaxe JSON. Ferramentas como o Apidog podem ajudar a depurar isso.

Falando em ferramentas, baixe o Apidog gratuitamente para simplificar o teste e a solução de problemas de suas chamadas de API — é indispensável para desenvolvedores.

Comparando OpenRouter e Together AI

Ambas as plataformas oferecem acesso gratuito, mas diferem:

- Disponibilidade de Modelos: O OpenRouter inclui o Llama 4 gratuitamente; o Together AI limita o acesso gratuito ao Llama 3.

- Facilidade de Uso: Ambas fornecem APIs diretas, mas a seleção mais ampla de modelos do OpenRouter se destaca.

- Escalabilidade: O Together AI pode direcionar para planos pagos para recursos avançados, enquanto o nível gratuito do OpenRouter é mais generoso.

Escolha com base nas necessidades do seu projeto — o acesso ao Llama 4 inclina para o OpenRouter, enquanto o Together AI é adequado para usuários do Llama 3.

Casos de Uso para a API do Llama

A API do Llama brilha em vários cenários:

- Chatbots: Construa agentes conversacionais com respostas naturais.

- Criação de Conteúdo: Gere artigos, resumos ou legendas.

- Aplicativos Multimodais: Combine processamento de texto e imagem com Llama 4 (via OpenRouter).

Essas aplicações demonstram a versatilidade da API, todas alcançáveis gratuitamente com a configuração certa.

Conclusão

Neste guia, demonstramos como usar a API do Llama gratuitamente através do OpenRouter e do Together AI. O OpenRouter concede acesso a modelos Llama 4, enquanto o Together AI oferece o Llama 3 em seu nível gratuito. Com instruções detalhadas e trechos de código, você agora está equipado para integrar esses modelos em seus projetos. Comece a experimentar hoje, e não se esqueça de aproveitar ferramentas como o Apidog para aprimorar seu fluxo de trabalho. O poder do Llama é seu — use-o com sabedoria!