A ascensão dos modelos de linguagem grandes de código aberto (LLMs) facilitou mais do que nunca a criação de ferramentas impulsionadas por IA que rivalizam com soluções proprietárias como o ChatGPT Operator da OpenAI. Entre esses modelos de código aberto, DeepSeek R1 se destaca por suas robustas capacidades de raciocínio, acessibilidade gratuita e adaptabilidade. Ao combinar o DeepSeek R1 com ferramentas como Browser Use, você pode construir uma poderosa alternativa totalmente de código aberto ao ChatGPT Operator sem gastar centenas de dólares em assinaturas premium.

Este artigo o guiará pelo processo de configuração do DeepSeek R1 e do Browser Use para criar um agente de IA capaz de realizar tarefas complexas, incluindo automação na web, raciocínio e interações em linguagem natural. Se você é um iniciante ou um desenvolvedor experiente, este guia passo a passo ajudará você a começar.

O que é o ChatGPT Operator e por que você precisa de uma alternativa de código aberto?

O ChatGPT Operator é um recurso premium oferecido pela OpenAI que permite aos usuários criar agentes de IA avançados capazes de realizar tarefas complexas, como raciocínio, automação na web e resolução de problemas em várias etapas.

O ChatGPT Operator custa $200 por mês, tornando-o menos acessível para indivíduos, pequenas empresas ou organizações com orçamentos limitados.

4. Reservando um voo de ida de Zurique para Viena usando a integração do Booking

— Rowan Cheung (@rowancheung) 23 de janeiro de 2025

Isso exigiu um pouco de idas e vindas, com o ChatGPT Operator me perguntando sobre minha preferência de voo e me fazendo inserir os dados de pagamento pic.twitter.com/XZiqUsQgVh

O ChatGPT Operator estava reservando um bilhete de avião no vídeo acima

Por que você precisa de uma alternativa de código aberto

Embora o ChatGPT Operator seja poderoso, ele possui várias limitações que tornam uma alternativa de código aberto atraente:

- Custo: A taxa de assinatura de $200/mês pode ser proibitiva para muitos usuários.

- Privacidade de Dados: O uso de APIs proprietárias requer o envio de dados para servidores externos, o que pode não estar em conformidade com políticas de privacidade ou requisitos regulatórios.

- Personalização Limitada: Soluções proprietárias costumam restringir o ajuste fino ou as otimizações específicas de tarefas, limitando sua adaptabilidade para casos de uso especializados.

Optando por ferramentas de código aberto como DeepSeek R1 e Browser Use, você pode superar esses desafios e desbloquear vários benefícios:

- Economia de Custos: Tanto o DeepSeek R1 quanto o Browser Use são completamente gratuitos e de código aberto, eliminando taxas de assinatura.

- Controle Total: Hospedar as ferramentas localmente ou em seu próprio servidor garante total privacidade e segurança dos dados.

- Personalizabilidade: Você pode ajustar o modelo para tarefas específicas, integrá-lo com outras ferramentas e modificar o sistema para atender aos seus requisitos únicos.

Uma abordagem de código aberto não só reduz a dependência de plataformas proprietárias, mas também capacita você a construir uma solução adaptada às suas necessidades, mantendo o controle sobre custos e dados.

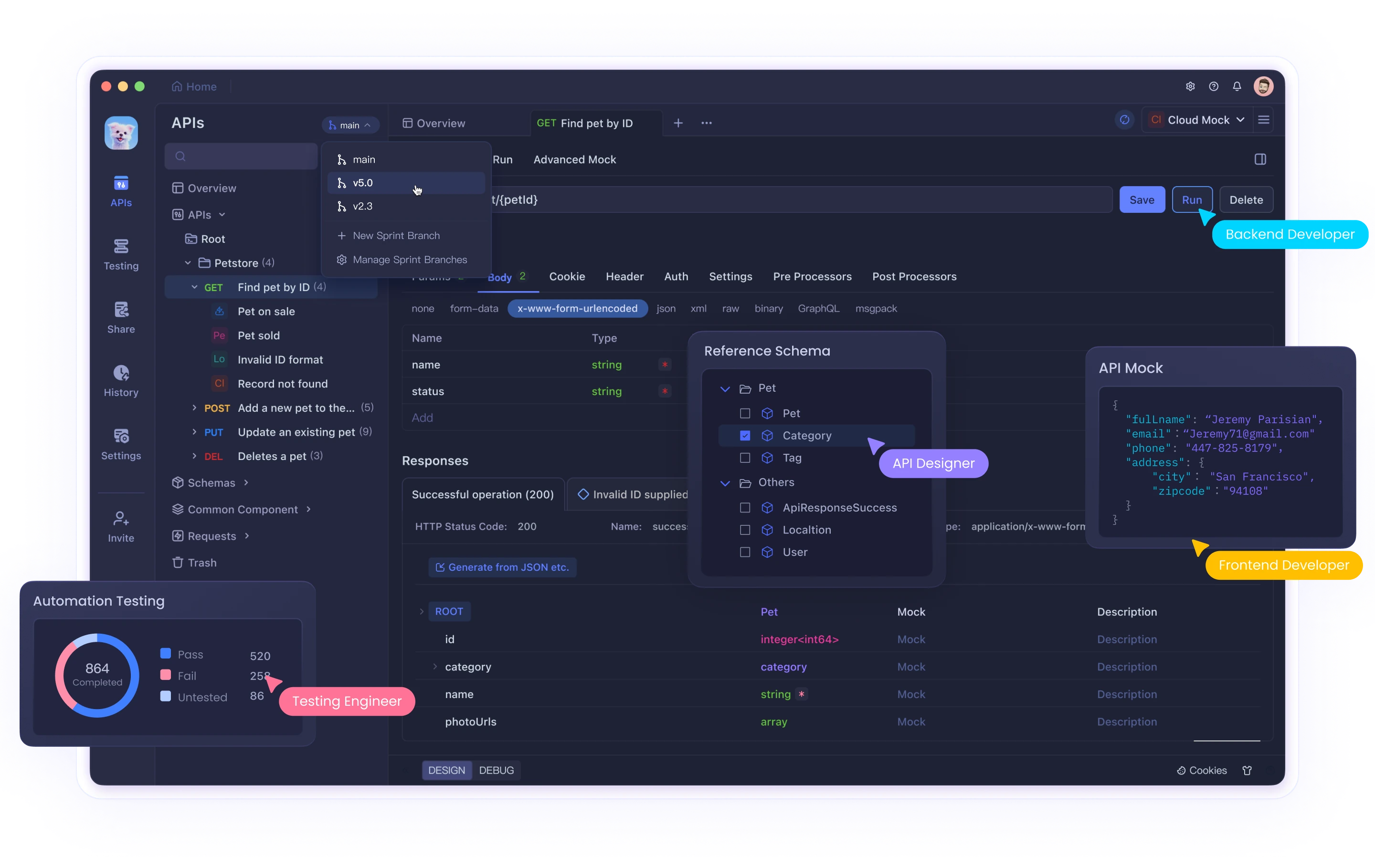

Você precisa dar uma olhada no Apidog, a ferramenta de teste de API tudo-em-um que leva você por todo o processo, desde o design da API até a documentação da API, e turbo carrega a produtividade da sua equipe de desenvolvimento!

Componentes Principais: DeepSeek R1 e Browser Use

DeepSeek R1

DeepSeek R1 é um LLM de código aberto otimizado para tarefas de raciocínio. Ele se destaca na resolução de problemas em cadeia de pensamento, assistência em programação e compreensão de linguagem natural. Está disponível em vários tamanhos (por exemplo, 1,5B, 7B parâmetros), tornando-o adaptável a diferentes capacidades de hardware.

Browser Use

O Browser Use é uma ferramenta de código aberto que permite que agentes de IA realizem tarefas baseadas em navegador, como raspagem de dados, preenchimento de formulários e navegação automatizada. Ele fornece uma interface amigável e pode ser integrado com LLMs como DeepSeek R1 para maior funcionalidade.

Passo 1: Configurando Seu Ambiente

Requisitos de Hardware

- Para versões menores do DeepSeek R1 (por exemplo, 1,5B parâmetros), uma CPU ou GPU de médio porte (8GB VRAM) é suficiente.

- Versões maiores requerem GPUs de alto desempenho (por exemplo, NVIDIA A100 ou RTX 4090).

Sistema Operacional

- Linux ou macOS é recomendado para facilitar a configuração. Usuários do Windows podem usar WSL (Subsistema do Windows para Linux).

Ambiente Python

Crie um ambiente virtual Python para isolar as dependências:

python -m venv venv

source venv/bin/activate # Em Linux/macOS

# Em Windows:

# venv\Scripts\activate

Instale as bibliotecas necessárias:

pip install torch torchvision transformers sentencepiece

Passo 2: Execute o DeepSeek com API ou Localmente com Ollama

Uso da API do DeepSeek

Para interagir com a API do DeepSeek, siga estes passos atualizados:

Obtenha uma Chave de API:

- Registre-se na plataforma DeepSeek e gere uma chave de API na seção "Chaves de API". Salve essa chave com segurança, pois ela não será exibida novamente.

Faça sua Primeira Chamada API:

A API do DeepSeek é compatível com o formato da API da OpenAI, facilitando a integração com SDKs ou softwares existentes da OpenAI. Abaixo está um exemplo de uma implementação em Python:

from openai import OpenAI

client = OpenAI(api_key="<Sua_Chave_API_DeepSeek>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner", # Use 'deepseek-reasoner' para DeepSeek-R1

messages=[

{"role": "system", "content": "Você é um assistente útil."},

{"role": "user", "content": "Explique o entrelaçamento quântico."}

],

stream=False # Defina como True se você quiser respostas em streaming

)

print(response.choices[0].message.content)

Exemplo de cURL:

Se você prefere usar cURL, aqui está como você pode fazer uma solicitação:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <Sua_Chave_API_DeepSeek>" \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "system", "content": "Você é um assistente útil."},

{"role": "user", "content": "Qual é a capital da França?"}

],

"stream": false

}'

Seleção de Modelo:

- Especifique

model="deepseek-reasoner"para o DeepSeek-R1. - Use

model="deepseek-chat"para tarefas de chat de uso geral.

O base_url também pode ser definido como https://api.deepseek.com/v1 para configurações compatíveis com a OpenAI, embora o caminho /v1 não tenha relação com versões de modelo.

Executando DeepSeek Localmente com Ollama

Ollama simplifica a execução de modelos de linguagem grandes como o DeepSeek-R1 na sua máquina local. Veja como configurá-lo e usá-lo corretamente:

Instale o Ollama:

- Baixe e instale o Ollama a partir do seu site oficial.

Baixe o Modelo Desejado:

Use os seguintes comandos para baixar versões específicas do DeepSeek-R1:

# Para o modelo 7B (padrão):

ollama pull deepseek-r1:7b

# Para um modelo menor de 1.5B:

ollama pull deepseek-r1:1.5b

# Para modelos maiores como 70B:

ollama pull deepseek-r1:70b

Execute o Modelo Localmente:

Uma vez baixado, execute o modelo usando:

ollama run deepseek-r1:7b

Isso iniciará uma sessão interativa onde você poderá interagir diretamente com o modelo.

Variantes do Modelo:

O DeepSeek oferece várias versões destiladas com base nas arquiteturas Qwen e Llama, otimizadas para diferentes casos de uso:

DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1:7b-qwen-distill

DeepSeek-R1-Distill-Llama-70B:

ollama run deepseek-r1:70b-llama-distill

Considerações sobre Hardware:

- Modelos menores como 1.5B ou 7B podem ser executados em GPUs de consumo ou até mesmo CPUs.

- Modelos maiores (por exemplo, 70B) requerem GPUs de alto desempenho com VRAM significativa (por exemplo, NVIDIA A100 ou RTX 4090).

Chat Interativo via API:

Ollama fornece uma API para integrar modelos que estão sendo executados localmente em suas aplicações:

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:7b",

"messages": [

{"role": "user", "content": "Escreva um poema curto sobre as estrelas."}

]

}'

Passo 3: Instalando o Browser Use

O Browser Use permite que seu agente de IA interaja com navegadores web. Siga estes passos:

Instalação

Clone o repositório do Browser Use do GitHub:

git clone https://github.com/browser-use/browser-use.git

cd browser-use

pip install -r requirements.txt

Configuração

Configure a WebUI do Browser Use:

python webui.py

Abra a WebUI no seu navegador para configurar as configurações do agente. Você pode especificar:

- O modelo LLM (por exemplo, DeepSeek R1)

- Configurações do navegador (por exemplo, tamanho da janela)

Passo 4: Combinando DeepSeek R1 e Browser Use

Para criar um agente de IA funcional que integre ambas as ferramentas:

Configuração do Agente

Modifique as configurações do agente no Browser Use para conectá-lo ao DeepSeek R1:

{

"model": "deepseek-r1",

"base_url": "http://localhost:5000",

"browser_settings": {

"window_height": 1080,

"window_width": 1920,

"keep_browser_open": true

}

}

Executando o Agente

Inicie tanto o DeepSeek R1 quanto o Browser Use:

# Iniciar servidor API do DeepSeek R1

python -m deepseek.api_server

# Iniciar WebUI do Browser Use

python webui.py

Uma vez que ambos os serviços estejam em execução, o agente pode realizar tarefas como preencher formulários, coletar dados ou navegar em sites de forma autônoma.

Passo 5: Engenharia de Prompt para Melhores Resultados

Para otimizar o desempenho do seu agente de IA, utilize técnicas de engenharia de prompt. Por exemplo:

Modelo Geral de Prompt

<instruções>

Você é um assistente de IA encarregado de automatizar tarefas web usando o Browser Use.

Siga estes passos:

1. Navegue até [site].

2. Realize [tarefa específica].

3. Retorne os resultados em um formato estruturado.

</instruções>

<exemplo>

Navegue até https://example.com e extraia todos os hyperlinks.

</exemplo>

Essa estrutura garante clareza e melhora a precisão na execução das tarefas.

Aqui estão algumas demonstrações que você pode experimentar executando:

uv pip install gradio

python examples/gradio_demo.py

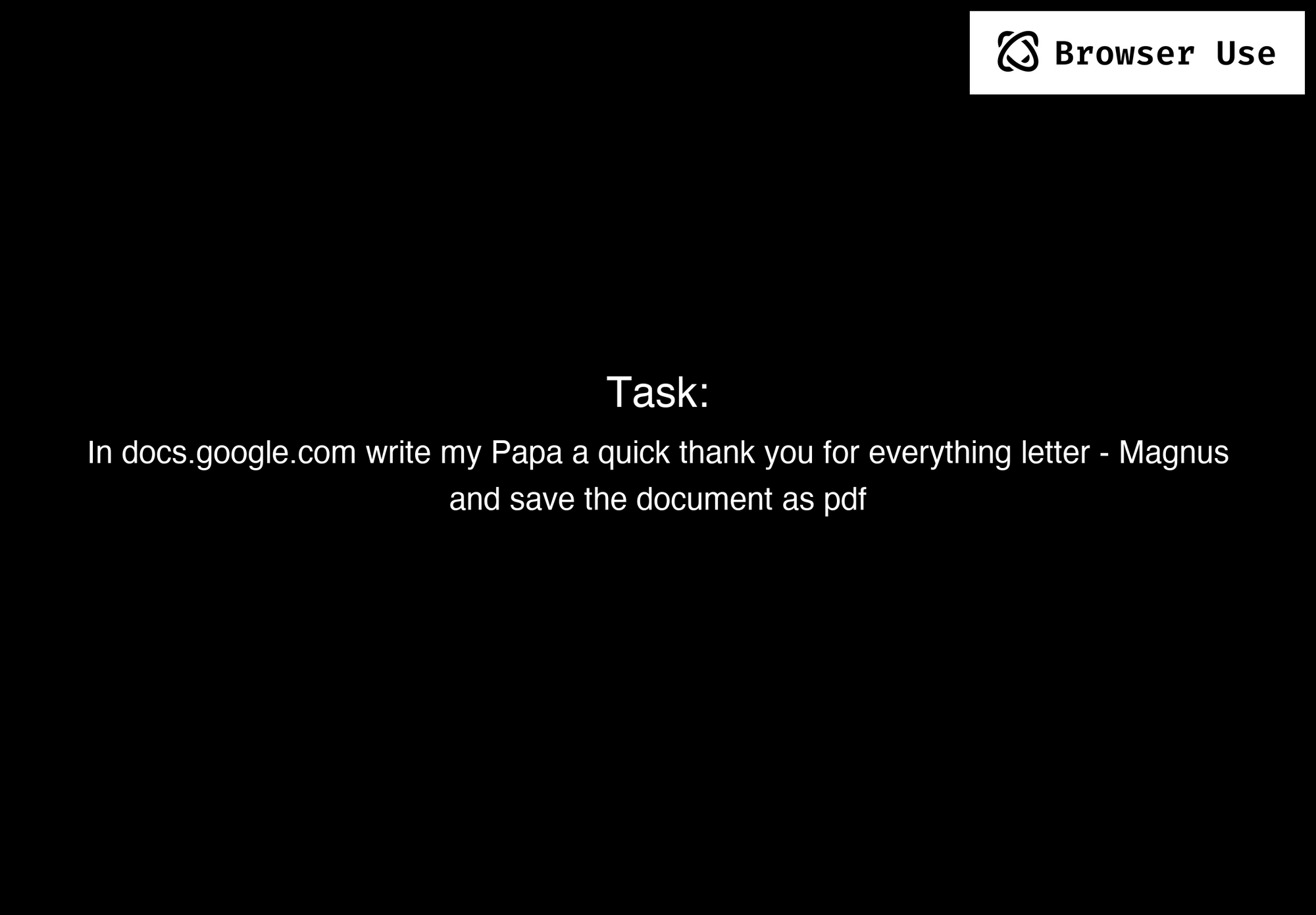

Exemplo 1.

Prompt: Escreva uma carta no Google Docs para meu pai, agradecendo-o por tudo, e salve o documento como um PDF.

Exemplo 2.

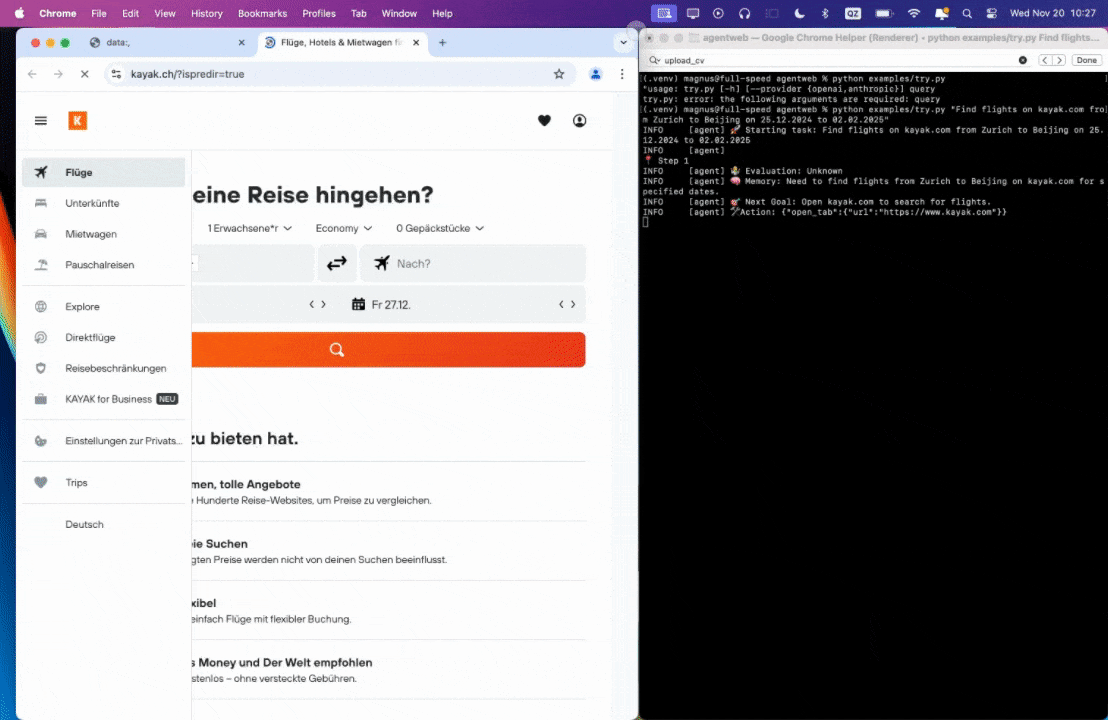

Prompt: Encontre voos no kayak.com de Zurique para Pequim de 25.12.2024 a 02.02.2025.

Exemplo 3.

Prompt: Leia meu CV e encontre vagas de ML, salve-as em um arquivo e depois comece a se candidatar a elas em novas abas, se precisar de ajuda, pergunte-me.

0:00/1×

Conclusão

Ao combinar o DeepSeek R1 com o Browser Use, você pode construir uma alternativa totalmente funcional ao ChatGPT Operator que é gratuita, de código aberto e altamente personalizável. Essa configuração não só economiza custos, mas também dá a você total controle sobre a privacidade dos dados e o comportamento do sistema.

Seja automatizando tarefas na web, construindo agentes conversacionais ou experimentando recursos avançados de IA como Geração Aumentada por Recuperação, este guia fornece tudo o que você precisa para começar. Abrace o poder do código aberto e crie seu próprio assistente inteligente hoje!

Você precisa dar uma olhada no Apidog, a ferramenta de teste de API tudo-em-um que leva você por todo o processo, desde o design da API até a documentação da API, e turbo carrega a produtividade da sua equipe de desenvolvimento!