Introdução

Os Macs com Apple Silicon mudaram o desempenho de modelos de IA locais, oferecendo um poder computacional sem precedentes em hardware de nível consumidor. Com o lançamento do Deepseek V3 0323, um poderoso modelo de linguagem grande (LLM), os usuários de Mac agora podem executar modelos de IA de ponta localmente usando o MLX, o framework de aprendizado de máquina da Apple otimizado especificamente para Apple Silicon. Este guia abrangente orienta você através de todo o processo de configuração e execução do Deepseek V3 0323 em seu Mac, completo com benchmarks de desempenho e comparações com outros modelos líderes, como Claude Sonnet 3.7.

O que é Deepseek V3 0323?

Deepseek V3 0323 faz parte da família de modelos Deepseek V3, uma série de modelos de linguagem grande avançados desenvolvidos pelo laboratório de IA chinês DeepSeek. O modelo representa capacidade de IA de ponta com forte desempenho em várias tarefas de linguagem, geração de código, raciocínio e criação de conteúdo criativo. O "0323" no nome indica sua data de lançamento (23 de março), seguindo a convenção da DeepSeek de incluir datas de lançamento nos nomes dos modelos.

Os últimos modelos da família Deepseek V3 são impressionantemente poderosos e foram lançados sob a licença MIT, tornando-os totalmente de código aberto e disponíveis para uso pessoal e comercial. Isso representa uma mudança significativa em relação às versões anteriores que tinham restrições de licenciamento personalizadas.

Benchmarks e Desempenho do Deepseek V3 0304

A família de modelos Deepseek V3 apresentou resultados impressionantes em benchmarks em várias métricas. Observando especificamente o Deepseek V3 0304 (a versão anterior à 0323), os dados de desempenho mostram que ele iguala ou supera muitas alternativas comerciais.

Resultados-chave de Benchmark

De acordo com testes independentes e as informações de Paul Gauthier, o Deepseek V3 obteve 55% no benchmark polyglot aider, melhorando significativamente em relação às versões anteriores. Isso o posiciona como o modelo #2 não pensante/raciocínio, atrás apenas do Claude Sonnet 3.7.

Em termos de desempenho prático, os modelos Deepseek V3 demonstram:

- Capacidades de raciocínio fortes: Excelente desempenho em problemas complexos que exigem pensamento em várias etapas

- Excelência na geração de código: Particularmente forte em tarefas de programação poliglota

- Seguimento de instruções: Alta adesão a instruções específicas

- Retenção de contexto: Uso eficaz do contexto fornecido para respostas precisas

- Precisão do conhecimento: Informações factuais confiáveis com alucinações mínimas

Deepseek V3 vs Claude 3.7 Sonnet vs Claude 3.7 Sonnet Thinking vs o3-mini

Ao comparar o Deepseek V3 0304 com o Claude Sonnet 3.7:

Embora o Claude Sonnet 3.7 tenha uma leve vantagem em alguns benchmarks, a capacidade do Deepseek V3 de operar localmente em hardware de consumo com MLX representa uma vantagem significativa para usuários que priorizam privacidade, acesso offline e eficiência de custos.

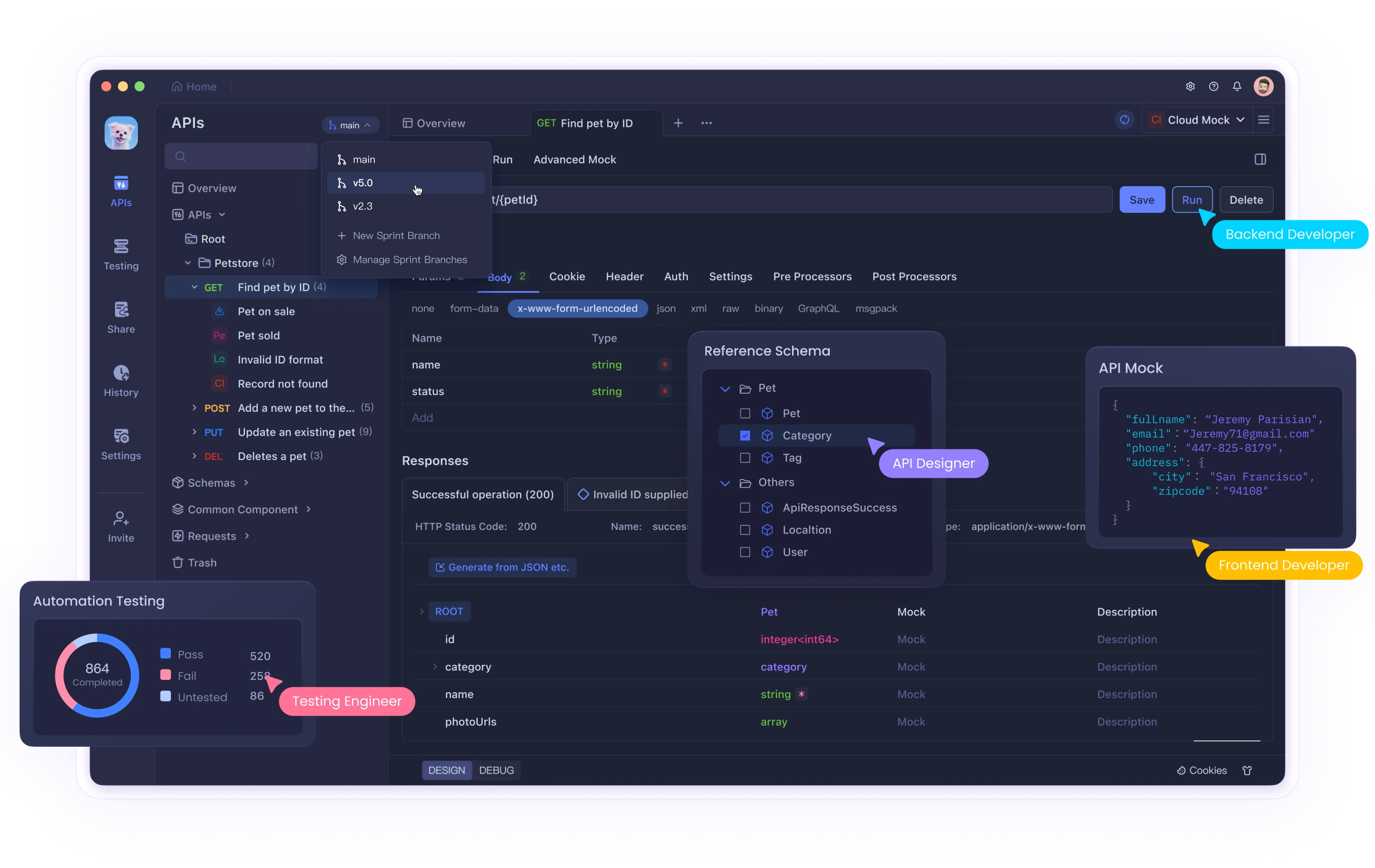

Sim, você pode executar o Deepseek V3 0324 no Mac Studio com MLX

O novo Deep Seek V3 0324 em 4-bits roda a > 20 toks/seg em um M3 Ultra de 512GB com mlx-lm! pic.twitter.com/wFVrFCxGS6

— Awni Hannun (@awnihannun) 24 de março de 2025

Executar o Deepseek V3 em sua máquina local com o MLX oferece várias vantagens importantes:

- Privacidade: Seus dados nunca saem do seu dispositivo, garantindo total privacidade

- Sem custos de API: Evite pagar pelo uso de API e limites de tokens

- Controle total: Personalize configurações e ajuste conforme necessário

- Sem dependência da internet: Use o modelo offline

- Baixa latência: Experimente tempos de resposta mais rápidos, sem atrasos de rede

- Otimização para Apple Silicon: O MLX é projetado especificamente para aproveitar o Neural Engine nos chips da série M

Requisitos de Hardware para Executar o Deepseek V3 0323 Localmente

Antes de começar, verifique se o seu Mac atende a esses requisitos mínimos:

- Mac com Apple Silicon (séries M1, M2, M3 ou M4)

- Mínimo de 16GB de RAM (32GB recomendado)

- Pelo menos 700GB de espaço de armazenamento livre (o modelo completo tem aproximadamente 641GB, embora as versões quantizadas requeiram menos)

Para desempenho ideal ao executar o modelo completo:

- 64GB+ de RAM

- Chips M2 Ultra, M3 Ultra ou M4

O desempenho varia significativamente com base nas especificações do seu Mac. De acordo com o desenvolvedor do MLX, Awni Hannun, o último Deepseek V3 pode rodar a velocidades superiores a 20 tokens por segundo em um Mac Studio M3 Ultra de 512GB usando quantização de 4 bits.

Guia Passo a Passo para Executar o Deepseek V3 0323 Localmente

Passo 1: Configurando Seu Ambiente

Primeiro, vamos configurar um ambiente virtual Python para manter nossas dependências organizadas:

# Crie um novo diretório para seu projeto

mkdir deepseek-mlx

cd deepseek-mlx

# Crie um ambiente virtual

python3 -m venv env

# Ative o ambiente

source env/bin/activate

Passo 2: Instalar Pacotes Necessários

MLX e MLX-LM são os pacotes principais necessários para executar o Deepseek V3 com MLX:

# Instale MLX e MLX-LM

pip install mlx mlx-lm

# Opcional: Instale o PyTorch noturno (suprime avisos)

pip install --pre torch --index-url <https://download.pytorch.org/whl/nightly/cpu>

Passo 3: Instalar a Ferramenta de Linha de Comando LLM

A ferramenta de linha de comando llm simplifica o trabalho com modelos de linguagem. Vamos instalá-la junto com o plugin MLX:

pip install llm

pip install llm-mlx

Passo 4: Baixar o Modelo Deepseek V3 0323

Existem duas abordagens para baixar o modelo:

Opção A: Versão Padrão (Qualidade Completa)

# Baixe o modelo completo (requer espaço em disco significativo)

llm mlx download-model deepseek-ai/DeepSeek-V3-0323

Opção B: Versão Quantizada (Tamanho Menor, Qualidade Ligeiramente Inferior)

# Baixe o modelo quantizado em 4 bits (recomendado para a maioria dos usuários)

llm mlx download-model mlx-community/DeepSeek-V3-0323-4bit

O download levará algum tempo dependendo da velocidade da sua conexão à internet. O modelo quantizado em 4 bits reduz significativamente a necessidade de armazenamento para aproximadamente 350GB, mantendo a maior parte do desempenho.

Passo 5: Testando o Modelo

Uma vez que o modelo esteja baixado, você pode testá-lo com um prompt simples:

# Teste com um prompt básico

llm chat -m mlx-community/DeepSeek-V3-0323-4bit

Isso iniciará uma sessão de chat interativa com o modelo Deepseek V3 0323. Agora você pode digitar seus prompts e interagir com o modelo.

Passo 6: Executando como um Servidor API Local

Para um uso mais flexível, você pode executar o Deepseek V3 0323 como um servidor API local:

# Inicie o servidor

python -m mlx_lm.server --model mlx-community/DeepSeek-V3-0323-4bit --port 8080

O servidor será iniciado em localhost:8080, fornecendo um endpoint de API compatível com OpenAI em http://localhost:8080/v1/chat/completions.

Passo 7: Interagindo com a API

Crie um script Python simples para interagir com seu servidor API local:

import requests

import json

def chat_with_model(prompt):

url = "<http://localhost:8080/v1/chat/completions>"

headers = {"Content-Type": "application/json"}

data = {

"messages": [{"role": "user", "content": prompt}],

"temperature": 0.7,

"max_tokens": 500

}

response = requests.post(url, headers=headers, json=data)

return response.json()["choices"][0]["message"]["content"]

# Teste a API

response = chat_with_model("Explique a computação quântica em termos simples")

print(response)

Dicas de Otimização de Desempenho

Para obter o melhor desempenho do Deepseek V3 em seu Mac:

- Feche outros aplicativos: Minimize processos em segundo plano para liberar memória

- Ajuste a janela de contexto: Janelas de contexto menores usam menos memória

- Quantização: Use quantização de 4 bits para melhor desempenho em máquinas de especificações mais baixas

- Refrigeração: Garanta ventilação adequada para seu Mac durante uso prolongado

- Ajuste de parâmetros: Experimente configurações de temperatura e top_p para diferentes casos de uso

Ajustando o Deepseek V3

Para aplicações especializadas, você pode querer ajustar o Deepseek V3 em seus próprios dados:

# Instale as dependências para ajuste fino

pip install datasets peft trl

# Execute o script de ajuste fino (exemplo)

python fine_tune_mlx.py \\\\

--model mlx-community/DeepSeek-V3-0323-4bit \\\\

--dataset seu_dataset.json \\\\

--output-dir modelo_ajustado \\\\

--epochs 3

Integrando o Modelo em Aplicações

Para integrar o Deepseek V3 em suas aplicações, você pode utilizar o servidor API ou interagir diretamente com o MLX:

from mlx_lm import load, generate

# Carregue o modelo

model, tokenizer = load("mlx-community/DeepSeek-V3-0323-4bit")

# Gere texto

prompt = "Explique a teoria da relatividade"

tokens = tokenizer.encode(prompt)

generation = generate(model, tokens, temp=0.7, max_tokens=500)

# Imprima o resultado

print(tokenizer.decode(generation))

Problemas Comuns e Solução de Problemas

- Erros de Memória Insuficiente: Tente usar uma quantização mais agressiva ou reduza sua janela de contexto

- Velocidade de geração lenta: Feche aplicativos em segundo plano e garanta refrigeração adequada

- Falhas de instalação: Certifique-se de que você está usando Python 3.9+ e atualizou o pip

- Erros no carregamento do modelo: Verifique se você tem espaço em disco suficiente e se baixou o modelo corretamente

- Problemas de conexão API: Verifique se o servidor está em execução e se a porta não está sendo usada por outro aplicativo

Conclusão

Executar o Deepseek V3 0323 localmente em seu Mac com MLX fornece uma solução de IA poderosa e focada na privacidade, sem as limitações dos serviços baseados em API. Com desempenho em benchmarks se aproximando dos melhores modelos comerciais, como o Claude Sonnet 3.7, o Deepseek V3 representa uma realização impressionante em IA de código aberto.

A combinação da eficiência computacional do Apple Silicon e da otimização do MLX para esses chips torna a implementação local cada vez mais prática, mesmo para modelos grandes que anteriormente exigiam infraestrutura em nuvem. À medida que essas tecnologias continuam a avançar, a lacuna entre a IA local e baseada em nuvem continuará a diminuir, capacitando os usuários com mais controle, privacidade e flexibilidade em suas aplicações de IA.

Seja você um desenvolvedor buscando integrar capacidades de IA em suas aplicações, um pesquisador explorando as capacidades do modelo, ou simplesmente um entusiasta querendo vivenciar IA de ponta, executar o Deepseek V3 0323 localmente com MLX oferece um caminho empolgante e acessível.