Vamos encarar: assistentes de codificação com IA, como o GitHub Copilot, são fantásticos, mas os custos de assinatura podem queimar o seu bolso. Apresentamos o DeepSeek R1—um modelo de linguagem gratuito e de código aberto que rivaliza com o GPT-4 e o Claude 3.5 em tarefas de raciocínio e codificação. Combine-o com o Cline, um plugin para VS Code que transforma esta IA em um agente de codificação completo, e você terá uma configuração poderosa que escreve, debuga e até executa código autonomamente—tudo isso sem gastar um centavo.

Neste guia, vou te levar por tudo que você precisa saber, desde a instalação do Cline até a otimização do DeepSeek R1 para seus projetos. Vamos começar!

O que torna o DeepSeek R1 especial?

1. É Grátis (Sim, é Verdade!)

Diferente dos modelos proprietários, o DeepSeek R1 é totalmente de código aberto e utilizável comercialmente. Sem limites de token, sem taxas ocultas—apenas o poder bruto da IA.

2. Desempenho que Rivaliza com Modelos Pagos

O DeepSeek R1 se destaca em codificação, matemática e raciocínio lógico. Por exemplo, sua variante de 32B parâmetros supera o o1-mini da OpenAI em benchmarks de geração de código, e seu modelo de 70B iguala o Claude 3.5 Sonnet em tarefas complexas.

3. Opções de Implantação Flexíveis

Execute localmente para privacidade e velocidade, ou use a API acessível do DeepSeek (a partir de $0,01 por milhão de tokens) para acesso baseado em nuvem.

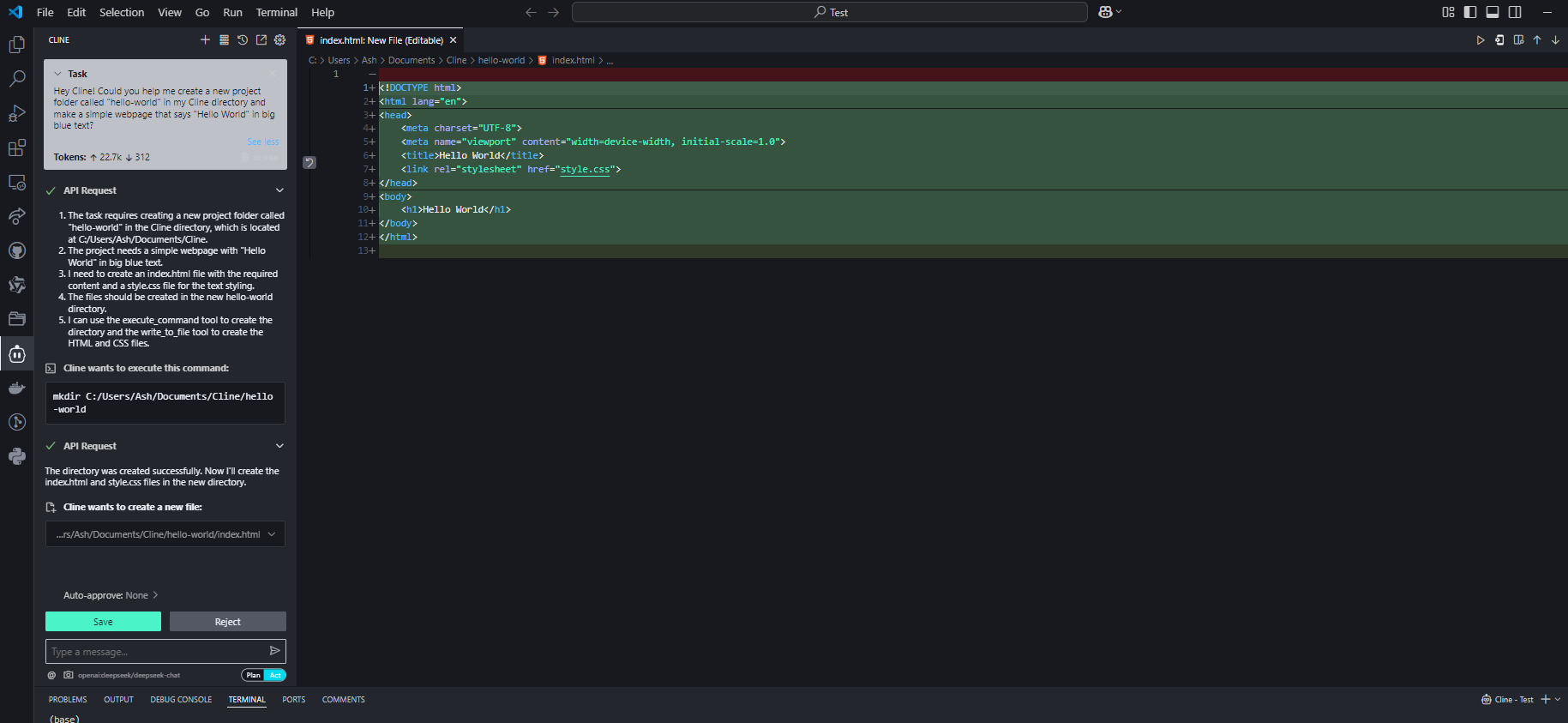

Configuração do DeepSeek R1 no VS Code com Cline

Passo 1: Instalar o Plugin Cline

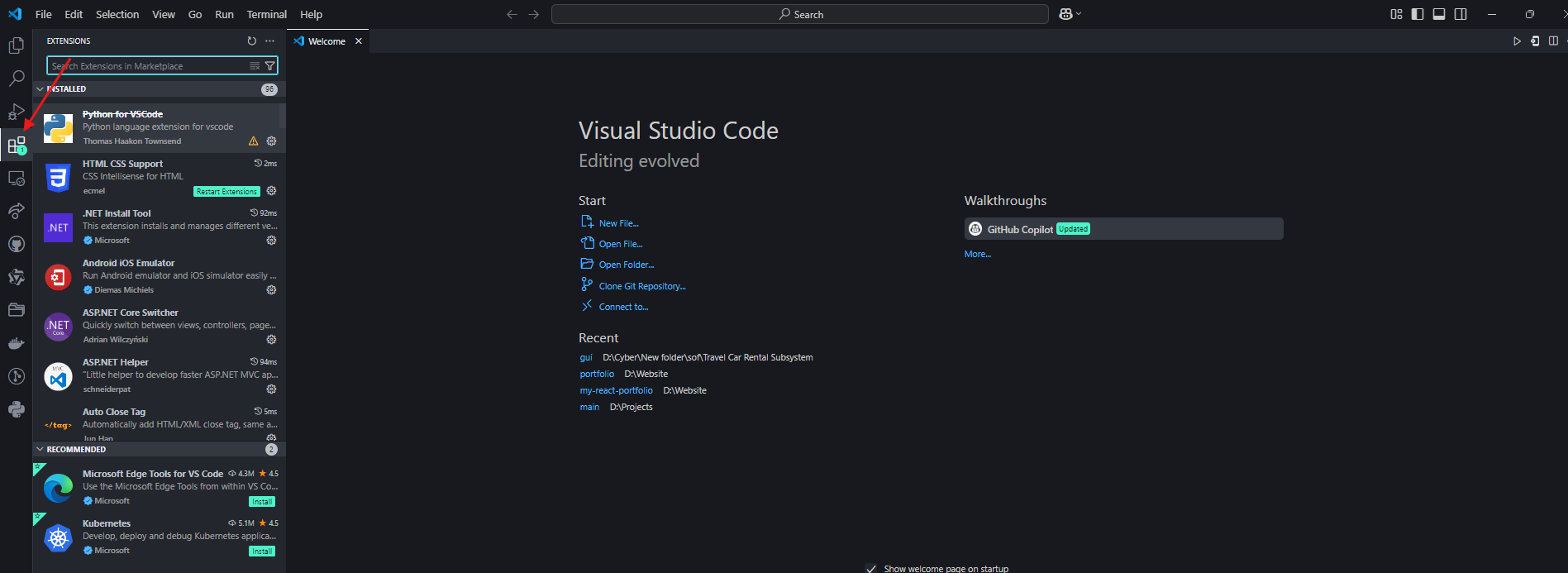

- Abra o VS Code e navegue até a aba Extensões.

2. Pesquise por “Cline” e instale-o.

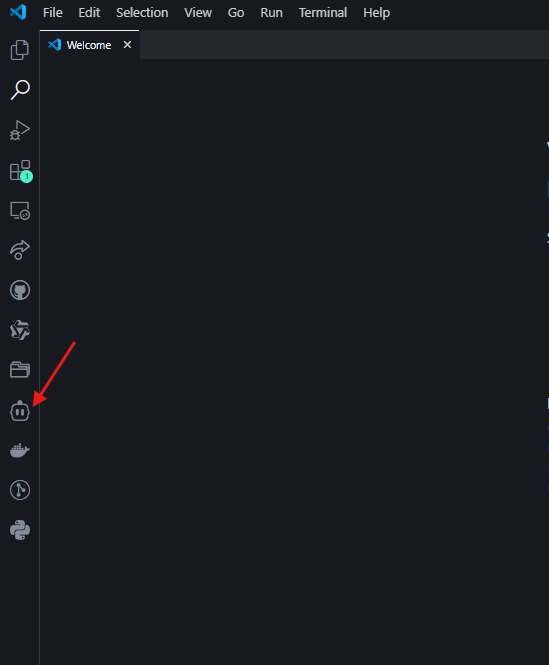

3. Clique no ícone do robô na barra lateral esquerda para ativar o Cline.

Passo 2: Escolha Seu Fluxo de Trabalho do DeepSeek R1

Opção A: Configuração Local (Grátis, Prioridade para Privacidade)

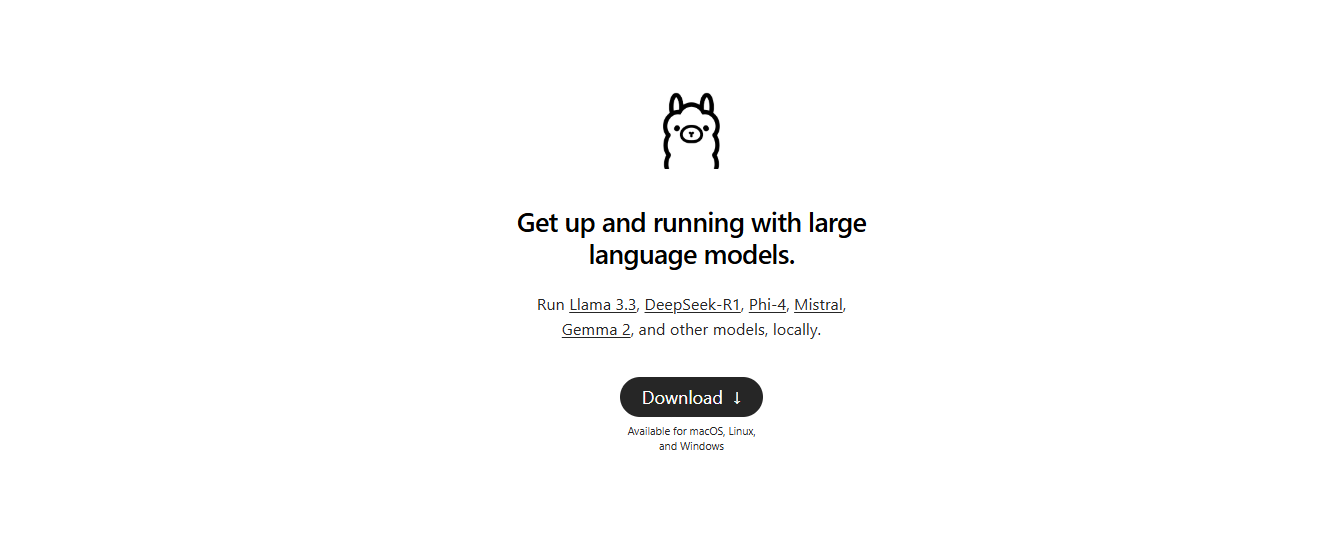

- Instale o Ollama: Baixe-o de ollama.com para gerenciar modelos de IA locais.

2. Baixe o Modelo: No seu terminal, execute:

ollama pull deepseek-r1:14b # Para hardware de gama média (ex: RTX 3060)

Modelos menores como 1.5b funcionam para tarefas básicas, mas 14B+ são recomendados para codificação.

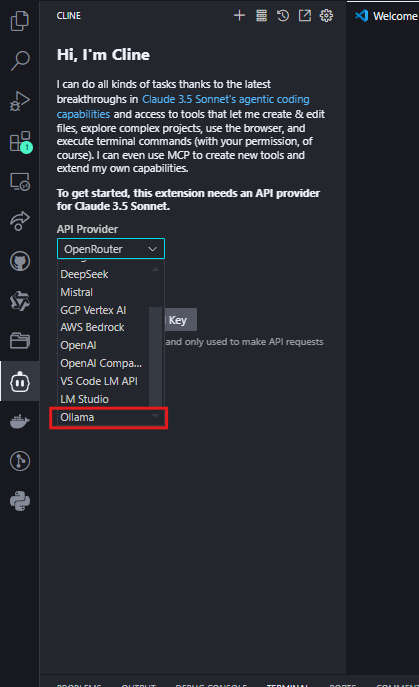

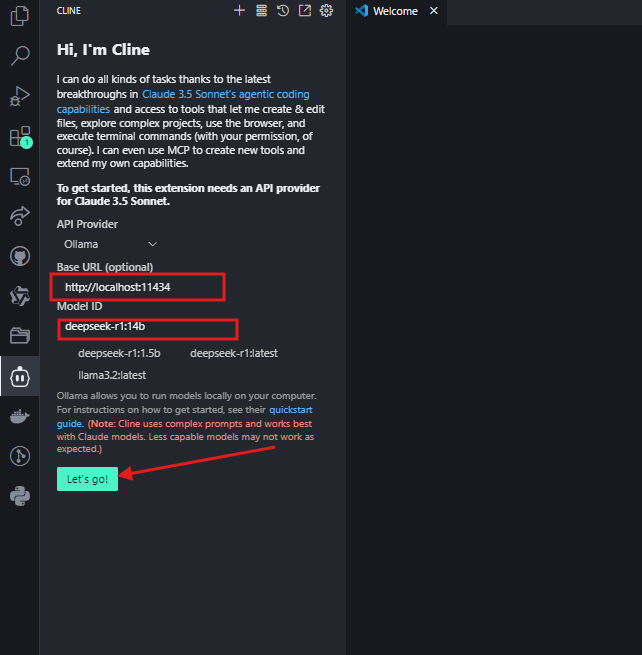

- Configure o Cline:

- Defina o Provedor da API como “Ollama”.

- Digite

http://localhost:11434como a URL base e selecione seu modelo (ex:deepseek-r1:14b).

Clique em "Vamos lá" e você pode usá-lo agora.

Opção B: Integração com OpenRouter (Alternância Flexível entre Modelos)

Para desenvolvedores que desejam acesso a múltiplos modelos de IA (incluindo o DeepSeek R1) através de uma única chave de API, o OpenRouter oferece uma solução simplificada. Isso é ideal se você ocasionalmente precisa comparar resultados com modelos como GPT-4 ou Claude, mas deseja que o DeepSeek R1 seja seu padrão.

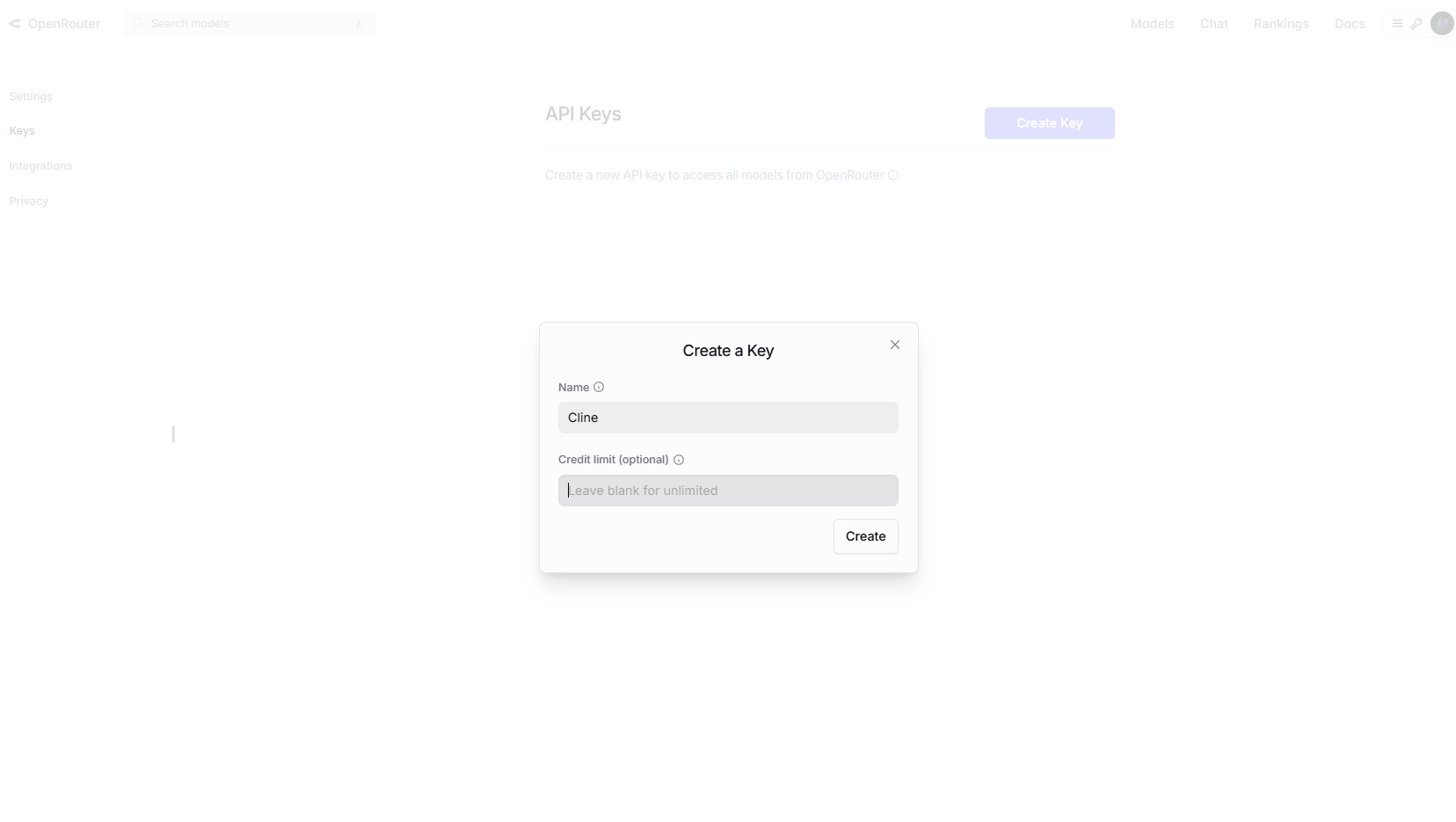

Passo 1: Obtenha Sua Chave de API do OpenRouter

- Visite OpenRouter.ai e se inscreva.

- Vá até Chaves de API e crie uma nova chave.

Opcional: Ative limites de gastos nas configurações da conta para controle de custos.

Passo 2: Configure o Cline para o OpenRouter

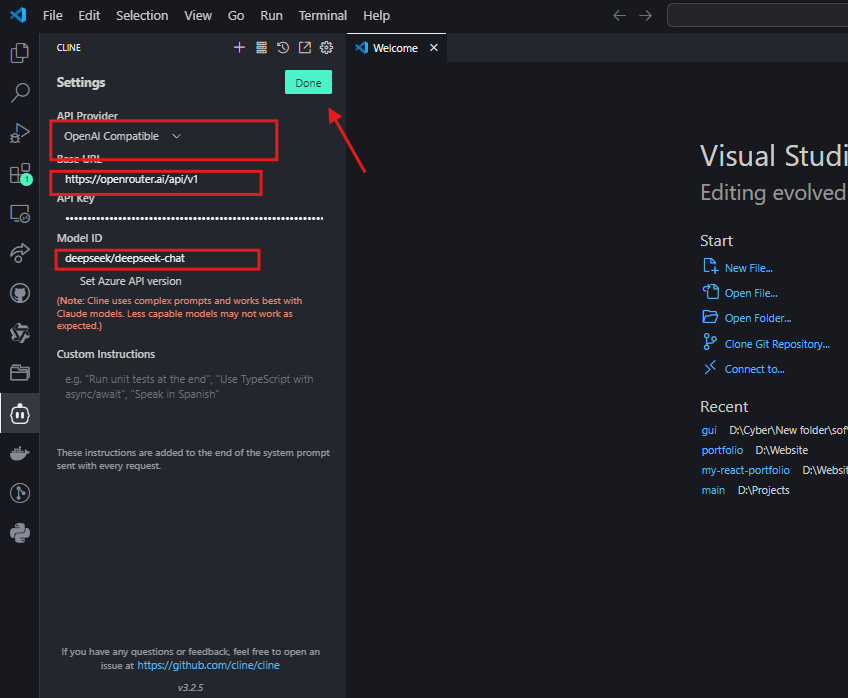

- No VS Code, abra as configurações do Cline.

- Selecione “Compatível com OpenAI” como o provedor da API.

- Defina a URL Base como

https://openrouter.ai/api/v1. - Cole sua chave de API do OpenRouter.

- No campo ID do Modelo, insira

deepseek/deepseek-chat.

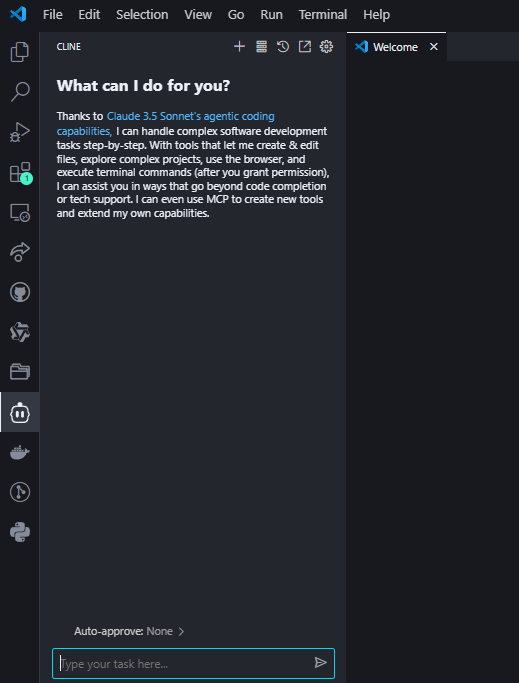

Passo 3: Teste a Integração

Faça uma pergunta de codificação ao Cline para confirmar a configuração:

Se configurado corretamente, o DeepSeek R1 gerará código com explicações na interface do Cline.

Por que escolher o OpenRouter?

- Acesso Multimodal: Troque facilmente entre o DeepSeek R1 e mais de 50 outros modelos (ex: GPT-4, Claude) sem reconfigurar as APIs.

- Transparência de Custos: Acompanhe o uso de tokens em todos os modelos em um único painel.

- Suporte de Fallback: Roteie automaticamente as solicitações para modelos de backup se a API do DeepSeek R1 estiver sobrecarregada.

Considerações sobre Custos

Enquanto o preço do OpenRouter para o DeepSeek R1 está alinhado com os custos diretos da API (~$0,01 por milhão de tokens de entrada), sempre verifique sua página de preços para taxas em tempo real. Para usuários frequentes, a cobrança unificada do OpenRouter pode simplificar a gestão de despesas.

Dicas Profissionais para Otimização de Desempenho

1. Tamanho do Modelo vs. Hardware

| Modelo | RAM Necessária | GPU Recomendada |

|---|---|---|

| 1.5B | 4GB | Integrada |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

Dica: Modelos quantizados (ex: Q4_K_M.gguf) reduzem o uso de VRAM em 30% sem perda significativa de qualidade.

2. Engenharia de Prompt

- Para Código: Inclua instruções explícitas como “Use Python 3.11 e dicas de tipo”.

- Para Depuração: Cole logs de erro e pergunte “Explique esse erro e conserte-o”.

Solução de Problemas Comuns

1. Respostas Lentas

- Solução: Troque para um modelo menor ou ative a aceleração de GPU no Ollama com

OLLAMA_GPU_LAYERS=12.

2. Alucinações ou Respostas Fora do Contexto

- Solução: Use prompts mais restritivos (ex: “Responda usando apenas o contexto fornecido”) ou faça upgrade para modelos maiores como 32B.

3. Cline Ignorando o Contexto do Arquivo

- Solução: Sempre forneça caminhos completos dos arquivos (ex:

/src/components/Login.jsx) em vez de referências vagas.

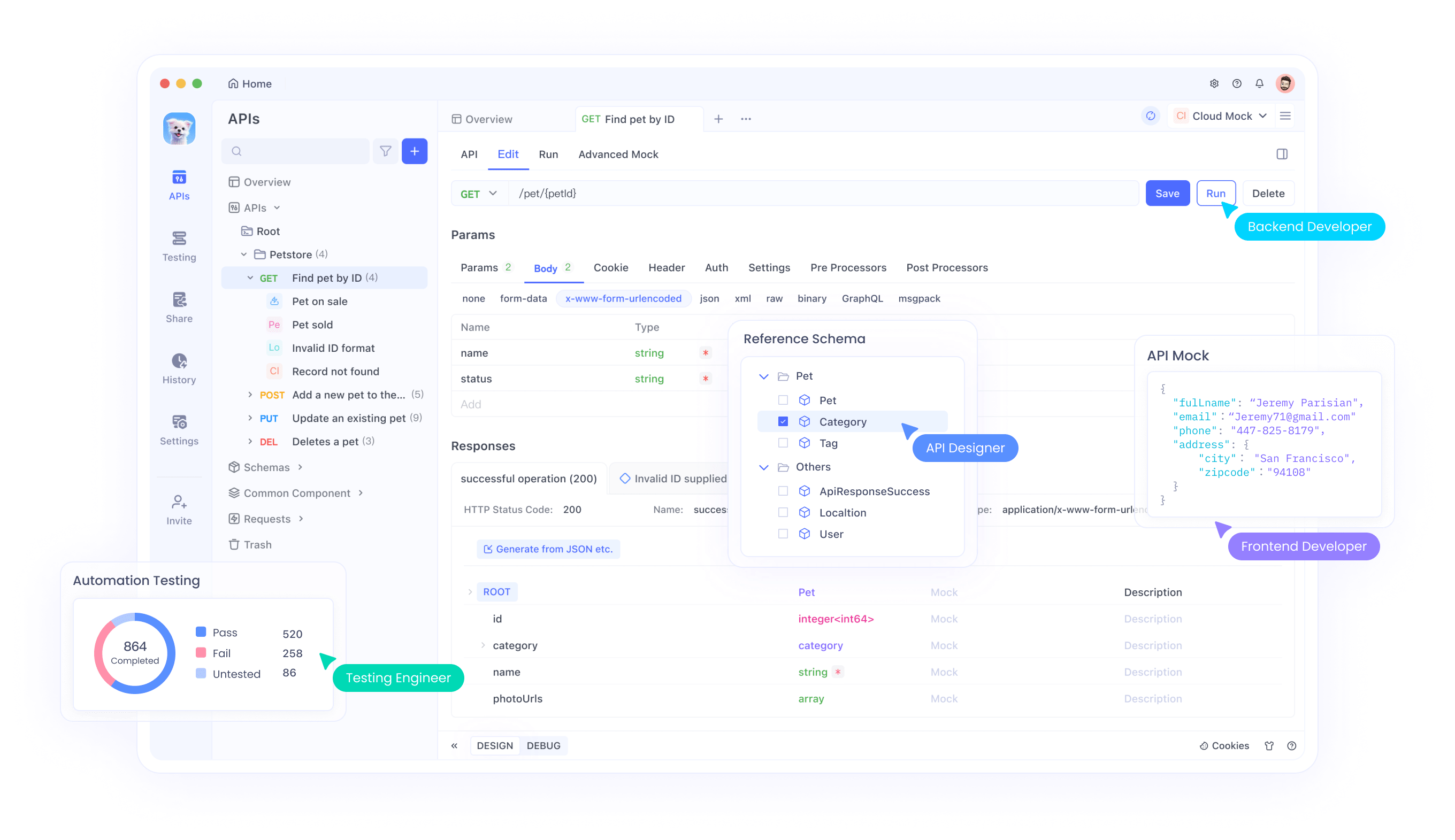

Casos de Uso Avançados com Integração do Apidog

Uma vez que sua configuração DeepSeek R1 + Cline esteja em funcionamento, use Apidog para:

- Testar Endpoints de API: Valide as respostas do DeepSeek programaticamente.

- Automatizar Fluxos de Trabalho: Encadeie a geração de código do Cline com chamadas de API (ex: implante um script gerado na AWS).

- Monitorar Desempenho: Acompanhe latência e precisão ao longo do tempo.

Concluindo: Por Que Esta Combinação é Vencedora

DeepSeek R1 e Cline não são apenas ferramentas—são uma mudança de paradigma. Você obtém inteligência de nível GPT-4 sem o custo, controle total sobre a privacidade e um fluxo de trabalho que se sente como se estivesse se associando a um desenvolvedor sênior.

Pronto para turbinar sua codificação?

- Instale o Cline e o Ollama.

- Escolha seu modelo DeepSeek R1.

- Construa algo incrível—e me avise como foi!

Não se esqueça de baixar o Apidog para simplificar testes de API e automação. É o companheiro perfeito para sua jornada de codificação impulsionada por IA!