Executar modelos poderosos localmente é cada vez mais importante para a privacidade, velocidade e eficiência de custos. Uma das últimas inovações nesse espaço é o Command A—um modelo generativo de última geração projetado para desempenho máximo com computação mínima. Se você está explorando opções de implantação de IA local, este guia o levará através de como executar o Command A localmente usando Ollama.

Mas o que exatamente é o Command A? Por que foi criado e como ele se compara a modelos líderes como o GPT-4o e o DeepSeek-V3? Neste tutorial, vamos nos aprofundar no propósito, benchmarks de desempenho e preços da API do Command A. Também forneceremos um passo a passo para configurar e executar o Command A na sua máquina usando o Ollama.

O que é Command A?

Command A é um modelo de IA generativa de ponta projetado para aplicações empresariais. Desenvolvido pela Equipe Cohere, o Command A é construído para oferecer desempenho máximo com mínima sobrecarga computacional. Ele é projetado para rodar em hardware local com um footprint de serviço tão pequeno quanto duas GPUs, em comparação com as 32 GPUs normalmente requeridas por outros modelos. Sua arquitetura é otimizada para respostas rápidas, seguras e de alta qualidade, tornando-o uma opção atraente para implantações privadas.

No seu núcleo, o Command A é uma ferramenta que facilita tarefas avançadas de processamento e geração de linguagem natural. Ele serve como a espinha dorsal para aplicativos que precisam processar grandes quantidades de texto rapidamente, lidar com instruções complexas e fornecer respostas confiáveis de forma conversacional.

Quem usaria o Command A?

O Command A é projetado para aplicações empresariais, oferecendo alto desempenho com requisitos mínimos de hardware. Ele funciona de forma eficiente com apenas duas GPUs (A100s ou H100s) sem sacrificar velocidade ou precisão. Com um comprimento de contexto de 256k, ele se destaca em processar documentos longos, consultas multilíngues e tarefas críticas para os negócios.

Suas capacidades agentes suportam fluxos de trabalho autônomos, enquanto a otimização multilíngue garante respostas consistentes em diferentes idiomas. Além disso, suas menores demandas de hardware e geração de tokens mais rápida tornam-no custo-efetivo, reduzindo tanto a latência quanto as despesas operacionais. Por fim, a implantação local melhora a segurança, mantendo dados sensíveis dentro da empresa e minimizando os riscos associados aos serviços de IA baseados em nuvem.

Essas vantagens tornam o Command A uma escolha atraente para empresas que buscam integrar poderosas capacidades de IA sem incorrer nos altos custos tipicamente associados a modelos de última geração.

Preços da API do Cohere Command A

O custo é uma consideração importante para qualquer empresa que implemente soluções de IA. O Command A foi projetado para ser tanto de alto desempenho quanto econômico. Veja como seus preços se comparam:

Preços da API Cohere para Command A:

- Tokens de Entrada: $2,50 por 1 milhão de tokens

- Tokens de Saída: $10,00 por 1 milhão de tokens

Quando você compara esses custos aos de acesso à API na nuvem para outros modelos, as implantações privadas do Command A podem ser até 50% mais baratas. Essa redução de custos significativa é alcançada através de:

- Uso Eficiente de Computação: Requerendo apenas duas GPUs em vez de dezenas.

- Maior Desempenho: Geração de tokens mais rápida reduz o tempo de processamento, levando a custos operacionais mais baixos.

- Implantação Privada: Executar o modelo no local não apenas melhora a segurança, mas também evita custos recorrentes de API na nuvem.

Para empresas que processam grandes volumes de dados ou requerem interações contínuas e em alta velocidade com a IA, esses benefícios de preços tornam o Command A uma opção muito atraente.

Como Instalar e Configurar o Ollama para Executar o Command A

Por que Executar o Command A Localmente?

- Privacidade: Seus dados ficam no seu dispositivo.

- Custo: Sem taxas de API ou limites de uso.

- Personalização: Ajuste o modelo para suas necessidades.

- Acesso Offline: Use a IA sem conexão com a internet.

Pré-requisitos

- Ollama: Instale-o a partir de Ollama.ai.

- Modelo Command A: você pode obter o modelo

command-adiretamente no site oficial do Ollama na seção "modelos".

Passo 1: Instalar o Ollama

Windows/macOS/Linux:

- Baixe o Ollama do site oficial, depois execute o instalador. Após a instalação, verifique a instalação usando o seguinte comando:

ollama --version

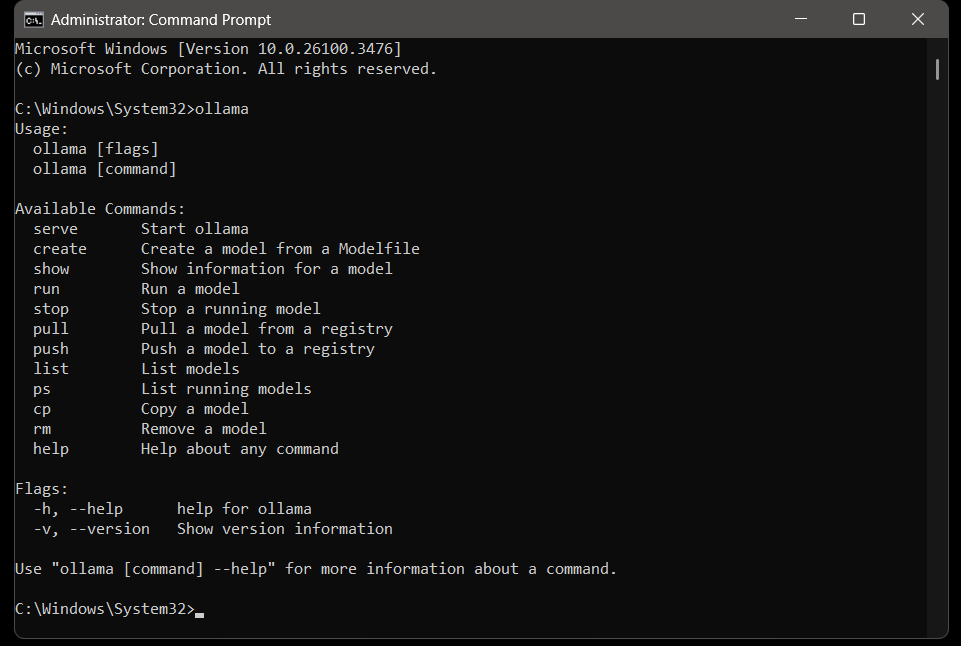

# Exemplo de Saída: ollama versão 0.1.23 Quando o Ollama estiver instalado em seu sistema, você pode executar o comando ollama para ver os comandos disponíveis do Ollama.

Passo 2: Puxar o Modelo Command A

Ollama suporta milhares de modelos através de sua biblioteca. Basta acessar o site oficial e procurar por command a na seção "modelos".

# Puxar o modelo

ollama pull command-a

# Puxar o modelo e executá-lo após a conclusão

ollama run command-a

Nota: Se você tiver um arquivo de modelo Command-a personalizado, use:

ollama create command-a -f ModelfileObserve que o modelo é bastante grande e requer espaço de armazenamento significativo. Antes da instalação, verifique seu espaço disponível em disco e explore outros modelos para encontrar um que melhor se adapte à capacidade do seu sistema.

Passo 3: Executar o Command A Localmente

Inicie o servidor Ollama e execute o modelo:

# Inicia o servidor

ollama serve

# Carrega o modelo

ollama run command-r Teste-o: Faça uma pergunta diretamente no terminal:

# Exemplo de Pergunta de Entrada

>>> Qual é a capital da Zâmbia?

# Exemplo de Resposta

>>> LusacaSolução de Problemas

Mesmo com uma configuração robusta, você pode encontrar problemas. Aqui estão algumas dicas de solução de problemas e melhores práticas:

1. Erro “Modelo Não Encontrado”

- Verifique o nome do modelo:

ollama list - Puxe o modelo novamente:

ollama pull command-a

2. Problemas de Conexão da API

- Certifique-se de que o Ollama está em execução:

ollama serve

3. Desempenho Lento

- Use modelos menores (por exemplo,

command-r:3b). - Alocar mais RAM para o Ollama.

Command A vs GPT-4o & Deepseek V3

Ao avaliar modelos de IA, é essencial compará-los não apenas em desempenho teórico, mas também em benchmarks práticos e casos de uso do mundo real. O Command-a foi avaliado em comparação com modelos como GPT-4o e DeepSeek-V3, e os resultados são impressionantes:

- Eficiência de Desempenho: O Command-a entrega tokens a uma taxa de até 156 tokens/segundo, o que é 1,75 vezes mais rápido que o GPT-4o e 2,4 vezes mais rápido que o DeepSeek-V3. Esse maior throughput significa respostas mais rápidas e uma melhor experiência do usuário.

- Requisitos de Computação: Enquanto muitos modelos requerem até 32 GPUs para desempenho ideal, o Command-a funciona efetivamente com apenas duas GPUs. Essa drástica redução nos requisitos de hardware não apenas reduz custos, mas também torna mais acessível para implantações privadas.

- Comprimento de Contexto: Com um comprimento de contexto de 256k tokens, o Command-a supera muitos modelos líderes que normalmente têm janelas de contexto mais curtas. Isso permite que o Command-a gerencie e compreenda documentos muito mais longos, uma vantagem chave para aplicações empresariais.

- Avaliação Humana: Em avaliações humanas diretas em tarefas que abrangem negócios, STEM e programação, o Command-a iguala ou supera o desempenho de concorrentes maiores e mais lentos. Essas avaliações são baseadas em precisão focada na empresa, cumprimento de instruções e estilo, garantindo que o Command-a atenda aos requisitos reais de negócios.

No geral, a filosofia de design do Command A enfatiza eficiência, escalabilidade e alto desempenho, tornando-o um modelo de destaque no cenário competitivo da IA.

Considerações Finais

Neste tutorial abrangente, exploramos como executar o Command A localmente usando o Ollama, juntamente com percepções detalhadas sobre o que é o Command A, por que foi criado e como ele se compara a outros modelos de última geração como GPT-4o e DeepSeek-V3.

Command A é um modelo generativo de ponta otimizado para desempenho máximo com requisitos mínimos de hardware. Ele se destaca em ambientes empresariais ao oferecer geração de tokens mais rápida, uma janela de contexto maior e eficiência de custos. Com benchmarks mostrando que pode entregar tokens a até 156 tokens por segundo—superando seus concorrentes—e com requisitos de computação significativamente mais baixos, o Command A representa o futuro da IA eficiente.

Também detalhamos a precificação da API, que é de $2,50 por 1M de tokens de entrada e $10,00 por 1M de tokens de saída, tornando o Command A uma opção economicamente atraente para implantações privadas.

Seguindo nosso guia passo a passo, você aprendeu como:

- Configurar o ambiente necessário para executar o Command-a.

- Configurar o Ollama para servir como o motor local que alimenta o Command-a.

- Compreender os benefícios de desempenho e a estrutura de preços que fazem o Command-a se destacar no cenário competitivo da IA.

Agora que você está equipado com esse conhecimento, pode experimentar diferentes consultas empresariais, integrar funcionalidades adicionais e otimizar ainda mais suas implantações de IA local.

🚀 Acelere seu desenvolvimento e teste de API! Baixe o Apidog gratuitamente e simplifique seu processo de integração com ferramentas de teste de API de alto nível.