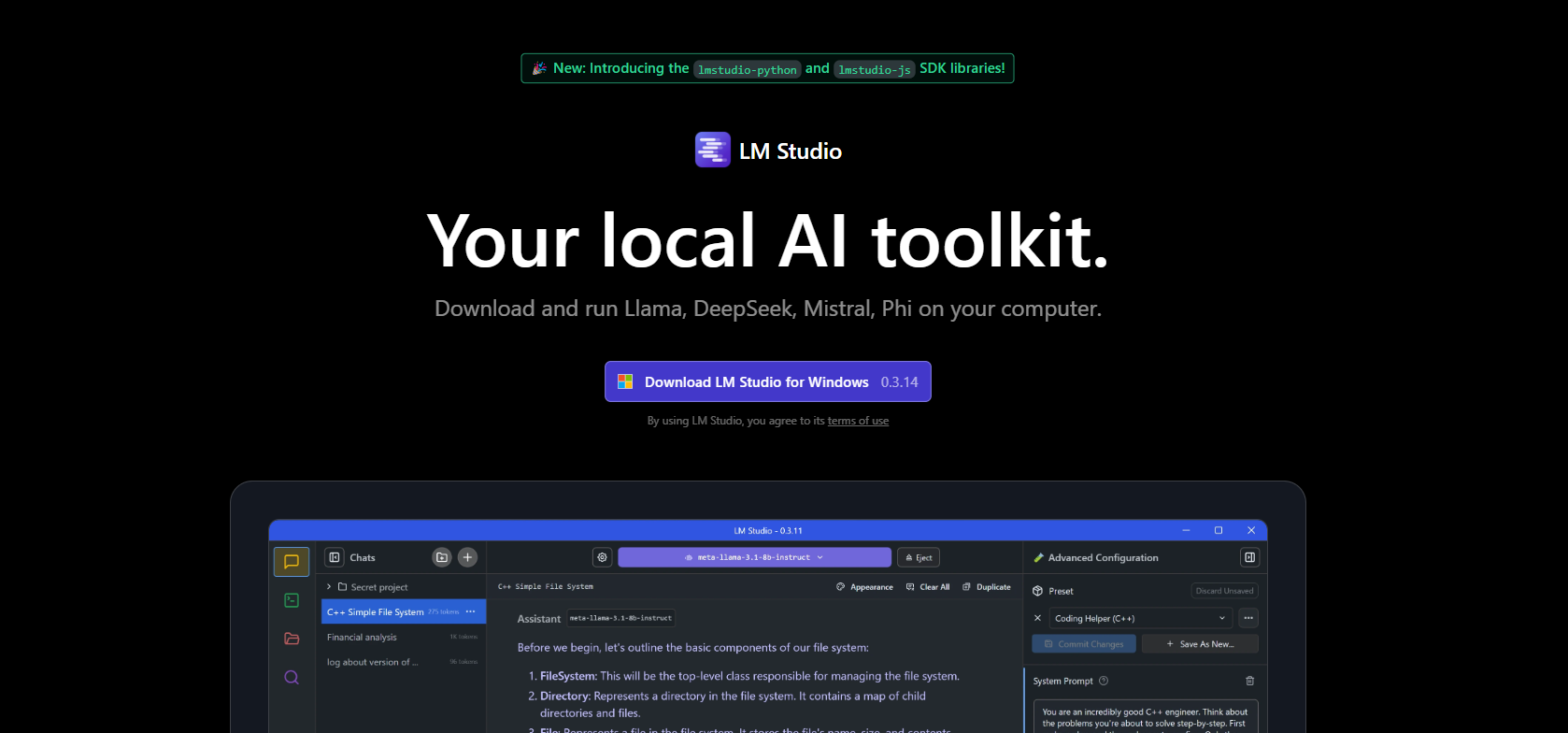

LM Studio에 인사하세요. LM Studio는 라마, 피 또는 제마와 같은 대형 언어 모델(LLM)을 다운로드하고 채팅하며 조작할 수 있는 매우 친숙한 데스크탑 앱입니다. 모든 작업을 로컬에서 수행할 수 있습니다. 개인적인 ChatGPT를 소유하는 것과 같지만, 데이터의 주인은 바로 여러분입니다. 이번 초보자 가이드에서는 LM Studio를 설정하고 사용하는 방법을 안내해 드리겠습니다. AI의 마법을 여는 데에 박사학위는 필요 없습니다. 코딩을 하든 글을 쓰든, 혹은 그냥 호기심이 많은 분이든, 이 도구는 게임 체인저입니다. 준비되셨나요? AI의 불꽃을 튀겨보세요!

LM Studio란 무엇인가요? 당신의 로컬 AI 놀이터

LM Studio란 무엇인가요? 이는 대형 언어 모델을 인터넷이나 클라우드 서비스 없이 컴퓨터로 가져오는 크로스 플랫폼 앱입니다(Windows, Mac, Linux). 허깅페이스에서 Llama 3.1 또는 Mistral과 같은 오픈 소스 LLM을 브라우징하고 다운로드하고 채팅할 수 있는 아늑한 허브와 같습니다. LM Studio는 모델 다운로드, 메모리 로드 및 ChatGPT와 유사한 인터페이스 제공 같은 많은 작업을 처리하므로 질문을 하거나 멋진 것을 구축하는 데 집중할 수 있습니다. 사용자는 “지극히 간단한 설정”과 개인 정보 보호 혜택에 대해 극찬하며, 데이터가 항상 자신의 머신에 남아 있게 됩니다. 코더, 작가 또는 취미생활을 즐기는 분이라면, LM Studio는 AI를 쉽게 느낄 수 있도록 도와줍니다.

왜 로컬에서 작업해야 할까요? 개인 정보, 제어력, 구독 요금 없이—게다가 AI를 로컬 PC에서 실행하는 게 단순히 재밌습니다. 이제 설정해 보겠습니다!

LM Studio 설치하기: 빠른 설정

LM Studio를 실행하는 것은 IKEA 가구 조립보다 쉽습니다—약속합니다! lmstudio.ai의 문서가 명확하게 설명되어 있으며, 제가 간단히 설명해 드릴게요. AI의 모험을 시작하는 방법은 다음과 같습니다.

1단계: 하드웨어 확인

LM Studio는 차분하지만 전원이 필요합니다:

- RAM: 괜찮은 모델을 위해 최소 16GB(작은 모델은 8GB로도 가능).

- 저장소: 모델의 크기는 2–20GB이니, 공간을 확보하세요.

- CPU/GPU: 최신 CPU면 좋고, GPU(NVIDIA/AMD)가 있으면 더 빨라지지만 필수는 아닙니다. Mac M1/M2 사용자라면, GPU가 필요 없습니다.

- OS: Windows(x86/ARM), macOS(M1–M4) 또는 Linux(x86 with AVX2).

빠른 lscpu(Linux) 또는 시스템 정보(Windows/Mac)를 실행하여 setup을 확인하세요. 16GB RAM을 가진 Ryzen 5를 사용하는 구형 컴퓨터도 LM Studio를 훌륭하게 수행하므로, 슈퍼컴퓨터가 없다면 걱정할 필요 없습니다.

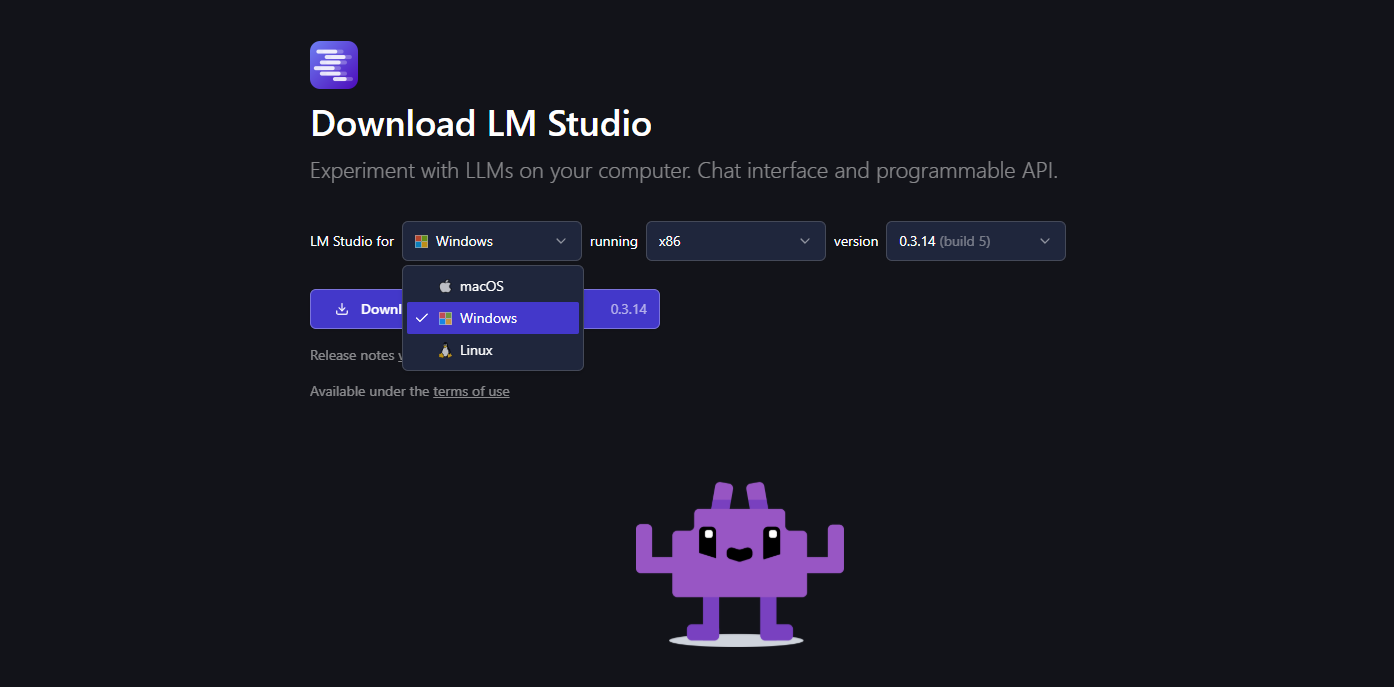

2단계: 다운로드 및 설치

- lmstudio.ai로 가서 운영 체제에 맞는 설치 관리자를 다운로드하세요.

2. 설치 관리자를 실행하세요—표준 “다음, 다음, 완료” 프로세스입니다. Mac에서는 응용 프로그램으로 드래그했고, Windows에서는 바탕 화면에 바로가기가 생깁니다.

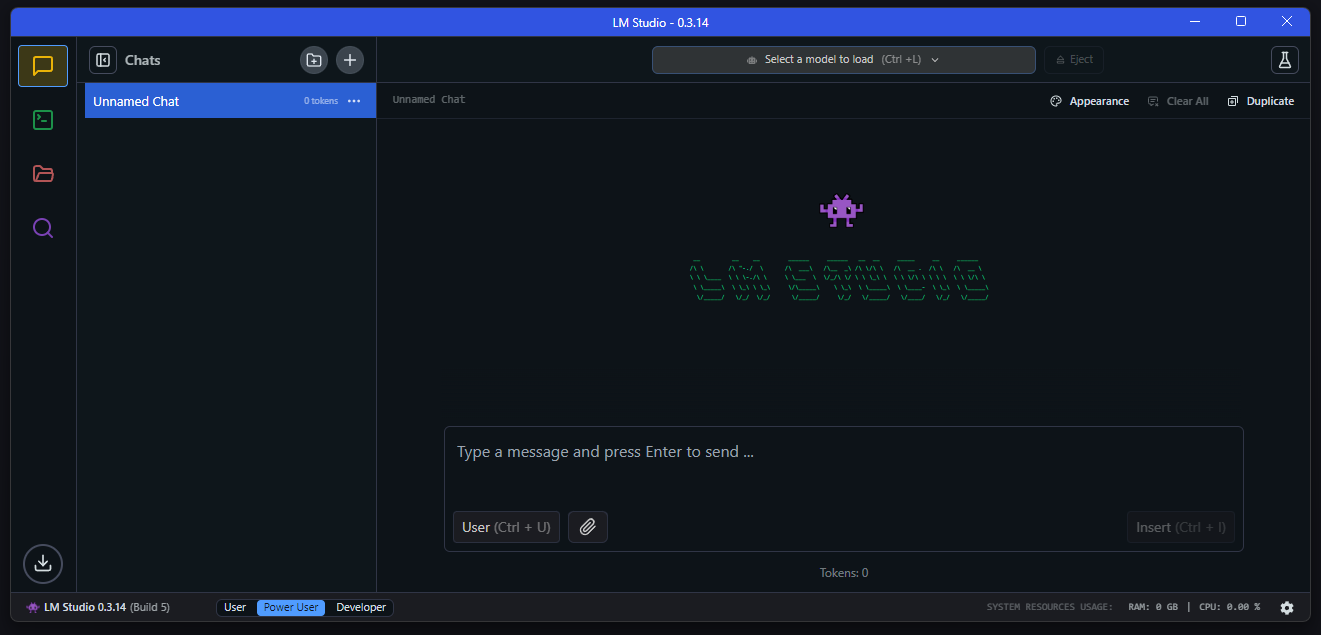

3. LM Studio를 시작하세요. 모델 검색 바와 추천 항목이 있는 세련된 홈페이지에 도착할 것입니다. 처음에는 다소 복잡하게 느껴질 수 있지만(저도 그랬습니다!), 간단하게 진행합시다.

3단계: 업데이트(선택 사항)

LM Studio는 자동으로 업데이트를 확인합니다(2025년 4월 기준 버전 0.3.14). 요청이 표시되면 “업데이트”를 클릭하여 최신 버전을 유지하세요. 버그를 수정하고 더 나은 도구 지원과 같은 멋진 기능을 추가합니다.

이제 완료입니다! LM Studio가 준비되었습니다. 저에게는 5분도 걸리지 않았습니다—여러분은요?

LM Studio 사용하기: 채팅 및 모델 탐색

LM Studio가 설치되었으니, 재미있게 놀아 봅시다! 이 앱은 모델을 다운로드하고 채팅하는 것이 핵심 기능이니, 좋은 것들에 대해 알아보겠습니다.

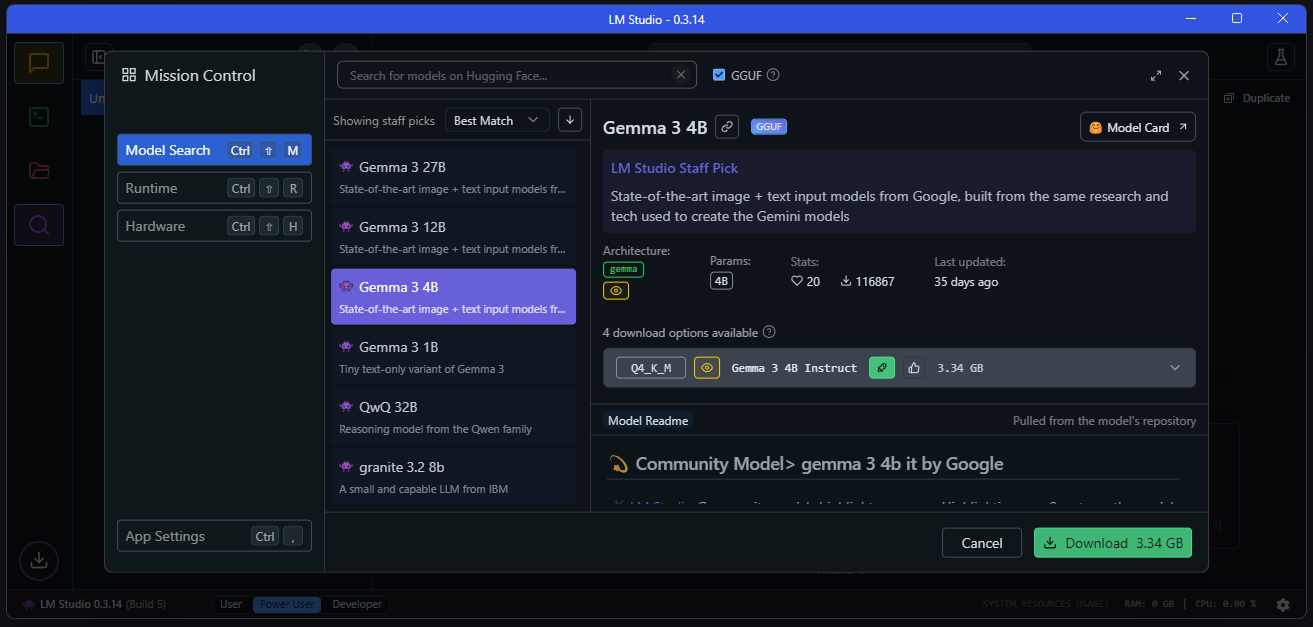

1단계: 모델 선택 및 다운로드

Discover 탭은 허깅페이스에서 모델을 가져오는 사탕 가게입니다. 선택하는 방법은 다음과 같습니다:

- LM Studio를 열고 확대경 아이콘(Discover 탭)을 클릭하세요.

- Llama 3.1 8B 또는 Phi-3-mini와 같은 추천 모델을 둘러보세요. 초보자라면 4–8GB 양자화 모델(Q4_K_M 버전)을 선택하세요—빠르고 가볍습니다.

3. 특정한 것을 검색하세요. 예: “Mistral-7B-Instruct”(채팅하는 데 좋음) 또는 "Meta-Llama-3.1-8B-Instruct"(시작하기에 좋음). 모델 옆의 “다운로드”를 클릭하세요.

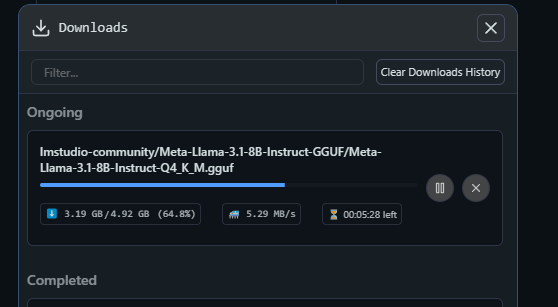

4. 잠시 기다리세요—다운로드 속도는 인터넷 연결에 따라 다릅니다(5GB 모델은 Wi-Fi에서 약 10분 걸렸습니다). 다운로드 탭에서 진행 상황을 확인하세요.

전문 팁: LM Studio는 하드웨어를 기반으로 시스템이 처리할 수 있는 모델을 추천하므로, 원활하게 진행하려면 해당 모델을 사용하세요.

2단계: 로드하고 채팅하기

다운로드가 완료되면 채팅 시간이 왔습니다:

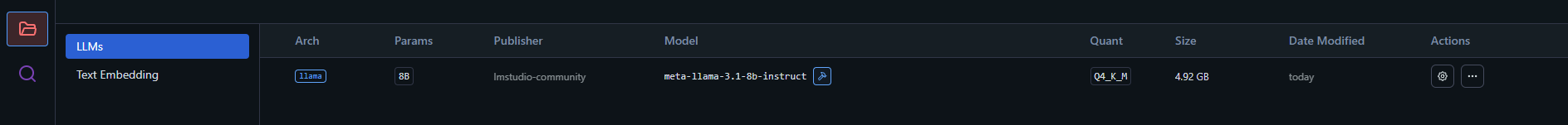

- 내 모델 탭(왼쪽 사이드바, 폴더처럼 보임)으로 가세요.

- 모델을 클릭하고(예: lmstudio-community/Meta-Llama-3-8B-Instruct-GGUF) “로드”를 클릭하세요.

3. 모델이 RAM에 로드될 때까지 기다리세요—작은 모델은 몇 초가 걸리고, 큰 모델은 1분 정도 걸릴 수 있습니다.

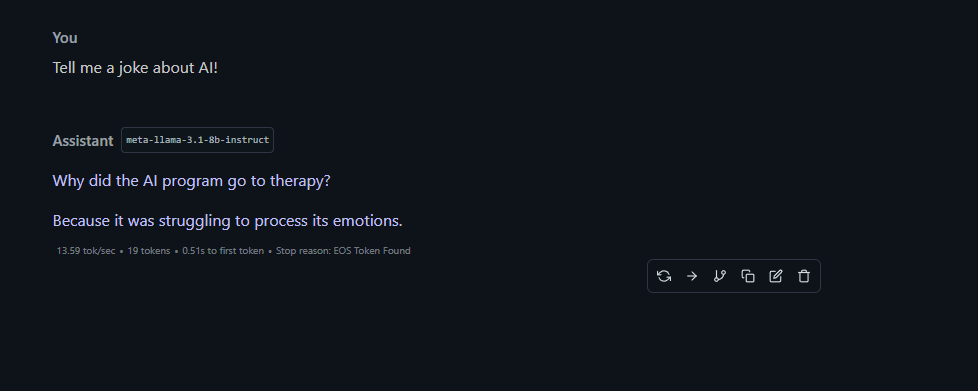

4. 채팅 탭(말풍선 아이콘)으로 전환하세요. 드롭다운에서 로드된 모델을 선택하세요.

5. “AI에 대한 농담 하나 해 줘!”와 같은 재미있는 내용을 입력하세요! 제가 받은 답변은 “왜 AI 프로그램이 치료를 받으러 갔을까요? 감정을 처리하는 데 어려움을 겪어서요.” 나쁘지 않네요, LM Studio!

채팅은 Grok 또는 ChatGPT와 대화하는 것처럼 느껴지지만, 모든 데이터는 로컬에서 처리됩니다—여러분의 단어는 비공개입니다.

3단계: 프롬프트로 놀아보기

LM Studio의 채팅 탭에서는 모델의 동작을 조절할 수 있습니다:

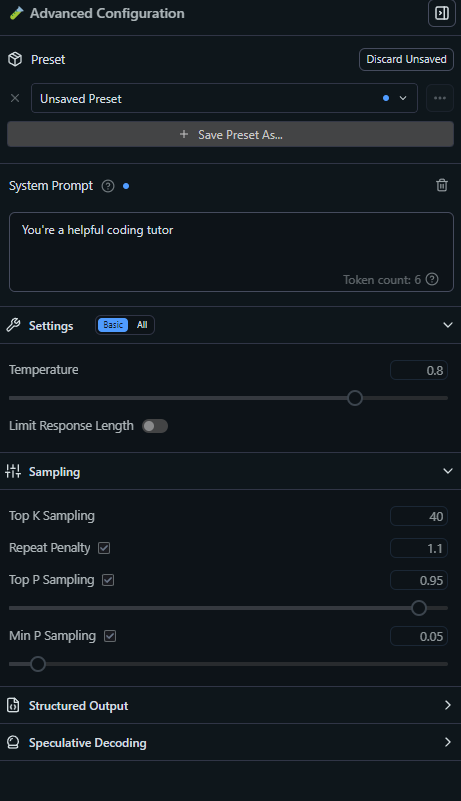

- 시스템 프롬프트: 분위기를 설정하세요. 예: “해적처럼 행동하라!” 기술 도움을 위해 “유용한 코딩 튜터”와 같은 프롬프트를 시도해 보세요.

- 온도: 창의력을 조절합니다(0.7은 균형 잡힌 수준; 1.0은 와일드합니다). 저는 명확한 답변을 위해 0.8을 고수합니다.

- 맥락 길이: 얼마나 많은 이력을 기억하는지를 설정합니다—4096 토큰은 대부분의 채팅에 충분합니다.

놀아 보세요! LM Studio에게 시를 써달라고 하거나, 양자 물리를 설명해 달라고 하거나, 코드를 디버그해 달라고 요청하세요. 여러분의 AI 샌드박스입니다.

LM Studio를 프로젝트에 연결하기 (코더를 위한 보너스)

레벨업하고 싶으신가요? LM Studio는 로컬 OpenAI API처럼 작동하므로 앱이나 스크립트에 연결할 수 있습니다. 코딩에 대한 호기심이 있는 초보자들을 위한 빠른 안내입니다:

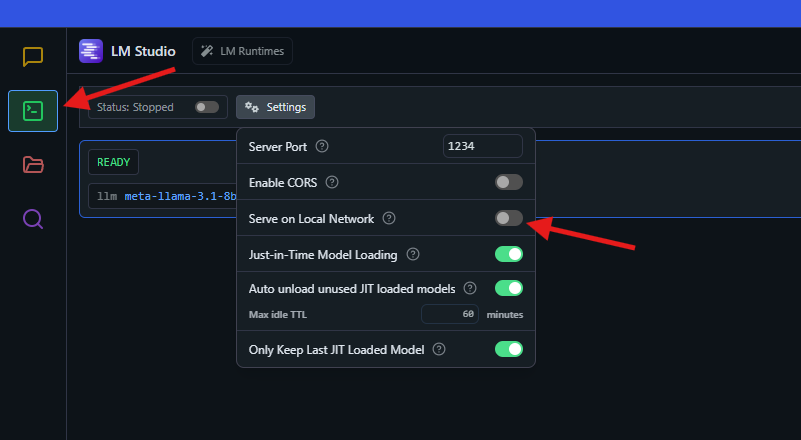

서버 시작하기:

- 개발자 탭(톱니바퀴 아이콘)으로 가서 “서버 시작”을 클릭하세요. 기본적으로 http://localhost:1234에서 실행됩니다.

- 이 설정은 OpenAI의 API를 모방하므로, LangChain과 같은 도구나 맞춤 스크립트가 원활하게 작동합니다.

스크립트로 테스트하기: Node.js가 있다면, 다음과 같은 코드를 시도해 보세요(파일명: test.js로 저장):

const { LMStudioClient } = require("@lmstudio/sdk");

async function main() {

const client = new LMStudioClient();

const model = await client.llm.load("lmstudio-community/Meta-Llama-3-8B-Instruct-GGUF");

const response = await model.respond([

{ role: "user", content: "프랑스의 수도는 어디인가요?" }

]);

for await (const text of response) {

process.stdout.write(text);

}

}

main();SDK 설치: npm install @lmstudio/sdk를 실행한 후: node test.js. 짜잔—LM Studio가 “파리”라고 답합니다.

코드를 작성하지 않으신가요? 걱정하지 마세요—이는 가능한 것의 기초일 뿐입니다. 지금은 채팅 탭에 집중하세요!

LM Studio 구성하기: 나만의 스타일로 만들기

LM Studio는 꽤 직관적이지만, 여러분의 스타일에 맞게 조정할 수 있습니다. 초보자에게 친숙한 옵션은 다음과 같습니다:

- GPU 오프로드: NVIDIA GPU가 있나요? 채팅 탭에서 “GPU 오프로드” 슬라이더를 VRAM이 처리할 수 있는 최대 레이어로 조정하세요(예. 3090의 경우 14). GPU가 없으신가요? 0으로 두세요—CPU만으로도 잘 작동합니다.

- 모델 프리셋: 프롬프트 설정(온도 등)을 채팅 탭에서 프리셋으로 저장합니다. 저는 Python 팁을 위한 ‘CodeHelper’라는 프리셋을 만들었습니다.

- 언어 지원: LM Studio는 영어, 스페인어, 일본어 등 다양한 언어를 지원합니다—전환할 수 있도록 설정을 확인하세요.

.env 파일: 코더의 경우, 외부 서비스를 사용할 때 API 키를 .env 파일에 저장합니다. 예:

LMS_SERVER_PORT=1234프로젝트 폴더에 배치하지만, LM Studio는 기본 사용을 위해서는 거의 필요하지 않습니다.

개발자 탭에서 로깅 또는 사용자 지정 엔드포인트와 같은 고급 기능을 확인할 수 있지만, 초보자로서는 기본값이 아주 좋습니다.

왜 LM Studio가 초보자에게 완벽한가요?

LM Studio가 초보자의 꿈이 되는 이유는 무엇인가요? 편리함과 강력함입니다:

- 코딩 필요 없음: GUI가 너무 친숙해서, 몇 분 만에 모델과 채팅할 수 있었습니다.

- 개인 정보 보호 우선: 데이터가 로컬에 저장됩니다—클라우드 AI에 대해 걱정하는 누구에게나 중요합니다.

- 모델 다양성: 작은 Phi-3부터 대형 Llama까지, 모든 시스템에 맞는 모델이 있습니다.

- 커뮤니티 사랑: X의 게시물들은 “로컬 LLM 실행의 가장 쉬운 방법”이라 부르며, Reddit의 r/LocalLLaMA도 초보자 친화적이라고 동의하고 있습니다.

AI에 대한 훈련 바퀴와 같은 존재입니다—머리 아플 필요 없이 전문가 같은 결과를 얻을 수 있습니다.

결론: 여러분의 LM Studio 모험이 기다립니다

이제 여러분은 LM Studio의 전문가가 되었습니다(혹은 적어도 자신 있는 초보자입니다)! 모델을 다운로드하는 것부터 Llama와 농담을 주고받는 것까지, 로컬 AI의 힘을 풀어냈습니다. LM Studio에게 이야기 작성, 개념 설명, 숙제 도움 요청 또는 짧은 앱 코딩을 시도해 보세요. LM Studio 문서에는 더 많은 팁이 있으며, Discord 커뮤니티도 아이디어로 가득 차 있습니다. 여러분의 첫 번째 AI 프로젝트는 무엇인가요? 챗봇? 시 생성기? API를 다루고 있다면 apidog.com에 들러 스킬을 갈고 닦아보세요.

최대 생산성을 위해 개발 팀이 함께 작업할 수 있는 통합된 올인원 플랫폼을 원하신다면?

Apidog는 모든 요구를 충족하고, Postman을 보다 저렴한 가격으로 대체합니다!