Chạy một mô hình ngôn ngữ lớn (LLM) trên máy tính cá nhân của bạn có nhiều lợi ích. Đầu tiên, bạn có toàn quyền kiểm soát dữ liệu của mình, đảm bảo rằng quyền riêng tư được duy trì. Thứ hai, bạn có thể thử nghiệm mà không phải lo lắng về chi phí gọi API đắt đỏ hoặc phí đăng ký hàng tháng. Hơn nữa, việc triển khai địa phương cung cấp một cách tiếp cận thực hành để tìm hiểu cách các mô hình này hoạt động.

Hơn nữa, khi bạn chạy LLM cục bộ, bạn sẽ tránh được các vấn đề độ trễ mạng và phụ thuộc vào dịch vụ đám mây. Điều này có nghĩa là bạn có thể xây dựng, thử nghiệm và lặp đi lặp lại nhanh hơn, đặc biệt nếu bạn đang làm việc trên các dự án yêu cầu tích hợp chặt chẽ với cơ sở mã của mình.

Hiểu về LLMs: Một Tổng Quan Nhanh

Trước khi chúng ta đi vào các lựa chọn hàng đầu của mình, hãy nhanh chóng đề cập đến LLM là gì. Nói một cách đơn giản, một mô hình ngôn ngữ lớn (LLM) là một mô hình AI đã được đào tạo trên lượng lớn dữ liệu văn bản. Những mô hình này học các mẫu thống kê trong ngôn ngữ, cho phép chúng tạo ra văn bản giống như con người dựa trên các gợi ý bạn cung cấp.

LLMs nằm ở trung tâm của nhiều ứng dụng AI hiện đại. Chúng cung cấp sức mạnh cho các chatbot, trợ lý viết, trình tạo mã, và thậm chí là các tác nhân hội thoại tinh vi. Tuy nhiên, việc chạy những mô hình này - đặc biệt là những mô hình lớn hơn - có thể tiêu tốn nhiều tài nguyên. Đó là lý do tại sao có một công cụ đáng tin cậy để chạy chúng cục bộ lại quan trọng như vậy.

Bằng cách sử dụng các công cụ LLM cục bộ, bạn có thể thử nghiệm với các mô hình mà không cần gửi dữ liệu của mình đến các máy chủ từ xa. Điều này có thể nâng cao cả về bảo mật và hiệu suất. Trong suốt hướng dẫn này, bạn sẽ nhận thấy từ khóa “LLM” được nhấn mạnh khi chúng ta khám phá cách mà mỗi công cụ giúp bạn khai thác những mô hình mạnh mẽ này trên phần cứng của riêng bạn.

Công Cụ #1: Llama.cpp

Llama.cpp có thể được coi là một trong những công cụ phổ biến nhất khi nói đến việc chạy LLMs cục bộ. Được tạo ra bởi Georgi Gerganov và được duy trì bởi một cộng đồng năng động, thư viện C/C++ này được thiết kế để thực hiện suy diễn trên các mô hình như LLaMA và các mô hình khác với các phụ thuộc tối thiểu.

Tại sao bạn sẽ yêu thích Llama.cpp

- Nhẹ và Nhanh: Llama.cpp được thiết kế để có tốc độ và hiệu quả. Với thiết lập tối thiểu, bạn có thể chạy các mô hình phức tạp ngay cả trên phần cứng khiêm tốn. Nó tận dụng các lệnh CPU tiên tiến như AVX và Neon, có nghĩa là bạn có thể khai thác tối đa hiệu suất của hệ thống của mình.

- Hỗ trợ Phần cứng Đa dạng: Cho dù bạn đang sử dụng máy x86, thiết bị dựa trên ARM, hay thậm chí là Mac Apple Silicon, Llama.cpp đều phù hợp với bạn.

- Độ linh hoạt của Dòng lệnh: Nếu bạn thích sử dụng terminal hơn là giao diện đồ họa, công cụ dòng lệnh của Llama.cpp giúp việc tải các mô hình và tạo phản hồi trực tiếp từ shell của bạn trở nên đơn giản.

- Cộng đồng và Nguồn mở: Là một dự án nguồn mở, nó được hưởng lợi từ các đóng góp và cải tiến liên tục của các nhà phát triển trên toàn thế giới.

Cách bắt đầu

- Cài đặt: Nhân bản kho mã từ GitHub và biên dịch mã trên máy của bạn.

- Thiết lập mô hình: Tải về mô hình mà bạn ưa thích (chẳng hạn như một biến thể LLaMA đã định lượng) và sử dụng các tiện ích dòng lệnh được cung cấp để bắt đầu suy diễn.

- Tùy chỉnh: Điều chỉnh các tham số như độ dài ngữ cảnh, nhiệt độ, và kích thước beam để xem cách đầu ra của mô hình thay đổi.

Ví dụ, một lệnh đơn giản có thể trông như thế này:

./main -m ./models/llama-7b.gguf -p "Kể cho tôi một câu chuyện hài về lập trình" --temp 0.7 --top_k 100

Lệnh này tải mô hình và tạo ra văn bản dựa trên gợi ý của bạn. Sự đơn giản của thiết lập này là một điểm cộng lớn cho bất kỳ ai bắt đầu với suy diễn LLM cục bộ.

Chuyển tiếp mượt mà từ Llama.cpp, hãy cùng khám phá một công cụ tuyệt vời khác có cách tiếp cận hơi khác.

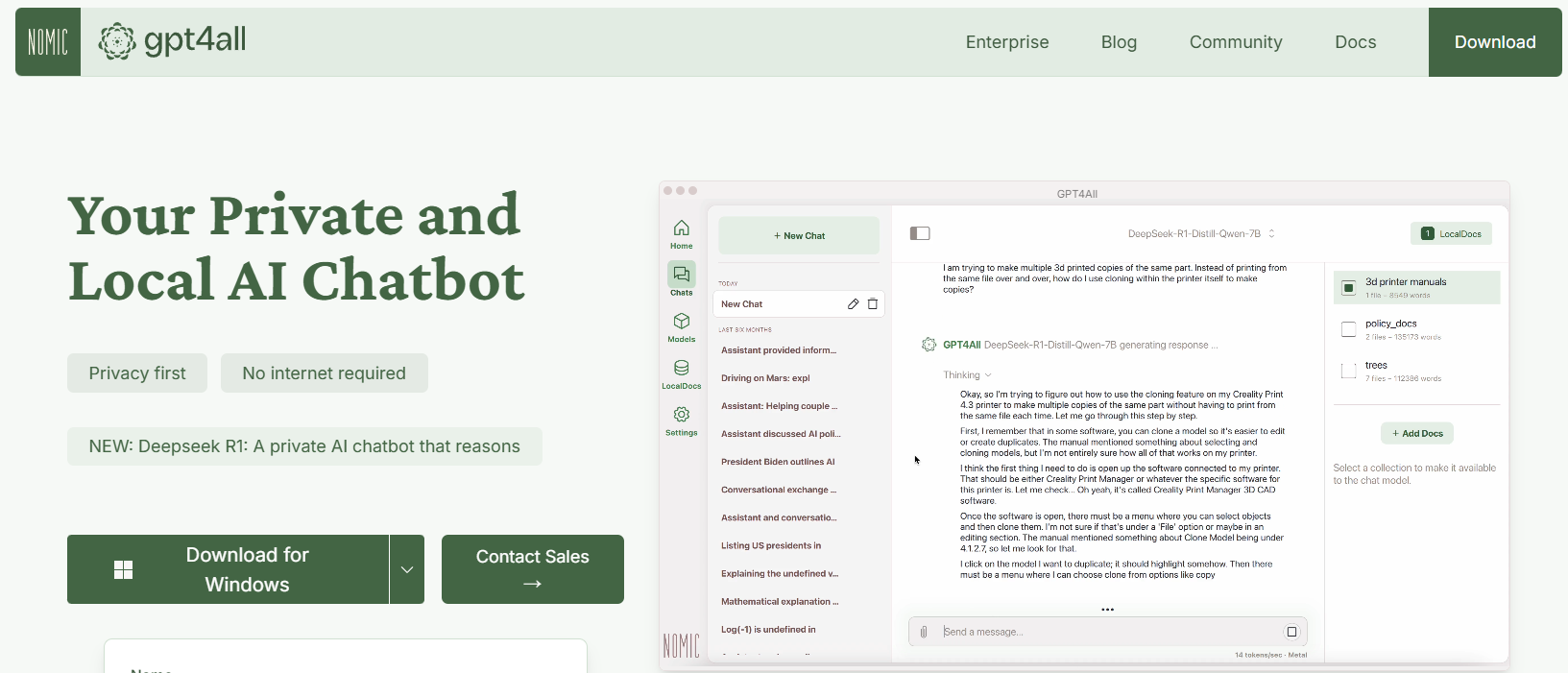

Công Cụ #2: GPT4All

GPT4All là một hệ sinh thái mã nguồn mở được thiết kế bởi Nomic AI nhằm dân chủ hóa việc tiếp cận LLMs. Một trong những điểm thú vị nhất của GPT4All là nó được xây dựng để chạy trên phần cứng tiêu dùng, cho dù bạn đang dùng CPU hay GPU. Điều này làm cho nó trở nên hoàn hảo cho các nhà phát triển muốn thử nghiệm mà không cần các máy móc đắt tiền.

Các Tính Năng Chính của GPT4All

- Cách tiếp cận ưu tiên cục bộ: GPT4All được phát triển để hoàn toàn chạy trên thiết bị của bạn. Điều này có nghĩa là không có dữ liệu nào rời khỏi máy của bạn, đảm bảo quyền riêng tư và thời gian phản hồi nhanh.

- Có thể sử dụng dễ dàng: Ngay cả khi bạn mới làm quen với LLMs, GPT4All đi kèm với giao diện đơn giản, trực quan cho phép bạn tương tác với mô hình mà không cần kiến thức kỹ thuật sâu sắc.

- Nhẹ và Hiệu quả: Các mô hình trong hệ sinh thái GPT4All được tối ưu hóa cho hiệu suất. Bạn có thể chạy chúng trên laptop của mình, giúp chúng dễ tiếp cận với nhiều người hơn.

- Mở và Được điều khiển bới cộng đồng: Với tính mở của nó, GPT4All khuyến khích các đóng góp từ cộng đồng, đảm bảo nó luôn cập nhật với những đổi mới mới nhất.

Bắt đầu với GPT4All

- Cài đặt: Bạn có thể tải GPT4All từ trang web của nó. Quy trình cài đặt rất đơn giản, và các bản nhị phân đã được biên dịch sẵn có cho Windows, macOS và Linux.

- Chạy mô hình: Sau khi cài đặt, chỉ cần mở ứng dụng và chọn từ nhiều mô hình đã được điều chỉnh sẵn. Công cụ này thậm chí cung cấp một giao diện trò chuyện, rất lý tưởng cho việc thử nghiệm không chính thức.

- Tùy chỉnh: Điều chỉnh các tham số như độ dài phản hồi của mô hình và cài đặt sáng tạo để xem cách đầu ra thay đổi. Điều này giúp bạn hiểu cách mà LLMs hoạt động trong các điều kiện khác nhau.

Ví dụ, bạn có thể gõ một gợi ý như:

Một số sự thật thú vị về trí tuệ nhân tạo là gì?

Và GPT4All sẽ tạo ra một phản hồi thân thiện, đầy kiến thức - tất cả đều không cần kết nối internet.

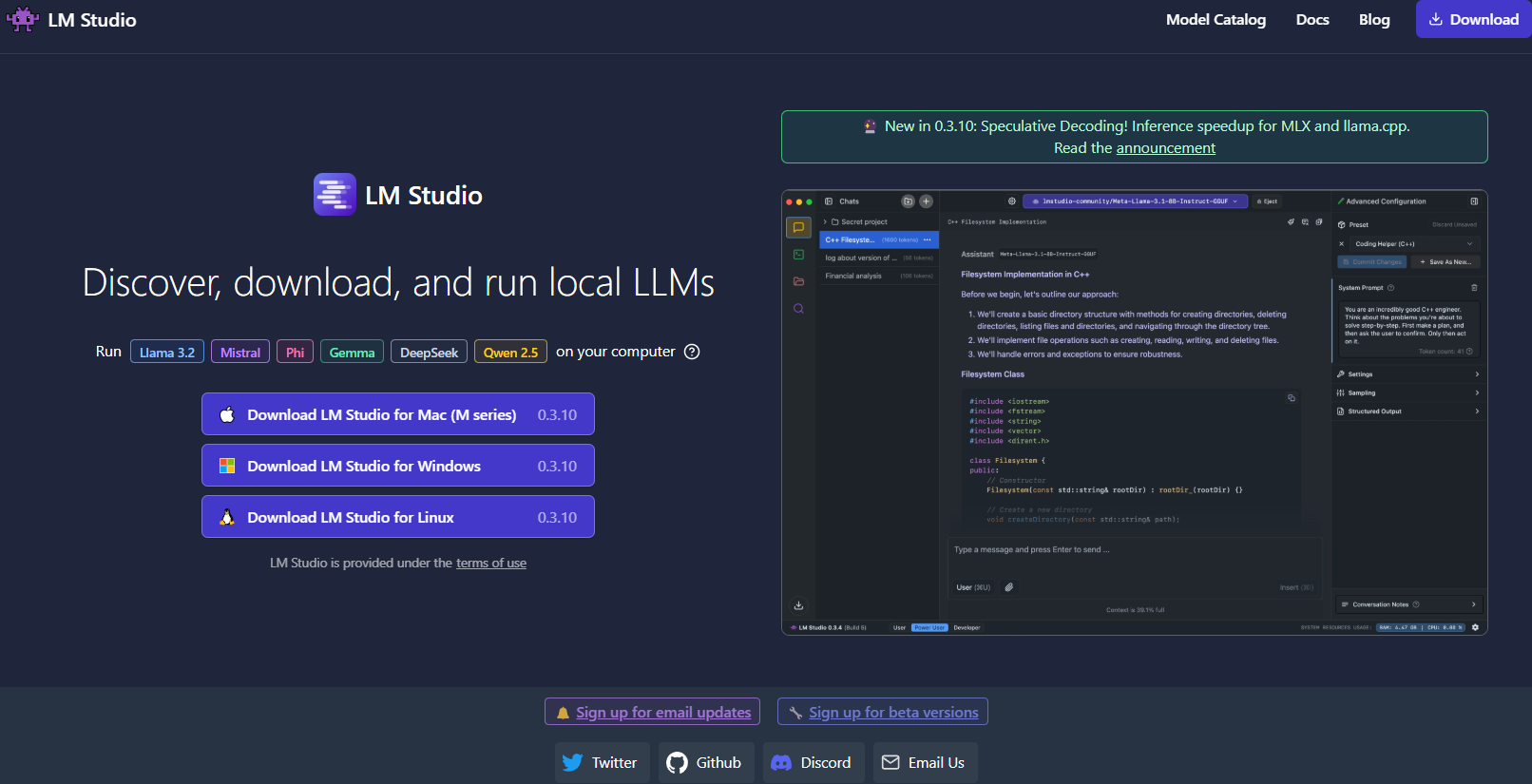

Công Cụ #3: LM Studio

Tiếp theo, LM Studio là một công cụ tuyệt vời khác để chạy LLMs cục bộ, đặc biệt nếu bạn đang tìm kiếm một giao diện đồ họa giúp việc quản lý mô hình trở nên dễ dàng.

Điều gì làm cho LM Studio trở nên khác biệt?

- Giao diện người dùng trực quan: LM Studio cung cấp một ứng dụng máy tính để bàn gọn gàng, thân thiện với người dùng. Điều này rất lý tưởng cho những người không thích làm việc chỉ trên dòng lệnh.

- Quản lý mô hình: Với LM Studio, bạn có thể dễ dàng duyệt, tải xuống và chuyển đổi giữa các LLM khác nhau. Ứng dụng có các bộ lọc và chức năng tìm kiếm tích hợp, vì vậy bạn có thể tìm mô hình hoàn hảo cho dự án của mình.

- Cài đặt có thể tùy chỉnh: Điều chỉnh các tham số như nhiệt độ, số token tối đa và cửa sổ ngữ cảnh trực tiếp từ UI. Vòng phản hồi tức thì này rất lý tưởng cho việc học cách các cấu hình khác nhau ảnh hưởng đến hành vi mô hình.

- Tương thích đa nền tảng: LM Studio chạy trên Windows, macOS và Linux, giúp nó có thể tiếp cận đến nhiều người dùng hơn.

- Máy chủ suy diễn cục bộ: Các nhà phát triển cũng có thể tận dụng máy chủ HTTP cục bộ của nó, mô phỏng API OpenAI. Điều này làm cho việc tích hợp khả năng LLM vào các ứng dụng của bạn trở nên đơn giản hơn nhiều.

Cách thiết lập LM Studio

- Tải xuống và cài đặt: Truy cập trang web LM Studio, tải về trình cài đặt cho hệ điều hành của bạn và làm theo các hướng dẫn cài đặt.

- Mở và khám phá: Mở ứng dụng, khám phá thư viện các mô hình có sẵn và chọn một mô hình phù hợp với nhu cầu của bạn.

- Thử nghiệm: Sử dụng giao diện trò chuyện tích hợp để tương tác với mô hình. Bạn cũng có thể thử nghiệm với nhiều mô hình cùng một lúc để so sánh hiệu suất và chất lượng.

Hãy tưởng tượng bạn đang làm việc trên một dự án viết sáng tạo; giao diện của LM Studio giúp việc chuyển đổi giữa các mô hình và tinh chỉnh đầu ra trong thời gian thực trở nên dễ dàng. Phản hồi bằng hình ảnh và sự dễ sử dụng của nó làm cho nó trở thành lựa chọn mạnh mẽ cho những người mới bắt đầu hoặc cho các chuyên gia cần một giải pháp cục bộ mạnh mẽ.

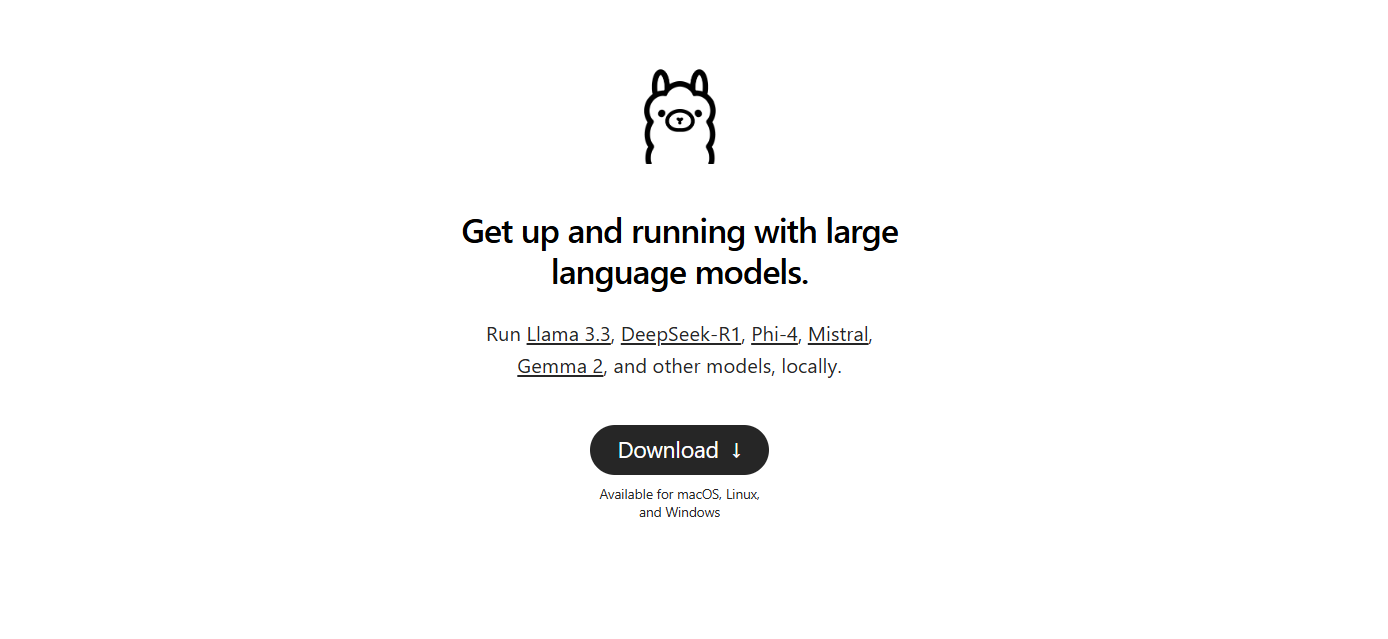

Công Cụ #4: Ollama

Công cụ tiếp theo là Ollama, một công cụ dòng lệnh mạnh mẽ nhưng đơn giản với trọng tâm vào cả tính đơn giản và chức năng. Ollama được thiết kế để giúp bạn chạy, tạo ra và chia sẻ LLM mà không gặp rắc rối với các thiết lập phức tạp.

Tại sao chọn Ollama?

- Triển khai mô hình dễ dàng: Ollama đóng gói tất cả những gì bạn cần - trọng số mô hình, cấu hình và thậm chí cả dữ liệu - vào một đơn vị di động duy nhất được gọi là “Modelfile.” Điều này có nghĩa là bạn có thể nhanh chóng tải xuống và chạy một mô hình với cấu hình tối thiểu.

- Các khả năng đa phương tiện: Không giống như một số công cụ chỉ tập trung vào văn bản, Ollama hỗ trợ đầu vào đa phương tiện. Bạn có thể cung cấp cả văn bản và hình ảnh làm gợi ý, và công cụ sẽ tạo ra các phản hồi xem xét cả hai.

- Độ khả dụng trên nhiều nền tảng: Ollama có sẵn trên macOS, Linux và Windows. Đây là một lựa chọn tuyệt vời cho các nhà phát triển làm việc trên nhiều hệ thống khác nhau.

- Hiệu quả trong dòng lệnh: Đối với những người thích làm việc trong terminal, Ollama cung cấp một giao diện dòng lệnh sạch sẽ, hiệu quả cho phép triển khai và tương tác nhanh chóng.

- Cập nhật nhanh chóng: Công cụ thường xuyên được cộng đồng cập nhật, đảm bảo bạn luôn làm việc với những cải tiến và tính năng mới nhất.

Thiết lập Ollama

1. Cài đặt: Truy cập trang web của Ollama và tải về trình cài đặt cho hệ điều hành của bạn. Việc cài đặt chỉ đơn giản là chạy một vài lệnh trong terminal của bạn.

2. Chạy một mô hình: Sau khi cài đặt, sử dụng một lệnh như:

ollama run llama3

Lệnh này sẽ tự động tải mô hình Llama 3 (hoặc bất kỳ mô hình nào được hỗ trợ khác) và bắt đầu quá trình suy diễn.

3. Thử nghiệm với tính đa phương tiện: Hãy thử chạy một mô hình hỗ trợ hình ảnh. Ví dụ, nếu bạn có một tệp hình ảnh sẵn sàng, bạn có thể kéo và thả nó vào gợi ý của bạn (hoặc sử dụng tham số API cho hình ảnh) để xem cách mà mô hình phản hồi.

Ollama đặc biệt hấp dẫn nếu bạn đang tìm kiếm một cách nhanh chóng để tạo mẫu hoặc triển khai LLM cục bộ. Sự đơn giản của nó không phải đánh đổi với sức mạnh, làm cho nó lý tưởng cho cả những người mới bắt đầu và các nhà phát triển dày dạn kinh nghiệm.

Công Cụ #5: Jan

Cuối cùng nhưng không kém phần quan trọng, chúng ta có Jan. Jan là một nền tảng mã nguồn mở, ưu tiên địa phương đang từ từ trở nên phổ biến trong số những người coi trọng sự riêng tư dữ liệu và hoạt động ngoại tuyến. Triết lý của nó rất đơn giản: cho phép người dùng chạy các LLM mạnh mẽ hoàn toàn trên phần cứng của chính họ, không có các chuyển giao dữ liệu ẩn.

Điều gì làm cho Jan trở nên nổi bật?

- Hoàn toàn ngoại tuyến: Jan được thiết kế để hoạt động mà không cần kết nối internet. Điều này đảm bảo rằng tất cả các tương tác và dữ liệu của bạn đều ở cục bộ, nâng cao quyền riêng tư và bảo mật.

- Tập trung vào người dùng và có thể mở rộng: Công cụ này cung cấp một giao diện sạch sẽ và hỗ trợ một khung ứng dụng/plugin. Điều này có nghĩa là bạn có thể dễ dàng mở rộng khả năng của nó hoặc tích hợp nó với các công cụ hiện có của bạn.

- Thực thi mô hình hiệu quả: Jan được xây dựng để xử lý nhiều loại mô hình khác nhau, bao gồm cả những mô hình được tinh chỉnh cho các nhiệm vụ cụ thể. Nó được tối ưu hóa để chạy ngay cả trên phần cứng khiêm tốn mà không đánh đổi hiệu suất.

- Phát triển được điều khiển bởi cộng đồng: Giống như nhiều công cụ trong danh sách của chúng tôi, Jan là mã nguồn mở và được hưởng lợi từ các đóng góp của một cộng đồng các nhà phát triển tận tâm.

- Không có phí đăng ký: Không giống như nhiều giải pháp dựa trên đám mây, Jan miễn phí sử dụng. Điều này làm cho nó trở thành sự lựa chọn xuất sắc cho các startup, những người đam mê và bất kỳ ai muốn thử nghiệm với các LLM mà không có rào cản tài chính.

Cách bắt đầu với Jan

- Tải xuống và cài đặt: Truy cập trang web chính thức của Jan hoặc kho GitHub của nó. Thực hiện theo các hướng dẫn cài đặt, rất đơn giản và được thiết kế để giúp bạn nhanh chóng khởi động và hoạt động.

- Mở và tùy chỉnh: Mở Jan và chọn từ nhiều mô hình đã được cài đặt sẵn. Nếu cần, bạn có thể nhập các mô hình từ các nguồn bên ngoài như Hugging Face.

- Thử nghiệm và mở rộng: Sử dụng giao diện trò chuyện để tương tác với LLM của bạn. Điều chỉnh các tham số, cài đặt các plugin và xem cách Jan thích nghi với quy trình làm việc của bạn. Sự linh hoạt của nó cho phép bạn tùy chỉnh trải nghiệm LLM cục bộ của mình theo nhu cầu chính xác của bạn.

Jan thực sự thể hiện tinh thần thực thi LLM cục bộ, tập trung vào quyền riêng tư. Nó hoàn hảo cho bất kỳ ai muốn một công cụ có thể tùy chỉnh, không rắc rối mà giữ tất cả dữ liệu trên máy của họ.

Mẹo chuyên nghiệp: Phát trực tiếp các phản hồi LLM bằng cách sử dụng gỡ lỗi SSE

Nếu bạn đang làm việc với các LLM (Mô hình Ngôn ngữ Lớn), việc tương tác theo thời gian thực có thể nâng cao đáng kể trải nghiệm người dùng. Dù đó là một chatbot cung cấp phản hồi trực tiếp hay một công cụ nội dung tự động cập nhật khi dữ liệu được tạo ra, việc phát trực tiếp là rất quan trọng. Các sự kiện do máy chủ gửi (SSE) cung cấp một giải pháp hiệu quả cho điều này, cho phép các máy chủ đẩy cập nhật đến khách hàng qua một kết nối HTTP duy nhất. Không giống như các giao thức hai chiều như WebSockets, SSE đơn giản và dễ thực hiện hơn, làm cho nó trở thành một lựa chọn tuyệt vời cho các tính năng theo thời gian thực.

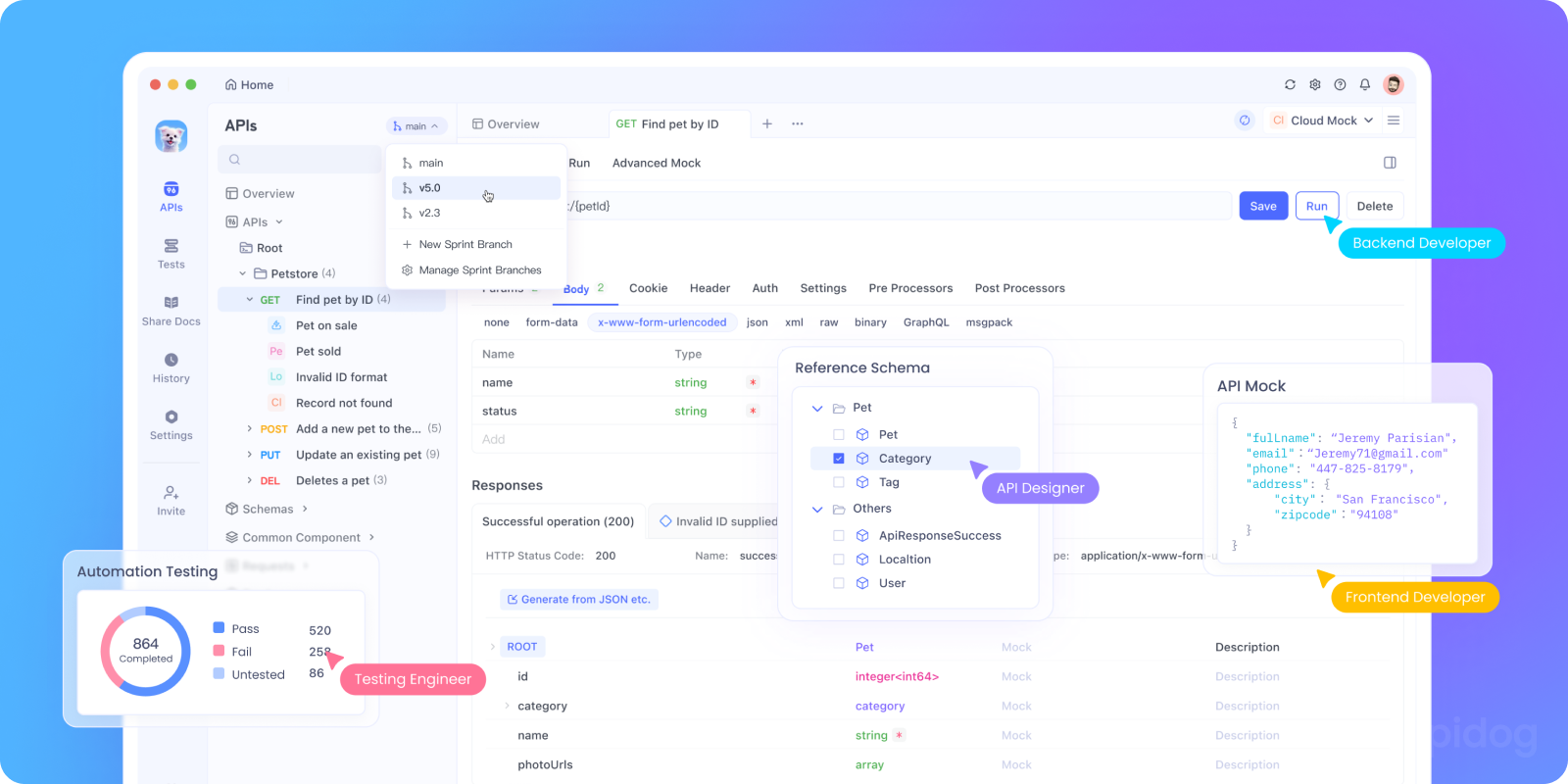

Gỡ lỗi SSE có thể khó khăn. Đó là nơi Apidog phát huy tác dụng. Tính năng gỡ lỗi SSE của Apidog cho phép bạn kiểm tra, giám sát và khắc phục sự cố các luồng SSE dễ dàng. Trong phần này, chúng ta sẽ khám phá lý do tại sao SSE quan trọng cho việc gỡ lỗi API LLM và hướng dẫn bạn từng bước về cách sử dụng Apidog để thiết lập và kiểm tra các kết nối SSE.

Tại sao SSE quan trọng cho việc gỡ lỗi API LLM

Trước khi chúng ta đi vào hướng dẫn, đây là lý do tại sao SSE là một sự phù hợp tuyệt vời để gỡ lỗi API LLM:

- Phản hồi theo thời gian thực: SSE phát dữ liệu khi nó được tạo ra, cho phép người dùng thấy phản hồi diễn ra một cách tự nhiên.

- Tài nguyên sử dụng thấp: Không giống như polling, SSE sử dụng một kết nối duy nhất bền vững, tối thiểu hóa việc sử dụng tài nguyên.

- Dễ dàng sử dụng: SSE tích hợp liền mạch vào các ứng dụng web, yêu cầu thiết lập tối thiểu ở phía khách hàng.

Sẵn sàng thử nghiệm? Hãy thiết lập gỡ lỗi SSE trong Apidog.

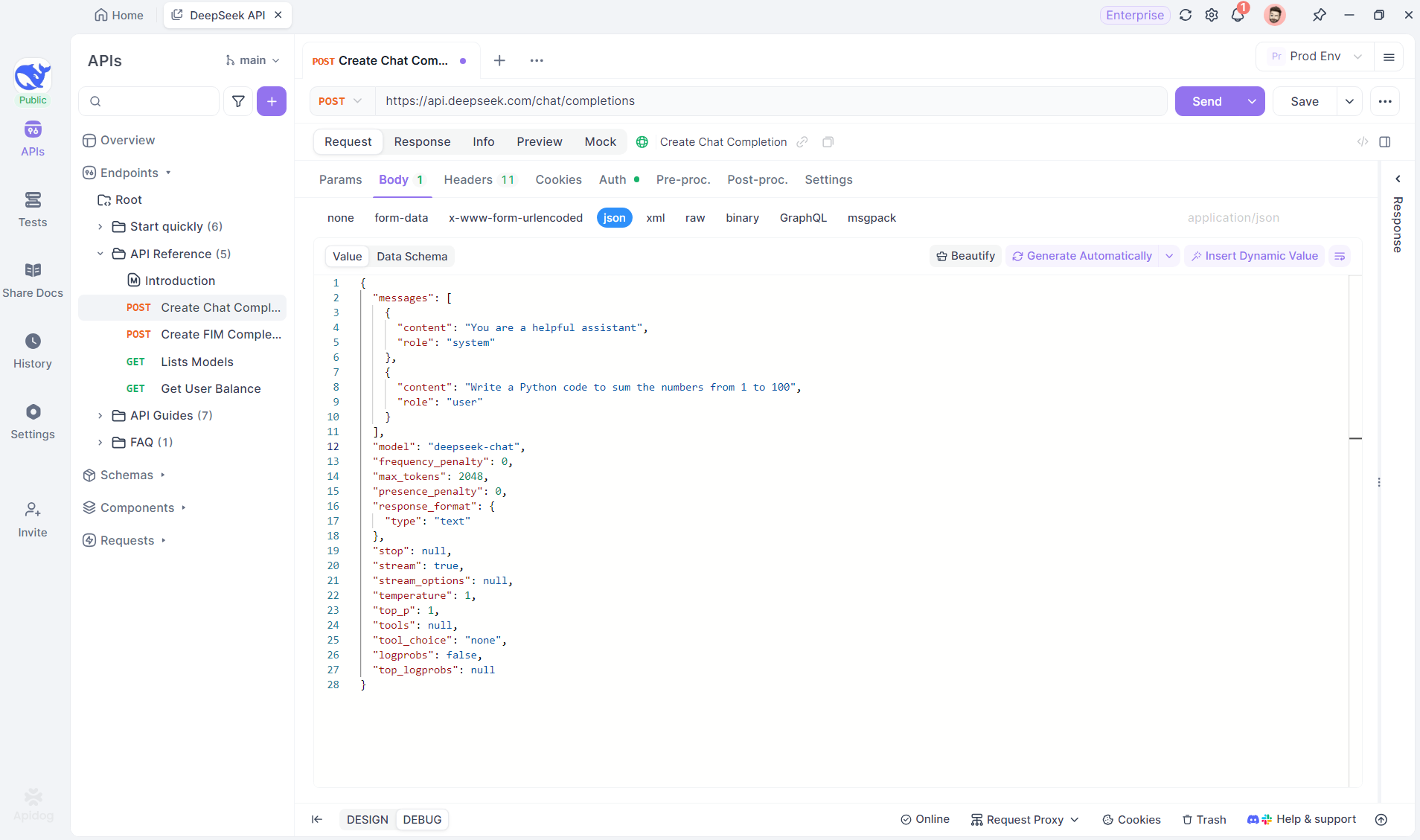

Hướng dẫn từng bước: Sử dụng gỡ lỗi SSE trong Apidog

Thực hiện theo các bước này để cấu hình và kiểm tra một kết nối SSE với Apidog.

Bước 1: Tạo một Điểm cuối mới trong Apidog

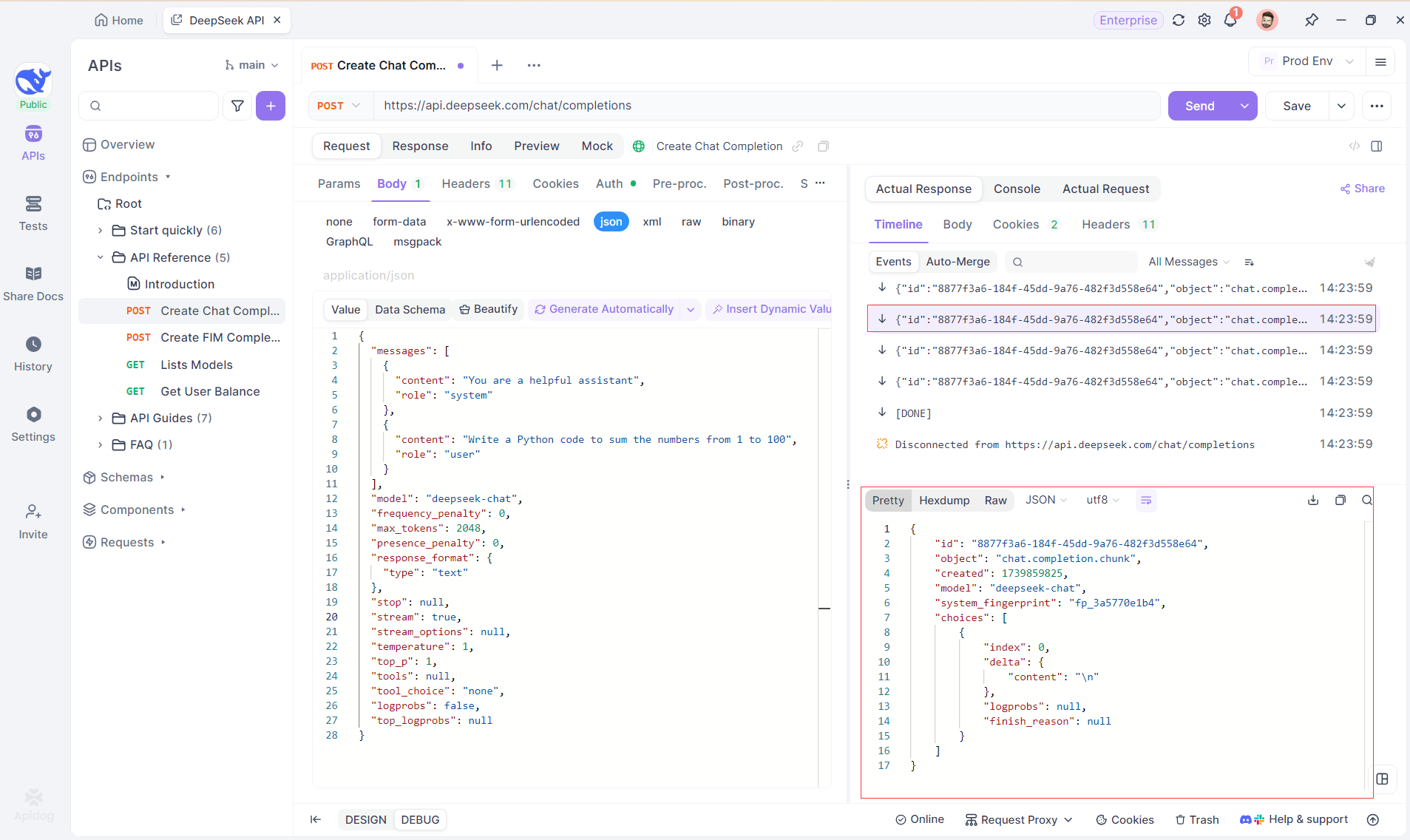

Tạo một dự án HTTP mới trong Apidog để kiểm tra và gỡ lỗi các yêu cầu API. Thêm một điểm cuối với URL của mô hình AI cho luồng SSE - sử dụng DeepSeek trong ví dụ này. (MẸO CHUYÊN NGHIỆP: Nhân bản dự án API DeepSeek đã hoàn chỉnh từ Hub API của Apidog).

Bước 2: Gửi yêu cầu

Sau khi thêm điểm cuối, nhấp vào Gửi để gửi yêu cầu. Nếu header phản hồi bao gồm Content-Type: text/event-stream, Apidog sẽ phát hiện luồng SSE, phân tích dữ liệu và hiển thị theo thời gian thực.

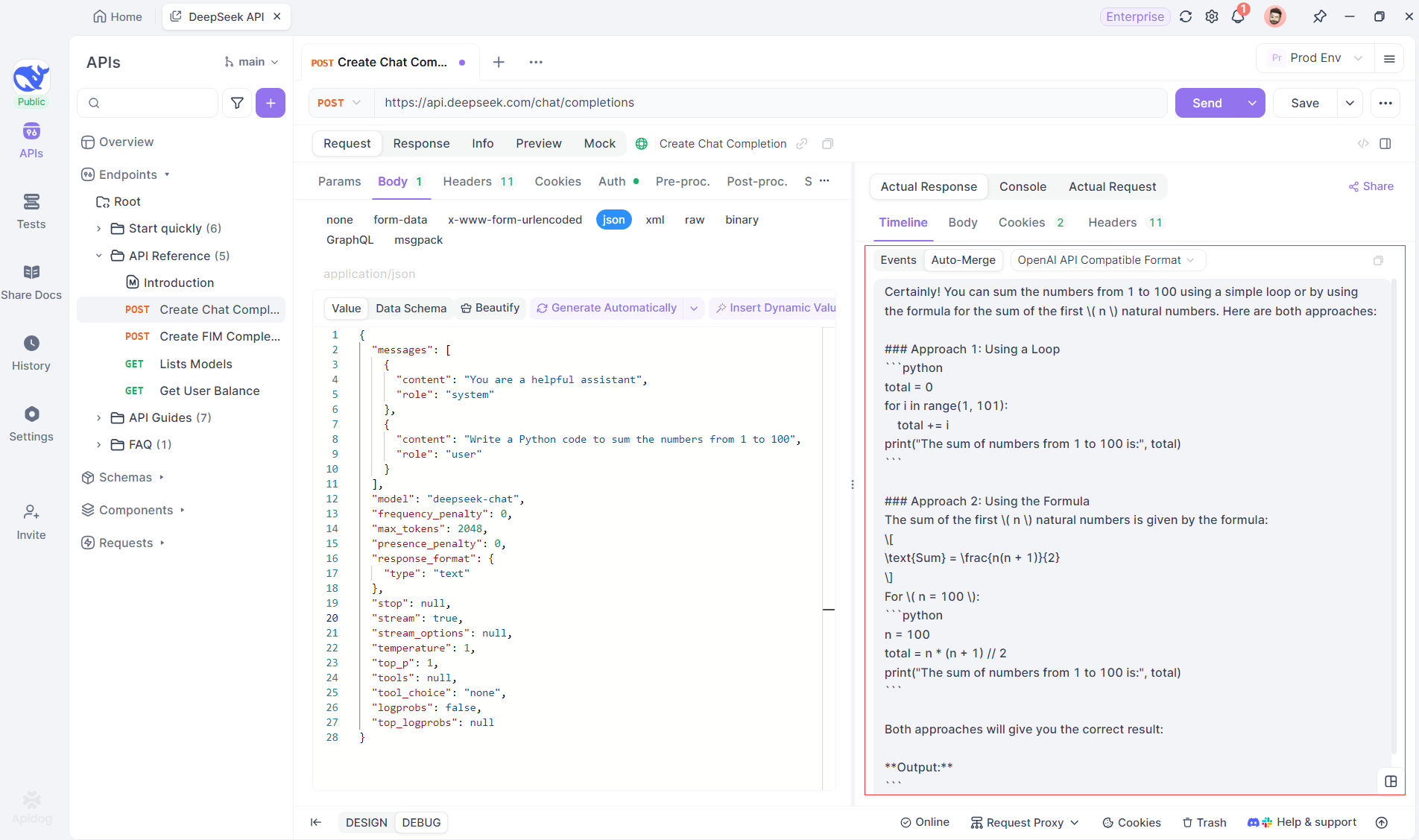

Bước 3: Xem phản hồi theo thời gian thực

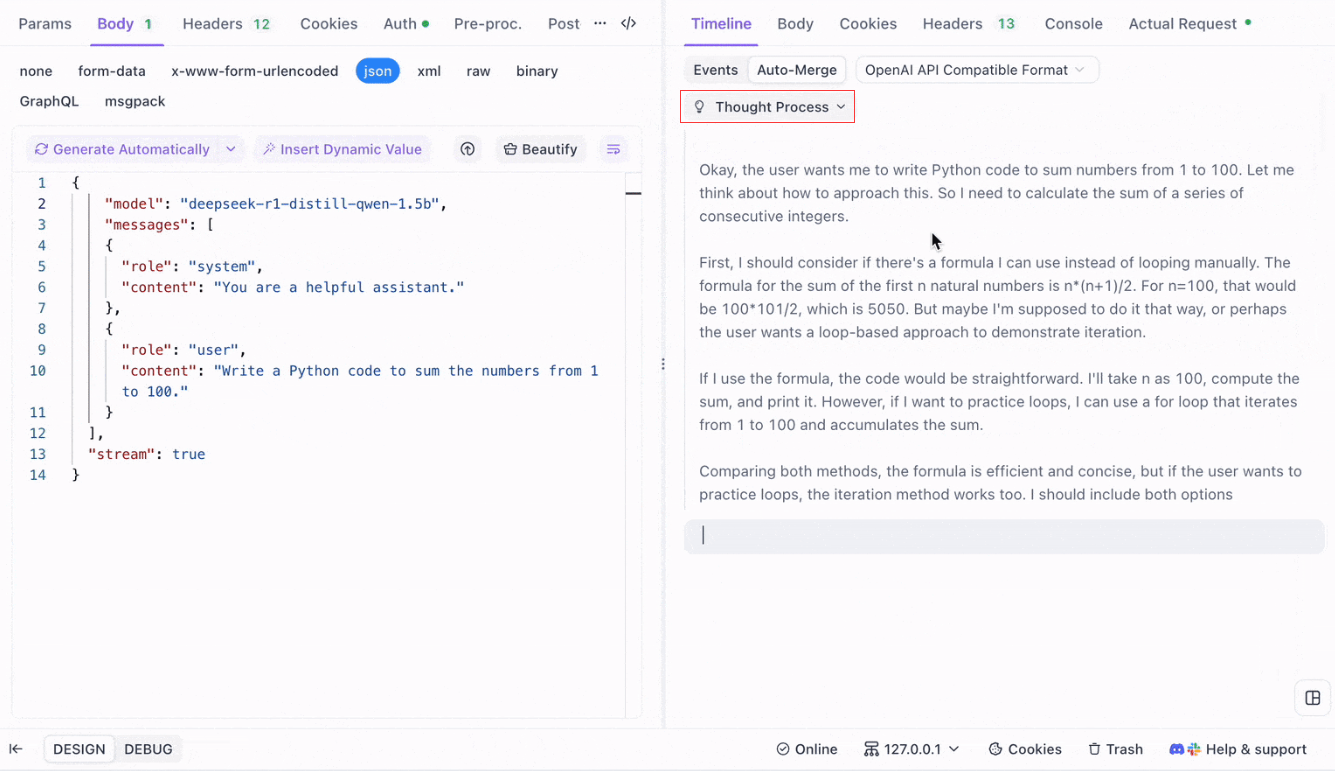

Chế độ xem Dòng thời gian của Apidog cập nhật theo thời gian thực khi mô hình AI phát lại phản hồi, hiển thị mỗi phần một cách động. Điều này cho phép bạn theo dõi quá trình suy nghĩ của AI và thu được những hiểu biết về cách nó tạo ra đầu ra.

Bước 4: Xem phản hồi SSE trong một phản hồi hoàn chỉnh

SSE phát dữ liệu theo các phân đoạn, cần xử lý thêm. Tính năng Tự động hợp nhất của Apidog giải quyết điều này bằng cách tự động kết hợp các phản hồi AI đã bị phân đoạn từ các mô hình như OpenAI, Gemini hoặc Claude thành một đầu ra hoàn chỉnh.

Tính năng Tự động hợp nhất của Apidog loại bỏ việc xử lý dữ liệu thủ công bằng cách tự động kết hợp các phản hồi AI đã bị phân đoạn từ các mô hình như OpenAI, Gemini hoặc Claude.

Đối với các mô hình lý luận như DeepSeek R1, Chế độ xem Dòng thời gian của Apidog trực quan hóa quá trình suy nghĩ của AI, giúp việc gỡ lỗi và hiểu cách các kết luận được hình thành trở nên dễ dàng hơn.

Apidog nhận diện và hợp nhất các phản hồi AI từ:

- Định dạng API OpenAI

- Định dạng API Gemini

- Định dạng API Claude

Khi một phản hồi phù hợp với những định dạng này, Apidog sẽ tự động kết hợp các phần lại với nhau, loại bỏ việc phải ghép nối thủ công và đơn giản hóa việc gỡ lỗi SSE.

Kết luận và các bước tiếp theo

Hôm nay chúng ta đã đề cập đến rất nhiều vấn đề! Để tóm tắt, đây là năm công cụ nổi bật để chạy LLMs cục bộ:

- Llama.cpp: Lý tưởng cho các nhà phát triển muốn một công cụ dòng lệnh nhẹ, nhanh và hiệu quả cao với hỗ trợ phần cứng rộng rãi.

- GPT4All: Một hệ sinh thái ưu tiên cục bộ chạy trên phần cứng tiêu dùng, cung cấp giao diện trực quan và hiệu suất mạnh mẽ.

- LM Studio: Hoàn hảo cho những ai thích giao diện đồ họa, với khả năng quản lý mô hình dễ dàng và tùy chỉnh phong phú.

- Ollama: Một công cụ dòng lệnh mạnh mẽ với các khả năng đa phương tiện và việc đóng gói mô hình liền mạch qua hệ thống “Modelfile” của nó.

- Jan: Một nền tảng mã nguồn mở tập trung vào quyền riêng tư, chạy hoàn toàn ngoại tuyến, cung cấp một khung mở rộng để tích hợp các LLM khác nhau.

Mỗi công cụ này đều mang lại những lợi ích độc đáo, cho dù đó là hiệu suất, dễ sử dụng hay quyền riêng tư. Tùy thuộc vào yêu cầu dự án của bạn, một trong những giải pháp này có thể là lựa chọn hoàn hảo cho nhu cầu của bạn. Điều tuyệt vời của các công cụ LLM cục bộ là chúng cho phép bạn khám phá và thử nghiệm mà không phải lo ngại về rò rỉ dữ liệu, chi phí đăng ký hay độ trễ mạng.

Hãy nhớ rằng việc thử nghiệm với các LLM cục bộ là một quá trình học hỏi. Hãy tự do pha trộn và sử dụng các công cụ này, thử nghiệm các cấu hình khác nhau, và xem cái nào phù hợp nhất với quy trình làm việc của bạn. Ngoài ra, nếu bạn đang tích hợp những mô hình này vào ứng dụng của riêng bạn, các công cụ như Apidog có thể giúp bạn quản lý và kiểm tra các điểm cuối API LLM của bạn bằng cách sử dụng các Sự kiện do máy chủ gửi (SSE) một cách liền mạch. Đừng quên tải Apidog miễn phí và nâng cao trải nghiệm phát triển địa phương của bạn.

Các bước tiếp theo

- Thử nghiệm: Chọn một công cụ từ danh sách của chúng tôi và thiết lập nó trên máy của bạn. Chơi xung quanh với các mô hình và cài đặt khác nhau để hiểu cách mà các thay đổi ảnh hưởng đến đầu ra.

- Tích hợp: Nếu bạn đang phát triển một ứng dụng, hãy sử dụng công cụ LLM cục bộ như một phần của backend của bạn. Nhiều công cụ này cung cấp tính tương thích với API (ví dụ, máy chủ suy diễn cục bộ của LM Studio) giúp việc tích hợp trở nên mượt mà hơn.

- Đóng góp: Hầu hết các dự án này đều là mã nguồn mở. Nếu bạn phát hiện ra một lỗi, một tính năng thiếu, hoặc đơn giản là bạn có ý tưởng cải tiến, hãy cân nhắc đóng góp cho cộng đồng. Đầu vào của bạn có thể giúp làm cho các công cụ này trở nên tốt hơn nữa.

- Tìm hiểu thêm: Tiếp tục khám phá thế giới LLM bằng cách đọc các chủ đề như định lượng mô hình, kỹ thuật tối ưu hóa và kỹ thuật gợi ý. Càng hiểu nhiều, bạn càng có thể khai thác những mô hình này đến tiềm năng tối đa của chúng.

Bây giờ, bạn nên có một nền tảng vững chắc để chọn công cụ LLM cục bộ phù hợp cho các dự án của bạn. Cảnh quan công nghệ LLM đang phát triển nhanh chóng, và việc chạy các mô hình cục bộ là một bước quan trọng để xây dựng các giải pháp AI riêng tư, có khả năng mở rộng và hiệu suất cao.

Khi bạn thử nghiệm với các công cụ này, bạn sẽ phát hiện ra rằng khả năng là vô hạn. Dù bạn đang làm việc trên một chatbot, một trợ lý mã hay một công cụ viết sáng tạo tùy chỉnh, các LLM cục bộ có thể mang lại sự linh hoạt và sức mạnh bạn cần. Chúc bạn có một hành trình vui vẻ và mã hóa thành công!