Chạy các mô hình mã hóa tiên tiến tại chỗ cho phép các nhà phát triển tận dụng AI tiên tiến mà không phụ thuộc vào dịch vụ đám mây. DeepCoder, một mô hình mã hóa mã nguồn mở với 14B tham số, cung cấp hiệu suất xuất sắc tương đương với O3-mini. Khi kết hợp với Ollama, một khung nhẹ để chạy các mô hình ngôn ngữ lớn (LLMs), bạn có thể triển khai DeepCoder trên máy tính của mình một cách hiệu quả. Hướng dẫn kỹ thuật này hướng dẫn bạn qua quá trình, từ cài đặt đến thực thi, đồng thời tích hợp các công cụ như Apidog để kiểm tra API.

DeepCoder là gì?

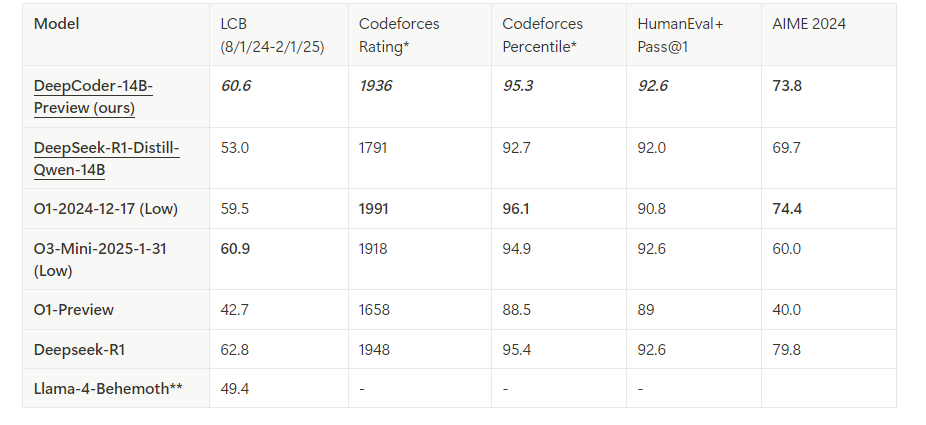

DeepCoder là một mô hình mã hóa mã nguồn mở với 14B tham số được phát triển thông qua sự hợp tác giữa Agentica và Together AI. Được xây dựng bằng cách tinh chỉnh Deepseek-R1-Distilled-Qwen-14B với học tăng cường phân phối (RL), nó xuất sắc trong các tác vụ lý luận và sinh mã. Thêm vào đó, còn có một phiên bản nhỏ hơn 1.5B dành cho các môi trường hạn chế tài nguyên. Khác với các mô hình độc quyền, bản chất mã nguồn mở của DeepCoder cho phép hoàn toàn minh bạch và tùy chỉnh, làm cho nó trở thành lựa chọn yêu thích của các nhà phát triển.

Ollama, mặt khác, đơn giản hóa việc triển khai các LLM như DeepCoder. Nó cung cấp một runtime nhẹ và một API để tích hợp liền mạch vào quy trình phát triển. Bằng cách kết hợp những công cụ này, bạn mở khóa một trợ lý mã hóa mạnh mẽ, chạy tại chỗ.

Các yêu cầu trước khi chạy DeepCoder tại chỗ

Trước khi tiếp tục, hãy đảm bảo hệ thống của bạn đáp ứng các yêu cầu. Đây là những gì bạn cần:

Phần cứng:

- Một máy với ít nhất 32GB RAM (64GB được khuyến nghị cho mô hình 14B).

- Một GPU hiện đại (ví dụ: NVIDIA RTX 3090 hoặc tốt hơn) với 24GB+ VRAM để có hiệu suất tối ưu.

- Hoặc, một CPU với đủ lõi (ví dụ: Intel i9 hoặc AMD Ryzen 9) sẽ hoạt động cho mô hình 1.5B.

Phần mềm:

- Hệ điều hành: Linux (Ubuntu 20.04+), macOS hoặc Windows (qua WSL2).

- Git: Để sao chép các kho lưu trữ.

- Docker (tùy chọn): Để triển khai trong container.

- Python 3.9+: Để lập trình kịch bản và tương tác với API.

Các phụ thuộc:

- Ollama: Đã được cài đặt và cấu hình.

- Tập tin mô hình DeepCoder: Đã tải xuống từ thư viện Ollama chính thức.

Với những điều này, bạn đã sẵn sàng để cài đặt và cấu hình môi trường.

Bước 1: Cài đặt Ollama trên máy của bạn

Ollama đóng vai trò là xương sống cho việc chạy DeepCoder tại chỗ. Thực hiện các bước sau để cài đặt nó:

Tải xuống Ollama:

Truy cập trang web chính thức của Ollama hoặc sử dụng trình quản lý gói. Đối với Linux, thực hiện:

curl -fsSL https://ollama.com/install.sh | sh

Trên macOS, sử dụng Homebrew:

brew install ollama

Xác minh cài đặt:

Kiểm tra phiên bản để xác nhận Ollama đã được cài đặt đúng cách:

ollama --version

Bắt đầu dịch vụ Ollama:

Khởi chạy Ollama ở chế độ nền:

ollama serve &

Điều này chạy máy chủ trên localhost:11434, mở một API cho các tương tác mô hình.

Ollama giờ đã hoạt động. Tiếp theo, bạn sẽ lấy mô hình DeepCoder.

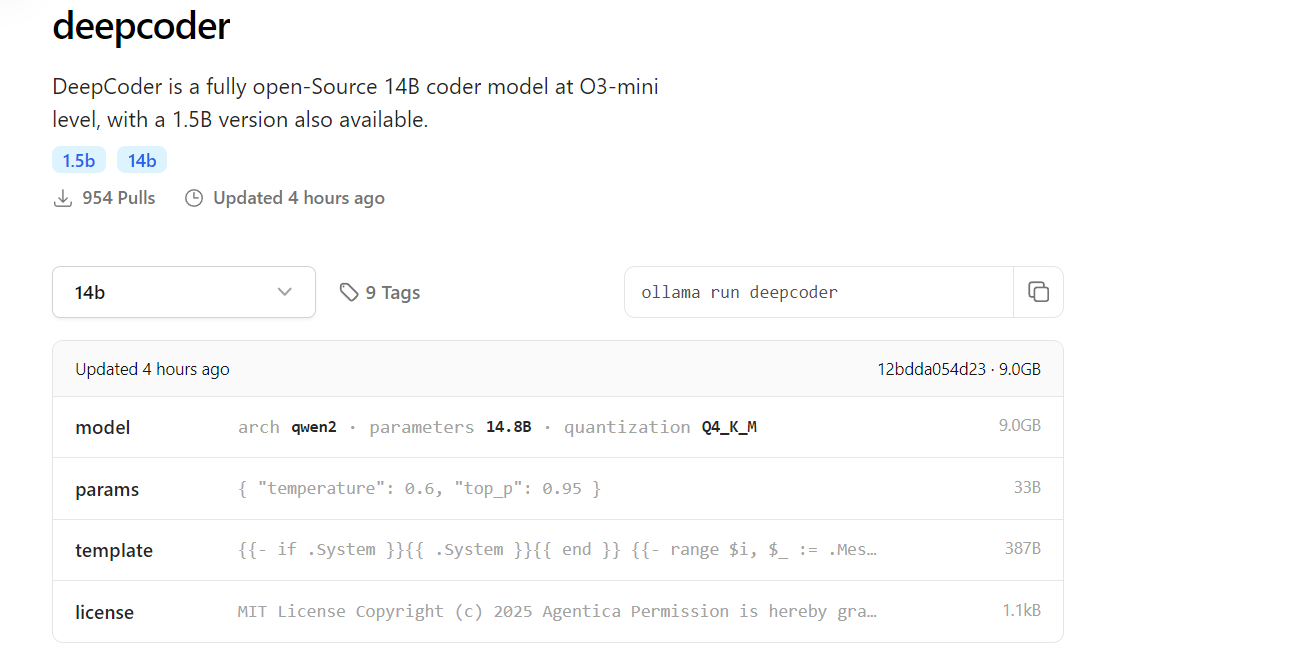

Bước 2: Tải xuống DeepCoder từ thư viện Ollama

DeepCoder có sẵn trong thư viện mô hình Ollama. Đây là cách để kéo nó:

Kéo DeepCoder:

Tải xuống mô hình 14B (hoặc 1.5B cho các thiết lập nhẹ hơn):

ollama pull deepcoder

Lệnh này kéo phiên bản đã đánh dấu mới nhất. Để sử dụng một nhãn cụ thể, hãy dùng:

ollama pull deepcoder:14b-preview

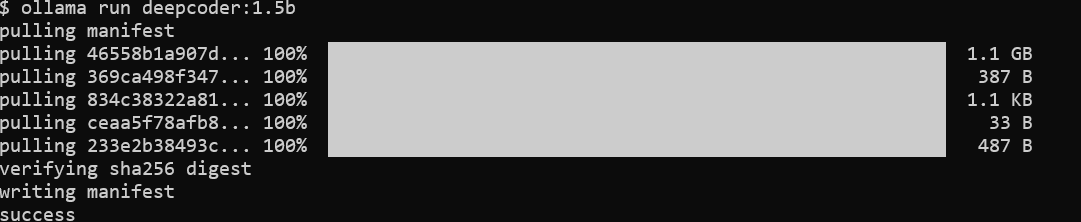

Theo dõi tiến độ tải xuống:

Quá trình sẽ phát trực tiếp các bản cập nhật, hiển thị tình trạng tệp và trạng thái hoàn thành. Kỳ vọng một tải xuống nhiều gigabyte cho mô hình 14B, vì vậy hãy đảm bảo kết nối internet ổn định.

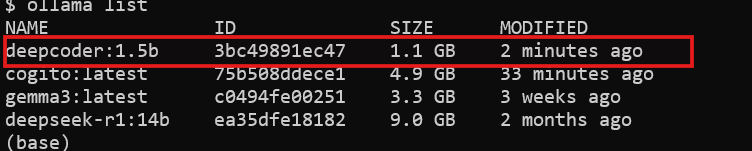

Xác minh cài đặt:

Kiểm tra xem DeepCoder đã có sẵn chưa:

ollama list

Bạn sẽ thấy deepcoder được liệt kê trong số các mô hình đã cài đặt.

Với DeepCoder đã được tải xuống, bạn đã sẵn sàng để chạy nó.

Bước 3: Chạy DeepCoder tại chỗ với Ollama

Bây giờ, hãy thực thi DeepCoder và kiểm tra khả năng của nó:

Bắt đầu DeepCoder:

Khởi chạy mô hình trong một phiên tương tác:

ollama run deepcoder

Điều này mở ra một dấu nhắc nơi bạn có thể nhập các truy vấn mã hóa.

Điều chỉnh tham số (Tùy chọn):

Đối với việc sử dụng nâng cao, điều chỉnh các cài đặt như nhiệt độ thông qua tệp cấu hình hoặc gọi API (sẽ được đề cập sau).

DeepCoder bây giờ đang chạy tại chỗ. Tuy nhiên, để tích hợp nó vào quy trình làm việc, bạn sẽ sử dụng API của nó.

Bước 4: Tương tác với DeepCoder qua API của Ollama

Ollama cung cấp một API RESTful cho quyền truy cập lập trình. Đây là cách để tận dụng nó:

Kiểm tra tính khả dụng của API:

Đảm bảo máy chủ Ollama đang chạy:

curl http://localhost:11434

Một phản hồi xác nhận máy chủ đang hoạt động.

Gửi một yêu cầu:

Sử dụng curl để truy vấn DeepCoder:

curl http://localhost:11434/api/generate -d '{

"model": "deepcoder",

"prompt": "Tạo một endpoint API REST trong Flask",

"stream": false

}'

Phản hồi bao gồm mã được tạo, chẳng hạn như:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['GET'])

def get_data():

return jsonify({"message": "Xin chào, Thế giới!"})

if __name__ == "__main__":

app.run(debug=True)

Tích hợp với Python:

Sử dụng thư viện requests của Python để tương tác sạch sẽ hơn:

import requests

url = "http://localhost:11434/api/generate"

payload = {

"model": "deepcoder",

"prompt": "Viết một API Express Node.js",

"stream": False

}

response = requests.post(url, json=payload)

print(response.json()["response"])

API mở ra tiềm năng của DeepCoder cho tự động hóa và tích hợp.

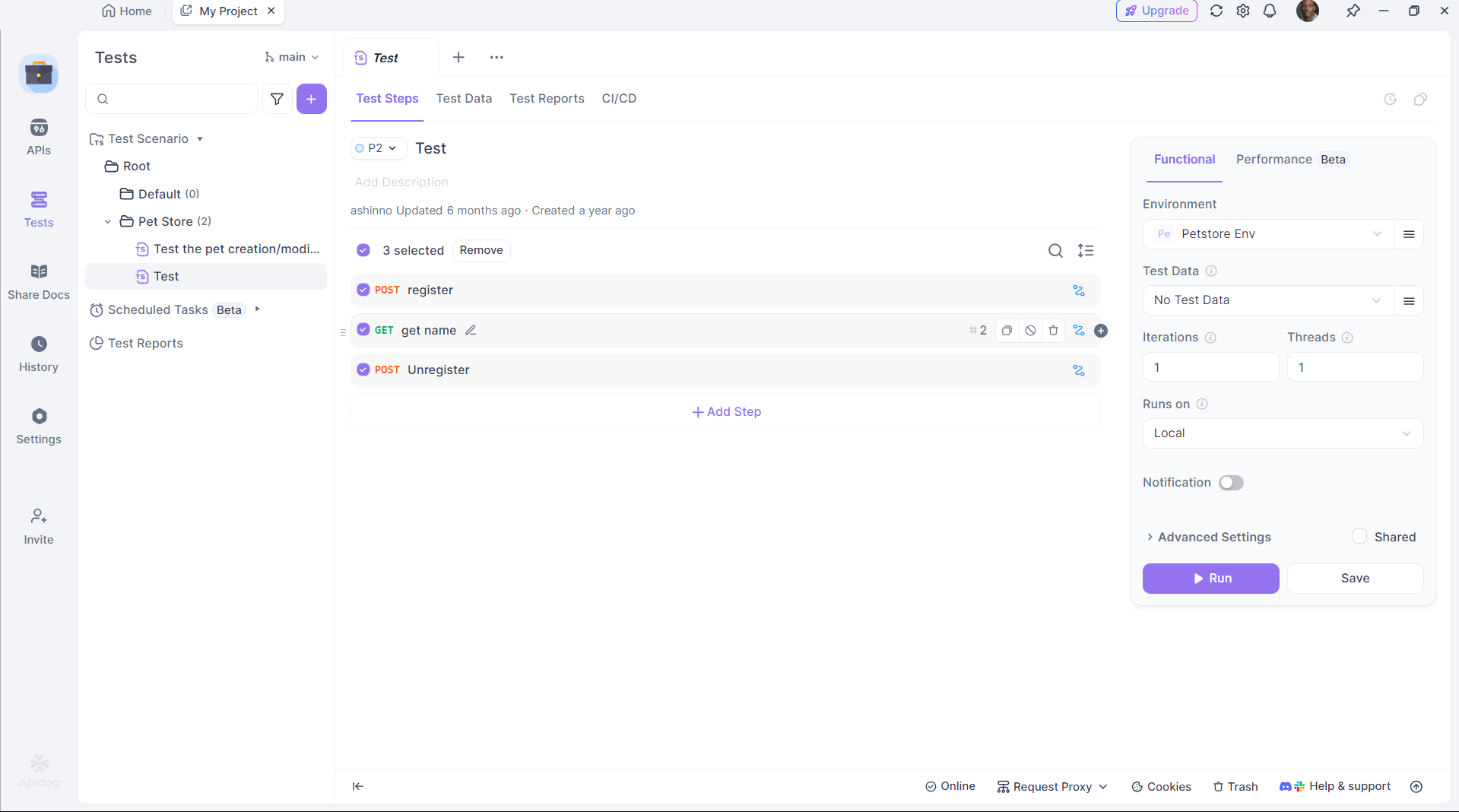

Bước 5: Nâng cao kiểm tra API với Apidog

DeepCoder xuất sắc trong việc tạo mã API, nhưng việc kiểm tra các API đó là điều quan trọng. Apidog đơn giản hóa quy trình này:

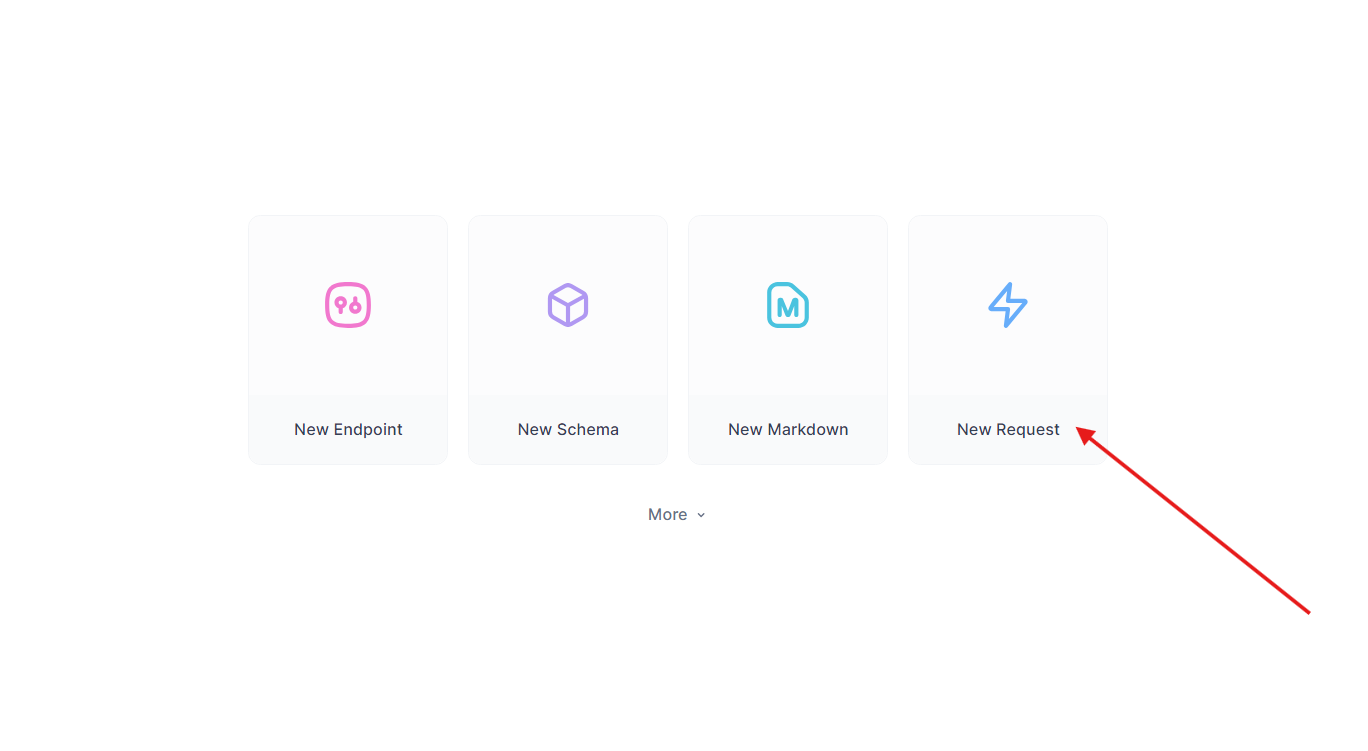

Cài đặt Apidog:

Tải xuống và cài đặt Apidog từ trang chính thức của nó.

Kiểm tra API được tạo ra:

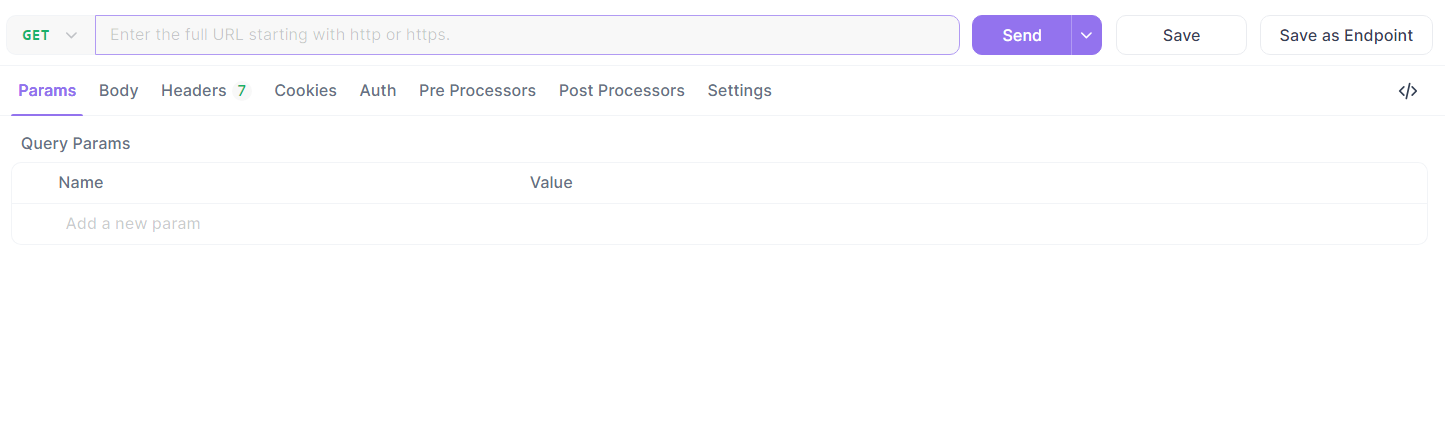

Prend tiếp endpoint Flask từ trước. Trong Apidog:

- Tạo một yêu cầu mới.

- Đặt URL thành

http://localhost:5000/api/datavà Gửi một yêu cầu GET.

- Xác minh phản hồi:

{"message": "Xin chào, Thế giới!"}.

Tự động hóa kiểm tra:

Sử dụng kịch bản của Apidog để tự động hóa xác thực, đảm bảo đầu ra của DeepCoder đáp ứng mong đợi.

Apidog kết nối khoảng cách giữa việc tạo mã và triển khai, nâng cao năng suất.

Bước 6: Tối ưu hóa hiệu suất của DeepCoder

Để tối đa hóa hiệu quả, hãy tinh chỉnh cài đặt của DeepCoder:

Tăng tốc GPU:

Đảm bảo Ollama chuyển tải tính toán cho GPU của bạn. Kiểm tra với:

nvidia-smi

Việc sử dụng GPU cho thấy tăng tốc thành công.

Quản lý bộ nhớ:

Đối với mô hình 14B, phân bổ đủ VRAM. Điều chỉnh không gian hoán đổi trên Linux nếu cần:

sudo fallocate -l 32G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

Định lượng mô hình:

Sử dụng định lượng nhỏ hơn (ví dụ: 4-bit) cho mô hình 1.5B:

ollama pull deepcoder:1.5b-q4

Các điều chỉnh này đảm bảo DeepCoder chạy mượt mà trên phần cứng của bạn.

Tại sao nên chọn DeepCoder với Ollama?

Chạy DeepCoder tại chỗ mang lại những lợi thế rõ ràng:

- Bảo mật: Giữ mã nhạy cảm ra khỏi máy chủ đám mây.

- Chi phí: Tránh các khoản phí đăng ký.

- Tùy chỉnh: Tùy chỉnh mô hình theo nhu cầu của bạn.

Kết hợp nó với khung nhẹ của Ollama và khả năng kiểm tra của Apidog tạo ra một hệ sinh thái phát triển mạnh mẽ, độc lập.

Kết luận

Cài đặt DeepCoder tại chỗ với Ollama thật đơn giản nhưng mang tính chuyển đổi. Bạn cài đặt Ollama, kéo DeepCoder, chạy nó, và tích hợp nó qua API—tất cả chỉ trong vài bước. Các công cụ như Apidog còn nâng cao trải nghiệm bằng cách đảm bảo các API được tạo ra hoạt động hoàn hảo. Cho dù bạn là một nhà phát triển độc lập hay một phần của một nhóm, thiết lập này mang lại một trợ lý mã hóa mã nguồn mở mạnh mẽ.