고급 코딩 모델을 로컬에서 실행하면 개발자들이 클라우드 서비스에 의존하지 않고 최첨단 AI를 활용할 수 있습니다. DeepCoder는 완전히 오픈 소스인 14B 파라미터 코딩 모델로, O3-mini와 유사한 뛰어난 성능을 제공합니다. Ollama와 함께 사용하면 대형 언어 모델(LLM)을 효율적으로 로컬 컴퓨터에 배포할 수 있습니다. 이 기술 가이드는 설정에서 실행까지의 모든 과정을 안내하며, API 테스트를 위한 Apidog와 같은 도구를 통합합니다.

DeepCoder란 무엇인가요?

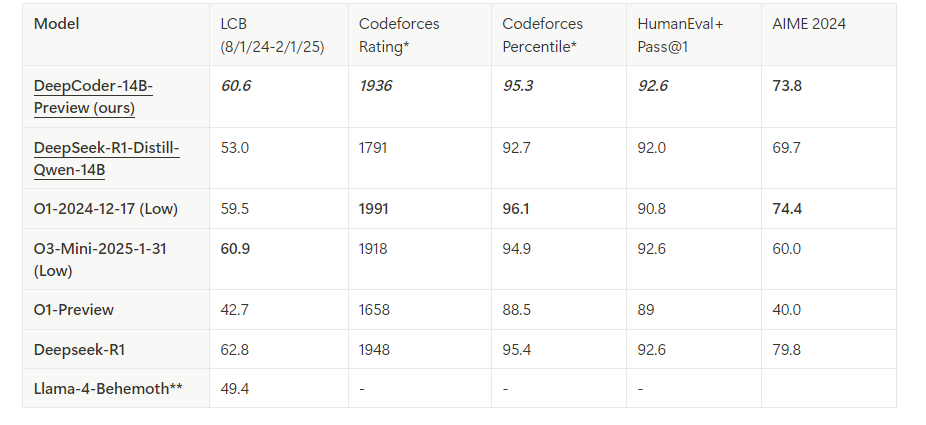

DeepCoder는 Agentica와 Together AI의 협력으로 개발된 14B 파라미터 오픈 소스 코딩 모델입니다. 분산 강화 학습(RL)을 통해 Deepseek-R1-Distilled-Qwen-14B를 미세 조정하여 구축되었으며, 코드 추론 및 생성 작업에서 탁월한 성능을 보입니다. 또한, 리소스가 제한된 환경에서도 사용할 수 있는 더 작은 1.5B 버전도 존재합니다. 독점 모델과 달리 DeepCoder는 오픈 소스의 특성 덕분에 완전한 투명성과 사용자화를 지원하여 개발자들에게 사랑받고 있습니다.

Ollama는 DeepCoder와 같은 LLM을 간편하게 배포할 수 있도록 돕습니다. 경량 실행 환경과 개발 워크플로우에 매끄럽게 통합할 수 있는 API를 제공합니다. 이러한 도구를 결합하면 강력한 로컬 코딩 도우미를 활용할 수 있습니다.

DeepCoder 로컬 실행을 위한 전제 조건

진행하기 전에 시스템이 요구 사항을 충족하는지 확인하세요. 필요한 사항은 다음과 같습니다:

하드웨어:

- 최소 32GB RAM이 장착된 기계(14B 모델은 64GB 권장).

- 최적의 성능을 위해 24GB 이상의 VRAM을 가진 최신 GPU(예: NVIDIA RTX 3090 이상).

- 대안으로, 충분한 코어를 가진 CPU(예: Intel i9 또는 AMD Ryzen 9)를 사용할 수 있습니다.

소프트웨어:

- 운영 체제: Linux (Ubuntu 20.04 이상), macOS 또는 Windows (WSL2를 통해).

- Git: 리포지토리를 복제하기 위한 도구.

- Docker(선택 사항): 컨테이너 기반 배포를 위한 도구.

- Python 3.9 이상: 스크립팅 및 API 상호작용을 위한 언어.

의존성:

- Ollama: 설치 및 구성되어 있어야 합니다.

- DeepCoder 모델 파일: 공식 Ollama 라이브러리에서 다운로드.

이 모든 것이 준비되었다면, 환경을 설치하고 구성할 준비가 된 것입니다.

1단계: 컴퓨터에 Ollama 설치하기

Ollama는 DeepCoder를 로컬에서 실행하기 위한 기반 역할을 합니다. 다음 단계를 따라 설치하세요:

Ollama 다운로드:

공식 Ollama 웹사이트를 방문하거나 패키지 관리자를 사용하세요. Linux의 경우, 다음 명령어를 실행합니다:

curl -fsSL https://ollama.com/install.sh | sh

macOS에서는 Homebrew를 사용하세요:

brew install ollama

설치 확인:

Ollama가 제대로 설치되었는지 확인하기 위해 버전을 체크합니다:

ollama --version

Ollama 서비스 시작:

Ollama를 백그라운드에서 실행합니다:

ollama serve &

이 명령어는 localhost:11434에서 서버를 실행하며, 모델 상호작용을 위한 API를 노출합니다.

이제 Ollama가 작동 중입니다. 다음 단계로는 DeepCoder 모델을 가져옵니다.

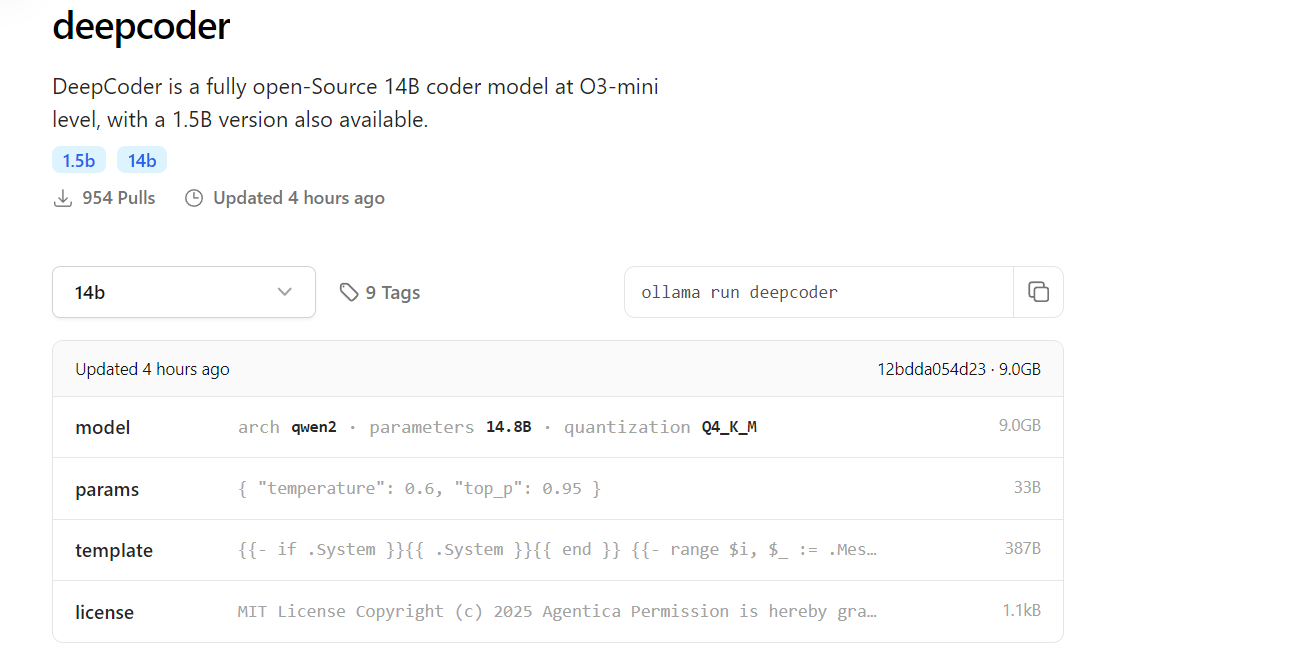

2단계: Ollama 라이브러리에서 DeepCoder 다운로드

DeepCoder는 Ollama 모델 라이브러리에서 사용할 수 있습니다. 다음과 같이 다운로드하세요:

DeepCoder 다운로드:

14B 모델(또는 더 가벼운 설정을 위한 1.5B 모델)을 다운로드합니다:

ollama pull deepcoder

이 명령어는 최신 태그가 있는 버전을 가져옵니다. 특정 태그를 지정하려면 다음 명령어를 사용하세요:

ollama pull deepcoder:14b-preview

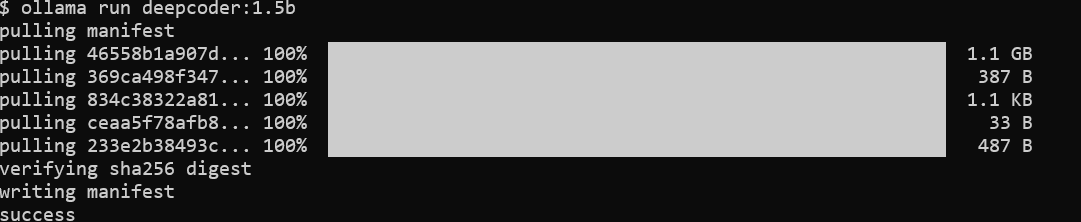

다운로드 진행 상황 모니터링:

과정이 업데이트를 스트리밍하며 파일 해시와 완료 상태를 보여줍니다. 14B 모델의 경우 여러 기가바이트의 다운로드가 예상되므로 안정적인 인터넷 연결을 확보하세요.

설치 확인:

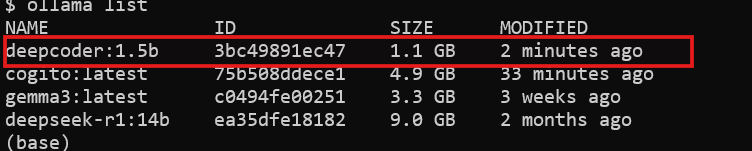

DeepCoder가 사용 가능한지 확인합니다:

ollama list

설치된 모델 목록에서 deepcoder를 확인할 수 있습니다.

DeepCoder가 다운로드되었으므로 이를 실행할 준비가 되었습니다.

3단계: Ollama로 DeepCoder 로컬 실행하기

이제 DeepCoder를 실행하고 그 기능을 테스트합니다:

DeepCoder 시작:

모델을 대화식 세션에서 실행합니다:

ollama run deepcoder

이 명령어는 코딩 쿼리를 입력할 수 있는 프롬프트를 엽니다.

매개변수 조정(선택 사항):

고급 사용을 위해 설정 파일이나 API 호출을 통해 온도와 같은 설정을 조정할 수 있습니다(자세한 내용은 나중에 다룹니다).

이제 DeepCoder가 로컬에서 실행되고 있습니다. 그러나 워크플로에 통합하기 위해 API를 사용해야 합니다.

4단계: Ollama API를 통해 DeepCoder와 상호작용하기

Ollama는 프로그래밍 방식으로 접근할 수 있는 RESTful API를 노출합니다. 이를 활용하는 방법은 다음과 같습니다:

API 가용성 확인:

Ollama 서버가 실행되고 있는지 확인합니다:

curl http://localhost:11434

응답이 서버가 활성화되어 있음을 확인합니다.

요청 전송:curl을 사용하여 DeepCoder에 쿼리합니다:

curl http://localhost:11434/api/generate -d '{

"model": "deepcoder",

"prompt": "Generate a REST API endpoint in Flask",

"stream": false

}'

응답에는 다음과 같은 생성된 코드가 포함됩니다:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['GET'])

def get_data():

return jsonify({"message": "Hello, World!"})

if __name__ == "__main__":

app.run(debug=True)

Python과 통합:

Python의 requests 라이브러리를 사용하여 보다 깔끔하게 상호작용합니다:

import requests

url = "http://localhost:11434/api/generate"

payload = {

"model": "deepcoder",

"prompt": "Write a Node.js Express API",

"stream": False

}

response = requests.post(url, json=payload)

print(response.json()["response"])

API를 활용하면 DeepCoder의 자동화 및 통합 가능성을 극대화할 수 있습니다.

5단계: Apidog로 API 테스트 향상하기

DeepCoder는 API 코드를 생성하는 데 뛰어나지만, 해당 API를 테스트하는 것은 매우 중요합니다. Apidog가 이 과정을 간소화합니다:

Apidog 설치:

공식 사이트에서 Apidog를 다운로드하고 설치하세요.

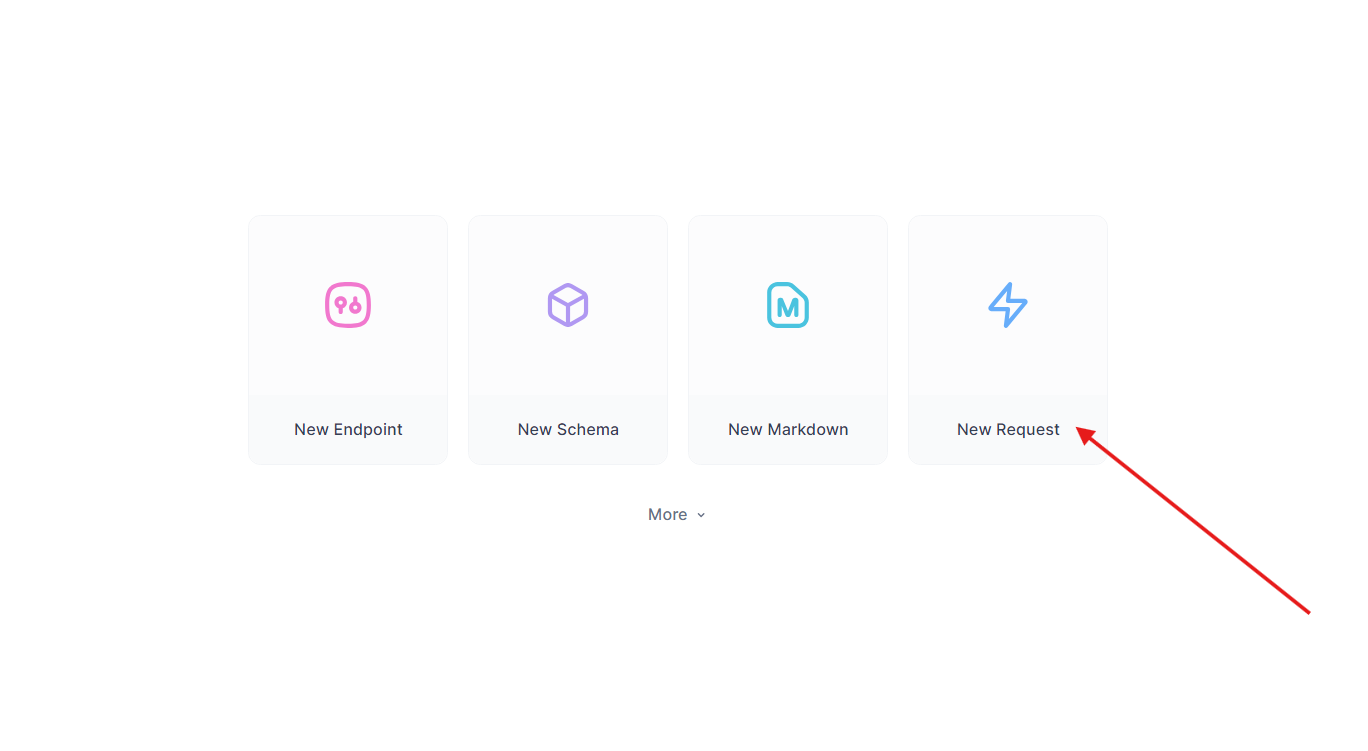

생성된 API 테스트:

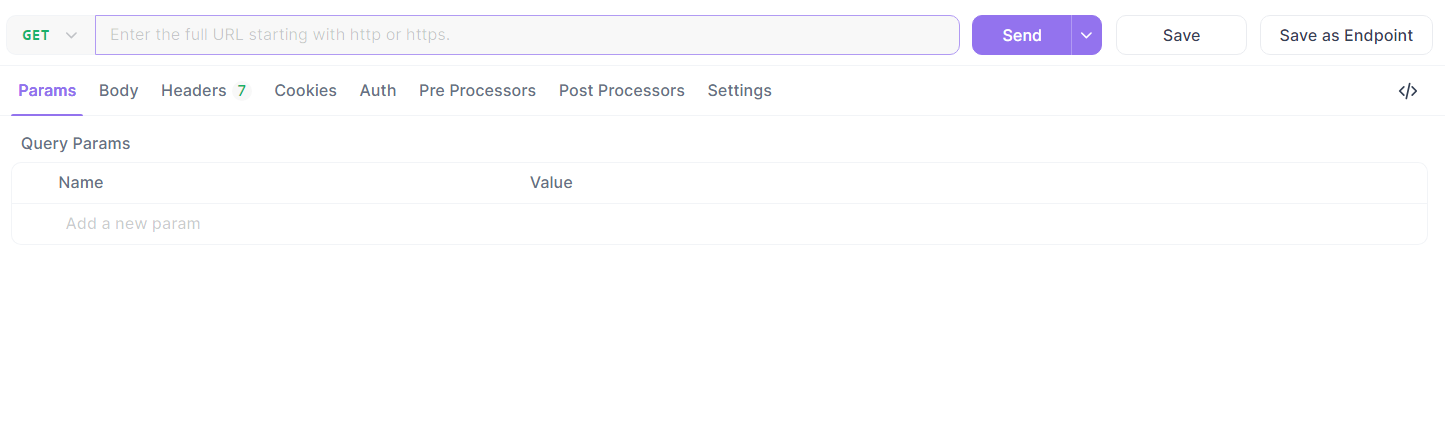

앞서 만든 Flask 엔드포인트를 사용하세요. Apidog에서:

- 새 요청을 만듭니다.

- URL을

http://localhost:5000/api/data로 설정하고 GET 요청을 전송합니다.

- 응답 확인:

{"message": "Hello, World!"}.

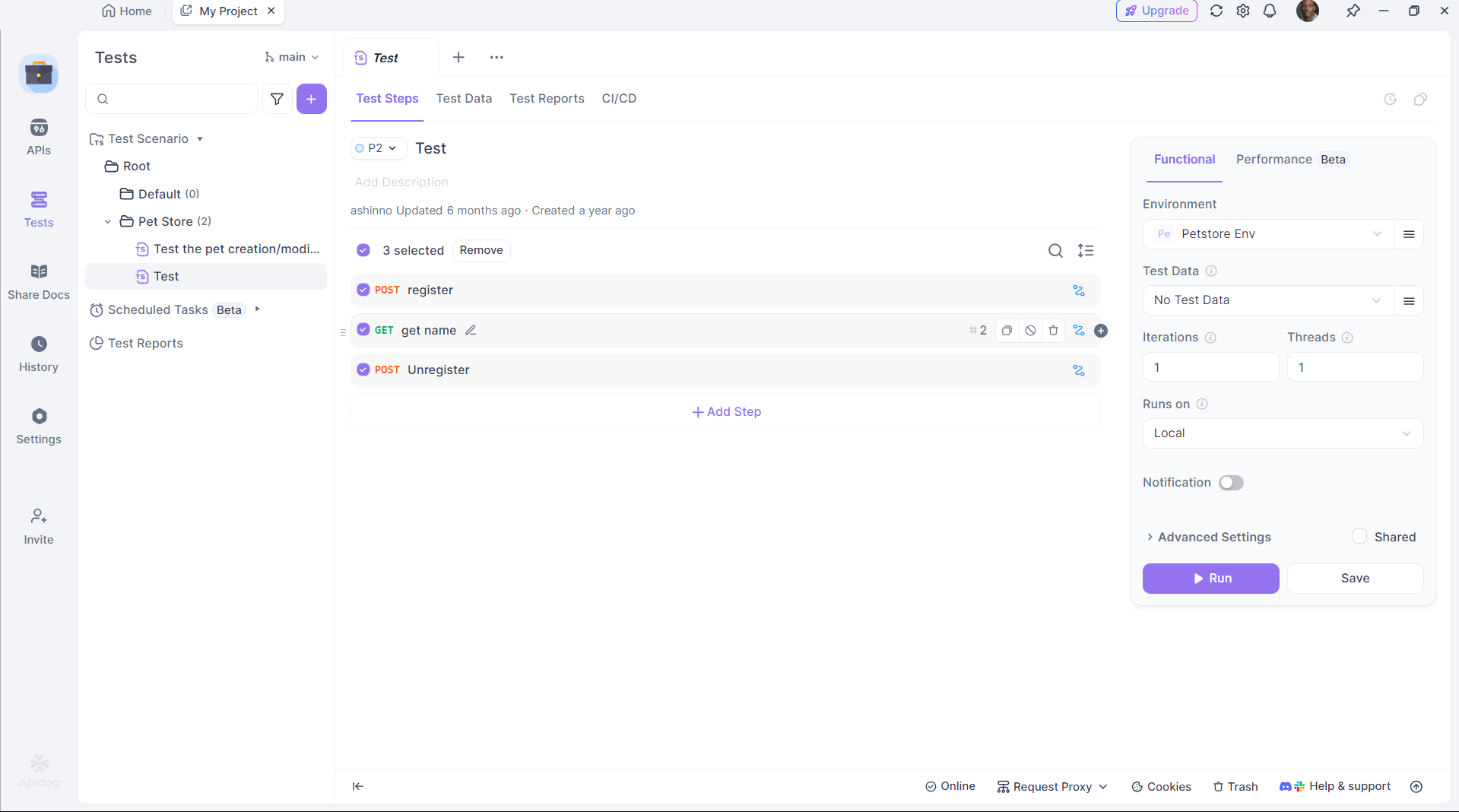

테스트 자동화:

Apidog의 스크립팅 기능을 사용하여 검증을 자동화하고, DeepCoder의 출력이 기대에 부응하는지 확인합니다.

Apidog는 코드 생성과 배포 사이의 간극을 메워 생산성을 높입니다.

6단계: DeepCoder 성능 최적화하기

효율성을 극대화하기 위해 DeepCoder의 설정을 세밀하게 조정합니다:

GPU 가속:

Ollama가 연산을 GPU로 오프로드하는지 확인하세요. 다음 명령어로 확인합니다:

nvidia-smi

GPU 사용량이 성공적인 가속을 나타냅니다.

메모리 관리:

14B 모델을 위해 충분한 VRAM을 할당합니다. 필요시 리눅스에서 스왑 공간을 조정하세요:

sudo fallocate -l 32G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

모델 양자화:

1.5B 모델에 대한 더 작은 양자화(예: 4비트)를 사용합니다:

ollama pull deepcoder:1.5b-q4

이러한 조정을 통해 DeepCoder가 하드웨어에서 원활하게 실행되도록 보장합니다.

DeepCoder와 Ollama를 선택해야 하는 이유

DeepCoder를 로컬에서 실행하면 확실한 이점이 있습니다:

- 프라이버시: 민감한 코드를 클라우드 서버에 저장하지 않습니다.

- 비용: 구독료를 피합니다.

- 사용자화: 모델을 필요에 맞게 조정할 수 있습니다.

Ollama의 경량 프레임워크와 Apidog의 테스트 기능을 결합하면 강력하고 독립적인 개발 생태계를 생성할 수 있습니다.

결론

Ollama를 사용하여 DeepCoder를 로컬로 설정하는 것은 간단하면서도 혁신적입니다. Ollama를 설치하고 DeepCoder를 가져오며, 실행하고 API를 통해 통합하는 모든 과정이 몇 가지 단계로 이루어집니다. Apidog와 같은 도구는 생성된 API가 제대로 작동하도록 보장하여 경험을 더욱 향상시킵니다. 개인 개발자든 팀의 일원이든, 이 설정은 강력한 오픈 소스 코딩 도우미를 제공합니다.