비용 부담 없이 Meta의 고급 Llama 언어 모델 기능을 활용하고 싶으신가요? 이 상세 가이드에서는 OpenRouter와 Together AI를 활용하여 Llama API를 무료로 사용하는 두 가지 실용적인 방법을 안내해 드립니다.

Llama API란 무엇인가요?

Llama API는 Llama 3 및 Llama 4를 포함한 Meta의 언어 모델 패밀리에 대한 액세스를 제공합니다. 이 모델들은 텍스트 생성, 문맥 이해, 심지어 이미지를 포함하는 멀티모달 애플리케이션과 같은 작업에서 뛰어난 성능을 발휘합니다. 개발자는 Llama API를 사용하여 챗봇부터 콘텐츠 생성 도구에 이르는 다양한 애플리케이션을 구축할 수 있으며, 처음부터 모델을 학습시킬 필요가 없습니다.

이 모델들은 인상적이지만, 액세스하려면 일반적으로 비용이 발생합니다. 하지만 어디를 찾아야 하는지 안다면 예외입니다. 다행히 OpenRouter 및 Together AI와 같은 플랫폼은 특정 Llama 모델에 대한 무료 액세스를 제공합니다. 이 가이드에서는 시작하기 위한 단계별 지침과 코드 예제를 포함하여 두 가지 방법을 모두 다룰 것입니다.

왜 Llama API를 선택해야 할까요?

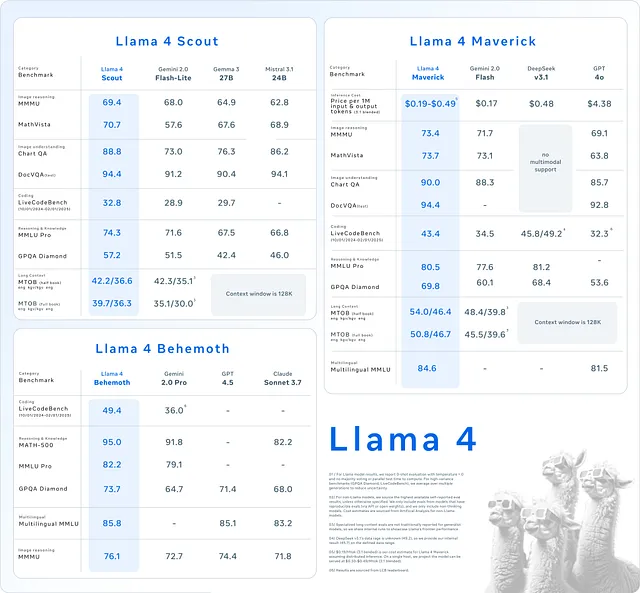

방법에 뛰어들기 전에 Llama API가 왜 눈에 띄는지 살펴보겠습니다. 첫째, 최고 수준의 언어 처리를 제공하여 애플리케이션이 일관성 있고 인간적인 텍스트를 생성할 수 있도록 합니다. 다음으로, Llama 4와 같은 최신 버전은 멀티모달 기능을 도입하여 모델이 텍스트와 이미지를 모두 처리할 수 있게 해줍니다. 이는 혁신적인 프로젝트에 큰 변화를 가져옵니다. 마지막으로, API를 사용하면 사용자 정의 모델을 구축하는 것보다 시간과 리소스를 절약할 수 있습니다.

이 점을 염두에 두고 Llama API에 무료로 액세스하는 방법을 알아보겠습니다.

방법 1: OpenRouter를 사용하여 Llama API 무료 액세스

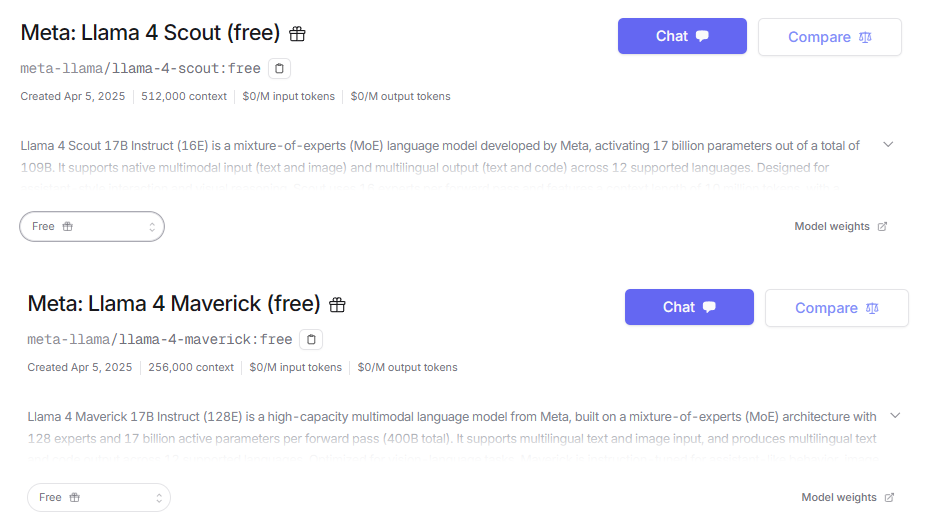

OpenRouter는 Meta의 Llama 시리즈를 포함하여 300개 이상의 AI 모델에 대한 액세스를 제공하는 통합 API 플랫폼 역할을 합니다. 무엇보다도 Llama 4 Maverick 및 Llama 4 Scout와 같은 모델을 포함하는 무료 티어를 제공합니다. 이는 OpenRouter를 최첨단 AI에 대한 비용 없는 액세스를 찾는 개발자에게 이상적인 출발점으로 만듭니다.

1단계: 가입 및 API 키 발급

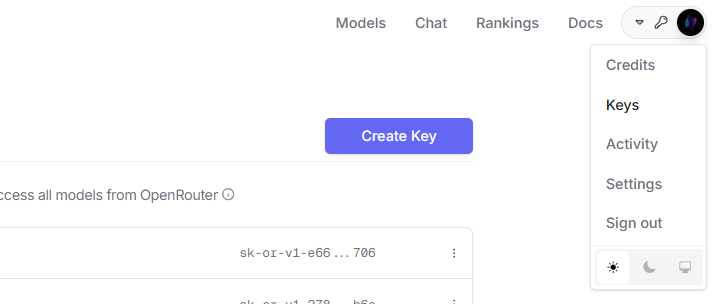

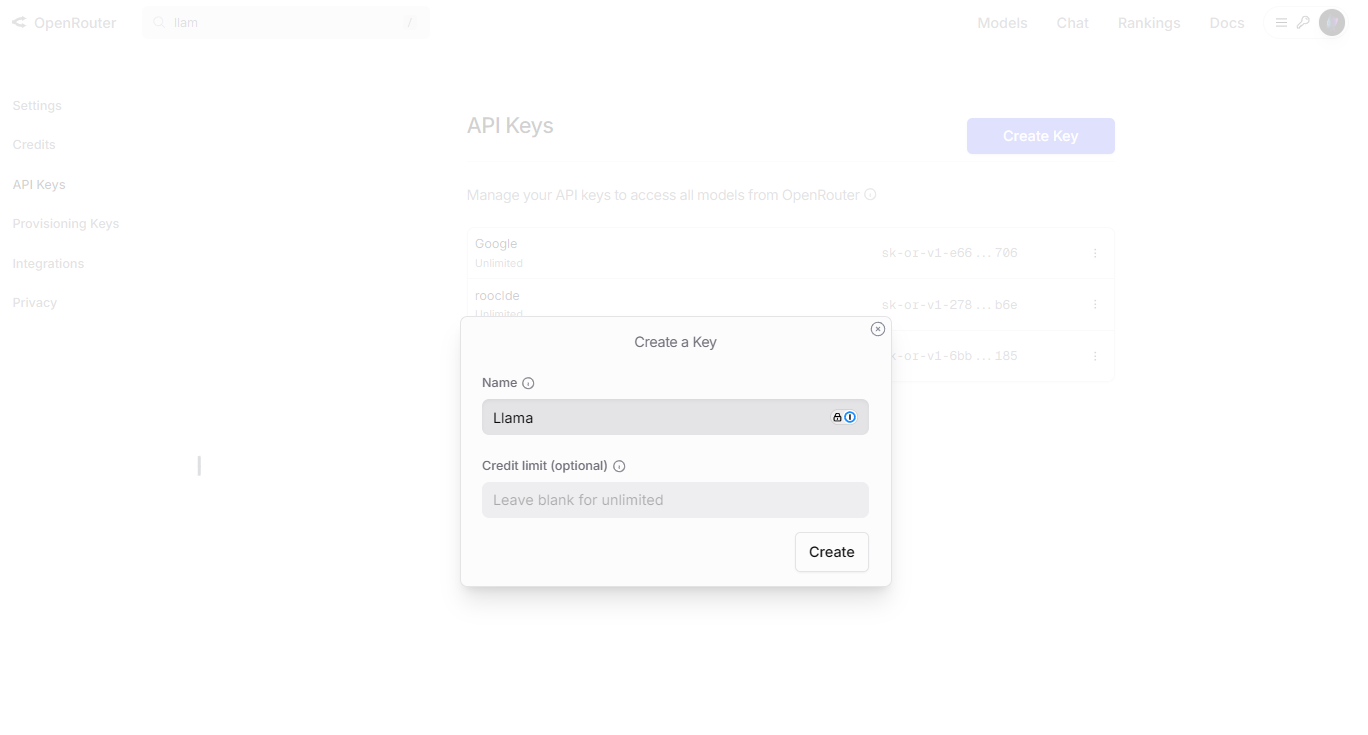

시작하려면 OpenRouter 계정과 API 키가 필요합니다. 다음 단계를 따르세요:

OpenRouter 웹사이트로 이동하여 "Sign Up"을 클릭합니다. 로그인한 후 대시보드의 "API Keys" 섹션으로 이동합니다.

"Create Key"를 클릭하고 이름을 지정한 후(예: "Llama Free Key") 키를 안전하게 복사합니다.

2단계: 환경 설정

API와 상호 작용하려면 프로그래밍 언어와 HTTP 클라이언트 라이브러리가 필요합니다. 여기서는 requests 라이브러리가 포함된 Python을 사용하겠습니다. 아직 설치하지 않았다면 설치하세요:

pip install requests

3단계: 첫 번째 요청 보내기

이제 OpenRouter를 통해 Llama 4 Scout 모델을 사용하여 텍스트를 생성하는 Python 스크립트를 작성해 보겠습니다:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://openrouter.ai/api/v1/chat/completions"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "meta-llama/llama-4-scout:free",

"messages": [

{"role": "user", "content": "Describe the Llama API in one sentence."}

],

"max_tokens": 50

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["choices"][0]["message"]["content"])

else:

print(f"Error: Request failed with status {response.status_code}")

이 스크립트는 Llama 4 Scout 모델에 프롬프트를 보내고 응답을 출력합니다. max_tokens를 조정하여 출력 길이를 제어할 수 있습니다.

4단계: 기능 실험

OpenRouter는 사용자 정의를 지원합니다. 예를 들어, temperature 매개변수를 조정하여 응답의 창의성을 조절하거나, Llama 4 Maverick과 같은 모델로 멀티모달 기능을 탐색할 수 있습니다. 사용 가능한 옵션에 대한 자세한 내용은 OpenRouter 모델 페이지를 확인하세요.

방법 2: Together AI를 사용하여 Llama API 무료 액세스

Together AI는 Llama 모델을 호스팅하는 또 다른 플랫폼으로, Llama 3.2 11B와 같은 Llama 3 모델에 대한 무료 액세스를 제공합니다. 그러나 현재 Together AI에서는 Llama 4가 무료가 아니며, 유료 요금제만 Llama 4를 사용할 수 있습니다. Llama 3가 요구 사항을 충족한다면 이 방법이 잘 작동할 것입니다.

1단계: 등록 및 API 키 발급

Together AI 계정을 설정하는 것으로 시작합니다:

Together AI 웹사이트를 방문하여 "API Keys" 섹션으로 이동하여 새 키를 생성합니다.

요청에 사용할 키를 안전하게 저장합니다.

2단계: 환경 준비

OpenRouter와 마찬가지로 Python과 requests를 사용하겠습니다. 필요한 경우 설치하세요:

pip install requests

3단계: API 호출

Together AI에서 Llama 3 모델로 텍스트를 생성하는 Python 스크립트입니다:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://api.together.xyz/inference"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "llama-3-2-11b-free",

"prompt": "What does the Llama API do?",

"max_tokens": 50,

"temperature": 0.7

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["output"]["text"])

else:

print(f"Error: Request failed with status {response.status_code}")

이 스크립트는 Llama 3 모델에 쿼리하고 출력을 표시합니다. temperature 설정은 창의성과 일관성 사이의 균형을 조절합니다.

4단계: 제한 사항 파악

Together AI의 무료 티어에는 속도 제한 및 Llama 4 액세스 불가와 같은 제약이 있습니다. Together AI 모델 페이지를 검토하여 사용 가능한 항목을 이해하고 그에 따라 계획을 세우세요.

Llama API 경험 최적화

Llama API를 최대한 활용하려면 다음 관행을 채택하세요:

- 정확한 프롬프트 작성: 명확한 프롬프트는 더 나은 결과를 가져옵니다. 다양한 프롬프트를 테스트하여 출력을 개선하세요.

- 사용량 추적: OpenRouter 또는 Together AI 대시보드를 통해 API 호출을 모니터링하여 무료 티어 제한 내에 머무르세요.

- 오류 처리: 코드에 try-except 블록을 추가하여 오류를 우아하게 관리하세요.

- 응답 캐싱: 자주 쿼리하는 결과를 저장하여 API 사용량을 줄이고 앱 속도를 높이세요.

이러한 단계는 프로젝트의 효율성과 신뢰성을 보장합니다.

일반적인 문제 해결

Llama API를 사용할 때 문제가 발생할 수 있습니다. 해결 방법은 다음과 같습니다:

- 401 Unauthorized: API 키가 올바른지 확인하고 헤더에 포함되어 있는지 확인하세요.

- 429 Too Many Requests: 속도 제한에 도달했습니다. 기다리거나 요금제를 업그레이드하세요.

- Invalid Model: 모델 이름이 제공업체의 문서와 일치하는지 확인하세요.

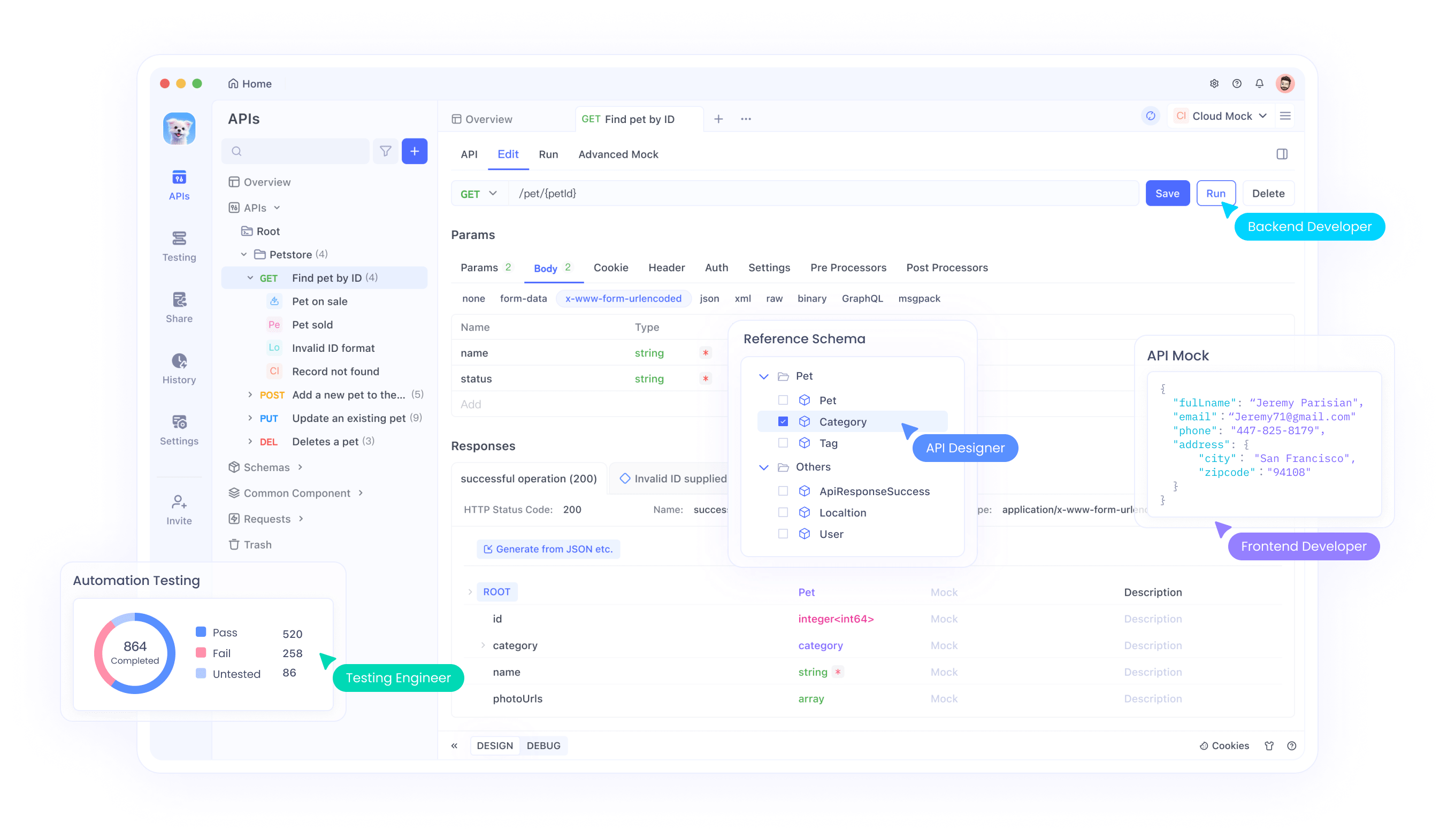

- Bad Payload: JSON 구문을 확인하세요. Apidog와 같은 도구가 디버깅에 도움이 될 수 있습니다.

도구에 대해 말하자면, API 호출 테스트 및 문제 해결을 간소화하려면 Apidog를 무료로 다운로드하세요. 개발자에게 필수적인 도구입니다.

OpenRouter와 Together AI 비교

두 플랫폼 모두 무료 액세스를 제공하지만 차이점이 있습니다:

- 모델 가용성: OpenRouter는 Llama 4를 무료로 포함합니다. Together AI는 무료 액세스를 Llama 3으로 제한합니다.

- 사용 편의성: 둘 다 직관적인 API를 제공하지만, OpenRouter의 더 넓은 모델 선택이 눈에 띕니다.

- 확장성: Together AI는 고급 기능을 위해 유료 요금제를 추천할 수 있지만, OpenRouter의 무료 티어는 더 관대합니다.

프로젝트 요구 사항에 따라 선택하세요. Llama 4 액세스가 필요하면 OpenRouter, Llama 3 사용자에게는 Together AI가 적합합니다.

Llama API 사용 사례

Llama API는 다양한 시나리오에서 빛을 발합니다:

- 챗봇: 자연스러운 응답으로 대화형 에이전트를 구축하세요.

- 콘텐츠 생성: 기사, 요약 또는 캡션을 생성하세요.

- 멀티모달 앱: Llama 4를 사용하여 텍스트 및 이미지 처리를 결합하세요 (OpenRouter 경유).

이러한 애플리케이션은 적절한 설정으로 무료로 달성할 수 있는 API의 다양성을 보여줍니다.

결론

이 가이드에서는 OpenRouter와 Together AI를 통해 Llama API를 무료로 사용하는 방법을 보여드렸습니다. OpenRouter는 Llama 4 모델에 대한 액세스를 제공하고, Together AI는 무료 티어에서 Llama 3를 제공합니다. 상세한 지침과 코드 스니펫을 통해 이제 이러한 모델을 프로젝트에 통합할 준비가 되었습니다. 오늘부터 실험을 시작하고, Apidog와 같은 도구를 활용하여 워크플로우를 개선하는 것을 잊지 마세요. Llama의 힘은 당신의 것입니다. 현명하게 사용하세요!