Kinerja dan stabilitas sangat penting saat membangun dan memelihara API. Kinerja API secara langsung memengaruhi pengalaman pengguna dan ketersediaan sistem, menjadikan pengujian kinerja komprehensif sangat penting.

Apa itu Pengujian Kinerja API?

Pengujian kinerja API biasanya melibatkan simulasi perilaku pengguna nyata, pengujian stres, dan pengujian beban untuk mengevaluasi stabilitas sistem dan metrik kinerja.

Sebelum melakukan pengujian kinerja, disarankan untuk melakukan pengujian fungsional pada API untuk memastikan semua API berfungsi dengan benar seperti yang diharapkan. Pengujian fungsional membantu mengidentifikasi dan memperbaiki masalah fungsional, sementara pengujian kinerja berfokus pada evaluasi perilaku API di bawah beban tinggi. Hanya API yang secara fungsional baik yang menghasilkan hasil pengujian kinerja yang bermakna, memberikan dasar yang andal untuk optimasi kinerja lebih lanjut.

Bagaimana Cara Melakukan Pengujian Kinerja di Apidog?

Panduan ini akan memandu Anda dalam memanfaatkan fitur "Uji Kinerja" Apidog untuk menilai kinerja API Anda.

Langkah 1: Mengatur Skenario Uji Kinerja

Sebelum memulai pengujian kinerja, Anda perlu membuat kasus uji. Anda dapat mengimpor ini dari API yang ada atau kasus penggunaan API, atau menentukan permintaan khusus. Setelah langkah-langkah pengujian siap, menjalankan pengujian fungsional disarankan untuk memastikan API beroperasi seperti yang diharapkan sebelum melanjutkan dengan pengujian kinerja.

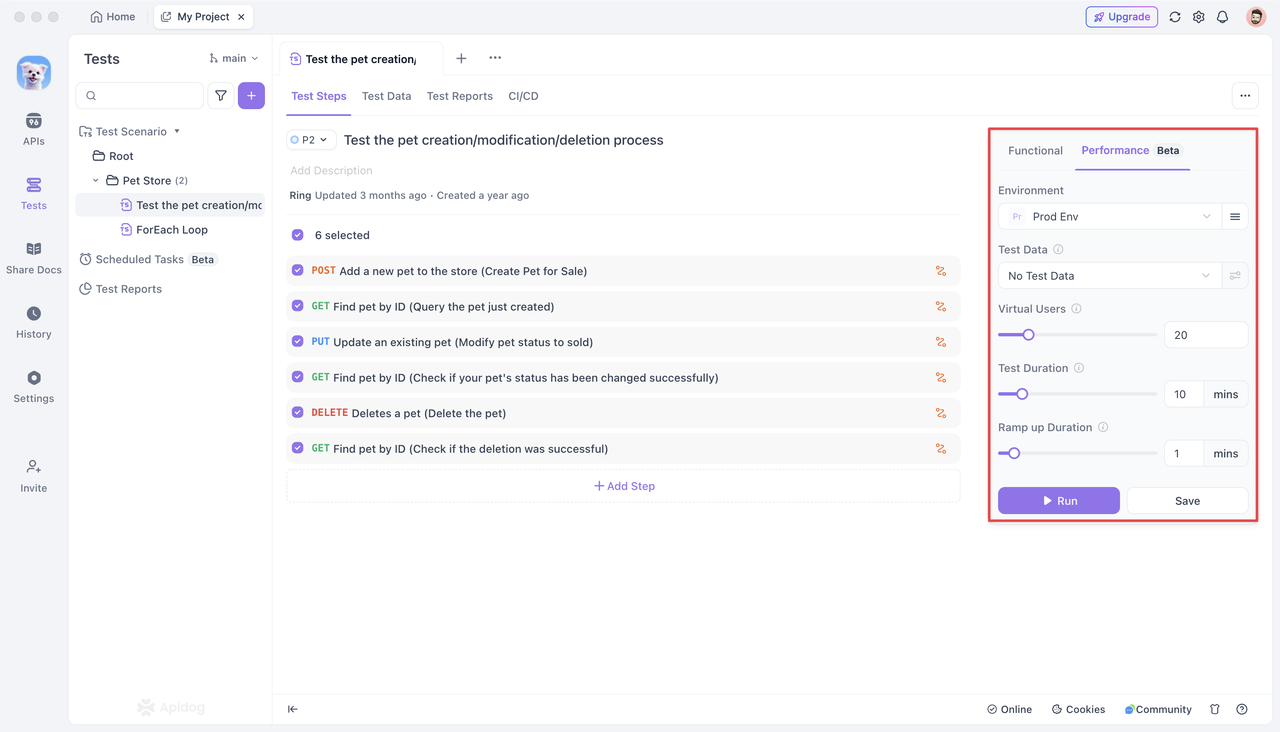

Langkah 2: Mengonfigurasi Pengaturan Uji Kinerja

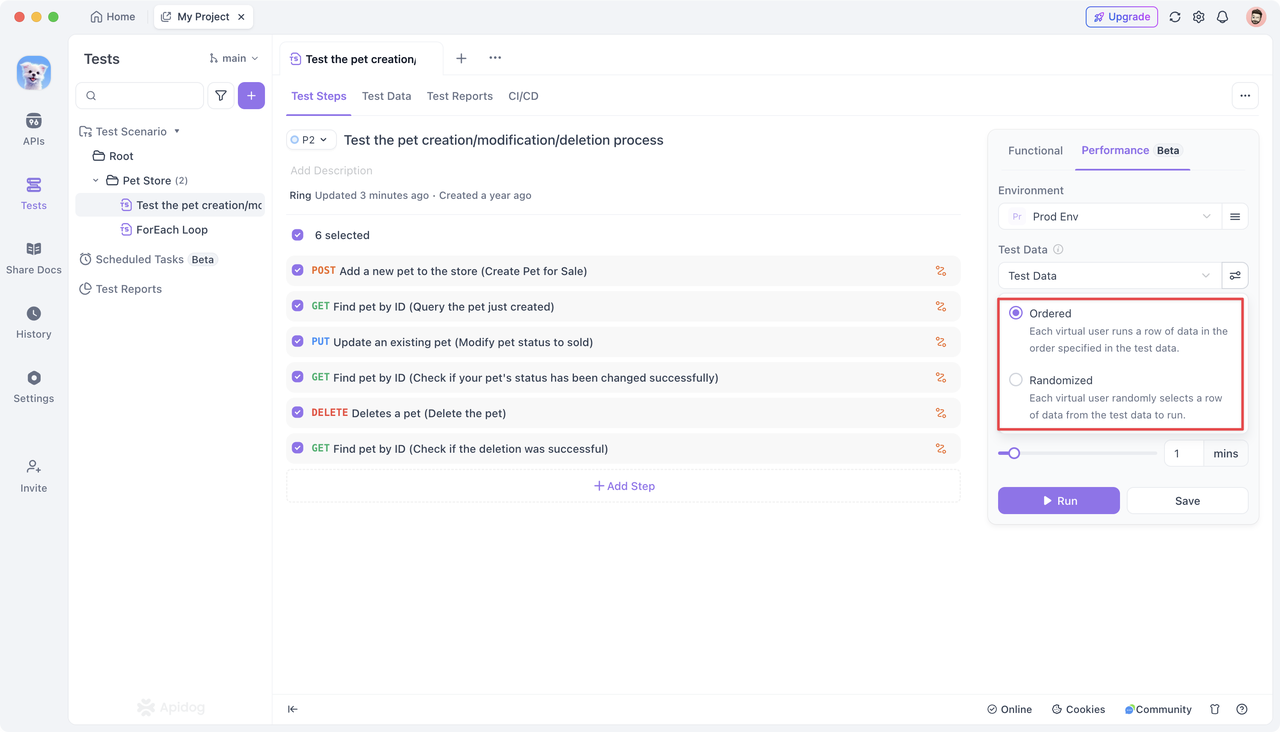

Di bagian "Pengujian" Apidog, Anda akan menemukan modul khusus untuk "Kinerja (Beta)." Di sini, Anda dapat mengonfigurasi berbagai pengaturan untuk mempersiapkan pengujian kinerja yang akan datang.

Opsi Konfigurasi:

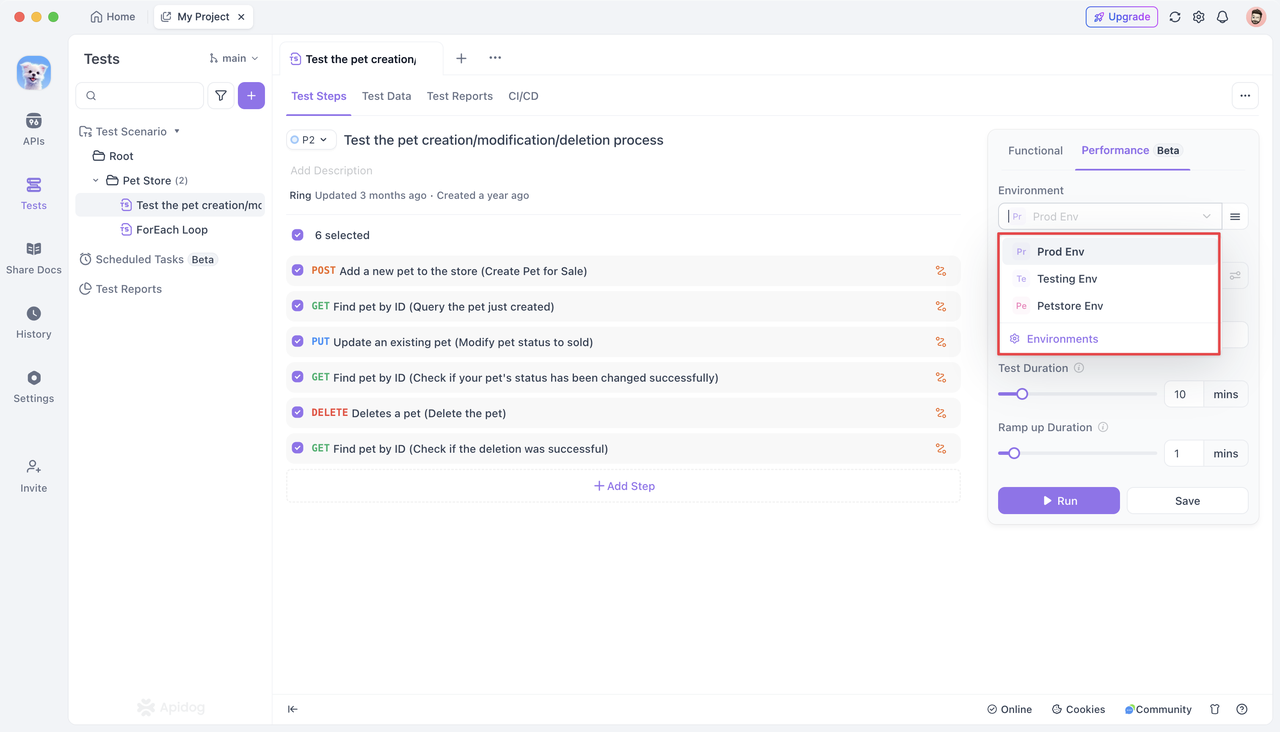

Tentukan lingkungan layanan backend untuk permintaan selama "Uji Kinerja." Secara default, konfigurasi lingkungan yang ditetapkan untuk proyek saat ini diterapkan secara otomatis.

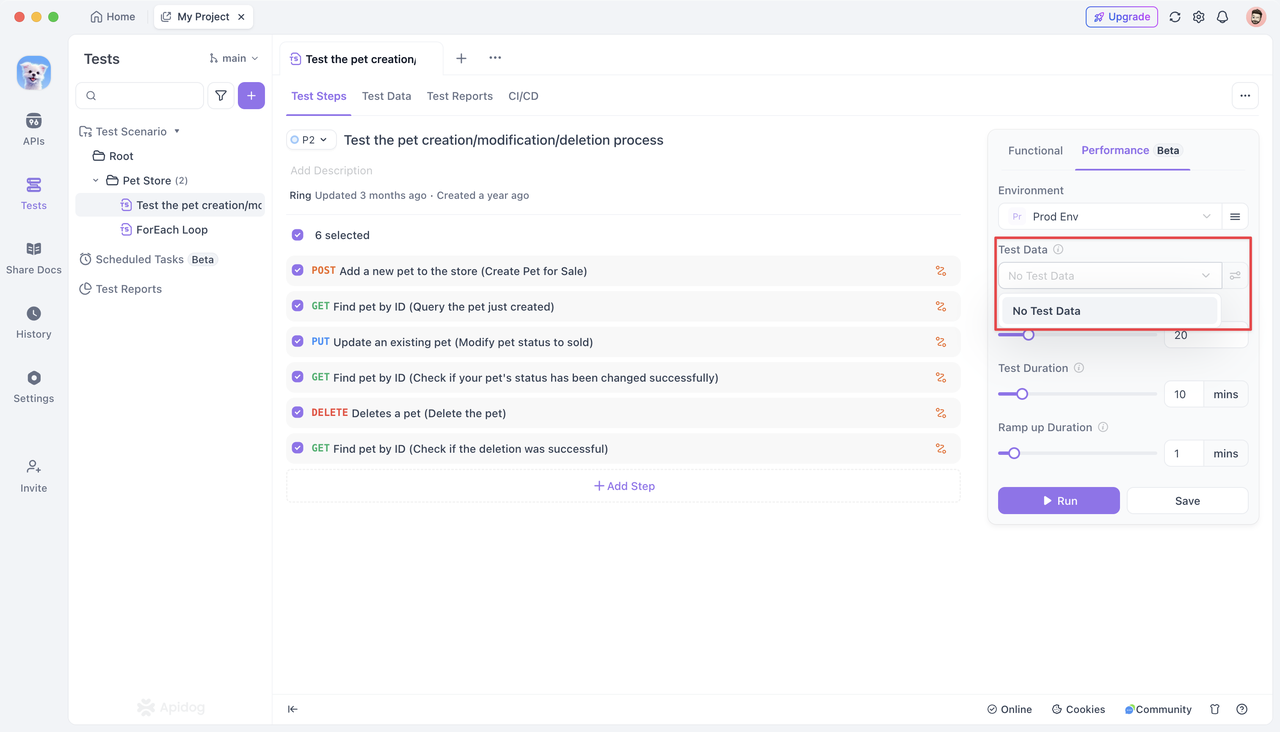

Data uji mengacu pada dataset yang digunakan untuk memulai permintaan selama pengujian kinerja. Menggunakan data uji memungkinkan setiap pengguna bersamaan membuat permintaan dengan parameter yang berbeda, mensimulasikan lalu lintas dunia nyata dengan lebih baik.

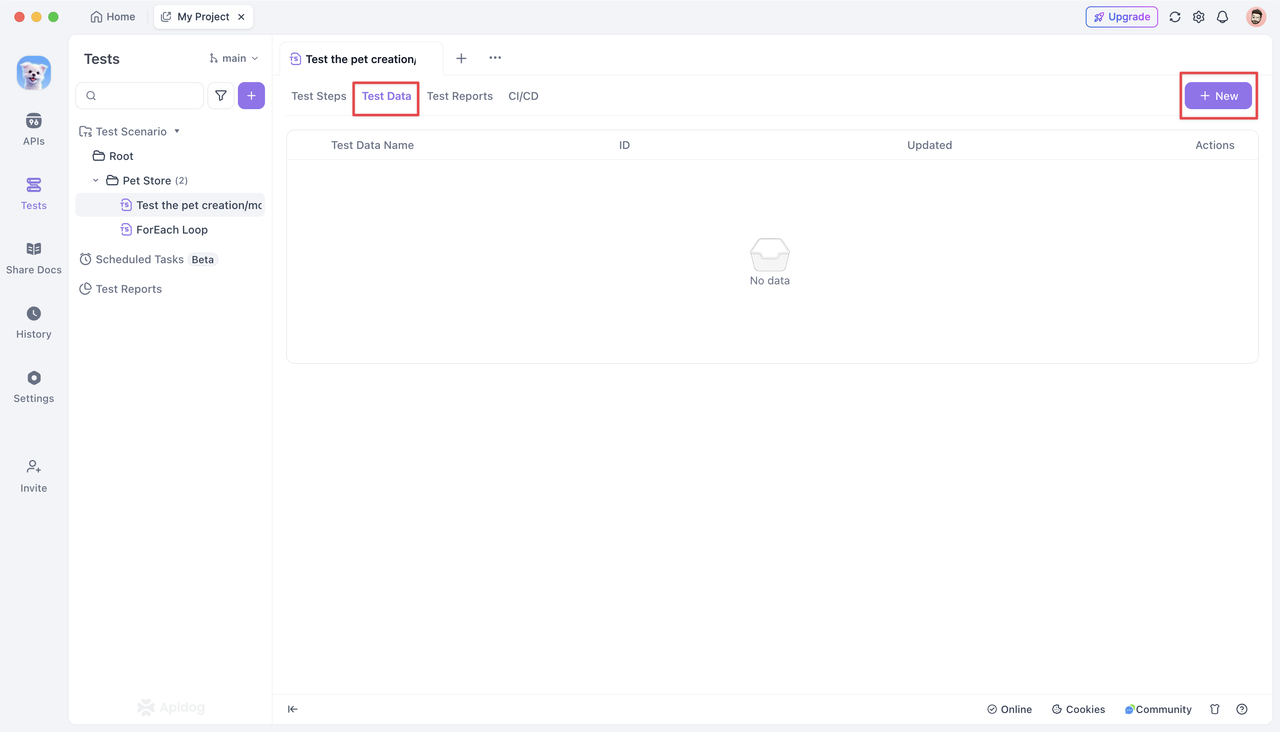

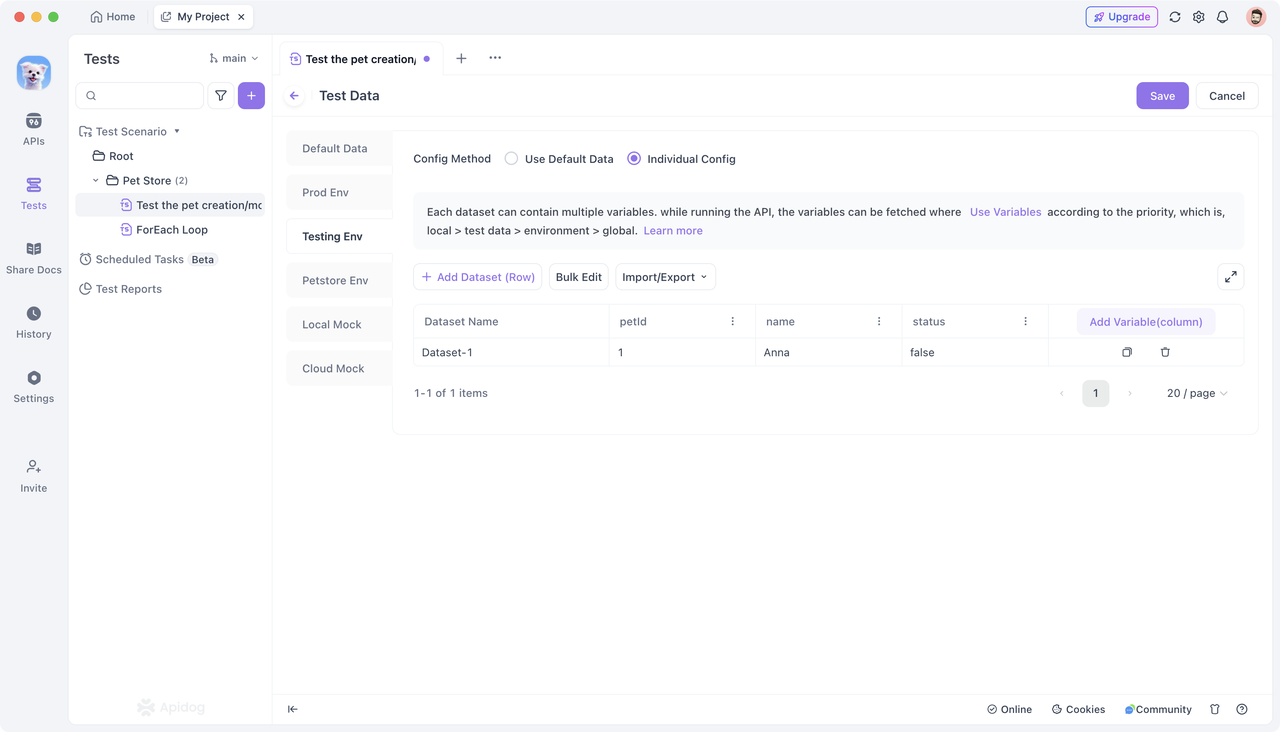

- Untuk menggunakan data uji, klik tab "Data Uji" dan buat dataset baru.

- Konfigurasikan dataset untuk lingkungan yang sesuai. Anda dapat menambahkan data secara manual atau mengimpornya dalam format JSON atau CSV. Simpan dataset setelah mengedit.

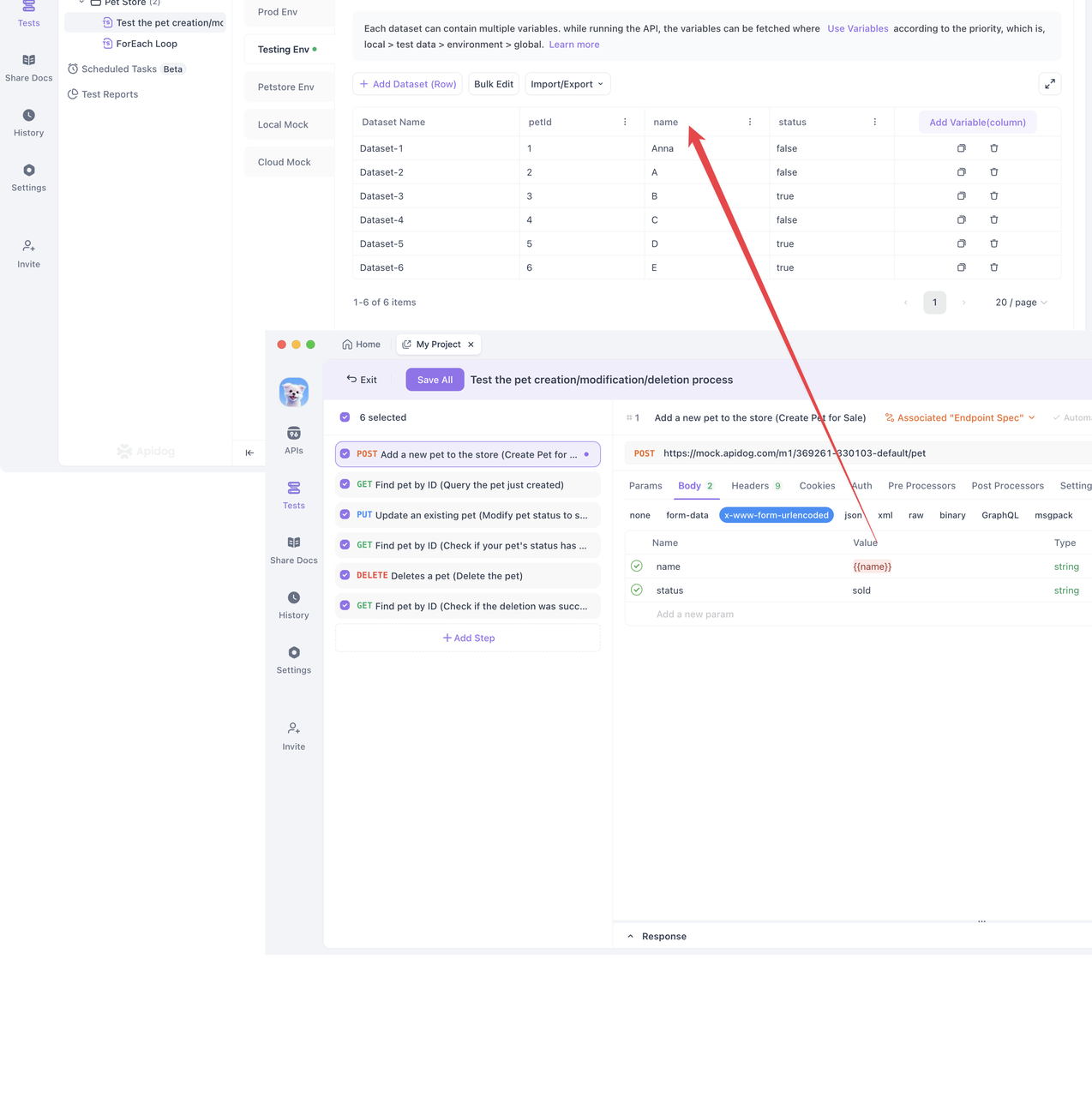

- Di halaman detail langkah pengujian, kaitkan variabel dengan data uji.

- Saat Anda memilih untuk mengaitkan data uji dalam pengujian kinerja, pengguna bersamaan akan menggunakan variabel yang ditentukan dalam data uji untuk membuat permintaan. Anda dapat memilih antara mode "Acak" dan "Berurutan" untuk pengujian.

Setiap pengguna bersamaan secara acak memilih baris data dari data uji. Ini memastikan bahwa setiap pengguna mendapatkan data unik, menjamin cakupan luas dalam pengujian kinerja.

Pencocokan Berurutan:

Setiap pengguna bersamaan memilih baris data berikutnya secara berurutan dari data uji. Perhatikan bahwa jika jumlah pengguna bersamaan melebihi jumlah baris dalam data uji, pengguna yang melebihi tidak akan berpartisipasi dalam pengujian. Pastikan Anda memiliki data uji yang cukup untuk mendukung semua pengguna bersamaan dalam mode ini.

- Pengguna Bersamaan (Pengguna Virtual):

Pengujian kinerja saat ini mendukung simulasi hingga 100 pengguna bersamaan. Pengguna ini akan secara bersamaan mensimulasikan perilaku pengguna online nyata dalam durasi pengujian yang ditentukan, berulang kali menjalankan skenario pengujian. Ini secara efektif mensimulasikan skenario konkurensi tinggi untuk mengevaluasi kinerja dan stabilitas API di bawah sejumlah besar permintaan pengguna.

- Waktu Berjalan:

Mendefinisikan total durasi pengujian kinerja. Setiap pengguna bersamaan akan terus mengulang semua permintaan API yang ditentukan dalam skenario pengujian dalam waktu yang ditetapkan ini. Saat ini, durasi pengujian maksimum yang didukung adalah 60 menit.

- Waktu Ramp-Up:

Dalam beberapa kasus, sejumlah besar pengguna tidak mengakses layanan secara instan tetapi secara bertahap meningkat seiring waktu.

Waktu ramp-up mensimulasikan peningkatan bertahap dalam lalu lintas pengguna. Alih-alih menggunakan semua pengguna bersamaan segera di awal pengujian, jumlah pengguna meningkat secara linear selama waktu yang ditetapkan (X menit) hingga mencapai jumlah total pengguna bersamaan. Menyetel X ke 0 berarti bahwa semua pengguna bersamaan akan diaktifkan untuk pengujian stres dari awal.

Setelah mengonfigurasi opsi di atas, simpan pengaturan dan klik tombol "Jalankan" untuk memulai pengujian kinerja.

Langkah 3: Menjalankan Pengujian Kinerja

Mengklik "Jalankan" memulai pengujian kinerja. Pengujian kinerja Apidog berasal dari komputer pengguna (bukan server Apidog) dan menggunakan sumber daya perangkat keras komputer untuk menjalankan langkah-langkah pengujian yang dikonfigurasi, data uji, dan permintaan bersamaan.

Oleh karena itu, Anda perlu mempertimbangkan kinerja komputer Anda dan perilaku API lain untuk menentukan apakah masalah kinerja terletak pada API yang sedang diuji atau komputer yang memulai pengujian. Jika Anda menemukan bahwa jumlah permintaan yang dimulai tidak meningkat terlepas dari server atau API, Anda mungkin memerlukan komputer yang lebih kuat untuk melakukan pengujian kinerja.

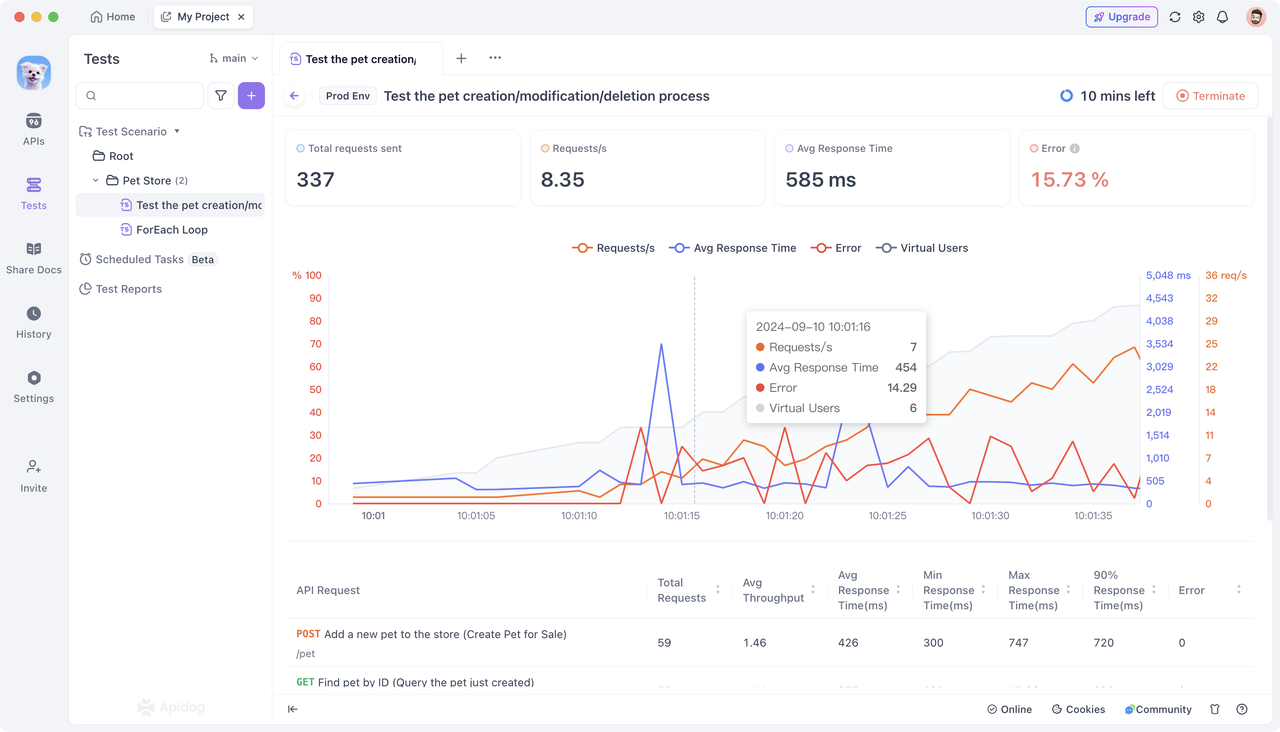

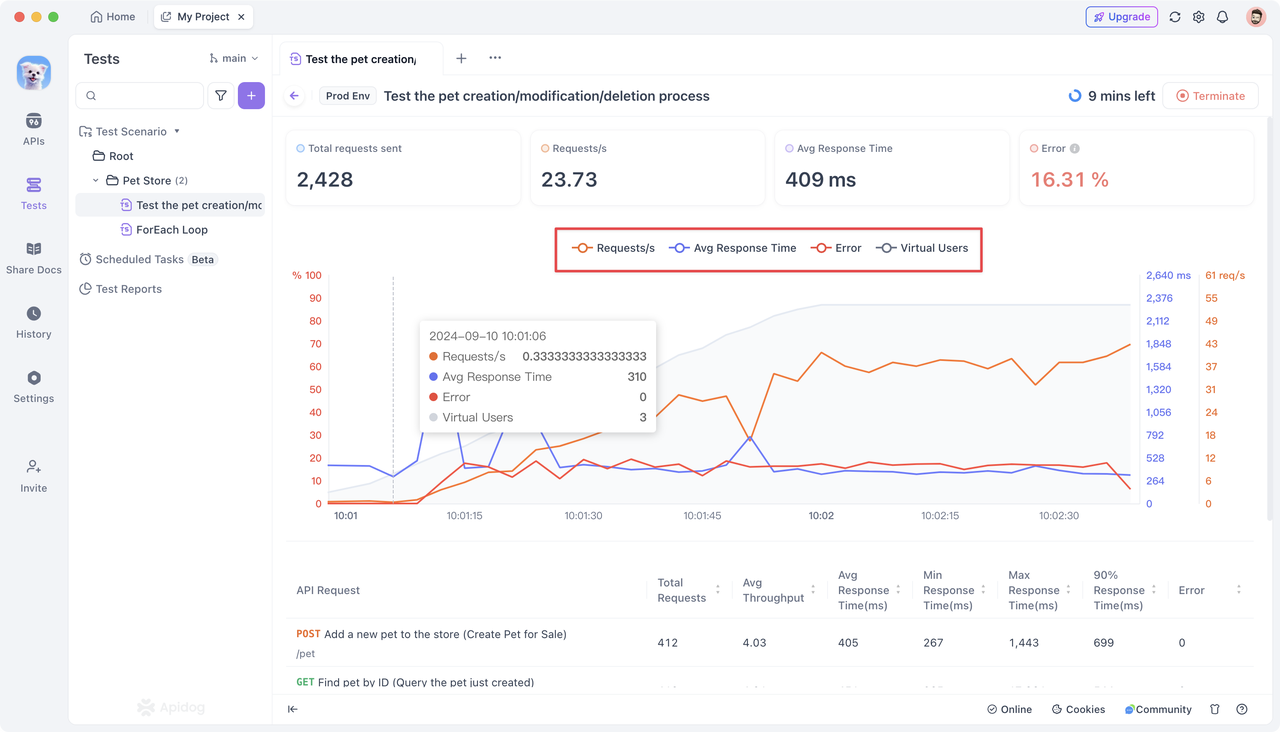

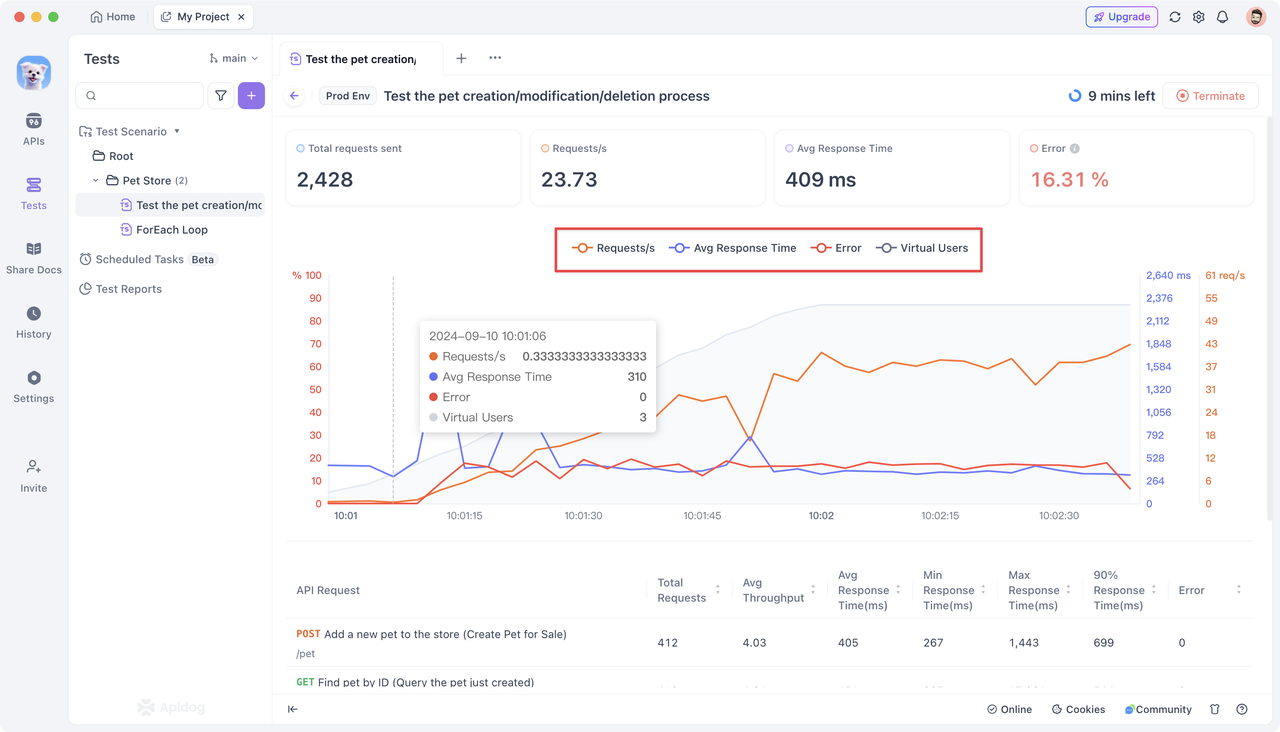

Setelah pengujian kinerja dimulai, Apidog menyediakan panel visualisasi intuitif untuk memantau dan menampilkan indikator kinerja utama secara real-time. Ini termasuk jumlah total permintaan untuk setiap API, permintaan per detik, waktu respons rata-rata, waktu respons maksimum/minimum, dan tingkat kegagalan permintaan.

Memahami Metrik Kinerja:

Panel visualisasi menyajikan data komprehensif untuk seluruh skenario pengujian dan data API individual.

Data Komprehensif:

- Total Permintaan: Mencerminkan jumlah total permintaan yang diproses oleh API selama pengujian. Jumlah total permintaan yang tinggi wajar dalam skenario pengguna skala besar, tetapi pastikan API dapat menangani permintaan ini secara efektif.

- Permintaan per Detik: Jumlah yang tinggi menunjukkan API dapat memproses volume permintaan yang besar dalam waktu singkat, menandakan kinerja yang baik. Jumlah yang rendah mungkin menunjukkan hambatan kinerja.

- Waktu Respons Rata-Rata: Waktu respons rata-rata yang rendah umumnya menunjukkan pengguna menerima umpan balik dengan cepat, mencerminkan kinerja API yang sangat baik. Waktu respons yang tinggi menunjukkan respons yang lambat, yang berpotensi memengaruhi pengalaman pengguna.

- Tingkat Kegagalan Permintaan: Memang, tingkat kegagalan harus mendekati nol. Tingkat kegagalan yang tinggi menunjukkan API tidak dapat menangani permintaan dengan benar dalam situasi tertentu, yang memerlukan analisis kesalahan dan optimasi lebih lanjut.

- Pengguna Bersamaan: Menetapkan jumlah pengguna bersamaan yang sesuai membantu mensimulasikan beban pengguna dunia nyata. Namun, menyetelnya terlalu tinggi dapat membebani sistem, yang menyebabkan penurunan kinerja.

Data API Individual:

- Total Permintaan: Total permintaan yang dikirim untuk satu API.

- Permintaan per Detik: Jumlah rata-rata permintaan yang dikirim per detik untuk satu API.

- Waktu Respons Rata-Rata (ms): Waktu respons rata-rata untuk semua permintaan ke satu API.

- Waktu Respons Minimum (ms): Waktu respons terpendek di antara semua permintaan ke satu API.

- Waktu Respons Maksimum (ms): Waktu respons terpanjang di antara semua permintaan ke satu API.

- 90% Waktu Respons: Waktu respons untuk persentil ke-90 dari permintaan ke satu API.

- Tingkat Kegagalan: Persentase permintaan yang gagal untuk satu API.

Menganalisis Hasil Pengujian:

- Visualisasi:

Warna kurva yang berbeda pada panel visualisasi sesuai dengan metrik kinerja yang berbeda pada sumbu vertikal. Sumbu horizontal mewakili durasi pengujian kinerja. Sumbu vertikal menampilkan metrik seperti tingkat kegagalan permintaan, waktu respons rata-rata, dan permintaan per detik (pengguna bersamaan disembunyikan secara default). Anda dapat mengklik metrik tertentu untuk menyorot atau menyembunyikannya untuk analisis terfokus.

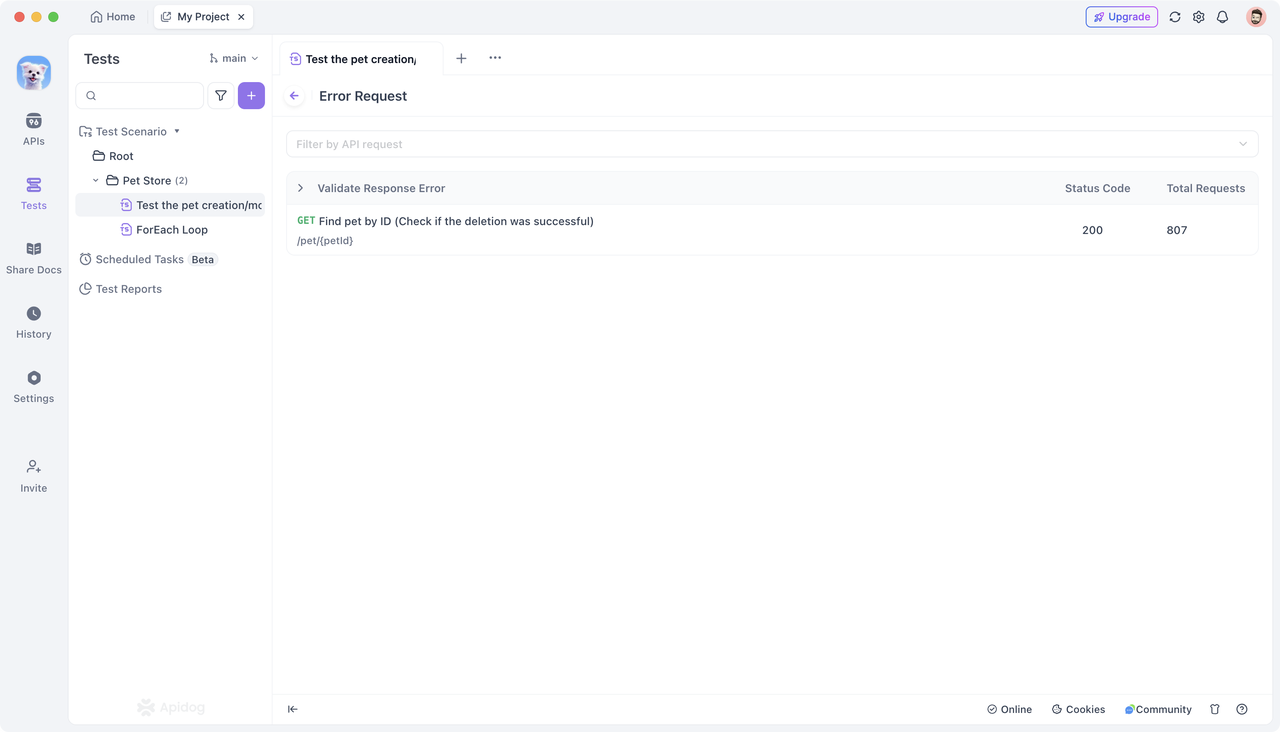

- Penyaringan dan Detail:

Untuk memeriksa permintaan gagal tertentu, klik "Validasi Kesalahan Respons." Anda juga dapat menggunakan fungsi penyaringan untuk fokus pada kinerja API tertentu.

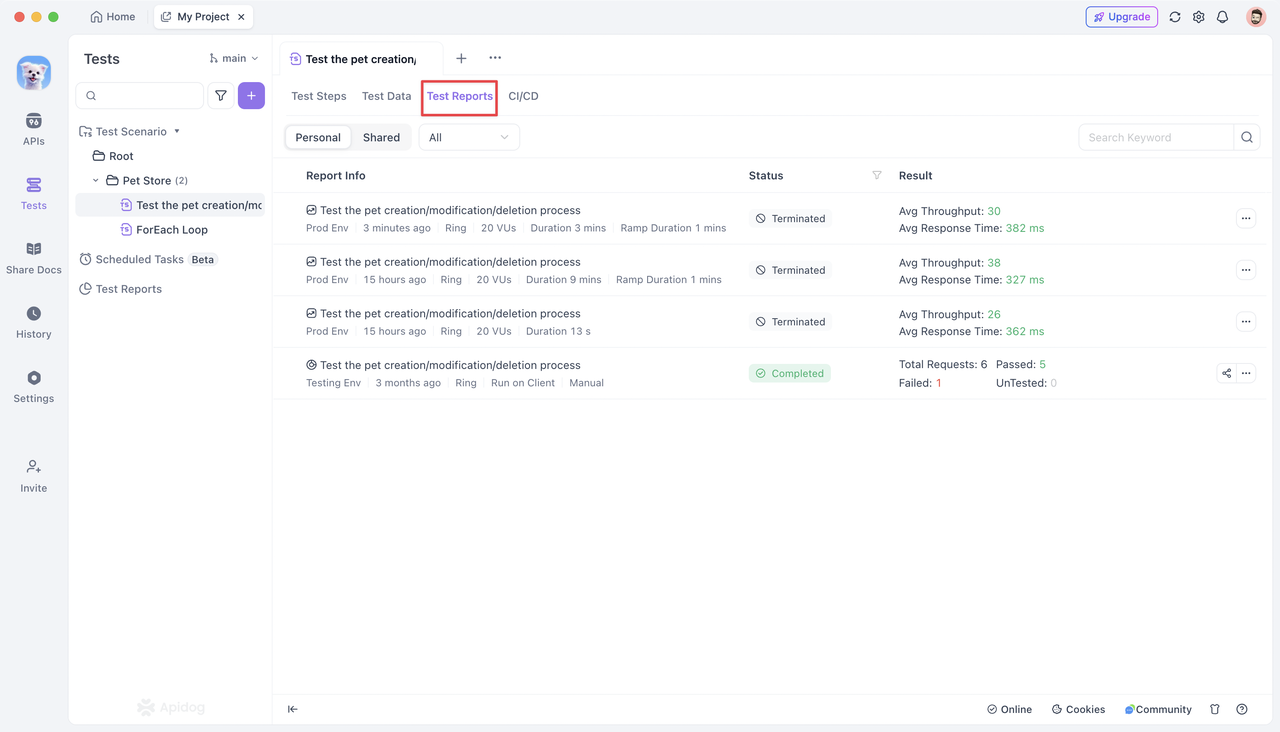

- Laporan Pengujian:

Setelah pengujian kinerja, klik tab "Laporan Pengujian" untuk melihat semua laporan historis untuk skenario pengujian. Laporan ini merinci "Opsi Konfigurasi" yang ditetapkan sebelum menjalankan pengujian kinerja.

Anda dapat memfilter laporan berdasarkan jenis (pengujian fungsional, pengujian kinerja). Mengklik laporan pengujian membawa Anda ke halaman detailnya, menampilkan metrik yang sama yang dikumpulkan selama pengujian kinerja.

Catatan: Hanya satu pengujian kinerja yang dapat dijalankan per proyek dalam satu waktu. Klik tombol "Hentikan" di sudut kanan atas untuk menghentikan pengujian saat ini jika pengujian prioritas lebih tinggi perlu dijalankan.

Kesimpulan

Apidog menyediakan solusi yang mudah digunakan untuk pengujian kinerja API, menyederhanakan proses pengaturan parameter pengujian, menjalankan pengujian, dan melihat hasil. Dengan metrik kinerja terperinci dan panel visualisasi yang jelas, Anda dapat secara komprehensif memahami kinerja API Anda.