هل ترغب في الدردشة مع نماذج لغوية قوية مثل Llama 3.1 أو Mistral دون أن تتعثر في سطر الأوامر (الطرفية)؟ Open WebUI هو تذكرتك لواجهة أنيقة تشبه ChatGPT تجعل التفاعل مع نماذج Ollama اللغوية الكبيرة (LLMs) ممتعًا وبديهيًا. يتيح لك حفظ سجلات الدردشة، وتخزين المطالبات، وحتى تحميل المستندات للحصول على ردود أكثر ذكاءً—كل ذلك في متصفحك. في هذا الدليل المخصص للمبتدئين، سأرشدك خلال تثبيت Ollama، واختبار نموذج في الطرفية، ثم الارتقاء بالمستوى باستخدام Open WebUI لتجربة أكثر سهولة في الاستخدام. سنستخدم Docker لإعداد سريع واختباره بمطالبة ممتعة. هل أنت مستعد لجعل محادثات الذكاء الاصطناعي سهلة؟ لنبدأ!

ما هو Open WebUI؟ مركز قيادة نماذجك اللغوية الكبيرة

Open WebUI هو واجهة ويب مفتوحة المصدر، تستضيفها ذاتيًا، تتصل بـ Ollama، مما يتيح لك التفاعل مع نماذج لغوية كبيرة (LLMs) مثل Llama 3.1 أو Mistral في لوحة تحكم قائمة على المتصفح. على عكس واجهة سطر الأوامر الخاصة بـ Ollama، فإن Open WebUI تشبه ChatGPT، وتقدم:

- سجل الدردشة: حفظ ومراجعة محادثاتك.

- تخزين المطالبات: تخزين وإعادة استخدام مطالباتك المفضلة.

- تحميل المستندات: إضافة ملفات للسياق في الردود (Retrieval-Augmented Generation, أو RAG).

- تبديل النماذج: التبديل بسهولة بين النماذج بنقرة واحدة.

مع أكثر من 50 ألف نجمة على GitHub، يعد Open WebUI نجاحًا كبيرًا للمطورين وعشاق الذكاء الاصطناعي الذين يريدون طريقة تعاونية ورسومية للعمل مع نماذج LLMs محليًا. أولاً، دعنا نجعل Ollama يعمل لترى لماذا يستحق Open WebUI الإضافة!

تثبيت واختبار Ollama

قبل أن نتعمق في Open WebUI، دعنا نعد Ollama ونختبر نموذجًا مثل Llama 3.1 أو Mistral في الطرفية. هذا يمنحك خط أساس لتقدير واجهة Open WebUI البديهية.

1. التحقق من متطلبات النظام:

- نظام التشغيل: Windows، macOS، أو Linux (Ubuntu 24.04 أو ما شابه).

- الأجهزة: 16 جيجابايت على الأقل من ذاكرة الوصول العشوائي (RAM) و 10 جيجابايت من مساحة التخزين الحرة للنماذج (Llama 3.1 8B يحتاج إلى حوالي 5 جيجابايت). وحدة معالجة الرسومات (GPU) (مثل NVIDIA 1060 4GB) اختيارية لأداء أسرع.

- البرنامج: Ollama، قابل للتنزيل من ollama.com.

2. تثبيت Ollama: قم بتنزيل وتثبيت Ollama من ollama.com لنظام التشغيل الخاص بك. اتبع تعليمات المثبت—إنه إعداد سريع. تحقق من التثبيت باستخدام:

ollama --version

توقع إصدارًا مثل 0.1.44 (أبريل 2025). إذا فشل، تأكد من أن Ollama موجود في مسار النظام (PATH).

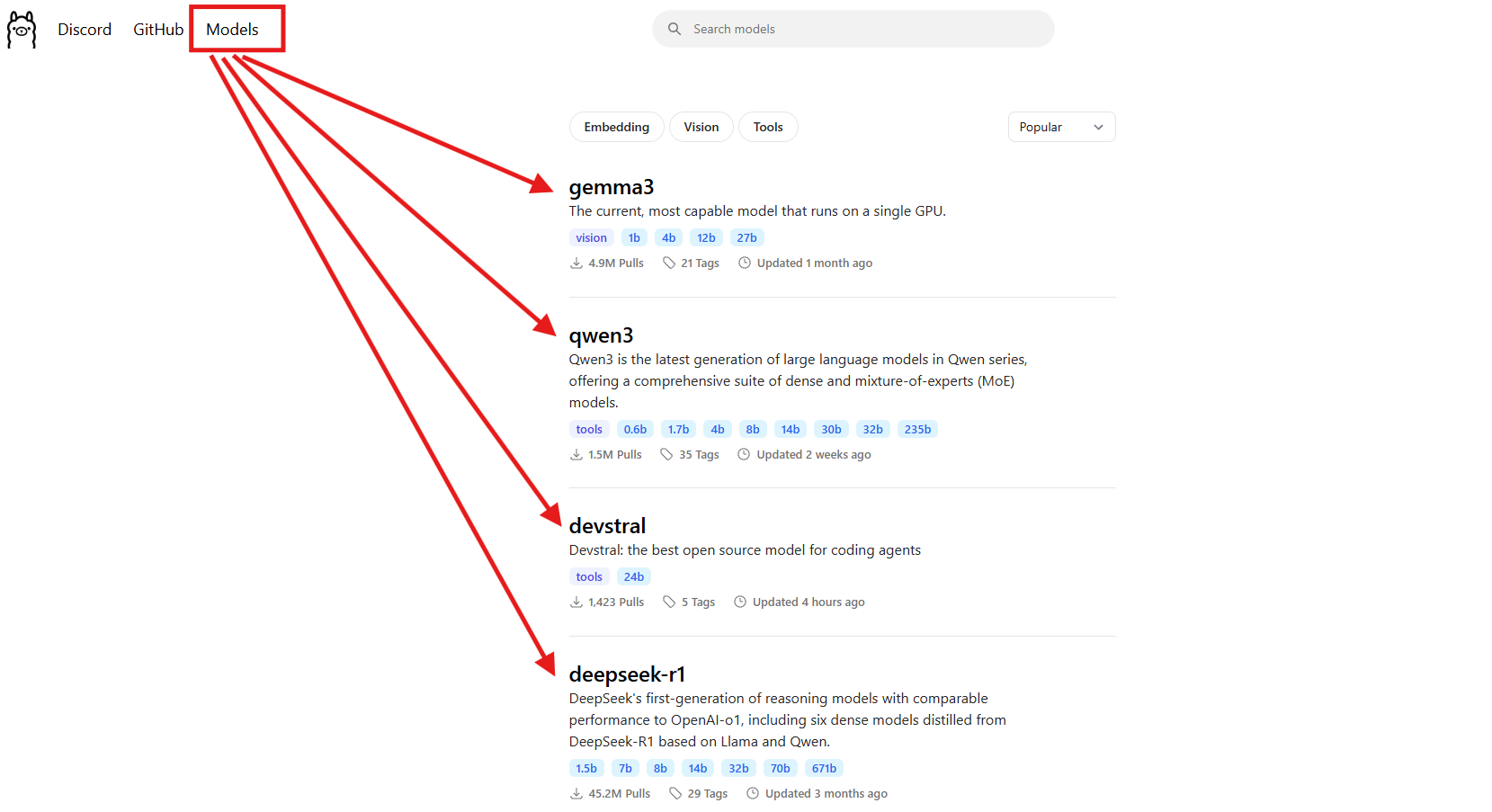

3. تنزيل نموذج: اختر نموذجًا مثل Llama 3.1 (8B) أو Mistral (7B). لهذا الدليل، سنستخدم Llama 3.1:

ollama pull llama3.1

يقوم هذا بتنزيل حوالي 5 جيجابايت، لذا احصل على قهوة إذا كان اتصال الإنترنت لديك بطيئًا. تحقق من تثبيته:

ollama list

ابحث عن llama3.1:latest. Mistral (ollama pull mistral) هو خيار رائع آخر إذا كنت تريد نموذجًا أخف (حوالي 4 جيجابايت).

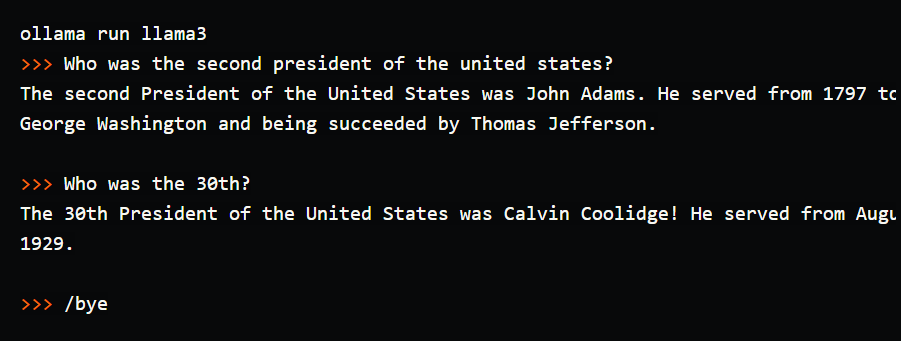

4. اختبار النموذج في الطرفية: جرب مطالبة بسيطة لترى Ollama في العمل:

ollama run llama3.1

عند المطالبة (>>>)، اكتب: "Tell me a dad joke about computers." (أخبرني نكتة أب عن أجهزة الكمبيوتر). اضغط على Enter. قد تحصل على: "Why did the computer go to the doctor? It had a virus!" (لماذا ذهب الكمبيوتر إلى الطبيب؟ كان لديه فيروس!). اخرج باستخدام /bye. قمت بتشغيل هذا وحصلت على نكتة تستحق الضحك، لكن الكتابة في الطرفية شعرت بأنها غير مريحة—لا يوجد سجل دردشة، لا يوجد مطالبات محفوظة. هنا يتألق Open WebUI، حيث يقدم واجهة مرئية لحفظ المحادثات، وإعادة استخدام المطالبات، وتحميل المستندات للحصول على ردود أكثر ثراءً. دعنا نعده!

إعداد بيئتك لـ Open WebUI

الآن بعد أن رأيت واجهة الطرفية لـ Ollama، دعنا نستعد لـ Open WebUI لجعل تجربة LLM الخاصة بك أكثر بديهية. سنفترض أن لديك Docker مثبتًا، حيث أنه مطلوب لإعداد Open WebUI.

1. التحقق من Docker: تأكد من تثبيت Docker وتشغيله:

docker --version

توقع شيئًا مثل Docker 27.4.0. إذا لم يكن لديك Docker، قم بتنزيل وتثبيت Docker Desktop من موقعه الرسمي—إنه إعداد سريع لأنظمة Windows، macOS، أو Linux.

2. إنشاء مجلد مشروع: حافظ على تنظيم الأمور:

mkdir ollama-webui

cd ollama-webui

سيكون هذا المجلد هو قاعدتك لتشغيل Open WebUI.

3. التأكد من تشغيل Ollama: ابدأ Ollama في طرفية منفصلة:

ollama serve

يقوم هذا بتشغيل واجهة برمجة تطبيقات Ollama على http://localhost:11434. احتفظ بهذه الطرفية مفتوحة، حيث يحتاجها Open WebUI للاتصال بنماذجك.

تثبيت Open WebUI باستخدام Docker

مع جاهزية Ollama و Llama 3.1، دعنا نثبت Open WebUI باستخدام أمر Docker واحد لإعداد سريع وموثوق.

1. تشغيل Open WebUI: في مجلد ollama-webui الخاص بك، نفذ الأمر:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

هذا الأمر:

- يسحب صورة Open WebUI (

ghcr.io/open-webui/open-webui:main، حوالي 3.77 جيجابايت). - يربط المنفذ 3000 (محلي) بالمنفذ 8080 (الحاوية) للوصول عبر المتصفح.

- يضيف

host.docker.internalللاتصال بواجهة برمجة تطبيقات Ollama علىlocalhost:11434. - يستخدم حجمًا (

open-webui) للحفاظ على سجل الدردشة والإعدادات. - يسمي الحاوية

open-webuiويضبطها لإعادة التشغيل تلقائيًا دائمًا.

يستغرق التنزيل دقيقة. تحقق من تشغيله باستخدام docker ps—ابحث عن حاوية open-webui.

2. الوصول إلى Open WebUI: افتح متصفحك وانتقل إلى http://localhost:3000. سترى صفحة الترحيب الخاصة بـ Open WebUI. انقر على "Sign Up" (التسجيل) لإنشاء حساب (يحصل المستخدم الأول على امتيازات المسؤول). استخدم كلمة مرور قوية واحفظها بأمان. أنت الآن جاهز للدردشة! إذا لم يتم تحميل الصفحة، تأكد من تشغيل الحاوية (docker logs open-webui) وأن المنفذ 3000 متاح.

استخدام Open WebUI: الدردشة واستكشاف الميزات

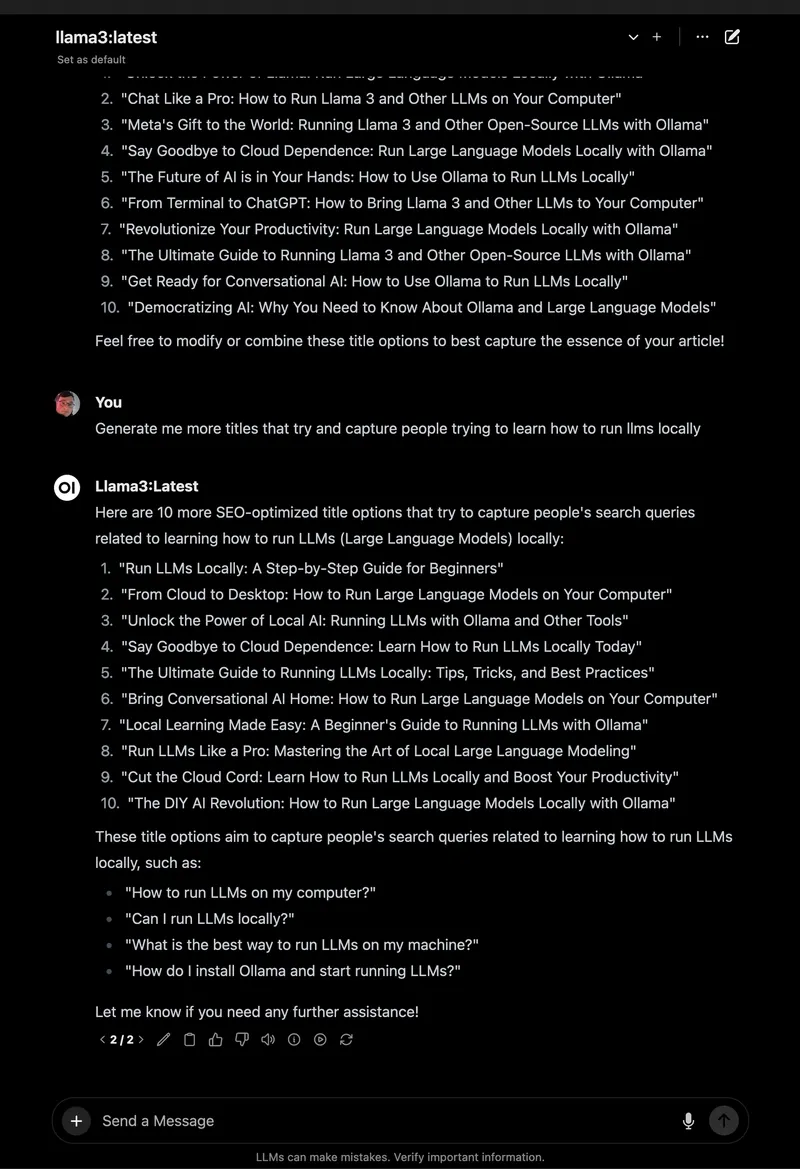

مع تشغيل Open WebUI، دعنا نتعمق في الدردشة مع Llama 3.1 واستكشاف ميزاته الرائعة، التي تجعله ترقية ضخمة مقارنة بالطرفية.

1. ابدأ الدردشة:

- في Open WebUI، حدد

llama3.1:8bمن محدد النموذج في أعلى اليسار (يجب أن يظهر لأنه تم سحبه). - انقر على "New Chat" (دردشة جديدة) في الشريط الجانبي.

- أدخل نفس المطالبة: "Tell me a dad joke about computers."

- اضغط على Enter. ستحصل على رد مثل: "Why did the computer go to art school? Because it wanted to learn to draw a better byte!" (لماذا ذهب الكمبيوتر إلى مدرسة الفن؟ لأنه أراد أن يتعلم رسم "بايت" أفضل!).

الواجهة نظيفة، مع حفظ مطالبتك وردك تلقائيًا في سجل الدردشة.

2. حفظ وتنظيم الدردشات: في الشريط الجانبي الأيسر، انقر على أيقونة الدبوس لحفظ الدردشة. أعد تسميتها (مثل "نكت الآباء") لسهولة الوصول. يمكنك أرشفة أو حذف الدردشات عبر الشريط الجانبي، مما يحافظ على تجاربك منظمة—أفضل بكثير من التمرير في الطرفية!

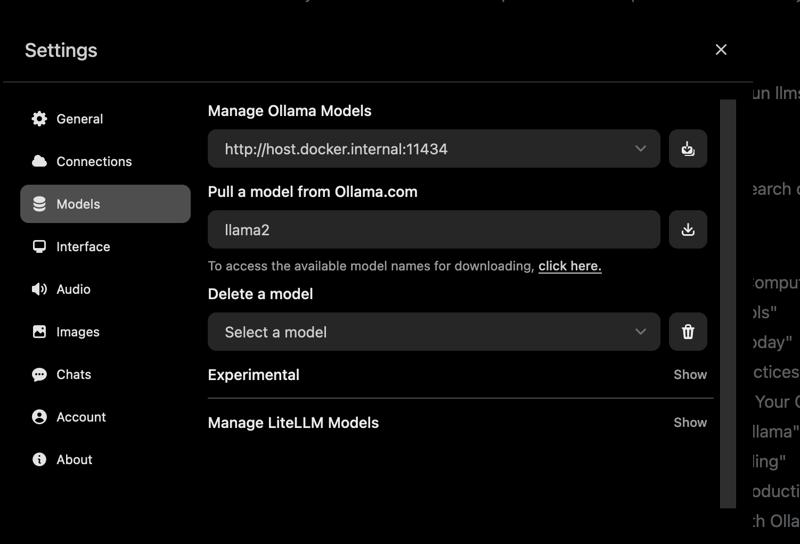

3. تخزين المطالبات: احفظ مطالبة نكتة الأب لإعادة استخدامها:

- اذهب إلى Settings (الإعدادات) > Prompts (المطالبات).

- انقر على "New Prompt" (مطالبة جديدة)، سمها "Dad Joke"، والصق: "Tell me a dad joke about computers."

- احفظ. الآن يمكنك تطبيقها في أي دردشة بنقرة واحدة.

4. تحميل مستند لـ RAG: أضف سياقًا إلى دردشاتك:

- انقر على أيقونة "#" في إدخال الدردشة لفتح مكتبة المستندات.

- قم بتحميل ملف نصي (مثل دليل Spring Boot 3.2).

- اسأل: "How do I use the REST Client in Spring Boot 3.2?" (كيف أستخدم REST Client في Spring Boot 3.2؟). سيشير Llama 3.1 إلى المستند، مقدمًا جزءًا من الكود مثل

RestClient.create().get().uri("/users").retrieve().

اختبرت هذا باستخدام ملف PDF تعليمي لـ Python، ونجح Open WebUI في تقديم إجابات واعية بالسياق، على عكس الردود الأساسية في الطرفية.

5. استكشاف المزيد من الميزات:

- تبديل النماذج: استخدم محدد النموذج لتجربة Mistral أو نماذج أخرى قمت بسحبها (

ollama pull mistral). - تخصيص الردود: انقر على "Chat Control" (التحكم في الدردشة) لضبط النبرة (مثل "مضحك") أو الطول.

- أدوات المسؤول: في Settings (الإعدادات) > Admin (المسؤول)، قم بإدارة المستخدمين أو تقييد الوصول إلى النماذج (رائع للفرق).

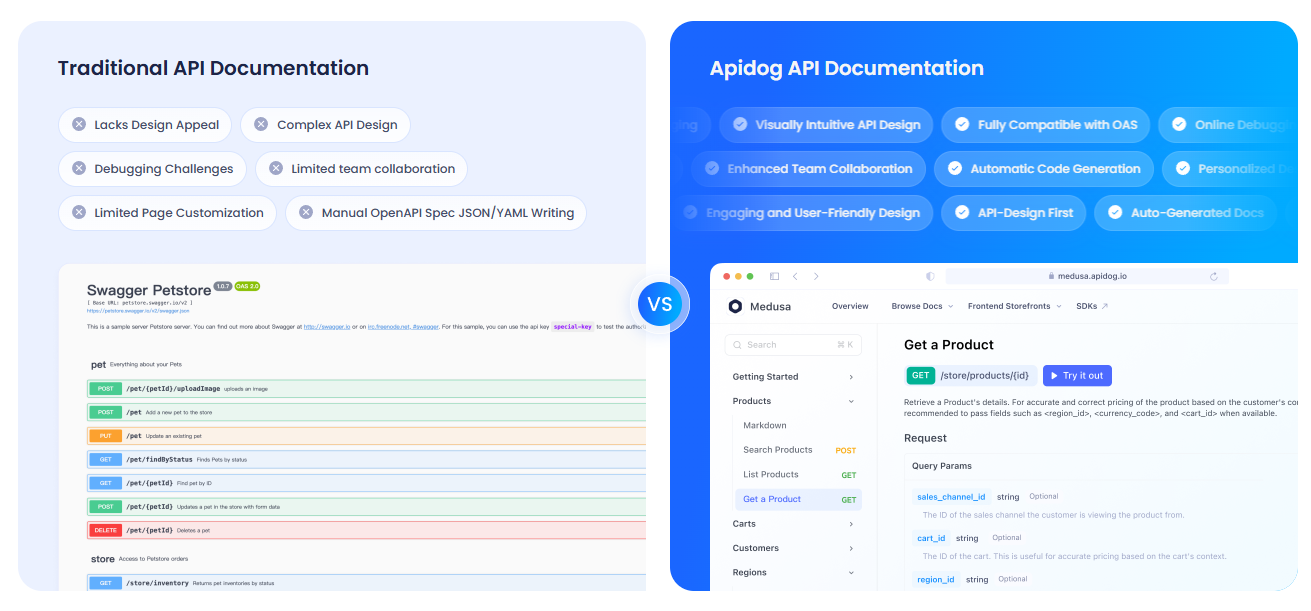

توثيق واجهات برمجة التطبيقات الخاصة بك باستخدام APIdog

هل تستخدم Open WebUI للتفاعل مع واجهة برمجة تطبيقات Ollama وتريد توثيق إعدادك؟ APIdog أداة رائعة لإنشاء وثائق تفاعلية لواجهات برمجة التطبيقات. واجهته الأنيقة وخيارات الاستضافة الذاتية تجعله مثاليًا لمشاركة مشاريع الذكاء الاصطناعي الخاصة بك—تحقق منه!

استكشاف الأخطاء وإصلاحها والنصائح

- مشاكل الاتصال: إذا لم يتمكن Open WebUI من العثور على Ollama، تأكد من تشغيل

ollama serveوأن المنفذ 11434 مفتوح. تحقق من سجلات Docker:docker logs open-webui. - تعارضات المنافذ: إذا كان المنفذ 3000 مشغولًا، أوقف الحاوية (

docker stop open-webui)، احذفها (docker rm open-webui)، وأعد تشغيل أمرdocker runبمنفذ جديد (مثل-p 3001:8080). - الاستجابات البطيئة: استخدم وحدة معالجة رسومات (GPU) مع علامات

:cudaالخاصة بـ Ollama أو نماذج أصغر مثل Mistral للسرعة. - المجتمع: انضم إلى مناقشات GitHub أو Discord الخاصة بـ Open WebUI للحصول على الدعم والأفكار.

لماذا تختار Open WebUI؟

يحول Open WebUI Ollama من أداة طرفية غير مريحة إلى منصة قوية وسهلة الاستخدام:

- واجهة بديهية: لوحة التحكم المستندة إلى المتصفح مثالية للمبتدئين والمحترفين.

- التنظيم: الدردشات والمطالبات المحفوظة تحافظ على عملك مرتبًا، على عكس سجلات الطرفية.

- الوعي بالسياق: تحميل المستندات يتيح RAG للحصول على إجابات أكثر ذكاءً.

- الخصوصية: يعمل محليًا، مما يحافظ على بياناتك آمنة.

بعد اختبار كل من الطرفية و Open WebUI، أنا مقتنع بسهولة وميزات الواجهة الرسومية. إنه مثل الترقية من هاتف قلاب إلى هاتف ذكي!

خاتمة: مغامرة Open WebUI الخاصة بك في انتظارك

لقد انتقلت من الدردشات الطرفية إلى إعداد كامل لـ Open WebUI مع Ollama، مما يجعل تفاعلات LLM سلسة وممتعة! مع Llama 3.1، والدردشات المحفوظة، وتحميل المستندات، أنت جاهز لاستكشاف الذكاء الاصطناعي كما لم يحدث من قبل. جرب نماذج جديدة، خزن المزيد من المطالبات، أو وثق واجهات برمجة التطبيقات الخاصة بك باستخدام APIdog. شارك نجاحاتك مع Open WebUI على GitHub الخاص بـ Open WebUI—أنا متحمس لرؤية ما ستنشئه! استمتع بالعبث بالذكاء الاصطناعي!