هل أنت متحمس للاستفادة من قدرات نماذج لغة Llama المتقدمة من Meta دون إنفاق فلس واحد؟ في هذا الدليل المفصل، سنرشدك عبر طريقتين عمليتين لاستخدام واجهة برمجة تطبيقات Llama (Llama API) مجانًا: الاستفادة من OpenRouter وTogether AI.

button

ما هي واجهة برمجة تطبيقات Llama (Llama API)؟

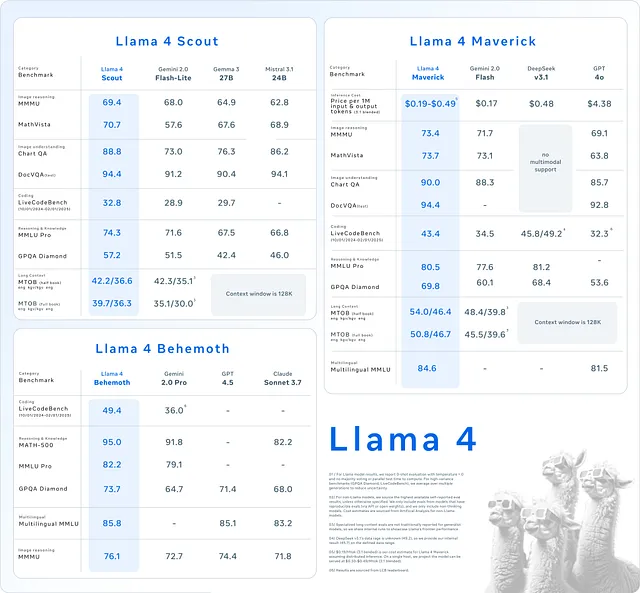

توفر واجهة برمجة تطبيقات Llama (Llama API) الوصول إلى عائلة نماذج اللغة من Meta، بما في ذلك Llama 3 وLlama 4. تتفوق هذه النماذج في مهام مثل توليد النصوص، والفهم السياقي، وحتى التطبيقات متعددة الوسائط التي تتضمن الصور. يستخدم المطورون Llama API لتشغيل تطبيقات تتراوح من روبوتات الدردشة إلى أدوات إنشاء المحتوى، كل ذلك دون الحاجة إلى تدريب النماذج من الصفر.

بينما هذه النماذج مثيرة للإعجاب، فإن الوصول إليها يتضمن عادة تكاليف—إلا إذا كنت تعرف أين تبحث. لحسن الحظ، تقدم منصات مثل OpenRouter وTogether AI وصولاً مجانيًا إلى نماذج Llama معينة. في هذا الدليل، سنغطي كلتا الطريقتين، مع تعليمات خطوة بخطوة وأمثلة برمجية لتبدأ.

لماذا تختار واجهة برمجة تطبيقات Llama (Llama API)؟

قبل أن نقفز إلى الطرق، دعنا نفكر لماذا تبرز واجهة برمجة تطبيقات Llama. أولاً، إنها تقدم معالجة لغوية من الدرجة الأولى، مما يمكّن التطبيقات من إنتاج نصوص متماسكة تشبه النصوص البشرية. بعد ذلك، تقدم الإصدارات الأحدث مثل Llama 4 ميزات متعددة الوسائط، مما يسمح للنموذج بالتعامل مع النصوص والصور على حد سواء—وهو تغيير جذري للمشاريع المبتكرة. أخيرًا، استخدام واجهة برمجة التطبيقات يوفر الوقت والموارد مقارنة ببناء نماذج مخصصة.

مع أخذ ذلك في الاعتبار، دعنا نستكشف كيفية الوصول إلى واجهة برمجة تطبيقات Llama مجانًا.

الطريقة 1: استخدام OpenRouter للوصول إلى واجهة برمجة تطبيقات Llama مجانًا

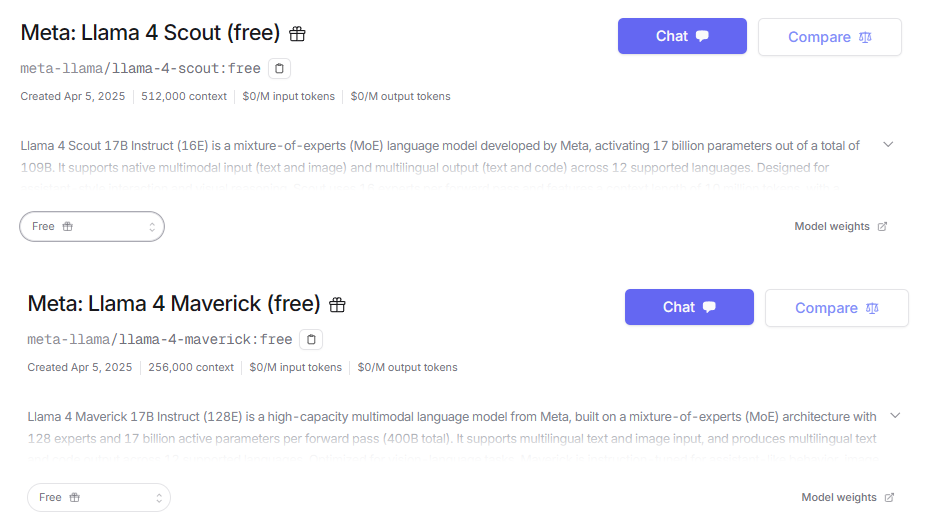

يعمل OpenRouter كمنصة موحدة لواجهات برمجة التطبيقات، مما يمنح الوصول إلى أكثر من 300 نموذج ذكاء اصطناعي، بما في ذلك سلسلة Llama من Meta. والأفضل من ذلك، أنه يقدم طبقة مجانية تتضمن نماذج مثل Llama 4 Maverick وLlama 4 Scout. هذا يجعل OpenRouter نقطة انطلاق مثالية للمطورين الذين يبحثون عن وصول مجاني إلى الذكاء الاصطناعي المتطور.

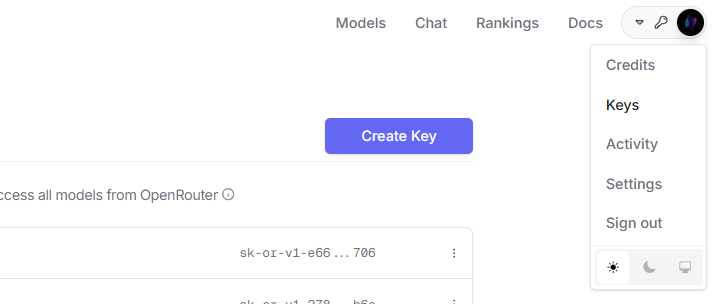

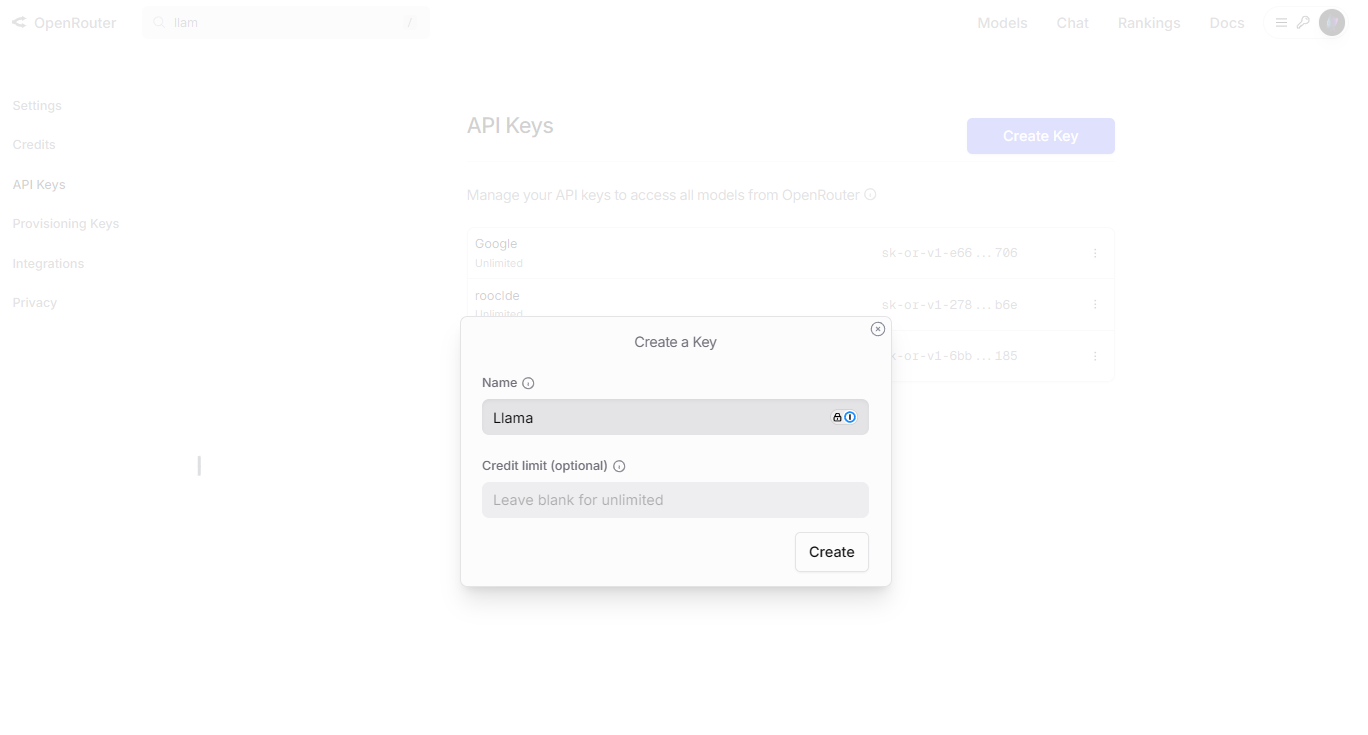

الخطوة 1: التسجيل والحصول على مفتاح API

للبدء، تحتاج إلى حساب OpenRouter ومفتاح API. اتبع هذه الخطوات:

انتقل إلى موقع OpenRouter وانقر على "Sign Up" (التسجيل). قم بتسجيل الدخول، ثم توجه إلى قسم "API Keys" (مفاتيح API) في لوحة التحكم الخاصة بك.

انقر على "Create Key" (إنشاء مفتاح)، سمّه (على سبيل المثال، "Llama Free Key")، وانسخ المفتاح بأمان.

الخطوة 2: إعداد بيئتك

ستحتاج إلى لغة برمجة ومكتبة عميل HTTP للتفاعل مع واجهة برمجة التطبيقات. سنستخدم Python مع مكتبة requests. قم بتثبيتها إذا لم تكن قد فعلت ذلك بالفعل:

pip install requests

الخطوة 3: إرسال طلبك الأول

الآن، دعنا نكتب نصًا برمجيًا بلغة Python لتوليد نص باستخدام نموذج Llama 4 Scout عبر OpenRouter:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://openrouter.ai/api/v1/chat/completions"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "meta-llama/llama-4-scout:free",

"messages": [

{"role": "user", "content": "Describe the Llama API in one sentence."}

],

"max_tokens": 50

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["choices"][0]["message"]["content"])

else:

print(f"Error: Request failed with status {response.status_code}")

يرسل هذا النص البرمجي طلبًا إلى نموذج Llama 4 Scout ويطبع الاستجابة. اضبط max_tokens للتحكم في طول الإخراج.

الخطوة 4: تجربة الميزات

يدعم OpenRouter التخصيص. على سبيل المثال، قم بتعديل معامل temperature لضبط إبداع الاستجابة، أو استكشف القدرات متعددة الوسائط مع نماذج مثل Llama 4 Maverick. تحقق من صفحة نماذج OpenRouter للحصول على تفاصيل حول الخيارات المتاحة.

الطريقة 2: استخدام Together AI للوصول إلى واجهة برمجة تطبيقات Llama مجانًا

Together AI هي منصة أخرى تستضيف نماذج Llama، وتقدم وصولاً مجانيًا إلى نماذج Llama 3 مثل Llama 3.2 11B. ومع ذلك، لاحظ أن Llama 4 ليست مجانية على Together AI في الوقت الحالي—الخطط المدفوعة فقط هي التي تفتحها. إذا كان Llama 3 يلبي احتياجاتك، فإن هذه الطريقة تعمل بشكل جيد.

الخطوة 1: التسجيل والحصول على مفتاح API

ابدأ بإعداد حساب Together AI:

قم بزيارة موقع Together AI وانتقل إلى قسم "API Keys" (مفاتيح API) وأنشئ مفتاحًا جديدًا.

احفظ المفتاح بأمان لاستخدامه في طلباتك.

الخطوة 2: تجهيز بيئتك

كما هو الحال مع OpenRouter، سنستخدم Python وrequests. قم بتثبيتها إذا لزم الأمر:

pip install requests

الخطوة 3: إجراء استدعاء API

إليك نص برمجي بلغة Python لتوليد نص باستخدام نموذج Llama 3 على Together AI:

import requests

import json

# Define the endpoint and your API key

API_URL = "https://api.together.xyz/inference"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "llama-3-2-11b-free",

"prompt": "What does the Llama API do?",

"max_tokens": 50,

"temperature": 0.7

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["output"]["text"])

else:

print(f"Error: Request failed with status {response.status_code}")

يستعلم هذا النص البرمجي عن نموذج Llama 3 ويعرض الإخراج. إعداد temperature يوازن بين الإبداع والتماسك.

الخطوة 4: معرفة الحدود

تتضمن الطبقة المجانية في Together AI قيودًا، مثل حدود المعدل وعدم الوصول إلى Llama 4. راجع صفحة نماذج Together AI لفهم ما هو متاح والتخطيط وفقًا لذلك.

تحسين تجربتك مع واجهة برمجة تطبيقات Llama

لتحقيق أقصى قدر من النجاح مع واجهة برمجة تطبيقات Llama، اتبع هذه الممارسات:

- صياغة طلبات دقيقة (Prompts): الطلبات الواضحة تؤدي إلى نتائج أفضل. اختبر الاختلافات لتحسين المخرجات.

- تتبع الاستخدام: راقب استدعاءات واجهة برمجة التطبيقات الخاصة بك عبر لوحات تحكم OpenRouter أو Together AI للبقاء ضمن حدود الطبقة المجانية.

- معالجة الأخطاء: أضف كتل try-except في التعليمات البرمجية الخاصة بك لإدارة حالات الفشل بسلاسة.

- تخزين الاستجابات مؤقتًا (Cache): قم بتخزين نتائج الاستعلامات المتكررة لتقليل استخدام واجهة برمجة التطبيقات وتسريع تطبيقك.

تضمن هذه الخطوات الكفاءة والموثوقية في مشاريعك.

استكشاف المشكلات الشائعة وإصلاحها

قد تنشأ مشكلات عند استخدام واجهة برمجة تطبيقات Llama. إليك كيفية إصلاحها:

- 401 Unauthorized (غير مصرح به): تحقق من صحة مفتاح API الخاص بك وأنه مدرج في الرؤوس (headers).

- 429 Too Many Requests (طلبات كثيرة جدًا): لقد تجاوزت حد المعدل—انتظر أو قم بترقية خطتك.

- Invalid Model (نموذج غير صالح): تأكد من أن اسم النموذج يطابق وثائق المزود.

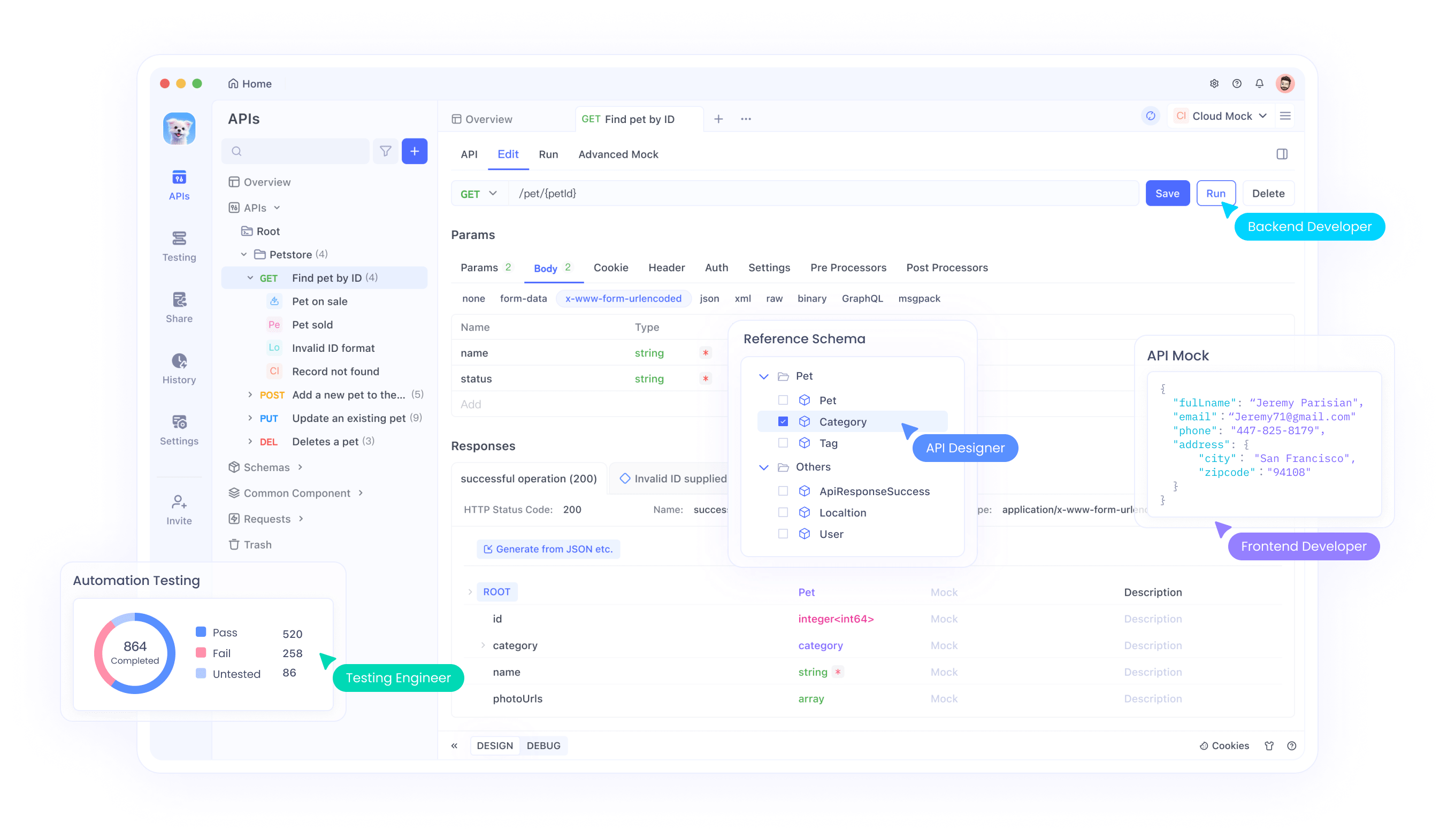

- Bad Payload (حمولة سيئة): تحقق من بناء جملة JSON الخاص بك. يمكن لأدوات مثل Apidog المساعدة في تصحيح هذا الخطأ.

بمناسبة الحديث عن الأدوات، قم بتنزيل Apidog مجانًا لتبسيط اختبار واستكشاف أخطاء استدعاءات واجهة برمجة التطبيقات الخاصة بك—إنه أمر لا غنى عنه للمطورين.

مقارنة بين OpenRouter و Together AI

تقدم كلتا المنصتين وصولاً مجانيًا، لكنهما تختلفان:

- توفر النماذج: يشمل OpenRouter نموذج Llama 4 مجانًا؛ بينما تحد Together AI الوصول المجاني بنموذج Llama 3.

- سهولة الاستخدام: كلاهما يوفر واجهات برمجة تطبيقات مباشرة، ولكن اختيار OpenRouter الأوسع للنماذج يبرز.

- قابلية التوسع: قد تدفع Together AI نحو الخطط المدفوعة للميزات المتقدمة، بينما الطبقة المجانية في OpenRouter أكثر سخاءً.

اختر بناءً على احتياجات مشروعك—الوصول إلى Llama 4 يميل نحو OpenRouter، بينما Together AI يناسب مستخدمي Llama 3.

حالات الاستخدام لواجهة برمجة تطبيقات Llama

تتألق واجهة برمجة تطبيقات Llama في سيناريوهات مختلفة:

- روبوتات الدردشة (Chatbots): قم ببناء وكلاء محادثة باستجابات طبيعية.

- إنشاء المحتوى: قم بتوليد مقالات، ملخصات، أو تعليقات توضيحية.

- تطبيقات متعددة الوسائط: ادمج معالجة النصوص والصور مع Llama 4 (عبر OpenRouter).

تعرض هذه التطبيقات تعدد استخدامات واجهة برمجة التطبيقات، وكلها قابلة للتحقيق مجانًا بالإعداد الصحيح.

الخلاصة

في هذا الدليل، أوضحنا كيفية استخدام واجهة برمجة تطبيقات Llama مجانًا من خلال OpenRouter وTogether AI. يمنح OpenRouter الوصول إلى نماذج Llama 4، بينما تقدم Together AI نموذج Llama 3 في طبقتها المجانية. مع التعليمات التفصيلية ومقتطفات التعليمات البرمجية، أنت الآن مجهز لدمج هذه النماذج في مشاريعك. ابدأ التجربة اليوم، ولا تنسَ الاستفادة من أدوات مثل Apidog لتحسين سير عملك. قوة Llama بين يديك—استخدمها بحكمة!

button