تشغيل نماذج قوية محليًا أصبح أمرًا مهمًا بشكل متزايد من أجل الخصوصية والسرعة وكفاءة التكلفة. واحدة من أحدث الابتكارات في هذا المجال هي Command A—نموذج توليدي متطور مصمم لتحقيق الأداء الأقصى مع الحد الأدنى من حسابات الحوسبة. إذا كنت تستكشف خيارات نشر الذكاء الاصطناعي المحلي، ستوجهك هذه الدليل حول كيفية تشغيل Command A محليًا باستخدام Ollama.

لكن ما هو Command A بالضبط؟ ولماذا تم إنشاؤه، وكيف يقارن بالنماذج الرائدة مثل GPT-4o و DeepSeek-V3؟ في هذا الدليل، سنتعمق في الغرض ومعايير الأداء وأسعار واجهة برمجة التطبيقات لـ Command A. سنقدم أيضًا دليل خطوة بخطوة لإعداد وتشغيل Command A على جهازك باستخدام Ollama.

ما هو Command A؟

Command A هو نموذج ذكاء اصطناعي توليدي متطور مصمم لتطبيقات المؤسسات. تم تطويره من قبل فريق Cohere، Command A مصمم لتقديم أداء أقصى مع الحد الأدنى من الحمل الحسابي. تم تصميمه ليعمل على الأجهزة المحلية بحجم خدمات صغير يصل إلى وحدتين معالجة رسومية، مقارنة بـ 32 وحدة معالجة رسومية مطلوبة عادةً من قبل نماذج أخرى. هيكله مصمم لتحسين استجابات الذكاء الاصطناعي السريعة والآمنة وعالية الجودة، مما يجعله خيارًا جذابًا للنشر الخاص.

في جوهره، يعد Command A أداة تسهل مهام المعالجة والتوليد المتقدمة للغة الطبيعية. يعمل كعمود فقري للتطبيقات التي تحتاج إلى معالجة كميات كبيرة من النص بسرعة، والتعامل مع تعليمات معقدة، وتقديم استجابات موثوقة بطريقة محادثة.

من سيستخدم Command A؟

تم تصميم Command A لتطبيقات المؤسسات، حيث يقدم أداءً عاليًا مع الحد الأدنى من متطلبات الأجهزة. إنه يعمل بكفاءة على وحدتين معالجة رسومية (A100s أو H100s) دون التضحية بالسرعة أو الدقة. مع سياق طوله 256k، يتفوق في معالجة الوثائق الطويلة، والطلبات متعددة اللغات، والمهام الحيوية للأعمال.

تدعم قدراته الوكيلة سير العمل المستقل، بينما يضمن تحسين متعدد اللغات استجابات متسقة عبر لغات مختلفة. بالإضافة إلى ذلك، فإن المتطلبات المنخفضة للأجهزة والتوليد الأسرع للتوكنات تجعل منه حلًا اقتصاديًا، مما يقلل من الكمون والنفقات التشغيلية. أخيرًا، تعزز النشر المحلي الأمان، حيث تبقي البيانات الحساسة داخل المؤسسة وتقلل من المخاطر المرتبطة بخدمات الذكاء الاصطناعي السحابية.

تجعل هذه المزايا Command A خيارًا جذابًا للشركات التي تسعى لدمج قدرات ذكاء اصطناعي قوية دون تحمل التكاليف العالية المرتبطة عادةً بالنماذج الرائدة.

أسعار واجهة برمجة التطبيقات لـ Cohere Command A

التكلفة هي اعتبار رئيسي لأي مؤسسة تقوم بنشر حلول الذكاء الاصطناعي. تم تصميم Command A ليكون عالي الأداء وذو تكلفة فعالة. إليك كيف تقارن أسعاره:

أسعار واجهة برمجة التطبيقات لـ Cohere Command A:

- توكين الإدخال: 2.50 دولار لكل 1 مليون توكن

- توكين الإخراج: 10.00 دولار لكل 1 مليون توكن

عند مقارنة هذه التكاليف تلك المتطلبات وصول واجهة برمجة التطبيقات السحابية لنماذج أخرى، يمكن أن تكون نفقات النشر الخاصة بـ Command A حتى 50% أرخص. يتم تحقيق هذا التخفيض الكبير في التكاليف من خلال:

- استخدام حسابات فعالة: تتطلب فقط وحدتي معالجة رسومية بدلاً من العشرات.

- زيادة التدفق: يولد التوكين بسرعة أكبر مما يقلل من زمن المعالجة، مما يؤدي إلى انخفاض التكاليف التشغيلية.

- نشر خاص: تشغيل النموذج في الموقع لا يعزز الأمان فحسب، بل يتجنب أيضًا تكاليف واجهة برمجة التطبيقات السحابية المتكررة.

بالنسبة للشركات التي تقوم بمعالجة كميات كبيرة من البيانات أو تتطلب تفاعلات سريعة وسلسة مع الذكاء الاصطناعي، فإن هذه المزايا السعرية تجعل Command A خيارًا جذابًا للغاية.

كيفية تثبيت وتكوين Ollama لتشغيل Command A

لماذا تشغيل Command-A محليًا؟

- الخصوصية: تبقى بياناتك على جهازك.

- التكلفة: لا رسوم استخدام أو حدود على واجهة برمجة التطبيقات.

- التخصيص: اضبط النموذج وفقًا لاحتياجاتك.

- الوصول بدون إنترنت: استخدم الذكاء الاصطناعي دون اتصال بالإنترنت.

المتطلبات الأساسية

- Ollama: قم بتثبيته من Ollama.ai.

- نموذج Command A: يمكنك الحصول على نموذج

command-aمباشرة من الموقع الرسمي لـ Ollama في قسم "النماذج".

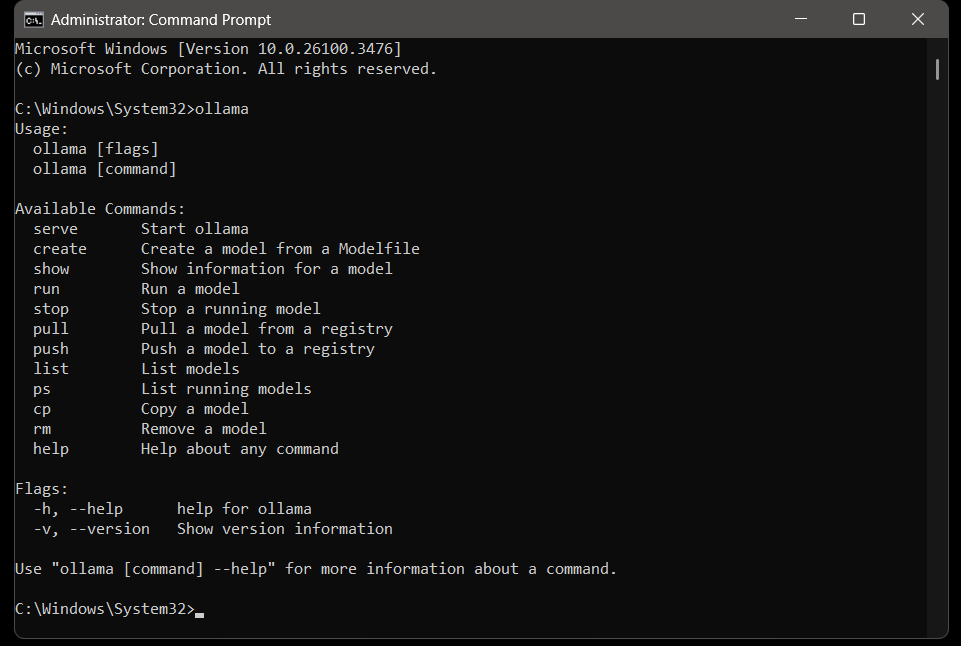

الخطوة 1: تثبيت Ollama

Windows/macOS/Linux:

- قم بتحميل Ollama من الموقع الرسمي، ثم قم بتشغيل المثبت. بعد التثبيت، تأكد من التحقق من التثبيت باستخدام الأمر التالي:

ollama --version

# مثال على المخرج: نسخة ollama 0.1.23 عند تثبيت Ollama على نظامك، يمكنك تشغيل الأمر ollama لرؤية الأوامر المتاحة لـ Ollama.

الخطوة 2: سحب نموذج Command A

يدعم Ollama الآلاف من النماذج عبر مكتبته. فقط توجه إلى موقعهم الرسمي وابحث عن command a في قسم "النماذج".

# سحب النموذج

ollama pull command-a

# سحب النموذج وتشغيله بعد الاكتمال

ollama run command-a

ملاحظة: إذا كان لديك ملف نموذج Command-a مخصص، استخدم:

ollama create command-a -f Modelfileتذكر أن النموذج كبير جدًا ويتطلب مساحة تخزين كبيرة. قبل التثبيت، تحقق من مساحة القرص المتاحة لديك واستكشاف نماذج أخرى للعثور على واحدة تناسب سعة نظامك بشكل أفضل.

الخطوة 3: تشغيل Command A محليًا

ابدأ خادم Ollama وتشغيل النموذج:

# يبدأ الخادم

ollama serve

# يحمل النموذج

ollama run command-r اختبره: اطرح سؤالاً مباشرة في الطرفية:

# سؤال إدخال عينة

>>> ما هي عاصمة زامبيا؟

# استجابة العينة

>>> لوساكااستكشاف الأخطاء وإصلاحها

حتى مع إعداد قوي، قد تواجه بعض المشكلات. إليك بعض نصائح واستراتيجيات لمواجهة المشكلات:

1. خطأ "النموذج غير موجود"

- تحقق من اسم النموذج:

ollama list - اسحب النموذج مرة أخرى:

ollama pull command-a

2. مشاكل الاتصال بواجهة برمجة التطبيقات

- تأكد من تشغيل Ollama:

ollama serve

3. أداء بطيء

- استخدم نماذج أصغر (مثل

command-r:3b). - خصص المزيد من ذاكرة الوصول العشوائي لـ Ollama.

Command A مقابل GPT-4o & Deepseek V3

عند تقييم نماذج الذكاء الاصطناعي، من الضروري مقارنتها ليس فقط من حيث الأداء النظري، ولكن أيضًا من خلال معايير الأداء العملية والحالات الاستخدام في الواقع. تم تقييم Command-a ضد نماذج مثل GPT-4o و DeepSeek-V3، وكانت النتائج مثيرة للإعجاب:

- كفاءة الأداء: يوفر Command-a توكنات بمعدل يصل إلى 156 توكن في الثانية، وهو أسرع بـ 1.75 مرة من GPT-4o وأسرع بـ 2.4 مرة من DeepSeek-V3. هذا التدفق الأعلى يعني استجابات أسرع وتجربة مستخدم محسنة.

- متطلبات الحوسبة: بينما تتطلب العديد من النماذج ما يصل إلى 32 وحدة معالجة رسومية لتحقيق الأداء الأمثل، يعمل Command-a بفعالية على وحدتين فقط. هذا التخفيض الكبير في متطلبات الأجهزة لا يقلل التكاليف فحسب، بل يجعله أكثر سهولة للنشر الخاص.

- طول السياق: مع سياق طوله 256k توكن، يتفوق Command-a على العديد من النماذج الرائدة التي لديها عادة نوافذ سياق أقصر. وهذا يسمح لـ Command-a بإدارة وفهم مستندات أطول بكثير، وهو ميزة رئيسية لتطبيقات المؤسسات.

- التقييم البشري: في التقييمات المباشرة البشرية للمهام التي تشمل الأعمال، وSTEM، والترميز، يتطابق Command-a أو يتجاوز أداء المنافسين الأكبر والأبطأ. تستند هذه التقييمات إلى دقة موجهة نحو المؤسسات، واتباع التعليمات، والنمط، مما يضمن تلبية Command-a لمتطلبات الأعمال الواقعية.

بشكل عام، تؤكد فلسفة تصميم Command A على الكفاءة، والقابلية للتوسع، والأداء العالي، مما يجعله نموذج بارز في مشهد الذكاء الاصطناعي التنافسي.

أفكار نهائية

في هذا الدليل الشامل، استكشفنا كيفية تشغيل Command A محليًا باستخدام Ollama، جنبًا إلى جنب مع رؤى متعمقة حول ما هو Command A، ولماذا تم إنشاؤه، وكيف يقارن بنماذج أخرى متطورة مثل GPT-4o و DeepSeek-V3.

Command A هو نموذج توليدي متطور مُحسَّن لتحقيق أقصى أداء مع الحد الأدنى من متطلبات الأجهزة. يتفوق في بيئات المؤسسات من خلال توفير توليد توكنات أسرع، ونافذة سياق أكبر، وكفاءة في التكاليف. مع معايير الأداء التي تظهر أنه يمكنه توفير توكنات بمعدل يصل إلى 156 توكن في الثانية—ما يتفوق على منافسيه—ومع متطلبات حوسبة منخفضة بشكل كبير، يمثل Command A مستقبل الذكاء الاصطناعي الفعال.

كما قمنا بتفصيل أسعار واجهة برمجة التطبيقات، والتي تبلغ 2.50 دولار لكل 1 مليون توكن إدخال و10.00 دولارات لكل 1 مليون توكن إخراج، مما يجعل Command A خيارًا جذابًا اقتصاديًا للنشر الخاص.

من خلال اتباع دليلنا خطوة بخطوة، تعلمت كيفية:

- إعداد البيئة اللازمة لتشغيل Command-a.

- تكوين Ollama ليكون محركًا محليًا يعمل بتقنية Command-a.

- فهم فوائد الأداء وهيكل الأسعار الذي يجعله Command-a يتفوق في مشهد الذكاء الاصطناعي التنافسي.

الآن بعد أن زودت بهذا المعرفة، يمكنك تجربة استفسارات المؤسسات المختلفة، ودمج وظائف إضافية، وتحسين نشرات الذكاء الاصطناعي المحلية لديك.

🚀 عزز تدفق تطوير واجهة برمجة التطبيقات واختبارها! قم بتحميل Apidog مجانًا وسهل عملية التكامل الخاصة بك مع أدوات اختبار واجهات برمجة التطبيقات عالية الجودة.