Entwickler suchen ständig nach fortschrittlichen KI-Modellen, um die Argumentation, Codierung und Problemlösung in ihren Anwendungen zu verbessern. Die Qwen3-Max-Thinking API sticht als Vorabversion hervor, die in diesen Bereichen neue Maßstäbe setzt. Dieser Leitfaden erklärt, wie Ingenieure diese API effektiv nutzen und implementieren. Darüber hinaus werden Tools hervorgehoben, die den Prozess vereinfachen.

Alibaba Cloud betreibt die Qwen3-Max-Thinking API und bietet eine frühe Vorschau auf verbesserte Denkfähigkeiten. Als Zwischenstand während des Trainings veröffentlicht, erreicht dieses Modell in Kombination mit Tool-Nutzung und skalierter Rechenleistung eine bemerkenswerte Leistung bei Benchmarks wie AIME 2025 und HMMT. Darüber hinaus aktivieren Benutzer den Denkmodus einfach über Parameter wie enable_thinking=True. Mit fortschreitendem Training sind noch stärkere Funktionen zu erwarten. Dieser Artikel behandelt alles von der Registrierung bis zur fortgeschrittenen Nutzung und stellt sicher, dass Sie die Qwen3-Max-Thinking API reibungslos in Ihre Arbeitsabläufe integrieren.

Die Qwen3-Max-Thinking API verstehen

Ingenieure erkennen die Qwen3-Max-Thinking API als eine Weiterentwicklung von Alibabas Qwen-Serie an, die speziell für überlegene Denkaufgaben entwickelt wurde. Im Gegensatz zu Standardmodellen integriert diese Vorschau "Denkbudgets", die es Benutzern ermöglichen, die Tiefe der Argumentation in Bereichen wie Mathematik, Codierung und wissenschaftlicher Analyse zu steuern. Alibaba veröffentlichte diese Version, um Fortschritte zu demonstrieren, auch während das Training fortgesetzt wird.

Das Basismodell Qwen3-Max verfügt über mehr als eine Billion Parameter und wurde mit 36 Billionen Tokens trainiert, was das Datenvolumen seines Vorgängers Qwen2.5 verdoppelt. Es unterstützt ein massives Kontextfenster von 262.144 Tokens, mit einer maximalen Eingabe von 258.048 Tokens und einer Ausgabe von 65.536 Tokens. Darüber hinaus verarbeitet es über 100 Sprachen, was es vielseitig für globale Anwendungen macht. Die Qwen3-Max-Thinking-Variante fügt jedoch agentische Funktionen hinzu, die Halluzinationen reduzieren und mehrstufige Prozesse durch Qwen-Agent-Tool-Aufrufe ermöglichen.

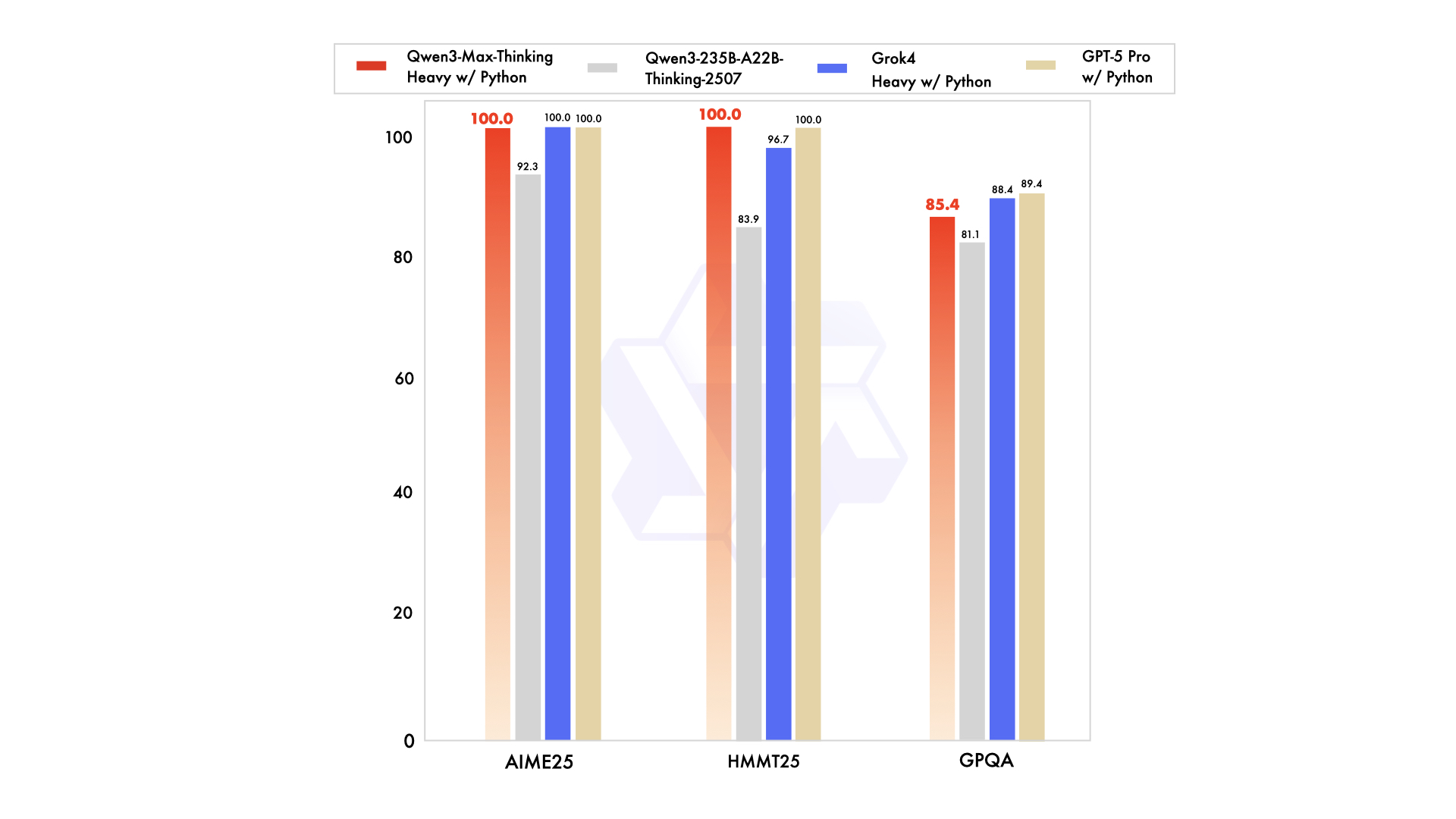

Leistungskennzahlen unterstreichen seine Stärken. Zum Beispiel erreicht es 74,8 Punkte bei LiveCodeBench v6 für Codierung und 81,6 Punkte bei AIME25 für Mathematik. Bei Erweiterung erreicht es 100 % bei anspruchsvollen Benchmarks wie AIME 2025 und HMMT. Dennoch arbeitet diese Vorschau zunächst als nicht-denkendes Instruktionsmodell, wobei Denkverbesserungen über spezifische Flags aktiviert werden. Entwickler greifen über die API von Alibaba Cloud darauf zu, die die Kompatibilität mit OpenAI-Standards für eine einfache Migration aufrechterhält.

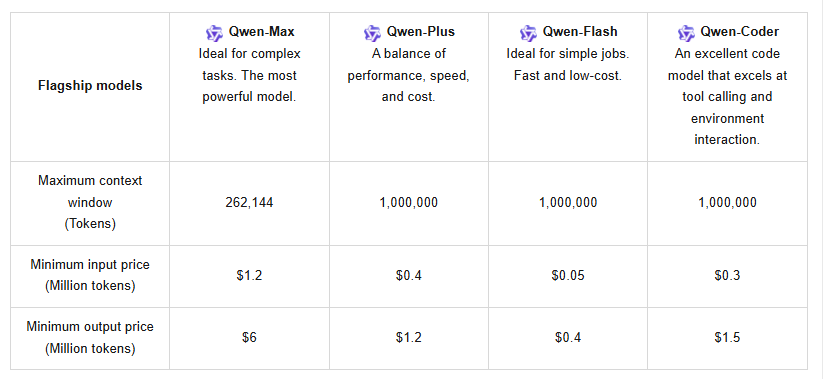

Darüber hinaus unterstützt die API Kontext-Caching, was wiederholte Abfragen optimiert und Kosten senkt. Die Preisgestaltung folgt einer gestaffelten Struktur: Für 0–32K Tokens kosten Eingaben 1,2 $ pro Million und Ausgaben 6 $ pro Million; für 32K–128K steigen die Eingaben auf 2,4 $ und die Ausgaben auf 12 $; und für 128K–252K erreichen die Eingaben 3 $ bei Ausgaben von 15 $. Neue Benutzer profitieren von einem kostenlosen Kontingent von einer Million Tokens, gültig für 90 Tage, was erste Tests fördert.

Im Vergleich zu Konkurrenten wie Claude Opus 4 oder DeepSeek-V3.1 übertrifft Qwen3-Max-Thinking in agentischen Aufgaben, wie SWE-Bench Verified mit 72,5. Dennoch bedeutet sein Vorschaustatus, dass einige Funktionen, wie vollständige Denkbudgets, noch in Entwicklung sind. Benutzer können es über Qwen Chat für interaktive Sitzungen oder die API für programmatischen Zugriff ausprobieren. Diese Konfiguration positioniert die Qwen3-Max-Thinking API als ein Schlüsselwerkzeug für Softwareentwicklung, Bildung und Unternehmensautomatisierung.

Voraussetzungen für den Zugriff auf die Qwen3-Max-Thinking API

Bevor Entwickler fortfahren, müssen sie die wesentlichen Anforderungen sammeln. Zuerst erstellen Sie ein Alibaba Cloud-Konto, falls noch keines vorhanden ist. Besuchen Sie die Alibaba Cloud-Website und registrieren Sie sich mit einer E-Mail-Adresse oder Telefonnummer. Verifizieren Sie das Konto über den bereitgestellten Link oder Code, um vollen Zugriff zu ermöglichen.

Als Nächstes stellen Sie sicher, dass Sie mit API-Konzepten vertraut sind, einschließlich RESTful-Endpunkten und JSON-Payloads. Die Qwen3-Max-Thinking API verwendet HTTPS-Protokolle, daher sind sichere Verbindungen wichtig. Bereiten Sie außerdem Entwicklungstools vor: Python 3.x oder ähnliche Sprachen mit Bibliotheken wie requests für HTTP-Aufrufe. Für fortgeschrittene Integrationen sollten Frameworks wie vLLM oder SGLang in Betracht gezogen werden, die ein effizientes Serving auf mehreren GPUs unterstützen.

Die Authentifizierung erfordert einen API-Schlüssel von Alibaba Cloud. Navigieren Sie nach dem Login zur Konsole und generieren Sie Schlüssel im Bereich API-Verwaltung. Speichern Sie diese sicher, da sie den Zugriff auf Modell-Endpunkte gewähren. Halten Sie sich außerdem an die Nutzungsrichtlinien – vermeiden Sie übermäßige Aufrufe, um Ratenbegrenzungen zu verhindern. Das System bietet die neuesten und Snapshot-Versionen; wählen Sie Snapshots für stabile Leistung unter hoher Last.

Hardware-Überlegungen gelten für lokale Tests, obwohl der Cloud-Zugriff dies mildert. Das Modell erfordert erhebliche Rechenleistung, aber Alibabas Infrastruktur bewältigt dies. Laden Sie schließlich unterstützende Tools wie Apidog herunter, um das Testen zu optimieren. Apidog verwaltet Anfragen, Umgebungen und Kollaborationen, was es ideal für Experimente mit den Qwen3-Max-Thinking API-Parametern macht.

Mit diesen Voraussetzungen vermeiden Ingenieure häufige Fallstricke wie Authentifizierungsfehler oder Quotenerschöpfung. Diese Vorbereitung gewährleistet einen reibungslosen Übergang zur eigentlichen Implementierung.

Schritt-für-Schritt-Anleitung zur Beschaffung und Einrichtung der Qwen3-Max-Thinking API

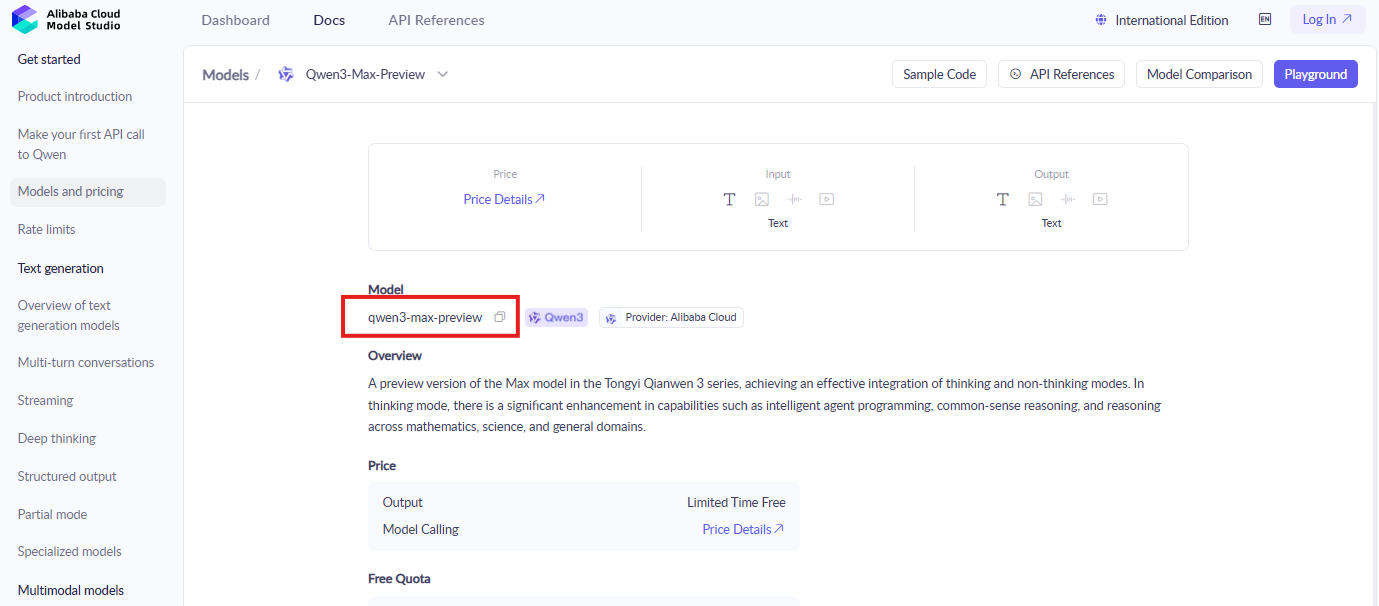

Entwickler beginnen mit der Anmeldung bei der Alibaba Cloud-Konsole. Suchen Sie den ModelStudio-Bereich, in dem sich die Qwen-Modelle befinden. Suchen Sie nach "qwen3-max-preview" oder ähnlichen Bezeichnungen, um die Dokumentation und Aktivierungsseite zu finden.

Aktivieren Sie als Nächstes das Modell. Klicken Sie auf die Schaltfläche "Aktivieren" für Qwen3-Max-Thinking und stimmen Sie den Bedingungen zu, falls Sie dazu aufgefordert werden. Dieser Schritt gewährt Zugriff auf die Vorschaufunktionen. Lösen Sie außerdem das kostenlose Token-Kontingent ein, indem Sie den Anweisungen auf dem Bildschirm folgen – neue Konten qualifizieren sich automatisch.

Generieren Sie dann API-Anmeldeinformationen. Erstellen Sie im Bereich zur Verwaltung der API-Schlüssel ein neues Schlüsselpaar. Notieren Sie sich die Zugriffs-Schlüssel-ID und das Geheimnis; diese authentifizieren Anfragen. Vermeiden Sie es, diese öffentlich zu teilen, um die Sicherheit zu gewährleisten.

Konfigurieren Sie anschließend Ihre Entwicklungsumgebung. Installieren Sie die notwendigen Bibliotheken über pip, z.B. pip install requests openai. Obwohl OpenAI-kompatibel, passen Sie die Endpunkte an die Basis-URL von Alibaba an, typischerweise so etwas wie "https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generation".

Testen Sie einen grundlegenden Aufruf, um die Einrichtung zu überprüfen. Erstellen Sie eine JSON-Payload mit dem Modellnamen "qwen3-max-preview", dem Eingabe-Prompt und dem entscheidenden Parameter "enable_thinking": true. Senden Sie eine POST-Anfrage an den Endpunkt. Zum Beispiel:

import requests

url = "https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generation"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "qwen3-max-preview",

"input": {

"messages": [{"role": "user", "content": "Solve this math problem: What is 2+2?"}]

},

"parameters": {

"enable_thinking": True

}

}

response = requests.post(url, headers=headers, json=data)

print(response.json())

Überwachen Sie die Antwort auf Denkschritte in der Ausgabe. Bei Erfolg demonstriert dies aktives Denken. Behandeln Sie jedoch Fehler wie 401 für ungültige Schlüssel, indem Sie die Anmeldeinformationen überprüfen.

Erweitern Sie auf fortgeschrittene Konfigurationen. Integrieren Sie Tool-Aufrufe, indem Sie Funktionen in die Payload aufnehmen. Die API unterstützt Qwen-Agent für agentische Workflows, die mehrstufige Ausführungen ermöglichen. Verwenden Sie außerdem Kontext-Caching, indem Sie Cache-IDs in Anfragen aufnehmen, um frühere Kontexte effizient wiederzuverwenden.

Beheben Sie Probleme umgehend. Ratenbegrenzungen lösen 429-Fehler aus; wechseln Sie zu Snapshot-Versionen oder optimieren Sie Abfragen. Netzwerkprobleme erfordern stabile Verbindungen. Durch Befolgen dieser Schritte sichern Entwickler einen zuverlässigen Zugriff auf die Qwen3-Max-Thinking API.

Die Qwen3-Max-Thinking API mit Apidog integrieren

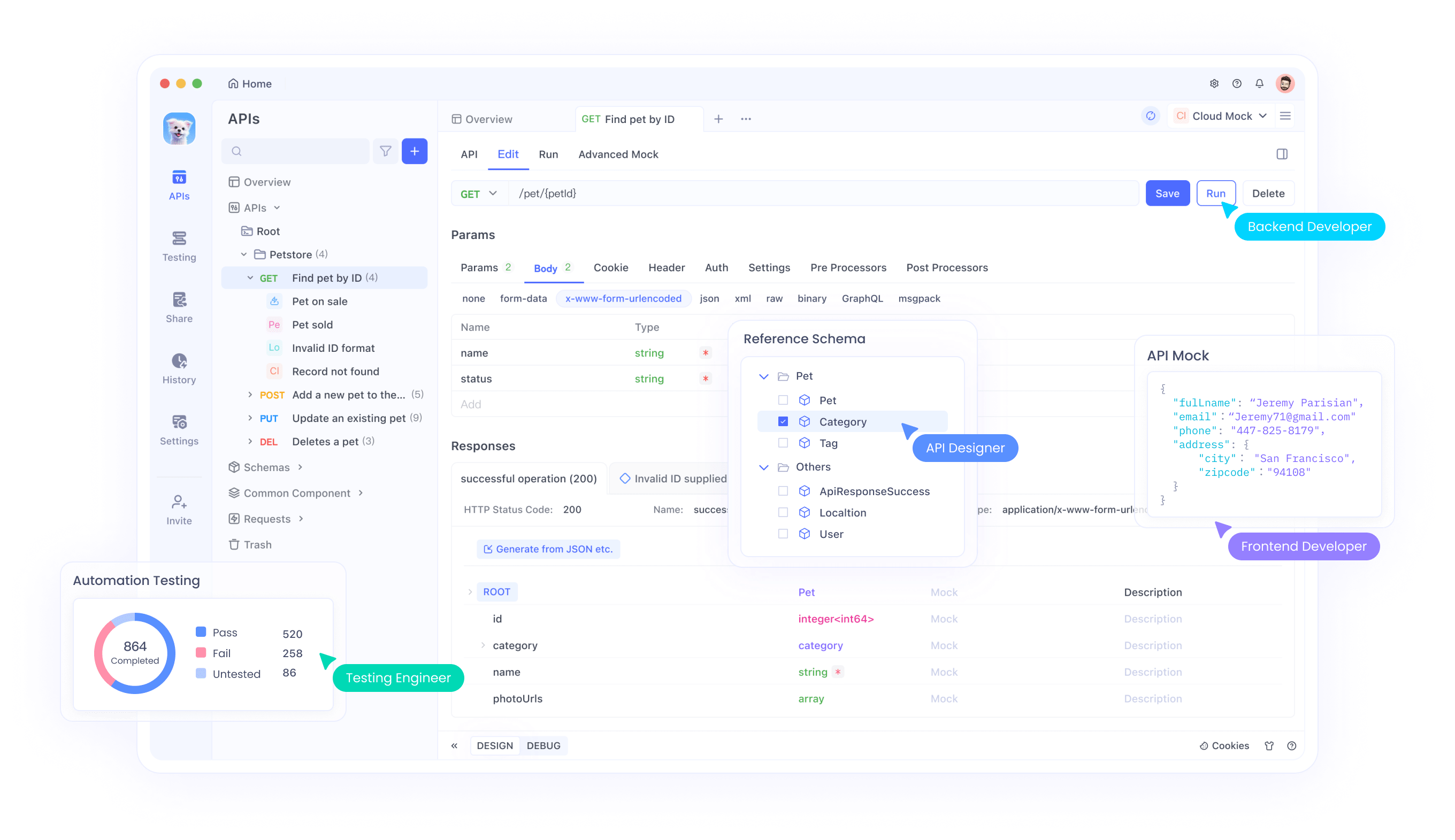

Apidog vereinfacht API-Interaktionen, und Entwickler nutzen es für die Qwen3-Max-Thinking API. Beginnen Sie mit dem Herunterladen von Apidog von der offiziellen Website – es ist kostenlos und lässt sich schnell auf den wichtigsten Plattformen installieren.

Importieren Sie als Nächstes die API-Spezifikation. Apidog unterstützt OpenAPI-Formate; laden Sie Alibabas Spezifikation für Qwen-Modelle herunter und laden Sie sie hoch. Diese Aktion füllt Endpunkte automatisch auf, einschließlich der Textgenerierungs-Endpunkte.

Richten Sie dann Umgebungen ein. Erstellen Sie eine neue Umgebung in Apidog und fügen Sie Variablen für API-Schlüssel und Basis-URLs hinzu. Diese Einrichtung ermöglicht ein einfaches Umschalten zwischen Test- und Produktionsumgebung.

Testen Sie anschließend Anfragen. Verwenden Sie die Apidog-Oberfläche, um POST-Aufrufe zu erstellen. Geben Sie das Modell, den Prompt und den Parameter enable_thinking ein. Senden Sie die Anfrage und überprüfen Sie die Antworten in Echtzeit, mit Funktionen wie Syntaxhervorhebung und Fehlerprotokollierung.

Verketten Sie Anfragen für komplexe Workflows. Apidog ermöglicht die Abfolge von Aufrufen, ideal für agentische Aufgaben, bei denen eine Antwort die nächste speist. Simulieren Sie außerdem hohe Lasten, um die Leistung zu testen.

Arbeiten Sie mit Teams zusammen, indem Sie die Freigabetools von Apidog nutzen. Exportieren Sie Sammlungen, damit Kollegen Setups replizieren können. Überwachen Sie außerdem die Token-Nutzung durch integrierte Analysen, um innerhalb der Quoten zu bleiben.

Optimieren Sie Integrationen weiter. Apidog verarbeitet große Payloads effizient und unterstützt das 262K Kontextfenster. Debuggen Sie Halluzinationen, indem Sie die Denkbudgets anpassen, sobald diese vollständig verfügbar sind.

API-Endpunkte und Parameter erkunden

Die Qwen3-Max-Thinking API stellt mehrere Endpunkte bereit, hauptsächlich für die Textgenerierung. Der Kern-Endpunkt, /api/v1/services/aigc/text-generation/generation, verarbeitet Vervollständigungsaufgaben. Entwickler POSTen hier JSON-Daten.

Zu den Schlüsselparametern gehört "model", das "qwen3-max-preview" angibt. Das "input"-Objekt enthält Nachrichten im Chat-Format. Darüber hinaus bestimmen "parameters" das Verhalten: Setzen Sie "enable_thinking" auf True für den Denkmodus.

- Weitere Optionen verbessern die Kontrolle. "max_tokens" begrenzt die Ausgabelänge auf bis zu 65.536. "temperature" passt die Kreativität an, Standardwert ist 0,7. "top_p" verfeinert die Stichprobenentnahme.

- Für die Tool-Nutzung fügen Sie ein "tools"-Array mit Funktionsdefinitionen hinzu. Die API antwortet mit Aufrufen, was agentische Abläufe ermöglicht.

- Kontext-Caching verwendet "cache_prompt", um frühere Eingaben zu speichern und zu referenzieren, wodurch Kosten reduziert werden. Geben Sie Cache-IDs in nachfolgenden Anfragen an.

- Fehlerbehandlungsparameter wie "retry" verwalten Transienten. Zusätzlich sorgt die Versionierung über "snapshot" für Konsistenz.

Das Verständnis dieser ermöglicht eine präzise Abstimmung. Bei mathematischen Problemen ermöglicht ein höheres Denkvermögen detaillierte Schritte; beim Codieren generiert es robuste Lösungen. Entwickler experimentieren, um optimale Einstellungen zu finden.

Praktische Beispiele für die Verwendung der Qwen3-Max-Thinking API

Ingenieure wenden die API in verschiedenen Szenarien an. Betrachten Sie die Codierung: Prompt "Schreiben Sie eine Python-Funktion zum Sortieren einer Liste." Mit aktiviertem Denken skizziert sie die Logik vor dem Code.

- In der Mathematik fragen Sie "Lösen Sie das Integral von x^2 dx." Die Antwort zerlegt die Schritte und zeigt Integrationsregeln auf.

- Für agentische Aufgaben definieren Sie Tools wie die Websuche. Das Modell plant Aktionen, führt sie über Callbacks aus und synthetisiert Ergebnisse.

- Unternehmensnutzung: Analysieren Sie lange Dokumente, indem Sie Kontexte eingeben. Das große Fenster verarbeitet Benutzerhistorien für Empfehlungen.

- Bildung: Erzeugen Sie Erklärungen für komplexe Themen und passen Sie die Tiefe über Parameter an.

- Gesundheitswesen: Unterstützen Sie ethische Entscheidungen mit begründeten Ausgaben, jedoch immer überprüfen.

- Kreatives Schreiben: Erstellen Sie Geschichten mit logischen Handlungssträngen.

Diese Beispiele veranschaulichen die Vielseitigkeit. Entwickler skalieren sie mithilfe von Apidog zum Testen.

Best Practices für eine effiziente Nutzung

Optimieren Sie zuerst den Token-Verbrauch. Erstellen Sie prägnante Prompts, um Verschwendung zu vermeiden. Verwenden Sie Caching für wiederkehrende Elemente.

Überwachen Sie Quoten sorgfältig. Verfolgen Sie die Nutzung in der Konsole; aktualisieren Sie bei Bedarf.

Sichern Sie Schlüssel mit Umgebungsvariablen oder Tresoren. Drehen Sie sie regelmäßig.

Behandeln Sie Ratenbegrenzungen, indem Sie exponentielles Backoff im Code implementieren.

Testen Sie gründlich mit Apidog vor der Produktion. Simulieren Sie Grenzfälle.

Aktualisieren Sie auf neue Snapshots, sobald sie veröffentlicht werden, und überprüfen Sie die Changelogs.

Kombinieren Sie mit anderen Tools für hybride Systeme.

Befolgen Sie diese, um das Potenzial der Qwen3-Max-Thinking API zu maximieren.

Fazit

Die Qwen3-Max-Thinking API transformiert KI-Anwendungen mit fortschrittlicher Argumentation. Durch Befolgen dieses Leitfadens können Entwickler sie effektiv nutzen und integrieren, wobei Apidog für Effizienz sorgt. Während sich die Funktionen weiterentwickeln, bleibt sie eine Top-Wahl für innovative Projekte.