Imagine ter um supercomputador no seu bolso, capaz de entender e gerar texto semelhante ao humano sobre qualquer tópico. Parece ficção científica, certo? Bem, graças a recentes avanços em inteligência artificial, esse sonho agora é uma realidade – e se chama Ollama.

Ollama é como um canivete suíço para LLMs Locais. É uma ferramenta de código aberto que permite executar poderosos modelos de linguagem diretamente no seu próprio computador. Não é necessário serviços em nuvem sofisticados ou um diploma em ciência da computação. Mas aqui é onde fica realmente empolgante: Ollama tem um superpoder oculto chamado API. Pense nisso como uma linguagem secreta que permite que seus programas conversem diretamente com esses cérebros de IA.

Agora, eu sei o que você está pensando. "APIs? Isso parece complicado!"

Não se preocupe – é aqui que o Apidog entra. É como um tradutor amigável que ajuda você a se comunicar com a API do Ollama sem suar a camisa. Neste artigo, vamos embarcar juntos em uma jornada. Serei seu guia enquanto exploramos como liberar todo o potencial do Ollama usando o Apidog. Ao final, você estará criando aplicações impulsionadas por IA como um profissional, tudo do conforto da sua própria máquina. Então, coloque o cinto – é hora de mergulhar no fascinante mundo da IA local e descobrir quão fácil pode ser!

O que é Ollama e como usar Ollama para executar LLMs localmente?

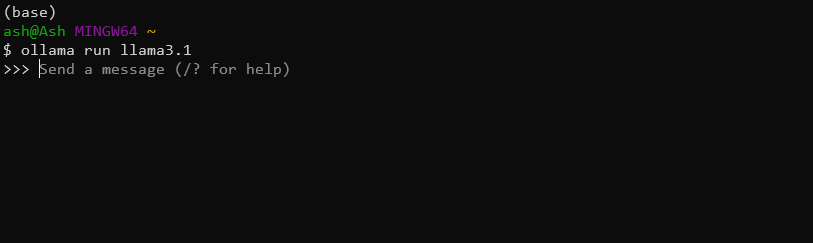

Ollama é uma ferramenta conveniente que permite aos usuários executar grandes modelos de linguagem em suas máquinas locais. Ela simplifica o processo de download, execução e ajuste fino de vários LLMs, tornando capacidades avançadas de IA acessíveis a um público mais amplo. Por exemplo, você pode simplesmente baixar e instalar o modelo Llama 3.1 8B com este comando:

ollama run llama3.1

O Ollama tem uma API?

Sim, você pode usar a API do Ollama para integrar esses poderosos LLMs Locais em suas aplicações de forma contínua.

Recursos principais da API do Ollama incluem:

- Gerenciamento de modelos (baixar, listar e excluir modelos)

- Geração de texto (completar e interações de chat)

- Geração de embeddings

- Capacidades de ajuste fino

Usando a API do Ollama, você pode facilmente aproveitar o poder dos LLMs em suas aplicações sem a necessidade de infraestrutura complexa ou dependências em nuvem.

Usando Apidog para testar APIs do Ollama

Apidog é uma plataforma versátil de desenvolvimento e documentação de API projetada para agilizar todo o ciclo de vida da API. Ela oferece uma interface amigável para projetar, testar e documentar APIs, tornando-a uma ferramenta ideal para trabalhar com a API do Ollama.

Alguns dos recursos destacados do APIDog incluem:

- Interface intuitiva de design de API

- Geração automática de documentação

- Ferramentas de teste e depuração de API

- Recursos de colaboração para projetos em equipe

- Suporte a vários protocolos e formatos de API

Com o Apidog, os desenvolvedores podem facilmente criar, gerenciar e compartilhar documentação de API, garantindo que suas integrações com a API do Ollama estejam bem documentadas e manteníveis.

Pré-requisitos

Antes de mergulhar nas chamadas de API do Ollama com o Apidog, certifique-se de ter os seguintes pré-requisitos em mente:

Instalação do Ollama: Baixe e instale o Ollama na sua máquina local. Siga a documentação oficial do Ollama para instruções de instalação específicas para o seu sistema operacional.

Conta do APIDog: Inscreva-se para uma conta no Apidog se ainda não tiver. Você pode usar a versão baseada na web ou baixar o aplicativo para desktop, dependendo da sua preferência.

Modelo do Ollama: Baixe um modelo usando a interface de linha de comando do Ollama. Por exemplo, para baixar o modelo "llama2", você executaria:

ollama pull llama3.1

Ferramenta de Teste de API: Embora o Apidog forneça capacidades de teste integradas, você também pode querer ter uma ferramenta como cURL ou Postman à disposição para testes e verificações adicionais.

Com esses elementos em vigor, você está pronto para começar a explorar a API do Ollama usando o Apidog.

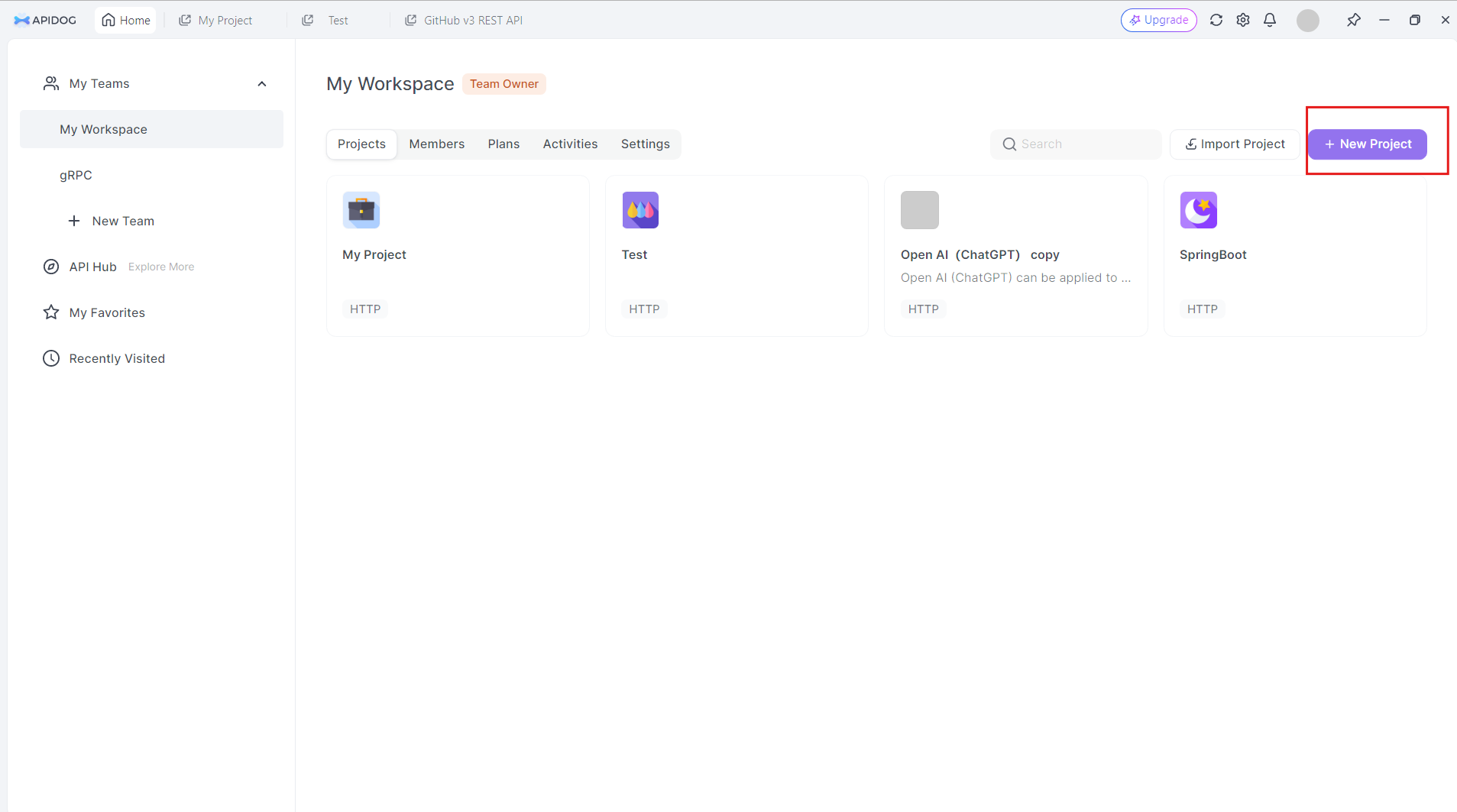

Criando um Projeto de API do Ollama no Apidog

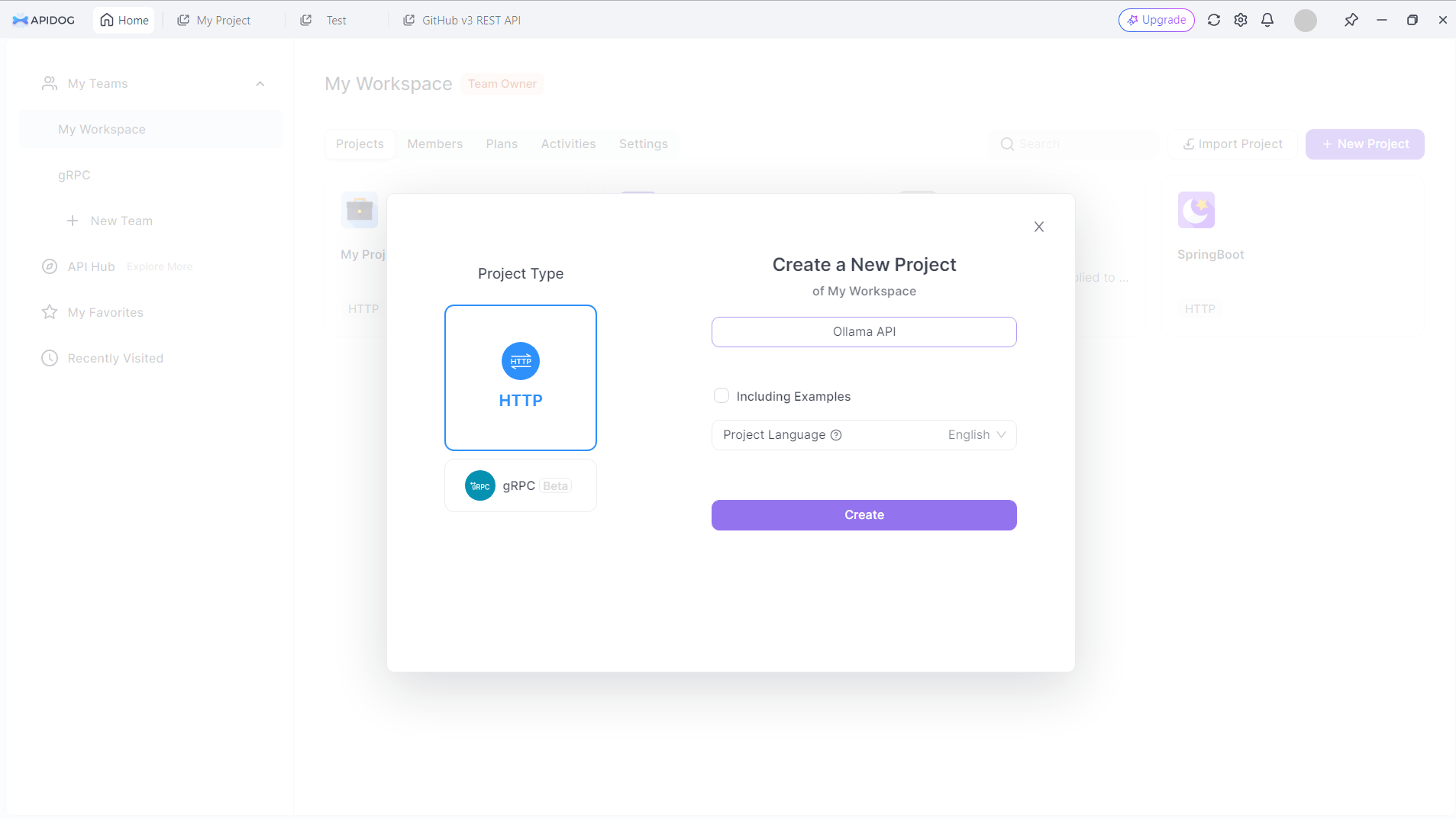

Para começar a trabalhar com a API do Ollama no Apidog, siga estes passos:

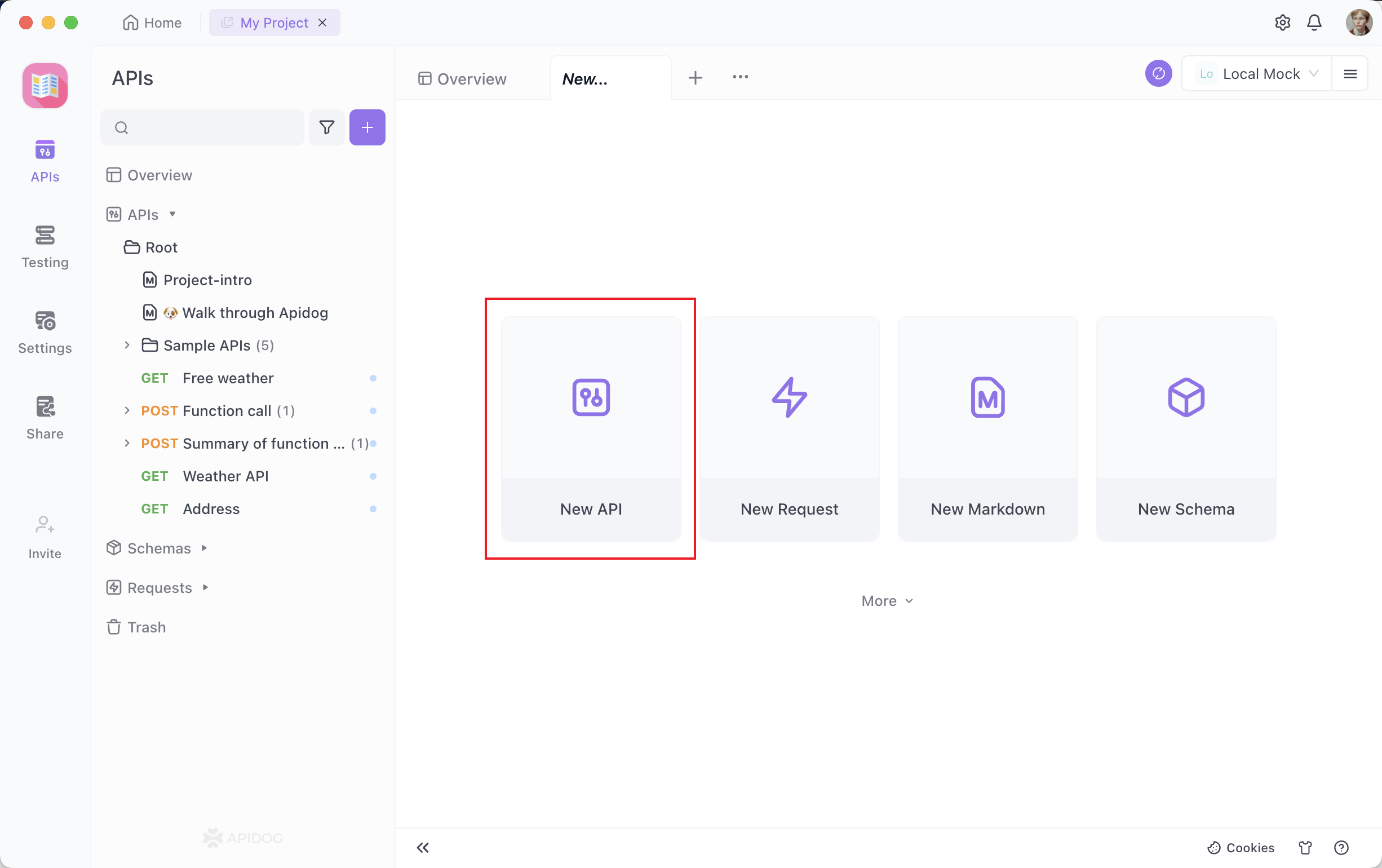

Crie um Novo Projeto: Faça login no Apidog e crie um novo projeto especificamente para seu trabalho com a API do Ollama. Clique no botão Novo Projeto no canto superior direito

Dê um nome ao seu novo projeto. Vamos dizer: API do Ollama:

Clique no botão Criar para prosseguir.

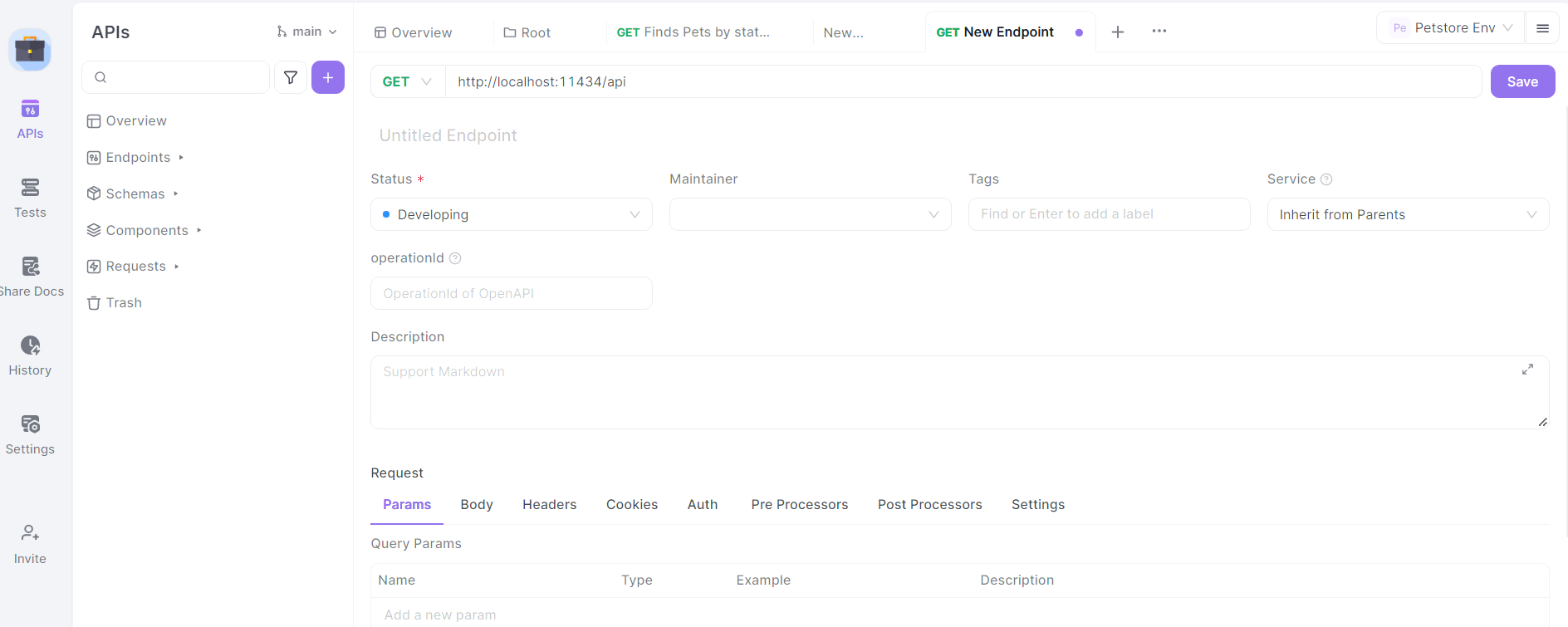

Configure a URL Base: Nas configurações do seu projeto, defina a URL base como http://localhost:11434/api. Este é o endereço padrão onde o Ollama expõe seus pontos finais de API.

Importar Especificação da API do Ollama: Embora o Ollama não forneça uma especificação oficial do OpenAPI, você pode criar uma estrutura básica para os pontos finais da API manualmente no APIDog.

Defina os Pontos Finais: Comece definindo os principais pontos finais da API do Ollama no APIDog. Alguns pontos finais importantes a incluir são:

/generate(POST): Para geração de texto/chat(POST): Para interações baseadas em chat/embeddings(POST): Para gerar embeddings/pull(POST): Para baixar novos modelos/list(GET): Para listar modelos disponíveis

Para cada ponto final, especifique o método HTTP, parâmetros de solicitação e o formato esperado de resposta com base na documentação da API do Ollama.

Projetando Chamadas de API do Ollama no Apidog

Vamos passar pelo processo de projetar chamadas de API para alguns dos pontos finais mais comumente usados do Ollama usando o Apidog:

Ponto Final de Geração de Texto (/generate)

No Apidog, crie um novo ponto final de API com o caminho /generate e defina o método HTTP como POST.

Defina o esquema do corpo da solicitação:

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Forneça uma descrição para cada parâmetro, explicando seu propósito e quaisquer restrições.

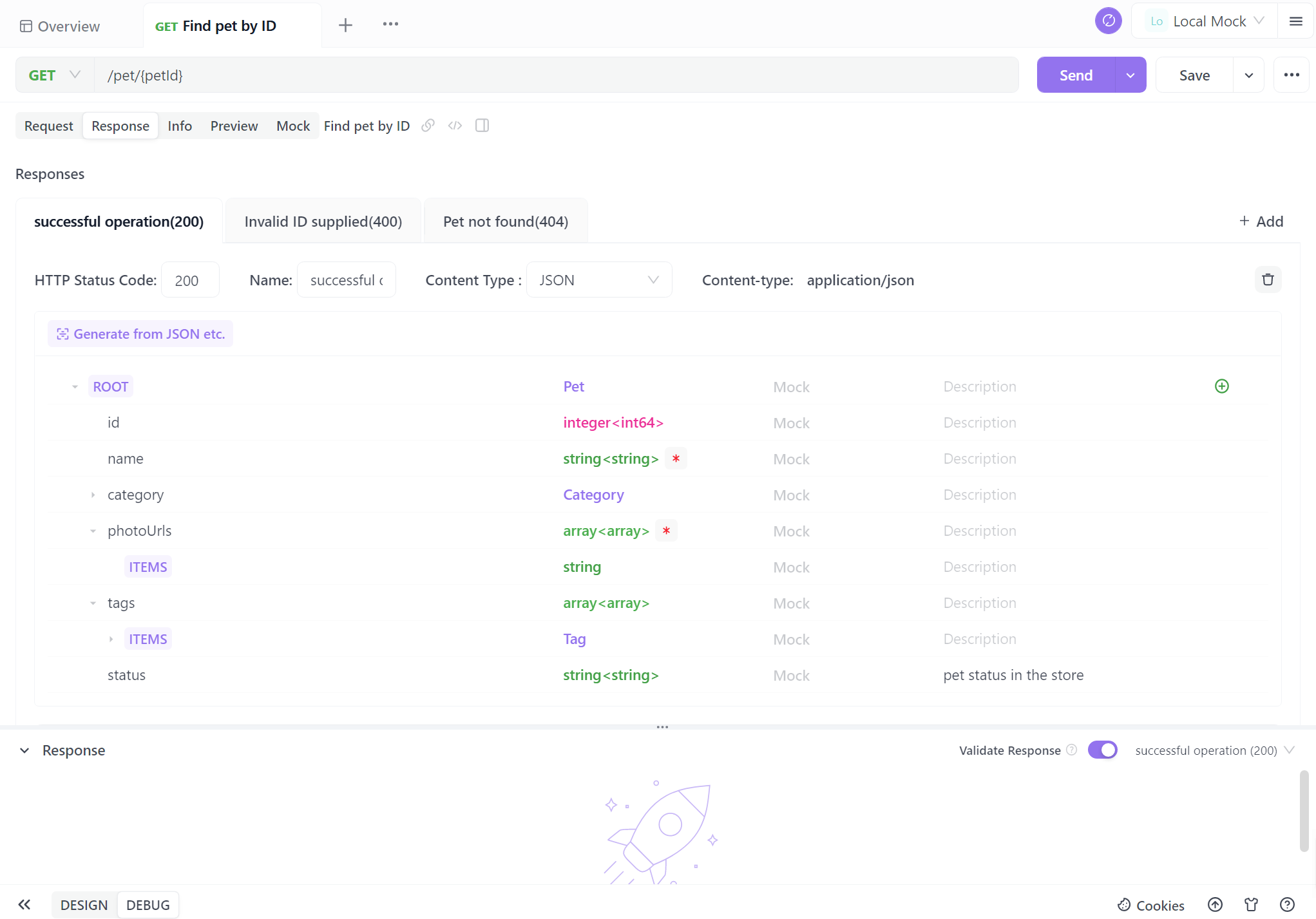

Defina o esquema de resposta com base na documentação da API do Ollama, incluindo campos como response, context e total_duration.

Ponto Final de Chat (/chat)

Crie um novo ponto final com o caminho /chat e defina o método HTTP como POST.

Defina o esquema do corpo da solicitação:

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Forneça descrições detalhadas para o array messages, explicando a estrutura das mensagens de chat com papéis (sistema, usuário, assistente) e conteúdo.

Defina o esquema de resposta, incluindo o objeto message com campos role e content.

Pontos Finais de Gerenciamento de Modelos

Crie pontos finais para operações de gerenciamento de modelos:

- Puxar Modelo (

/pull): solicitação POST com o parâmetronamepara o modelo a ser baixado. - Listar Modelos (

/list): solicitação GET para recuperar modelos disponíveis. - Excluir Modelo (

/delete): solicitação DELETE com o parâmetronamepara o modelo a ser removido.

Para cada um desses pontos finais, defina esquemas de solicitação e resposta apropriados com base na documentação da API do Ollama.

Testando Chamadas de API do Ollama no Apidog

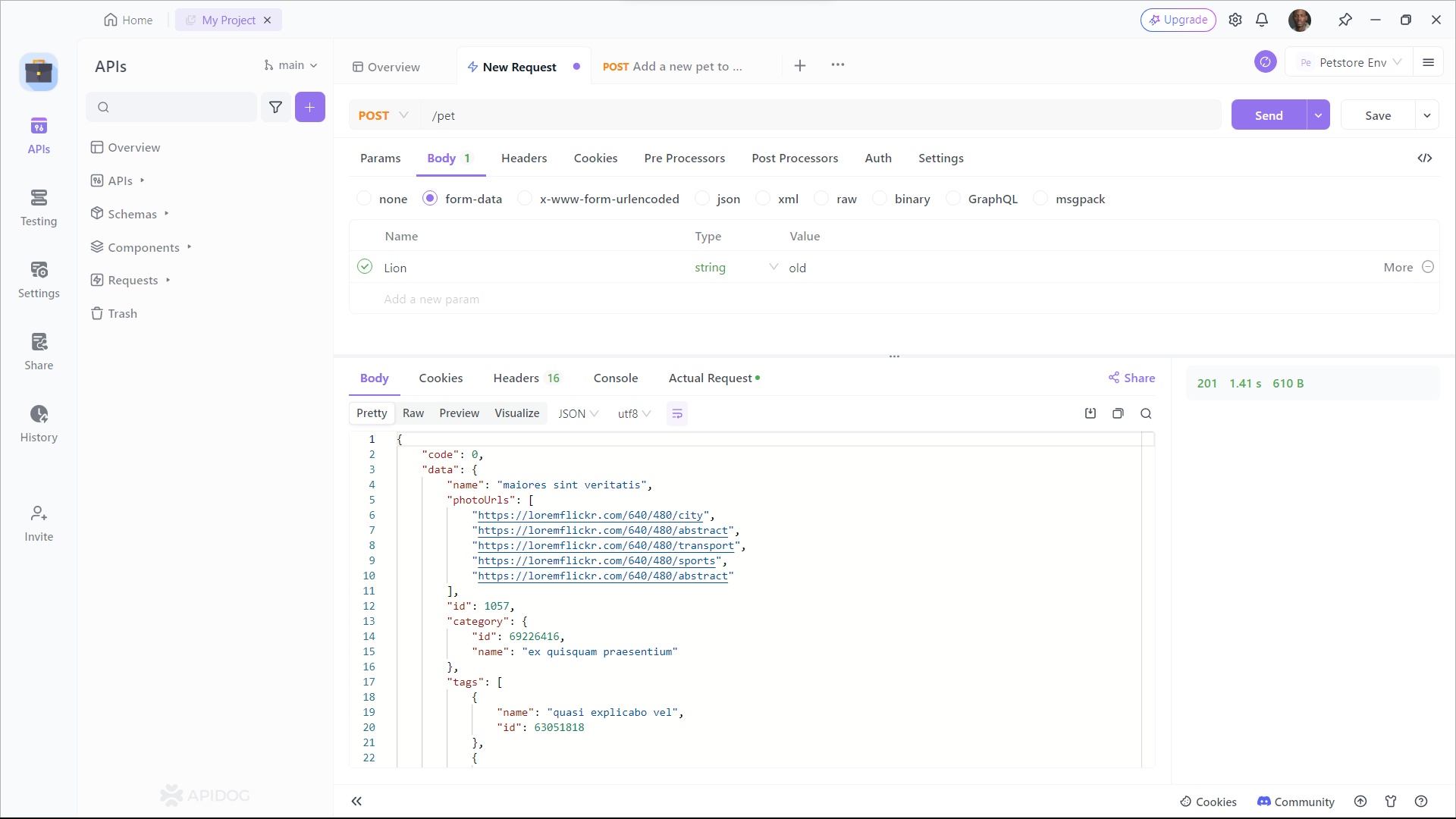

Apidog fornece um ambiente de teste integrado que permite enviar solicitações para sua API do Ollama e verificar as respostas. Veja como usá-lo:

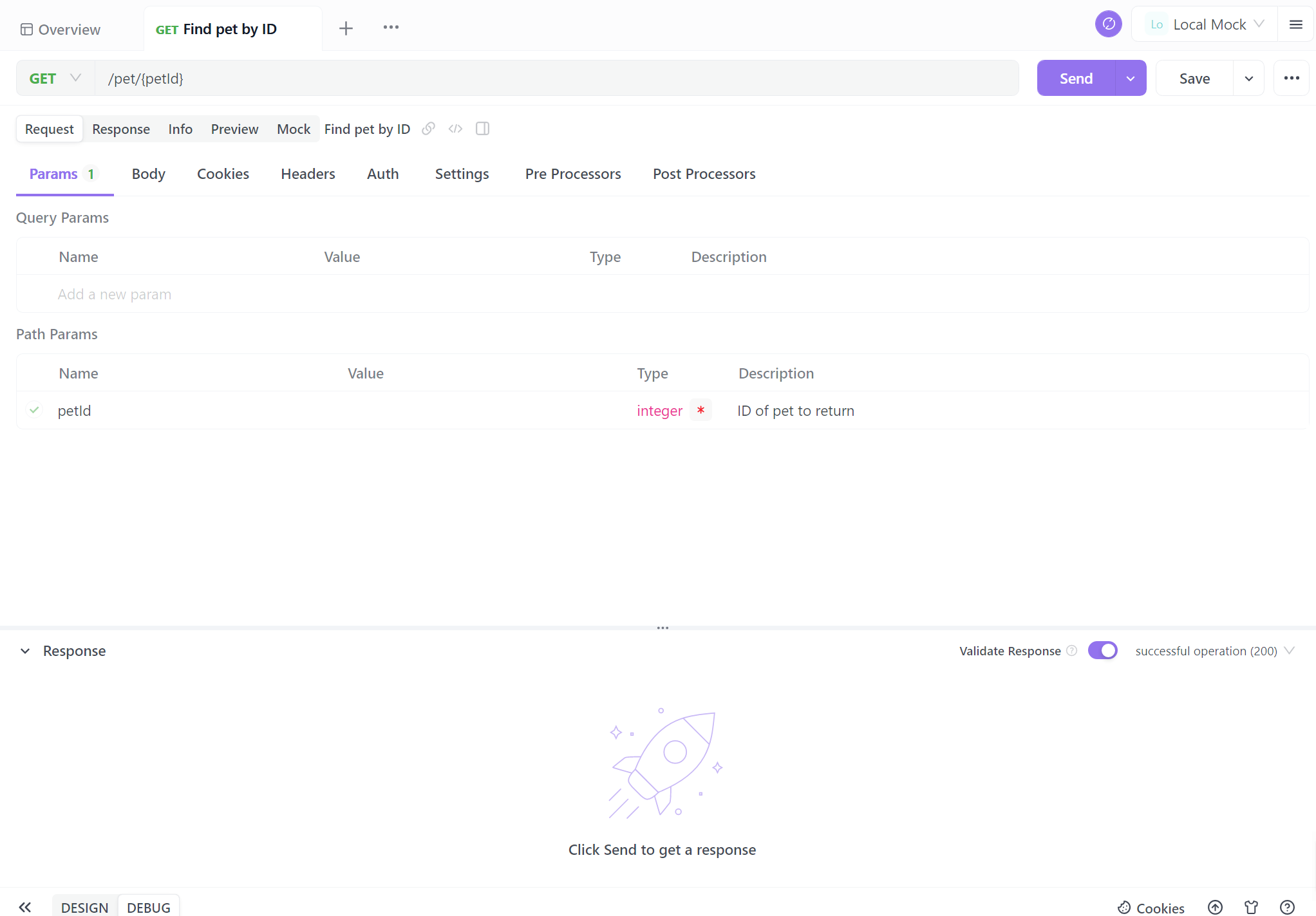

Selecionar um Ponto Final: Escolha um dos pontos finais da API do Ollama que você definiu no Apidog.

Configurar Parâmetros de Solicitação: Preencha os parâmetros obrigatórios para o ponto final selecionado. Por exemplo, para o ponto final /generate, você pode definir:

{

"model": "llama2",

"prompt": "Explique o conceito de inteligência artificial em termos simples."

}

Enviar a Solicitação: Use o botão "Enviar" do Apidog para executar a chamada da API para sua instância local do Ollama.

Examine a resposta do Ollama, verificando se ela corresponde ao formato esperado e contém o texto gerado ou outras informações relevantes. Se você encontrar algum problema, use as ferramentas de depuração do Apidog para inspecionar os cabeçalhos, corpo e quaisquer mensagens de erro da solicitação e resposta.

Gerando Documentação da API

Uma das funcionalidades mais poderosas do Apidog é sua capacidade de gerar automaticamente documentação abrangente da API. Para criar a documentação para o seu projeto da API do Ollama:

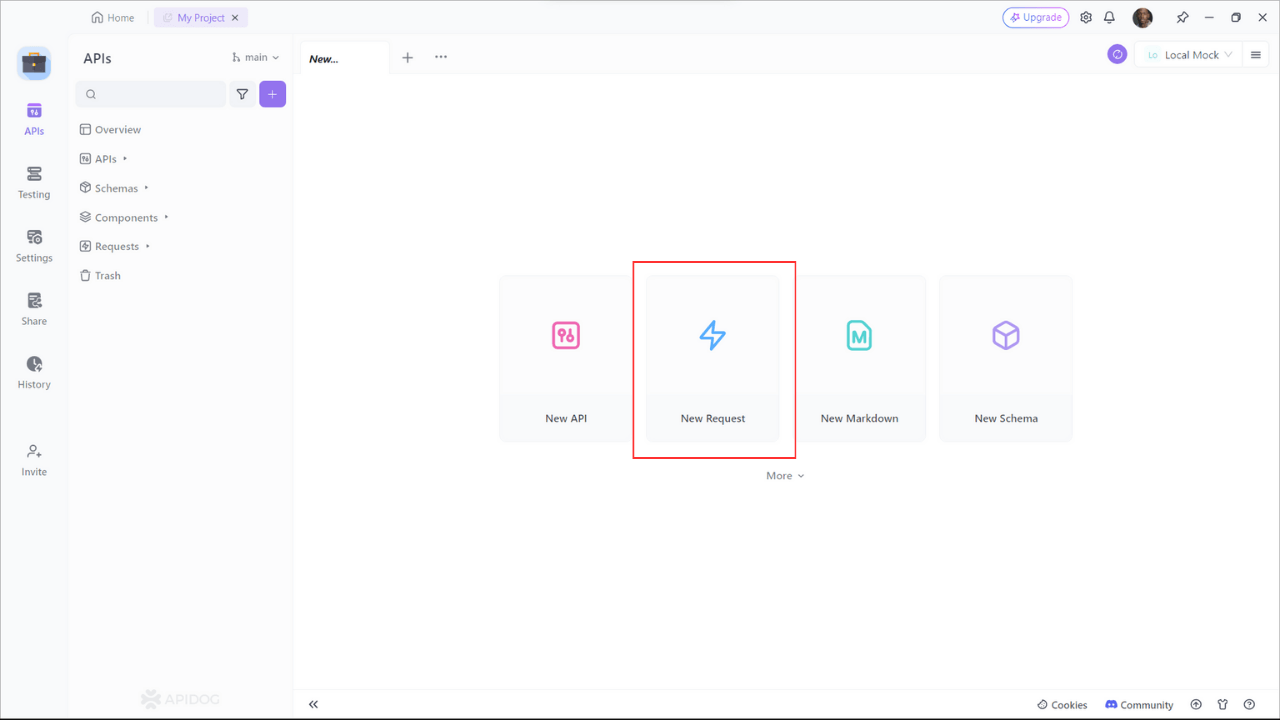

Passo 1: Inscreva-se no Apidog

Para começar a usar o Apidog para geração de documentação da API, você precisará se inscrever para uma conta, se ainda não o fez. Uma vez logado, você será recebido pela interface amigável do Apidog.

Passo 2: Criando Sua Solicitação de API

Um projeto de documentação de API é composto por vários pontos finais, cada um representando uma rota ou funcionalidade específica da API. Para adicionar um ponto final, clique no botão "+" ou "Nova API" dentro do seu projeto.

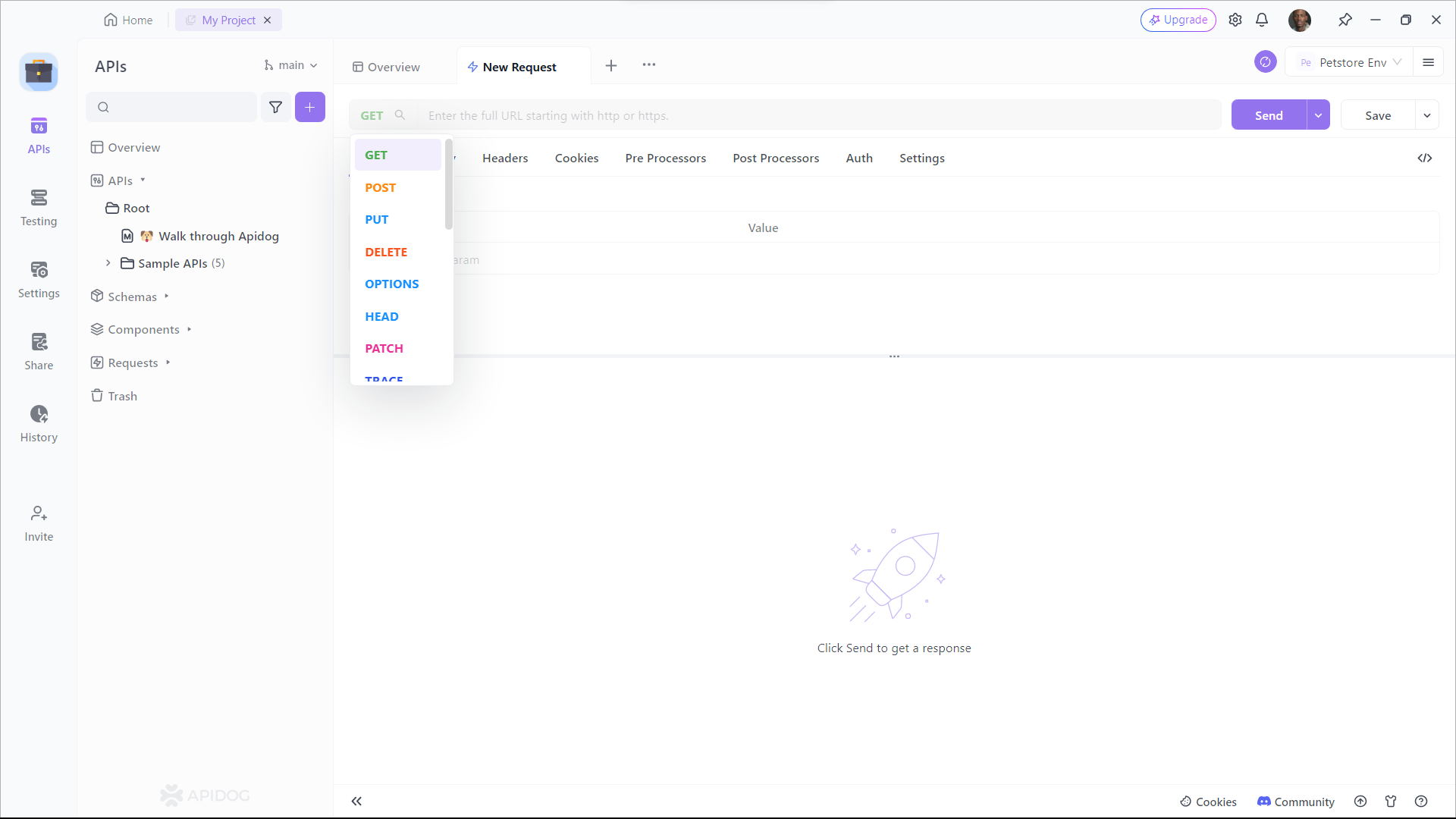

Passo 3: Configure os Parâmetros da Solicitação

Você precisará fornecer detalhes como a URL do ponto final, descrição e detalhes de solicitação/resposta. Agora vem a parte crítica – documentar seus pontos finais. O Apidog torna esse processo incrivelmente direto. Para cada ponto final, você pode:

- Especificar o método HTTP (GET, POST, PUT, DELETE, etc.).

- Definir parâmetros de solicitação, incluindo seus nomes, tipos e descrições.

- Descrever a resposta esperada, incluindo códigos de status, formatos de resposta (JSON, XML, etc.) e exemplos de respostas.

Muitos desenvolvedores não gostam de escrever documentação de API, muitas vezes achando-a complexa. No entanto, na realidade, com o Apidog, você pode completá-la com apenas alguns cliques do mouse. A interface visual do Apidog é amigável, tornando-a muito mais simples do que gerar documentação de API a partir do código.

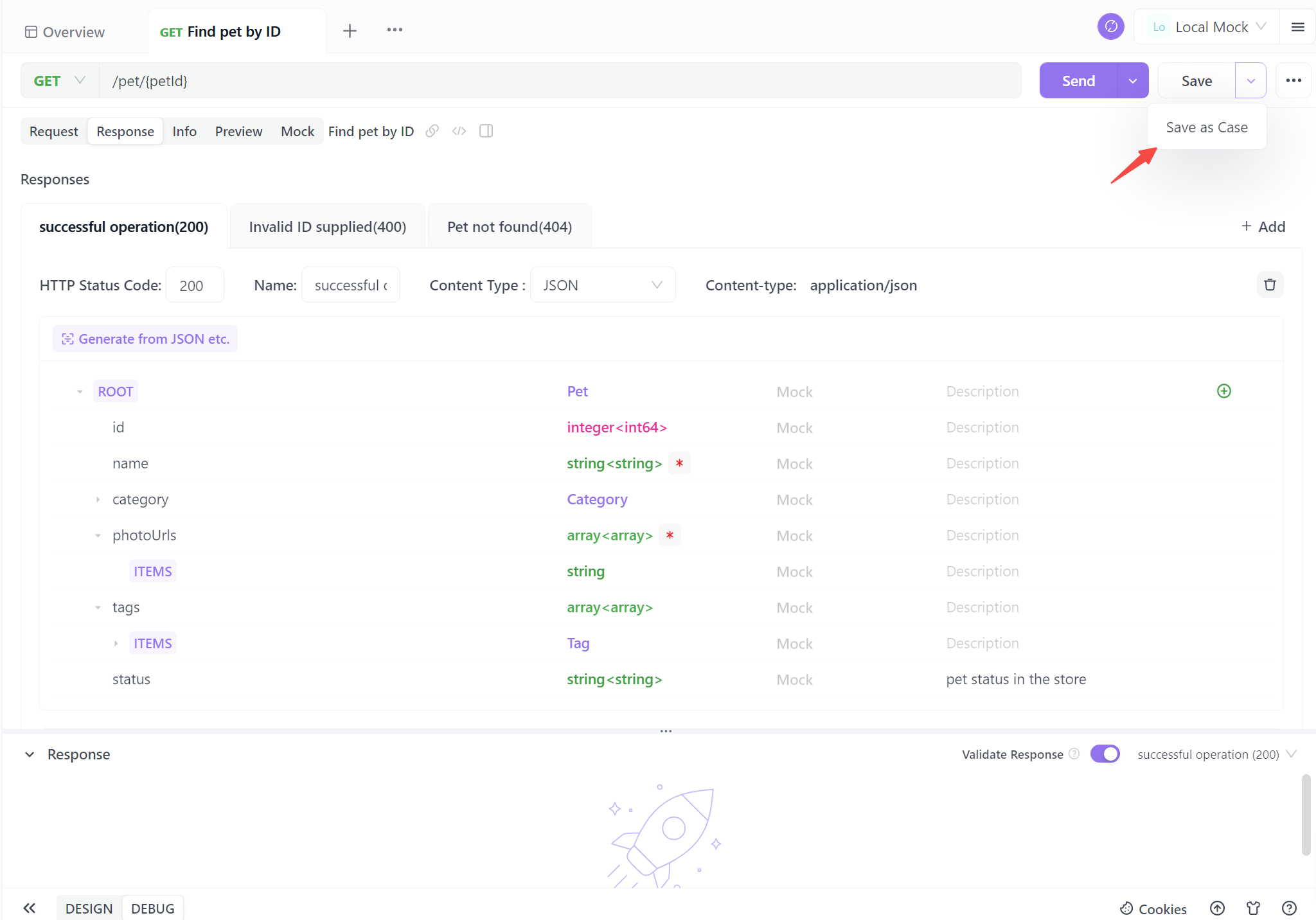

Passo 4. Gere Sua API

Quando você completar as informações básicas da API, basta um clique para salvar como um caso. Você também pode salvá-la diretamente, mas é recomendável salvá-la como um caso de teste para uma referência futura mais fácil.

Seguir esses quatro passos permite que você gere facilmente documentação de API padronizada. Esse processo simplificado não apenas garante clareza e consistência, mas também economiza tempo valioso. Com documentação automatizada, você está bem equipado para melhorar a colaboração, simplificar a interação do usuário e impulsionar seus projetos com confiança.

Melhores Práticas para Integração da API do Ollama

Enquanto você trabalha com a API do Ollama através do APIDog, mantenha essas melhores práticas em mente:

- Controle de Versão: Use os recursos de controle de versão do APIDog para monitorar as mudanças nas definições da sua API ao longo do tempo.

- Tratamento de Erros: Documente as respostas de erro comuns e inclua exemplos de como lidar com elas na documentação da sua API.

- Limitação de Taxa: Esteja ciente de qualquer limitação de taxa implementada pelo Ollama, especialmente ao executar em sistemas com recursos limitados, e documente essas limitações.

- Considerações de Segurança: Embora o Ollama geralmente execute localmente, considere implementar autenticação se expuser a API em uma rede.

- Otimização de Desempenho: Documente melhores práticas para otimizar solicitações, como reutilizar o contexto para consultas relacionadas para melhorar os tempos de resposta.

Conclusão

Integrar a API do Ollama em seus projetos abre um mundo de possibilidades para aproveitar poderosos modelos de linguagem em suas aplicações. Ao usar o APIDog para projetar, testar e documentar suas chamadas à API do Ollama, você cria uma integração robusta e fácil de manter, que pode evoluir com as necessidades do seu projeto.

A combinação das capacidades de LLM local do Ollama e os recursos abrangentes de gerenciamento de API do APIDog fornece aos desenvolvedores um poderoso conjunto de ferramentas para construir aplicações aprimoradas por IA. À medida que você continua a explorar o potencial do Ollama e aprimorar suas integrações de API, lembre-se de que uma documentação clara e testes rigorosos são fundamentais para uma implementação bem-sucedida.

Seguindo os passos e as melhores práticas delineadas neste artigo, você estará bem preparado para aproveitar todo o potencial da API do Ollama, criando aplicações sofisticadas impulsionadas por IA com confiança e facilidade. A jornada da integração de IA é empolgante, e com ferramentas como Ollama e Apidog à sua disposição, as possibilidades são realmente ilimitadas.