LM Studioにこんにちは!大規模言語モデル(LLM)であるLlama、Phi、Gemmaなどをダウンロードしてチャットし、いじくることができる非常にフレンドリーなデスクトップアプリです。全てローカルで行います。自分のデータを自由に扱える、まるでプライベートなChatGPTを持っているようです。この初心者向けガイドでは、LM Studioを設定して使う方法を紹介します。博士号は必要ありません。コーディングをしている人も、文章を書いている人も、ただ楽しんでいる人も、このツールはゲームチェンジャーです。準備はいいですか?AIの火花を飛ばしましょう!

button

LM Studioとは?あなたのローカルAI遊び場

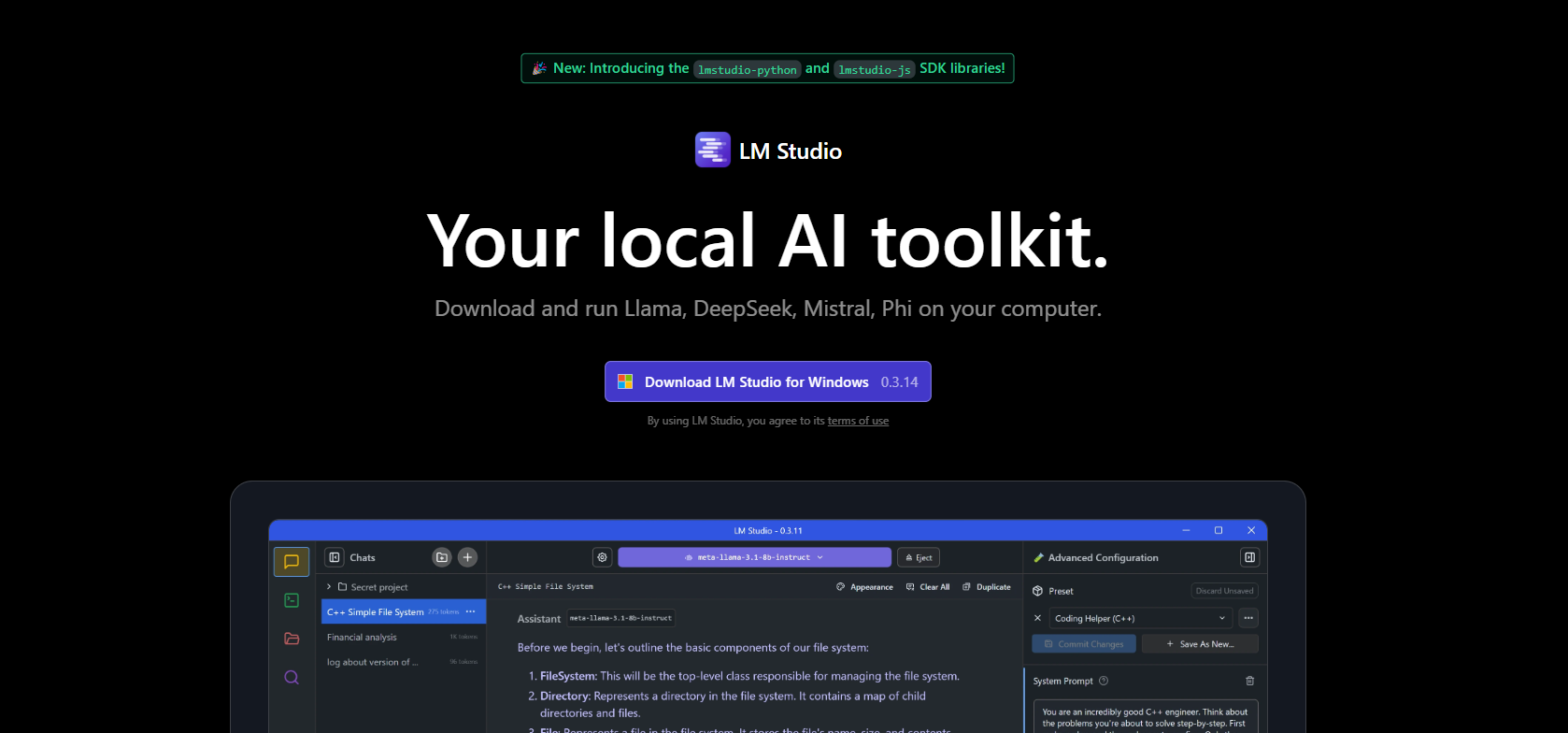

LM Studioは何ですか?それは、インターネットやクラウドサービスを必要とせずに、大規模言語モデルをPCに持ち込むクロスプラットフォームアプリ(Windows、Mac、Linux)です。Hugging FaceからオープンソースLLMをブラウズ、ダウンロード、チャットできる居心地の良いハブのようなものです。LM Studioは、モデルのダウンロード、メモリへの読み込み、ChatGPTのようなインターフェースの提供を担当しますので、質問をしたり面白いものを作ったりすることに集中できます。ユーザーは、その「非常に簡単なセットアップ」とプライバシーの利点について称賛しています。データはあなたのマシンから出ることはありません。あなたがコーダーであろうと、ライターであろうと、趣味であろうと、LM StudioはAIを軽やかに感じさせます。

なぜローカルが良いのか?プライバシー、制御、そしてサブスクリプション料金が不要です。さらに、あなたのPCでAIを実行するのは単純に楽しいです。さあ、セットアップを始めましょう!

LM Studioのインストール:簡単なセットアップ

LM Studioを動かすのはIKEAの家具を組み立てるよりも簡単です—約束します!lmstudio.aiのドキュメントにはわかりやすく説明が書かれており、私がその手順を整理します。これがあなたのAI冒険を始める方法です。

ステップ1:ハードウェアの確認

LM Studioは快適ですが、少し電力を必要とします:

- RAM:まともなモデルには少なくとも16GB(8GBは小さいモデル用で使えます)。

- ストレージ:モデルは2~20GBなので、スペースを確保してください。

- CPU/GPU:現代的なCPUで問題ありませんが、GPU(NVIDIA/AMD)は処理を高速化しますが、必須ではありません。Mac M1/M2ユーザー?良好です—GPUは不要です。

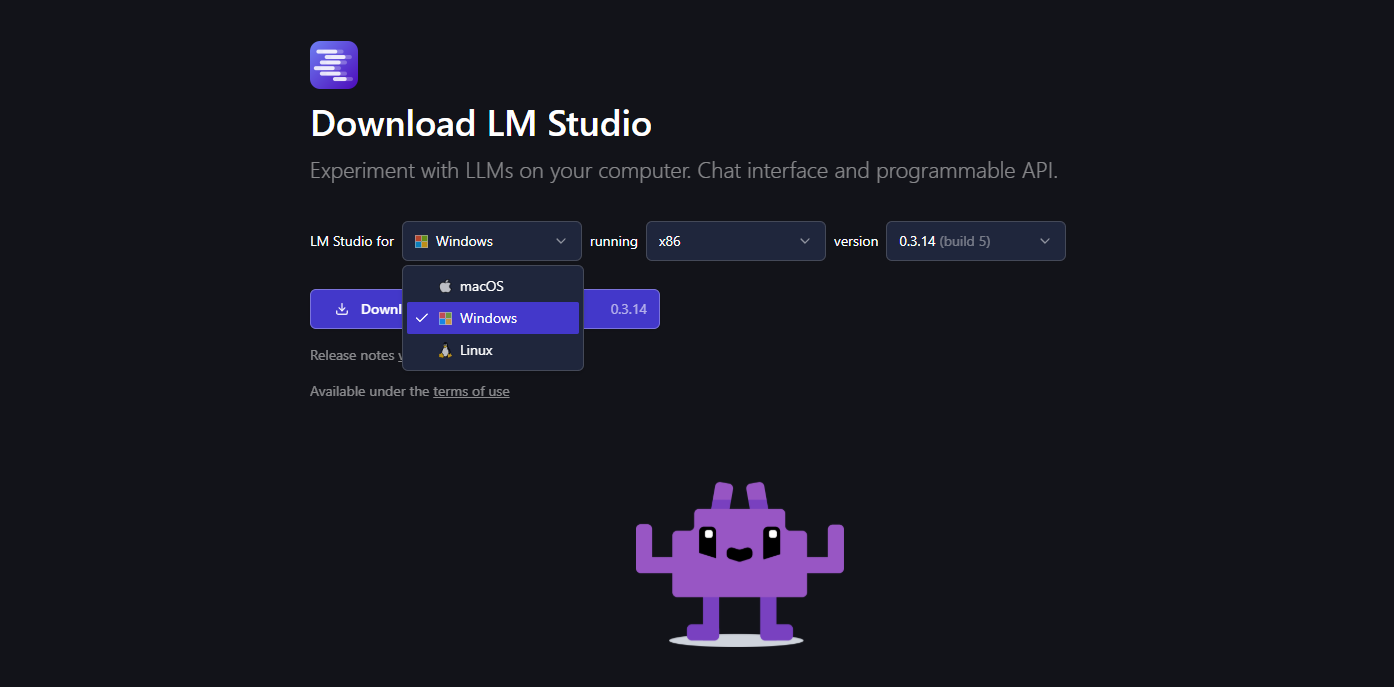

- OS:Windows(x86/ARM)、macOS(M1–M4)、またはLinux(x86 with AVX2)。

quick lscpu(Linux)の実行や、システム情報の確認(Windows/Mac)でセットアップを確認してください。16GB RAMでRyzen 5を搭載した古いPCでもLM Studioを問題なく使えますので、スーパーコンピュータを持っていなくても心配しないでください。

ステップ2:ダウンロードとインストール

- lmstudio.aiにアクセスして、あなたのオペレーティングシステム用のインストーラーを取得してください。

2. インストーラーを実行します。標準の「次へ、次へ、完了」の流れです。Macではアプリケーションにドラッグしました;Windowsの方々にはデスクトップショートカットが作成されます。

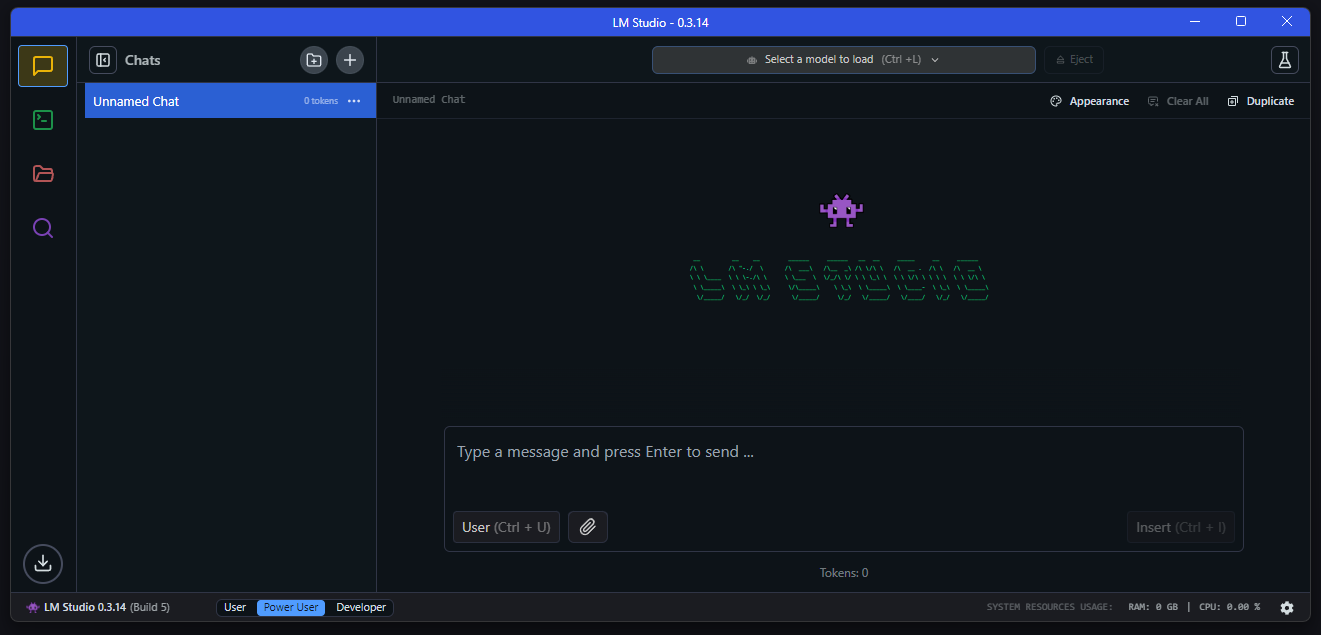

3. LM Studioを起動します。モデル検索バーと特集されたピックがあるクールなホームページに飛びます。最初は少し忙しそうに見えるかもしれません(私もそう思いました!)、でもシンプルに進めましょう。

ステップ3:アップデート(オプション)

LM Studioは自動でアップデートを確認します(2025年4月時点でのバージョンは0.3.14)。もし促されたら、「更新」をクリックしてフレッシュな状態を保ちましょう—これによりバグが修正され、より良いツールサポートなどの機能が追加されます。

これだけです!LM Studioは準備完了です。私には5分もかかりませんでした—あなたはどうですか?

LM Studioの使用:チャットとモデルの探索

さて、LM Studioがインストールされたので、楽しい時間を過ごしましょう!アプリのコアはモデルをダウンロードしてチャットすることですので、早速本題に入りましょう。

ステップ1:モデルを選択してダウンロード

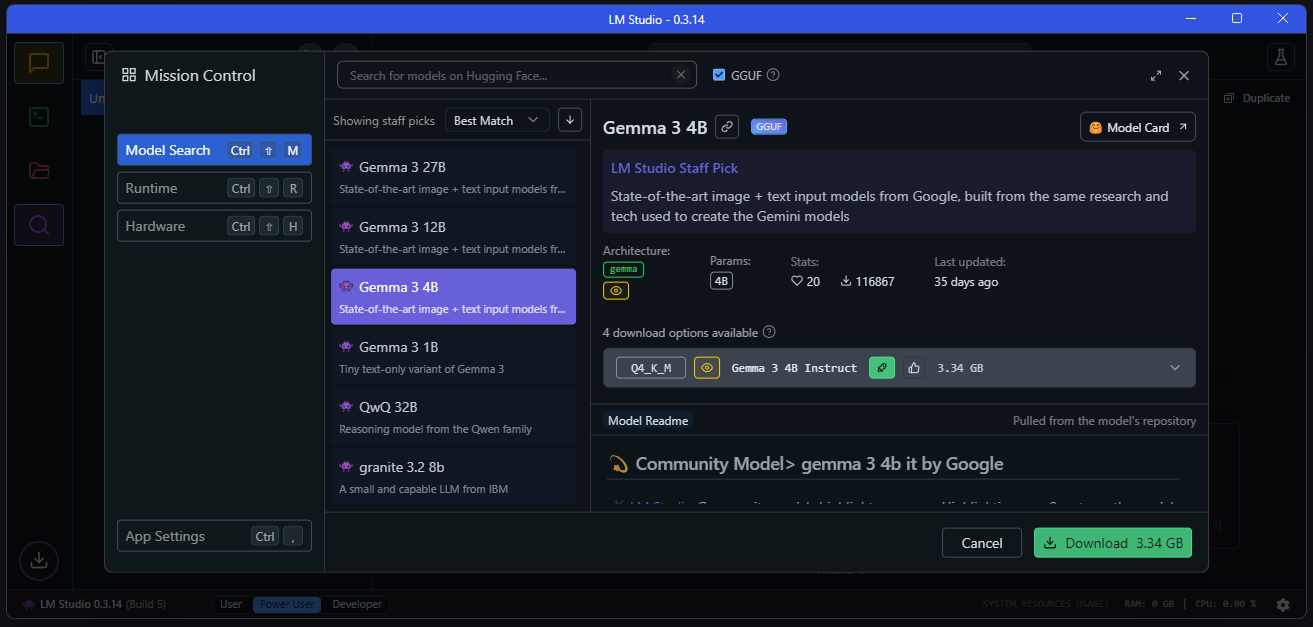

Discoverタブはモデルのお菓子屋さんで、Hugging Faceからのものを引き出します。選ぶ方法は以下の通りです:

- LM Studioを開いて、虫眼鏡(Discoverタブ)をクリックします。

- Llama 3.1 8BやPhi-3-miniなどの特集されたモデルを閲覧します。初心者には4–8GBの量子化モデル(Q4_K_Mバージョンなど)を選ぶことをお勧めします—速くて軽量です。

3. 何か特定のものを検索します。例えば、「Mistral-7B-Instruct」(チャットに最適)や「Meta-Llama-3.1-8B-Instruct」(始めるのに最適)などです。モデルの横にある「ダウンロード」をクリックします。

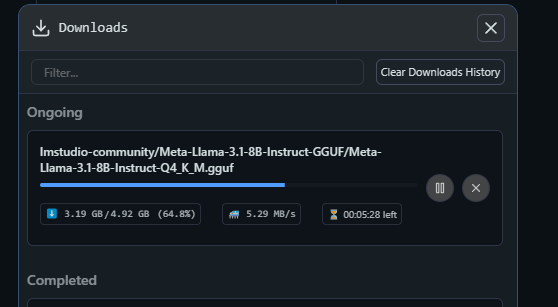

4. 少し待ってください—ダウンロードはインターネットの速度に依存します(5GBのモデルはWi-Fiで約10分かかりました)。ダウンロードタブで進捗を確認しましょう。

プロヒント:LM Studioはあなたのハードウェアに基づいてどのモデルが処理できるかを推測しますので、スムーズに進めるためにそれに従ってください。

ステップ2:ロードしてチャット

ダウンロードが終わったら、チャットの時間です:

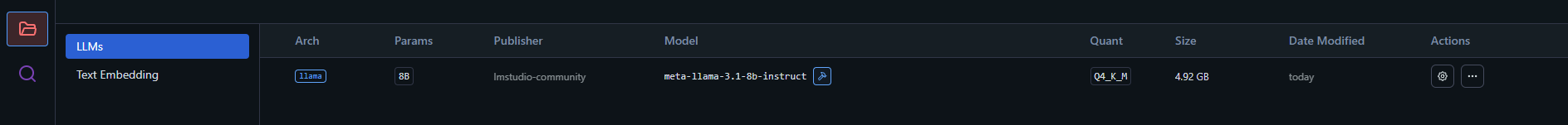

- My Modelsタブに移動します(左サイドバー、フォルダーのように見えます)。

- あなたのモデル(例:lmstudio-community/Meta-Llama-3-8B-Instruct-GGUF)をクリックして「ロード」を押します。

3. RAMにロードされるまで待ってください—小さいモデルは数秒、大きいものは1分かかるかもしれません。

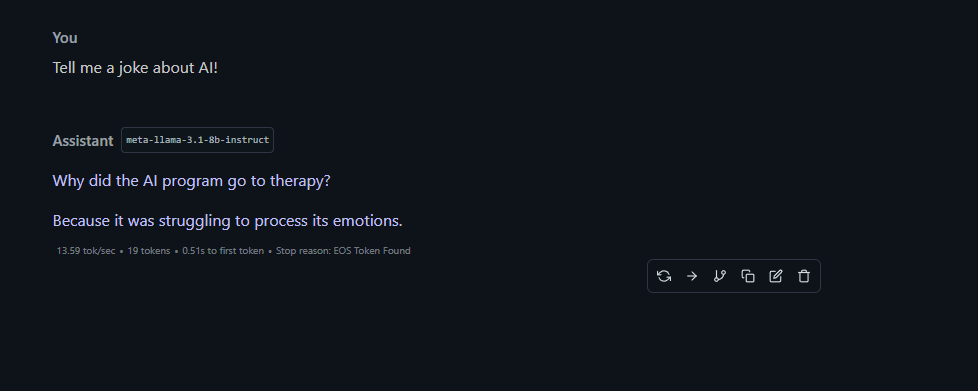

4. Chatタブ(吹き出しアイコン)に切り替えます。ドロップダウンからロードしたモデルを選択します。

5. 何か楽しいことを入力してみてください。「AIについてのジョークを教えて!」など。私が得たのは「なぜAIプログラムがセラピーに行ったのか?それは感情を処理するのに苦労していたからだ。」—悪くないですね、LM Studio!

チャットはGrokやChatGPTと話しているように感じますが、すべてローカルです—あなたの言葉はプライベートに保たれます。

ステップ3:プロンプトで遊ぶ

LM StudioのChatタブでは、モデルの振る舞いを調整できます:

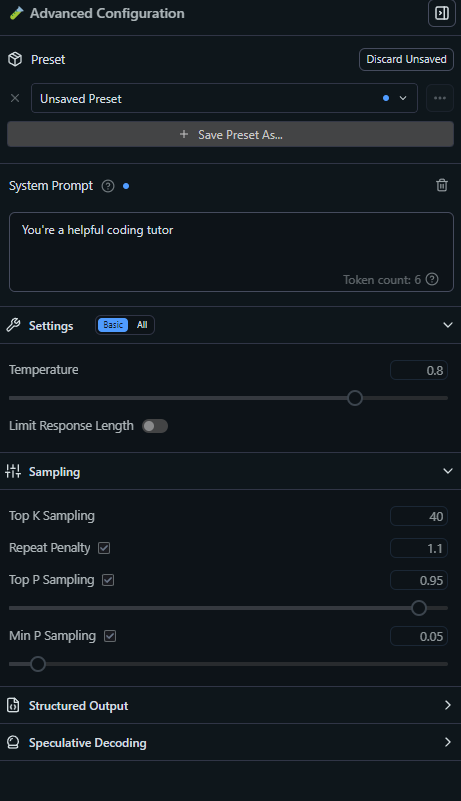

- システムプロンプト:雰囲気を設定します。「海賊のように振る舞う!」など。例えば、「あなたは非常に助けになるコーディングチューターです」として技術的なサポートをお願いしてみてください。

- 温度:創造性を制御します(0.7はバランスが取れており、1.0はワイルドになります)。私は明確な回答を得るために0.8を使用しています。

- コンテキストの長さ:モデルが覚えておく履歴の量—4096トークンはほとんどのチャットには十分です。

遊んでみてください!LM Studioに詩を書かせたり、量子物理学を説明させたり、コードのデバッグをお願いしたりすることができます。あなたのAIサンドボックスです。

プロジェクトへのLM Studioの接続(コーダーへのボーナス)

レベルアップしたいですか?LM StudioはローカルのOpenAI APIのように機能し、アプリやスクリプトに組み込むことができます。コーディングに触れている初心者のための簡単な見通しです:

サーバーを開始する:

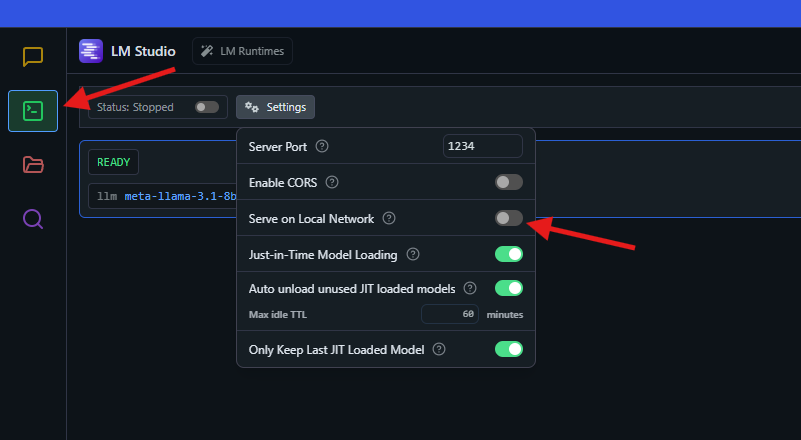

- Developerタブ(ギアアイコン)に行き、「Start Server」をクリックします。デフォルトではhttp://localhost:1234で実行されます。

- これはOpenAIのAPIと似た動作をするので、LangChainなどのツールやカスタムスクリプトはシームレスに動作します。

スクリプトでテストする: Node.jsを持っているなら、これを試してください(test.jsとして保存):

const { LMStudioClient } = require("@lmstudio/sdk");

async function main() {

const client = new LMStudioClient();

const model = await client.llm.load("lmstudio-community/Meta-Llama-3-8B-Instruct-GGUF");

const response = await model.respond([

{ role: "user", content: "フランスの首都はどこですか?" }

]);

for await (const text of response) {

process.stdout.write(text);

}

}

main();SDKをインストールします:npm install @lmstudio/sdk、その後実行します:node test.js。バン!LM Studioは「パリ」と答えます。

コーディングしませんか?心配しないでください—これは可能性のほんの一部に過ぎません。今はChatタブに留まっておきましょう!

LM Studioの設定:あなたのスタイルに合わせて

LM Studioは非常に使い易いですが、あなたのスタイルに合わせて調整できます。初心者向けのオプションは以下の通りです:

- GPUオフロード:NVIDIA GPUをお持ちですか?Chatタブで、「GPU Offload」をスライドして、あなたのVRAMが処理できる最大のレイヤーに合わせます(例えば、3090なら14など)。GPUがない場合は0のままにしてください—CPUで問題ありません。

- モデルプリセット:プロンプト設定(温度など)をChatタブにプリセットとして保存します。「CodeHelper」というプリセットをPythonのヒントのために作りました。

- 言語サポート:LM Studioは英語、スペイン語、日本語などを話します—設定を確認して切り替えたい場合はどうぞ。

.envファイル:コーダー向けに、外部サービスを使用する場合のAPIキーを.envファイルに保存します。例:

LMS_SERVER_PORT=1234これをプロジェクトフォルダーに配置しますが、LM Studioは基本的な使用法ではこれを必要としません。

Developerタブで、ロギングやカスタムエンドポイントなどの高度な設定を確認できますが、初心者としてはデフォルトのままで大丈夫です。

なぜLM Studioは初心者に最適なのか

LM Studioが初心者の夢である理由は何ですか?使いやすさと力です:

- コーディング不要:GUIは非常に親しみやすく、数分でモデルとチャットを始めることができました。

- プライバシー優先:あなたのデータはローカルに保たれます—クラウドAIに懸念を持つ方には大きな利点です。

- モデルの多様性:小さなPhi-3から強力なLlamaまで、どのシステムにも合ったモデルがあります。

- コミュニティの支持:Xの投稿では「ローカルLLMを実行する最も簡単な方法」と呼ばれ、Redditのr/LocalLLaMAも初心者向けであることに同意しています。

AIの補助輪のようなもので、頭痛なくプロの結果を得ることができます。

結論:あなたのLM Studioの冒険が待っています

これで完了です—あなたは今やLM Studioのプロ(少なくとも自信のある初心者)です!最初のモデルをダウンロードするところから、Llamaでジョークを交わすところまで、あなたはローカルAIの力を解き放ちました。LM Studioに物語を書かせたり、概念を説明させたり、宿題を手伝わせたりしてみてください—気分が乗れば小さなアプリをコーディングすることもできます。LM Studioのドキュメントにはさらに多くのヒントがあり、Discordコミュニティでもアイデアが活気にあふれています。あなたの最初のAIプロジェクトは何ですか?チャットボット?詩の生成器?APIをいじっているなら、apidog.comに立ち寄ってスキルを磨きましょう。

開発者チームが最大限の生産性で協力できる統合されたオールインワンプラットフォームが必要ですか?

Apidogはすべての要求を満たし、Postmanのより手頃な価格での代替品を提供します!

button