新しいLlama 3.2 APIの力を活用する準備はできていますか?もしそうなら、正しいところにいます!このガイドでは、Llama 3.2 APIを効果的に使用するために知っておくべきすべてを紹介します。しかし、始める前に、簡単なヒントをお教えします:Apidogを無料でダウンロードしましょう!この強力なAPI開発ツールは、Llama 3.2を使うのをさらに簡単にしてくれます。それでは、始めましょう!

Llama 3.2とは何ですか?

Llama 3.2 は、自然言語理解および生成を必要とするアプリケーションの開発を支援するために設計された高度な言語モデルです。前のバージョンに比べて強化された機能を提供し、AI駆動の機能をプロジェクトに実装したい人にとって優れた選択肢となります。

なぜLlama 3.2 APIを使用するのですか?

Llama 3.2 APIを使用することでいくつかの利点があります。まず第一に、独自のモデルをゼロから構築する必要なく、強力な言語処理機能を統合できることです。テキストを生成したり、コンテキストを理解したり、さらには会話を続けたりすることができ、すべてわずか数回のAPI呼び出しで行えます。さらに、使いやすいドキュメントとコミュニティサポートにより、すべてのスキルレベルの開発者が利用できるようになっています。

Llama 3.2 APIの始め方

Llama 3.2 APIを使用する前に、いくつかの設定を行う必要があります。以下にステップバイステップのガイドを示します。

ステップ1:サインアップしてAPIキーを取得する

まず、Llama 3.2 APIへのアクセスをサインアップする必要があります。数秒でLlamaのAPIページから実行できます。

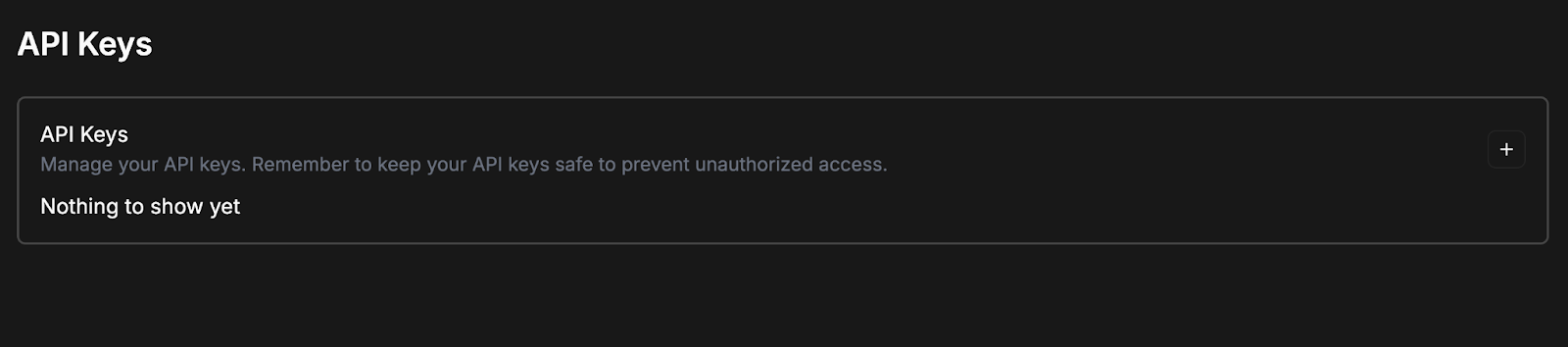

ログインすると、APIトークンを作成するように促される画面が表示されるはずです。

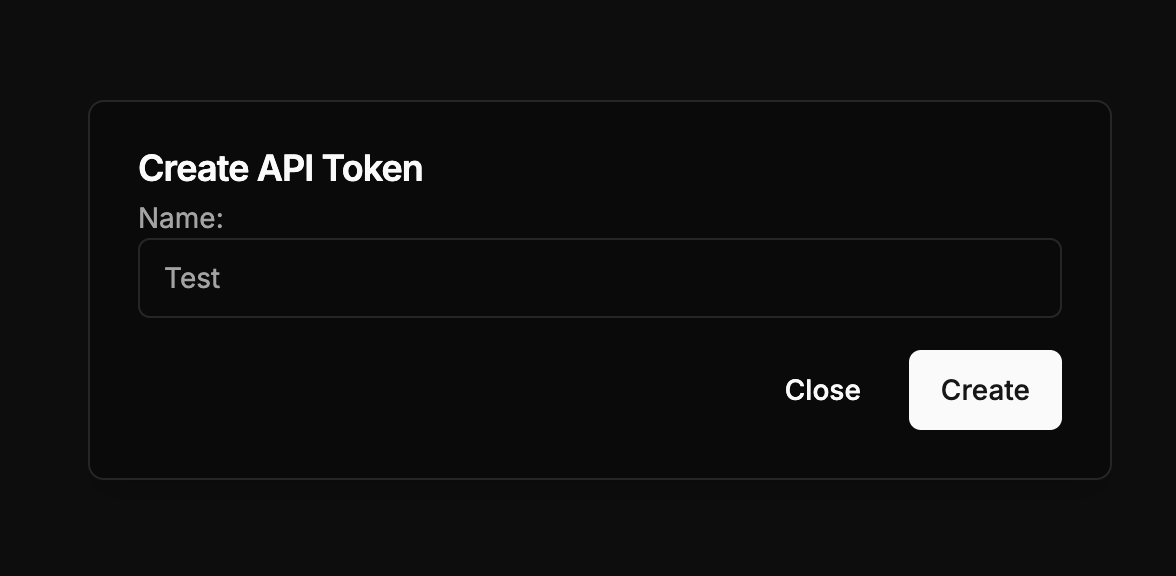

+ボタンをクリックし、APIトークンに名前を付けて、「作成」をクリックします。

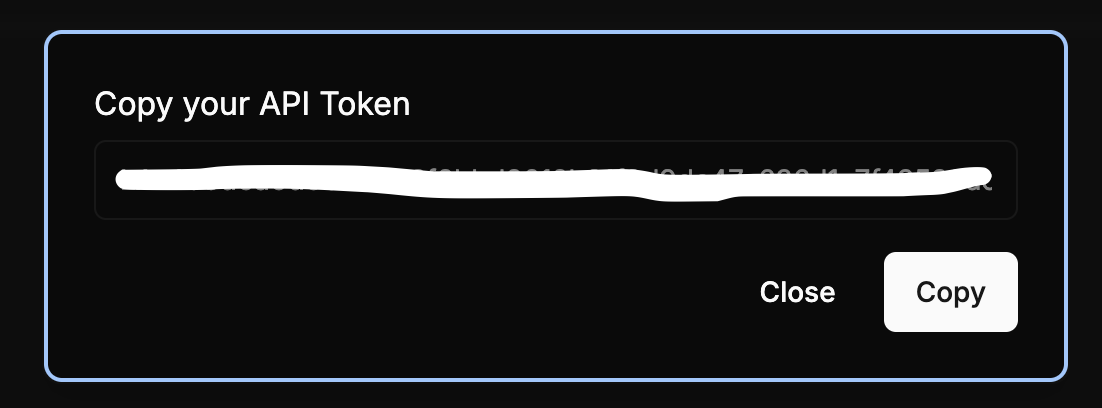

APIトークンが自動的に生成されるはずです。無断アクセスを防ぐために、安全な場所にコピーして保存してください。

APIトークンが作成されたら、それをコピーし、トークンの名前を変更し、削除できます。また、上記の手順に従って追加のトークンを簡単に作成することもできます。

ステップ2:Apidogをインストールする

前述のように、Apidog はあなたのAPI開発プロセスにおいてゲームチェンジャーになる可能性があります。無料でダウンロードでき、多様なAPIテストとドキュメントのストリーミング機能にアクセスできます。特にLlama 3.2を扱う際に便利で、リクエストのフォーマットやレスポンスの分析を簡単に行えます。

ステップ3:APIの構造を理解する

Llama 3.2が提供するAPIエンドポイントに慣れておきましょう。主要なエンドポイントには通常、以下が含まれます:

- /generate:プロンプトに基づいてテキストを生成します。

- /analyze:コンテキストや意図を理解します。

- /converse:リアルタイムで会話を続けます。

これらのエンドポイントを理解することは、効果的なAPI呼び出しを行うために重要です。

最初のAPI呼び出しを行う

準備が整ったら、最初のAPI呼び出しを行う時が来ました。やり方をステップバイステップで説明します。

ステップ1:環境を準備する

HTTPリクエストを行うために適切な環境があることを確認してください。Postman、curl、またはプログラミング言語のHTTPライブラリを使用できます。

ステップ2:リクエストを作成する

以下は/generateエンドポイントのサンプルリクエストです。Apidogを使用すると、このプロセスが簡素化されます:

POST /generate

{

"api_key": "your_api_key_here",

"prompt": "昔々、遠い国で",

"max_tokens": 100

}

ステップ3:リクエストを送信する

リクエストを準備したら、送信します。Apidogを使用している場合は、次のようにします:

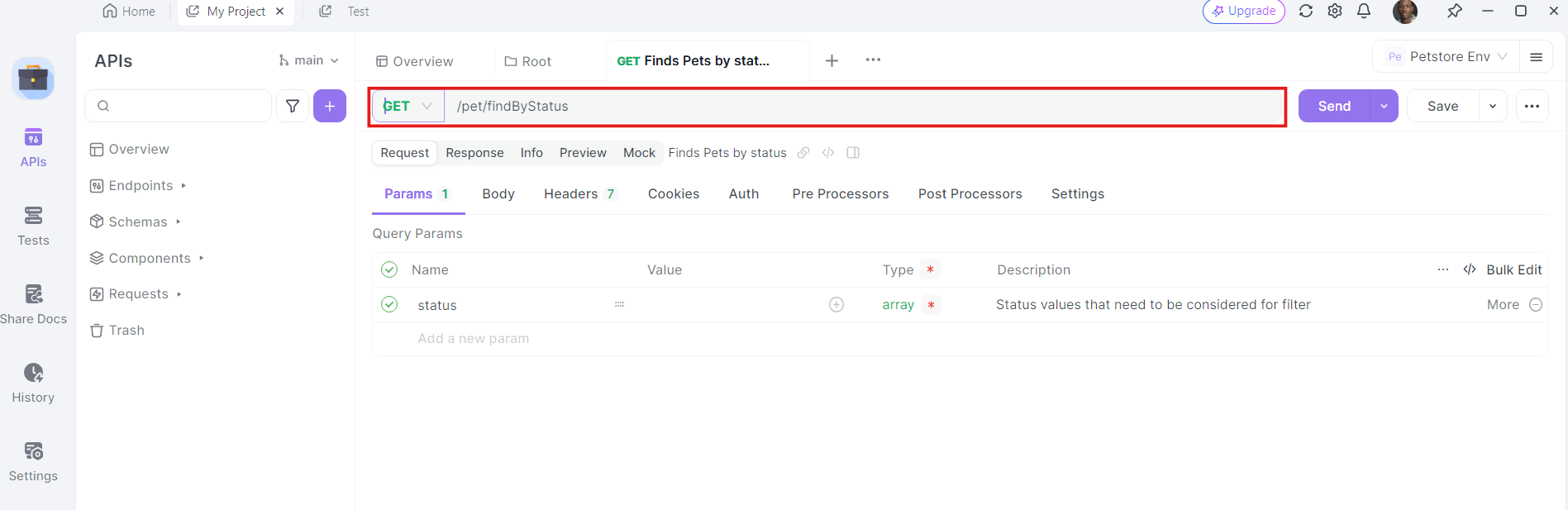

- Apidogを開く:Apidogを起動し、新しいリクエストを作成します。

2. HTTPメソッドを選択する:"GET"をリクエストメソッドとして選択するか、"POST"を選びます。

3. URLを入力する:URLフィールドに、GETリクエストを送りたいエンドポイントを入力します。

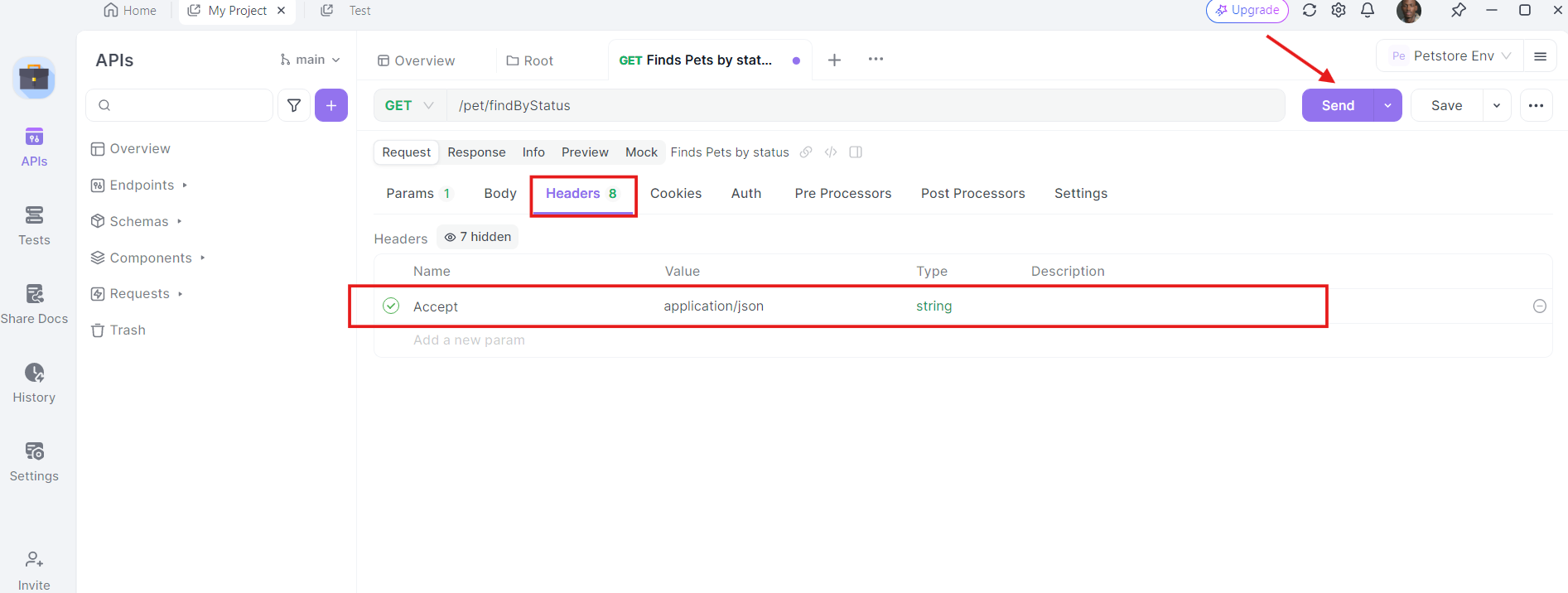

4. ヘッダーを追加する:必要なヘッダーを追加する時間です。Apidogの「ヘッダー」タブをクリックします。ここで、APIが必要とするヘッダーを指定できます。GETリクエストの一般的なヘッダーには、Authorization、Accept、およびUser-Agentが含まれることがあります。

例えば:

- Authorization:

Bearer YOUR_ACCESS_TOKEN - Accept:

application/json

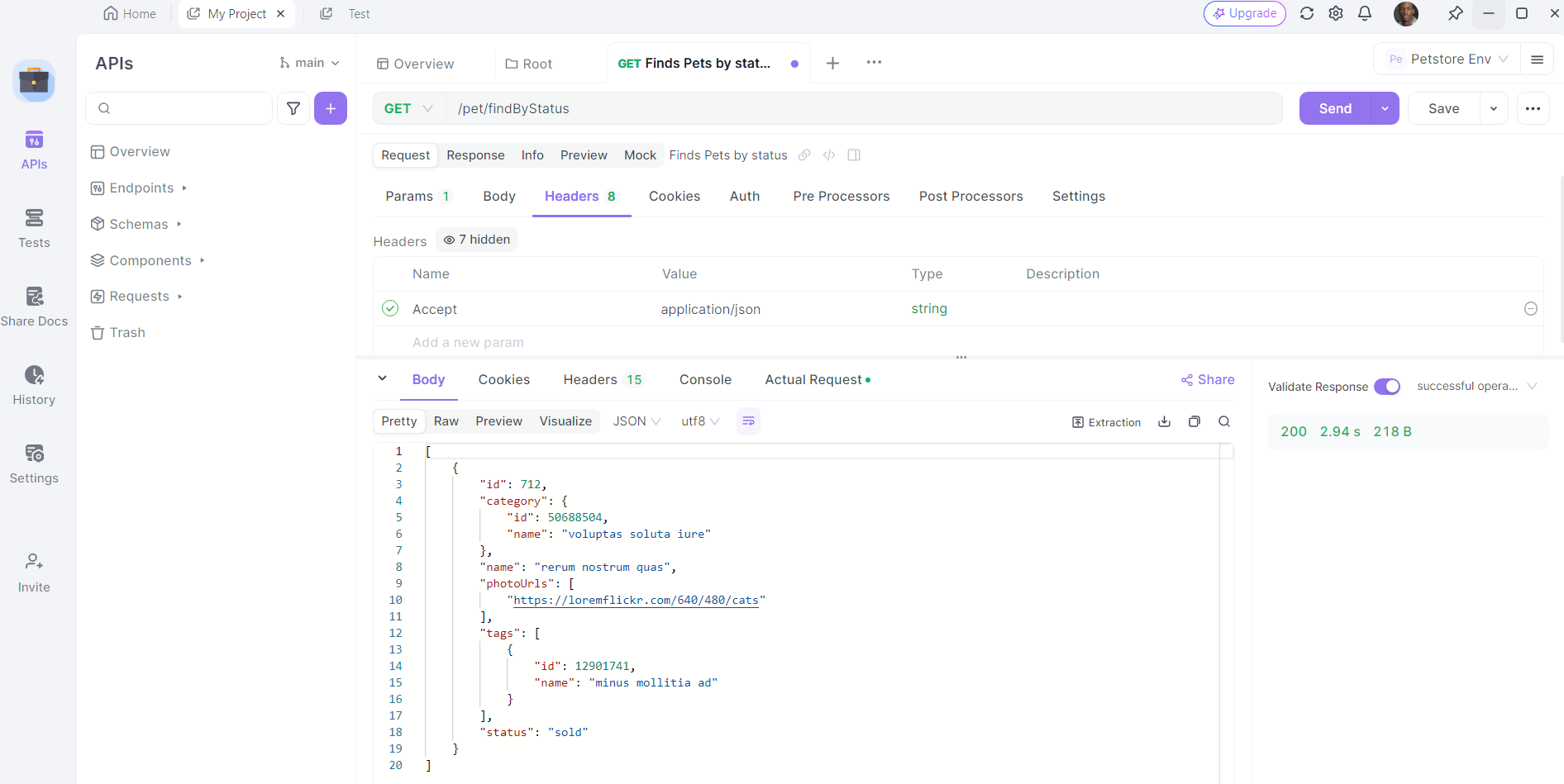

5. リクエストを送信してレスポンスを検査する:URL、クエリパラメータ、ヘッダーが整ったら、APIリクエストを送信できます。「送信」ボタンをクリックすると、Apidogがリクエストを実行します。レスポンスセクションに表示されるレスポンスを確認します。

ステップ4:レスポンスを分析する

レスポンスには通常、生成されたテキストと他の関連メタデータが含まれます。例えば:

{

"success": true,

"data": {

"text": "ドラゴンと戦った勇敢な騎士が住んでいました。"

}

}

このレスポンスは、リクエストが成功したことを示し、生成されたテキストを提供します。

Llama 3.2 APIの高度な機能

基本的なリクエストに慣れたら、高度な機能を探求することができます。

動的プロンプト

Llama 3.2の最もクールな機能の一つは、動的プロンプトです。コンテキストを含めたり、特定の質問をしたりすることで、よりニュアンスのあるリクエストを作成できます。例えば:

{

"api_key": "your_api_key_here",

"prompt": "Llama 3.2 APIを使用する主な利点は何ですか?",

"max_tokens": 50

}

このアプローチにより、ニーズに合わせて出力を適合させることができます。

コンテキストに基づく会話

/converseエンドポイントを使用すると、リアルな会話をシミュレートするインタラクティブなアプリケーションを作成できます。これは、チャットボットやバーチャルアシスタントに特に便利です。実装方法は次のとおりです:

POST /converse

{

"api_key": "your_api_key_here",

"message": "こんにちは、あなたは何ができますか?"

}

APIは自然な形で応答し、魅力的なユーザー体験を生み出すのを助けます。

Llama 3.2 APIを使用するためのベストプラクティス

Llama 3.2 APIで成功を最大化するために、これらのベストプラクティスを念頭に置いてください:

1. プロンプトを最適化する

出力の品質は、プロンプトの明確さと具体性によって大きく左右されます。最良の結果を得るために、考え抜かれた質問やステートメントを作成する時間をかけましょう。

2. 使用状況を監視する

予期しない課金を避けるために、APIの使用状況を監視しましょう。ほとんどのプロバイダーは、使用状況メトリクスを追跡できるダッシュボードを提供しています。

3. エラーハンドリングを実装する

API呼び出しは、ネットワークの問題やレート制限の超過など、さまざまな理由で失敗することがあります。これらの状況をうまく処理できるように、コードに堅牢なエラーハンドリングを実装しましょう。

4. キャッシングを賢く使用する

繰り返しリクエストを行う場合は、レスポンスをキャッシュしてパフォーマンスを向上させ、API呼び出しを減らすことを考慮してください。これにより、時間とリソースを節約できます。

結論

Llama 3.2 APIを使用すると、開発者に多くの可能性が広がります。高度な言語処理機能を活用することで、人間のようなテキストを理解し生成するアプリケーションを作成することができます。API開発体験を向上させるために、Apidogを無料でダウンロードすることを忘れないでください。このガイドで説明した手順に従うことで、Llama 3.2をプロジェクトに統合する準備が整います。