オープンソースの大規模言語モデル(LLM)の出現は、OpenAI の ChatGPT オペレーターのような独自のソリューションに匹敵する AI 駆動ツールを作成することをこれまで以上に容易にしました。これらのオープンソースモデルの中でも、DeepSeek R1は、堅牢な推論能力と、無料でのアクセス性、適応性で際立っています。DeepSeek R1をBrowser Useのようなツールと組み合わせることで、プレミアムサブスクリプションに何百ドルも支払うことなく、ChatGPT オペレーターに対する強力で完全にオープンソースの代替品を構築できます。

この記事では、DeepSeek R1 と Browser Use を設定して、ウェブオートメーション、推論、自然言語の相互作用などの複雑なタスクを実行できる AI エージェントを作成する手順を案内します。初心者の方も経験豊富な開発者の方も、このステップバイステップのガイドで始められます。

ChatGPT オペレーターとは何か、なぜオープンソースの代替が必要なのか?

ChatGPT オペレーターは、OpenAI が提供するプレミアム機能で、ユーザーが推論、ウェブオートメーション、複雑な問題解決などのタスクを実行できる高度な AI エージェントを作成することを可能にします。

ChatGPT オペレーターは月額 200 ドルで提供されており、限られた予算を持つ個人、小規模ビジネス、または組織にはアクセスしづらいです。

4. Booking a one-way flight from Zurich to Vienna using the Booking integration

— Rowan Cheung (@rowancheung) January 23, 2025

This one required a bit of back and forth, with ChatGPT Operator pinging me and asking for my flight preference and having me take control of entering payment details pic.twitter.com/XZiqUsQgVh

上記のビデオでは、ChatGPT オペレーターが航空券を予約していました。

なぜオープンソースの代替が必要なのか

ChatGPT オペレーターは強力ですが、オープンソースの代替品を魅力的にするいくつかの制限があります:

- コスト:月額 200 ドルのサブスクリプション料金は、多くのユーザーにとって高額です。

- データプライバシー:独自の API を使用すると、データを外部のサーバーに送信する必要があり、プライバシーポリシーや規制要件に準拠しない可能性があります。

- カスタマイズの制限:独自のソリューションは、微調整やタスク固有の最適化を制限することが多く、特化した使用例への適応を制限します。

DeepSeek R1 や Browser Use のようなオープンソースツールを選択することで、これらの課題を克服し、いくつかの利点を解放できます:

- コスト削減:DeepSeek R1 と Browser Use は完全に無料でオープンソースであり、サブスクリプション料金を排除します。

- 完全な制御:ツールをローカルまたは独自のサーバーでホスティングすることで、完全なデータプライバシーとセキュリティを確保できます。

- カスタマイズ性:特定のタスクに合わせてモデルを微調整したり、他のツールと統合したり、ユニークな要件に合わせてシステムを変更したりできます。

オープンソースアプローチは、独自のプラットフォームへの依存を減らすだけでなく、コストとデータを管理しながら、ニーズに合わせたソリューションを構築する力を与えます。

だったら、Apidogをチェックしてください。API設計からAPIドキュメントまで、すべてのサイクルをサポートし、開発チームの生産性を向上させるオールインワン API テストツールです。

重要なコンポーネント:DeepSeek R1 と Browser Use

DeepSeek R1

DeepSeek R1 は、推論タスク向けに最適化されたオープンソースの LLM です。思考過程の問題解決、コーディング支援、自然言語理解に優れています。さまざまなサイズ(例:1.5B、7Bパラメータ)で利用可能であり、異なるハードウェア能力に適応できます。

Browser Use

Browser Use は、AI エージェントがウェブスクレイピング、フォーム記入、自動ナビゲーションなどのブラウザベースのタスクを実行できるオープンソースツールです。ユーザーフレンドリーなインターフェースを提供し、DeepSeek R1 のような LLM と組み合わせて機能を向上させることができます。

ステップ 1: 環境を設定する

ハードウェア要件

- DeepSeek R1 の小型バージョン(例:1.5B パラメータ)の場合、CPU または中程度の GPU(8GB VRAM)があれば十分です。

- 大きなバージョンには高性能な GPU(例:NVIDIA A100 または RTX 4090)が必要です。

オペレーティングシステム

- セットアップの容易さから、Linux または macOS が推奨されます。Windows ユーザーは WSL(Windows Subsystem for Linux)を使用できます。

Python 環境

依存関係を隔離するために、Python 仮想環境を作成します:

python -m venv venv

source venv/bin/activate # Linux/macOS の場合

# Windows の場合:

# venv\Scripts\activate

必要なライブラリをインストールします:

pip install torch torchvision transformers sentencepiece

ステップ 2: DeepSeek を API 経由または Ollama でローカルに実行する

DeepSeek API 使用法

DeepSeek API と対話するには、以下の最新の手順に従います:

API キーを取得:

- DeepSeek プラットフォームに登録し、「API キー」セクションから API キーを生成します。このキーは、再表示されないため、安全に保存してください。

最初の API コールを行う:

DeepSeek API は OpenAI の API 形式と互換性があるため、既存の OpenAI SDK やソフトウェアとの統合が容易です。以下は、Python 実装の例です:

from openai import OpenAI

client = OpenAI(api_key="", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner", # DeepSeek-R1 には 'deepseek-reasoner' を使用

messages=[

{"role": "system", "content": "あなたは役立つアシスタントです。"},

{"role": "user", "content": "量子もつれについて説明してください。"}

],

stream=False # ストリーミング応答を希望する場合は True に設定

)

print(response.choices[0].message.content)

cURL の例:

cURL を使用する場合、リクエストを行う方法は次のとおりです:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer " \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "system", "content": "あなたは役立つアシスタントです。"},

{"role": "user", "content": "フランスの首都は何ですか?"}

],

"stream": false

}'

モデルの選択:

model="deepseek-reasoner"を指定して、DeepSeek-R1 を使用します。model="deepseek-chat"を一般的なチャットタスクに使用します。

base_url は https://api.deepseek.com/v1 に設定することもできますが、/v1 パスはモデルバージョンとは関係ありません。

Ollama で DeepSeek をローカルに実行する

Ollama は、DeepSeek-R1 のような大規模言語モデルをローカルマシンで実行するのを簡素化します。正しい設定と使用方法は次のとおりです:

Ollama をインストールする:

- 公式ウェブサイトから Ollama をダウンロードしてインストールします。

必要なモデルを取得する:

次のコマンドを使用して、特定のバージョンの DeepSeek-R1 をダウンロードします:

# 7B モデル (デフォルト)の場合:

ollama pull deepseek-r1:7b

# 小型の 1.5B モデルの場合:

ollama pull deepseek-r1:1.5b

# 70B のような大きなモデルの場合:

ollama pull deepseek-r1:70b

モデルをローカルで実行する:

ダウンロード後、モデルを次のように実行します:

ollama run deepseek-r1:7b

これにより、モデルと直接対話できるインタラクティブなセッションが開始されます。

モデルのバリエーション:

DeepSeek には、さまざまな使用例に最適化された Qwen と Llama アーキテクチャに基づくいくつかの蒸留版があります:

DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1:7b-qwen-distill

DeepSeek-R1-Distill-Llama-70B:

ollama run deepseek-r1:70b-llama-distill

ハードウェアの考慮事項:

- 1.5B または 7B などの小型モデルは、コンシューマグレードの GPU や CPU でも実行できます。

- 70B などの大きなモデルには、十分な VRAM(例:NVIDIA A100 または RTX 4090)を備えた高性能な GPU が必要です。

API 経由のインタラクティブチャット:

Ollama は、ローカルで実行されているモデルをアプリケーションに統合するための API を提供します:

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:7b",

"messages": [

{"role": "user", "content": "星についての短い詩を書いてください。"}

]

}'

ステップ 3: Browser Use のインストール

Browser Use により、AI エージェントがウェブブラウザと対話できるようになります。次の手順に従ってください:

インストール

GitHub から Browser Use リポジトリをクローンします:

git clone https://github.com/browser-use/browser-use.git

cd browser-use

pip install -r requirements.txt

構成

Browser Use WebUI を設定します:

python webui.py

エージェントの設定を構成するために、ブラウザで WebUI を開きます。以下を指定できます:

- LLM モデル(例:DeepSeek R1)

- ブラウザ設定(例:ウィンドウサイズ)

ステップ 4: DeepSeek R1 と Browser Use を組み合わせる

両方のツールを統合した機能的な AI エージェントを作成するには:

エージェントの構成

Browser Use のエージェント設定を変更して、DeepSeek R1 に接続します:

{

"model": "deepseek-r1",

"base_url": "http://localhost:5000",

"browser_settings": {

"window_height": 1080,

"window_width": 1920,

"keep_browser_open": true

}

}

エージェントの実行

DeepSeek R1 と Browser Use の両方を起動します:

# DeepSeek R1 API サーバーを開始

python -m deepseek.api_server

# Browser Use WebUI を開始

python webui.py

両方のサービスが実行されていると、エージェントはフォームの記入、データのスクレイピング、またはウェブサイトのナビゲートなどのタスクを自律的に実行できます。

ステップ 5: より良い結果のためのプロンプトエンジニアリング

AI エージェントのパフォーマンスを最適化するには、プロンプトエンジニアリングテクニックを使用します。例えば:

一般的なプロンプトテンプレート

<instructions>

あなたは、Browser Use を使用してウェブタスクを自動化する AI アシスタントです。

これらの手順に従ってください:

1. [ウェブサイト] に移動します。

2. [特定のタスク] を実行します。

3. 構造化された形式で結果を返します。

</instructions>

<example>

https://example.com に移動して、すべてのハイパーリンクを抽出します。

</example>

この構造は明確さを確保し、タスク実行の精度を向上させます。

以下は、実行することで試すことができるデモです:

uv pip install gradio

python examples/gradio_demo.py

例 1.

プロンプト:Google ドキュメントでパパへの手紙を書いて、すべてに感謝し、ドキュメントを PDF として保存します。

例 2.

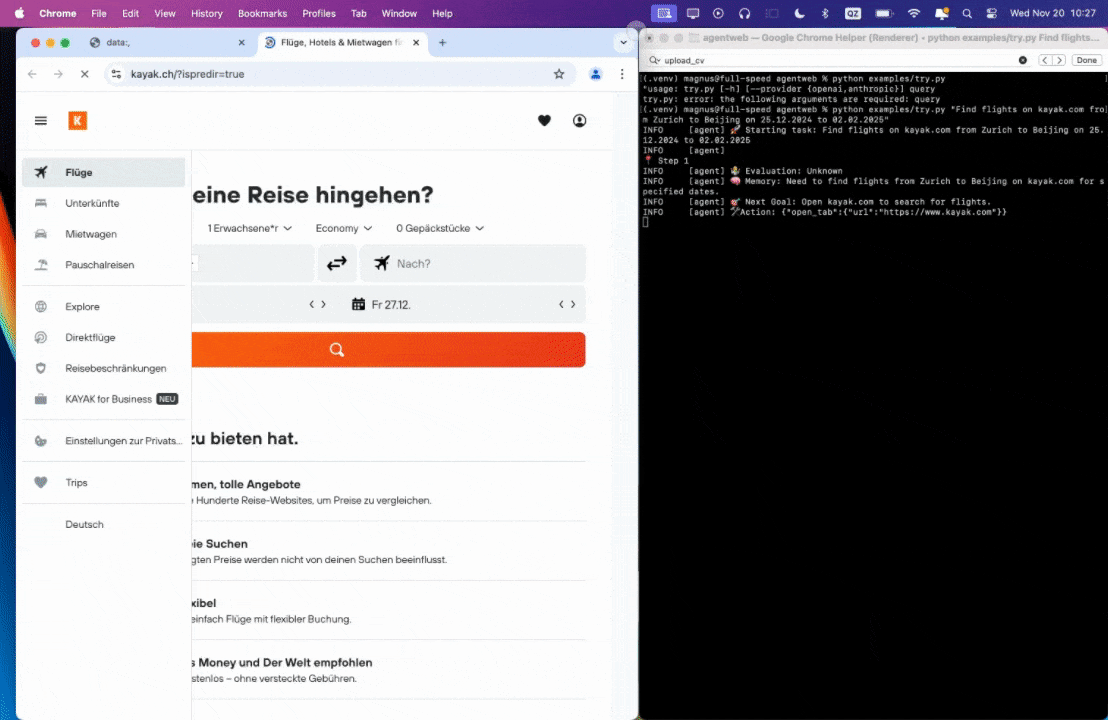

プロンプト:2024年12月25日から2025年2月2日まで、チューリッヒから北京へのフライトを kayak.com で見つけてください。

例 3.

プロンプト:私の CV を読み、ML の仕事を見つけてファイルに保存し、新しいタブで応募を開始して、必要な場合は私に助言を求めてください。

0:00/1×

結論

DeepSeek R1 と Browser Use を組み合わせることで、無料でオープンソースで、カスタマイズ性の高い完全な機能を持つ ChatGPT オペレーターの代替品を構築できます。このセットアップはコストを節約するだけでなく、データプライバシーとシステムの動作に完全に制御を与えます。

ウェブタスクの自動化、会話エージェントの構築、または Retrieval-Augmented Generation のような高度な AI 機能の実験を行っている場合、このガイドは始めるために必要なすべてを提供します。オープンソースの力を受け入れて、自分自身のインテリジェントアシスタントを今日作成しましょう!

だったら、Apidogをチェックしてください。API設計からAPIドキュメントまで、すべてのサイクルをサポートし、開発チームの生産性を向上させるオールインワン API テストツールです。