GoogleのGemini 2.5 Proのような高度なAIモデルのリリースは、開発者コミュニティにおいて大きな興奮を引き起こします。その強化された推論、コーディング能力、マルチモーダル理解は、アプリケーションの構築方法を革命的に変えることを約束しています。しかし、最先端のモデルにアクセスするには、コストや利用可能性に関する疑問が伴うことがよくあります。多くの開発者は「どのようにGemini 2.5 Proを無料で使用できるのか?」と考えています。一般的に、直接的で無制限のAPIアクセスには費用がかかることが多いですが、この強力なモデルと無償で対話する合法的な方法があります。主にそのウェブインターフェースを通じて、またコミュニティプロジェクトを介してプログラム的に使用できます。

Gemini 2.5 Proを無料で使用する公式な方法:ウェブインターフェース

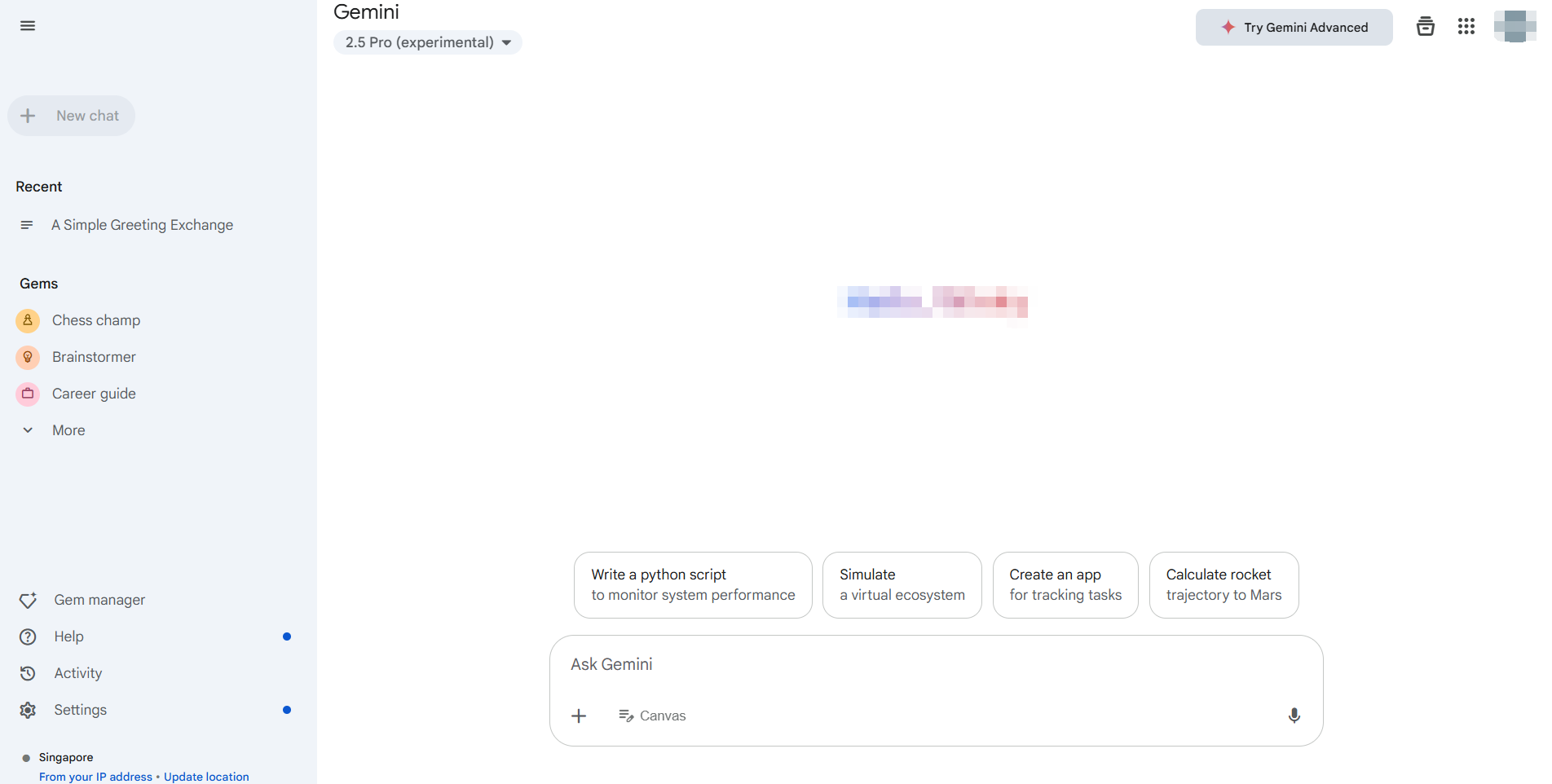

Gemini 2.5 Proを無償で使用する最も簡単で公式にサポートされた方法は、専用のウェブアプリケーションを通じて行うことです。通常、https://gemini.google.com/でアクセスできます。Googleは一般ユーザー向けにこのインターフェースを通じて、最新のモデル、特にGemini 2.5 Pro(地域やアカウントの状態によって異なる場合があります)へのアクセスを提供しています。

ウェブインターフェースの主な利点:

- コストゼロ:これは、直接的なインタラクションを提供する標準の無料プランです。

- 完全な機能アクセス:通常、テキスト生成、ブレインストーミング、コーディング支援、場合によっては画像生成(Imagen3のように、利用可能性に依存)やGoogle Workspace拡張機能(Gmail、Docs、Driveなど)とのインタラクションを含めて、モデルのコア機能を活用できます。

- 使いやすいUI:ウェブインターフェースは使いやすさを重視して設計されており、Googleアカウントにログインする以外のセットアップは必要ありません。

使い方:

- Geminiウェブアプリケーションにアクセスします。

- Googleアカウントでログインします。

- 複数のモデルが利用可能な場合は(設定やプロンプト入力の近くに表示されることが多い)、Gemini 2.5 Proが選択されていることを確認します。

5. インタラクションを開始します!プロンプトを入力したり、ファイルをアップロード(サポートされている場合)したりして、機能を探索します。

Gemini 2.5 Proを評価したり、プロンプトをテストしたり、非プログラム的なタスクを実行したりする必要のある多くのユーザーや開発者にとって、公式のウェブインターフェースは理想的でコストのかからないソリューションです。この方法はAPIキーを必要とせず、有料APIに関連する使用制限に対処することなく、モデルの力に直接アクセスを提供します。この方法は、探索や手動インタラクションに対してGemini 2.5 Proを無料で使用するニーズを完璧に解決します。

直接的なAPIコストなしでGemini 2.5 Proをプログラム的に使う方法

ウェブインターフェースは手動での使用には優れていますが、開発者は統合、オートメーション、バッチ処理のためにプログラム的アクセスを必要とすることがよくあります。公式のGoogle生成AI APIは、Gemini 2.5 Proのようなモデルに対して通常、トークン使用に基づいて費用が発生します。しかし、開発者コミュニティはこのギャップを埋めるためのツールを作成することがよくあります。

そのようなツールの一例として、Gemini API Pythonライブラリのようなコミュニティリソースで強調されているものがあります。これにより、開発者はプログラム的に無料のGeminiウェブインターフェースと対話することができます。

重要な免責事項:これは公式のGoogle生成AI APIではありません。これらのライブラリは、ウェブアプリケーションのプライベートAPIコールをリバースエンジニアリングし、ブラウザクッキーを使用して認証します。

- 非公式:Googleによってサポートされたり推奨されたりしていません。

- 潜在的に不安定:通知なしに変更される可能性のあるウェブインターフェースの要素に依存しているため、ライブラリが壊れる可能性があります。

- セキュリティに関する考慮:ブラウザからの認証クッキーの抽出が必要であり、注意深く扱わないと固有のセキュリティリスクが伴います。

- 利用規約:使用がウェブアプリケーションのGoogleの利用規約に違反する可能性があります。

これらの警告にもかかわらず、このようなライブラリは開発者にとって実験を行い、Gemini 2.5 Proを無料で使用する方法を提供しています。ただし、これはウェブインターフェース自体の無料プランの制限を超えたものですが、自動化された方法で行われます。

ステップバイステップガイド:

前提条件:Python 3.10以降がインストールされていることを確認してください。

インストール:pipを使用してライブラリをインストールします:

pip install -U gemini_webapi

# オプション:簡単なクッキー取得のためにbrowser-cookie3をインストール

pip install -U browser-cookie3認証(難しい部分):

gemini.google.comにウェブブラウザでログインします。- 開発者ツール(F12)を開き、

Networkタブに行き、ページをリフレッシュします。 - リクエストを見つけます(通常はどのリクエストでも機能します)。

- リクエストヘッダー(通常は「Cookies」の下)で、

__Secure-1PSIDと__Secure-1PSIDTSの値を見つけてコピーします。これをパスワードのように扱ってください! - 代替策:もし

browser-cookie3がインストールされていれば、ライブラリはサポートされているブラウザでログインしている場合、自動的にクッキーをインポートできることがあります。このステップが簡略化されますが、ローカルブラウザの状態に依存しています。

初期化&基本的な使用法:

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # モデル定数をインポート

# --- 認証 ---

# 方法1:手動でクッキーを貼り付ける(安全に扱うこと!)

Secure_1PSID = "YOUR__SECURE_1PSID_COOKIE_VALUE"

Secure_1PSIDTS = "YOUR__SECURE_1PSIDTS_COOKIE_VALUE" # オプションかもしれません

async def run_gemini():

# 方法2:browser-cookie3を使用する(インストールされログインしている場合)

# client = GeminiClient(proxy=None) # 自動クッキーインポートを試みる

# 手動のクッキーで初期化

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # 接続を初期化

# --- モデルを選択し、コンテンツを生成 ---

prompt = "RESTとGraphQL APIの違いを説明してください。"

# Gemini 2.5 Proモデル識別子を使用

print(f"Gemini 2.5 Proにプロンプトを送信中...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # 特定のモデルを使用

print("\n応答:")

print(response.text)

# クライアントセッションを閉じる(リソース管理に重要)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())さらに探求する:このようなライブラリは、マルチターンチャット(client.start_chat())、ファイルアップロード、画像生成リクエスト、拡張機能の使用(@Gmail、@Youtube)など、ウェブUIで利用可能な機能をサポートしていることが多いです。これにより、ウェブアプリの機能をプログラム的に反映できます。

このアプローチは、無料のウェブティアとのインタラクションを自動化します。有料APIなしでGemini 2.5 Proをプログラム的に実験することができますが、信頼性やセキュリティに関する重大な警告が伴います。

LLMにおけるデバッグの課題

ウェブ、公式API、または非公式ライブラリを通じてGemini 2.5 Proと対話する際、特に複雑な出力やストリーミング出力を扱う場合、応答の理解とデバッグが重要です。多くのLLM、特にAPI形式のものは、トークンごとやチャンクごとに応答をストリーミングするためにサーバー送信イベント(SSE)を利用しています。これによりリアルタイム感がありますが、標準のHTTPクライアントを使用してデバッグするのは困難です。

従来のAPIテストツールは、生データをそのまま表示するだけで、チャンクを組み合わせて完全なメッセージを作成したり、情報の流れ、特にモデルの「思考過程」を理解したりするのが難しくなります。これが専門のツールが非常に価値あるものとなる理由です。

Apidogを紹介します:API開発プラットフォームの包括的でオールインワンなソリューションです。設計やドキュメント作成からデバッグ、自動テスト、モックまで、APIライフサイクル全体を扱うために設計されています。強力さと全体的な機能を持ちながら、Apidogは特に現代のAPIプロトコルを扱うのに優れており、LLMと連携する開発者にとっては卓越したAPIテストツールとなります。SSEデバッグの機能は、ストリーミング応答の課題に対処するために特別に構築されています。

リアルタイムLLM応答をマスターする

Gemini 2.5 ProのようなLLMを使用する場合、通常はサーバー送信イベント(SSE)を利用して結果をストリーミングします。この技術により、AIモデルはリアルタイムでクライアントにデータをプッシュし、生成されたテキストやその過程を表示します。ユーザーエクスペリエンスには素晴らしいですが、基本的なツールで生のSSEストリームをデバッグするのは、断片化されたメッセージの山という悪夢になることがあります。

Apidogは、先進的なAPIテストツールとしての役割を果たし、SSEデバッグを面倒な作業から明確なプロセスへと変えます。ApidogがどのようにLLMストリームを制御するのかを以下に示します:

- 自動SSE検出:Apidogを使用してLLMエンドポイントにリクエストを送信すると、応答ヘッダーの

Content-Typeがtext/event-streamの場合、Apidogは自動的にそれをSSEストリームとして認識します。 - リアルタイムタイムラインビュー:生の

data:行をそのまま表示するのではなく、Apidogは受信メッセージを時系列に表示する専用の「タイムライン」ビューを提供します。これにより、サーバーから送信される情報の流れを正確に視覚化できます。 - インテリジェント自動マージ:これはLLMのSSEデバッグにとってゲームチェンジャーです。Apidogは、主要なAIプロバイダーが使用する一般的なストリーミングフォーマットを認識するためのビルトインインテリジェンスを持っています:

- OpenAI API互換フォーマット(多くが使用)

- Gemini API互換フォーマット

- Claude API互換フォーマット

- Ollama API互換フォーマット(ローカルで実行されるモデル用、通常はJSONストリーミング/NDJSON)

ストリームがこれらのフォーマットに一致する場合、Apidogは個々のメッセージフラグメント(data:チャンク)を完全一貫した最終応答または中間ステップに自動的にマージします。もう手動でチャンクをコピー&ペーストする必要はありません!AIが意図した通りの全体像が見えます。

4. 思考プロセスの可視化:メインコンテンツと一緒に推論や「思考」をストリーミングするモデル(DeepSeekの特定の設定など)については、Apidogはタイムライン内でこのメタ情報を明確に表示できることが多く、モデルのプロセスに対する貴重な洞察を提供します。

ApidogをSSEデバッグに利用することで、LLMエンドポイントがどのように応答しているかを、明確でリアルタイムの、そしてしばしば自動的に構造化された形で取得できます。これにより、問題を特定し、生成プロセスを理解し、最終出力が正しいことを確認するのが、一般的なHTTPクライアントや従来のAPIテストツールに比べて大幅に容易になります。

結論:Gemini 2.5 Proを無料で利用する

Gemini 2.5 Proを公式ウェブインターフェースを通じて無料で探索できます。APのようなアクセスを求める開発者は、コミュニティが構築したツールを試すことができますが、これらには不安定性や利用規約に関するリスクが伴います。

LLM、特にストリーミング応答を扱う場合は、従来のツールでは十分ではありません。そこでApidogが輝きます。自動SSE検出、タイムラインビュー、破片化されたデータのスマートマージなどの機能を備え、Apidogはリアルタイムの応答をデバッグする作業をはるかに容易にします。そのカスタムパースサポートにより複雑なワークフローがさらにスムーズになり、現代のAPIおよびLLM開発に不可欠なツールとなります。