AIを活用したコーディングが急速に進化する世界では、スピードがすべてです。Cursorは、人気のAIコーディングIDEであり、コード生成、コンテキスト認識、エージェントツールによって生産性を向上させると約束しています。しかし最近、多くのユーザーから「なぜCursorはこんなに遅いのか?」という声が上がっています。

応答の遅延、コード適用のもたつき、UIの重さにイライラしているのはあなただけではありません。この記事では、実際のユーザーの懸念事項を掘り下げ、Cursorのパフォーマンス問題の根本原因を探り、そして最も重要なこととして、それらを修正する方法を示します。また、Cursorのワークフローに統合して、より速くスマートにコーディングするのに役立つ強力なツールも紹介します。

なぜCursorは遅いのか?実際のユーザー体験と懸念事項

Cursorの約束はシンプルです。AIとペアプログラミングし、コードを編集し、コードベース全体を理解するエージェントを使用することです。しかし多くのユーザーにとって、現実はイライラするほどの遅さでした。

ユーザーは何を経験しているのか?

- AI応答の遅延:有料プランでも、単純なコード生成に20〜60秒の遅延を報告するユーザーがいます。

- UIの遅さ:タイピング、クリック、さらにはアプリの終了さえ、耐えられないほど遅くなることがあります。

- 高いリソース使用率:コード適用中にGPUが90%に急上昇するユーザーもいますが、VRAMやCUDAの関与は最小限です。

- クラッシュとフリーズ:Cursorは時々ハングアップしたり、再起動したり、応答しなくなったりします。特に大規模なコードベースや長いチャット履歴がある場合に顕著です。

- エージェントの遅延:AIエージェントがタスクの途中でハングアップしたり、単純なアクションに10分以上かかったりします。

- メモリリーク:エラーログには数千のイベントリスナーが表示されており、メモリリークの可能性を示唆しています。

ユーザーの声:

元のソースを見る

元のソースを見る

元のソースを見る

元のソースを見る

一般的なトリガー:

- 大規模なコードベース

- 長いチャット履歴

- 最近のアップデート(特にv0.49以降)

- 拡張機能またはプラグイン

- 高いシステムリソース使用率

Cursorが遅くなる原因は何ですか?

根本原因を掘り下げると、Cursorのパフォーマンス低下を引き起こすいくつかの要因が考えられます。

1. 大規模なコードベースとコンテキストウィンドウ

- CursorのAIはコンテキストを必要としますが、数千のファイルや大規模なコードベースをロードするとシステムが圧倒される可能性があります。

- ロードされるファイルや履歴が多いほど、応答は遅くなります。特にコンテキストウィンドウが満杯の場合に顕著です。

2. 長いチャット履歴

- 過去のチャットを参照したり、長いチャットウィンドウを開いたままにしたりすると、大幅な遅延が発生する可能性があります。

- 考えられる解決策:新しいチャットまたはプロジェクトディレクトリを開始すると、すぐに速度が回復したと報告するユーザーもいます。

3. 拡張機能とプラグイン

- 拡張機能はリソースを消費したり、Cursorのコアプロセスと競合したりする可能性があります。

- 考えられる解決策:すべての拡張機能を無効にすると、パフォーマンスの問題が解決することがよくあります。

4. メモリリークとリソース管理

- エラーログには数千のイベントリスナーが表示されており、メモリリークの可能性を示唆しています。

- 最小限のVRAM/CUDA関与での高いGPU使用率は、非効率なリソース割り当てを示唆しています。

5. 最近のアップデートとバグ

- 多くのユーザーがv0.49以降にアップデートしてから遅延に気づきました。

- 以前のバージョンに戻したり、パッチを待ったりすることが役立つ場合があります。

6. システムの制限

- 古いハードウェア、限られたRAM、または複数の重いアプリを実行していると、Cursorの遅さが悪化する可能性があります。

表:Cursorが遅くなる一般的な原因

| 原因 | 症状 | 解決策 |

|---|---|---|

| 大規模なコードベース | ロードが遅い、AIがもたつく | ファイルを制限する、プロジェクトを分割する |

| 長いチャット履歴 | UIの遅延、応答が遅い | 新しいチャット/プロジェクトを開始する |

| 拡張機能 | クラッシュ、高いリソース使用率 | すべての拡張機能を無効にする |

| メモリリーク | 遅延の増加、エラー | アプリを再起動する、バグを報告する |

| 最近のアップデート | アップデート後の新しい遅延 | ロールバックする、パッチを確認する |

| システムの制限 | 全体的な遅さ | 他のアプリを閉じる、RAMをアップグレードする |

Cursorの遅さを修正する方法:実行可能な解決策

Cursorの遅い体験に苦労している場合は、これらの解決策を試してみてください。多くはユーザーとCursorの公式トラブルシューティングガイドの両方で推奨されています。

1. 新しく始める:新しいチャットまたはプロジェクト

- 新しいチャットウィンドウを開き、古いチャットを参照しないようにします。

- プロジェクトを新しいディレクトリに移動してコンテキストをクリアします。

- 可能であれば、大規模なコードベースを小さなプロジェクトに分割します。

2. 拡張機能を無効にする

- コマンドラインから

cursor --disable-extensionsでCursorを起動します。 - パフォーマンスが向上した場合は、拡張機能を一つずつ再度有効にして原因を特定します。

3. キャッシュをクリアして再インストールする

- Cursorのキャッシュをクリアしたり、アプリを再インストールしたりすると、永続的な遅延が解決することがあります。

- 注:現在、「チャット履歴をクリア」ボタンはありません。完全にリセットするには再インストールが唯一の方法です。

4. システムリソースを監視する

- タスクマネージャー(Windows)またはアクティビティモニター(Mac)を使用して、CPU、GPU、RAMの使用率を確認します。

- 他の重いアプリケーションを閉じてリソースを解放します。

5. アップデートまたはロールバックする

- 最新のCursorアップデートを確認します。パフォーマンスのバグはしばしば迅速に修正されます。

- 新しいアップデートが問題を引き起こす場合は、以前のバージョンにロールバックすることを検討します。

6. メモリリークを確認する

- エラーログで「potential listener LEAK detected」を確認します。

- 永続的なリークはCursorのサポートチームに報告して調査してもらいます。

7. チャットとコンテキストを最適化する

- 不要なファイルをロードしたり、タブをたくさん開いたままにしたりしないようにします。

- 重要なチャット履歴をエクスポートし、必要に応じて新しく開始します。

これらの問題は気が遠くなるかもしれませんが、特にAPIを扱う場合に、AIアシスト開発の重要な部分を最適化するために積極的に講じることができるステップがあります。ここでApidog MCP Serverが役立ちます。Cursorが様々な形式や複雑なオンラインドキュメントに散らばったAPI仕様を解析したりアクセスしたりするのに苦労する可能性がある代わりに、無料のApidog MCP Serverは、ApidogプロジェクトまたはOpenAPIファイルから直接、合理化されたキャッシュされたAIフレンドリーなデータソースを提供します。これにより、CursorがAPIコントラクトに基づいてコードを理解し生成する必要がある場合の負荷が大幅に軽減され、より高速で信頼性の高いCursorコーディングワークフローにつながります。

Apidog MCP Server(無料)でCursorワークフローをスーパーチャージ

特にAPI仕様を含むタスク中にCursorが遅い場合、根本原因はCursorがこのAPIデータにアクセスして処理する方法にある可能性があります。従来のAPIドキュメントは人間が読めますが、AIツールが効率的に解析するのは難しい場合があります。Apidog MCP Serverは、Cursorコーディングワークフローを強化するための無料で強力な方法を提供します。

Apidog MCP Serverとは?

ApidogはオールインワンのAPI開発プラットフォームであり、そのApidog MCP Serverは、CursorのようなAIパワードIDE向けに特別に設計された機能の素晴らしい拡張機能です。これにより、AIアシスタントがApidogプロジェクトまたはローカル/オンラインのOpenAPI/SwaggerファイルからAPI仕様に直接かつ効率的にアクセスできます。この統合は単なる小さな調整ではなく、AIがAPI設計とどのように相互作用するかの根本的な改善です。Apidog MCP Serverの主な利点は以下の通りです。

- AIがAPI仕様に直接アクセスできるようにすることで、より高速で信頼性の高いコード生成を実現

- 速度とプライバシーのためのローカルキャッシュ—リモート検索を待つ必要がありません

- Cursor、VS Code、その他のIDEとのシームレスな統合

- 複数のデータソースをサポート:Apidogプロジェクト、公開APIドキュメント、Swagger/OpenAPIファイル

Cursorの遅さをどのように助けますか?

- コンテキストの過負荷を軽減:AIが必要なAPIデータのみをフェッチできるようにすることで、Cursorのコンテキストウィンドウに大量のコードベースをロードすることを回避します。

- 遅延を最小限に抑える:ローカルキャッシュにより、リモート応答を待つ時間が短縮されます。

- ワークフローを合理化:Cursorのパフォーマンスボトルネックにぶつかることなく、コードの生成、更新、ドキュメント作成を高速化します。

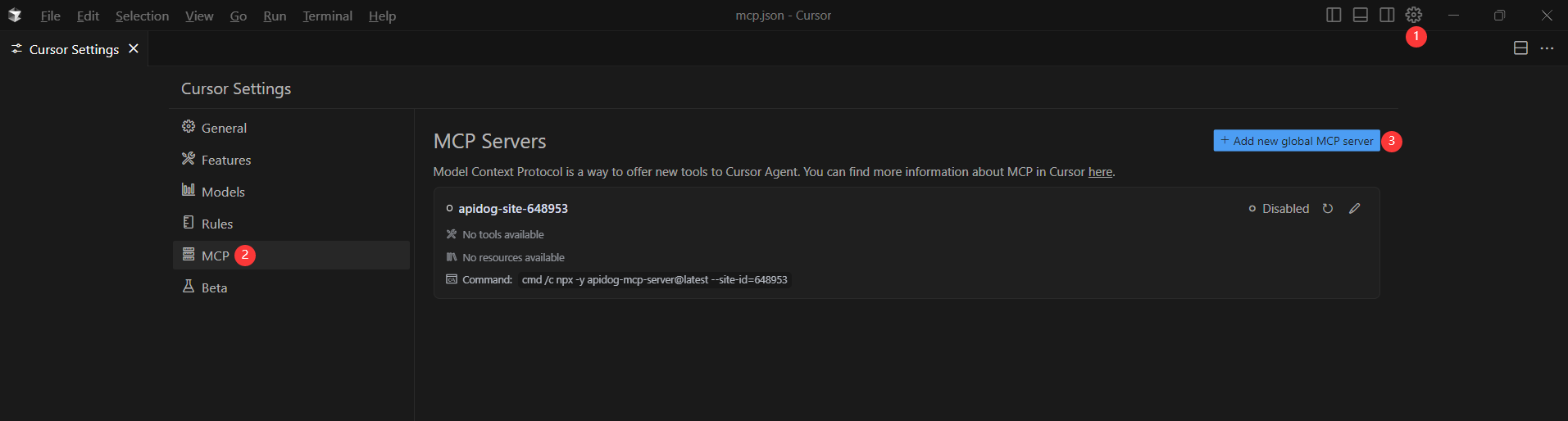

Apidog MCP ServerをCursorと統合する方法

Apidog MCP ServerをCursorと統合すると、AIアシスタントがAPI仕様に直接アクセスできるようになります。設定方法は以下の通りです。

前提条件:

開始する前に、以下を確認してください。

✅ Node.jsがインストールされていること(バージョン18+; 最新のLTS推奨)

✅ MCPをサポートするIDE(例:Cursor)を使用していること

ステップ1:OpenAPIファイルを準備する

API定義へのアクセスが必要です。

- URL(例:

https://petstore.swagger.io/v2/swagger.json) - またはローカルファイルパス(例:

~/projects/api-docs/openapi.yaml) - サポートされる形式:

.jsonまたは.yaml(OpenAPI 3.x推奨)

ステップ2:CursorにMCP構成を追加する

Cursorのmcp.jsonファイルに構成を追加します。

<oas-url-or-path>を実際のOpenAPIのURLまたはローカルパスに置き換えることを忘れないでください。

- MacOS/Linuxの場合:

- Windowsの場合:

{

"mcpServers": {

"API specification": {

"command": "npx",

"args": [

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}{

"mcpServers": {

"API specification": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}ステップ3:接続を確認する

設定を保存したら、エージェントモードで以下のコマンドを入力してIDEでテストします。

Please fetch API documentation via MCP and tell me how many endpoints exist in the project.動作すれば、エンドポイントとその詳細をリストした構造化された応答が表示されます。動作しない場合は、OpenAPIファイルへのパスを再確認し、Node.jsが正しくインストールされていることを確認してください。

結論

CursorでのAIアシストコーディングの複雑さを乗り越えるには、その潜在的な落とし穴を理解することと、機能を強化するツールを活用することの両方が必要です。パフォーマンスの遅さ、リソースの占有、コンテキストの制限といった問題はイライラする可能性がありますが、新しいプロジェクトを開始したり、拡張機能を管理したり、システムリソースを監視したりといった積極的なトラブルシューティングによって、多くは軽減できます。

さらに、Apidog MCP Serverのような革新的なソリューションを統合することで、特にAPIを扱う場合のワークフローが大幅に合理化されます。CursorにAPI仕様への直接的で最適化されたアクセスを提供することで、処理負荷を軽減し、より高速で信頼性の高いコード生成を実現できます。