強力なモデルをローカルで実行することは、プライバシー、速度、およびコスト効率のためにますます重要です。この領域の最新の革新の1つがCommand Aであり、最小限の計算で最大のパフォーマンスを発揮するように設計された最先端の生成モデルです。ローカルAI展開オプションを模索している場合、このガイドではOllamaを使用してCommand Aをローカルで実行する方法を詳しく説明します。

しかし、Command Aとは一体何なのでしょうか?なぜ作成されたのか、そしてGPT-4oやDeepSeek-V3のような主要モデルとどのように比較されるのでしょうか?このチュートリアルでは、Command Aの目的、パフォーマンスベンチマーク、API価格について深く掘り下げます。また、Ollamaを使用してCommand Aをマシンで設定および実行するためのステップバイステップの手順も提供します。

Command Aとは何ですか?

Command Aは、企業アプリケーション向けに設計された最先端の生成AIモデルです。Cohere Teamによって開発されたCommand Aは、最小限の計算オーバーヘッドで最大のパフォーマンスを提供するように構築されています。通常の他のモデルが必要とする32個のGPUと比較して、わずか2つのGPUでローカルハードウェア上で動作するように設計されています。そのアーキテクチャは、高速で安全かつ高品質なAI応答を提供するように最適化されており、プライベートな展開にとって魅力的な選択肢となっています。

Command Aの核心は、高度な自然言語処理と生成タスクを促進するツールです。大量のテキストを迅速に処理し、複雑な指示を扱い、会話的な方法で信頼性の高い応答を提供するアプリケーションのバックボーンとして機能します。

誰がCommand Aを使用しますか?

Command Aは企業アプリケーション向けに設計されており、最小限のハードウェア要件で高パフォーマンスを提供します。速度や精度を犠牲にすることなく、わずか2つのGPU(A100またはH100)で効率的に動作します。256kのコンテキスト長により、長文書、マルチリンガルクエリ、およびビジネスにおける重要なタスクの処理に優れています。

そのエージェント機能は自律的なワークフローをサポートし、また多言語最適化により異なる言語間での一貫した応答を保証します。さらに、低いハードウェア要求と速いトークン生成は、コスト効率的であり、待機時間と運用コストの両方を削減します。最後に、ローカルデプロイメントはセキュリティを強化し、機密データを社内に保持し、クラウドベースのAIサービスに関連するリスクを最小限に抑えます。

これらの利点により、Command Aは最先端のモデルに伴う高コストを負担することなく、強力なAI機能を統合しようとする企業にとって魅力的な選択肢となっています。

Cohere Command AのAPI価格設定

コストは、AIソリューションを展開する企業にとって重要な考慮事項です。Command Aは、高性能でありながらコスト効率的に設計されています。以下はその価格設定の比較です:

Command AのCohere API価格設定:

- 入力トークン: 1百万トークンあたり$2.50

- 出力トークン: 1百万トークンあたり$10.00

これらのコストを他のモデルのクラウドベースのAPIアクセスのコストと比較すると、Command Aのプライベートデプロイメントは最大50%安価にすることができます。この大幅なコスト削減は以下によって達成されます:

- 効率的な計算使用: 数十個のGPUではなく、わずか2つのGPUを必要とします。

- 高いスループット: より速いトークン生成により処理時間が短縮され、運用コストが削減されます。

- プライベートデプロイメント: モデルをオンプレミスで実行すると、セキュリティが強化されるだけでなく、繰り返し発生するクラウドAPIコストを回避できます。

大量のデータを処理する企業やAIとの継続的かつ高速なインタラクションが必要な企業にとって、これらの価格の利点はCommand Aを非常に魅力的な選択肢にしています。

OllamaをインストールしてCommand Aを実行する方法

なぜCommand Aをローカルで実行するのですか?

- プライバシー: データはデバイス内に留まります。

- コスト: API料金や使用制限がありません。

- カスタマイズ: 必要に応じてモデルを微調整できます。

- オフラインアクセス: インターネット接続なしでAIを使用できます。

前提条件

- Ollama: Ollama.aiからインストールします。

- Command Aモデル: Ollamaの公式ウェブサイトの「models」セクションから直接

command-aモデルを取得できます。

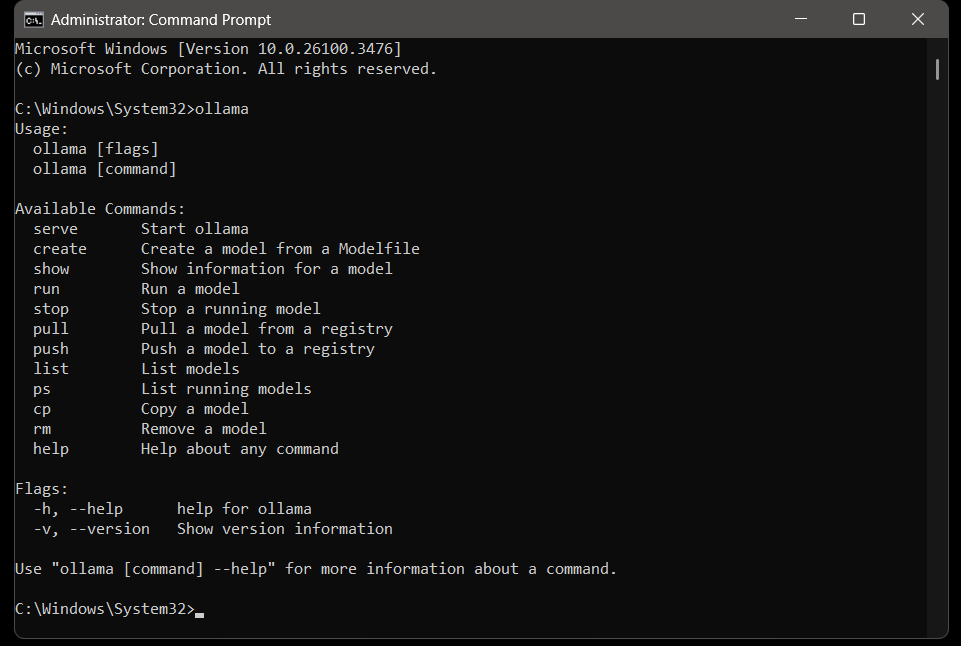

ステップ 1: Ollamaをインストールする

Windows/macOS/Linux:

- 公式サイトからOllamaをダウンロードし、インストーラーを実行します。インストール後、次のコマンドを使用してインストールを確認してください:

ollama --version

# 例の出力: ollama version 0.1.23 Ollamaがシステムにインストールされると、ollamaコマンドを実行してOllamaの利用可能なコマンドを表示できます。

ステップ 2: Command Aモデルを取得する

Ollamaは、ライブラリを介して数千のモデルをサポートしています。公式サイトに移動し、「models」セクションの下でcommand aを検索してください。

# モデルを取得する

ollama pull command-a

# モデルを取得し、完了後に実行する

ollama run command-a

注意: カスタムCommand-aモデルファイルがある場合は、次を使用してください:

ollama create command-a -f Modelfileモデルは非常に大きく、かなりのストレージスペースを必要とします。インストール前に、使用可能なディスクスペースを確認し、システムの容量に最適な別のモデルを探してください。

ステップ 3: Command Aをローカルで実行する

Ollamaサーバーを起動し、モデルを実行します:

# サーバーを起動

ollama serve

# モデルをロード

ollama run command-a テストする: ターミナルで直接質問します:

# サンプル入力の質問

>>> ザンビアの首都はどこですか?

# サンプルの応答

>>> ルサカトラブルシューティング

堅牢なセットアップでも、問題が発生する可能性があります。以下はトラブルシューティングのヒントとベストプラクティスです:

1. “モデルが見つかりません”エラー

- モデル名を確認します:

ollama list - モデルを再度取得します:

ollama pull command-a

2. API接続の問題

- Ollamaが実行中であることを確認します:

ollama serve

3. 遅いパフォーマンス

- より小さなモデルを使用します(例:

command-r:3b)。 - Ollamaにより多くのRAMを割り当てます。

Command A vs GPT-4o & Deepseek V3

AIモデルを評価する際には、理論的なパフォーマンスだけでなく、実際のベンチマークや実世界のユースケースでも比較することが重要です。Command AはGPT-4oやDeepSeek-V3のようなモデルとベンチマークされ、その結果は印象的です:

- パフォーマンス効率: Command Aは、最大156トークン/秒の速度でトークンを出力し、GPT-4oの1.75倍、DeepSeek-V3の2.4倍の速さです。この高いスループットは、より速い応答と改善されたユーザー体験を意味します。

- 計算要件: 多くのモデルが最適なパフォーマンスに32のGPUを必要とするのに対し、Command Aはわずか2つのGPUで効果的に動作します。この大幅なハードウェア要件の削減は、コストを削減するだけでなく、プライベートデプロイメントにとってもアクセスしやすくなっています。

- コンテキスト長: 256kトークンのコンテキスト長を持ち、Command Aは比較的短いコンテキストウィンドウを持つ多くの主要モデルを上回ります。これにより、Command Aは長い文書を管理し理解することができ、企業アプリケーションにとって重要な利点となります。

- 人間の評価: ビジネス、STEM、コーディングを含むタスクに関する対面の人間評価において、Command Aはより大きく遅い競合他社のパフォーマンスに匹敵するか、あるいはそれを超えています。これらの評価は、企業志向の精度、指示の遵守、スタイルに基づいており、Command Aが実世界のビジネス要件を満たすことを保証します。

全体として、Command Aの設計哲学は効率、スケーラビリティ、および高パフォーマンスを強調しており、競争の激しいAIの競争環境において際立つモデルとなっています。

最終的な考え

この包括的なチュートリアルでは、Ollamaを使用してCommand Aをローカルで実行する方法を探り、Command Aとは何か、なぜ作成されたのか、またGPT-4oやDeepSeek-V3のような他の最先端モデルとどのように比較されるのかについて深い洞察を提供しました。

Command Aは、最小限のハードウェア要件で最大のパフォーマンスに最適化された最先端の生成モデルです。高速なトークン生成、より大きなコンテキストウィンドウ、およびコスト効率を提供することで、企業環境で優れています。156トークン/秒の速度でトークンを出力できることが示されており、競合他社に対して優れた性能を発揮し、計算要件が大幅に低いため、Command Aは効率的なAIの未来を代表しています。

また、API価格設定についても詳述し、1百万入力トークンあたり$2.50、1百万出力トークンあたり$10.00であるため、Command Aはプライベートデプロイメントにとって経済的に魅力的な選択肢であることがわかりました。

私たちのステップバイステップのガイドに従うことで、以下のことを学びました:

- Command Aを実行するために必要な環境を設定する。

- Ollamaを本地エンジンとして設定してCommand Aを動かす。

- 競争の激しいAIの環境でCommand Aが際立つ理由となるパフォーマンスの利点と価格構造を理解する。

この知識を持って、さまざまな企業のクエリを実験し、追加の機能を統合し、ローカルAI展開をさらに最適化できます。

🚀 API開発とテストのワークフローを強化しましょう! Apidogを無料でダウンロードし、最高のAPIテストツールで統合プロセスをスリム化してください。