AI駆動アプリケーションの世界では、AnthropicのClaude APIが高度な言語処理機能を求める多くの開発者にとっての主要なソリューションとなっています。しかし、どんな人気サービスでもそうであるように、アプリケーションの機能を一時的に停止させるレート制限に直面することは避けられません。これらの制限を理解し、それに合わせた戦略を実装することは、スムーズなユーザー体験を維持するために重要です。

AIコーディングにおいて、Claudeはカジュアルなユーザーと開発者の両方にとっての強力なアシスタントとして浮上しています。しかし、多くのユーザーが共通のフラストレーションに直面しています:レート制限。

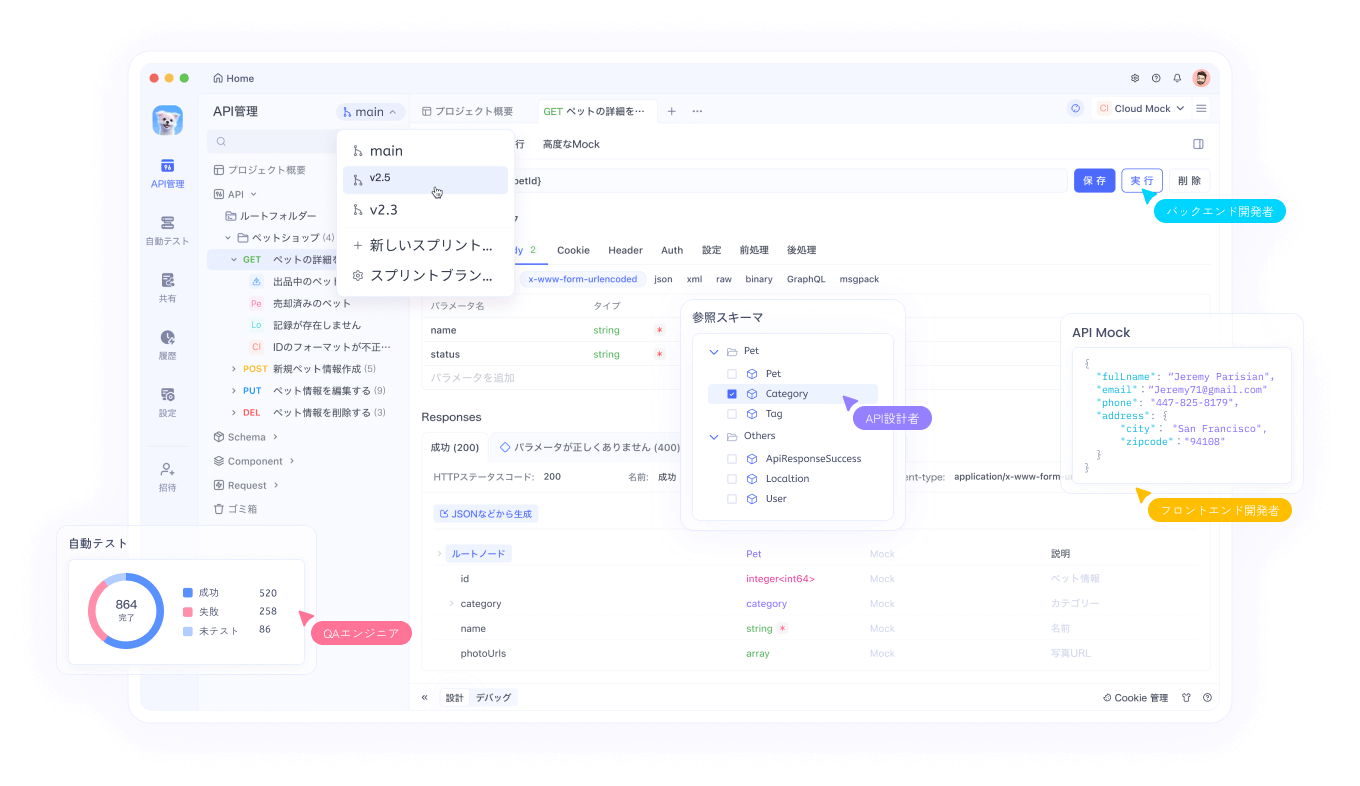

ClaudeのWebインターフェースを使用する場合でも、CursorやClineのようなツールを通じてAPIと統合する場合でも、これらの制限に達するとワークフローや生産性が妨げられる可能性があります。Claudeのようなツールは強力なAI機能を提供しますが、APIインタラクションを効果的に管理するためには、適切なテストおよびデバッグツールが必要です。Apidogは、AIや他のAPIを扱う際のこれらの複雑さを開発者がナビゲートするのを助けます。

この包括的なガイドでは、Claude APIのレート制限が存在する理由、制限に達したときの識別方法、そしてこれらの課題を効果的に克服するための3つの詳細な解決策を提供します。

Claude APIのレート制限とは何であり、なぜ存在するのか?

レート制限は、特定の時間枠内でユーザーが行えるリクエストの量を制御するためにAPIプロバイダーによって課される制限です。Anthropicは、いくつかの重要な理由に基づいてこれらの制限を実施しています:

- サーバーリソース管理:特定のユーザーが計算リソースを過剰に消費するのを防ぐため

- 公正なアクセス:すべてのユーザーにわたるAPIアクセスの公正な分配を確保するため

- 悪用防止:スクレイピングやDDoS攻撃などの悪意のある活動から保護するため

- サービスの安定性:ピーク使用時の全体的なシステムパフォーマンスを維持するため

Claude APIの具体的なレート制限

Claudeのレート制限は、アカウントの種類に応じて異なります:

- 無料ユーザー:1日あたり約100メッセージ、クォータは真夜中にリセット

- プロユーザー:無料ユーザーの制限の約5倍(1日あたり約500メッセージ)

- APIユーザー:特定のプランとAnthropicとの合意に基づくカスタム制限

さらに、ピーク使用時にはこれらの制限がより厳格に適用され、最大割当てに達する前に一時的な制限を経験する可能性があります。

レート制限の問題を特定する

アプリケーションが429 Too Many RequestsのHTTPステータスコードを受け取った場合、レート制限に達した可能性があります。レスポンスには通常、以下の情報を含むヘッダが含まれています:

- リクエストを再開できる時期

- 現在の使用状況の統計

- 残りのクォータ情報

解決策 1: コード内に適切なレート制限を実装する

APIレート制限に対処する最も基本的なアプローチは、クライアント側のレート制限を実装することです。これは、アプリケーションが許可されたリクエスト量を超えるのを防ぎます。

トークンバケットアルゴリズムを使用する

トークンバケットは、次のように機能する人気のあるレート制限アルゴリズムです:

- 一定の速度でトークンが満たされる「バケット」を維持

- 各APIリクエストのためにトークンを消費

- 利用可能なトークンがない場合にリクエストをブロック

以下はPythonでの実装例です:

import time

import threading

class TokenBucket:

def __init__(self, tokens_per_second, max_tokens):

self.tokens_per_second = tokens_per_second

self.max_tokens = max_tokens

self.tokens = max_tokens

self.last_refill = time.time()

self.lock = threading.Lock()

def _refill_tokens(self):

now = time.time()

elapsed = now - self.last_refill

new_tokens = elapsed * self.tokens_per_second

self.tokens = min(self.max_tokens, self.tokens + new_tokens)

self.last_refill = now

def get_token(self):

with self.lock:

self._refill_tokens()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def wait_for_token(self, timeout=None):

start_time = time.time()

while True:

if self.get_token():

return True

if timeout is not None and time.time() - start_time > timeout:

return False

time.sleep(0.1) # ビジーウェイティングを避けるためスリープ

# Claude APIとの例

import anthropic

# レートリミッターを作成(1秒あたり5リクエスト、最大バースト10)

rate_limiter = TokenBucket(tokens_per_second=5, max_tokens=10)

client = anthropic.Anthropic(api_key="your_api_key")

def generate_with_claude(prompt):

# トークンが利用可能になるまで待機

if not rate_limiter.wait_for_token(timeout=30):

raise Exception("レート制限トークンの待機中にタイムアウトしました")

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

print("レート制限に達しました!バックオフします...")

time.sleep(10) # 追加のバックオフ

return generate_with_claude(prompt) # 再試行

raise

この実装では:

- 一定の速度で満たされるトークンバケットを作成

- リクエストを行う前にトークンが利用可能になるのを待つ

- レート制限が発生した場合に追加のバックオフを実装

429レスポンスを指数バックオフで処理する

積極的なレート制限を行っていても、時折制限に達することがあります。指数バックオフを実装することで、アプリケーションが優雅に回復できます:

import time

import random

def call_claude_api_with_backoff(prompt, max_retries=5, base_delay=1):

retries = 0

while retries <= max_retries:

try:

# レートリミッターのトークンを待機

rate_limiter.wait_for_token()

# API呼び出しを行う

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e) and retries < max_retries:

# 指数バックオフとジッターを考慮して遅延を計算

delay = base_delay * (2 ** retries) + random.uniform(0, 0.5)

print(f"レート制限に達しました。{delay:.2f}秒後に再試行します...")

time.sleep(delay)

retries += 1

else:

raise

raise Exception("最大再試行回数を超えました")

この関数では:

- API呼び出しを試みる

- 429エラーが発生した場合、指数的に増加する時間待機する

- リクエストの同期を防ぐためにランダムなジッターを追加する

- 最大再試行回数を超えた場合は諦める

解決策 2: リクエストキューと優先順位の実装

リクエストの重要度が異なるアプリケーションの場合、優先順位処理を伴うリクエストキューを実装することでAPI使用を最適化できます。

優先度キューシステムの構築

import heapq

import threading

import time

from dataclasses import dataclass, field

from typing import Any, Callable, Optional

@dataclass(order=True)

class PrioritizedRequest:

priority: int

execute_time: float = field(compare=False)

callback: Callable = field(compare=False)

args: tuple = field(default_factory=tuple, compare=False)

kwargs: dict = field(default_factory=dict, compare=False)

class ClaudeRequestQueue:

def __init__(self, requests_per_minute=60):

self.queue = []

self.lock = threading.Lock()

self.processing = False

self.requests_per_minute = requests_per_minute

self.interval = 60 / requests_per_minute

def add_request(self, callback, priority=0, delay=0, *args, **kwargs):

"""指定された優先順位でキューにリクエストを追加します。"""

with self.lock:

execute_time = time.time() + delay

request = PrioritizedRequest(

priority=-priority, # 優先度を高くするためにネガティブ

execute_time=execute_time,

callback=callback,

args=args,

kwargs=kwargs

)

heapq.heappush(self.queue, request)

if not self.processing:

self.processing = True

threading.Thread(target=self._process_queue, daemon=True).start()

def _process_queue(self):

"""レート制限を尊重しつつ、キューからのリクエストを処理します。"""

while True:

with self.lock:

if not self.queue:

self.processing = False

return

# 実行準備が整った最高優先度のリクエストを取得

request = self.queue[0]

now = time.time()

if request.execute_time > now:

# リクエストが準備できるまで待つ

wait_time = request.execute_time - now

time.sleep(wait_time)

continue

# キューからリクエストを取り除く

heapq.heappop(self.queue)

# ロックの外でリクエストを実行

try:

request.callback(*request.args, **request.kwargs)

except Exception as e:

print(f"リクエストの実行エラー: {e}")

# レート制限間隔を待つ

time.sleep(self.interval)

# 使用例

queue = ClaudeRequestQueue(requests_per_minute=60)

def process_result(result, callback):

print(f"結果を取得しました: {result[:50]}...")

if callback:

callback(result)

def make_claude_request(prompt, callback=None, priority=0):

def execute():

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

process_result(response.content, callback)

except Exception as e:

if "429" in str(e):

# レート制限された場合は遅延を付加して再キュー

print("レート制限中、再キューします...")

queue.add_request(

make_claude_request,

priority=priority-1, # 再試行のため優先度を下げる

delay=10, # 再試行前に10秒待機

prompt=prompt,

callback=callback,

priority=priority

)

else:

print(f"エラー: {e}")

queue.add_request(execute, priority=priority)

# 異なる優先順位でいくつかのリクエストを作成

make_claude_request("高優先度の質問", priority=10)

make_claude_request("中優先度の質問", priority=5)

make_claude_request("低優先度の質問", priority=1)

この実装では:

- APIリクエストのための優先度キューを作成します

- 優先順位と予定された実行時間に基づいてリクエストを処理します

- レート制限を維持するために自動でリクエストを制御します

- 優先度を下げて再試行を扱います

解決策 3: 複数インスタンスにリクエストを分散する

高トラフィックのアプリケーションにおいて、Claude APIリクエストを複数インスタンスに分散することで、単一アカウントの制限を超えてスケールするのを助けることができます。

複数のAPIキーにわたる負荷分散

import random

import threading

from datetime import datetime, timedelta

class APIKeyManager:

def __init__(self, api_keys, requests_per_day_per_key):

self.api_keys = {}

self.lock = threading.Lock()

# 各APIキーの使用追跡を初期化

for key in api_keys:

self.api_keys[key] = {

'key': key,

'daily_limit': requests_per_day_per_key,

'used_today': 0,

'last_reset': datetime.now().date(),

'available': True

}

def _reset_daily_counters(self):

"""新しい日に日次カウンターをリセットします。"""

today = datetime.now().date()

for key_info in self.api_keys.values():

if key_info['last_reset'] < today:

key_info['used_today'] = 0

key_info['last_reset'] = today

key_info['available'] = True

def get_available_key(self):

"""日次制限に達していない利用可能なAPIキーを取得します。"""

with self.lock:

self._reset_daily_counters()

available_keys = [

key_info for key_info in self.api_keys.values()

if key_info['available'] and key_info['used_today'] < key_info['daily_limit']

]

if not available_keys:

return None

# 今日は最も少ない使用リクエストのキーを選びます

selected_key = min(available_keys, key=lambda k: k['used_today'])

selected_key['used_today'] += 1

# キーが制限に達した場合は、利用不可とマークします

if selected_key['used_today'] >= selected_key['daily_limit']:

selected_key['available'] = False

return selected_key['key']

def mark_key_used(self, api_key):

"""このキーでリクエストが行われたことをマークします。"""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['used_today'] += 1

if self.api_keys[api_key]['used_today'] >= self.api_keys[api_key]['daily_limit']:

self.api_keys[api_key]['available'] = False

def mark_key_rate_limited(self, api_key, retry_after=60):

"""レート制限のため一時的に利用できないキーとしてマークします。"""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = False

# リトライ期間後にキーを再利用可能にするタイマーを開始

def make_available_again():

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = True

timer = threading.Timer(retry_after, make_available_again)

timer.daemon = True

timer.start()

# 使用例

api_keys = [

"key1_abc123",

"key2_def456",

"key3_ghi789"

]

key_manager = APIKeyManager(api_keys, requests_per_day_per_key=100)

def call_claude_api_distributed(prompt):

api_key = key_manager.get_available_key()

if not api_key:

raise Exception("利用可能なAPIキーがありません - すべてのキーが日次制限に達しました")

client = anthropic.Anthropic(api_key=api_key)

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

# 使用後の待機時間ヘッダーを解析、利用可能な場合はそれを使用

retry_after = 60 # デフォルト

key_manager.mark_key_rate_limited(api_key, retry_after)

# 別のキーで再度試みる

return call_claude_api_distributed(prompt)

else:

raise

このアプローチでは:

- 複数のAPIキーを管理し、その使用状況を追跡します

- キーごとのレート制限を超えないようにリクエストを分散します

- レート制限レスポンスを処理し、影響を受けたキーをローテーションから一時的に取り除きます

- 使用カウンターを毎日自動でリセットします

Claude APIのレート制限を管理するためのベストプラクティス

上記の3つの解決策を超えて、以下の追加のベストプラクティスがあります:

積極的に使用状況をモニタリング

- API使用状況を追跡するためのダッシュボードを実装

- レート制限に近づいたときのアラートを設定

- 使用パターンを定期的にレビューし、最適化の機会を特定

優雅な劣化を実装

- レート制限に達した場合に代替の応答を提供するようアプリケーションを設計

- 似たクエリの前の応答をキャッシュすることを検討

- レート制限を経験している際にユーザーに透明なフィードバックを提供

プロンプトの最適化

- より効果的なプロンプトを作成することで不必要なAPI呼び出しを減らす

- 関連するクエリを可能な限り単一のリクエストにまとめる

- 明確化リクエストの必要を排除するために入力を前処理する

Anthropicとのコミュニケーション

- プロダクションアプリケーションの場合は、上位プランへのアップグレードを検討

- 特定のユースケースについてAnthropicにカスタムレート制限を問い合わせる

- プラットフォームの更新やレート制限ポリシーの変更について最新情報を把握

結論

レート制限は、Claudeのような強力なAPIを扱う上で避けられない部分です。この記事で概説された解決策—適切なレート制限コード、リクエストキューイング、分散リクエスト処理を実装することで、これらの制限を優雅に扱う堅牢なアプリケーションを構築できます。

レート制限はすべてのユーザーに対して公正なアクセスとシステムの安定性を確保するために存在します。これらの制約の範囲内で作業することは、アプリケーションの信頼性を向上させるだけでなく、エコシステム全体の健康にも貢献します。

これらの戦略を慎重に計画し実装することで、ユーザーにとってスムーズな体験を維持しながら、Claudeの強力なAI機能の使用を最大化できます。