Stellen Sie sich vor, Sie hätten einen Supercomputer in Ihrer Tasche, der in der Lage ist, menschenähnlichen Text zu jedem Thema zu verstehen und zu generieren. Klingt nach Science-Fiction, oder? Nun, dank der jüngsten Durchbrüche in der künstlichen Intelligenz ist dieser Traum jetzt Realität – und er heißt Ollama.

Ollama ist wie ein Schweizer Taschenmesser für Local LLMs. Es ist ein Open-Source-Tool, mit dem Sie leistungsstarke Sprachmodelle direkt auf Ihrem eigenen Computer ausführen können. Keine Notwendigkeit für ausgefallene Cloud-Dienste oder einen Abschluss in Informatik. Aber hier wird es wirklich spannend: Ollama hat eine versteckte Superkraft namens API. Stellen Sie es sich als eine geheime Sprache vor, mit der Ihre Programme direkt mit diesen KI-Gehirnen sprechen können.

Nun, ich weiß, was Sie denken. "APIs? Das klingt kompliziert!"

Keine Sorge – hier kommt Apidog ins Spiel. Es ist wie ein freundlicher Übersetzer, der Ihnen hilft, mit der API von Ollama zu kommunizieren, ohne ins Schwitzen zu kommen. In diesem Artikel werden wir uns gemeinsam auf eine Reise begeben. Ich werde Ihr Führer sein, während wir erkunden, wie Sie das volle Potenzial von Ollama mit Apidog entfesseln können. Am Ende werden Sie KI-gestützte Anwendungen wie ein Profi erstellen, alles bequem von Ihrem eigenen Rechner aus. Also schnallen Sie sich an – es ist Zeit, in die faszinierende Welt der lokalen KI einzutauchen und zu entdecken, wie einfach es sein kann!

Was ist Ollama und wie man Ollama verwendet, um LLMs lokal auszuführen?

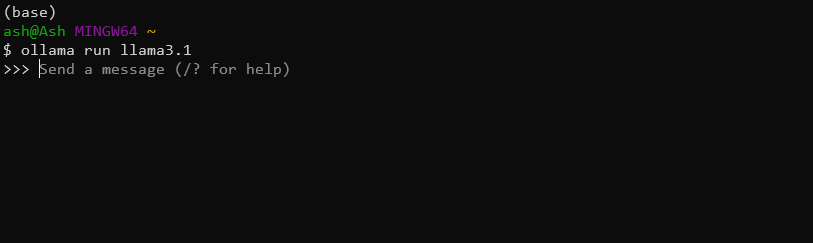

Ollama ist ein praktisches Tool, mit dem Benutzer große Sprachmodelle auf ihren lokalen Rechnern ausführen können. Es vereinfacht den Prozess des Herunterladens, Ausführens und Feinabstimmens verschiedener LLMs und macht erweiterte KI-Funktionen einem breiteren Publikum zugänglich. Zum Beispiel können Sie einfach das neueste Llama 3.1 8B-Modell mit diesem Befehl herunterladen und installieren:

ollama run llama3.1

Hat Ollama eine API?

Ja, Sie können die Ollama-API verwenden, um diese leistungsstarken Local LLMs nahtlos in ihre Anwendungen zu integrieren.

Zu den wichtigsten Funktionen der Ollama-API gehören:

- Modellverwaltung (Abrufen, Auflisten und Löschen von Modellen)

- Texterstellung (Vervollständigungen und Chat-Interaktionen)

- Generierung von Einbettungen

- Feinabstimmungsfunktionen

Mit der Ollama-API können Sie die Leistung von LLMs in ihren Anwendungen einfach nutzen, ohne komplexe Infrastruktur oder Cloud-Abhängigkeiten.

Verwendung von Apidog zum Testen von Ollama-APIs

Apidog ist eine vielseitige API-Entwicklungs- und Dokumentationsplattform, die darauf ausgelegt ist, den gesamten API-Lebenszyklus zu optimieren. Es bietet eine benutzerfreundliche Oberfläche zum Entwerfen, Testen und Dokumentieren von APIs und ist damit ein ideales Werkzeug für die Arbeit mit der Ollama-API.

Einige der herausragenden Funktionen von APIDog sind:

- Intuitive API-Design-Oberfläche

- Automatische Dokumentationserstellung

- API-Test- und Debugging-Tools

- Zusammenarbeitsfunktionen für Teamprojekte

- Unterstützung für verschiedene API-Protokolle und -Formate

Mit Apidog können Entwickler auf einfache Weise API-Dokumentationen erstellen, verwalten und freigeben und so sicherstellen, dass ihre Ollama-API-Integrationen gut dokumentiert und wartbar sind.

Voraussetzungen

Bevor Sie sich mit dem Tätigen von Ollama-API-Aufrufen mit Apidog befassen, stellen Sie sicher, dass Sie die folgenden Voraussetzungen erfüllt haben:

Ollama-Installation: Laden Sie Ollama herunter und installieren Sie es auf Ihrem lokalen Rechner. Befolgen Sie die offizielle Ollama-Dokumentation für Installationsanweisungen, die für Ihr Betriebssystem spezifisch sind.

APIDog-Konto: Melden Sie sich für ein Apidog-Konto an, falls Sie dies noch nicht getan haben. Sie können entweder die webbasierte Version verwenden oder die Desktop-Anwendung herunterladen, je nach Ihren Präferenzen.

Ollama-Modell: Rufen Sie ein Modell über die Befehlszeilenschnittstelle von Ollama ab. Um beispielsweise das Modell "llama2" herunterzuladen, würden Sie Folgendes ausführen:

ollama pull llama3.1

API-Testtool: Während Apidog über integrierte Testfunktionen verfügt, möchten Sie möglicherweise auch ein Tool wie cURL oder Postman zur Hand haben, um zusätzliche Tests und Überprüfungen durchzuführen.

Mit diesen Elementen können Sie die Ollama-API mit Apidog erkunden.

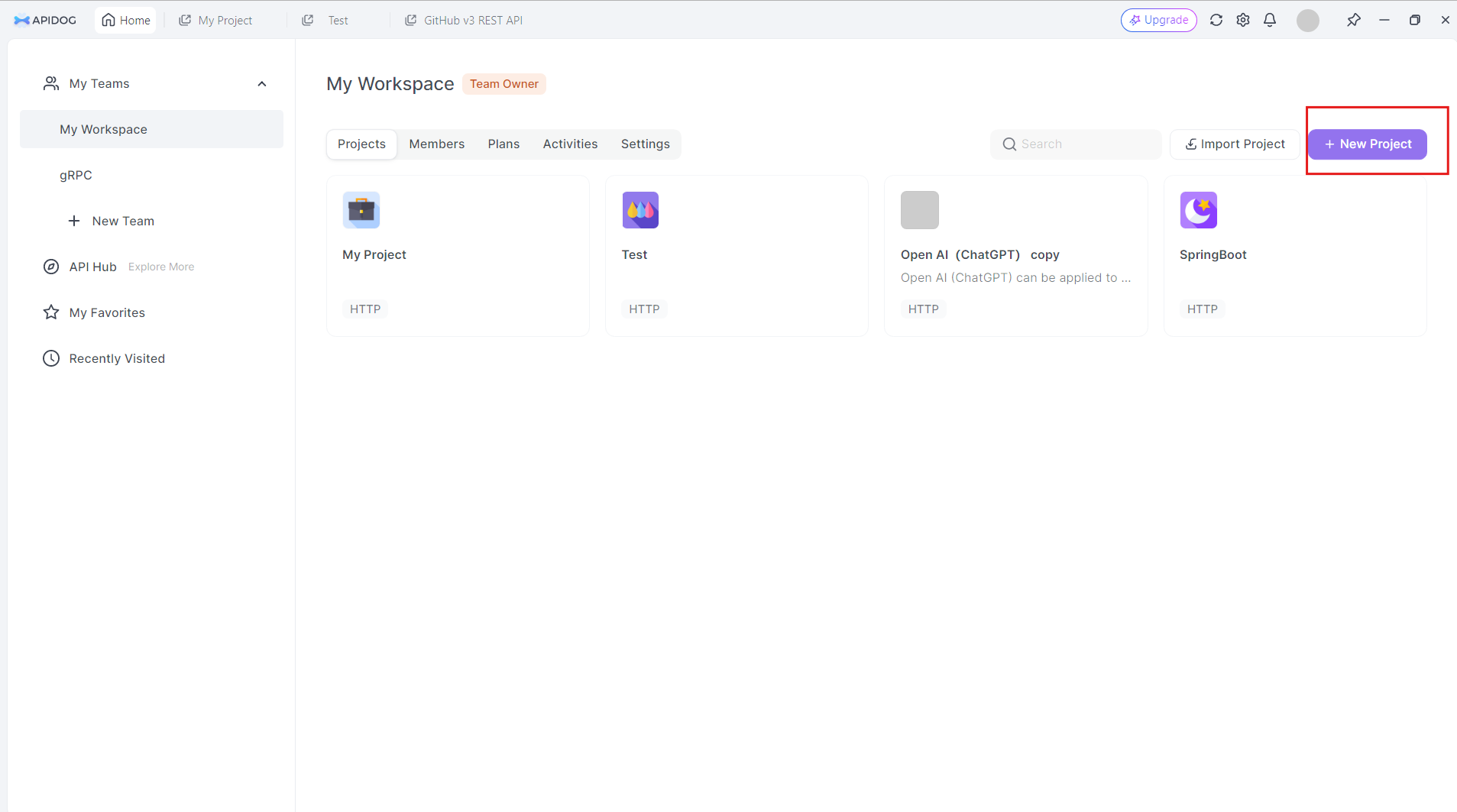

Erstellen eines Ollama-API-Projekts in Apidog

Um mit der Ollama-API in Apidog zu arbeiten, gehen Sie wie folgt vor:

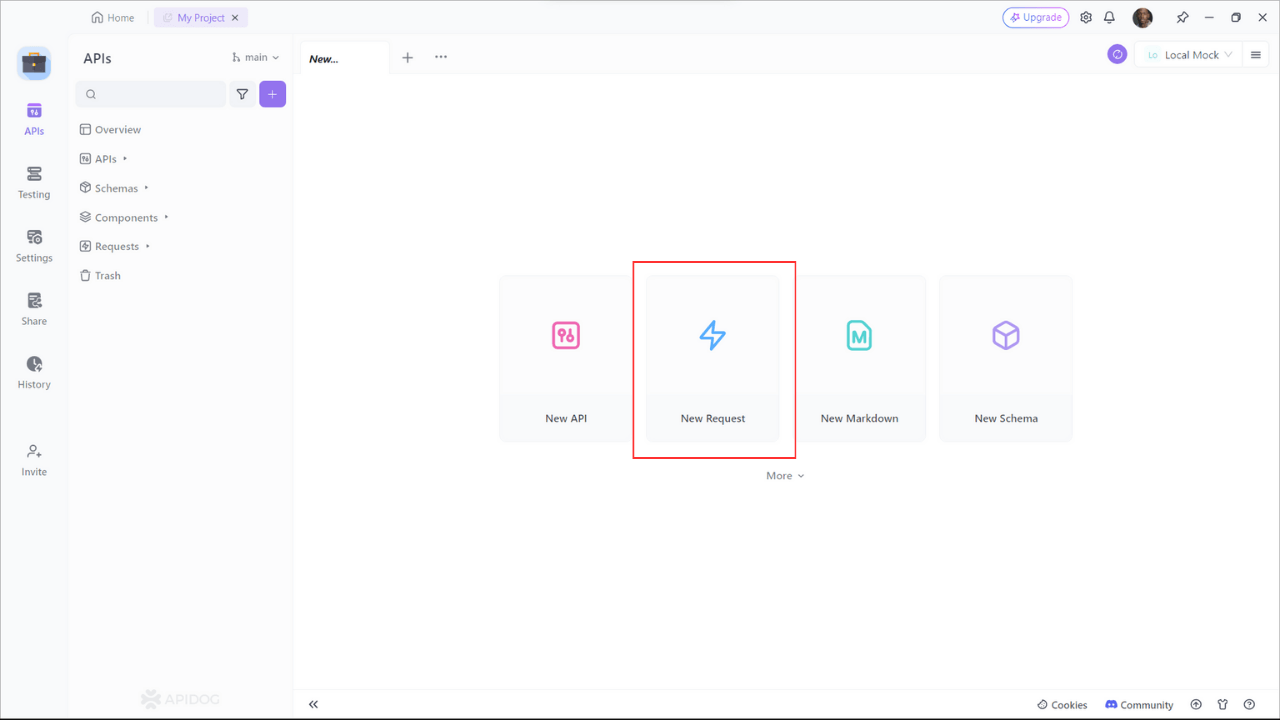

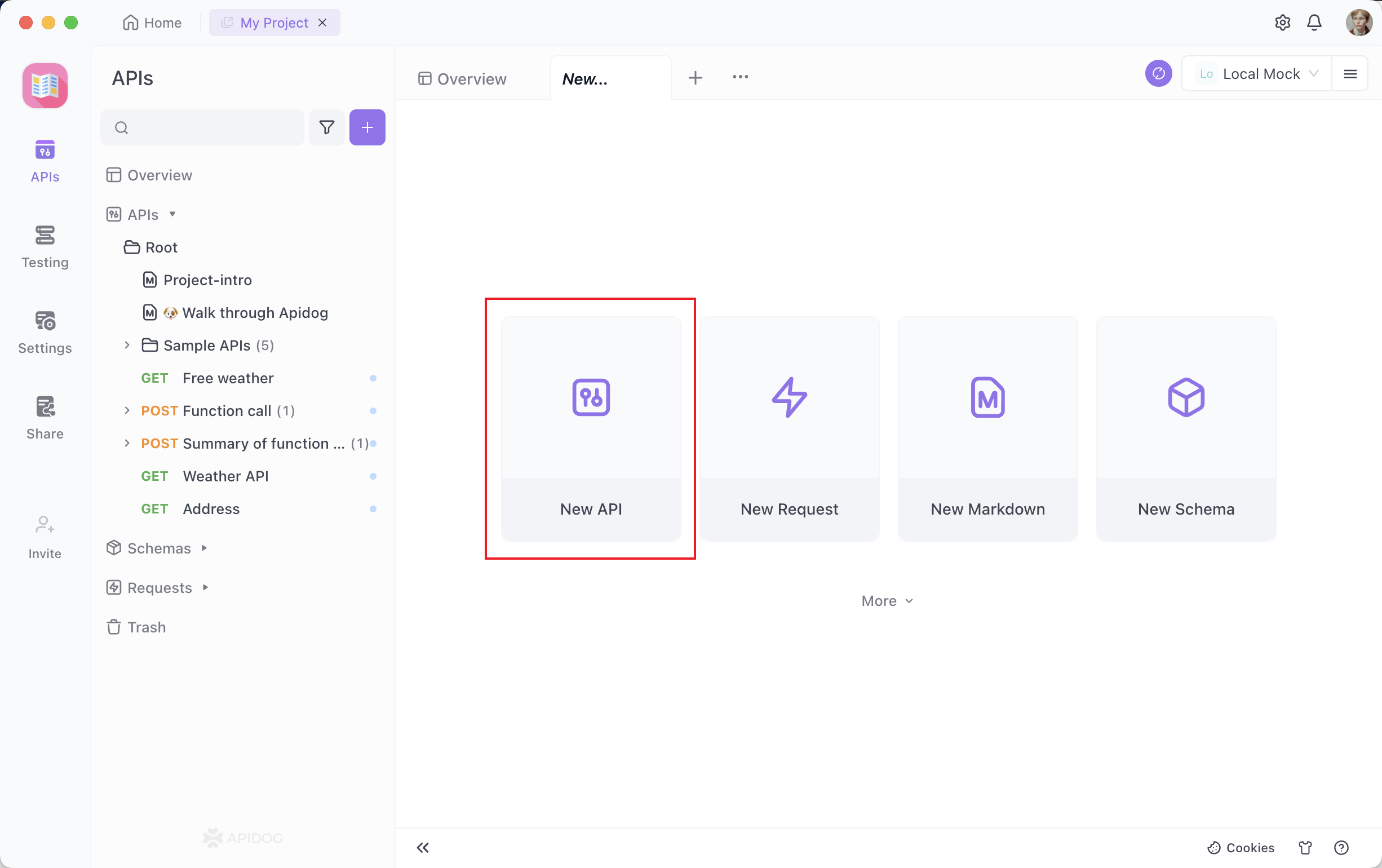

Erstellen Sie ein neues Projekt: Melden Sie sich bei Apidog an und erstellen Sie ein neues Projekt speziell für Ihre Ollama-API-Arbeit. Klicken Sie auf die Schaltfläche "Neues Projekt" in der oberen rechten Ecke

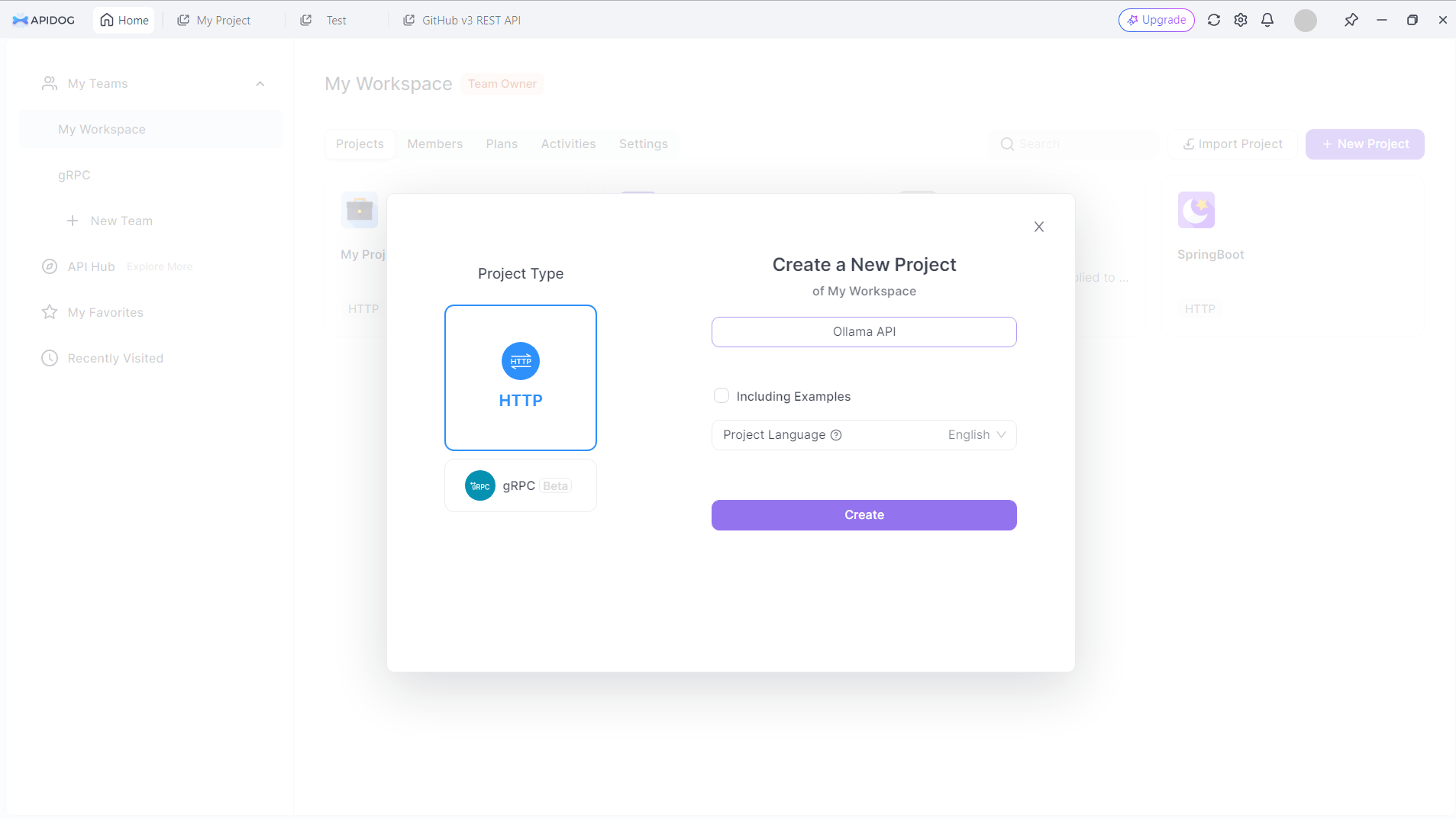

Geben Sie Ihrem neuen Projekt einen Namen. Sagen wir: Ollama API:

Klicken Sie auf die Schaltfläche "Erstellen", um fortzufahren.

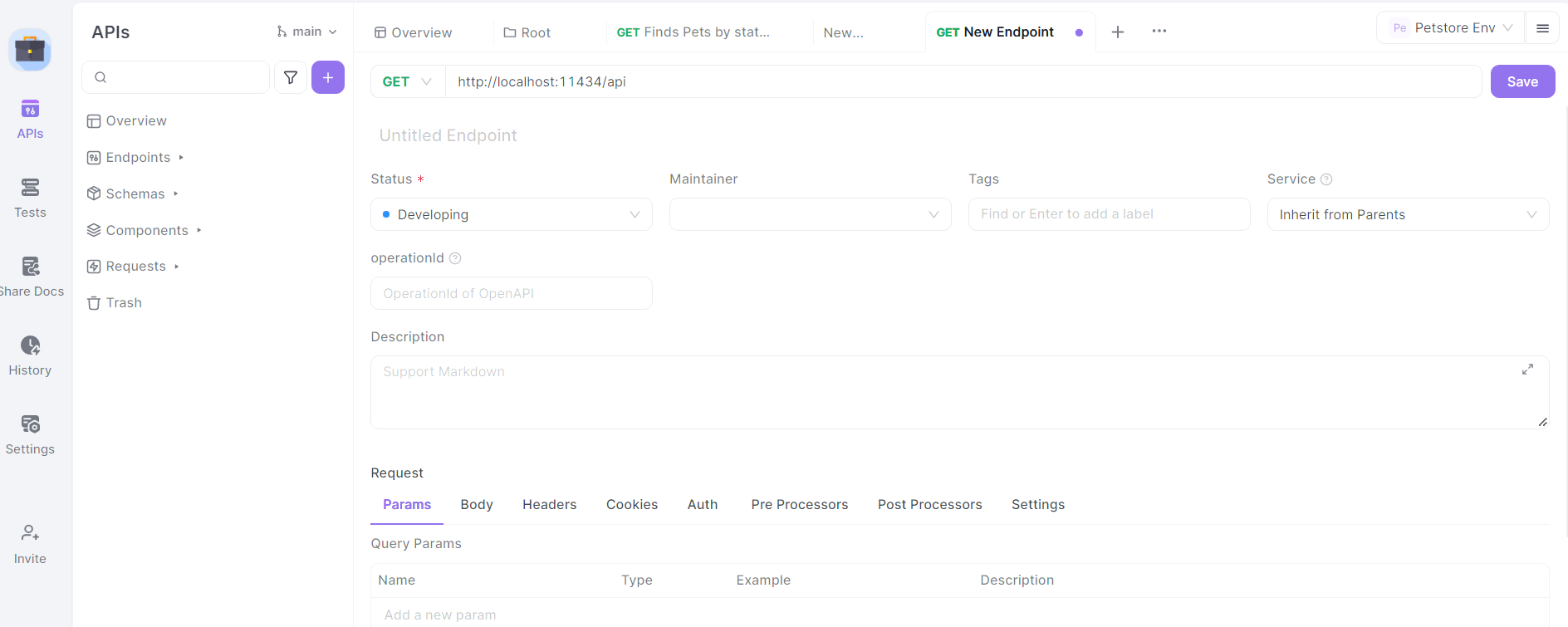

Richten Sie die Basis-URL ein: Legen Sie in Ihren Projekteinstellungen die Basis-URL auf http://localhost:11434/api fest. Dies ist die Standardadresse, unter der Ollama seine API-Endpunkte verfügbar macht.

Importieren Sie die Ollama-API-Spezifikation: Obwohl Ollama keine offizielle OpenAPI-Spezifikation bereitstellt, können Sie in APIDog manuell eine grundlegende Struktur für die API-Endpunkte erstellen.

Definieren Sie Endpunkte: Beginnen Sie mit der Definition der wichtigsten Ollama-API-Endpunkte in APIDog. Einige wichtige Endpunkte, die enthalten sein sollten, sind:

/generate(POST): Für die Texterstellung/chat(POST): Für chatbasierte Interaktionen/embeddings(POST): Für die Generierung von Einbettungen/pull(POST): Für das Abrufen neuer Modelle/list(GET): Zum Auflisten verfügbarer Modelle

Geben Sie für jeden Endpunkt die HTTP-Methode, die Anforderungsparameter und das erwartete Antwortformat basierend auf der Ollama-API-Dokumentation an.

Entwerfen von Ollama-API-Aufrufen in Apidog

Gehen wir den Prozess des Entwurfs von API-Aufrufen für einige der am häufigsten verwendeten Ollama-Endpunkte mit Apidog durch:

Texterstellungs-Endpunkt (/generate)

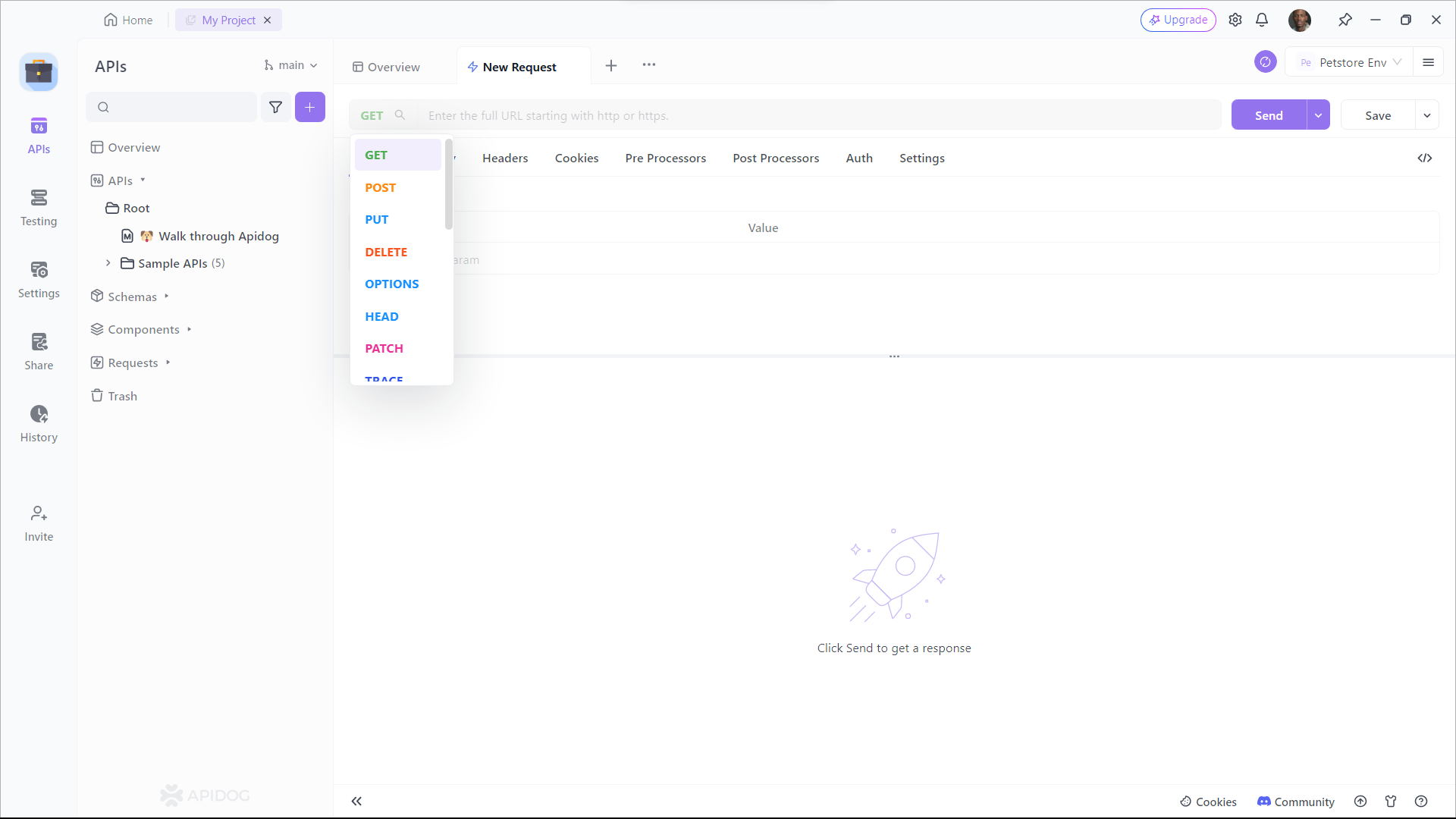

Erstellen Sie in Apidog einen neuen API-Endpunkt mit dem Pfad /generate und legen Sie die HTTP-Methode auf POST fest.

Definieren Sie das Anforderungsschema:

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Geben Sie eine Beschreibung für jeden Parameter an und erläutern Sie dessen Zweck und etwaige Einschränkungen.

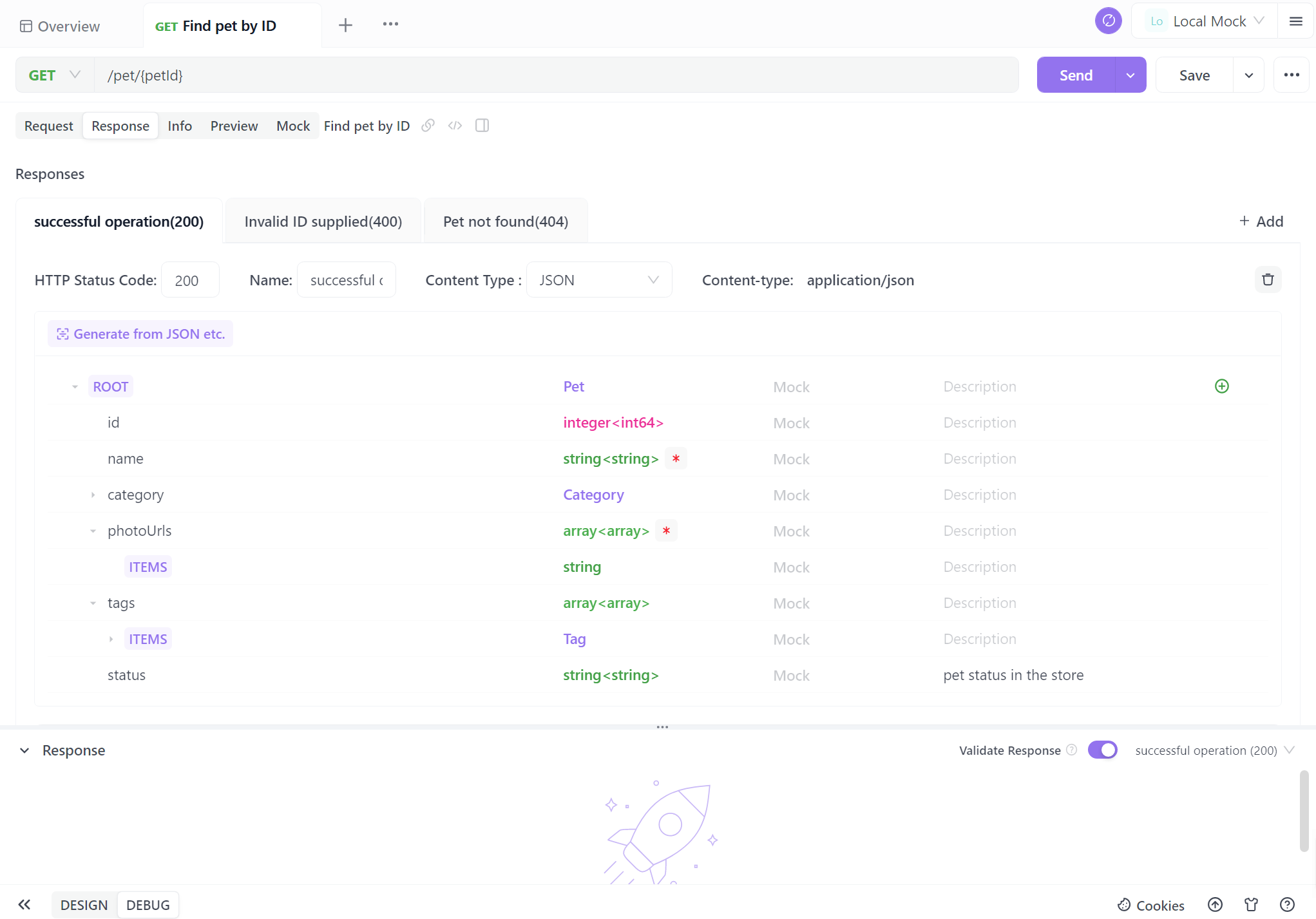

Definieren Sie das Antwortschema basierend auf der Ollama-API-Dokumentation, einschließlich Felder wie response, context und total_duration.

Chat-Endpunkt (/chat)

Erstellen Sie einen neuen Endpunkt mit dem Pfad /chat und legen Sie die HTTP-Methode auf POST fest.

Definieren Sie das Anforderungsschema:

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Geben Sie detaillierte Beschreibungen für das messages-Array an und erläutern Sie die Struktur von Chat-Nachrichten mit Rollen (System, Benutzer, Assistent) und Inhalten.

Definieren Sie das Antwortschema, einschließlich des message-Objekts mit den Feldern role und content.

Modellverwaltungs-Endpunkte

Erstellen Sie Endpunkte für Modellverwaltungsoperationen:

- Modell abrufen (

/pull): POST-Anfrage mit dem Parameternamefür das herunterzuladende Modell. - Modelle auflisten (

/list): GET-Anfrage zum Abrufen verfügbarer Modelle. - Modell löschen (

/delete): DELETE-Anfrage mit dem Parameternamefür das zu entfernende Modell.

Definieren Sie für jeden dieser Endpunkte geeignete Anforderungs- und Antwortschemata basierend auf der Ollama-API-Dokumentation.

Testen von Ollama-API-Aufrufen in Apidog

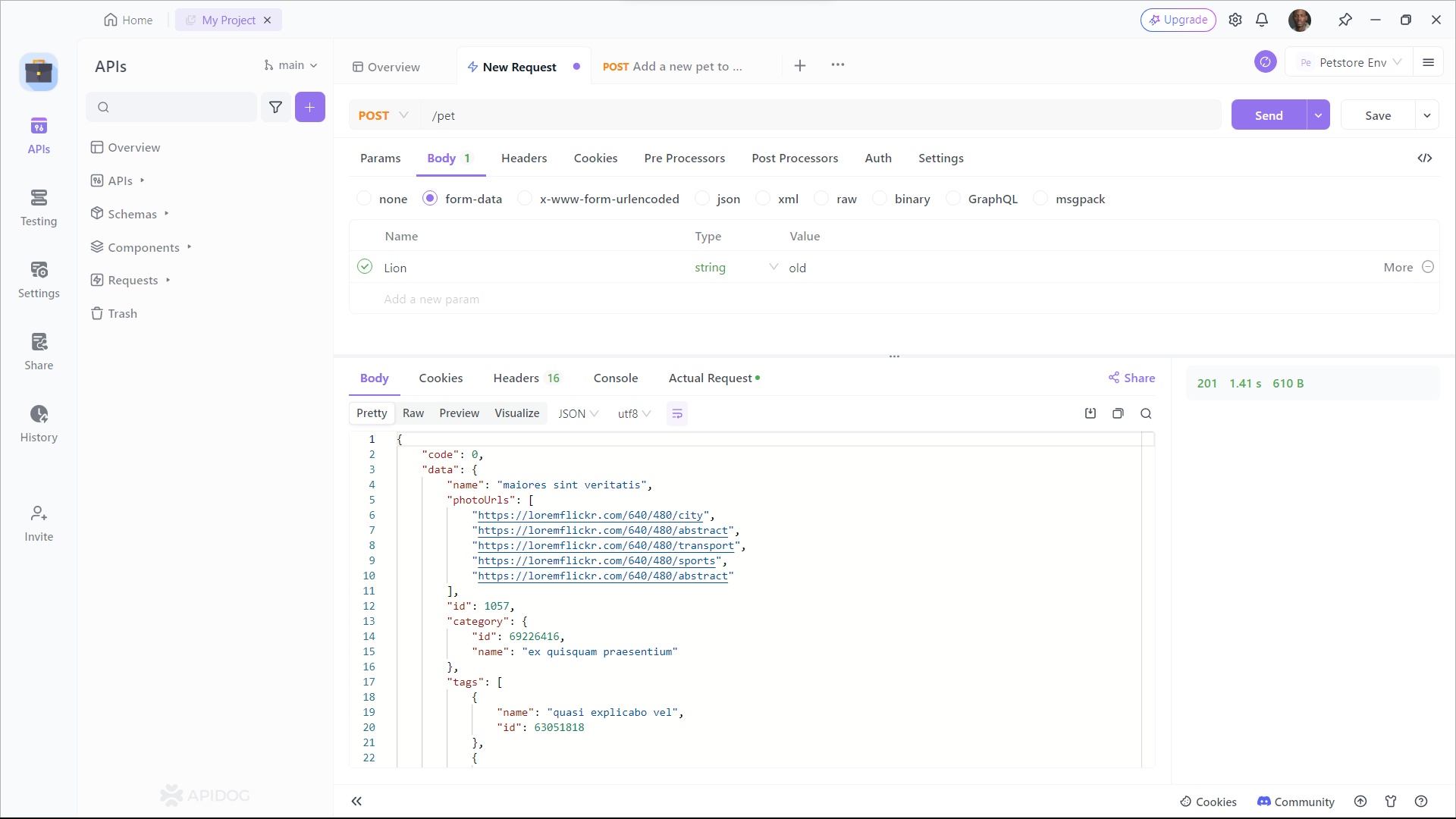

Apidog bietet eine integrierte Testumgebung, mit der Sie Anfragen an Ihre Ollama-API senden und die Antworten überprüfen können. So verwenden Sie es:

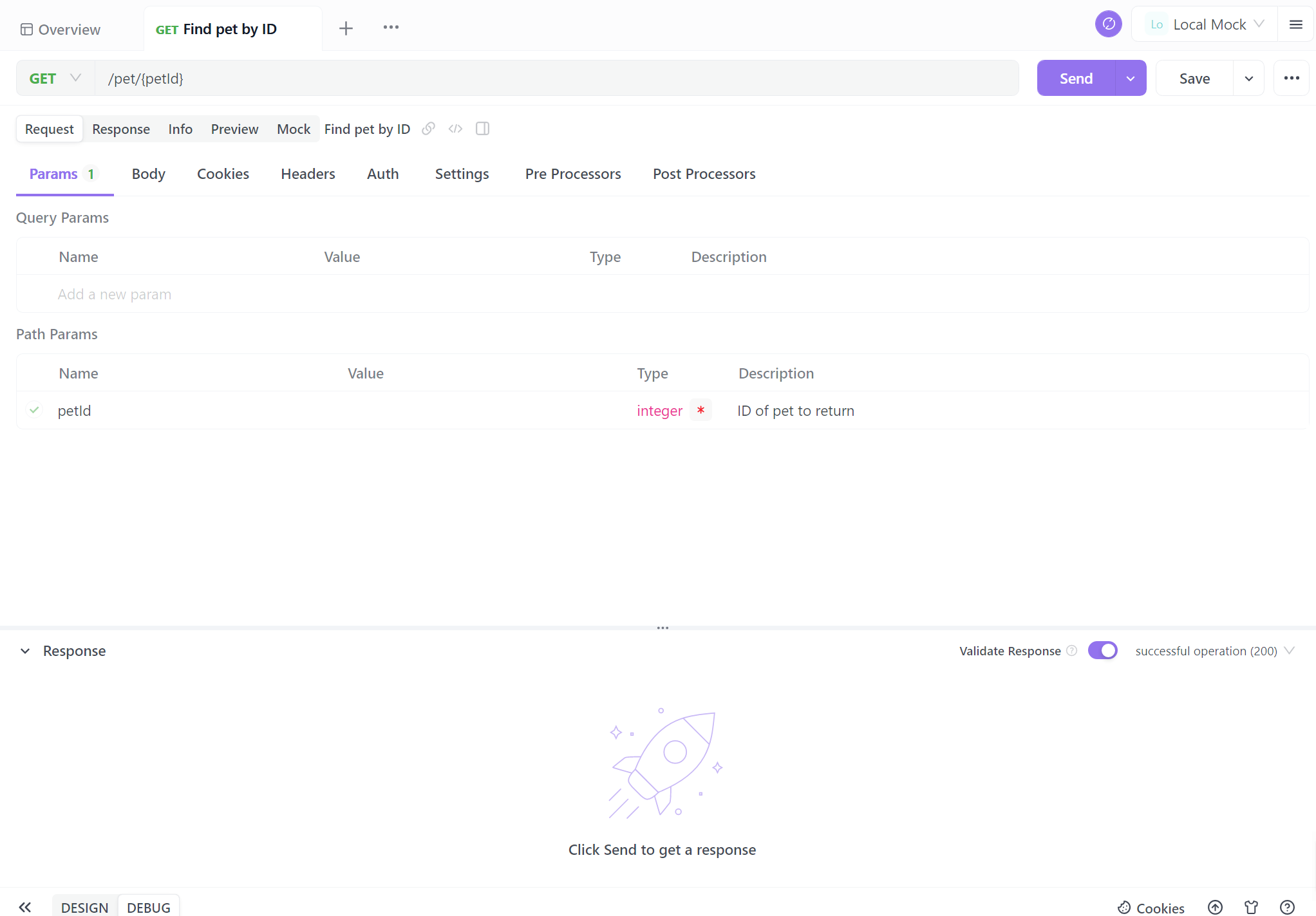

Wählen Sie einen Endpunkt aus: Wählen Sie einen der Ollama-API-Endpunkte aus, die Sie in Apidog definiert haben.

Konfigurieren Sie die Anforderungsparameter: Füllen Sie die erforderlichen Parameter für den ausgewählten Endpunkt aus. Für den Endpunkt /generate können Sie beispielsweise Folgendes festlegen:

{

"model": "llama2",

"prompt": "Erklären Sie das Konzept der künstlichen Intelligenz in einfachen Worten."

}

Senden Sie die Anfrage: Verwenden Sie die Schaltfläche "Senden" von Apidog, um den API-Aufruf an Ihre lokale Ollama-Instanz auszuführen.

Untersuchen Sie die Antwort von Ollama und überprüfen Sie, ob sie dem erwarteten Format entspricht und den generierten Text oder andere relevante Informationen enthält. Wenn Probleme auftreten, verwenden Sie die Debugging-Tools von Apidog, um die Anforderungs- und Antwortheader, den Textkörper und alle Fehlermeldungen zu untersuchen.

Generieren von API-Dokumentation

Eine der leistungsstärksten Funktionen von Apidog ist die Fähigkeit, automatisch eine umfassende API-Dokumentation zu erstellen. So erstellen Sie eine Dokumentation für Ihr Ollama-API-Projekt:

Schritt 1: Melden Sie sich bei Apidog an

Um Apidog für die Generierung von API-Dokumentationen zu verwenden, müssen Sie sich für ein Konto anmelden, falls Sie dies noch nicht getan haben. Sobald Sie sich angemeldet haben, werden Sie von der benutzerfreundlichen Oberfläche von Apidog begrüßt.

Schritt 2: Erstellen Ihrer API-Anfrage

Ein API-Dokumentationsprojekt besteht aus verschiedenen Endpunkten, die jeweils eine bestimmte API-Route oder -Funktionalität darstellen. Um einen Endpunkt hinzuzufügen, klicken Sie in Ihrem Projekt auf die Schaltfläche "+" oder "Neue API".

Schritt 3: Richten Sie die Anforderungsparameter ein

Sie müssen Details wie die URL des Endpunkts, die Beschreibung und die Anforderungs-/Antwortdetails angeben. Jetzt kommt der kritische Teil – die Dokumentation Ihrer Endpunkte. Apidog macht diesen Prozess unglaublich einfach. Für jeden Endpunkt können Sie:

- Geben Sie die HTTP-Methode an (GET, POST, PUT, DELETE usw.).

- Definieren Sie Anforderungsparameter, einschließlich ihrer Namen, Typen und Beschreibungen.

- Beschreiben Sie die erwartete Antwort, einschließlich Statuscodes, Antwortformate (JSON, XML usw.) und Beispielantworten.

Viele Entwickler sind nicht begeistert davon, API-Dokumentationen zu schreiben, und empfinden dies oft als komplex. In Wirklichkeit können Sie es mit Apidog jedoch mit nur wenigen Mausklicks erledigen. Die visuelle Oberfläche von Apidog ist anfängerfreundlich und macht es viel einfacher, API-Dokumentationen aus Code zu generieren.

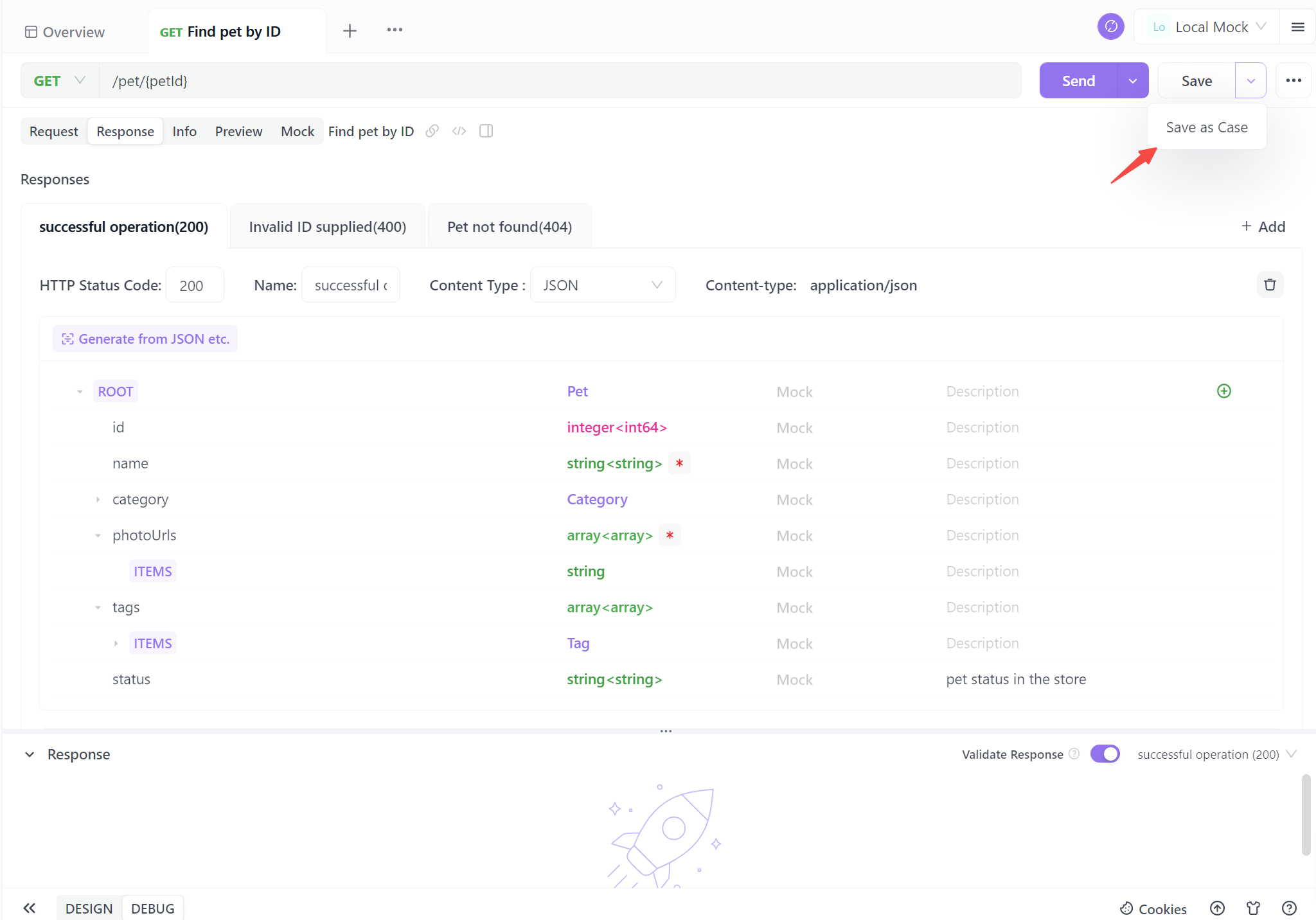

Schritt 4. Generieren Sie Ihre API

Wenn Sie die grundlegenden API-Informationen ausfüllen, können Sie mit nur einem Klick als Fall speichern. Sie können es auch direkt speichern, aber es wird empfohlen, es als Testfall zu speichern, um es in Zukunft leichter nachschlagen zu können.

Wenn Sie diese vier Schritte befolgen, können Sie mühelos standardisierte API-Dokumentationen erstellen. Dieser optimierte Prozess sorgt nicht nur für Klarheit und Konsistenz, sondern spart auch wertvolle Zeit. Mit der automatisierten Dokumentation sind Sie bestens gerüstet, um die Zusammenarbeit zu verbessern, die Benutzerinteraktion zu vereinfachen und Ihre Projekte mit Zuversicht voranzutreiben.

Best Practices für die Ollama-API-Integration

Beachten Sie bei der Arbeit mit der Ollama-API über APIDog diese Best Practices:

- Versionskontrolle: Verwenden Sie die Versionskontrollfunktionen von APIDog, um Änderungen an Ihren API-Definitionen im Laufe der Zeit zu verfolgen.

- Fehlerbehandlung: Dokumentieren Sie häufige Fehlerantworten und fügen Sie Beispiele dafür ein, wie Sie diese in Ihrer API-Dokumentation behandeln können.

- Ratenbegrenzung: Beachten Sie alle von Ollama implementierten Ratenbegrenzungen, insbesondere wenn Sie auf ressourcenbeschränkten Systemen arbeiten, und dokumentieren Sie diese Einschränkungen.

- Sicherheitsaspekte: Obwohl Ollama normalerweise lokal ausgeführt wird, sollten Sie eine Authentifizierung implementieren, wenn Sie die API über ein Netzwerk verfügbar machen.

- Leistungsoptimierung: Dokumentieren Sie Best Practices zur Optimierung von Anfragen, z. B. die Wiederverwendung von Kontext für verwandte Abfragen, um die Reaktionszeiten zu verbessern.

Fazit

Die Integration der Ollama-API in Ihre Projekte eröffnet eine Welt voller Möglichkeiten, um leistungsstarke Sprachmodelle in Ihren Anwendungen zu nutzen. Durch die Verwendung von APIDog zum Entwerfen, Testen und Dokumentieren Ihrer Ollama-API-Aufrufe erstellen Sie eine robuste und wartbare Integration, die sich mit den Anforderungen Ihres Projekts weiterentwickeln kann.

Die Kombination aus den lokalen LLM-Funktionen von Ollama und den umfassenden API-Verwaltungsfunktionen von APIDog bietet Entwicklern ein leistungsstarkes Toolkit für den Aufbau KI-gestützter Anwendungen. Denken Sie bei der weiteren Erforschung des Potenzials von Ollama und der Verfeinerung Ihrer API-Integrationen daran, dass eine klare Dokumentation und gründliche Tests der Schlüssel zu einer erfolgreichen Implementierung sind.

Wenn Sie die in diesem Artikel beschriebenen Schritte und Best Practices befolgen, sind Sie bestens gerüstet, um das volle Potenzial der Ollama-API zu nutzen und anspruchsvolle KI-gestützte Anwendungen mit Zuversicht und Leichtigkeit zu erstellen. Die Reise der KI-Integration ist aufregend, und mit Tools wie Ollama und APIDog zu Ihrer Verfügung sind die Möglichkeiten wirklich grenzenlos.