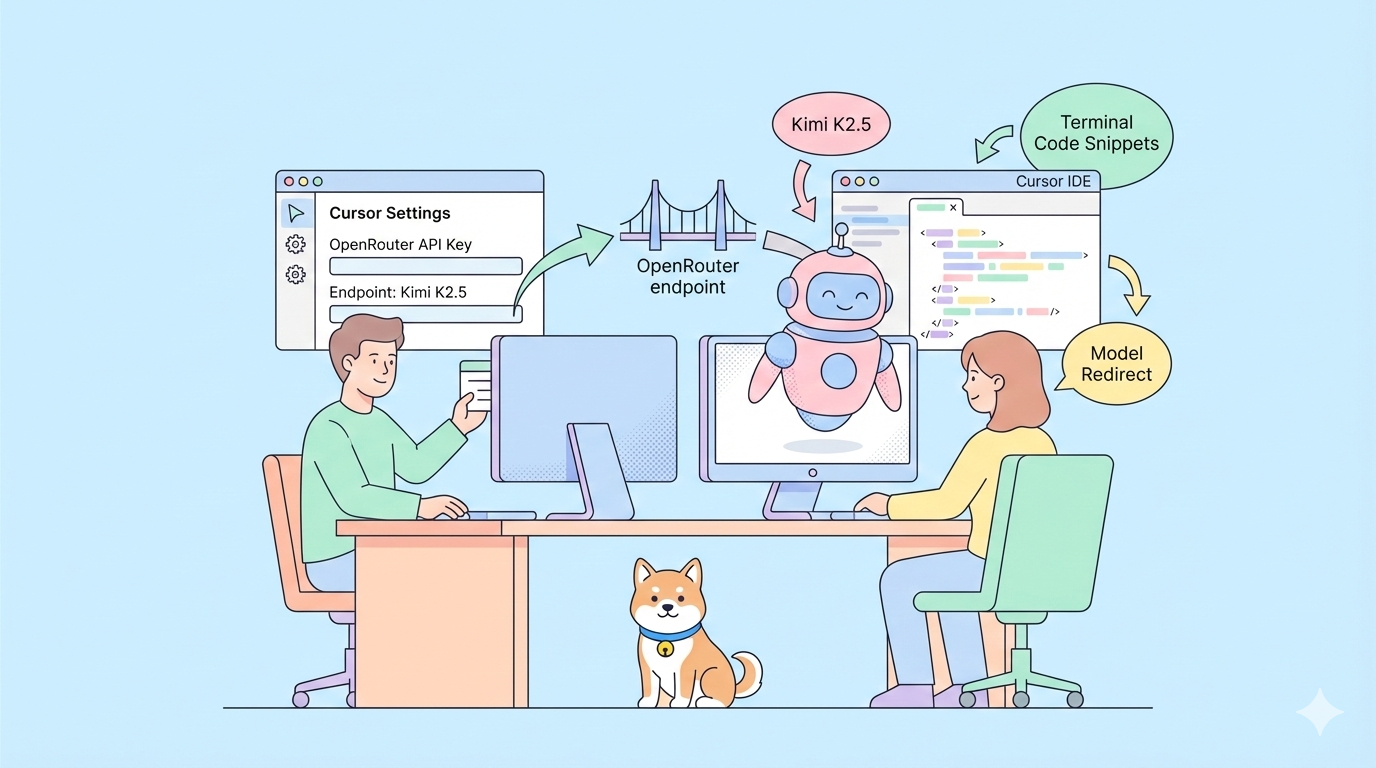

Wollten Sie schon immer eines der fortschrittlichsten Open-Source-KI-Modelle in Ihrer bevorzugten Code-IDE verwenden, aber es fehlte in der Dropdown-Liste? Mit Kimi K2.5, einem leistungsstarken multimodalen, Agent-fähigen Modell von Moonshot AI, können Sie es jetzt in Cursor integrieren, auch wenn es nicht nativ unterstützt wird. Anstatt auf offizielle Unterstützung zu warten, zeigt Ihnen dieser Leitfaden genau, wie Sie Kimi K2.5 mit Cursor verbinden, sodass Sie es direkt aus Ihrem Editor für Codierung, Reasoning und Tool-gesteuerte Workflows verwenden können.

Warum Kimi K2.5 zu Cursor hinzufügen?

Cursor ist eine beliebte KI-gestützte Entwicklungsumgebung, mit der Sie direkt in Ihrem Editor mit KI-Modellen interagieren können. Allerdings sind nicht alle Modelle im integrierten Modellselektor verfügbar, insbesondere neu veröffentlichte oder aufstrebende offene Modelle wie Kimi K2.5. Wenn Sie die leistungsstarken Codierungs- und Reasoning-Fähigkeiten von K2.5 nutzen möchten, es aber nicht in der Cursor-Dropdown-Liste sehen, sind Sie nicht allein. Glücklicherweise gibt es eine praktische Umgehung, die das Hinzufügen von Kimi K2.5 als benutzerdefiniertes Modell unter Verwendung von Anbieter-Endpunkten wie OpenRouter oder direktem Moonshot API-Zugang beinhaltet.

Dies ist wichtig, da Entwickler zunehmend Flexibilität wünschen – die Möglichkeit zu wählen, welches Modell ihre KI-Workflows antreibt, anstatt an das gebunden zu sein, was die IDE mitbringt. In diesem Leitfaden werden wir genau durchgehen, wie diese Verbindung mithilfe der Cursor-Konfigurationseinstellungen, der Unterstützung für benutzerdefinierte Modelle und API-Schlüssel funktioniert.

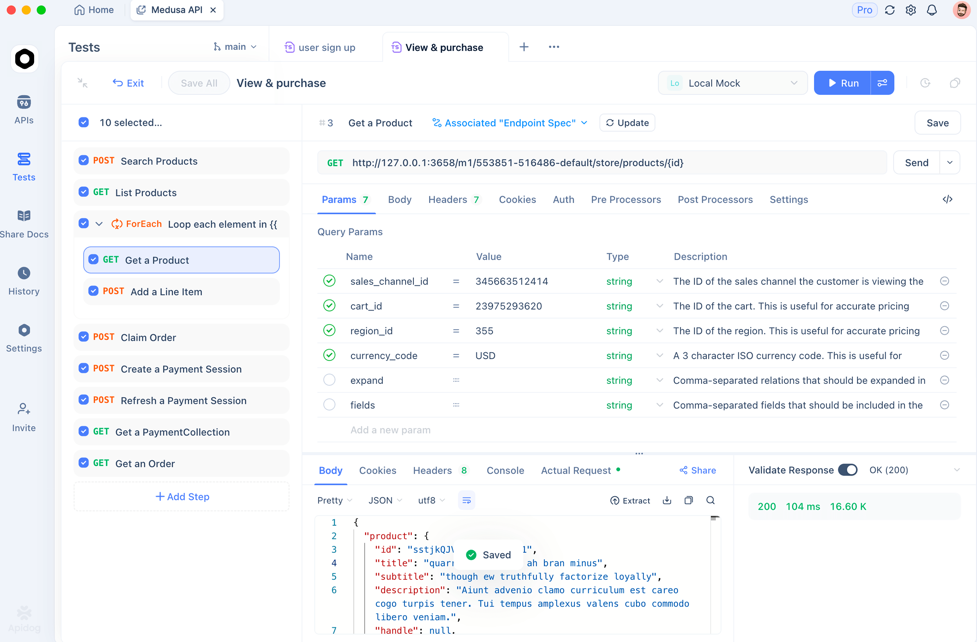

💡Profi-Tipp: Testen Sie Ihre API-Endpunkte in Apidog, bevor Sie sie in Cursor konfigurieren. Dies verhindert Authentifizierungsfehler und stellt sicher, dass Ihre benutzerdefinierte Modellintegration von Anfang an funktioniert.

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!

Kimi K2.5s Fähigkeiten verstehen

Bevor wir integrieren, hier ist, was Kimi K2.5 für Cursor-Workflows wertvoll macht:

- Multimodale Fähigkeit: Verarbeitet nativ Text, Code und visuelle Daten

- Agentic Design: Entwickelt für Reasoning, Tool-Aufrufe und mehrstufige Workflows

- Offener API-Zugang: Verfügbar über die API-Endpunkte von Moonshot und Drittanbieter wie OpenRouter

- Großes Kontextfenster: Bis zu 256K Token für komplexes Projektverständnis

- Kosteneffizienz: Günstiger als westliche Alternativen bei gleicher Leistung

Obwohl Kimi K2.5 noch nicht nativ in Cursor unterstützt wird, bedeutet seine OpenAI-kompatible API, dass Sie es manuell verbinden und fast so verwenden können, als wäre es nativ.

Wählen Sie Ihren Kimi K2.5 API-Anbieter

✅ Option A (via OpenRouter)

OpenRouter fungiert als universelles API-Gateway, das Ihnen über eine einzige Schnittstelle Zugang zu mehreren KI-Modellen bietet:

- Registrieren Sie sich bei OpenRouter.ai

- Fügen Sie Guthaben für die API-Nutzung hinzu

- Generieren Sie einen API-Schlüssel unter Einstellungen → Schlüssel

Dieser Schlüssel authentifiziert Ihre Anfragen an OpenRouter und unterstützt die Weiterleitung an Kimi K2.5.

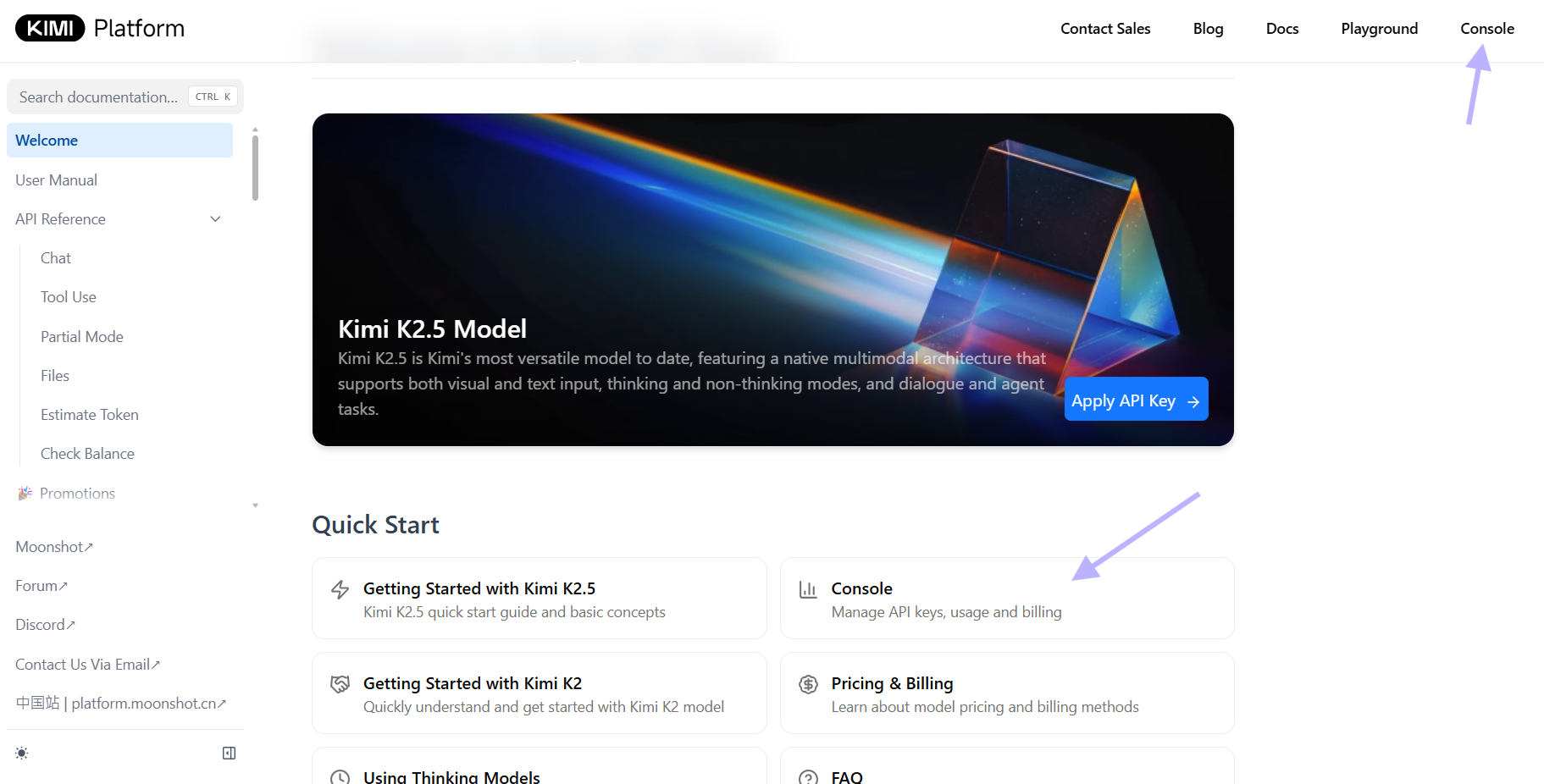

✅ Option B (via der Moonshot API)

Wenn Sie Zugriff auf das Entwicklerportal von Moonshot haben:

- Melden Sie sich auf der Moonshot-Plattform an

- Erstellen oder rufen Sie Ihren API-Schlüssel für deren Endpunkte ab

- Verwenden Sie den OpenAI-kompatiblen Endpunkt - Moonshot unterstützt `moonshot/kimi-k2.5`

Der Moonshot-Endpunkt bietet vollen 256K Kontext und multimodale Unterstützung mit der Einfachheit einer direkten API-Verbindung.

💡Profi-Tipp: Der offizielle Endpunkt von Moonshot verwendet das OpenAI-kompatible Format, was ihn ideal für die benutzerdefinierte Modellkonfiguration von Cursor macht.

Cursor für benutzerdefinierte Modelle konfigurieren

Sobald Ihr Anbieter konfiguriert ist, ist es an der Zeit, Cursor auf den richtigen Endpunkt zu verweisen.

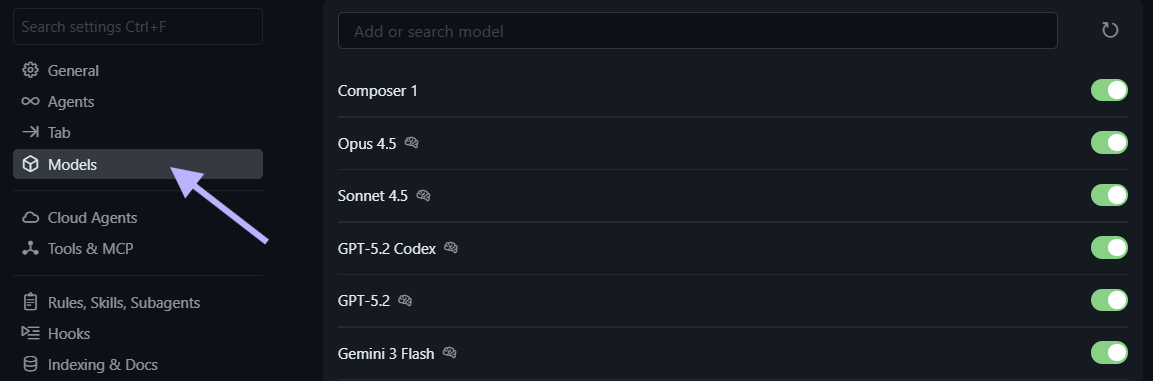

🧩 Cursor-Einstellungen öffnen

- Cursor öffnen

- Navigieren Sie zu Einstellungen → Modelle.

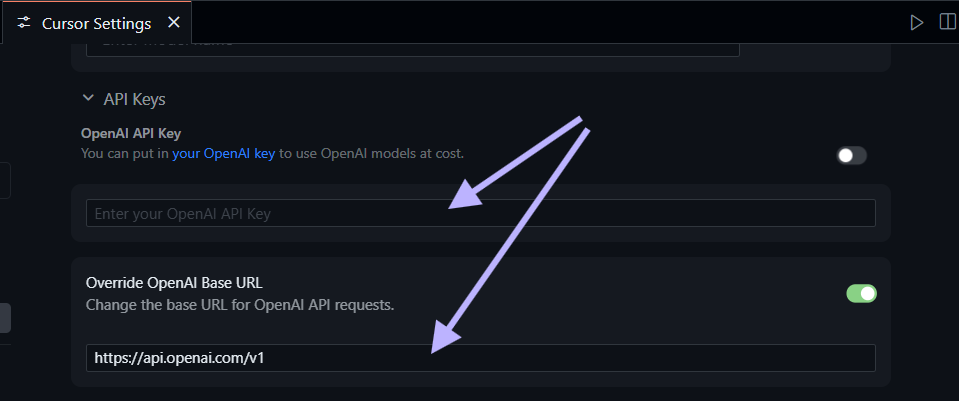

🔌 Die Basis-API-URL aktualisieren

Abhängig von Ihrem Anbieter

OpenRouter-Konfiguration:

Basis-URL: https://openrouter.ai/api/v1

Authentifizierung: Ihr OpenRouter API-SchlüsselMoonshot-Konfiguration:

Basis-URL: https://api.moonshot.cn/v1

Authentifizierung: Ihr Moonshot API-Schlüssel⚠️Wichtig: Wenn Sie Fehlermeldungen wie „Anbieter wird nicht unterstützt“ erhalten, stellen Sie sicher, dass die Basis-URL auf einen Anbieter verweist, der Kimi K2.5 explizit unterstützt.

Kimi K2.5 als benutzerdefiniertes Modell hinzufügen

Die Benutzeroberfläche für benutzerdefinierte Modelle von Cursor ermöglicht es Ihnen, Modelle hinzuzufügen, die nicht nativ aufgelistet sind.

Kimi K2.5 Modell hinzufügen

- Wählen Sie unter Einstellungen → Modelle die Option Benutzerdefiniertes Modell hinzufügen

- Geben Sie für den Modell-Slug (Namen) ein:

moonshot/kimi-k2.5

- Verwenden Sie

moonshotai/kimi-k2.5, wenn Sie über OpenRouter zugreifen - Verwenden Sie

moonshot/kimi-k2.5, wenn Sie direkt über Moonshot zugreifen

3. Speichern Sie die Modellkonfiguration

4. Aktualisieren Sie die Cursor-Einstellungen, falls das Modell nicht in der Liste erscheint

✅Schneller Erfolg: Nach dem Hinzufügen des Modells sollte es in Ihrem Dropdown-Menü neben den nativen Modellen erscheinen.

Fehlerbehebung

- Modell wird nicht angezeigt? Überprüfen Sie, ob die Basis-URL korrekt und Ihr API-Schlüssel gültig ist

- Authentifizierungsfehler? Überprüfen Sie, ob Ihr API-Schlüssel nicht abgelaufen ist und über ausreichend Guthaben verfügt

- Ratenbegrenzung? Einige Anbieter können die Anzahl der Anfragen pro Minute begrenzen

Testen Sie Ihre Kimi K2.5 Integration

Nachdem Cursor nun auf Kimi K2.5 verweist, testen Sie es mit einer einfachen Aufforderung, um sicherzustellen, dass alles funktioniert:

# Beispiel-Aufforderung

Schreiben Sie eine Funktion in Python, die zwei große Listen effizient unter Verwendung von integrierten Funktionen und Typ-Hinweisen schneidet.Cursor sendet dies über Ihren konfigurierten Anbieter an Kimi K2.5 und zeigt die Antwort an. Wenn nichts erscheint oder das Modell auf ein Standardmodell zurückfällt, überprüfen Sie Ihre benutzerdefinierten Modelleinstellungen und stellen Sie sicher, dass keine Tippfehler im Modell-Slug oder API-Endpunkt vorhanden sind.

💡Profi-Tipp: Beginnen Sie mit einfachen Codierungsaufgaben, bevor Sie zu komplexen Projekten mit mehreren Dateien übergehen. Dies hilft Ihnen zu überprüfen, ob die Reasoning-Fähigkeiten des Modells korrekt funktionieren.

Praktische Anwendungen in Cursor

Sobald Kimi K2.5 konfiguriert ist, können Sie es für typische KI-gestützte Entwicklungsaufgaben verwenden:

💡Codegenerierung und Refactoring

- Funktionen generieren mit klar definierten Docstrings und Typ-Annotationen

- Komplexe Module refaktorieren mit verbesserter Organisation und Lesbarkeit

- Muster und Idiome vorschlagen, die den modernen Best Practices von Python entsprechen

# Beispiel-Aufforderung

Refaktorieren Sie diese Klasse in kleinere Funktionen mit klaren, einzelnen Verantwortlichkeiten.🧠Reasoning und Debugging

- Dichte Logik oder Algorithmen erklären mit klaren Beispielen

- Optimierungsvorschläge erhalten für Performance-Engpässe

- Architektur-Entscheidungen überprüfen und Verbesserungen vorschlagen

# Beispiel-Aufforderung

Erklären Sie, warum dieser rekursive Algorithmus die Stack-Limits überschreiten könnte, und schlagen Sie eine iterative Version vor.🔄Workflow-Automatisierung

- Boilerplate-Code generieren für gängige Projektstrukturen

- Test-Suites automatisch erstellen aus API-Spezifikationen

- CI/CD-Pipelines einrichten für automatisiertes Testen

💡Apidog-Integration: Beim Testen von API-Workflows verwenden Sie die visuelle Oberfläche von Apidog, um Anfragen zu debuggen, Antworten zu validieren und produktionsreifen Code zu generieren.

Erweiterte Konfigurationsoptionen

🌐Umgebungsvariablen-Verwaltung

Für Produktions-Setups verwenden Sie Umgebungsvariablen anstelle von fest codierten Anmeldeinformationen:

# Zu Ihrem Shell-Profil (.zshrc, .bashrc) hinzufügen

export OPENROUTER_API_KEY="ihr-schlüssel-hier"

export MOONSHOT_API_KEY="ihr-schlüssel-hier"Verweisen Sie dann in der Cursor-Konfiguration mit dem Standardformat ${ENV_VAR} auf diese.

🚀Leistungsoptimierung

- Kontextlänge reduzieren für schnellere Antworten, wenn nicht benötigt

- Temperatur-Einstellungen anpassen (0.7 für kreativ, 0.3 für analytisch)

- Streaming-Antworten verwenden für Echtzeit-Feedback bei langen Generierungen

- Häufige Abfragen cachen bei wiederkehrenden Aufgaben

🔒Sicherheits-Best-Practices

- API-Schlüssel niemals in die Versionskontrolle übertragen

- Nur HTTPS-Endpunkte verwenden

- Nutzung überwachen und Ausgabenlimits in den Anbieter-Dashboards festlegen

- API-Schlüssel regelmäßig rotieren für Produktionsumgebungen

⚠️Sicherheitshinweis: Die Verwendung von Apidog für API-Tests hilft Ihnen, Sicherheitskonfigurationen vor der Bereitstellung in der Produktion zu validieren.

Fehlerbehebung bei häufigen Problemen

Problem: "Modell antwortet nicht"

- Ursache: Falscher API-Endpunkt oder Authentifizierungsfehler

- Lösung: Überprüfen Sie Ihre Basis-URL und den API-Schlüssel, und starten Sie Cursor dann neu

Problem: "Ratenbegrenzung überschritten"

- Ursache: Zu viele Anfragen an den Anbieter in kurzer Zeit

- Lösung: Warten Sie 60 Sekunden und versuchen Sie es erneut, oder aktualisieren Sie Ihren Anbieterplan

Problem: "Kontextfenster zu klein"

- Ursache: Anbieter fällt standardmäßig auf 4K Kontext statt Kimi K2.5s 256K zurück

- Lösung: Überprüfen Sie die Anbietereinstellungen und stellen Sie sicher, dass der volle Kontext aktiviert ist

Problem: "Authentifizierungstoken abgelaufen"

- Ursache: API-Schlüssel hat sein Ablaufdatum erreicht

- Lösung: Generieren Sie einen neuen API-Schlüssel und aktualisieren Sie Ihre Konfiguration

Fazit

Die Integration von Kimi K2.5 mit Cursor erschließt ein flexibles, leistungsstarkes KI-Modell in Ihrer bevorzugten Entwicklungsumgebung, auch ohne native Unterstützung. Durch die Konfiguration benutzerdefinierter API-Endpunkte über OpenRouter oder Moonshot erhalten Sie Zugriff auf die multimodalen Fähigkeiten, das 256K-Kontextfenster und die agentischen Verhaltensweisen von K2.5.

Dieser Ansatz gibt Ihnen die vollständige Kontrolle über Ihren KI-Workflow – die Möglichkeit, Ihr Modell basierend auf Projektanforderungen, Budget und Datenschutzanforderungen auszuwählen. Richten Sie es in wenigen Minuten ein, validieren Sie Ihre Konfiguration und nutzen Sie die fortschrittlichen Reasoning- und Codierungsfähigkeiten von Kimi K2.5 direkt dort, wo Sie Code schreiben.

Nächste Schritte:

- Wählen Sie Ihren Anbieter (OpenRouter für Flexibilität, Moonshot für direkten Zugriff)

- Konfigurieren Sie API-Anmeldeinformationen in Ihrer Umgebung oder den Cursor-Einstellungen

- Fügen Sie Kimi K2.5 hinzu als benutzerdefiniertes Modell mit dem richtigen Slug

- Testen Sie die Integration mit einfachen Codierungsaufgaben, bevor Sie wichtige Projekte beginnen

- Verwenden Sie Apidog, um API-Workflows zu validieren und Probleme effizient zu debuggen

💡Abschließender Tipp: Treten Sie Communities von Entwicklern bei, die benutzerdefinierte KI-Modelle verwenden, um Workflows, Fehlerbehebungstipps und kreative Lösungen zur Maximierung des Potenzials von Kimi K2.5 in Cursor auszutauschen.