A Vercel entrou na arena de IA com sua API v0, apresentando o modelo v0-1.0-md. Esta API foi projetada para capacitar desenvolvedores na criação de aplicações web modernas, oferecendo um conjunto de recursos pensados para velocidade, eficiência e facilidade de integração. Este artigo oferece uma visão abrangente da API Vercel v0-1.0-md, cobrindo seus recursos, preços e como começar, incluindo uma análise de como aproveitá-la com ferramentas de desenvolvimento de API como o APIdog.

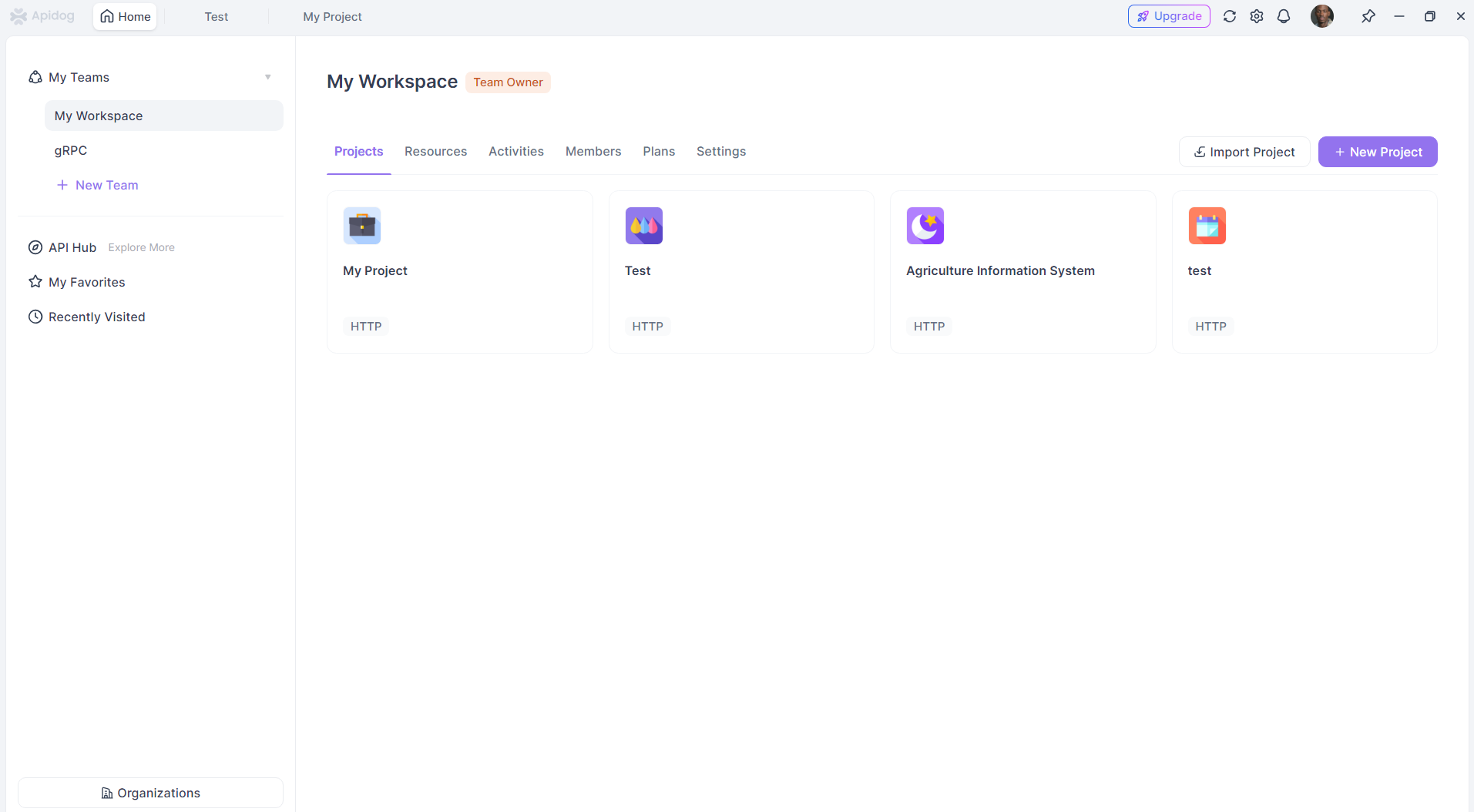

Quer uma plataforma integrada e All-in-One para sua equipe de desenvolvedores trabalhar em conjunto com produtividade máxima?

O Apidog atende a todas as suas demandas e substitui o Postman por um preço muito mais acessível!

Recursos da API Vercel v0-1.0-md

O modelo v0-1.0-md está no coração da API v0, trazendo um conjunto robusto de capacidades adaptadas para os desafios do desenvolvimento web contemporâneo.

Framework Aware Completions (Conclusões Cientes de Frameworks): Uma das características de destaque é sua consciência das stacks de desenvolvimento web modernas. O modelo foi avaliado e otimizado para frameworks populares como Next.js e, naturalmente, a própria plataforma da Vercel. Isso significa que os desenvolvedores podem esperar conclusões de código e sugestões mais relevantes e contextualmente precisas ao trabalhar dentro desses ecossistemas.

Auto-fix Capabilities (Capacidades de Auto-correção): Escrever código perfeito na primeira tentativa é uma raridade. O modelo v0-1.0-md auxilia nisso identificando e corrigindo automaticamente problemas comuns de codificação durante o processo de geração. Isso pode reduzir significativamente o tempo de depuração e melhorar a qualidade geral do código.

Quick Edit Functionality (Funcionalidade de Edição Rápida): Velocidade é um tema recorrente com a API v0. O recurso de edição rápida transmite edições inline assim que elas ficam disponíveis. Esse loop de feedback em tempo real permite que os desenvolvedores vejam as mudanças instantaneamente, promovendo uma experiência de desenvolvimento mais dinâmica e interativa.

OpenAI Compatibility (Compatibilidade com OpenAI): Reconhecendo a ampla adoção dos padrões de API da OpenAI, a Vercel garantiu que o modelo v0-1.0-md seja compatível com o formato da API OpenAI Chat Completions. Esta é uma vantagem significativa, pois permite que os desenvolvedores usem a API v0 com quaisquer ferramentas, SDKs ou bibliotecas existentes que já suportem a estrutura da OpenAI. Essa interoperabilidade reduz a barreira de entrada e permite uma integração mais fácil em fluxos de trabalho existentes.

Multimodal Input (Entrada Multimodal): A API não se limita a interações baseadas em texto. Ela suporta entradas multimodais, o que significa que pode processar dados de texto e imagem. As imagens precisam ser fornecidas como dados codificados em base64. Isso abre uma gama de possibilidades para aplicações que exigem compreensão ou geração de conteúdo com base em informações visuais juntamente com prompts textuais.

Function/Tool Calls (Chamadas de Função/Ferramenta): Aplicações de IA modernas frequentemente exigem interação com sistemas externos ou a execução de funções específicas. O modelo v0-1.0-md suporta chamadas de função e ferramenta, permitindo que os desenvolvedores definam ferramentas personalizadas que a IA pode invocar. Isso estende as capacidades do modelo além da simples geração de texto, permitindo que ele realize ações, recupere dados de outras APIs ou interaja com outros serviços como parte de sua geração de resposta.

Low Latency Streaming Responses (Respostas de Streaming de Baixa Latência): Para aplicações que exigem interação em tempo real, como chatbots ou assistentes de codificação ao vivo, a latência é um fator crítico. A API v0 é projetada para fornecer respostas rápidas e em streaming. Isso significa que, em vez de esperar que a resposta inteira seja gerada, os dados são enviados em blocos à medida que ficam disponíveis, levando a uma experiência de usuário muito mais responsiva e envolvente.

Optimization for Web Development (Otimização para Desenvolvimento Web): O modelo é especificamente otimizado para tarefas de desenvolvimento web frontend e full-stack. Esse foco garante que seu treinamento e capacidades estejam alinhados com os desafios e requisitos comuns da construção de aplicações web modernas, desde a geração de componentes de UI até a escrita de lógica do lado do servidor.

Os desenvolvedores podem experimentar o modelo v0-1.0-md diretamente no AI Playground fornecido pela Vercel. Isso permite testar diferentes prompts, observar as respostas do modelo e ter uma ideia de suas capacidades antes de integrá-lo a um projeto.

Preços e Acesso da API Vercel v0

O acesso à API Vercel v0, e consequentemente ao modelo v0-1.0-md, está atualmente em beta. Para utilizar a API, os usuários precisam estar em um plano Premium ou Team com faturamento baseado em uso habilitado. Informações detalhadas sobre a estrutura de preços geralmente podem ser encontradas na página oficial de preços da Vercel. Como em muitos programas beta, é aconselhável verificar os termos e condições mais recentes diretamente com a Vercel.

Para começar a usar a API, o primeiro passo é criar uma chave de API em v0.dev. Esta chave será usada para autenticar as requisições à API.

Limites de Uso

Como a maioria dos serviços de API, a API Vercel v0 possui limites de uso para garantir o uso justo e manter a estabilidade do serviço. Os limites atualmente documentados para o modelo v0-1.0-md são:

- Máximo de mensagens por dia: 200

- Tamanho máximo da janela de contexto: 128.000 tokens

- Tamanho máximo do contexto de saída: 32.000 tokens

Esses limites estão sujeitos a alterações, especialmente à medida que a API sai do beta. Para usuários ou aplicações que exigem limites mais altos, a Vercel oferece um ponto de contato (support@v0.dev) para discutir possíveis aumentos. Também é importante notar que, ao usar a API, os desenvolvedores concordam com os Termos da API da Vercel.

Como Usar a API Vercel v0

Integrar a API Vercel v0 a um projeto é projetado para ser direto, particularmente para desenvolvedores familiarizados com o formato da API OpenAI ou usando o ecossistema da Vercel.

Integração com AI SDK: A Vercel recomenda o uso de seu AI SDK, uma biblioteca TypeScript especificamente projetada para trabalhar com <V0Text /> e outros modelos compatíveis com OpenAI. Este SDK simplifica o processo de fazer chamadas de API, lidar com respostas e integrar capacidades de IA em aplicações.

Para começar, você normalmente instalaria os pacotes necessários:

npm install ai @ai-sdk/openai

Exemplo de Uso (JavaScript/TypeScript):

O exemplo a seguir demonstra como usar a função generateText do AI SDK para interagir com o modelo v0-1.0-md:

import { generateText } from 'ai';

import { createOpenAI } from '@ai-sdk/openai';

// Configure o cliente da API Vercel v0

const vercel = createOpenAI({

baseURL: 'https://api.v0.dev/v1', // O endpoint da API v0

apiKey: process.env.VERCEL_V0_API_KEY, // Sua chave da API Vercel v0

});

async function getAIChatbotResponse() {

try {

const { text } = await generateText({

model: vercel('v0-1.0-md'), // Especifique o modelo Vercel

prompt: 'Create a Next.js AI chatbot with authentication',

});

console.log(text);

return text;

} catch (error) {

console.error("Error generating text:", error);

// Lide com o erro apropriadamente

}

}

getAIChatbotResponse();

Neste exemplo:

- Importamos

generateTextda bibliotecaaiecreateOpenAIde@ai-sdk/openai. - Um cliente compatível com OpenAI é criado usando

createOpenAI, configurado com a URL base da API v0 (https://api.v0.dev/v1) e sua chave da API Vercel v0 (que deve ser armazenada de forma segura, por exemplo, como uma variável de ambiente). - A função

generateTexté chamada, passando o clientevercelconfigurado (especificando o modelov0-1.0-md) e o prompt desejado. - A resposta da API, contendo o texto gerado, está então disponível na variável

text.

Referência da API:

Para interação direta com a API, sem o SDK, ou para entender a mecânica subjacente, a referência da API é fundamental.

Endpoint: POST https://api.v0.dev/v1/chat/completions

Este único endpoint é usado para gerar respostas do modelo com base em um histórico de conversação.

Headers:

Authorization: Obrigatório. Um token Bearer no formatoBearer $V0_API_KEY.Content-Type: Obrigatório. Deve serapplication/json.

Corpo da Requisição (Request Body): O corpo da requisição é um objeto JSON com os seguintes campos principais:

model(string, Obrigatório): O nome do modelo. Para esta API, deve ser"v0-1.0-md".messages(array, Obrigatório): Uma lista de objetos de mensagem que formam o histórico da conversação. Cada objeto de mensagem deve ter:role(string, Obrigatório): Identifica o remetente, pode ser"user","assistant"ou"system".content(string ou array, Obrigatório): O conteúdo real da mensagem. Pode ser uma string simples ou um array de blocos de texto e imagem para entrada multimodal.stream(boolean, Opcional): Se definido comotrue, a API retornará a resposta como um fluxo de Server-Sent Events (SSE). O padrão éfalse.tools(array, Opcional): Definições de quaisquer ferramentas personalizadas (por exemplo, funções) que o modelo pode chamar.tool_choice(string ou object, Opcional): Especifica qual ferramenta o modelo deve chamar, se ferramentas forem fornecidas.

Exemplo de Requisição (cURL):

Veja como você pode fazer uma chamada direta à API usando cURL:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Create a Next.js AI chatbot" }

]

}'

Exemplo com Streaming (cURL):

Para receber uma resposta em streaming:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"stream": true,

"messages": [

{ "role": "user", "content": "Add login to my Next.js app" }

]

}'

Formato da Resposta:

Não-streaming (stream: false): A API retorna um único objeto JSON contendo a resposta completa. Este objeto inclui um id, o nome do model, um tipo de object (por exemplo, chat.completion), um timestamp de created e um array choices. Cada escolha no array contém a message (com role: "assistant" e o content da resposta) e um finish_reason (por exemplo, "stop").

{

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion",

"created": 1715620000,

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Here's how to add login to your Next.js app..."

},

"finish_reason": "stop"

}

]

}

Streaming (stream: true): O servidor envia uma série de blocos de dados formatados como Server-Sent Events (SSE). Cada evento começa com data: seguido por um objeto JSON representando um delta parcial da resposta. Isso permite que o cliente processe a resposta incrementalmente.

data: {

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion.chunk",

"choices": [

{

"delta": {

"role": "assistant",

"content": "Here's how"

},

"index": 0,

"finish_reason": null

}

]

}

Um bloco final geralmente terá um finish_reason diferente de null.

Usando a API Vercel v0 com APIdog

APIdog é uma plataforma de API abrangente projetada para projetar, desenvolver, testar e documentar APIs. Sua força reside na unificação dessas diferentes etapas do ciclo de vida da API. Você pode usar o APIdog para interagir com a API Vercel v0, assim como faria com qualquer outra API baseada em HTTP.

Aqui está uma abordagem geral para usar a API Vercel v0 com APIdog:

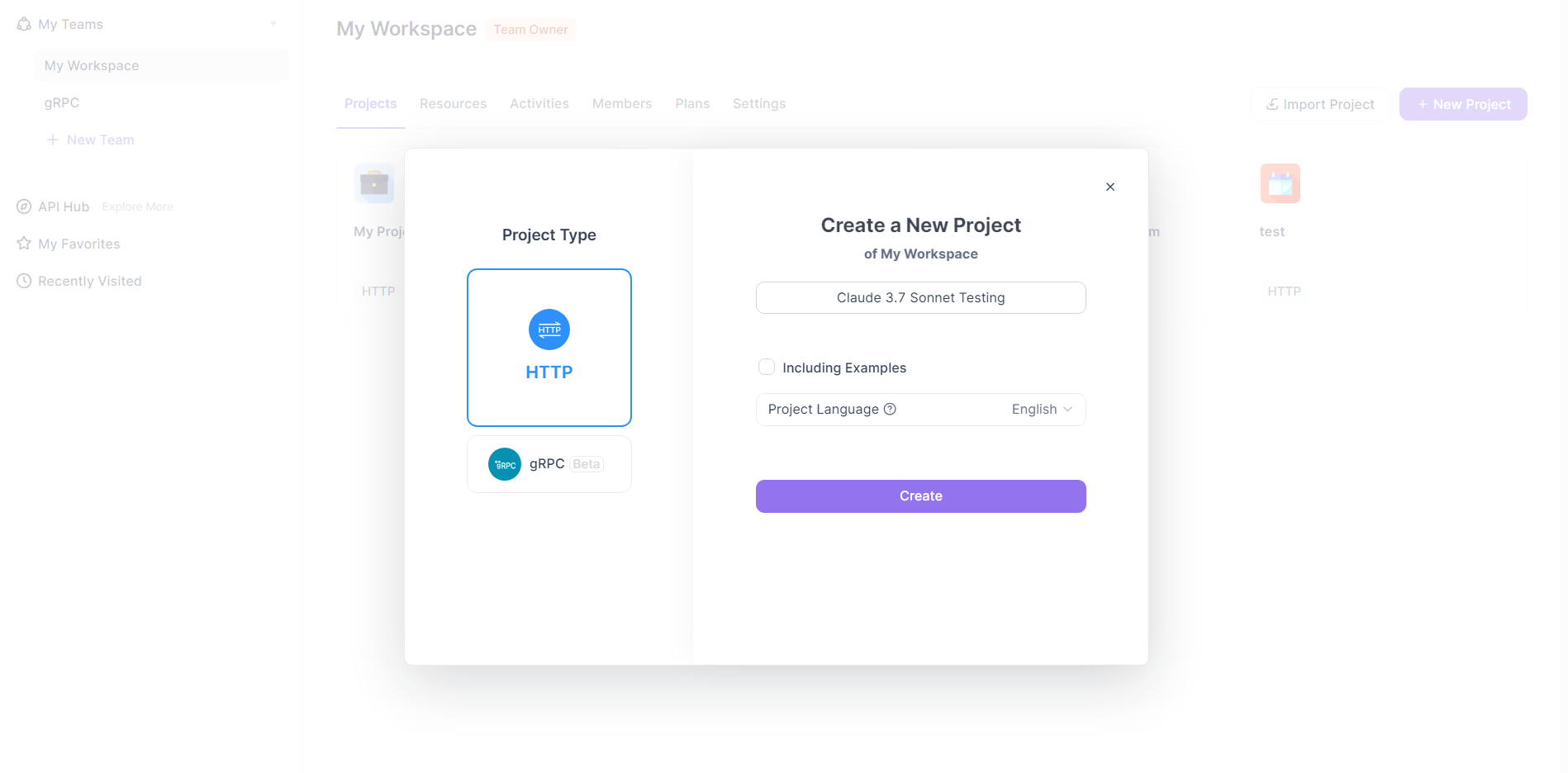

Criar uma Nova Requisição no APIdog:

- Dentro do seu projeto APIdog, inicie a criação de uma nova requisição. Isso geralmente é feito clicando em um ícone "+" e selecionando "New Request" (Nova Requisição) ou uma opção similar.

- APIdog suporta vários tipos de requisição; para a API Vercel v0, você estará criando uma requisição HTTP.

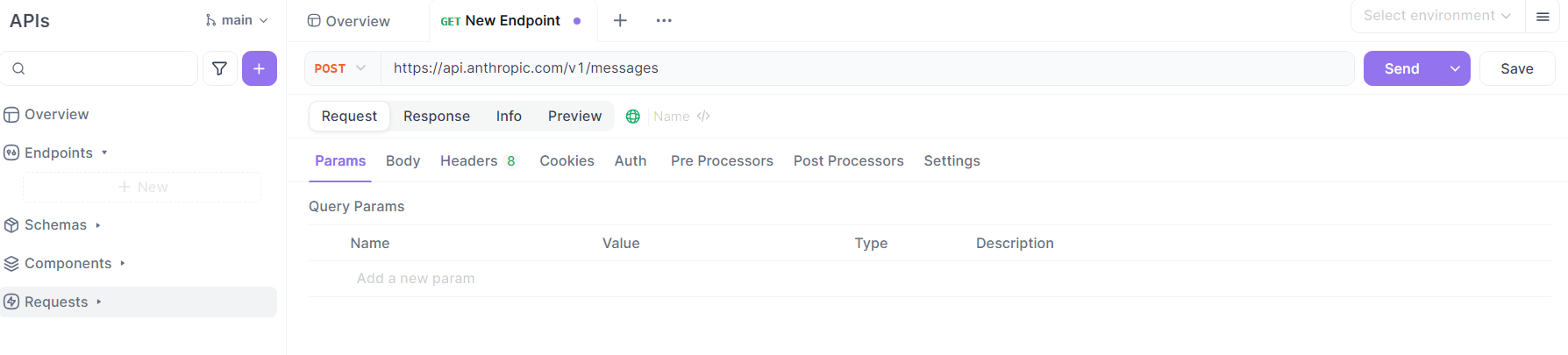

Configurar os Detalhes da Requisição:

- Método: Selecione

POSTcomo o método HTTP, conforme especificado na documentação da API Vercel v0. - URL: Insira o endpoint da API Vercel v0:

https://api.v0.dev/v1/chat/completions. - Headers:

- Adicione um header

Authorization. O valor deve serBearer SUA_CHAVE_API_VERCEL_V0, substituindoSUA_CHAVE_API_VERCEL_V0pela chave de API real que você obteve em v0.dev. - Adicione um header

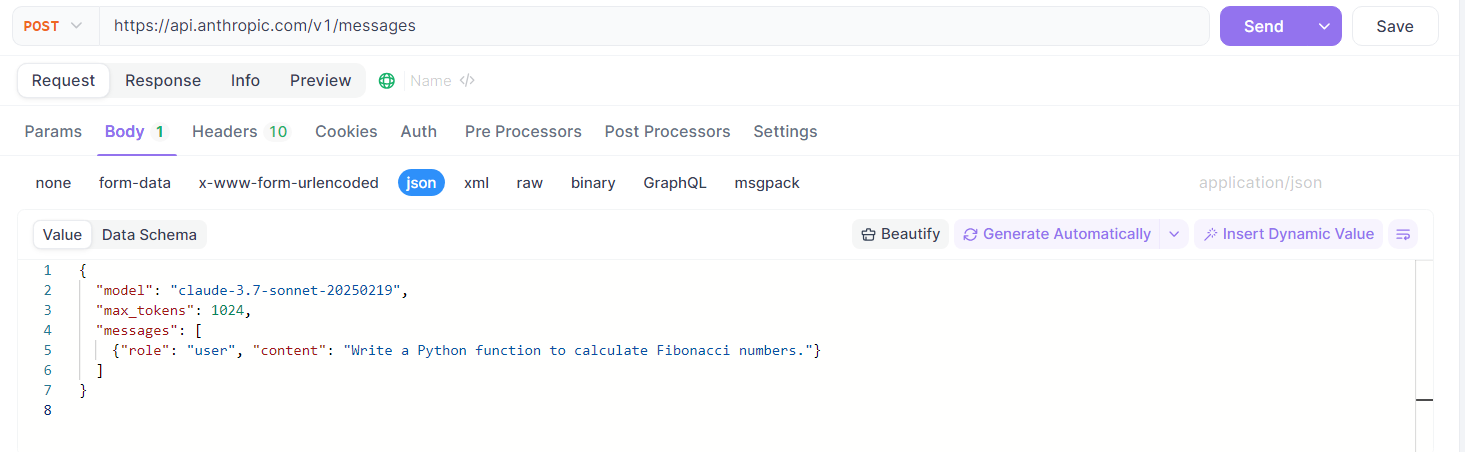

Content-Typecom o valorapplication/json. - Body:

Mude para a aba "Body" no APIdog e selecione o tipo de entrada "raw", então escolha "JSON" como o formato.

Construa o payload JSON de acordo com as especificações da API Vercel v0. Por exemplo:

{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Generate a React component for a loading spinner." }

],

"stream": false // ou true, dependendo das suas necessidades

}

Você pode personalizar o array messages com seu histórico de conversação e prompt desejados. Você também pode incluir campos opcionais como stream, tools ou tool_choice conforme necessário.

Enviar a Requisição:

- Uma vez que todos os detalhes estejam configurados, clique no botão "Send" (Enviar) no APIdog.

Visualizar a Resposta:

- APIdog exibirá a resposta do servidor no painel de resposta.

- Se

streamfoifalse, você verá a resposta JSON completa. - Se

streamfoitrue, o tratamento de SSE pelo APIdog pode variar. Ele pode exibir os blocos à medida que chegam ou acumulá-los. Consulte a documentação do APIdog para detalhes sobre como lidar com respostas em streaming. Você pode precisar usar as capacidades de script ou cenários de teste do APIdog para um tratamento de stream mais avançado.

Utilizar Recursos do APIdog (Opcional):

- Environments (Ambientes): Armazene sua

CHAVE_API_V0e a URL base (https://api.v0.dev) como variáveis de ambiente no APIdog para facilitar o gerenciamento em diferentes requisições ou projetos. - Endpoint Saving (Salvamento de Endpoint): Salve esta requisição configurada como um "Endpoint Case" (Caso de Endpoint) ou dentro de uma definição de API no APIdog. Isso permite que você reutilize e versionize facilmente suas interações com a API Vercel v0.

- Test Scenarios (Cenários de Teste): Se você precisar fazer uma sequência de chamadas ou incorporar a API Vercel v0 em um fluxo de trabalho de teste maior, crie Test Scenarios no APIdog.

- Automated Validation (Validação Automatizada): Se você definir uma especificação de API para a API Vercel v0 dentro do APIdog (ou importar uma se disponível), o APIdog pode validar automaticamente as respostas contra este esquema.

Seguindo estes passos, você pode usar efetivamente o APIdog como um cliente para enviar requisições à API Vercel v0, inspecionar respostas e gerenciar suas interações de API de forma estruturada. Isso é particularmente útil para testar prompts, explorar recursos da API e integrar conteúdo ou lógica gerada por IA em aplicações durante as fases de desenvolvimento e teste.

Conclusão

A API Vercel v0-1.0-md representa um passo significativo da Vercel no campo do desenvolvimento assistido por IA. Seu foco em frameworks web modernos, compatibilidade com OpenAI e recursos como auto-correção e entrada multimodal a tornam uma opção atraente para desenvolvedores que buscam construir aplicações web de próxima geração. Embora atualmente em beta e sujeita a requisitos de plano específicos, o design da API e o AI SDK de suporte sugerem um compromisso em fornecer uma ferramenta poderosa, porém acessível. Seja usada diretamente via sua API REST, através do AI SDK ou gerenciada com ferramentas como APIdog, o modelo v0-1.0-md oferece um caminho promissor para integrar capacidades avançadas de IA no fluxo de trabalho de desenvolvimento web, otimizando tarefas e desbloqueando novas possibilidades criativas. À medida que a API amadurece e potencialmente expande suas ofertas, será, sem dúvida, um espaço a ser observado por desenvolvedores interessados em alavancar a IA em seus projetos.