Sora 2 da OpenAI se destaca como uma ferramenta poderosa que combina prompts de texto com sincronização avançada de áudio para produzir clipes realistas. Desenvolvedores frequentemente buscam maneiras de aproveitar essa tecnologia, evitando distrações visuais como marcas d'água, que podem prejudicar aplicações profissionais. Felizmente, usar a API do Sora 2 oferece um caminho para saídas mais limpas, especialmente quando integrada com ferramentas robustas de gerenciamento de API.

Este artigo explora os aspectos técnicos do Sora 2, focando na utilização da API e em estratégias para eliminar marcas d'água. Você aprenderá como configurar seu ambiente, executar chamadas de API e aplicar métodos de pós-processamento. Além disso, o guia incorpora exemplos práticos e dicas de otimização para aprimorar seus projetos.

Compreendendo o Sora 2 e Suas Capacidades

A OpenAI lançou o Sora 2 em 30 de setembro de 2025, marcando um avanço significativo na tecnologia de geração de vídeo. Este modelo se baseia no Sora original, incorporando simulações físicas mais precisas, animações realistas e áudio sincronizado. Por exemplo, o Sora 2 renderiza com precisão cenários complexos, como uma bola de basquete quicando na tabela ou um ginasta realizando rotinas intrincadas. Desenvolvedores aproveitam esses recursos para criar conteúdo dinâmico para aplicações em entretenimento, educação e marketing.

O Sora 2 opera como um modelo baseado em difusão que transforma prompts de texto em vídeos de até 20 segundos de duração, com resoluções que chegam a 1080p em níveis superiores. Ele suporta estilos que variam do realismo cinematográfico à estética de anime. No entanto, as saídas oficiais do aplicativo e site do Sora frequentemente incluem marcas d'água visíveis para indicar a geração por IA, de acordo com as políticas de IA responsável da OpenAI. Essas marcas d'água aparecem como sobreposições em movimento ou metadados incorporados, o que pode limitar a usabilidade em ambientes comerciais.

Transitando para a versão API, o Sora 2 oferece maior flexibilidade. A API, disponível em prévia para desenvolvedores, permite acesso programático a endpoints de geração sem as restrições do aplicativo do consumidor. Você a acessa através da plataforma da OpenAI, exigindo uma chave de API e, potencialmente, uma assinatura Pro para recursos aprimorados, como resoluções mais altas e nenhuma marca d'água embutida em certas configurações. De acordo com a documentação do desenvolvedor, os endpoints da API focam em solicitações de texto para vídeo, onde você especifica parâmetros como prompt, duração e estilo.

Plataformas como Replicate e ComfyUI oferecem versões hospedadas da API do Sora 2, permitindo saídas sem marca d'água através de suas interfaces. Essas alternativas se integram perfeitamente com ferramentas como o Apidog, que lida com autenticação e formatação de requisições. Ao usar a API, você contorna a marca d'água padrão aplicada na camada gratuita do aplicativo, embora algumas implementações ainda incorporem metadados. No entanto, essa abordagem permite que você gere vídeos limpos e adaptados às suas necessidades.

Acessando a API do Sora 2: Pré-requisitos e Configuração

Antes de gerar vídeos, você deve garantir o acesso à API do Sora 2. A OpenAI libera a disponibilidade da API para desenvolvedores com contas ativas, frequentemente priorizando aqueles com assinaturas Pro ou empresariais. Comece fazendo login na plataforma de desenvolvedores da OpenAI em platform.openai.com. Lá, você cria uma chave de API na seção de chaves de API. Certifique-se de que sua conta atenda aos requisitos para acesso prévio ao Sora 2, o que pode envolver entrar em uma lista de espera ou verificar seu caso de uso.

Uma vez aprovado, você configura seu ambiente de desenvolvimento. Instale as bibliotecas necessárias, como o OpenAI Python SDK, usando pip: pip install openai. Esta biblioteca simplifica as interações com a API. Para usuários de JavaScript, o pacote Node.js oferece funcionalidade semelhante. Além disso, se você optar por hosts de terceiros como Replicate, cadastre-se no site deles e obtenha um token de API.

A segurança desempenha um papel crucial aqui. Sempre armazene sua chave de API em variáveis de ambiente, em vez de codificá-la diretamente, para evitar exposição. Por exemplo, em Python, use os.environ['OPENAI_API_KEY'] = 'sua-chave'. Esta prática protege suas credenciais durante projetos colaborativos.

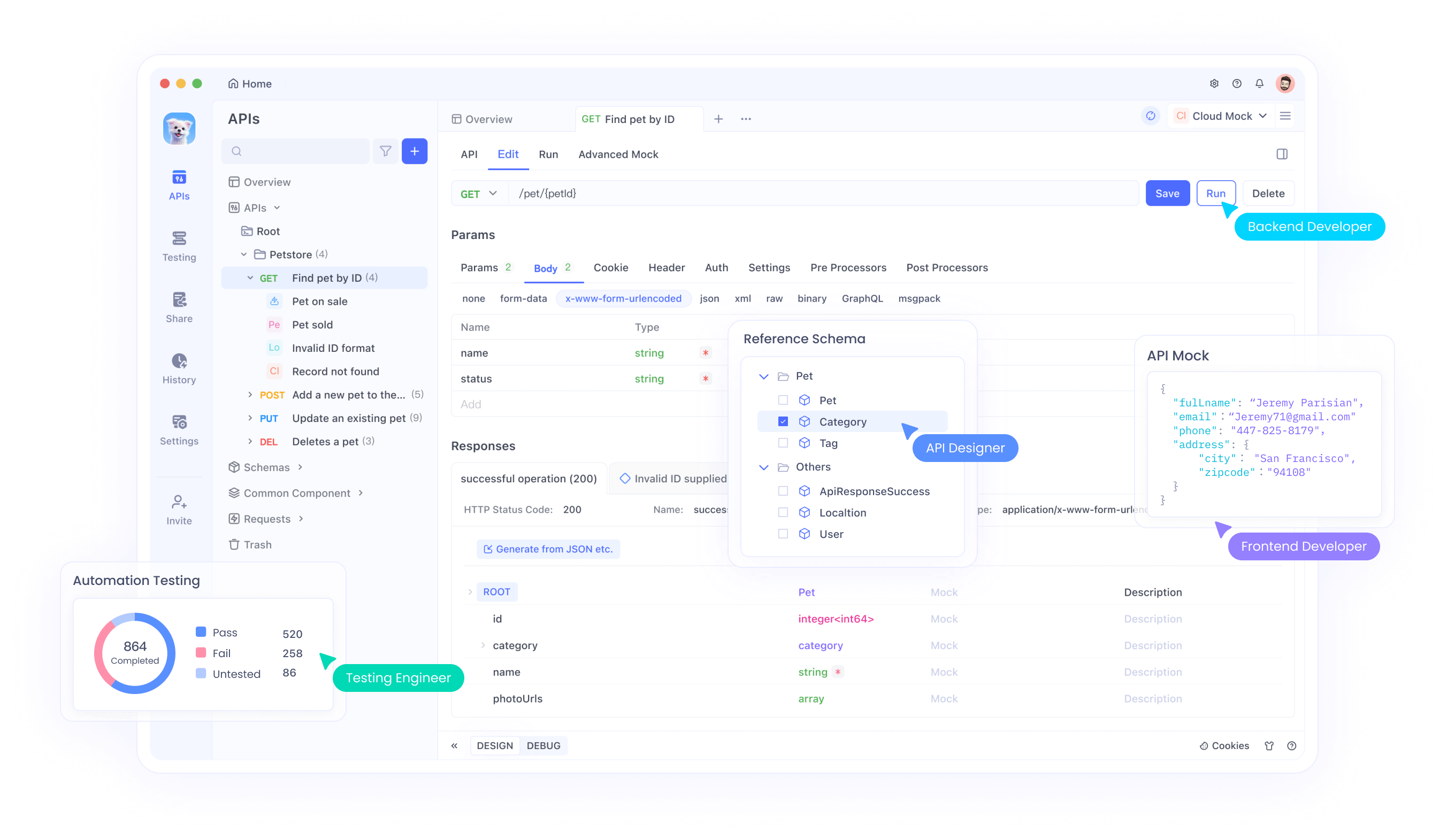

Agora, integre o Apidog em sua configuração. Como um cliente API abrangente, o Apidog se destaca no teste e documentação de endpoints da OpenAI, incluindo o Sora 2. Baixe e instale o Apidog em seu site oficial. Ao iniciar, crie um novo projeto e importe a especificação da API da OpenAI colando a URL do esquema OpenAPI ou carregando um arquivo JSON. O Apidog gera automaticamente endpoints para modelos como o Sora 2, permitindo que você personalize solicitações com parâmetros como nome do modelo ("sora-2") e prompts de entrada.

A interface do Apidog se assemelha ao Postman, mas oferece recursos avançados como testes automatizados e mocking. Você adiciona sua chave de API ao cabeçalho de autorização, tipicamente como um token Bearer. Teste um endpoint simples, como a lista de modelos, para verificar a conectividade: Envie uma requisição GET para /v1/models e confirme se o Sora 2 aparece na resposta. Esta etapa garante que sua configuração funcione corretamente antes de prosseguir para a geração de vídeo.

Configurando o Apidog para Requisições da API do Sora 2

Com seu ambiente pronto, você mergulha nas capacidades do Apidog para o Sora 2. Crie uma nova coleção de API dedicada à geração de vídeo. Dentro dela, adicione uma requisição POST para o endpoint do Sora 2, geralmente /v1/video/generations ou similar, com base na documentação da OpenAI. Defina o corpo da requisição para o formato JSON.

Parâmetros chave incluem:

model: Especifique "sora-2" para invocar a versão mais recente.prompt: Uma descrição de texto detalhada, por exemplo, "Um gato realizando um triplo axel no gelo com áudio de miado sincronizado."duration: Em segundos, até 20.resolution: Opções como "720p" ou "1080p" para usuários Pro.style: "realistic", "cinematic", ou "anime".

O Apidog permite que você os parametrize para reutilização. Por exemplo, use variáveis como {{prompt}} para testar múltiplos cenários rapidamente. Além disso, habilite variáveis de ambiente para alternar entre chaves de API de teste e produção.

Para lidar com respostas assíncronas—já que a geração de vídeo pode levar minutos—você configura webhooks ou polling no Apidog. Configure um script para verificar o status da geração via uma requisição GET para o endpoint do ID do trabalho. Essa automação economiza tempo e garante que você recupere vídeos concluídos de forma eficiente.

Além disso, o Apidog suporta scripts com JavaScript para ações pré e pós-requisição. Escreva um script para validar o comprimento do prompt antes de enviar, prevenindo erros. Por exemplo:

if (pm.variables.get('prompt').length > 1000) {

throw new Error('Prompt muito longo');

}

Esta salvaguarda técnica aumenta a confiabilidade. Uma vez configurado, envie sua primeira requisição e monitore a resposta, que tipicamente inclui uma URL de vídeo ou um arquivo codificado em base64.

Gerando Vídeos com a API do Sora 2: Exemplos Passo a Passo

Agora você executa gerações reais. Comece com um prompt básico para testar. No Apidog, preencha o corpo:

{

"model": "sora-2",

"prompt": "Uma rua movimentada da cidade ao anoitecer com pedestres e carros, incluindo sons ambiente da rua.",

"duration": 10,

"resolution": "720p"

}

Envie a requisição. A API a processa e retorna um ID de trabalho. Verifique o endpoint de status a cada 10 segundos até que esteja "completed" (concluído). Recupere a URL do vídeo da resposta.

Para uso avançado, incorpore cameos—um recurso que permite elementos do mundo real, como a semelhança de uma pessoa. Faça upload de um vídeo de referência via uma requisição de formulário multipart no Apidog. O corpo pode ser parecido com:

{

"model": "sora-2",

"prompt": "A pessoa carregada dando uma palestra TED sobre IA.",

"cameo_video": "base64-encoded-video",

"audio_sync": true

}

O Apidog lida com uploads de arquivos nativamente, tornando isso contínuo.

No entanto, as saídas ainda podem conter marcas d'água se você estiver usando o nível padrão. O acesso à API Pro, disponível para assinantes do ChatGPT Pro, frequentemente oferece opções para downloads sem marca d'água. Verifique seu nível de assinatura; a atualização desbloqueia isso.

Para otimizar prompts, experimente com detalhes. Adicione descritores de física como "salto desafiador da gravidade" para aproveitar os pontos fortes de simulação do Sora 2. Acompanhe as métricas de uso nos analytics do Apidog para permanecer dentro dos limites de taxa, tipicamente 500 gerações por mês para acesso prioritário.

Estratégias para Remover Marcas D'água de Vídeos do Sora 2

Mesmo com acesso à API, alguns vídeos incluem marcas d'água. Você aborda isso através do pós-processamento. Primeiro, entenda os tipos de marca d'água: sobreposições visíveis (logotipos em movimento) e metadados invisíveis (padrões C2PA).

Para remoção visível, empregue ferramentas baseadas em IA. O Vmake AI, um serviço online gratuito, usa aprendizado profundo para detectar e apagar marcas d'água em movimento. Faça upload do seu vídeo do Sora 2, selecione a área da marca d'água e processe. A ferramenta preserva a qualidade preenchendo as seções removidas com pixels contextuais.

Alternativamente, use bibliotecas de código aberto como OpenCV em Python. Carregue o vídeo:

import cv2

cap = cv2.VideoCapture('sora_video.mp4')

width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH))

height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT))

fps = cap.get(cv2.CAP_PROP_FPS)

out = cv2.VideoWriter('clean_video.mp4', cv2.VideoWriter_fourcc(*'mp4v'), fps, (width, height))

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# Detectar e mascar marca d'água (lógica personalizada, por exemplo, corte de ROI ou modelo ML)

clean_frame = remove_watermark(frame) # Implementar função

out.write(clean_frame)

cap.release()

out.release()

Implemente remove_watermark usando um modelo pré-treinado do Hugging Face, como uma rede de segmentação treinada em conjuntos de dados de marca d'água.

Para metadados, remova as tags C2PA com FFmpeg: ffmpeg -i input.mp4 -codec copy -bsf:v "filter_units=remove_types=6" output.mp4. Este comando remove filtros de bitstream específicos sem recodificação.

No entanto, considere as implicações legais. Os termos da OpenAI proíbem a adulteração de sinais de proveniência, mas para uso interno ou onde permitido, esses métodos se aplicam. Sempre atribua o conteúdo gerado por IA eticamente.

Integrando isso aos fluxos de trabalho do Apidog, automatize o pós-processamento via scripts. Após recuperar a URL do vídeo, baixe e execute o código de remoção.

Técnicas Avançadas para Otimização da API do Sora 2

Para aprimorar seu uso, encadeie múltiplas chamadas de API. Gere um vídeo base e, em seguida, remixe-o com um prompt de acompanhamento: "Estenda a cena anterior com uma reviravolta dramática." Use o ID do trabalho como referência em requisições subsequentes.

Além disso, incorpore aprimoramentos de áudio. O Sora 2 sincroniza efeitos sonoros automaticamente, mas você pode ajustar, especificando "incluir música de fundo orquestral" nos prompts.

A otimização de desempenho envolve o agrupamento de requisições. O Apidog suporta coleções para executar múltiplos testes simultaneamente, ideal para experimentos de prompt A/B.

Além disso, monitore os custos. O preço da API do Sora 2 começa em $0.05 por segundo de vídeo para o padrão, com o Pro a taxas mais altas para recursos premium. Acompanhe via o painel da OpenAI e configure alertas no Apidog.

Para escalabilidade, implante em ambientes de produção. Use funções em nuvem como AWS Lambda para lidar com chamadas de API, acionadas por entradas do usuário. Proteja com gateways de API.

Melhores Práticas e Solução de Problemas para Sora 2 com Apidog

Adote estas práticas para maximizar a eficiência. Primeiro, valide as entradas rigorosamente—prompts ruins resultam em vídeos abaixo do padrão. Use os testes de asserção do Apidog para verificar os códigos de status de resposta (200 para sucesso).

Solucione problemas comuns: Se a autenticação falhar, regenere sua chave. Para limites de taxa, implemente um backoff exponencial em scripts:

import time

def api_call_with_retry(func, max_retries=5):

for attempt in range(max_retries):

try:

return func()

except Exception as e:

if 'rate_limit' in str(e):

time.sleep(2 ** attempt)

else:

raise

Erros de rede? Mude para as configurações de proxy do Apidog.

Além disso, colabore compartilhando projetos do Apidog via links, garantindo o alinhamento da equipe nas configurações do Sora 2.

Estudos de Caso: Aplicações Reais do Sora 2 Sem Marca D'água

Considere uma empresa de marketing usando a API do Sora 2 para criar clipes de anúncios. Eles geram vídeos sem marcas d'água para apresentações a clientes, integrando o Apidog para iterações rápidas.

Na educação, professores produzem aulas animadas. Após a remoção, os vídeos são incorporados de forma limpa em plataformas como o YouTube.

Esses exemplos ilustram a versatilidade do Sora 2 quando desimpedido por marcas d'água.

Perspectivas Futuras e Atualizações para a API do Sora 2

A OpenAI continua evoluindo o Sora 2, com expansões planejadas como durações mais longas e melhores integrações. Mantenha-se atualizado através do blog deles.

O Apidog adiciona regularmente recursos, como geração de requisições assistida por IA, complementando os avanços do Sora 2.

Em resumo, dominar o Sora 2 sem marcas d'água envolve acesso à API, facilitação do Apidog e técnicas de remoção direcionadas. Implemente estas etapas para produzir vídeos de nível profissional de forma eficiente.