A Alibaba lança o Qwen3-Max, um modelo de linguagem grande e carro-chefe que expande os limites das capacidades da inteligência artificial. Este modelo surge da série Qwen, conhecida por seus avanços em modelos de base abertos voltados para a inteligência artificial geral. Desenvolvedores e pesquisadores agora têm acesso a uma ferramenta que se destaca em tarefas complexas, desde desafios de codificação até raciocínio multifacetado. À medida que as equipes integram o Qwen3-Max por meio de sua API para aplicações no mundo real, testes eficientes tornam-se essenciais.

O Qwen3-Max escala para mais de um trilhão de parâmetros, treinado em 36 trilhões de tokens — o dobro do Qwen2.5. Ele lida com tarefas de agente e segue instruções com precisão. Embora comece sem modos de pensamento explícitos, os próximos recursos adicionarão aprimoramentos de raciocínio.

O modelo suporta mais de 100 idiomas, expandindo o uso global. A Alibaba oferece acesso à API em sua nuvem, simplificando a implantação.

Especificações Técnicas do Qwen3-Max

A Alibaba projeta o Qwen3-Max com foco em escalabilidade e eficiência. O modelo possui mais de um trilhão de parâmetros, posicionando-o entre os maiores modelos de IA disponíveis via API. Esse tamanho imenso permite que o sistema processe vastas quantidades de dados durante o pré-treinamento, resultando em reconhecimento de padrões robusto e habilidades de geração. Engenheiros treinam o Qwen3-Max em um conjunto de dados que excede 36 trilhões de tokens, dobrando o volume usado em gerações anteriores como o Qwen2.5.

O Qwen3-Max apresenta uma janela de contexto de 262.144 tokens, com uma entrada máxima de 258.048 tokens e uma saída máxima de 65.536 tokens. Este contexto expansivo permite que o modelo lide com documentos de formato longo, conversas estendidas e sequências complexas de resolução de problemas sem perder a coerência. Desenvolvedores se beneficiam disso em aplicações como análise de documentos ou diálogos de múltiplas rodadas. No entanto, a interface de chat pode impor limitações aparentes, mas o modelo subjacente suporta capacidade total através de chamadas de API.

O Qwen3-Max opera como um modelo de instrução não-pensante em seu lançamento inicial, priorizando a geração de respostas diretas. A Alibaba planeja introduzir recursos de raciocínio, incluindo uso de ferramentas e implantação de modo pesado, que prometem pontuações de benchmark quase perfeitas. A arquitetura se baseia na série Qwen3, incorporando melhorias no seguimento de instruções, redução de alucinações e suporte multilíngue aprimorado. Para implantação, frameworks como vLLM e SGLang facilitam o serviço eficiente, suportando paralelismo de tensor em várias GPUs.

Em termos de requisitos de hardware, o Qwen3-Max demanda recursos computacionais substanciais. Executá-lo localmente requer configurações de alto desempenho, mas o acesso à API mitiga isso, aproveitando a infraestrutura de nuvem da Alibaba. Os preços seguem uma estrutura de níveis baseada no volume de tokens: para 0–32K tokens, a entrada custa $1.2 por milhão, a saída $6 por milhão; para 32K–128K, $2.4 e $12; e para 128K–252K, $3 e $15. Novos usuários recebem uma cota gratuita de um milhão de tokens válida por 90 dias, incentivando a experimentação.

Além disso, o Qwen3-Max se integra com APIs compatíveis com OpenAI, simplificando a migração de outros provedores. Essa compatibilidade se estende ao cache de contexto, que otimiza consultas repetidas e reduz custos em ambientes de produção. No entanto, para operações estáveis, os usuários selecionam entre as versões mais recentes e de snapshot para gerenciar os limites de taxa de forma eficaz.

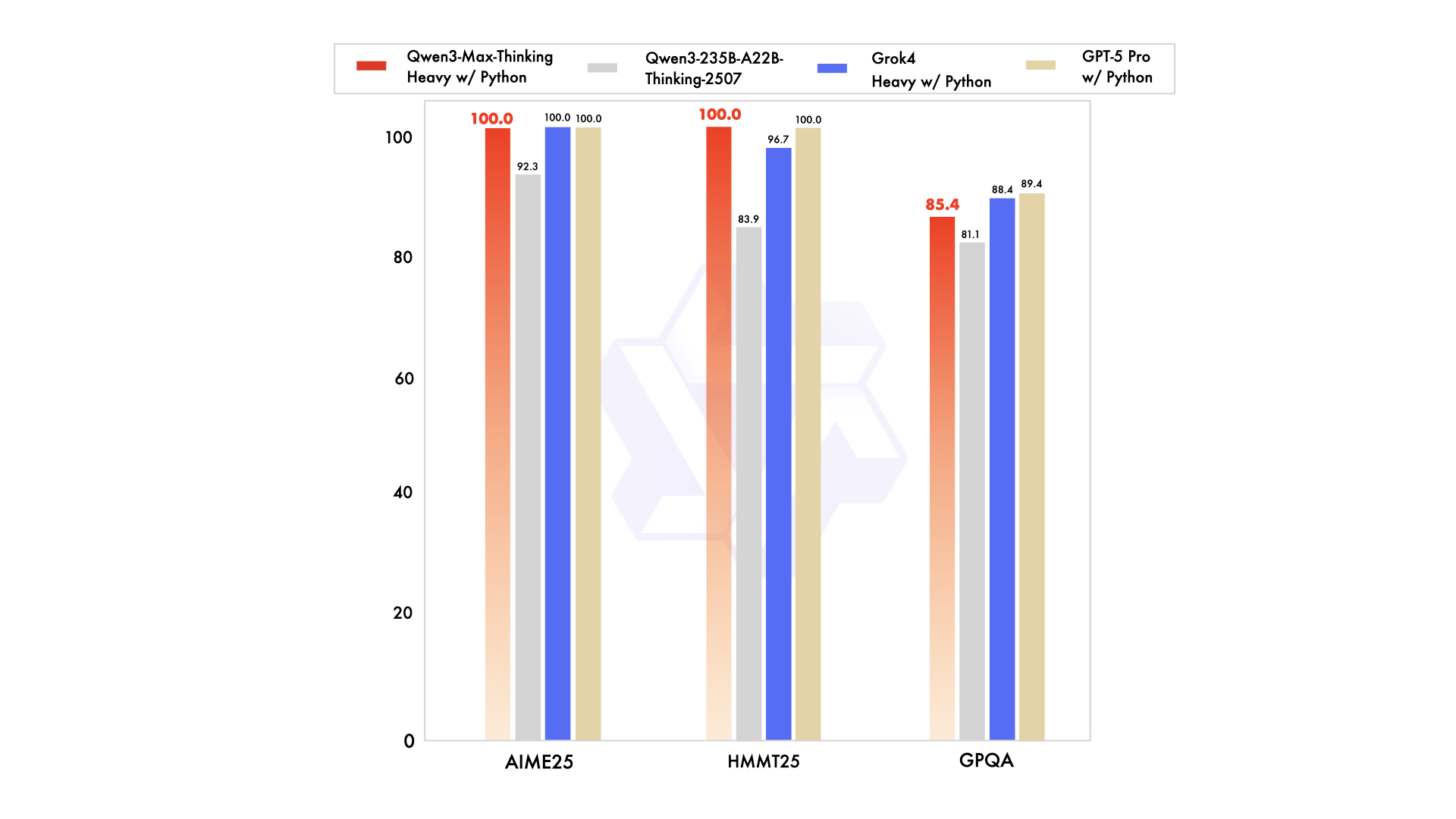

Análise de Desempenho de Benchmark

O Qwen3-Max demonstra resultados excepcionais em múltiplos benchmarks, solidificando sua posição como líder em desempenho de IA. A Alibaba avalia o modelo em testes rigorosos focados em codificação, matemática e raciocínio geral. Por exemplo, no SuperGPQA, o Qwen3-Max-Instruct pontua 65.1, superando o Claude Opus 4 com 56.5 e o DeepSeek-V3.1 com 43.9.

Além disso, no AIME25, um benchmark desafiador de matemática, o Qwen3-Max alcança 81.6, significativamente à frente do Qwen3-235B-A22B com 70.3 e outros. Isso destaca sua proeza na resolução de problemas matemáticos avançados, onde precisão e dedução lógica são cruciais. Passando para as avaliações de codificação, o LiveCodeBench v6 rende uma pontuação de 74.8 para o Qwen3-Max, superando concorrentes como o Non-thinking com 52.3.

Além disso, o Tau2-Bench (Verificado) mostra o Qwen3-Max com 69.6, enquanto o SWE-Bench Verificado registra 72.5, ambos liderando o grupo. Essas pontuações resultam de desafios de codificação do mundo real, onde o modelo resolve problemas de repositórios GitHub de forma eficaz. A Alibaba atribui isso à escalabilidade computacional implacável e a dados massivos de pré-treinamento.

Além disso, o Qwen3-Max se destaca em benchmarks de agente como Arena-Hard v2 e LiveBench, consistentemente classificando-se acima do Claude Opus 4 e do DeepSeek-V3.1. Testes da comunidade revelam evidências anedóticas de comportamento semelhante ao raciocínio em tarefas mais difíceis, produzindo respostas estruturadas apesar de sua base não-racional. No entanto, benchmarks formais confirmam sua confiabilidade, com taxas de sucesso de 100% em áreas como alucinações, conhecimento geral e ética.

Analistas observam que o aumento dos orçamentos de pensamento, quando ativado, impulsiona o desempenho em domínios de matemática, codificação e ciência. Este recurso controlado pelo usuário, acessível no aplicativo Qwen, oferece controle granular sobre a profundidade do raciocínio. No geral, essas métricas ressaltam a eficiência do Qwen3-Max, classificando-o no percentil 63 para velocidade e 34 para preços entre seus pares.

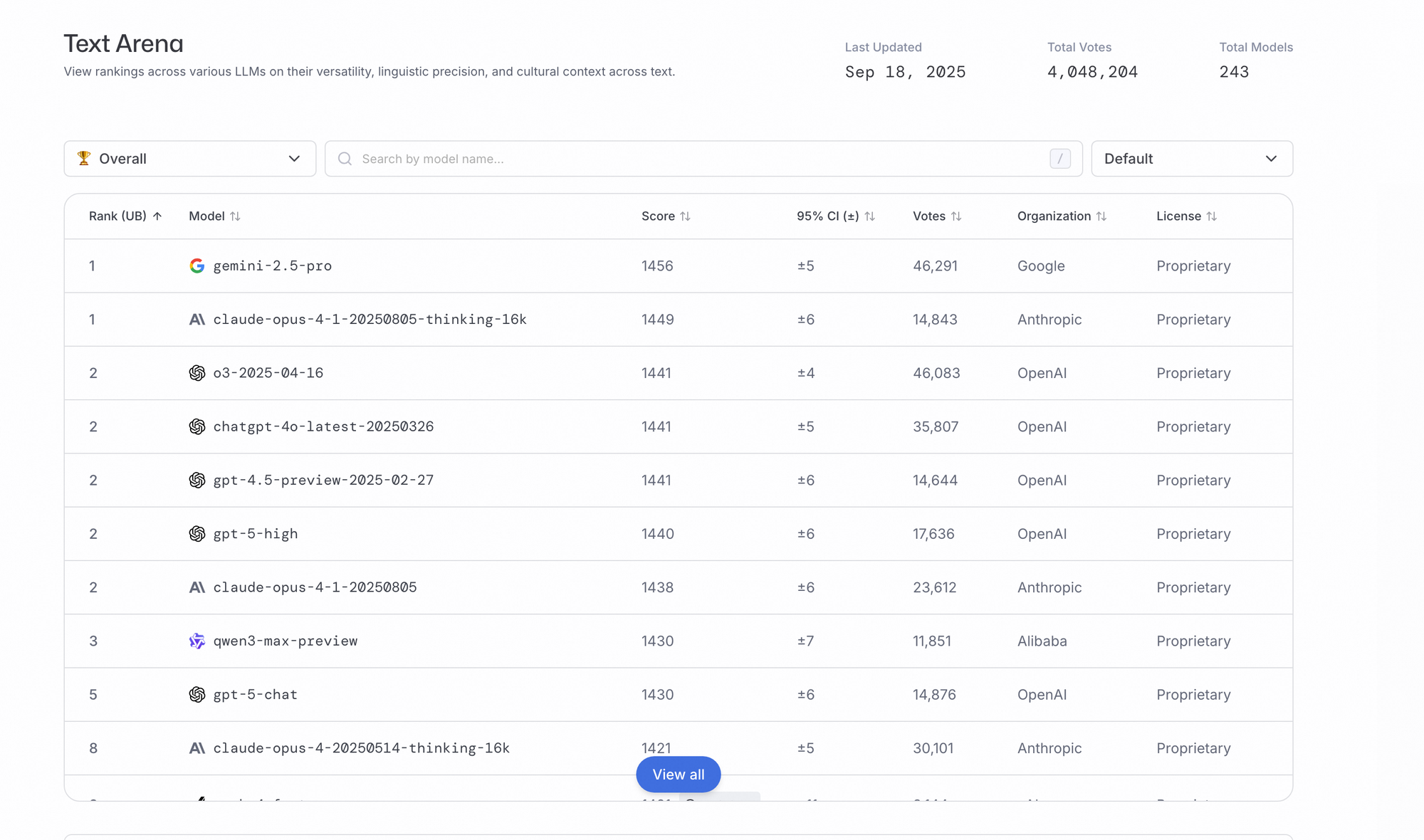

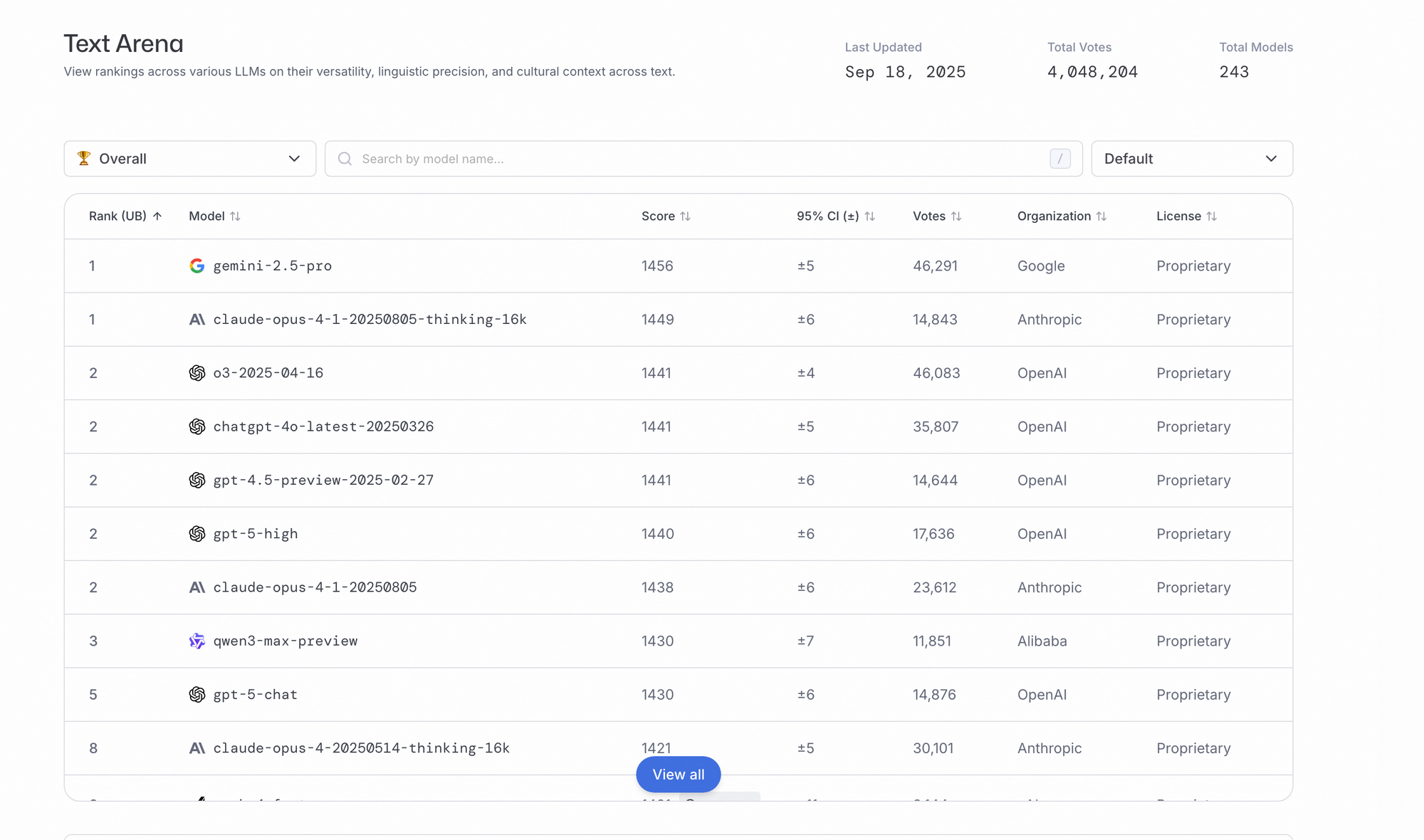

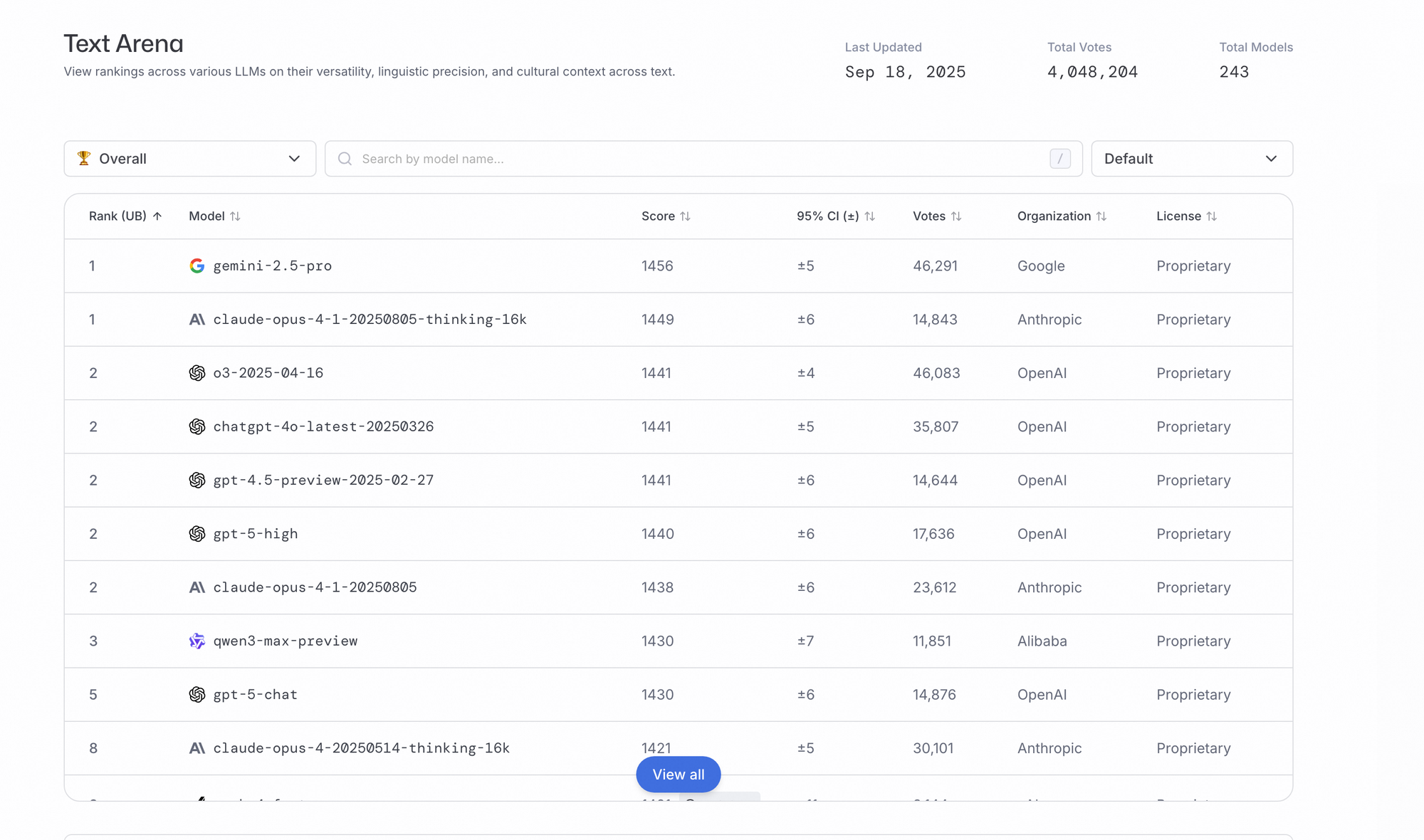

Comparações com Modelos de IA Líderes

O Qwen3-Max compete diretamente com modelos de ponta como GPT-5, Claude 4 Opus e DeepSeek-V3.1. Em tarefas de codificação, o Qwen3-Max supera o DeepSeek-V3.1 em desenvolvimento frontend e conversões Java, embora as melhorias em Python permaneçam modestas. O feedback da comunidade em plataformas como o Reddit destaca seu potencial para igualar ou exceder o GPT-5 Pro antes do final do ano.

Além disso, em comparação com o Claude Opus 4, o Qwen3-Max lidera no SuperGPQA e AIME25, demonstrando capacidades matemáticas e gerais mais fortes. A escala de um trilhão de parâmetros do modelo oferece uma vantagem na cobertura de conhecimento de cauda longa, reduzindo alucinações em comparação com os predecessores. No entanto, os modos de raciocínio do Claude oferecem vantagens em certos cenários, que o Qwen3-Max abordará com futuras atualizações.

Em tarefas multilíngues, o Qwen3-Max suporta mais de 100 idiomas, rivalizando com o Gemini-2.5-Pro e o Grok-3. Os benchmarks mostram resultados competitivos contra estes, particularmente no seguimento de instruções e uso de ferramentas. Em termos de preço, o Qwen3-Max se mostra mais econômico, com taxas escalonadas que superam as opções premium da OpenAI e Anthropic.

Além disso, em comparação com modelos de peso aberto como o Qwen3-235B-A22B, a variante Max aprimora as habilidades de agente sem pensamento profundo, alcançando pontuações mais altas no SWE-Bench e Tau2-Bench. Isso o posiciona como um híbrido entre as forças de código aberto e fechado, embora sua natureza de código fechado gere debates sobre acessibilidade.

Principais Recursos e Capacidades

O Qwen3-Max se destaca no seguimento de instruções para chatbots e escrita. Alucinações reduzidas garantem confiabilidade na classificação e ética.

Recursos de agente lidam com processos de várias etapas via chamada de ferramenta Qwen-Agent. Respostas rápidas são adequadas para aplicativos em tempo real.

Ele suporta chamadas de função compatíveis com OpenAI. Contexto longo auxilia na análise de dados; parâmetros aprimoram a criatividade.

Como não-racional, ele se adapta ao pensamento estruturado. Orçamentos de pensamento futuros ajustam o desempenho do domínio.

Integração e Uso da API com Apidog

Desenvolvedores acessam o Qwen3-Max principalmente através da API da Alibaba Cloud, que suporta endpoints compatíveis com OpenAI. Essa configuração permite uma integração direta em aplicações usando bibliotecas padrão. Por exemplo, usuários chamam a API com prompts como "Por que o céu é azul?" para gerar respostas.

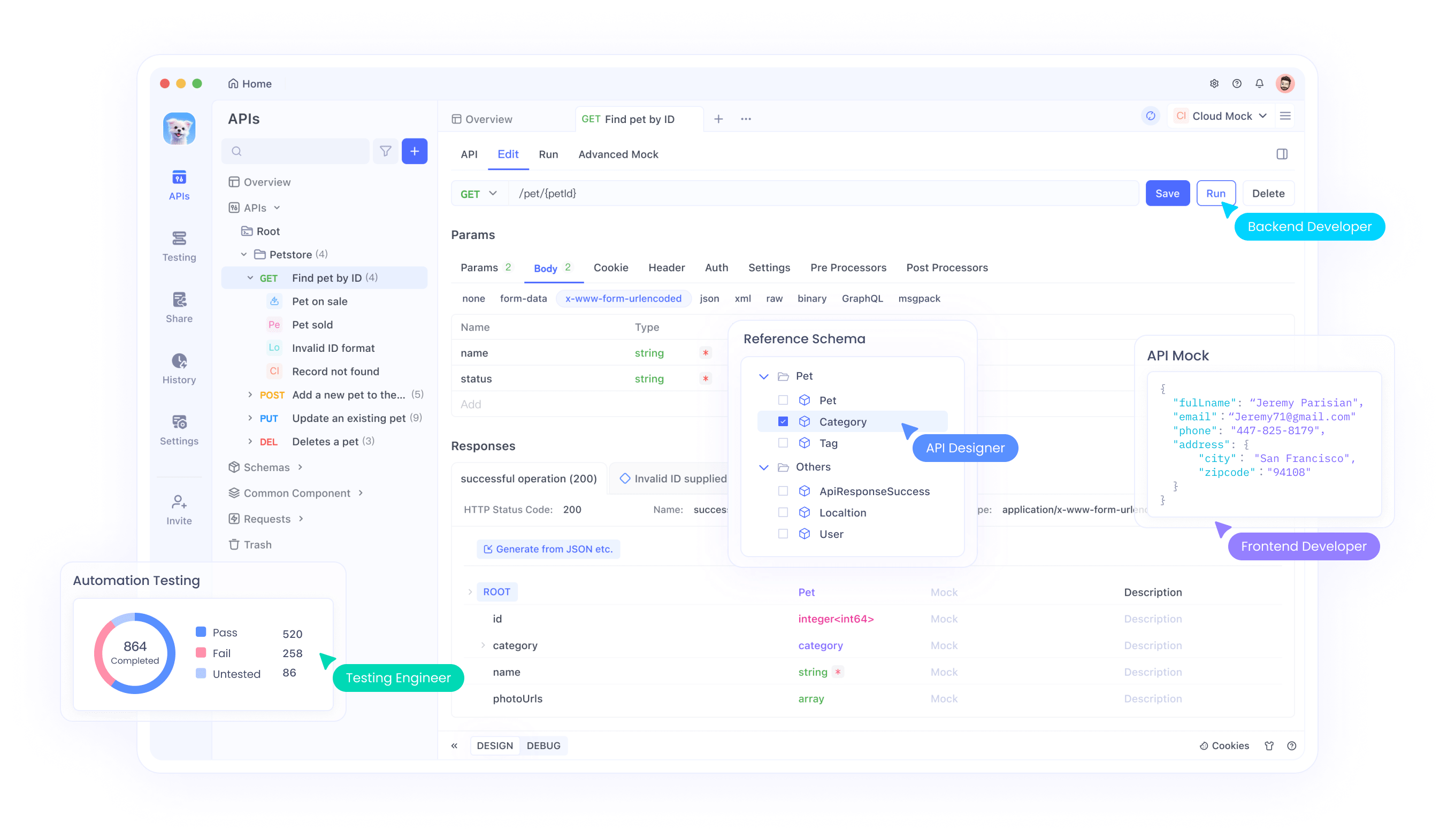

O Apidog desempenha um papel crucial aqui, fornecendo uma plataforma intuitiva para testes e gerenciamento de API. Engenheiros usam o Apidog para simular requisições, monitorar respostas e depurar integrações com o Qwen3-Max. Os recursos da ferramenta, como encadeamento de requisições e variáveis de ambiente, otimizam os fluxos de trabalho ao lidar com grandes volumes de tokens.

Além disso, o Apidog suporta colaboração, permitindo que equipes compartilhem coleções de API para projetos Qwen3-Max. Para começar, baixe o Apidog gratuitamente e importe as especificações da API Qwen da documentação da Alibaba. Isso garante testes eficientes de recursos como cache de contexto, que reduz a latência em tarefas repetitivas.

Adicionalmente, integrações com provedores como OpenRouter e Vercel AI Gateway expandem as opções. O Apidog facilita a troca entre eles, garantindo compatibilidade e monitoramento de desempenho em todos os ecossistemas.

Casos de Uso para o Qwen3-Max

Organizações aplicam o Qwen3-Max em diversos cenários, aproveitando suas capacidades para inovação. No desenvolvimento de software, o modelo auxilia na geração de código e depuração, resolvendo problemas do GitHub com alta precisão no SWE-Bench. Desenvolvedores o integram via API para automatizar pull requests ou refatorar código legado.

Além disso, na educação, o Qwen3-Max resolve problemas matemáticos avançados, auxiliando tutores na explicação de conceitos dos benchmarks AIME25. Seu suporte multilíngue permite que plataformas de aprendizado globais entreguem conteúdo em idiomas nativos.

Em ambientes corporativos, recursos de agente impulsionam ferramentas de automação, como chatbots para atendimento ao cliente ou pipelines de análise de dados. Provedores de saúde o utilizam para suporte a decisões éticas, beneficiando-se de pontuações perfeitas em benchmarks de ética.

Além disso, indústrias criativas empregam o Qwen3-Max para escrita e geração de conteúdo, onde alucinações reduzidas garantem saídas de qualidade. Plataformas de e-commerce o integram para recomendações personalizadas, processando contextos longos de históricos de usuários.

No entanto, em pesquisa, cientistas exploram seu potencial de raciocínio para simulações e testes de hipóteses, antecipando aprimoramentos nos modos de pensamento.

Conclusão

O Qwen3-Max transforma os cenários da IA com sua potência de um trilhão de parâmetros e dominância em benchmarks. Desenvolvedores aproveitam seu poder através de APIs, aprimoradas por ferramentas como o Apidog para uma integração eficiente. À medida que a Alibaba refina o modelo, ele promete inovações ainda maiores em codificação, raciocínio e além. Equipes adotam o Qwen3-Max hoje para se manterem competitivas em um campo em evolução.