No mundo em rápida evolução da inteligência artificial, um novo marco foi alcançado com o lançamento do Qwen 2.5 Omni 7B. Este modelo revolucionário da Alibaba Cloud representa um salto significativo na IA multimodal, combinando a capacidade de processar e entender múltiplas formas de input enquanto gera saídas de texto e fala. Vamos nos aprofundar no que torna este modelo realmente especial e como ele está remodelando nossa compreensão das capacidades da IA.

O verdadeiro significado de "Omni" no Qwen 2.5 Omni 7B

O termo "Omni" no Qwen 2.5 Omni 7B não é apenas uma marca inteligente—é uma descrição fundamental das capacidades do modelo. Ao contrário de muitos modelos multimodais que se destacam em um ou dois tipos de dados, o Qwen 2.5 Omni 7B é projetado desde o início para perceber e entender:

- Texto (linguagem escrita)

- Imagens (informações visuais)

- Áudio (sons e linguagem falada)

- Vídeo (conteúdo visual em movimento com dimensão temporal)

Voice Chat + Video Chat! Just in Qwen Chat (https://t.co/FmQ0B9tiE7)! You can now chat with Qwen just like making a phone call or making a video call! Check the demo in https://t.co/42iDe4j1Hs

— Qwen (@Alibaba_Qwen) 26 de março de 2025

What's more, we opensource the model behind all this, Qwen2.5-Omni-7B, under the… pic.twitter.com/LHQOQrl9Ha

O que é ainda mais impressionante é que este modelo não apenas aceita esses variados inputs—ele pode responder com saídas de texto e fala natural de forma contínua. Essa capacidade "qualquer-para-qualquer" representa um avanço significativo em direção a interações de IA mais naturais e semelhantes às humanas.

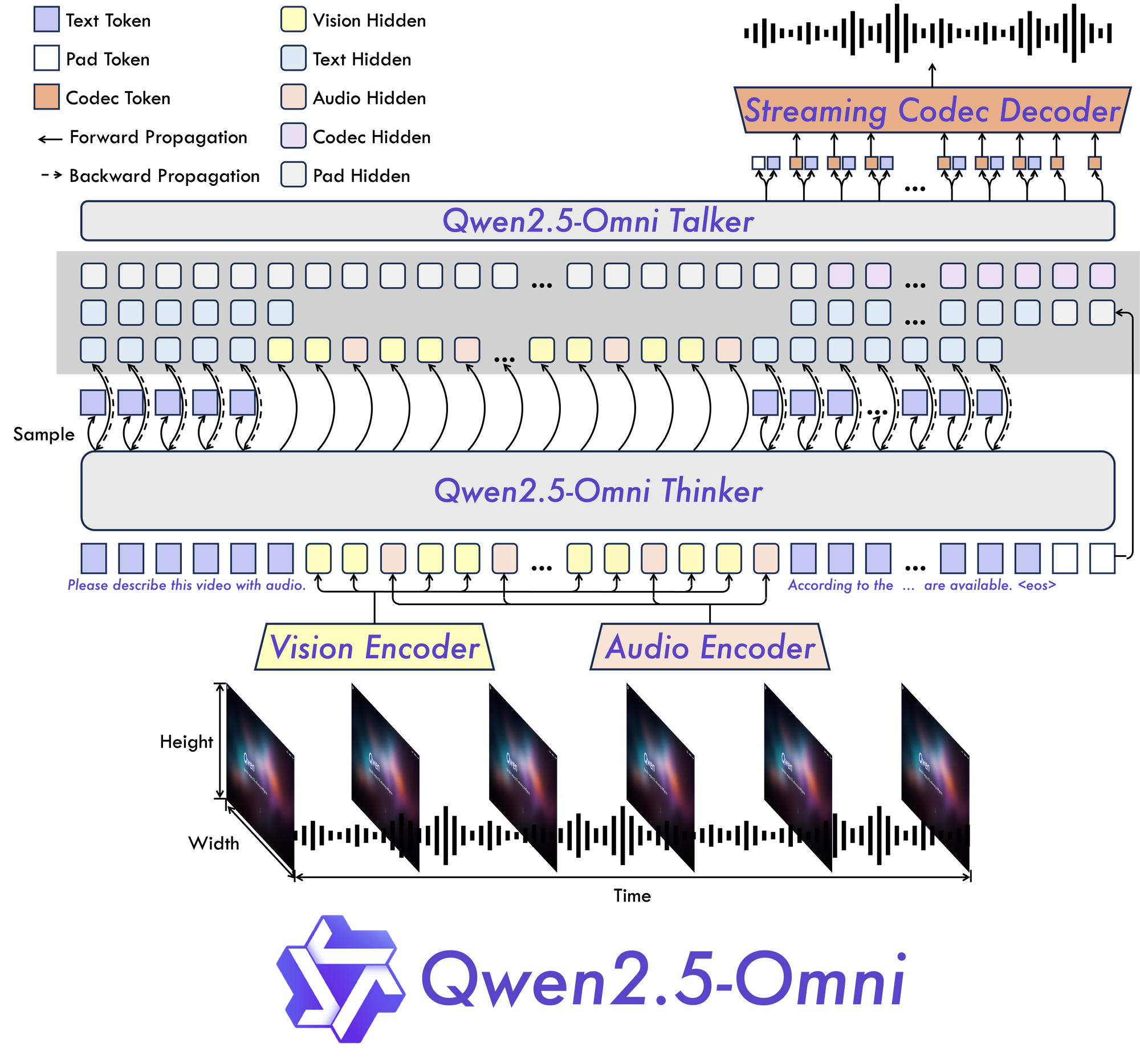

A Arquitetura Inovadora do Qwen 2.5 Omni 7B: Explicada

Thinker-Talker: Um Novo Paradigma

No coração do Qwen 2.5 Omni 7B está sua arquitetura fundamental "Thinker-Talker". Este design inovador cria um modelo especificamente construído para ser end-to-end multimodal, permitindo um processamento contínuo através de diferentes tipos de informações.

Como o nome sugere, essa arquitetura separa o processamento cognitivo da informação (pensar) da geração de saídas (falar). Essa separação permite que o modelo gerencie de maneira eficaz as complexidades inerentes dos dados multimodais e produza respostas apropriadas em múltiplos formatos.

TMRoPE: Resolvendo o Desafio do Alinhamento Temporal

Uma das inovações mais significativas no Qwen 2.5 Omni 7B é seu mecanismo Time-aligned Multimodal RoPE (TMRoPE). Esta inovação enfrenta um dos aspectos mais desafiadores da IA multimodal: sincronizar dados temporais de diferentes fontes.

Ao processar vídeo e áudio simultaneamente, o modelo precisa entender como eventos visuais se alinham com sons ou fala correspondentes. Por exemplo, fazer corresponder os movimentos labiais de uma pessoa com suas palavras faladas requer um alinhamento temporal preciso. O TMRoPE fornece a estrutura sofisticada para alcançar essa sincronização, permitindo que o modelo construa uma compreensão coerente dos inputs multimodais que se desenrolam ao longo do tempo.

Projetado para Interação em Tempo Real

O Qwen 2.5 Omni 7B foi construído com aplicações em tempo real em mente. A arquitetura suporta streaming de baixa latência, permitindo processamento de input em blocos e geração imediata de saídas. Isso o torna ideal para aplicações que exigem interações rápidas, como assistentes de voz, análise de vídeo ao vivo ou serviços de tradução em tempo real.

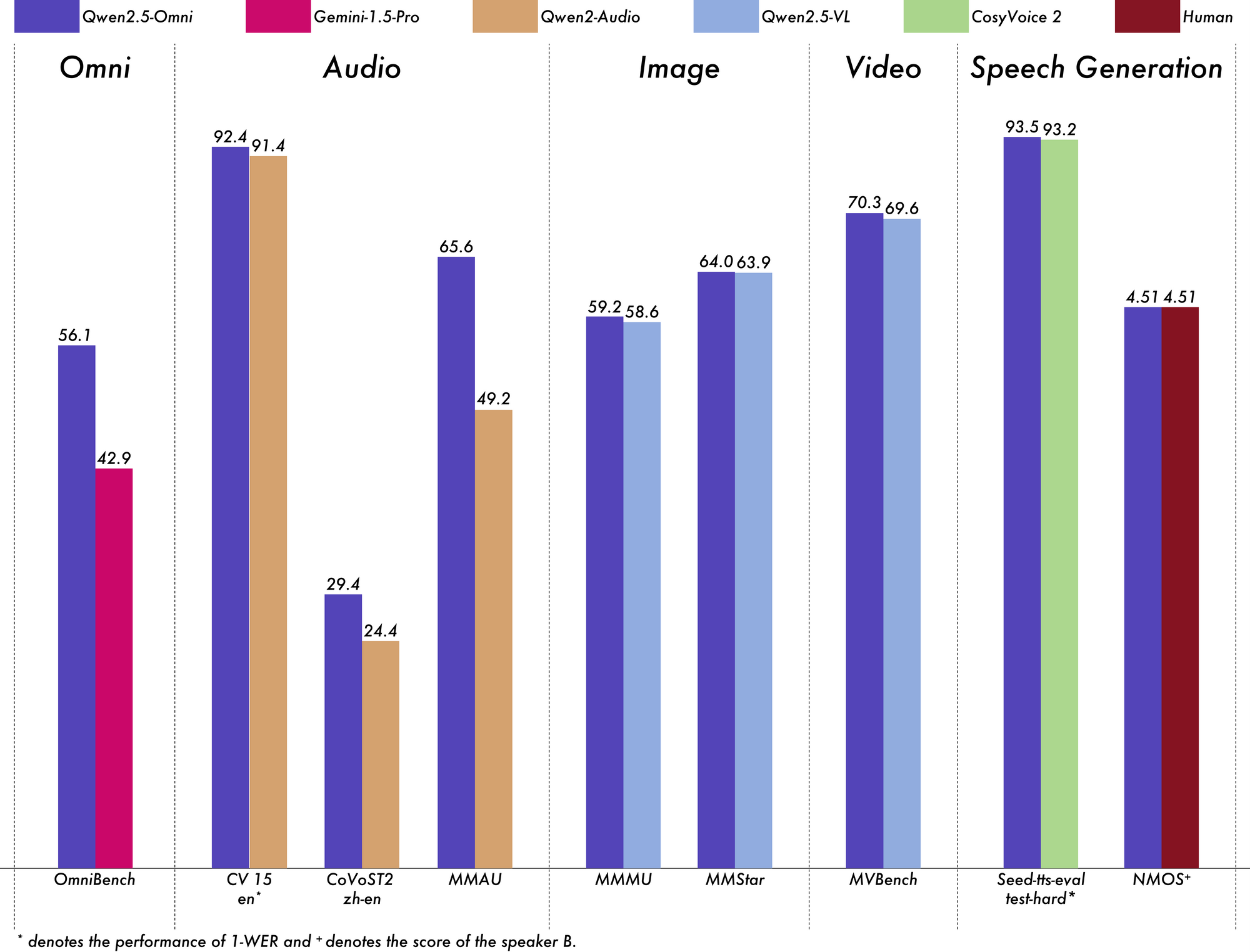

Desempenho do Qwen 2.5 Omni 7B: Os Benchmarks Falam por Si

O verdadeiro teste de qualquer modelo de IA é seu desempenho em benchmarks rigorosos, e o Qwen 2.5 Omni 7B entrega resultados impressionantes em todas as áreas.

Liderando em Compreensão Multimodal

No benchmark OmniBench para compreensão multimodal geral, o Qwen 2.5 Omni 7B alcança uma pontuação média de 56,13%. Isso supera significativamente outros modelos como Gemini-1.5-Pro (42,91%) e MIO-Instruct (33,80%). Seu desempenho excepcional em categorias específicas do OmniBench é particularmente notável:

- Tarefas de fala: 55,25%

- Tarefas de eventos sonoros: 60,00%

- Tarefas de música: 52,83%

Esse desempenho abrangente demonstra a capacidade do modelo de integrar e raciocinar de forma eficaz através de múltiplas modalidades.

Excepcional em Processamento de Áudio

Para tarefas de áudio-para-texto, o Qwen 2.5 Omni 7B apresenta resultados quase de ponta em Reconhecimento Automático de Fala (ASR). No conjunto de dados Librispeech, ele alcança Taxas de Erro de Palavra (WER) variando de 1,6% a 3,5%, comparável a modelos especializados como Whisper-large-v3.

No Reconhecimento de Eventos Sonoros no conjunto de dados Meld, ele atinge um desempenho de melhor classe com uma pontuação de 0,570. O modelo ainda se destaca na compreensão de música, com uma pontuação de 0,88 no benchmark Tempo do GiantSteps.

Forte Compreensão de Imagens

Quando se trata de tarefas de imagem-para-texto, o Qwen 2.5 Omni 7B alcança uma pontuação de 59,2 no benchmark MMMU, notavelmente próximo dos 60,0 do GPT-4o-mini. Na tarefa de RefCOCO Grounding, ele atinge 90,5% de precisão, superando os 73,2% do Gemini 1.5 Pro.

Impressionante Compreensão de Vídeo

Para tarefas de vídeo-para-texto sem legendas, o modelo pontua 64,3 no Video-MME, quase igualando o desempenho de modelos de vídeo especializados. Quando as legendas são adicionadas, o desempenho salta para 72,4, demonstrando a capacidade do modelo de integrar eficazmente múltiplas fontes de informação.

Geração de Fala Natural

O Qwen 2.5 Omni 7B não apenas entende—ele fala. Para geração de fala, alcança pontuações de similaridade de locutor variando de 0,754 a 0,752, comparáveis a modelos dedicados de texto-para-fala como Seed-TTS_RL. Isso demonstra sua capacidade de gerar fala com som natural que mantém as características da voz original do falante.

Mantendo Fortes Capacidades de Texto

Apesar de seu foco multimodal, o Qwen 2.5 Omni 7B ainda apresenta um desempenho admirável em tarefas apenas de texto. Ele alcança resultados sólidos em raciocínio matemático (pontuação GSM8K: 88,7%) e geração de código. Embora haja um pequeno trade-off em comparação com o modelo Qwen2.5-7B apenas de texto (que pontua 91,6% no GSM8K), essa leve queda é um compromisso razoável para obter capacidades multimodais tão abrangentes.

Aplicações do Mundo Real do Qwen 2.5 Omni 7B:

Qwen 2.5 Omni is NUTS!

— Jeff Boudier 🤗 (@jeffboudier) 26 de março de 2025

I can't believe a 7B model

can take text, images, audio, video as input

give text and audio as output

and work so well!

Open source Apache 2.0

Try it, link below!

You really cooked @Alibaba_Qwen ! pic.twitter.com/pn0dnwOqjY

A versatilidade do Qwen 2.5 Omni 7B abre uma ampla gama de aplicações práticas em vários domínios.

Interfaces de Comunicação Aprimoradas

Suas capacidades de streaming de baixa latência o tornam ideal para aplicações de chat de voz e vídeo em tempo real. Imagine assistentes virtuais que podem ver, ouvir e falar naturalmente, entendendo tanto as pistas de comunicação verbal quanto não verbal enquanto respondem com fala natural.

Análise Avançada de Conteúdo

A capacidade do modelo de processar e compreender diversas modalidades o posiciona como uma ferramenta poderosa para análise abrangente de conteúdo. Ele pode extrair insights de documentos multimídia, identificando automaticamente informações-chave de texto, imagens, áudio e vídeo simultaneamente.

Interfaces de Voz Acessíveis

Com seu forte desempenho em seguir instruções de fala de ponta a ponta, o Qwen 2.5 Omni 7B permite uma interação mais natural e verdadeiramente sem as mãos com a tecnologia. Isso pode revolucionar recursos de acessibilidade para usuários com deficiências ou em situações onde a operação sem as mãos é essencial.

Geração de Conteúdo Criativo

A capacidade do modelo de gerar tanto texto quanto fala natural abre novas possibilidades para criação de conteúdo. Desde a geração automática de narrações para vídeos até a criação de materiais educacionais interativos que respondem a perguntas de alunos com explicações apropriadas, as aplicações são vastas.

Serviço ao Cliente Multimodal

As empresas poderiam implementar o Qwen 2.5 Omni 7B para potencializar sistemas de atendimento ao cliente que podem analisar consultas de clientes de múltiplos canais—chamadas de voz, videoconferências, mensagens escritas—e responder de maneira natural e apropriada a cada uma.

Considerações Práticas e Limitações

Embora o Qwen 2.5 Omni 7B represente um avanço significativo em IA multimodal, há algumas considerações práticas a serem levadas em conta ao trabalhar com ele.

Requisitos de Hardware

As capacidades abrangentes do modelo vêm com demandas computacionais substanciais. Processar até mesmo um vídeo relativamente curto de 15 segundos em precisão FP32 requer aproximadamente 93,56 GB de memória GPU. Mesmo com precisão BF16, um vídeo de 60 segundos ainda precisa de cerca de 60,19 GB.

Esses requisitos podem limitar o acesso para usuários sem acesso a hardware de ponta. No entanto, o modelo suporta várias otimizações como Flash Attention 2, que podem ajudar a melhorar o desempenho em hardware compatível.

Personalização do Tipo de Voz

Curiosamente, o Qwen 2.5 Omni 7B suporta múltiplos tipos de voz para suas saídas de áudio. Atualmente, ele oferece duas opções de voz:

- Chelsie: Uma voz feminina descrita como "doce, aveludada" com "quente suavidade e clareza luminosa"

- Ethan: Uma voz masculina caracterizada como "brilhante, animada" com "energia contagiante e um clima acolhedor e acessível"

Essa personalização adiciona mais uma dimensão à flexibilidade do modelo em aplicações do mundo real.

Considerações sobre Integração Técnica

Ao implementar o Qwen 2.5 Omni 7B, vários detalhes técnicos precisam de atenção:

- O modelo requer padrões de solicitação específicos para a saída de áudio

- Configurações consistentes para os parâmetros

use_audio_in_videosão necessárias para conversas apropriadas de múltiplas rodadas - A compatibilidade de URL de vídeo depende de versões específicas de biblioteca (torchvision ≥ 0.19.0 para suporte HTTPS)

- O modelo não está atualmente disponível através da API de Inferência do Hugging Face devido a limitações em suportar modelos "qualquer-para-qualquer"

O Futuro da IA Multimodal

O Qwen 2.5 Omni 7B representa mais do que apenas mais um modelo de IA—é um vislumbre do futuro da inteligência artificial. Ao reunir múltiplas modalidades sensoriais em uma arquitetura unificada e de ponta a ponta, ele nos aproxima de sistemas de IA que podem perceber e interagir com o mundo de maneira mais semelhante aos humanos.

A integração do TMRoPE para alinhamento temporal resolve um desafio fundamental no processamento multimodal, enquanto a arquitetura Thinker-Talker proporciona uma estrutura para combinar efetivamente inputs diversos e gerar saídas apropriadas. Seu forte desempenho em benchmarks demonstra que modelos multimodais unificados podem competir e, às vezes, superar modelos especializados de uma única modalidade.

À medida que os recursos computacionais se tornam mais acessíveis e técnicas para a implementação eficiente de modelos melhoram, podemos esperar ver uma adoção mais ampla de IA realmente multimodal como o Qwen 2.5 Omni 7B. As aplicações abrangem praticamente todas as indústrias—desde saúde e educação até entretenimento e atendimento ao cliente.

Conclusão

O Qwen 2.5 Omni 7B se destaca como uma conquista notável na evolução da IA multimodal. Suas capacidades abrangentes "Omni", arquitetura inovadora e desempenho impressionante entre modalidades estabelecem-no como um exemplo líder da próxima geração de sistemas de inteligência artificial.

Ao combinar a capacidade de ver, ouvir, ler, e falar em um único modelo unificado, o Qwen 2.5 Omni 7B derruba as barreiras tradicionais entre diferentes capacidades de IA. Representa um passo significativo em direção à criação de sistemas de IA que podem interagir com humanos e entender o mundo de maneira mais natural e intuitiva.

Embora existam limitações práticas a serem consideradas, particularmente em relação aos requisitos de hardware, as conquistas do modelo apontam para um futuro empolgante onde a IA pode processar e responder de forma contínua ao rico mundo multimodal que habitamos. À medida que essas tecnologias continuam a evoluir e se tornam mais acessíveis, podemos esperar que transformem a maneira como interagimos com a tecnologia em incontáveis aplicações e domínios.

O Qwen 2.5 Omni 7B não é apenas uma realização tecnológica—é um vislumbre de um futuro onde as fronteiras entre diferentes formas de comunicação começam a se dissolver, criando maneiras mais naturais e intuitivas para humanos e IA interagirem.