A OpenAI tem sido líder no campo da inteligência artificial, avançando continuamente as capacidades dos modelos de machine learning. Sua mais recente oferta, o modelo o3-pro, marca outro marco significativo nesta jornada. Revelado no início de 2025, o o3-pro se destaca por seu desempenho e adaptabilidade excepcionais, tornando-se um divisor de águas no cenário da IA. Este artigo explora os benchmarks, preços e preços da API do o3-pro da OpenAI, fornecendo uma visão detalhada do que torna este modelo uma inovação notável.

Quer uma plataforma integrada, Tudo-em-Um para sua Equipe de Desenvolvedores trabalhar em conjunto com máxima produtividade?

Apidog entrega todas as suas demandas e substitui o Postman por um preço muito mais acessível!

O que é o OpenAI o3-pro?

O modelo o3-pro da OpenAI é um modelo de linguagem de ponta projetado para lidar com uma extensa gama de tarefas com precisão e velocidade impressionantes. Ele se baseia no legado de modelos anteriores como GPT-4 e o1, integrando os mais recentes avanços em processamento de linguagem natural, machine learning e deep learning. Sua arquitetura é ajustada para oferecer processamento rápido e alta precisão, atendendo a uma ampla variedade de aplicações, desde simples geração de texto até resolução de problemas complexos.

I’ve been secretly testing o3-pro for a while now 👀

— Flavio Adamo (@flavioAd) June 10, 2025

Extremely cheaper, faster, and way more precise than o1-pro (and coding with o3 vs o3-pro is night and day)

Got some cool tests coming, starting with (of course) a tougher version of the Hexagon Bauncing ball

o3-pro is the… https://t.co/BDUyA7TXms pic.twitter.com/fG5l7LlGp4

Uma característica definidora do o3-pro é sua capacidade de produzir e compreender texto que espelha de perto a comunicação humana, mantendo coerência e relevância mesmo em cenários complexos. Isso é possível por meio de vastos conjuntos de dados de treinamento, algoritmos avançados e técnicas de treinamento inovadoras. Além do texto, o o3-pro suporta entradas multimodais, lidando perfeitamente com tipos de dados como imagens juntamente com texto, ampliando sua utilidade.

Este modelo se destaca em tarefas que exigem profunda compreensão contextual, como resumir documentos extensos, traduzir idiomas ou responder a perguntas matizadas. Ele também se destaca em empreendimentos criativos, incluindo escrita de narrativas, codificação e até mesmo geração de composições musicais. Com capacidades tão versáteis, o o3-pro está pronto para transformar indústrias como educação, saúde, entretenimento e finanças, oferecendo ferramentas poderosas para indivíduos e organizações.

Benchmarks do OpenAI o3-pro

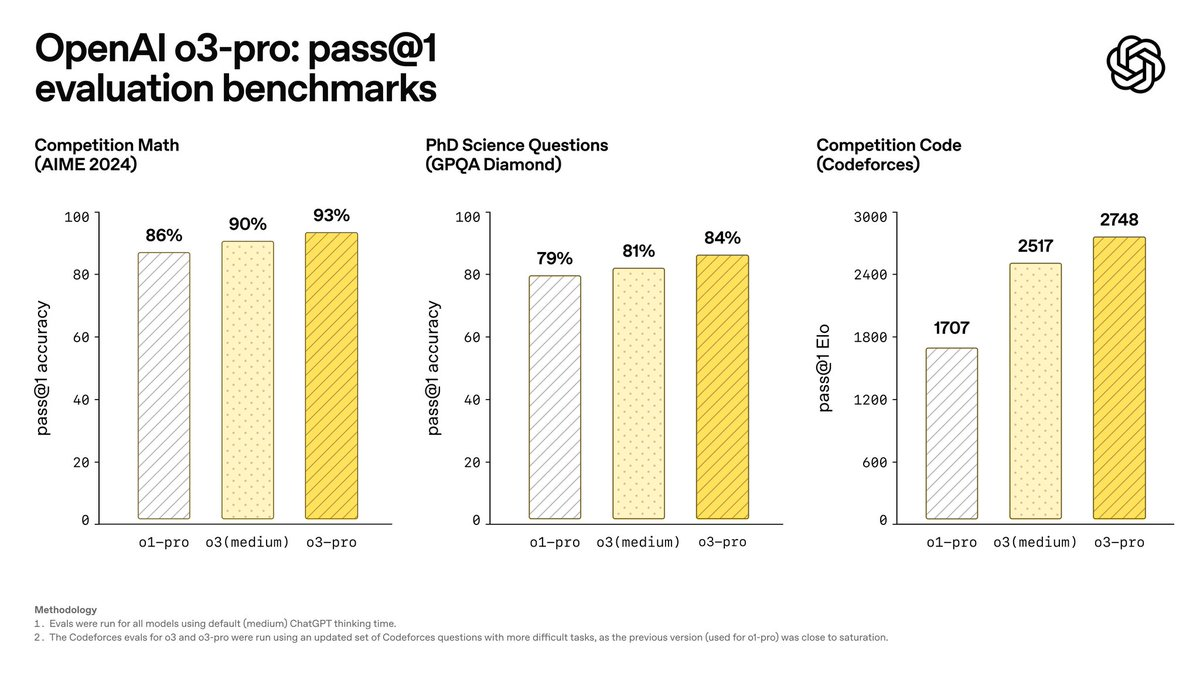

Benchmarks são essenciais para medir o desempenho de um modelo de IA, e o o3-pro elevou o nível em várias métricas. As avaliações internas da OpenAI revelam que o o3-pro se destaca em benchmarks proeminentes de IA, demonstrando sua superioridade em áreas como matemática e conhecimento científico.

No benchmark AIME 2024, que testa a proficiência matemática, o o3-pro supera o modelo líder do Google, Gemini 2.5 Pro. Essa conquista ressalta sua excepcional capacidade de resolver equações complexas e aplicar raciocínio lógico, tornando-o um ativo valioso para aplicações técnicas e acadêmicas.

Da mesma forma, no benchmark GPQA Diamond — uma avaliação rigorosa da compreensão científica em nível de PhD — o o3-pro supera o Claude 4 Opus da Anthropic. Isso demonstra sua compreensão profunda e precisa de conceitos científicos avançados, posicionando-o como uma escolha superior para pesquisa e uso profissional.

Além desses testes específicos, o o3-pro demonstra notáveis pontos fortes na compreensão de linguagem natural, velocidade de geração de texto e desempenho em tarefas multimodais. Sua capacidade de manter a precisão ao processar dados rapidamente o diferencia dos concorrentes. A OpenAI também testou rigorosamente o o3-pro quanto à confiabilidade, submetendo-o a testes de estresse e desafios adversários para garantir que permaneça estável e seguro sob condições exigentes. Esses resultados afirmam o o3-pro como um modelo poderoso e confiável pronto para implantação no mundo real.

Preços do OpenAI o3-pro

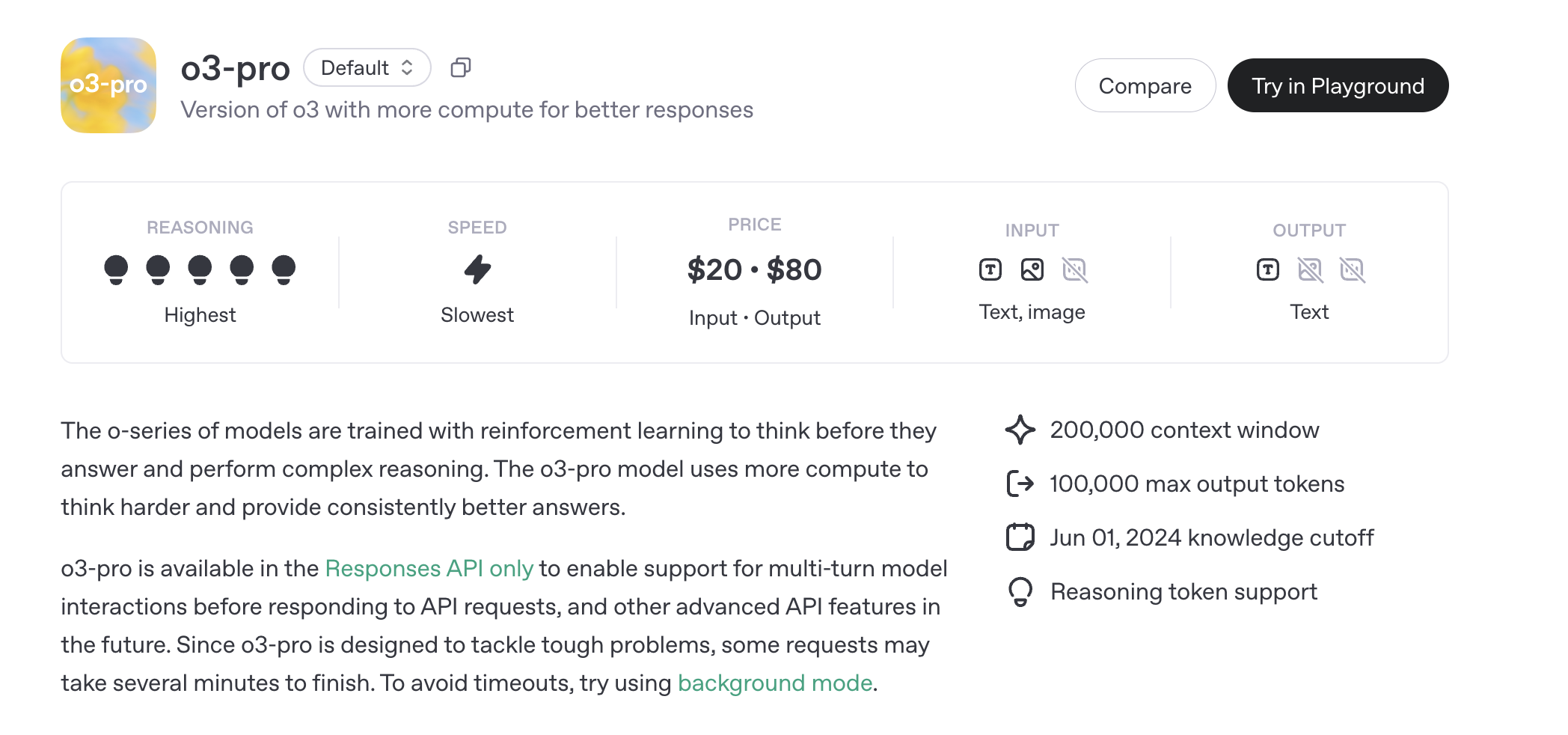

O preço da OpenAI para o o3-pro é estruturado em torno do uso de sua API, sem planos de assinatura autônomos para acesso individual ou empresarial. Em vez disso, os custos estão ligados ao consumo de tokens, refletindo a natureza computacionalmente intensiva do modelo. Abaixo está um detalhamento da estrutura de preços.

Preços da API o3-pro

O modelo o3-pro é acessível apenas através da API de Respostas, com preços baseados no número de tokens processados. Tokens representam pedaços de texto, com aproximadamente 1 milhão de tokens equivalendo a 750.000 palavras — aproximadamente o comprimento de um romance como Guerra e Paz.

- Tokens de Entrada: $20,00 por 1 milhão de tokens

- Tokens de Saída: $80,00 por 1 milhão de tokens

Tokens de saída são mais caros devido à maior demanda computacional para gerar respostas. Para comparação, o modelo o3 padrão custa $2,00 por milhão de tokens de entrada e $8,00 por milhão de tokens de saída, enquanto o o3-mini é ainda mais barato, a $1,10 e $4,40, respectivamente. O custo elevado do o3-pro reflete seu raciocínio aprimorado e requisitos computacionais.

Custos adicionais podem ser aplicados para recursos específicos de ferramentas, como pesquisa de arquivos ou geração de imagens, que incorrem em taxas por chamada. Por exemplo, usar a ferramenta de pesquisa de arquivos ou integrar a geração de imagens via API aumentará o custo total com base no uso.

Preços da API Batch o3-pro

Para usuários de alto volume, a OpenAI oferece uma opção de API Batch, que processa solicitações de forma assíncrona para eficiência de custo. O preço da API Batch para o o3-pro espelha as taxas padrão: $20,00 por milhão de tokens de entrada e $80,00 por milhão de tokens de saída. Isso é ideal para aplicações que exigem processamento em larga escala, como análise de dados ou geração de conteúdo em massa.

Preços Empresariais e Personalizados

Empresas com uso extensivo da API podem negociar planos de preços personalizados, que podem incluir descontos por volume e suporte aprimorado. Esses planos são adaptados à escala do projeto, garantindo custo-benefício para implantações em larga escala. A OpenAI também oferece recursos de fine-tuning, permitindo que os desenvolvedores personalizem o o3-pro para tarefas específicas, embora isso incorra em custos adicionais com base em recursos computacionais.

Descontos e Acessibilidade

Para promover a acessibilidade, a OpenAI oferece taxas reduzidas para instituições educacionais e organizações sem fins lucrativos. Organizações elegíveis podem solicitar descontos, tornando o o3-pro mais acessível para pesquisa acadêmica ou projetos de impacto social. Promoções periódicas também podem reduzir os custos para usuários novos ou de alto volume.

Limites de Taxa do o3-pro

Limites de taxa são críticos para garantir acesso justo e confiável à API, limitando o número de solicitações ou tokens processados dentro de um determinado período. Os limites de taxa da OpenAI para o o3-pro variam por nível de uso, escalando automaticamente à medida que os usuários aumentam sua atividade e gastos com a API.

Abaixo está um detalhamento dos níveis e seus respectivos limites:

- Nível Gratuito: Não suportado para o3-pro.

- Nível 1: 500 solicitações por minuto (RPM), 30.000 tokens por minuto (TPM), limite de fila batch de 90.000.

- Nível 2: 5.000 RPM, 450.000 TPM, limite de fila batch de 1.350.000.

- Nível 3: 5.000 RPM, 800.000 TPM, limite de fila batch de 50.000.000.

- Nível 4: 10.000 RPM, 2.000.000 TPM, limite de fila batch de 200.000.000.

- Nível 5: 10.000 RPM, 30.000.000 TPM, limite de fila batch de 5.000.000.000.

Níveis mais altos desbloqueiam maior capacidade, permitindo que os desenvolvedores lidem com cargas de trabalho maiores. O limite da fila batch governa o número de tokens que podem ser enfileirados para processamento assíncrono, crítico para usuários da API Batch. Esses limites garantem acesso equitativo, ao mesmo tempo que acomodam diversos casos de uso, desde pequenos aplicativos até soluções de nível empresarial.

Recursos e Limitações da API o3-pro

O modelo o3-pro suporta uma gama de endpoints e recursos da API, embora alguns não estejam disponíveis devido ao seu design computacionalmente pesado:

- Endpoints Suportados: Chat Completions, Responses, Assistants, Batch, Fine-tuning, Embeddings, Image Generation, Image Edit, Speech Generation, Transcription, Translation, Moderation.

- Endpoints Não Suportados: Realtime, Completions (legado).

- Recursos:

- Chamada de Função: Suportada, permitindo integração com ferramentas externas.

- Saídas Estruturadas: Suportadas, garantindo formatos de resposta consistentes.

- Ferramentas: Pesquisa de arquivos, geração de imagens e MCP (Model Control Protocol) são suportados via API de Respostas. Pesquisa na web, interpretador de código e uso de computador não são suportados.

- Limitações:

- Streaming não é suportado, refletindo o processamento mais lento e deliberado do modelo.

- Fine-tuning está disponível, mas não destilação ou saídas preditas.

- Entradas de áudio não são suportadas; apenas entradas de texto e imagem são aceitas.

Snapshots, como o3-pro-2025-06-10, permitem que os usuários bloqueiem uma versão específica do modelo para desempenho consistente, garantindo estabilidade para ambientes de produção.

Conclusão

O o3-pro da OpenAI é um modelo de IA poderoso, destacando-se em raciocínio complexo e entregando desempenho de ponta em benchmarks como AIME 2024 e GPQA Diamond. Seu preço — $20 por milhão de tokens de entrada e $80 por milhão de tokens de saída — reflete sua natureza computacionalmente intensiva, com opções de API Batch e empresariais oferecendo flexibilidade para usuários de alto volume. Limites de taxa, escalando do Nível 1 ao Nível 5, garantem acesso justo, ao mesmo tempo que suportam diversas cargas de trabalho.

Disponível exclusivamente via API de Respostas, a janela de contexto de 200.000 tokens do o3-pro e o suporte a ferramentas como pesquisa de arquivos e geração de imagens o tornam uma escolha versátil para desenvolvedores. Apesar de sua velocidade mais lenta e custos mais altos em comparação com o3 e o3-mini, suas capacidades de raciocínio inigualáveis o posicionam como uma solução líder para lidar com as tarefas de IA mais desafiadoras. À medida que a OpenAI continua a inovar, o o3-pro se destaca como um testemunho do potencial transformador da IA avançada, impulsionando o progresso em indústrias e aplicações.

Quer uma plataforma integrada, Tudo-em-Um para sua Equipe de Desenvolvedores trabalhar em conjunto com máxima produtividade?

Apidog entrega todas as suas demandas e substitui o Postman por um preço muito mais acessível!