A OpenAI expandiu sua linha de modelos de IA poderosos com o o1-pro, uma nova oferta projetada para tarefas avançadas de raciocínio e resolução de problemas. Como parte da evolução da OpenAI além da série GPT, os modelos "o" representam sistemas de IA especializados otimizados para casos de uso específicos. Neste guia abrangente, vamos explorar tudo o que você precisa saber sobre o o1-pro, incluindo suas capacidades, estrutura de preços e como implementá-lo em suas aplicações através de vários métodos, incluindo ferramentas de teste de API como o Apidog.

botão

O que é o o1-pro? E quão bom ele é?

o1-pro é o modelo especializado da OpenAI para tarefas de raciocínio complexo. Ele faz parte da família de modelos "o1" que se destacam em pensar passo a passo e resolver problemas. A variante "pro" oferece capacidades aprimoradas em relação ao modelo base, tornando-o adequado para aplicações exigentes que requerem raciocínio sofisticado.

Diferentemente de modelos mais genéricos como o GPT-4o, o o1-pro foi especificamente ajustado para tarefas que exigem progresso lógico, raciocínio matemático e análise estruturada. Esse foco especializado permite que ele tenha um desempenho excepcional em áreas onde o pensamento metódico e a decomposição de problemas são cruciais.

O o1-pro foi projetado com as seguintes forças:

- Raciocínio Avançado: Destaca-se em decompor problemas complexos em etapas lógicas, tornando-o ideal para tarefas que exigem pensamento e análise estruturados. Ele pode navegar em árvores de decisão complexas e fornecer caminhos de raciocínio explícitos.

- Resolução de Problemas Matemáticos: Lida com raciocínio matemático, provas e cálculos com precisão aprimorada. O modelo demonstra força particular em álgebra, cálculo, estatística e lógica formal.

- Análise de Código: Capaz de analisar, depurar e explicar código com compreensão detalhada. Ele pode trabalhar com várias linguagens de programação e identificar erros lógicos ou oportunidades de otimização.

- Pensamento Estruturado: Produz respostas mais claras e estruturadas para consultas complexas, com decomposições naturais de problemas multifásicos e raciocínio claramente delineado.

- Pesquisa e Análise: Realiza análises profundas de tópicos com organização lógica, comparando diferentes perspectivas e avaliando evidências de forma metódica.

- Processamento em Cadeia de Raciocínio: Mostra explicitamente seu processo de raciocínio, facilitando o acompanhamento de linhas de pensamento complexas e a verificação de conclusões.

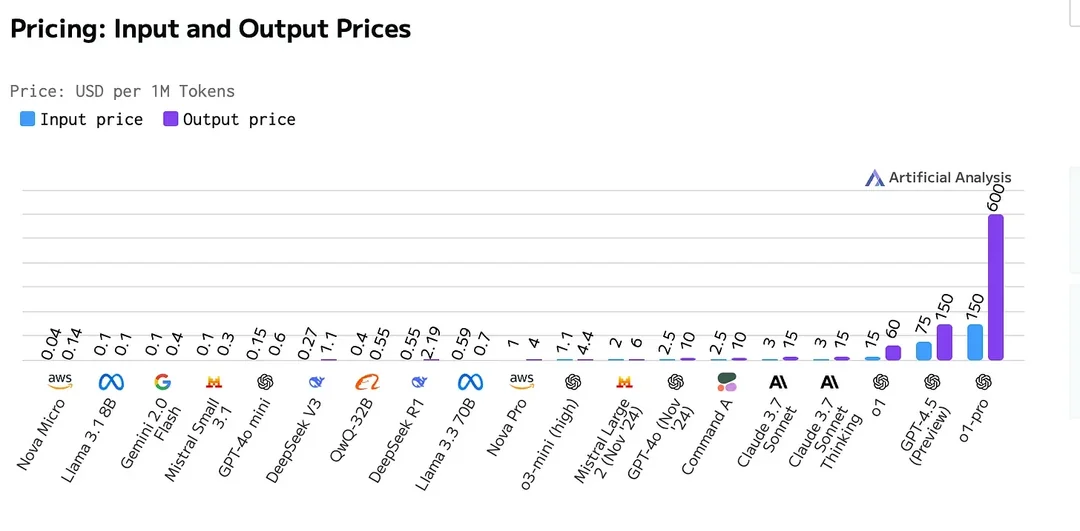

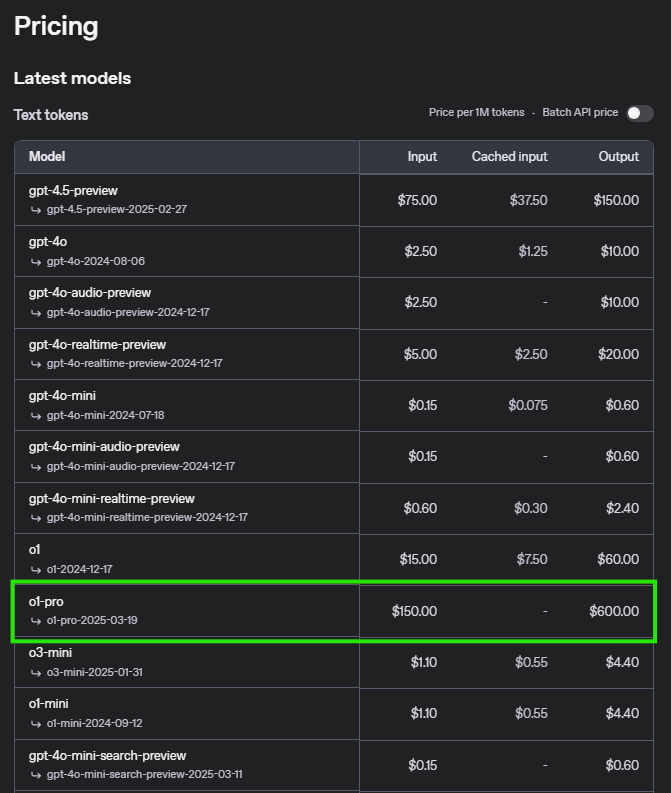

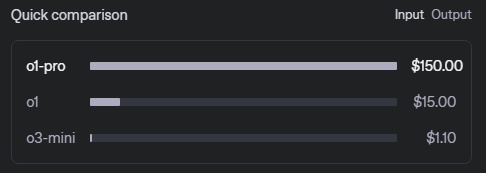

Preços da API o1-pro

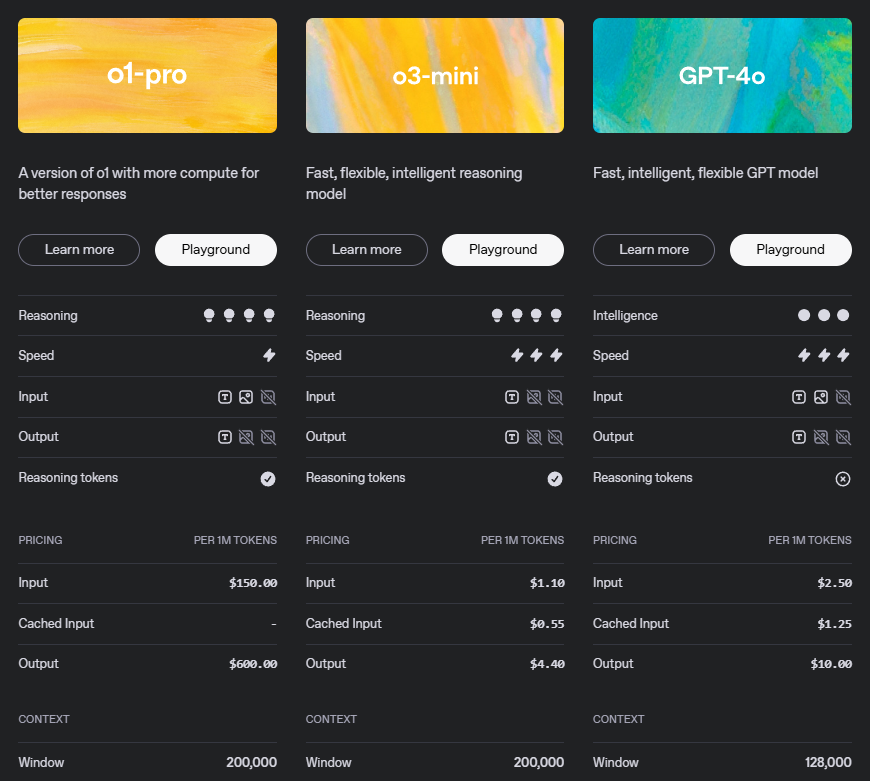

Compreender a estrutura de preços é essencial para planejar seu uso da API. Aqui está a divisão detalhada para o o1-pro:

Este modelo de preços reflete as capacidades sofisticadas do o1-pro, particularmente seu raciocínio avançado e qualidade de saída. O custo mais alto para os tokens de saída reconhece o valor das respostas estruturadas e bem fundamentadas que o modelo gera.

Cenários de Exemplo de Preço

| Operação | Preço |

|---|---|

| Entrada (Prompt) | $5 por milhão de tokens |

| Saída (Conclusão) | $15 por milhão de tokens |

Cenário 1: Uso em pequena escala

Para um cenário com 500.000 tokens de entrada e 200.000 tokens de saída:

- Custo de entrada: 500.000 tokens × 5/milhão de tokens = 2,50

- Custo de saída: 200.000 tokens × 15/milhão de tokens = 3,00

- Custo total: $5,50

Cenário 2: Uso em média escala

Para um cenário com 5 milhões de tokens de entrada e 2 milhões de tokens de saída:

- Custo de entrada: 5.000.000 tokens × 5/milhão de tokens = 25,00

- Custo de saída: 2.000.000 tokens × 15/milhão de tokens = 30,00

- Custo total: $55,00

Cenário 3: Uso em grande escala

Para um cenário com 50 milhões de tokens de entrada e 20 milhões de tokens de saída:

- Custo de entrada: 50.000.000 tokens × 5/milhão de tokens = 250,00

- Custo de saída: 20.000.000 tokens × 15/milhão de tokens = 300,00

- Custo total: $550,00

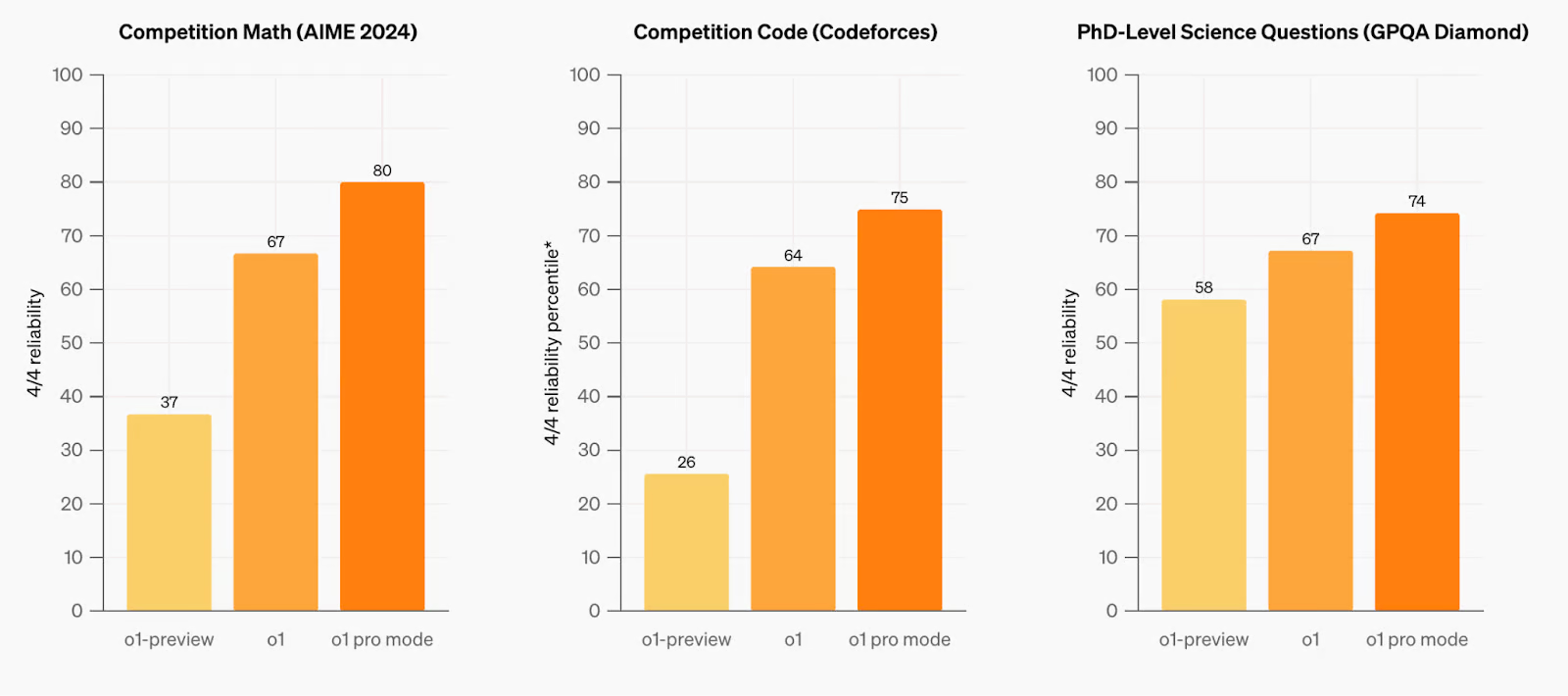

Comparação com Modelos Anteriores

o1-pro demonstra avanços notáveis em raciocínio, resolução de problemas e compreensão de contextos longos. O modelo foi rigorosamente testado em vários benchmarks, mostrando melhorias em relação aos seus predecessores no manuseio de consultas complexas e tarefas de raciocínio multifásico. Em domínios-chave como matemática, codificação e planejamento estruturado, o o1-pro exibe maior precisão e confiabilidade, superando modelos anteriores em desempenho e eficiência. Sua arquitetura otimizada permite uma melhor compreensão de solicitações intrincadas, tornando-o um forte candidato para aplicações avançadas que exigem raciocínio de alto nível e capacidades de contexto estendido.

Você pode encontrar a comparação completa dos modelos da OpenAI, incluindo especificações detalhadas e benchmarks, na página oficial de documentação da OpenAI.

Requisitos e Limites da API OpenAI O1 Pro

| Nível | Qualificação | Limites de Uso |

|---|---|---|

| Gratuito | O usuário deve estar em uma geografia permitida | $100/mês |

| Nível 1 | $5 pago | $100/mês |

| Nível 2 | $50 pago e 7+ dias desde o primeiro pagamento bem-sucedido | $500/mês |

| Nível 3 | $100 pago e 7+ dias desde o primeiro pagamento bem-sucedido | $1.000/mês |

| Nível 4 | $250 pago e 14+ dias desde o primeiro pagamento bem-sucedido | $5.000/mês |

| Nível 5 | $1.000 pago e 30+ dias desde o primeiro pagamento bem-sucedido | $50.000/mês |

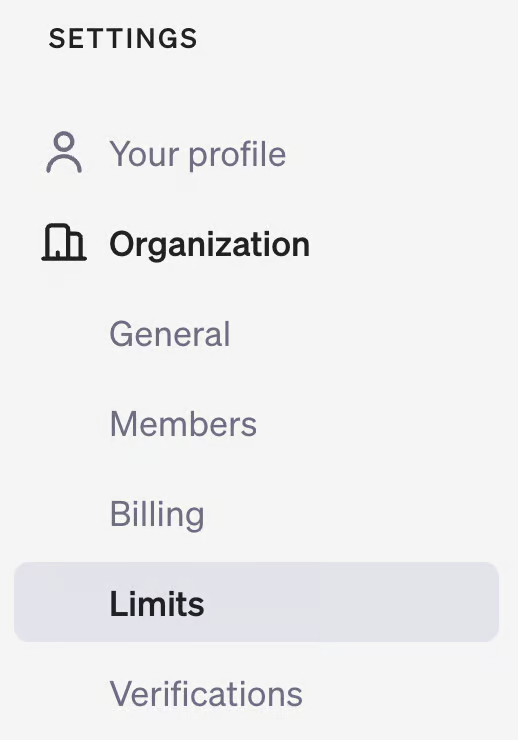

Para verificar seu nível de uso, visite sua página de conta na plataforma de desenvolvedor da OpenAI e verifique a seção "Limites" em "Organização".

Como Usar a API o1

Implementar o o1-pro em suas aplicações é simples. Siga estas etapas para começar:

1. Pré-requisitos

- Uma chave de API da OpenAI (obtenha no seu painel da OpenAI)

- Um ambiente de desenvolvimento compatível com bibliotecas apropriadas

- Créditos suficientes de API ou um método de pagamento vinculado à sua conta da OpenAI

2. Instalação

Instale a biblioteca OpenAI para sua linguagem de programação preferida:

Para Python:

pip install openai

Para JavaScript:

npm install openai

Para outras linguagens, consulte a documentação oficial da OpenAI para bibliotecas cliente.

3. Exemplo de Implementação em Python

Aqui está como usar o o1-pro em Python com parâmetros detalhados:

from openai import OpenAI

client = OpenAI(api_key="sua-chave-api")

response = client.chat.completions.create(

model="o1-pro",

messages=[

{"role": "system", "content": "Você é um assistente de IA especializado em raciocínio matemático. Forneça soluções claras, passo a passo, com explicações para cada etapa."},

{"role": "user", "content": "Resolva este problema de cálculo passo a passo: encontre a derivada de f(x) = x^3*ln(x)."}

],

temperature=0.1, # Temperatura mais baixa para raciocínio mais preciso

max_tokens=1024, # Ajuste com base na expectativa de comprimento da resposta

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

print(response.choices[0].message.content)

4. Exemplo de Implementação em JavaScript

Para aplicações Node.js com configuração mais detalhada:

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'sua-chave-api',

});

async function askO1Pro() {

try {

const response = await openai.chat.completions.create({

model: 'o1-pro',

messages: [

{role: 'system', content: 'Você é um assistente de IA especializado em raciocínio lógico. Forneça soluções claras, passo a passo, com explicações para cada etapa.'},

{role: 'user', content: 'Analise o seguinte argumento lógico e identifique quaisquer falácias: Todas as aves podem voar. Os pinguins são aves. Portanto, os pinguins podem voar.'}

],

temperature: 0.1,

max_tokens: 1024,

top_p: 0.95,

frequency_penalty: 0,

presence_penalty: 0

});

console.log(response.choices[0].message.content);

// Opcional: Acompanhe o uso de tokens

console.log("Tokens do prompt:", response.usage.prompt_tokens);

console.log("Tokens de conclusão:", response.usage.completion_tokens);

console.log("Total de tokens:", response.usage.total_tokens);

} catch (error) {

console.error('Erro:', error);

}

}

askO1Pro();

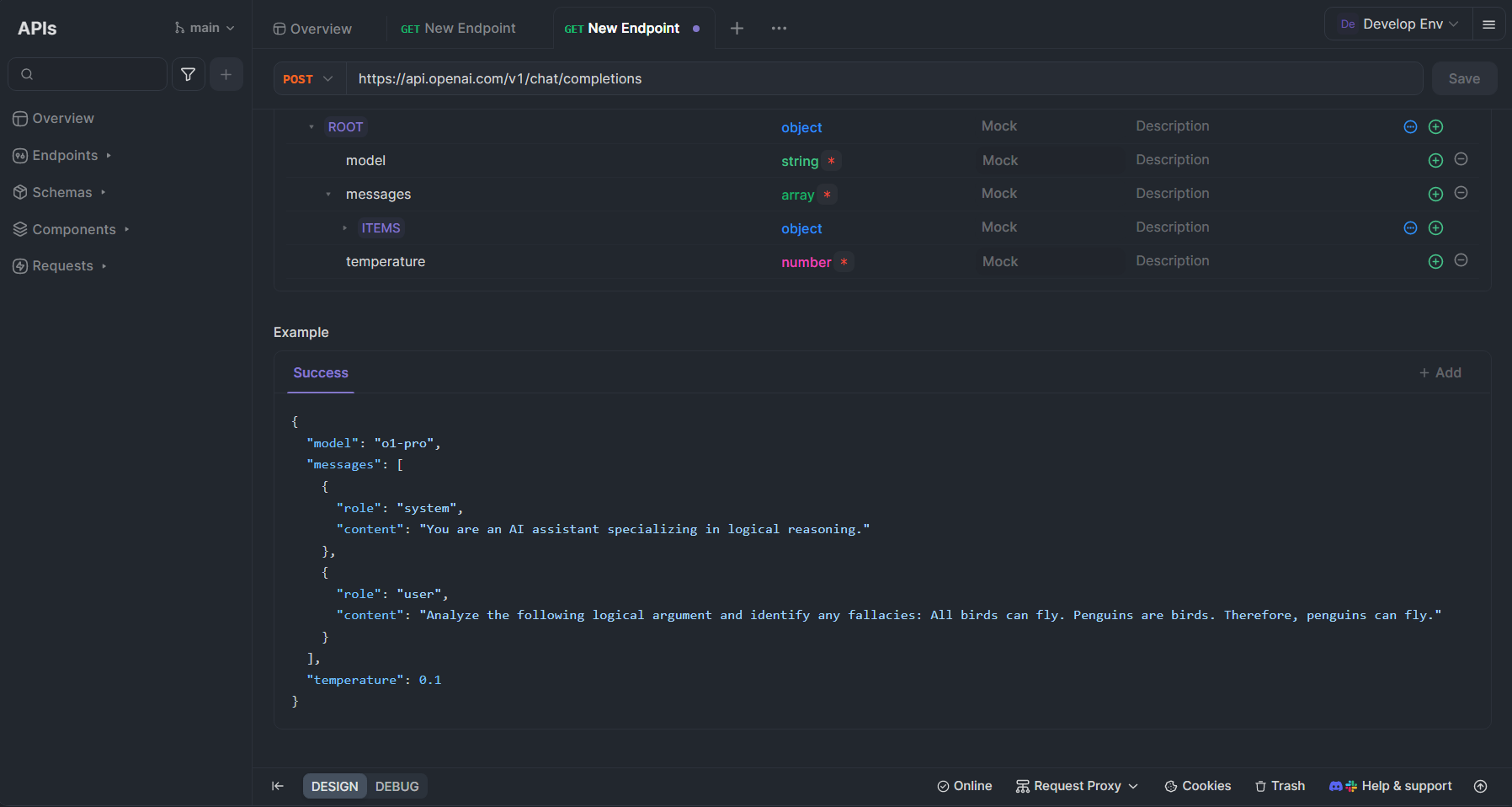

Testando a API o1-pro com Apidog

Apidog é uma plataforma abrangente de desenvolvimento de API que pode agilizar significativamente seu trabalho com o o1-pro e outras APIs da OpenAI. Veja como você pode aproveitar o Apidog para testar e integrar o o1-pro ao seu fluxo de trabalho:

Configurando o o1-pro no Apidog

- Criar uma Conta: Cadastre-se no Apidog em apidog.com se você ainda não tiver uma conta.

- Criar uma Nova Coleção de API: No seu painel do Apidog, crie uma nova coleção especificamente para as APIs da OpenAI.

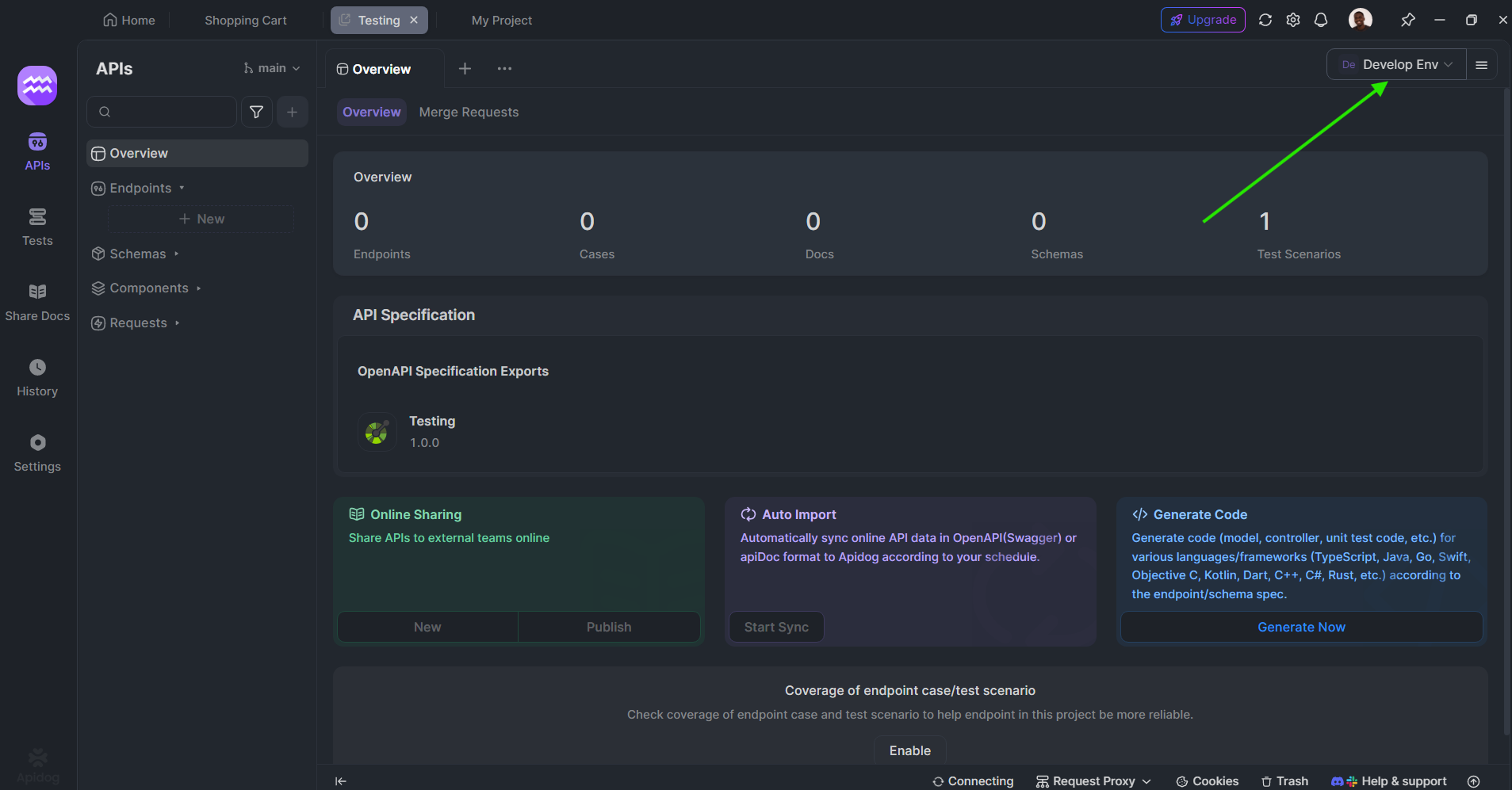

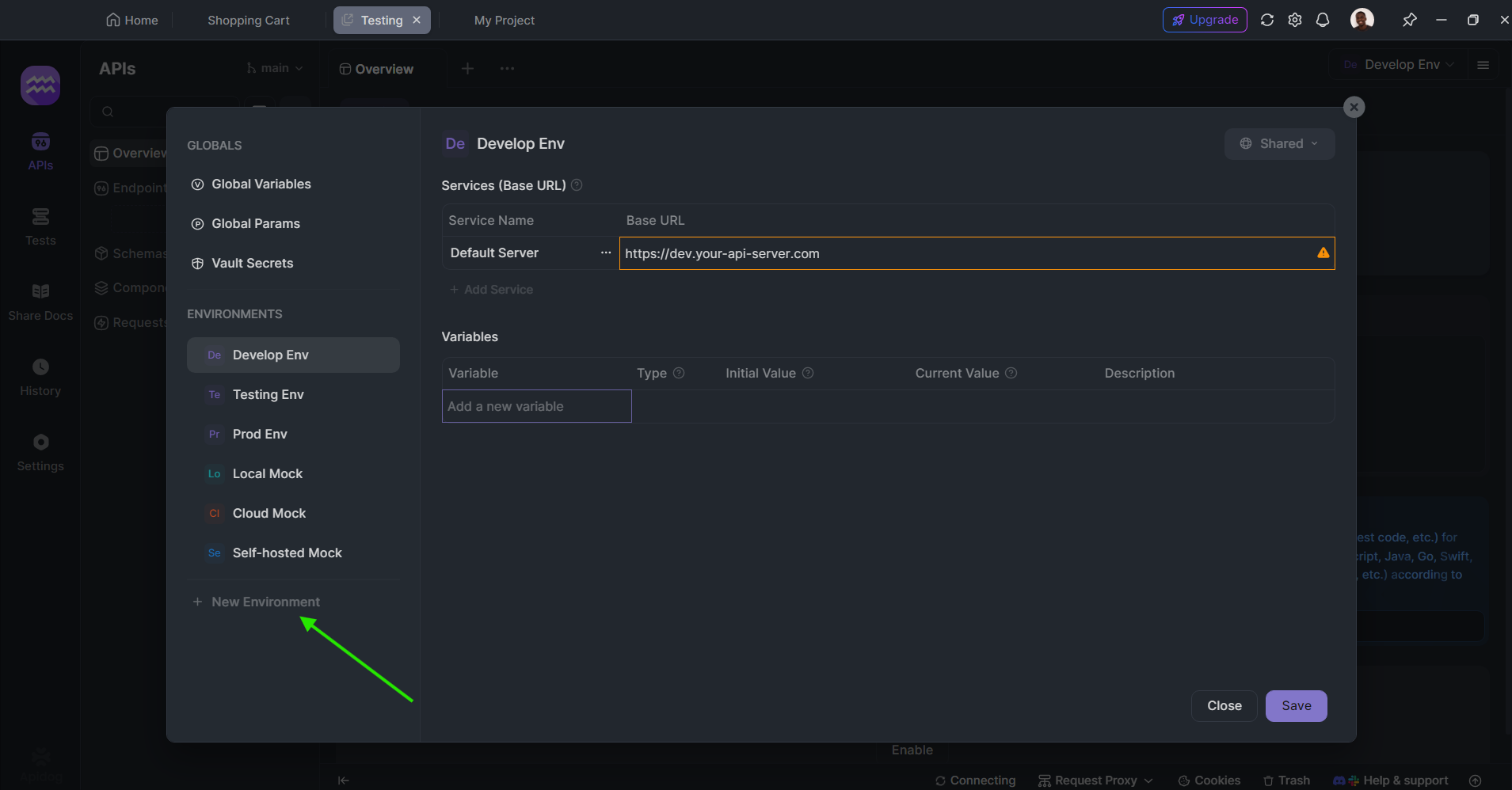

Definir Variáveis de Ambiente: Configure sua chave de API da OpenAI como uma variável de ambiente para acesso seguro e conveniente:

- Vá para Ambientes no canto superior direito

- Crie um novo ambiente chamado "OpenAI"

- Adicione uma variável nomeada "OPENAI_API_KEY" com sua chave API real como valor

Criar uma Solicitação para o o1-pro:

- Criar um novo pedido POST

- Defina a URL para

https://api.openai.com/v1/chat/completions - Adicione um cabeçalho de Autorização com o valor

Bearer {{OPENAI_API_KEY}} - No corpo da solicitação (JSON), use:

{

"model": "o1-pro",

"messages": [

{

"role": "system",

"content": "Você é um assistente de IA especializado em raciocínio lógico."

},

{

"role": "user",

"content": "Analise o seguinte argumento lógico e identifique quaisquer falácias: Todas as aves podem voar. Os pinguins são aves. Portanto, os pinguins podem voar."

}

],

"temperature": 0.1

}

Benefícios de Usar Apidog com o o1-pro

O Apidog oferece várias vantagens ao trabalhar com o o1-pro:

- Teste Interativo: Teste chamadas de API em tempo real e veja as respostas formatadas, facilitando a iteração sobre os prompts.

- Documentação Automática: Documente suas implementações de API automaticamente, facilitando a colaboração em equipe.

- Simulação de API: Crie respostas simuladas para chamadas da API o1-pro durante o desenvolvimento.

- Recursos de Colaboração: Compartilhe coleções de API com membros da equipe para desenvolvimento colaborativo.

- Gerenciamento de Ambiente: Troque facilmente entre ambientes de desenvolvimento, teste e produção com diferentes chaves de API.

- Visualização de Respostas: Obtenha uma representação visual clara do uso de tokens e custos para melhor gerenciamento de orçamento.

- Histórico de Solicitações: Acompanhe chamadas de API anteriores para referência e otimização.

Melhores Práticas para Usar APIs o1-pro

Para maximizar a eficácia do o1-pro e otimizar seus custos:

- Estruture Seus Prompts Claramente: Para tarefas de raciocínio complexo, estruture seus prompts com instruções claras e saídas esperadas. Considere usar marcadores ou instruções numeradas para problemas de múltiplas partes.

- Use Mensagens de Sistema de Forma Eficaz: Defina o contexto com mensagens de sistema para guiar o o1-pro em direção à abordagem de raciocínio que você deseja. Seja específico sobre o tipo de raciocínio (dedutivo, indutivo, etc.) que você está esperando.

Ajuste os Parâmetros de Temperatura:

- Temperatura mais baixa (0.1-0.3) para raciocínio mais preciso e problemas matemáticos

- Temperatura moderada (0.3-0.7) para raciocínio equilibrado com alguma flexibilidade

- Temperatura mais alta para abordagens de resolução de problemas mais criativas

- Peça Pensamento Passo a Passo: Peça explicitamente por etapas detalhadas de raciocínio ao resolver problemas complexos. Frases como "Pense nisso passo a passo" ou "Mostre seu raciocínio" ajudam a ativar os pontos fortes do o1-pro.

- Monitore o Uso de Tokens: Acompanhe os tokens de entrada e saída para gerenciar os custos de forma eficaz. Considere implementar uma função de estimativa de tokens em sua aplicação.

- Agrupe Consultas Relacionadas: Sempre que possível, combine perguntas relacionadas em uma única chamada de API, em vez de fazer chamadas separadas múltiplas.

- Implemente Cache: Armazene em cache respostas comuns para evitar chamadas de API redundantes para informações frequentemente solicitadas.

- Use Técnicas de Cadeia de Raciocínio: Para problemas complexos, implemente a solicitação em cadeia de raciocínio pedindo ao modelo para "pensar sobre este problema passo a passo antes de fornecer a resposta final."

Conclusão

O o1-pro representa um avanço significativo nas capacidades de raciocínio da IA, oferecendo ferramentas poderosas para tarefas que exigem pensamento estruturado e resolução complexa de problemas. Com sua estrutura de preços competitiva e implementação simples, ele é acessível a desenvolvedores que buscam aprimorar suas aplicações com capacidades avançadas de raciocínio.

Seguindo as diretrizes de implementação e as melhores práticas apresentadas neste artigo, você pode integrar efetivamente o o1-pro em seus fluxos de trabalho e aproveitar suas sofisticadas habilidades de raciocínio enquanto gerencia seus custos de API de forma eficiente. Ferramentas como o Apidog tornam ainda mais ágil o processo de desenvolvimento e teste, facilitando a exploração do potencial máximo do o1-pro para seus casos de uso específicos.

À medida que as capacidades de raciocínio da IA continuam a avançar, modelos como o o1-pro se tornarão componentes cada vez mais essenciais em aplicações que exigem não apenas inteligência, mas também um pensamento lógico e estruturado que os usuários possam seguir e entender.