A marcha implacável da inteligência artificial está remodelando indústrias, e a engenharia de software está na vanguarda dessa transformação. Ferramentas com inteligência artificial não são mais conceitos futurísticos, mas assistentes práticos, aumentando as capacidades dos desenvolvedores e otimizando fluxos de trabalho complexos. A OpenAI, um nome proeminente na pesquisa de IA, revelou recentemente sua mais recente contribuição para este cenário em evolução: o ChatGPT Codex, um agente de engenharia de software baseado na nuvem, projetado para lidar com uma infinidade de tarefas de codificação em paralelo. Esta nova oferta, inicialmente disponível para usuários ChatGPT Pro, Team e Enterprise, com versões Plus e Edu no horizonte, promete redefinir como os desenvolvedores interagem com suas bases de código e constroem software.

Quer uma plataforma integrada, Tudo-em-Um, para sua Equipe de Desenvolvedores trabalhar em conjunto com máxima produtividade?

Apidog atende a todas as suas demandas e substitui o Postman por um preço muito mais acessível!

O Amanhecer da Engenharia de Software com IA: Apresentando o Codex

Imagine um painel perguntando: "O que devemos codificar em seguida?", completo com uma caixa de prompt, seletores de repositório e branch, e uma lista de tarefas, tudo ambientado em um plano de fundo pastel com tema de código. Esta é a porta de entrada para o Codex, um agente pronto para se tornar uma parte indispensável do kit de ferramentas de um desenvolvedor. O Codex é projetado para lidar com uma ampla gama de tarefas – desde escrever novas funcionalidades e responder a perguntas complexas sobre uma base de código até corrigir bugs e propor pull requests para revisão. Cada tarefa é meticulosamente processada em seu próprio ambiente de sandbox na nuvem, pré-carregado com o repositório específico, garantindo isolamento e foco.

Em sua essência, o Codex é alimentado por codex-1, uma versão especializada do modelo o3 da OpenAI, ajustada para as nuances da engenharia de software. A destreza deste modelo deriva de um rigoroso aprendizado por reforço, onde foi treinado em tarefas de codificação do mundo real em vários ambientes. O objetivo era claro: gerar código que não apenas funcione perfeitamente, mas também espelhe as preferências estilísticas humanas, adira precisamente às instruções e possa executar testes iterativamente até que um resultado aprovado seja alcançado. O lançamento do Codex significa um grande passo em direção a uma assistência de codificação mais inteligente e autônoma.

Por Dentro: Como o Codex Opera

O acesso ao Codex é direto para usuários elegíveis do ChatGPT, com uma seção dedicada na barra lateral. Desenvolvedores podem atribuir novas tarefas de codificação digitando um prompt e iniciando o comando "Code", ou fazer perguntas sobre sua base de código usando a função "Ask".

O verdadeiro poder do Codex reside em suas capacidades de processamento paralelo. Cada tarefa é tratada independentemente dentro de um sandbox de nuvem separado e isolado. Este ambiente vem pré-carregado com a base de código relevante, permitindo que o Codex leia e edite arquivos, execute comandos (incluindo test harnesses, linters e type checkers) e opere sem interferência de outras tarefas em andamento. Os tempos de conclusão das tarefas variam, geralmente de um a trinta minutos, dependendo da complexidade, e os usuários podem monitorar o progresso em tempo real.

Um aspecto crucial do Codex é seu compromisso com o trabalho verificável. Uma vez que uma tarefa é concluída, o Codex commita suas alterações dentro de seu ambiente. Ele não apenas apresenta o código final; ele fornece evidências verificáveis de suas ações através de citações de logs de terminal e saídas de teste. Essa transparência permite que os desenvolvedores rastreiem cada passo dado durante a conclusão da tarefa, promovendo confiança e permitindo uma revisão completa. Os usuários podem então decidir solicitar revisões adicionais, abrir um pull request no GitHub ou integrar diretamente as alterações em seu ambiente de desenvolvimento local. Além disso, o ambiente do Codex pode ser configurado para espelhar de perto a configuração de desenvolvimento real do usuário, garantindo compatibilidade e relevância.

Guiando o Agente: O Papel de AGENTS.md e Diretivas de Sistema

Para aumentar ainda mais sua eficácia e adaptar seu comportamento às necessidades específicas do projeto, o Codex pode ser guiado por arquivos AGENTS.md colocados dentro de um repositório. Esses arquivos de texto, muito parecidos com o familiar README.md, servem como um canal de comunicação entre desenvolvedores humanos e o agente de IA. Através do AGENTS.md, os desenvolvedores podem informar ao Codex como navegar na base de código, quais comandos executar para teste e como melhor aderir aos padrões e práticas de codificação estabelecidos pelo projeto. Assim como com desenvolvedores humanos, os agentes Codex performam de forma otimizada quando fornecidos com ambientes de desenvolvimento bem configurados, configurações de teste confiáveis e documentação clara.

A mensagem de sistema subjacente para codex-1 também revela um conjunto explícito de instruções que regem seu comportamento. Por exemplo, ao modificar arquivos, o Codex é instruído a não criar novas branches, a usar git para commitar alterações (tentando novamente em falhas de pre-commit) e a garantir que a área de trabalho (worktree) seja deixada em um estado limpo. Ele enfatiza que apenas o código commitado será avaliado e que os commits existentes não devem ser alterados (amended).

A especificação AGENTS.md é bastante detalhada. Seu escopo é toda a árvore de diretórios enraizada em sua localização, e suas instruções têm precedência com base na profundidade de aninhamento, embora prompts diretos do usuário possam substituí-las. Uma diretiva chave é que, se o AGENTS.md incluir verificações programáticas, o Codex *deve* executar todas elas e se esforçar para validar seu sucesso após todas as alterações de código, mesmo para modificações aparentemente simples como atualizações de documentação. As instruções de citação também são rigorosas, exigindo referências precisas de caminhos de arquivo e saídas de terminal para quaisquer arquivos navegados ou comandos executados, garantindo uma trilha de auditoria clara.

Colocando o Codex à Prova: Performance e Benchmarks

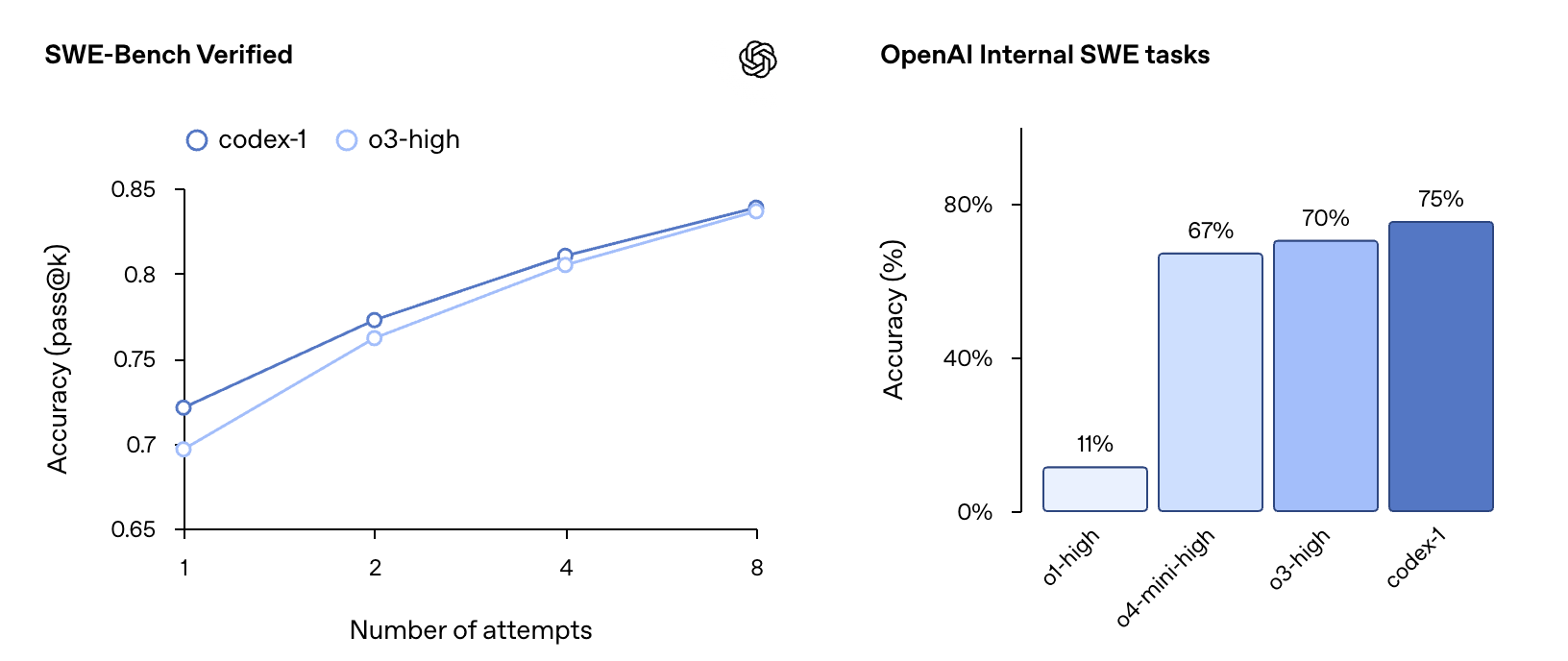

A OpenAI relata que o codex-1 demonstra forte performance em avaliações de codificação e benchmarks internos, mesmo sem personalização extensiva através de arquivos AGENTS.md ou scaffolding específico. No benchmark SWE-Bench Verified, o codex-1 mostrou uma progressão de precisão pass@k de 67% em k=1 para 75% em k=8, superando o o3-high (que pontuou 70% em k=8 em um subconjunto ligeiramente diferente). Nas tarefas internas de Engenharia de Software (SWE) da OpenAI, um conjunto curado de desafios internos do mundo real, o codex-1 alcançou uma precisão de 70%, significativamente maior que o o1-high (25%), o4-mini-high (40%) e o3-high (61%). Esses testes foram conduzidos com o codex-1 em um comprimento máximo de contexto de 192k tokens e um 'esforço de raciocínio' médio, refletindo as configurações disponíveis no produto.

Construindo com Confiança: Segurança, Confiança e Considerações Éticas

O Codex está sendo lançado como uma prévia de pesquisa, alinhando-se à estratégia da OpenAI de implantação iterativa. Essa abordagem permite aprendizado e refinamento com base no uso no mundo real. Segurança e transparência foram primordiais no design do Codex. A capacidade dos usuários de verificar as saídas através de citações, logs de terminal e resultados de teste é um pilar dessa filosofia — uma salvaguarda que se torna cada vez mais vital à medida que modelos de IA lidam com tarefas de codificação mais complexas de forma independente.

Quando confrontado com incertezas ou falhas em testes, o agente Codex é projetado para comunicar explicitamente esses problemas, permitindo que os usuários tomem decisões informadas. No entanto, a OpenAI ressalta que continua sendo essencial para os usuários revisar e validar manualmente todo o código gerado pelo agente antes da integração e execução.

Abordar o potencial de uso indevido, particularmente em áreas como desenvolvimento de malware, é uma preocupação crítica. O Codex foi treinado para identificar e recusar precisamente solicitações destinadas a criar software malicioso, ao mesmo tempo em que distingue e suporta tarefas legítimas e avançadas que podem envolver técnicas semelhantes (por exemplo, engenharia de kernel de baixo nível). Estruturas de políticas aprimoradas e avaliações de segurança rigorosas, detalhadas em um adendo ao System Card do o3, reforçam esses limites.

O agente opera inteiramente dentro de um contêiner seguro e isolado na nuvem. Durante a execução da tarefa, o acesso à internet é desativado, restringindo as interações apenas ao código explicitamente fornecido via repositórios GitHub e dependências pré-instaladas configuradas pelo usuário. Isso significa que o agente não pode acessar sites externos, APIs ou outros serviços, mitigando significativamente os riscos de segurança.

Um Toque Humano: Alinhando-se às Preferências e Fluxos de Trabalho do Desenvolvedor

Um objetivo principal durante o treinamento do codex-1 foi alinhar suas saídas de perto com as preferências e padrões de codificação humanos. Comparado ao OpenAI o3 de propósito geral, o codex-1 produz consistentemente patches mais limpos que são mais facilmente revisáveis por humanos e mais fáceis de integrar em fluxos de trabalho padrão. Isso é demonstrado através de vários exemplos de correções aplicadas a projetos populares de código aberto:

Projeto: Astropy (Biblioteca de Astronomia em Python)

- O Bug: A função

separability_matrixcalculava incorretamente a separabilidade para instâncias aninhadas deCompoundModel. Por exemplo, se um modelo composto comom.Linear1D(10) & m.Linear1D(5)fosse aninhado dentro de outro, a matriz resultante indicava erroneamente dependências onde nenhuma existia. - A Solução do Codex:

- Uma modificação direcionada foi feita na função

_cstackemastropy/modeling/separable.py. - Essa mudança tratou corretamente as dimensões e valores da matriz do lado direito quando ela representava um array pré-calculado (ou seja, um modelo aninhado).

- Teste: Um teste de regressão preciso foi adicionado a

test_separable.pypara confirmar a correção, garantindo que a saída fosse a matriz de separabilidade esperada em bloco diagonal para modelos aninhados. - Comparação: Esta correção foi notada como mais direta e menos verbosa do que uma alternativa potencial do

o3, que havia incluído extensos comentários explicativos.

Projeto: Matplotlib (Biblioteca de Plotagem em Python)

- O Bug: Um problema em

mlab._spectral_helpercausava correção de janela incorreta devido a uma chamada desnecessária denp.abs(). Isso levava a resultados imprecisos para janelas com valores negativos (por exemplo, a janelaflattop). - A Solução do Codex:

- As chamadas

np.abs()foram removidas de(np.abs(window)**2).sum()enp.abs(window).sum()**2. - Estas foram alteradas para

(window.conjugate() * window).sum()ewindow.sum()**2, respectivamente. - Essa modificação garante que a escala use os valores reais da janela, preservando a potência com precisão.

- Teste: Um novo teste,

test_psd_windowarray_negative, foi adicionado alib/matplotlib/tests/test_mlab.pypara verificar especificamente essa correção usando uma janela contendo valores negativos.

Projeto: Django (Framework Web em Python)

- O Bug: Expressões apenas de duração (por exemplo,

F('estimated_time') + datetime.timedelta(1)) falhavam no SQLite e MySQL, levantando um errodecimal.InvalidOperation. Isso se devia a problemas na forma como os valores de duração eram convertidos. - A Solução do Codex:

- O método

convert_durationfield_valueemdjango/db/backends/base/operations.pyfoi refinado para lidar robustamente com vários tipos de entrada para duração (comoNone,timedelta,stringeint). - A compilação dos lados para

DurationExpressionemdjango/db/models/expressions.pyfoi ajustada, garantindo queformat_for_duration_arithmeticseja aplicado de forma mais seletiva, principalmente quando combinado com tipos de data/hora. - Teste: Um novo teste,

test_durationfield_only_expression, foi adicionado emtests/expressions/tests.pypara validar essa correção. - Comparação: A solução do

o3para este problema do Django foi descrita como mais extensa em sua lógica de verificação de tipo e parsing dentro deconvert_durationfield_value, oferecendo uma abordagem muito detalhada para lidar com diferentes representações de string e numéricas de durações.

Projeto: Expensify (ReportUtils.ts - TypeScript)

- O Problema: Os nomes das salas dos membros não estavam atualizando no Navegador da Mão Esquerda (LHN) após limpar o cache.

- Solução Proposta pelo Codex (com base nos diffs fornecidos relacionados ao cache de nome de relatório):

- O diff "Codex" modificou a função

getCacheKeypara incluirpolicyName. Essa mudança poderia tornar as chaves de cache mais específicas, potencialmente evitando a obsolescência se os nomes das políticas influenciarem os títulos das salas. - Proposta Alternativa do

OpenAI o3: - O diff "OpenAI o3" sugeriu uma solução mais estrutural para a invalidação de cache: garantir que o

reportNameCacheseja limpo sempre queONYXKEYS.COLLECTION.POLICYfor atualizado. Isso aborda diretamente dados obsoletos, atualizando proativamente o cache quando as informações de política subjacentes (que podem afetar os nomes das salas) mudam. - Insight: Este exemplo destaca como a IA pode propor diferentes estratégias — desde refinar chaves de cache até implementar mecanismos de invalidação mais amplos — para resolver tais problemas.

Esses exemplos ilustram coletivamente a capacidade do Codex de entender problemas complexos e implementar soluções direcionadas e eficazes, frequentemente incluindo os casos de teste necessários para garantir a correção.

Ampliando o Alcance: Atualizações para o Codex CLI

Complementando o agente baseado em nuvem, a OpenAI também atualizou o Codex CLI, um agente de codificação leve e de código aberto que roda diretamente no terminal. Uma nova versão menor do codex-1, chamada codex-mini-latest (uma versão especializada do o4-mini), é agora o modelo padrão no Codex CLI. É otimizado para Q&A e edição de código de baixa latência, mantendo fortes capacidades de seguir instruções e estilo.

Conectar uma conta de desenvolvedor ao Codex CLI também foi simplificado. Em vez de gerar tokens de API manualmente, os usuários agora podem fazer login com sua conta ChatGPT e selecionar sua organização de API, com o CLI cuidando da configuração automática da chave de API. Usuários Plus e Pro que fizerem login dessa forma também podem resgatar créditos de API gratuitos.

Acesso, Acessibilidade e Aspirações: Disponibilidade, Preços e Limitações

O Codex está sendo lançado atualmente para usuários ChatGPT Pro, Enterprise e Team globalmente, com suporte para Plus e Edu previsto em breve. O acesso inicial será generoso e sem custo adicional por várias semanas, permitindo que os usuários explorem suas capacidades. Posteriormente, a OpenAI introduzirá acesso com limite de taxa e opções de preços flexíveis para uso sob demanda. Para desenvolvedores que usam codex-mini-latest via API, ele é precificado em US$ 1,50 por 1M de tokens de entrada e US$ 6 por 1M de tokens de saída, com um desconto de 75% para cache de prompt.

Como uma prévia de pesquisa, o Codex tem limitações. Atualmente, ele carece de recursos como entradas de imagem para desenvolvimento frontend e a capacidade de corrigir o curso do agente no meio da tarefa. Delegar tarefas a um agente remoto também introduz uma latência em comparação com a edição interativa, o que pode exigir algum ajuste no fluxo de trabalho. A OpenAI prevê que a interação com os agentes Codex se assemelhará cada vez mais à colaboração assíncrona com colegas humanos.

O Caminho à Frente: O Futuro da IA na Engenharia de Software com o Codex

A OpenAI imagina um futuro onde os desenvolvedores impulsionam o trabalho que desejam possuir e delegam o restante a agentes de IA altamente capazes, levando a um aumento de velocidade e produtividade. Para realizar isso, eles estão construindo um conjunto de ferramentas Codex que suportam tanto a colaboração em tempo real quanto a delegação assíncrona. Embora as ferramentas de pareamento de IA como o Codex CLI estejam se tornando normas da indústria, o fluxo de trabalho assíncrono e multi-agente introduzido pelo Codex no ChatGPT é visto como o futuro padrão de fato para produzir código de alta qualidade.

Em última análise, esses dois modos de interação — pareamento em tempo real e delegação de tarefas — devem convergir. Desenvolvedores colaborarão com agentes de IA em seus IDEs e ferramentas do dia a dia para Q&A, sugestões e descarregamento de tarefas mais longas em um fluxo de trabalho unificado. Planos futuros incluem fluxos de trabalho de agente mais interativos e flexíveis, permitindo que os desenvolvedores forneçam orientação no meio da tarefa, colaborem em estratégias de implementação e recebam atualizações proativas de progresso. Integrações mais profundas também estão planejadas em ferramentas como GitHub, Codex CLI, ChatGPT Desktop, rastreadores de problemas e sistemas de CI.

A engenharia de software é uma das primeiras indústrias a testemunhar ganhos significativos de produtividade impulsionados pela IA, abrindo novas possibilidades para indivíduos e pequenas equipes. Embora otimista em relação a esses avanços, a OpenAI também está colaborando com parceiros para entender as implicações mais amplas da adoção generalizada de agentes nos fluxos de trabalho dos desenvolvedores e no desenvolvimento de habilidades em diversas populações.

O lançamento do ChatGPT Codex é mais do que apenas uma nova ferramenta; é um vislumbre de um futuro onde a engenhosidade humana e a inteligência artificial colaboram de forma mais integrada do que nunca para construir a próxima geração de software. Este é apenas o começo, e o potencial para o que os desenvolvedores podem construir com o Codex é vasto e emocionante.