Você gostaria de conversar com modelos de linguagem poderosos como Llama 3.1 ou Mistral sem ficar preso a um terminal? O Open WebUI é seu bilhete para uma interface elegante, semelhante ao ChatGPT, que torna a interação com os LLMs do Ollama divertida e intuitiva. Ele permite salvar históricos de chat, armazenar prompts e até mesmo fazer upload de documentos para respostas mais inteligentes—tudo no seu navegador. Neste guia para iniciantes, vou guiá-lo pela instalação do Ollama, testar um modelo no terminal e, em seguida, avançar com o Open WebUI para uma experiência mais amigável. Usaremos Docker para uma configuração rápida e o testaremos com um prompt divertido. Pronto para tornar os chats de IA uma brisa? Vamos começar!

O que é o Open WebUI? Seu Centro de Comando para LLMs

O Open WebUI é uma interface web de código aberto e auto-hospedada que se conecta ao Ollama, permitindo que você interaja com grandes modelos de linguagem (LLMs) como Llama 3.1 ou Mistral em um painel baseado em navegador. Ao contrário da interface de linha de comando do Ollama, o Open WebUI parece com o ChatGPT, oferecendo:

- Histórico de Chat: Salve e revise suas conversas.

- Armazenamento de Prompts: Armazene e reutilize seus prompts favoritos.

- Upload de Documentos: Adicione arquivos para respostas com contexto (Geração Aumentada por Recuperação, ou RAG).

- Troca de Modelos: Alterne facilmente entre modelos com um clique.

Com mais de 50 mil estrelas no GitHub, o Open WebUI é um sucesso entre desenvolvedores e entusiastas de IA que desejam uma maneira colaborativa e gráfica de trabalhar com LLMs localmente. Primeiro, vamos colocar o Ollama para rodar para ver por que o Open WebUI vale a pena adicionar!

Instalando e Testando o Ollama

Antes de mergulharmos no Open WebUI, vamos configurar o Ollama e testar um modelo como Llama 3.1 ou Mistral no terminal. Isso lhe dará uma base para apreciar a interface intuitiva do Open WebUI.

1. Verificar Requisitos do Sistema:

- SO: Windows, macOS ou Linux (Ubuntu 24.04 ou similar).

- Hardware: Pelo menos 16GB de RAM e 10GB de armazenamento livre para modelos (Llama 3.1 8B precisa de ~5GB). Uma GPU (por exemplo, NVIDIA 1060 4GB) é opcional para desempenho mais rápido.

- Software: Ollama, disponível para download em ollama.com.

2. Instalar Ollama: Baixe e instale o Ollama de ollama.com para seu sistema operacional. Siga os prompts do instalador—é uma configuração rápida. Verifique a instalação com:

ollama --version

Espere uma versão como 0.1.44 (Abril de 2025). Se falhar, certifique-se de que o Ollama está no seu PATH.

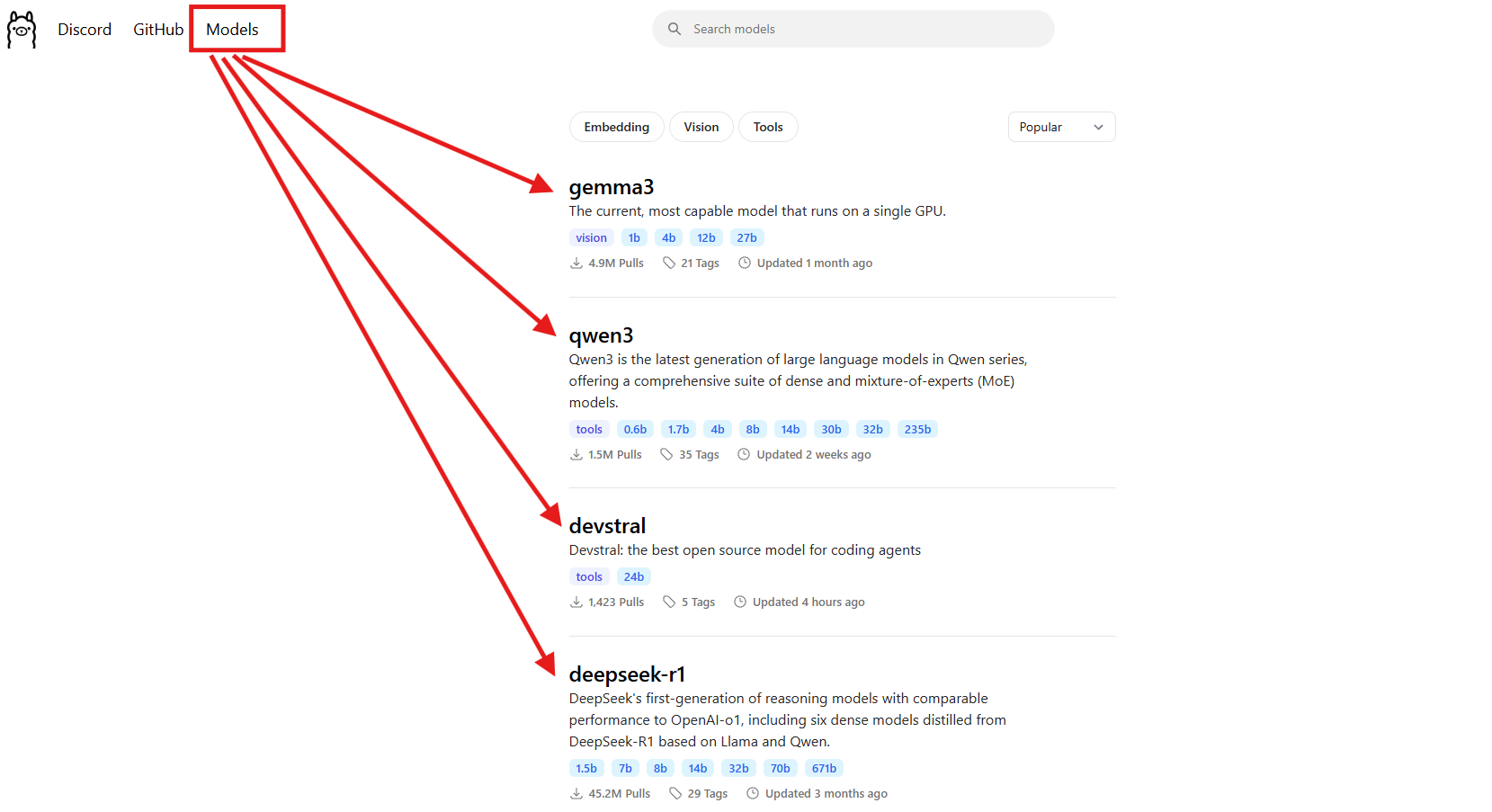

3. Baixar um Modelo: Escolha um modelo como Llama 3.1 (8B) ou Mistral (7B). Para este guia, usaremos Llama 3.1:

ollama pull llama3.1

Isso baixa ~5GB, então pegue um café se sua internet for lenta. Verifique se está instalado:

ollama list

Procure por llama3.1:latest. Mistral (ollama pull mistral) é outra ótima opção se você quiser um modelo mais leve (~4GB).

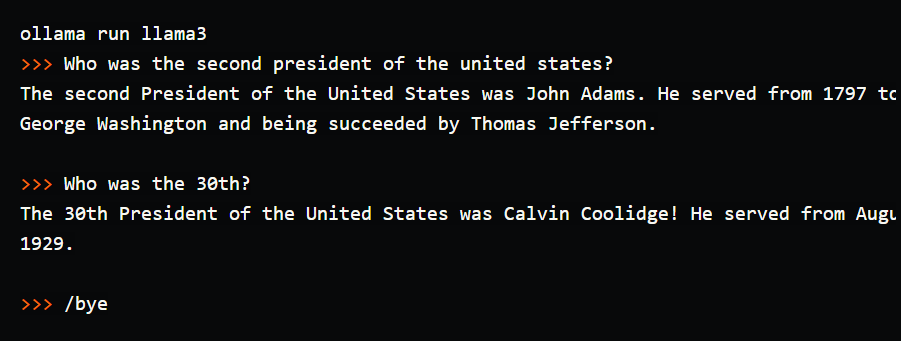

4. Testar o Modelo no Terminal: Experimente um prompt simples para ver o Ollama em ação:

ollama run llama3.1

No prompt (>>>), digite: “Conte-me uma piada de pai sobre computadores.” Pressione Enter. Você pode receber: “Por que o computador foi ao médico? Porque ele tinha um vírus!” Saia com /bye. Eu executei isso e recebi uma piada que valeu a pena rir, mas digitar no terminal parecia desajeitado—sem histórico de chat, sem prompts salvos. É aqui que o Open WebUI brilha, oferecendo uma interface visual para salvar conversas, reutilizar prompts e fazer upload de documentos para respostas mais ricas. Vamos configurá-lo!

Configurando Seu Ambiente para o Open WebUI

Agora que você viu a interface de terminal do Ollama, vamos nos preparar para o Open WebUI para tornar sua experiência com LLM mais intuitiva. Assumiremos que você tem o Docker instalado, pois é necessário para a configuração do Open WebUI.

1. Verificar Docker: Certifique-se de que o Docker está instalado e rodando:

docker --version

Espere algo como Docker 27.4.0. Se você não tem o Docker, baixe e instale o Docker Desktop do site oficial—é uma configuração rápida para Windows, macOS ou Linux.

2. Criar uma Pasta de Projeto: Mantenha as coisas organizadas:

mkdir ollama-webui

cd ollama-webui

Esta pasta será sua base para rodar o Open WebUI.

3. Certificar-se de que o Ollama Está Rodando: Inicie o Ollama em um terminal separado:

ollama serve

Isso roda a API do Ollama em http://localhost:11434. Mantenha este terminal aberto, pois o Open WebUI precisa dele para se conectar aos seus modelos.

Instalando o Open WebUI com Docker

Com o Ollama e o Llama 3.1 prontos, vamos instalar o Open WebUI usando um único comando Docker para uma configuração rápida e confiável.

1. Rodar Open WebUI: Na sua pasta ollama-webui, execute:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Este comando:

- Baixa a imagem do Open WebUI (

ghcr.io/open-webui/open-webui:main, ~3.77GB). - Mapeia a porta 3000 (local) para 8080 (container) para acesso via navegador.

- Adiciona

host.docker.internalpara conectar à API do Ollama emlocalhost:11434. - Usa um volume (

open-webui) para persistir histórico de chat e configurações. - Nomeia o container como

open-webuie o configura para reiniciar automaticamente.

Leva um minuto para baixar. Verifique se está rodando com docker ps—procure pelo container open-webui.

2. Acessar Open WebUI: Abra seu navegador e vá para http://localhost:3000. Você verá a página de boas-vindas do Open WebUI. Clique em “Sign Up” (Cadastrar-se) para criar uma conta (o primeiro usuário obtém privilégios de administrador). Use uma senha forte e salve-a com segurança. Agora você está pronto para conversar! Se a página não carregar, certifique-se de que o container está rodando (docker logs open-webui) e que a porta 3000 está livre.

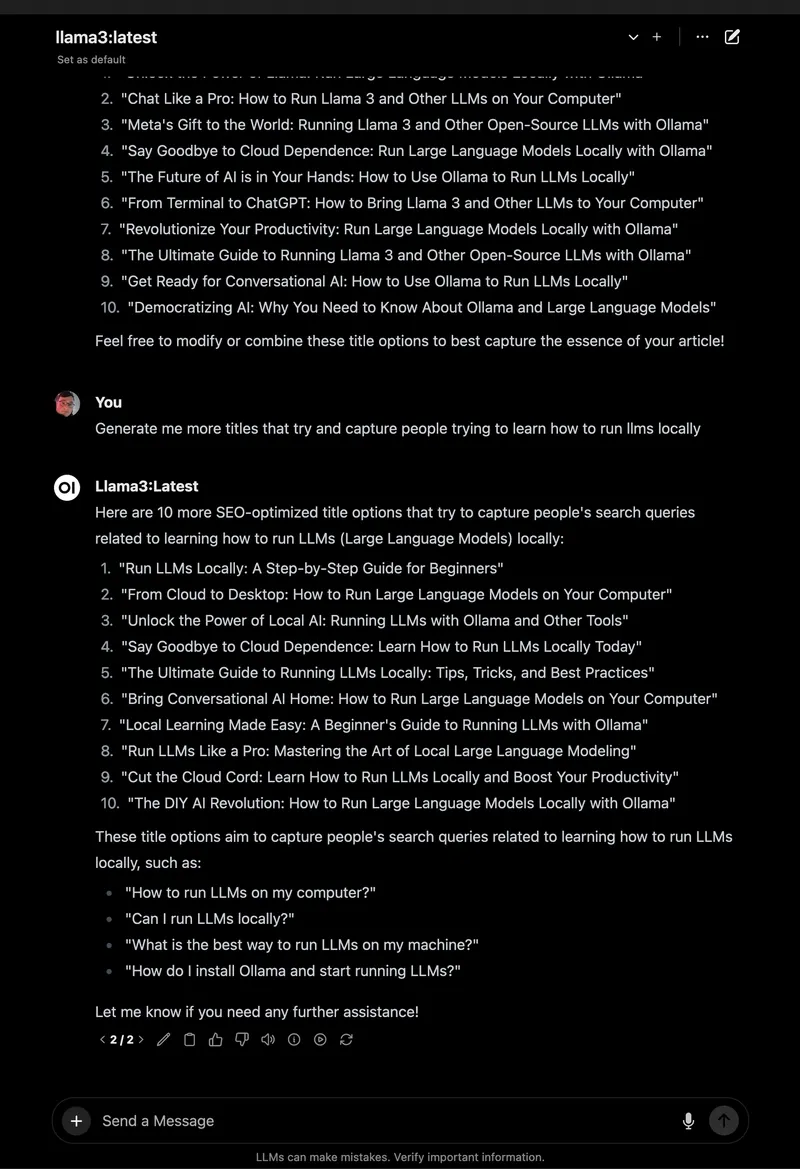

Usando o Open WebUI: Conversando e Explorando Recursos

Com o Open WebUI rodando, vamos mergulhar na conversa com o Llama 3.1 e explorar seus recursos incríveis, que o tornam uma grande melhoria em relação ao terminal.

1. Começar a Conversar:

- No Open WebUI, selecione

llama3.1:8bno seletor de modelo no canto superior esquerdo (ele deve aparecer, já que você o baixou). - Clique em “New Chat” (Novo Chat) na barra lateral.

- Digite o mesmo prompt: “Conte-me uma piada de pai sobre computadores.”

- Pressione Enter. Você receberá uma resposta como: “Por que o computador foi para a escola de arte? Porque ele queria aprender a desenhar um byte melhor!”

A interface é limpa, com seu prompt e resposta salvos automaticamente no histórico de chat.

2. Salvar e Organizar Chats: Na barra lateral esquerda, clique no ícone de alfinete para salvar o chat. Renomeie-o (por exemplo, “Piadas de Pai”) para fácil acesso. Você pode arquivar ou excluir chats pela barra lateral, mantendo seus experimentos organizados—muito melhor do que rolar o terminal!

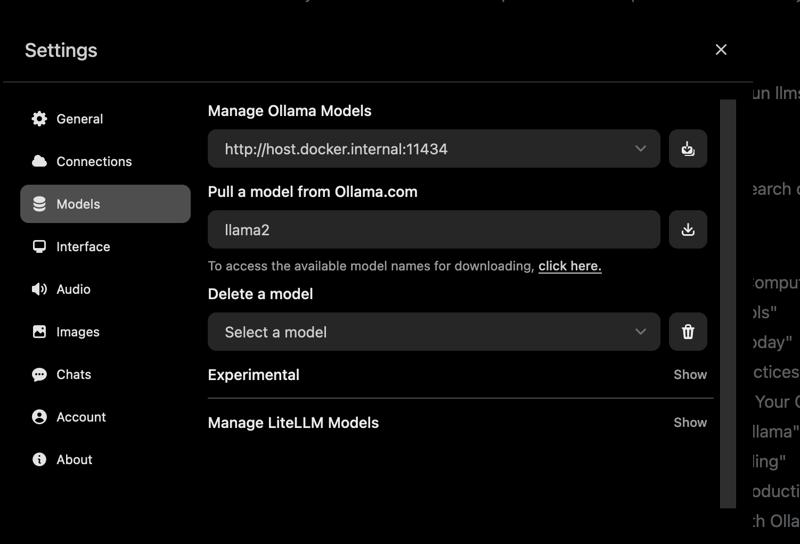

3. Armazenar Prompts: Salve o prompt da piada de pai para reutilizar:

- Vá para Settings (Configurações) > Prompts.

- Clique em “New Prompt” (Novo Prompt), nomeie-o como “Piada de Pai” e cole: “Conte-me uma piada de pai sobre computadores.”

- Salve. Agora você pode aplicá-lo em qualquer chat com um clique.

4. Fazer Upload de um Documento para RAG: Adicione contexto aos seus chats:

- Clique no ícone “#” na entrada do chat para abrir a biblioteca de documentos.

- Faça upload de um arquivo de texto (por exemplo, um guia do Spring Boot 3.2).

- Pergunte: “Como uso o REST Client no Spring Boot 3.2?” O Llama 3.1 fará referência ao documento, fornecendo um trecho de código como

RestClient.create().get().uri("/users").retrieve().

Testei isso com um PDF de tutorial de Python, e o Open WebUI acertou em cheio as respostas com contexto, ao contrário das respostas básicas do terminal.

5. Explorar Mais Recursos:

- Trocar Modelos: Use o seletor de modelo para experimentar o Mistral ou outros modelos que você baixou (

ollama pull mistral). - Personalizar Respostas: Clique em “Chat Control” (Controle de Chat) para ajustar o tom (por exemplo, “engraçado”) ou o comprimento.

- Ferramentas de Administração: Em Settings (Configurações) > Admin, gerencie usuários ou restrinja o acesso a modelos (ótimo para equipes).

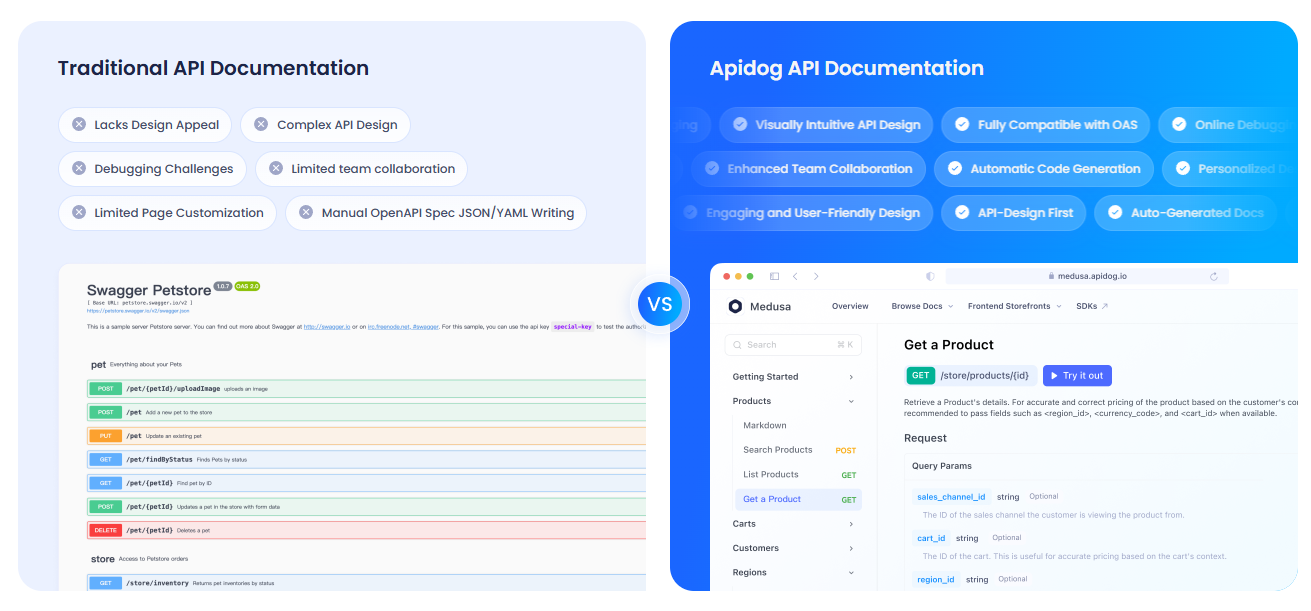

Documentando Suas APIs com APIdog

Usando o Open WebUI para interagir com a API do Ollama e quer documentar sua configuração? O APIdog é uma ferramenta fantástica para criar documentação de API interativa. Sua interface elegante e opções de auto-hospedagem o tornam ideal para compartilhar seus projetos de IA—confira!

Solução de Problemas e Dicas

- Problemas de Conexão: Se o Open WebUI não conseguir encontrar o Ollama, certifique-se de que

ollama serveestá rodando e que a porta 11434 está aberta. Verifique os logs do Docker:docker logs open-webui. - Conflitos de Porta: Se a porta 3000 estiver ocupada, pare o container (

docker stop open-webui), remova-o (docker rm open-webui) e execute novamente o comandodocker runcom uma nova porta (por exemplo,-p 3001:8080). - Respostas Lentas: Use uma GPU com as tags

:cudado Ollama ou modelos menores como Mistral para velocidade. - Comunidade: Junte-se às Discussões do GitHub ou Discord do Open WebUI para suporte e ideias.

Por Que Escolher o Open WebUI?

O Open WebUI transforma o Ollama de uma ferramenta de terminal desajeitada em uma plataforma poderosa e amigável:

- Interface Intuitiva: O painel baseado em navegador é perfeito para iniciantes e profissionais.

- Organização: Chats e prompts salvos mantêm seu trabalho organizado, ao contrário dos logs do terminal.

- Consciência de Contexto: O upload de documentos permite RAG para respostas mais inteligentes.

- Privacidade: Roda localmente, mantendo seus dados seguros.

Após testar tanto o terminal quanto o Open WebUI, estou convencido da facilidade e dos recursos da GUI. É como atualizar de um celular de flip para um smartphone!

Conclusão: Sua Aventura com o Open WebUI Espera por Você

Você passou de chats no terminal para uma configuração completa do Open WebUI com Ollama, tornando as interações com LLMs suaves e divertidas! Com Llama 3.1, chats salvos e upload de documentos, você está pronto para explorar IA como nunca antes. Experimente novos modelos, armazene mais prompts ou documente suas APIs com APIdog. Compartilhe seus sucessos com o Open WebUI no GitHub do Open WebUI—estou animado para ver o que você cria! Feliz experimentação com IA!