Desenvolvedores buscam ferramentas eficientes que lidam com texto e imagens sem gastar muito. O NVIDIA Nemotron Nano 12B v2 VL se destaca como um modelo de visão-linguagem compacto, porém poderoso, e acessá-lo através do nível gratuito da API NVIDIA por meio de plataformas como OpenRouter torna a experimentação direta.

Esta postagem o guia através do processo de aproveitamento gratuito da API NVIDIA Nemotron Nano 12B v2 VL. Você aprenderá sobre a arquitetura do modelo, requisitos de configuração, etapas práticas de implementação e padrões de uso avançado. Ao final, você possuirá o conhecimento para implantar este modelo em suas aplicações, desde a legendagem de imagens até a resposta a perguntas visuais.

Compreendendo o NVIDIA Nemotron Nano 12B v2 VL: Arquitetura Central e Capacidades

Os engenheiros da NVIDIA projetaram o modelo Nemotron Nano 12B v2 VL para atender à crescente demanda por processamento eficiente de visão-linguagem. Este modelo de 12 bilhões de parâmetros combina a compreensão de linguagem baseada em transformer com codificadores visuais, permitindo processar sequências intercaladas de texto e imagens. Ao contrário de modelos maiores que exigem recursos substanciais de GPU, o Nemotron Nano 12B v2 VL otimiza para implantação em edge e inferência de baixa latência, tornando-o ideal para aplicações em tempo real.

Em sua essência, o modelo emprega um transformador de visão (ViT) para extrair características de imagens de entrada, seguido por um projetor multimodal que alinha essas características com o espaço de incorporação de texto. O componente de linguagem é construído sobre a arquitetura Nemotron da NVIDIA, que incorpora embeddings posicionais rotacionais para tratamento de contexto estendido. Essa configuração suporta um comprimento de contexto de até 4.096 tokens, suficiente para a maioria das tarefas práticas que envolvem descrições curtas ou consultas emparelhadas com recursos visuais.

As principais capacidades incluem:

- Alinhamento Imagem-Texto: O modelo gera legendas descritivas para imagens ou responde a perguntas com base no conteúdo visual.

- Raciocínio Multimodal: Ele executa tarefas como resposta a perguntas visuais (VQA), onde os usuários consultam detalhes específicos de uma imagem, como "Qual a cor do carro em primeiro plano?"

- Compreensão de Documentos: Processa documentos ou gráficos digitalizados combinando extração de texto semelhante a OCR com interpretação semântica.

Benchmarks revelam um desempenho forte: No conjunto de dados VQAv2, o Nemotron Nano 12B v2 VL atinge aproximadamente 75% de precisão, rivalizando com modelos maiores enquanto consome muito menos processamento. Para desenvolvedores, isso se traduz em ciclos de prototipagem mais rápidos, especialmente ao usar o acesso gratuito à API NVIDIA.

Além disso, as opções de quantização do modelo — como pesos de 4 ou 8 bits — reduzem o consumo de memória sem perda significativa de precisão. A NVIDIA fornece essas opções através de seu catálogo NGC, mas para uso baseado em API, plataformas como OpenRouter fazem o trabalho pesado, expondo o modelo através de endpoints HTTP padronizados.

Acessando o Nível Gratuito da API NVIDIA: Integração com OpenRouter

Para usar a API NVIDIA Nemotron Nano 12B v2 VL gratuitamente, você encaminha as requisições através do OpenRouter, um gateway unificado para modelos de IA. O OpenRouter oferece um nível gratuito generoso para esta variante específica do modelo, permitindo até 10 requisições por minuto e 1.000 tokens por minuto sem custos. Essa limitação é adequada para testes e desenvolvimento em pequena escala, e você pode fazer upgrade para planos pagos para maior throughput, se necessário.

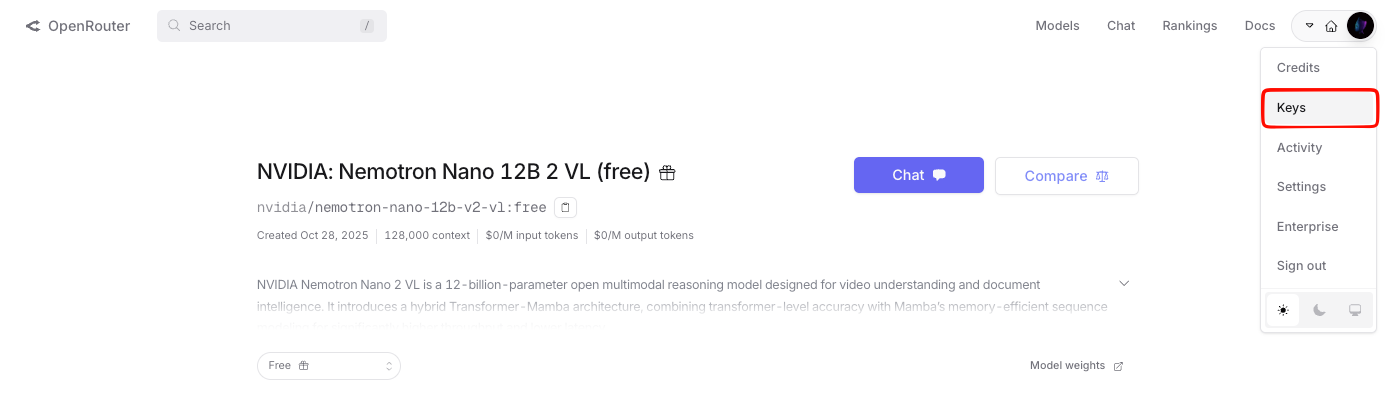

Primeiro, crie uma conta no OpenRouter. Navegue até o painel e cadastre-se usando seu e-mail ou credenciais do GitHub. Uma vez logado, gere uma chave de API na seção "Keys". Esta chave autentica todas as chamadas subsequentes, seguindo um esquema simples de token Bearer.

O OpenRouter padroniza a interface da API para imitar o formato da OpenAI, o que simplifica a migração para desenvolvedores familiarizados com os endpoints GPT. A URL base para as requisições é https://openrouter.ai/api/v1, e você especifica o modelo como nvidia/nemotron-nano-12b-v2-vl:free. Essa tag garante que você acesse o endpoint do nível gratuito, evitando quaisquer cobranças inadvertidas.

Para entradas de visão, você codifica imagens como strings base64 dentro do payload JSON. A API suporta formatos JPEG e PNG, com uma resolução máxima de 1024x1024 pixels por imagem — resoluções mais altas acionam o redimensionamento automático para evitar estouro. As entradas de texto permanecem strings UTF-8 padrão, e o modelo gera respostas formatadas em JSON contendo o texto gerado.

Passando da configuração para a implementação, você agora prepara seu ambiente de desenvolvimento. Instale o Python 3.8 ou posterior, juntamente com a biblioteca requests para tratamento de HTTP. Para testes mais avançados, o Apidog se integra perfeitamente, permitindo visualizar ciclos de requisição/resposta e exportar coleções para colaboração em equipe.

Configuração Passo a Passo: Pré-requisitos e Configuração do Ambiente

Você começa verificando a prontidão do seu sistema. Certifique-se de que o Python esteja instalado em sua máquina; verifique via python --version no terminal. Se ausente, faça o download no site oficial do Python.

Em seguida, crie um ambiente virtual para isolar as dependências:

python -m venv nemotron_env

source nemotron_env/bin/activate # No Windows: nemotron_env\Scripts\activate

Instale o pacote necessário:

pip install requests

Armazene sua chave de API do OpenRouter de forma segura. Use variáveis de ambiente para este fim—crie um arquivo .env no diretório do seu projeto com OPENROUTER_API_KEY=sua_chave_aqui. Carregue-o usando a biblioteca python-dotenv:

pip install python-dotenv

No seu código, importe e use-o da seguinte forma:

import os

from dotenv import load_dotenv

load_dotenv()

api_key = os.getenv('OPENROUTER_API_KEY')

Essa configuração evita a codificação rígida de dados sensíveis, uma boa prática para ambientes de produção. Com essas bases estabelecidas, você prossegue para a criação de sua primeira chamada de API.

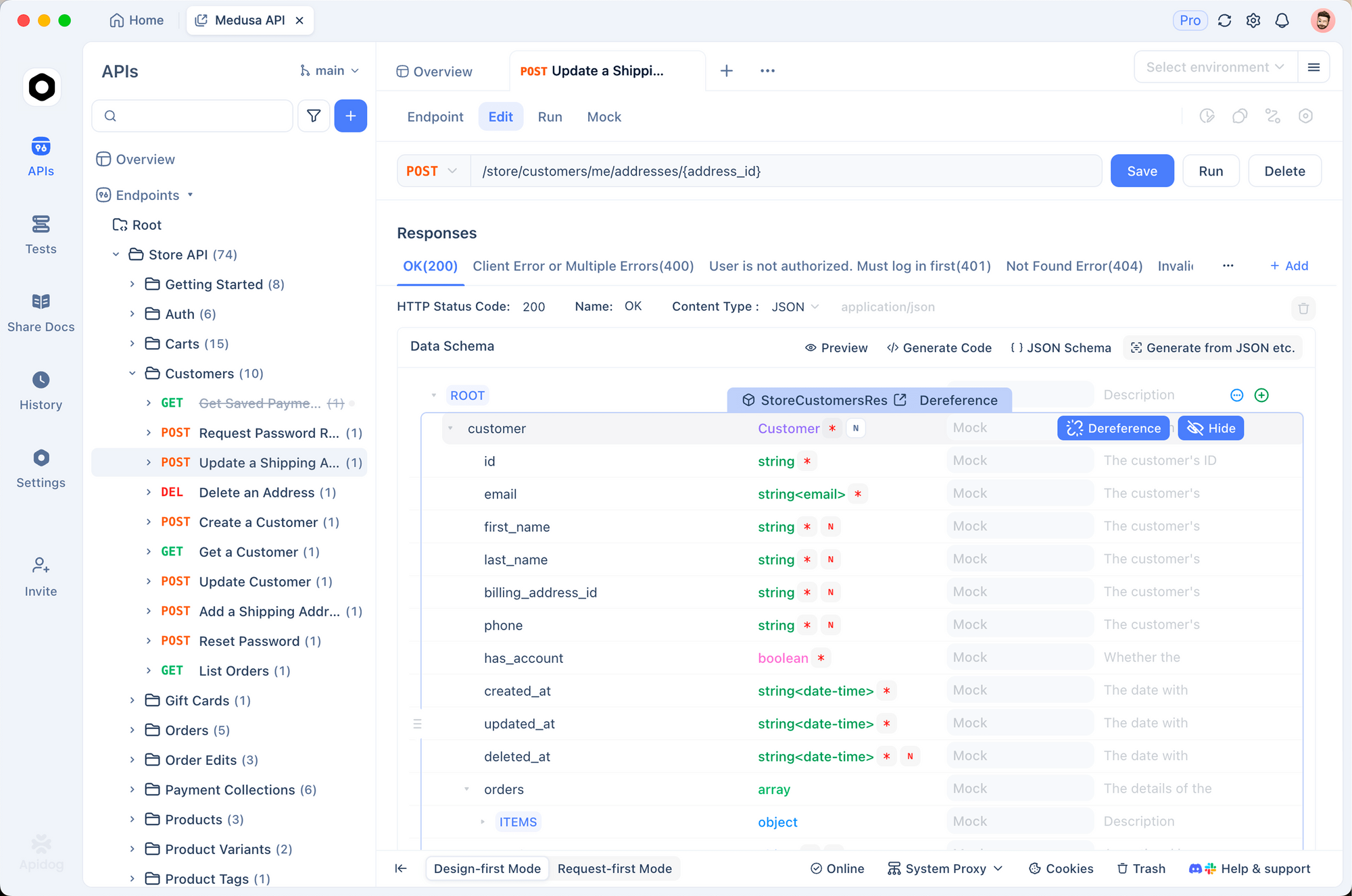

Além disso, se você prefere testes baseados em GUI, o Apidog se destaca aqui. Importe o esquema OpenRouter diretamente para o Apidog, configure sua chave gratuita da API NVIDIA e execute simulações sem escrever código. Essa abordagem acelera a depuração, particularmente para payloads multimodais onde a estrutura JSON é importante.

Implementando Chamadas Básicas de API: Exemplos Apenas de Texto e Apenas de Imagem

Você começa com requisições simples para construir confiança. O endpoint principal é /chat/completions, um método POST que aceita um corpo JSON com model, messages e parâmetros opcionais como temperature (0-2 para controle de criatividade) e max_tokens (até 2048).

Considere uma consulta apenas de texto para familiarização com o modelo:

import requests

import json

import base64

url = "https://openrouter.ai/api/v1/chat/completions"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

payload = {

"model": "nvidia/nemotron-nano-12b-v2-vl:free",

"messages": [

{"role": "user", "content": "Explique os fundamentos dos modelos de visão-linguagem em 100 palavras."}

],

"max_tokens": 150,

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=payload)

result = response.json()

print(result['choices'][0]['message']['content'])

Este script envia um prompt e recupera uma explicação concisa. A resposta é transmitida de volta em menos de 2 segundos em média, graças ao roteamento otimizado do OpenRouter.

Agora, estenda para o processamento apenas de imagem. Codifique um arquivo de imagem para base64:

with open("sample_image.jpg", "rb") as image_file:

base64_image = base64.b64encode(image_file.read()).decode('utf-8')

content = [

{

"type": "text",

"text": "Descreva esta imagem em detalhes."

},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

payload["messages"] = [{"role": "user", "content": content}]

# Repita a requisição POST como acima

O modelo analisa a imagem, produzindo descrições como "Um carro esportivo vermelho estacionado em uma rua da cidade ao entardecer, com pedestres borrados ao fundo." Tais saídas demonstram a fusão VL de forma eficaz.

No entanto, para cenários complexos, você combina modalidades, como explorado a seguir.

Uso Avançado: Consultas Multimodais com NVIDIA Nemotron Nano 12B v2 VL

A combinação de texto e imagens libera todo o potencial do modelo. Você constrói mensagens com arrays de conteúdo intercalados, onde cada elemento especifica o tipo ("text" ou "image_url") e o valor.

Exemplo para resposta a perguntas visuais:

content = [

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{base64_chart_image}"}},

{"type": "text", "text": "Qual a tendência de vendas de T1 a T4 neste gráfico?"}

]

payload["messages"] = [{"role": "user", "content": content}]

response = requests.post(url, headers=headers, json=payload)

A API retorna respostas fundamentadas, como "As vendas aumentam constantemente de US$ 100 mil no T1 para US$ 400 mil no T4, indicando um crescimento de 300%." Essa capacidade se mostra inestimável para ferramentas de visualização de dados ou sistemas de relatórios automatizados.

Para aumentar a confiabilidade, você incorpora prompts de sistema para simulação de papéis:

payload["messages"] = [

{"role": "system", "content": "Você é um analista de imagem preciso."},

{"role": "user", "content": content}

]

Mensagens de sistema guiam o comportamento do modelo, reduzindo alucinações nas saídas. Além disso, defina top_p para 0.9 para amostragem de núcleo, o que equilibra diversidade e coerência.

Para processamento em lote, o OpenRouter suporta chamadas assíncronas via WebSockets, mas mantenha as requisições POST síncronas para simplicidade no nível gratuito. Monitore o uso através do painel para permanecer dentro dos limites — excedê-los aciona erros 429, que você trata com backoff exponencial:

import time

try:

response = requests.post(url, headers=headers, json=payload)

if response.status_code == 429:

time.sleep(60) # Espere 1 minuto

response = requests.post(url, headers=headers, json=payload)

except Exception as e:

print(f"Erro: {e}")

Essa resiliência garante fluxos de trabalho ininterruptos. À medida que você escala, os recursos de mocking do Apidog simulam respostas, auxiliando no desenvolvimento offline.

Aproveitando o Apidog para Testes e Documentação Gratuitos da API NVIDIA

O Apidog eleva suas interações de API além de scripts brutos. Esta ferramenta de código aberto suporta a importação de especificações OpenAPI, e o OpenRouter fornece uma para os endpoints Nemotron.

Baixe o Apidog gratuitamente, conforme mencionado anteriormente, e siga estes passos:

- Inicie o Apidog e crie um novo projeto.

- Importe a coleção OpenRouter do repositório GitHub deles ou cole o JSON do esquema.

- Adicione sua chave gratuita da API NVIDIA nas variáveis de ambiente.

- Projete requisições: uploads de imagens por arrastar e soltar convertem para base64 automaticamente.

- Execute testes e visualize rastreamentos — o Apidog destaca picos de latência ou erros de payload.

Você documenta endpoints sem esforço, gerando relatórios Markdown com exemplos. Por exemplo, exporte um comando curl para sua consulta VQA:

curl -X POST https://openrouter.ai/api/v1/chat/completions \

-H "Authorization: Bearer $OPENROUTER_API_KEY" \

-H "Content-Type: application/json" \

-d '{"model":"nvidia/nemotron-nano-12b-v2-vl:free","messages":[{"role":"user","content":[{"type":"image_url","image_url":{"url":"data:image/jpeg;base64,..."},"type":"text","text":"Analise isto."}]}]}'

Tais exportações facilitam o compartilhamento com equipes. Além disso, o modo de colaboração do Apidog rastreia as alterações, controlando a versão de seus experimentos com NVIDIA Nemotron Nano 12B v2 VL.

Na prática, os desenvolvedores relatam ciclos de iteração 40% mais rápidos com o Apidog, pois ele abstrai o código repetitivo. Faça a transição para a produção exportando para o Postman ou integrando diretamente via SDKs.

Tratamento de Erros, Melhores Práticas e Estratégias de Otimização

Erros surgem no uso da API, então você os antecipa proativamente. Problemas comuns incluem 401 (chave inválida)—verifique novamente seu token Bearer. Para 400 (JSON malformado), valide os payloads com ferramentas como JSONLint. Erros específicos de imagem, como strings base64 superdimensionadas, são resolvidos comprimindo arquivos previamente usando Pillow:

from PIL import Image

img = Image.open("large_image.jpg")

img = img.resize((512, 512))

img.save("resized.jpg", quality=85)

As melhores práticas incluem limitação de taxa em seu lado com time.sleep(6) entre as chamadas para respeitar o limite de 10 RPM. Armazene em cache respostas frequentes usando Redis para minimizar as chamadas à API.

A otimização se concentra na engenharia de prompt. Use consultas concisas: "Identifique objetos e suas relações nesta foto" produz resultados melhores do que as vagas. Experimente valores de temperatura—mais baixos para tarefas factuais, mais altos para geração criativa.

Para escalabilidade sem custo dentro dos limites, agrupe consultas lógicas em mensagens únicas, maximizando a eficiência de tokens. Monitore o uso de tokens via metadados da resposta: result['usage']['total_tokens'].

Além disso, integre o registro (logging) com o módulo logging para rastrear o desempenho:

import logging

logging.basicConfig(level=logging.INFO)

logging.info(f"Tokens de resposta: {result['usage']['total_tokens']}")

Esses hábitos constroem aplicações robustas. À medida que você aprimora, considere configurações híbridas combinando Nemotron com pré-processamento local para latência ultrabaixa.

Conclusão

Você agora possui as ferramentas para aproveitar a API NVIDIA Nemotron Nano 12B v2 VL gratuitamente. Desde a configuração inicial até implantações avançadas, este guia o prepara para o sucesso. Experimente com ousadia—comece com chamadas simples e itere em direção a aplicações sofisticadas. Lembre-se, pequenos ajustes consistentes, como prompts refinados ou testes assistidos por Apidog, rendem ganhos substanciais.

Para leitura adicional, explore os fóruns de desenvolvedores da NVIDIA ou o changelog do OpenRouter. Baixe o Apidog hoje mesmo, se ainda não o fez, e transforme seus fluxos de trabalho de API. Qual projeto você vai abordar primeiro?