Desenvolvedores e pesquisadores buscam cada vez mais LLMs sem restrições para expandir os limites das aplicações de inteligência artificial. Esses grandes modelos de linguagem não censurados operam sem filtros de conteúdo embutidos, permitindo respostas irrestritas para diversas consultas. À medida que o cenário da IA evolui, os LLMs não censurados capacitam os usuários a explorar tópicos complexos, desde dilemas éticos até narrativas criativas, sem restrições morais ou de segurança predefinidas.

Neste artigo, especialistas examinam os fundamentos técnicos dos LLMs não censurados, suas arquiteturas e implantações no mundo real. Os usuários devem lidar com esses modelos de forma responsável, pois a falta de filtros pode gerar conteúdo sensível.

Compreendendo os LLMs Não Censurados: Fundamentos Técnicos

Engenheiros projetam LLMs não censurados ajustando modelos base em conjuntos de dados que omitem instruções de alinhamento, que normalmente impõem diretrizes éticas em variantes padrão. Modelos base como Llama 2 ou Mistral passam por esse processo, onde os desenvolvedores removem mecanismos de negação — como recusar consultas sobre violência ou preconceito — e ajustam os prompts do sistema para encorajar respostas abrangentes. Por exemplo, técnicas como o Aprendizado por Reforço a partir de Feedback Humano (RLHF) são ignoradas ou revertidas para priorizar a utilidade em detrimento da segurança.

Além disso, os LLMs não censurados aproveitam arquiteturas de transformadores, prevendo os próximos tokens em sequências com bilhões de parâmetros. Comunidades de código aberto contribuem compartilhando versões ajustadas em plataformas como Hugging Face, onde os modelos alcançam a não censura através da "ablitação" — um método que erode os alinhamentos de segurança por meio de um ajuste fino direcionado. Essa abordagem garante que os modelos respondam a qualquer prompt, mas exige hardware robusto para inferência, muitas vezes requerendo GPUs com VRAM ampla.

Esses modelos diferem dos proprietários, como o GPT-4, que incorporam filtros rigorosos para cumprir as regulamentações. Variantes não censuradas, no entanto, promovem a inovação em campos como pesquisa e simulação, onde saídas irrestritas revelam capacidades brutas. No entanto, os desenvolvedores mitigam os riscos implementando salvaguardas personalizadas nas aplicações.

Benefícios e Riscos de LLMs Sem Restrições

Os usuários obtêm vantagens significativas com LLMs sem restrições, pois esses modelos fornecem insights não filtrados que aprimoram a resolução de problemas. Por exemplo, pesquisadores os utilizam para testar hipóteses em domínios sensíveis, onde modelos padrão poderiam reter informações. Além disso, os programadores se beneficiam da geração irrestrita de código, acelerando os ciclos de desenvolvimento sem interrupções éticas.

Além disso, esses LLMs promovem a transparência na IA, permitindo que os engenheiros inspecionem e modifiquem comportamentos diretamente. Comunidades constroem sobre eles, criando variantes especializadas para tarefas como processamento multilíngue ou raciocínio de contexto longo. No entanto, surgem riscos de uso indevido potencial, como a geração de conteúdo prejudicial, o que exige supervisão ética dos implementadores.

Plataformas como Ollama permitem execuções locais, minimizando preocupações com a privacidade dos dados e maximizando o controle. No entanto, altas demandas computacionais representam barreiras, embora otimizações como a quantização resolvam isso reduzindo o tamanho do modelo sem sacrificar muito desempenho.

Critérios para Classificar os 10 Melhores LLMs Não Censurados

Analistas classificam esses modelos com base na contagem de parâmetros, velocidade de inferência, suporte da comunidade e pontuações de benchmark de fontes como as tabelas de classificação do Hugging Face. A versatilidade em diversas tarefas — como codificação, interpretação de papéis e raciocínio — também é um fator, juntamente com a facilidade de implantação local. Além disso, as atualizações recentes de 2025 priorizam modelos com janelas de contexto estendidas e designs de mistura de especialistas (MoE) para eficiência.

1. Dolphin 3.0: Potência Não Censurada Orientada pela Precisão

A Cognitive Computations desenvolve o Dolphin 3.0 na base Llama 3.1 8B, ajustando-o para raciocínio e dirigibilidade excepcionais via prompts do sistema. Este modelo se destaca em tarefas intensivas em lógica, entregando saídas precisas e não filtradas sem excesso de verbosidade. Engenheiros apreciam seus 8 bilhões de parâmetros, que equilibram desempenho e necessidades de recursos, exigindo cerca de 16GB de VRAM para inferência ideal.

As principais características incluem uma arquitetura híbrida que melhora a aderência aos prompts, tornando-o ideal para assistentes de IA personalizados. Além disso, o Dolphin 3.0 suporta chamadas de função, permitindo a integração com ferramentas externas. Os prós incluem controle incomparável sobre personas e resolução rápida de problemas em codificação ou matemática, enquanto os contras envolvem seu estilo de prosa direto, que é adequado para aplicações técnicas, mas não narrativas.

Desenvolvedores executam o Dolphin 3.0 localmente usando Ollama: instale a ferramenta, puxe o modelo com ollama pull dolphin-llama3, e consulte via API ou CLI. Benchmarks mostram que ele supera seus pares em raciocínio estruturado, com pontuações acima de 80% nos testes MMLU. Além disso, sua não censura decorre da curadoria de conjuntos de dados que evitam vieses de alinhamento, permitindo a exploração de casos extremos na pesquisa.

Em cenários de implantação, as equipes o integram em pipelines para análise automatizada, onde sua eficiência se destaca. No entanto, os usuários calibram os prompts cuidadosamente para evitar vieses não intencionais.

2. Nous Hermes 3: Modelo Não Censurado Focado na Criatividade

A NousResearch desenvolve o Nous Hermes 3 na base Llama 3.2 8B, enfatizando a escrita criativa e a interpretação de papéis com saídas de formato longo coerentes. Com 8 bilhões de parâmetros, ele mantém a consistência dos personagens em diálogos, aproveitando o ChatML para conversas estruturadas. Isso o torna uma excelente escolha para geração narrativa sem restrições.

As características destacam sua compreensão matizada de prompts, suportando contextos estendidos de até 8k tokens. Os prós incluem criação superior de ficção e interações envolventes, enquanto os contras notam verbosidade ocasional em consultas concisas. Atualizações impulsionadas pela comunidade garantem melhorias contínuas.

Para implantar, os usuários utilizam o Hugging Face: baixam o modelo, o carregam com a biblioteca Transformers via from transformers import AutoModelForCausalLM; model = AutoModelForCausalLM.from_pretrained('NousResearch/Hermes-3-Llama-3.2-8B'), e geram texto. Benchmarks indicam altas pontuações em benchmarks criativos, frequentemente excedendo 85% em avaliações de interpretação de papéis.

Além disso, sua não censura surge do ajuste fino em conjuntos de dados diversos e não filtrados, permitindo explorações profundas na narrativa. Desenvolvedores o aplicam no design de jogos, onde a criatividade irrestrita acelera a prototipagem.

3. LLaMA-3.2 Dark Champion Abliterado: Fera Não Censurada de Contexto Longo

DavidAU ajusta o LLaMA-3.2 Dark Champion em uma arquitetura MoE 8x3B, ablacionando camadas de segurança para saídas não alinhadas. Com uma janela de contexto de 128k, ele processa vastos documentos de forma eficiente, ideal para análise de dados.

O design MoE deste modelo ativa subconjuntos de parâmetros, reduzindo o poder computacional enquanto mantém a potência. Os prós incluem inferência rápida e raciocínio profundo, mas os contras incluem potenciais vieses negativos e altas demandas de VRAM (cerca de 40GB).

A instalação envolve downloads do Hugging Face, com inferência via pipeline('text-generation', model='DavidAU/Llama-3.2-8X3B-MOE-Dark-Champion-Instruct-uncensored-abliterated-18.4B'). Ele pontua alto em benchmarks de contexto longo, superando 90% de precisão em tarefas de recuperação.

Além disso, a ablação garante que não haja restrições, adequando-se à pesquisa avançada. As equipes o utilizam para automatizar relatórios, onde sua escala lida com conjuntos de dados complexos de forma contínua.

4. Llama 2 Não Censurado: LLM Não Censurado de Nível de Entrada Versátil

O Llama 2 da Meta serve como base para esta variante não censurada, ajustada por George Sung para eliminar filtros morais. Com 7-13 bilhões de parâmetros, ele roda em hardware de consumidor, suportando interpretação de papéis e tarefas gerais.

As características incluem múltiplas opções de quantização como GGUF para equilíbrio CPU/GPU. Prós: acessibilidade e plugins da comunidade; contras: raciocínio mais fraco que o Llama 3.

Execute-o via Ollama: ollama run llama2-uncensored. Popular com 234 mil downloads, ele se desempenha bem para uso leve.

Além disso, seu design fomenta a experimentação, tornando-o um pilar para iniciantes em IA não censurada.

5. WizardLM Não Censurado: Multiuso Confiável

TheBloke empacota o WizardLM Não Censurado no Llama 2 13B, removendo alinhamentos para aplicações amplas. Ele se destaca em chat e escrita, com capacidades equilibradas.

Aspectos chave: comunidade forte, fácil implantação. Prós: previsibilidade; contras: base desatualizada.

Implante com ollama run wizardlm-uncensored. Ele acumula 23 mil downloads, adequado para fluxos de trabalho criativos.

6. Dolphin 2.7 Mixtral 8x7B: Modelo Não Censurado Especializado em Codificação

Eric Hartford constrói isso sobre o MoE do Mixtral, ajustado para codificação sem filtros. Parâmetros 8x7B garantem eficiência em tarefas especializadas.

Características: formatos de quantização, alto desempenho de codificação. Prós: velocidade; contras: necessidades de hardware.

Use Ollama: ollama run dolphin-mixtral:8x7b. Benchmarks destacam sua proficiência em programação.

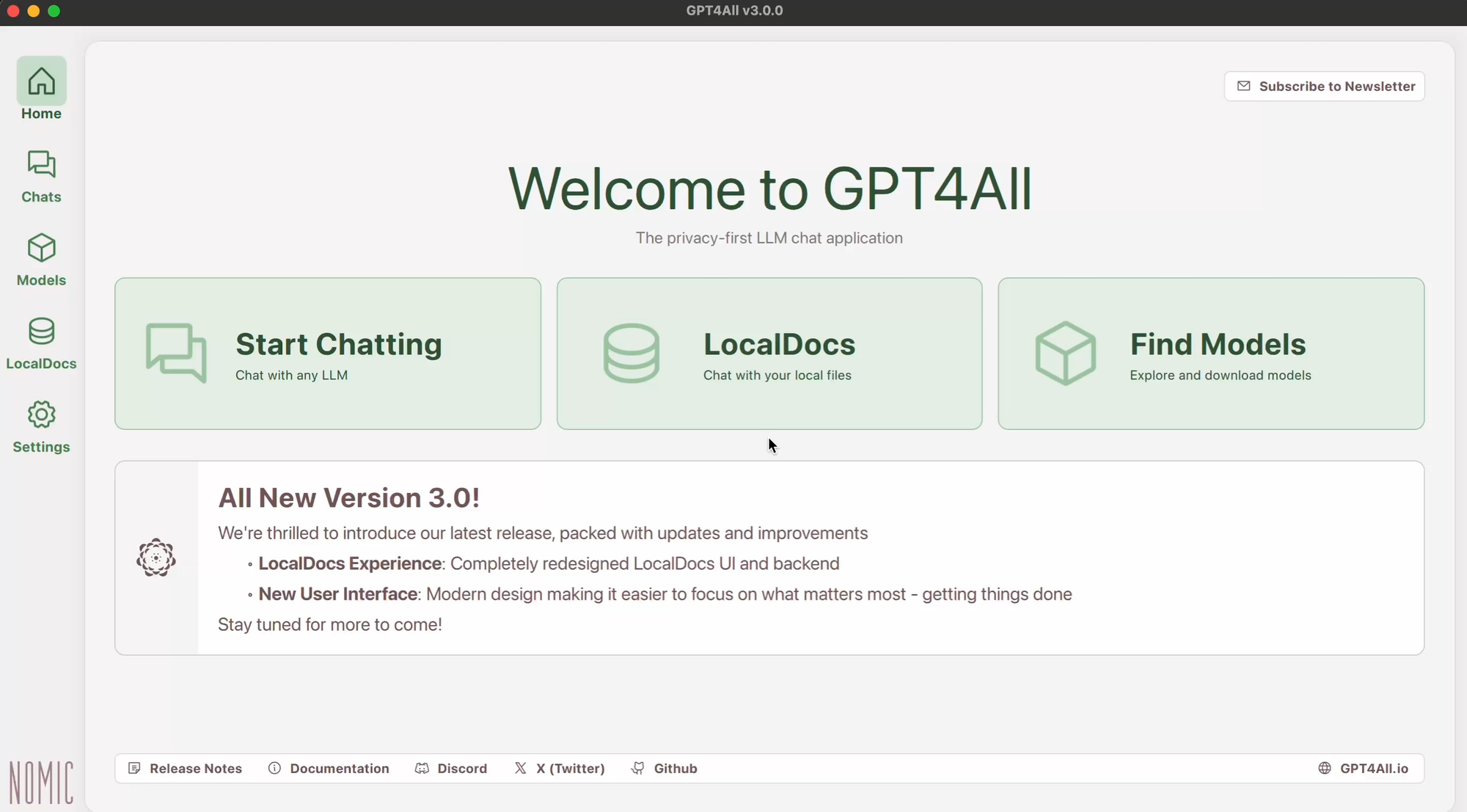

7. GPT-4All: Framework Não Censurado Focado Offline

GPT-4All otimiza para execuções locais, construindo sobre a pesquisa de transformadores para chats não censurados. O suporte multiplataforma auxilia na implantação.

Prós: gratuito, personalizável; contras: limites de contexto.

Instale via site oficial, execute os executáveis. Ideal para usuários preocupados com a privacidade.

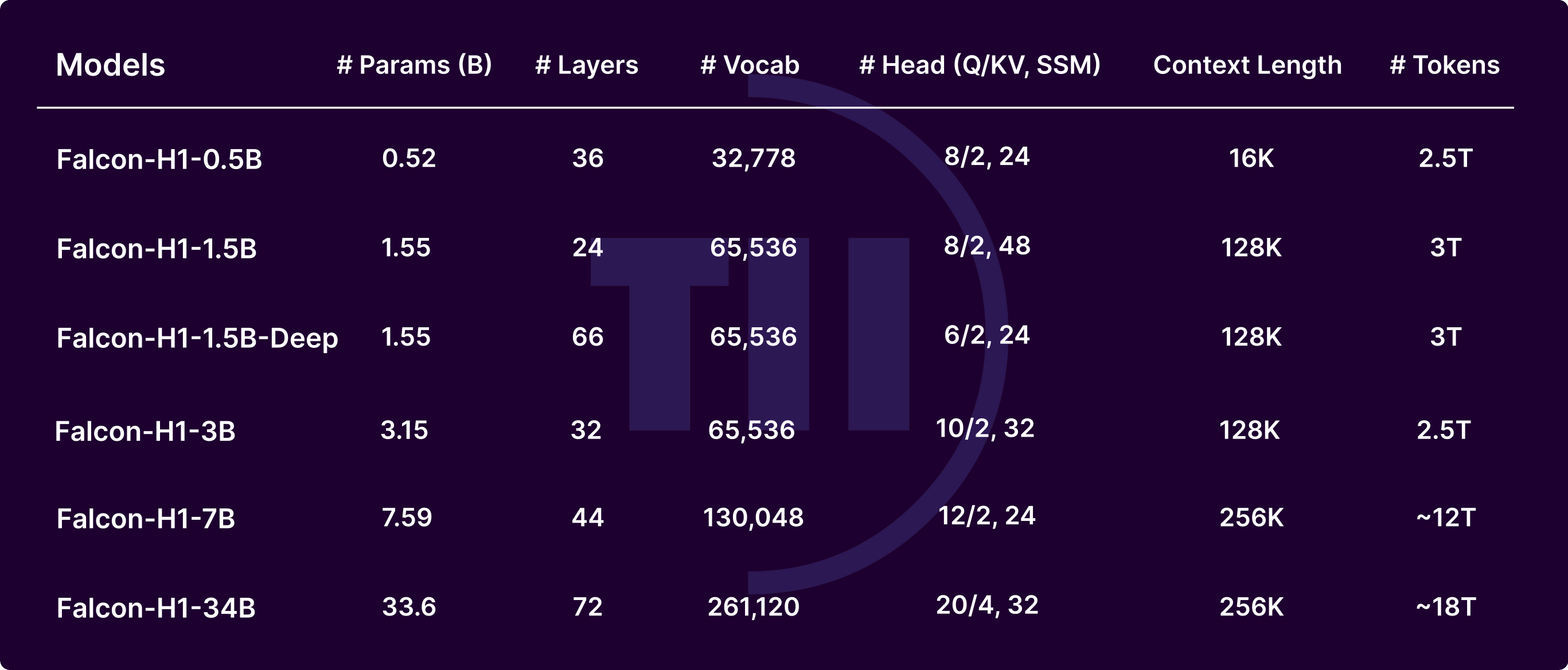

8. Falcon LLM: Alternativa Não Censurada de Alto Desempenho

O Technology Innovation Institute desenvolve o Falcon com arquitetura inovadora para texto matizado. Otimizado para velocidade.

Características: design modular. Prós: qualidade; contras: maturidade do ecossistema.

Carregue com a biblioteca Transformers. Adequado para pesquisa.

9. MPT-7B Chat: LLM Não Censurado Conversacional

A MosaicML ajusta o MPT-7B para chats, enfatizando baixa latência. 7B parâmetros se encaixam em configurações modestas.

Prós: tempo real; contras: tarefas complexas.

Implante localmente com scripts. Ótimo para bots.

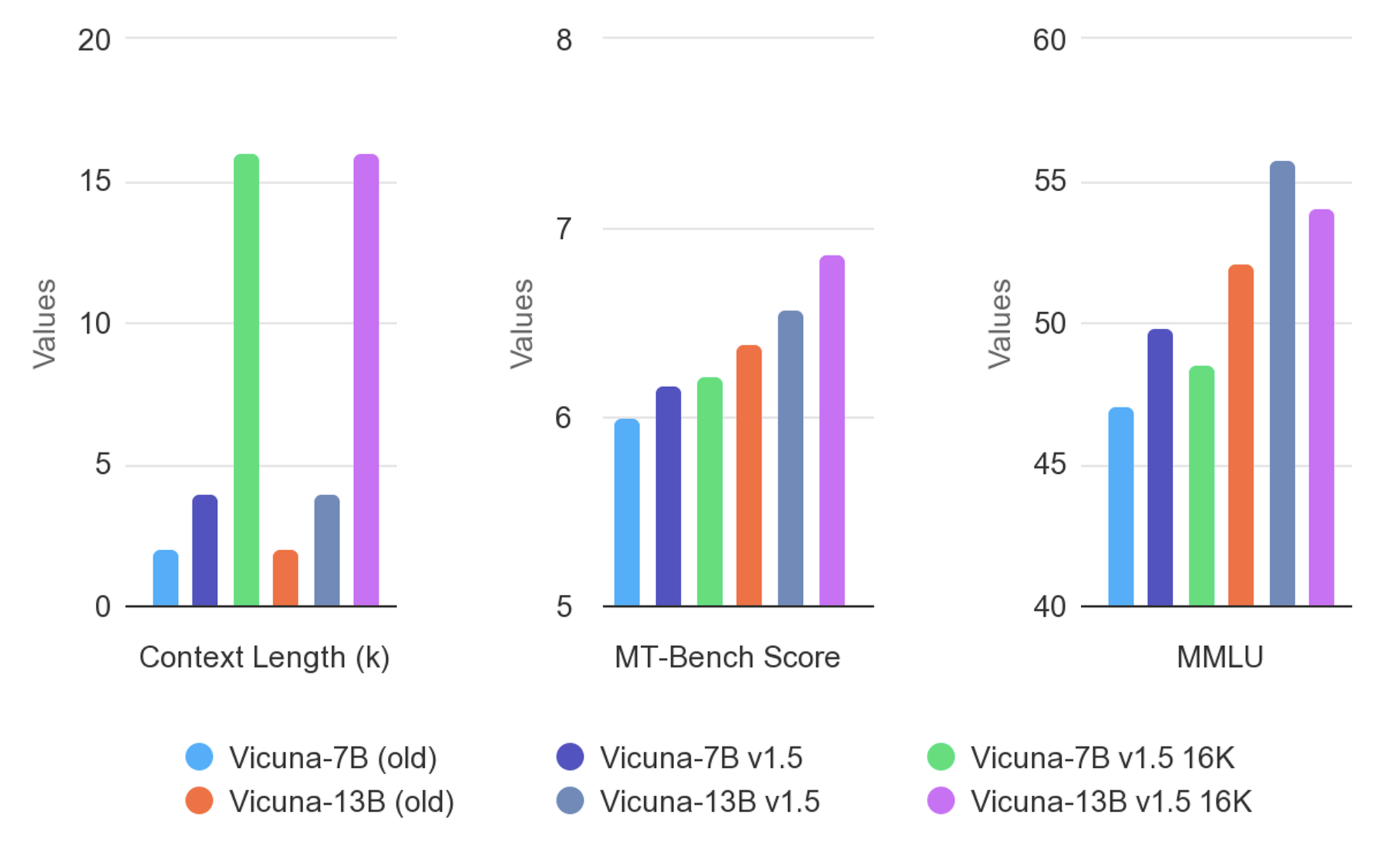

10. Vicuna: Modelo Não Censurado Otimizado para Diálogo

Vicuna ajusta-se a dados conversacionais para interações naturais. Design leve.

Prós: envolvente; contras: fraquezas não conversacionais.

Execute via ferramentas da comunidade. Aprimora aplicativos interativos.

Melhores Práticas de Implantação para LLMs Não Censurados

Engenheiros otimizam as implantações selecionando níveis de quantização, como Q4 ou Q8, para se adequar ao hardware. Ferramentas como Ollama ou LM Studio simplificam as execuções, enquanto APIs via Apidog permitem o dimensionamento.

Além disso, monitore o uso de VRAM e ajuste fino para domínios específicos. As medidas de segurança incluem o isolamento de ambientes.

Tendências Futuras em LLMs Não Censurados

Inovadores preveem modelos MoE maiores e melhores técnicas de ablação. A integração com capacidades multimodais expande os usos.

No entanto, pressões regulatórias podem influenciar o desenvolvimento, impulsionando abordagens híbridas.

Conclusão

Esta exploração revela como os LLMs sem restrições revolucionam as aplicações de IA. Da precisão do Dolphin 3.0 aos diálogos do Vicuna, esses modelos oferecem liberdade incomparável. Desenvolvedores os utilizam de forma responsável, aproveitando ferramentas como o Apidog para integrações perfeitas. À medida que a tecnologia avança, esses LLMs não censurados continuam a impulsionar a inovação, transformando os cenários de pesquisa e desenvolvimento.