À medida que os modelos de IA expandem os limites do raciocínio e das capacidades agentivas, o Kimi K2 Thinking surge como uma inovação notável da Moonshot AI, combinando acessibilidade de código aberto com desempenho de nível empresarial. Este modelo de agente pensante de trilhões de parâmetros redefine a forma como os desenvolvedores interagem com grandes modelos de linguagem, particularmente através de sua robusta API. Projetado para tarefas que exigem inferência profunda e encadeamento de ferramentas, a API do Kimi K2 Thinking permite integração perfeita em aplicações, desde agentes de pesquisa automatizados até assistentes de codificação complexos. Neste guia, exploraremos os fundamentos, arquitetura, benchmarks, preços, aplicações práticas e uso prático do Kimi K2 Thinking – capacitando você a aproveitar a API do Kimi K2 Thinking de forma eficaz. Vamos começar!

Quer uma plataforma integrada e completa para sua Equipe de Desenvolvedores trabalhar em conjunto com máxima produtividade?

Apidog atende a todas as suas demandas e substitui o Postman por um preço muito mais acessível!

Introdução ao Kimi K2 Thinking

O Kimi K2 Thinking representa um passo ousado da Moonshot AI na IA de código aberto, sendo lançado como um modelo de agente pensante especializado, otimizado para raciocínio sequencial e uso de ferramentas. Em sua essência, o Kimi K2 Thinking é construído para simular a deliberação humana, processando consultas através de tokens de "pensamento" estendidos que permitem interações de ferramentas em múltiplas etapas sem a constante intervenção humana. Este modelo, disponível via API para desenvolvedores, se destaca em ambientes que exigem retenção prolongada de contexto e tomada de decisões adaptativa, como busca agentiva ou geração de código.

O que diferencia o Kimi K2 Thinking é seu foco na escalabilidade em tempo de teste – expandindo não apenas o tamanho do modelo, mas a profundidade da inferência durante a execução. Com um trilhão de parâmetros, ele lida com cadeias de pensamento intrincadas, tornando a API do Kimi K2 Thinking ideal para aplicações onde a precisão supera a velocidade. Os desenvolvedores podem acessá-lo através da plataforma da Moonshot, onde o modo de chat está ativo em kimi.com, e as capacidades agentivas completas serão lançadas em breve. Para aqueles cansados de modelos de caixa preta, os pesos e códigos abertos do Kimi K2 Thinking convidam à personalização, promovendo um ecossistema impulsionado pela comunidade. À medida que nos aprofundamos, você verá como esta API transforma o raciocínio abstrato em ferramentas tangíveis para seus projetos.

A Arquitetura do Kimi K2 Thinking

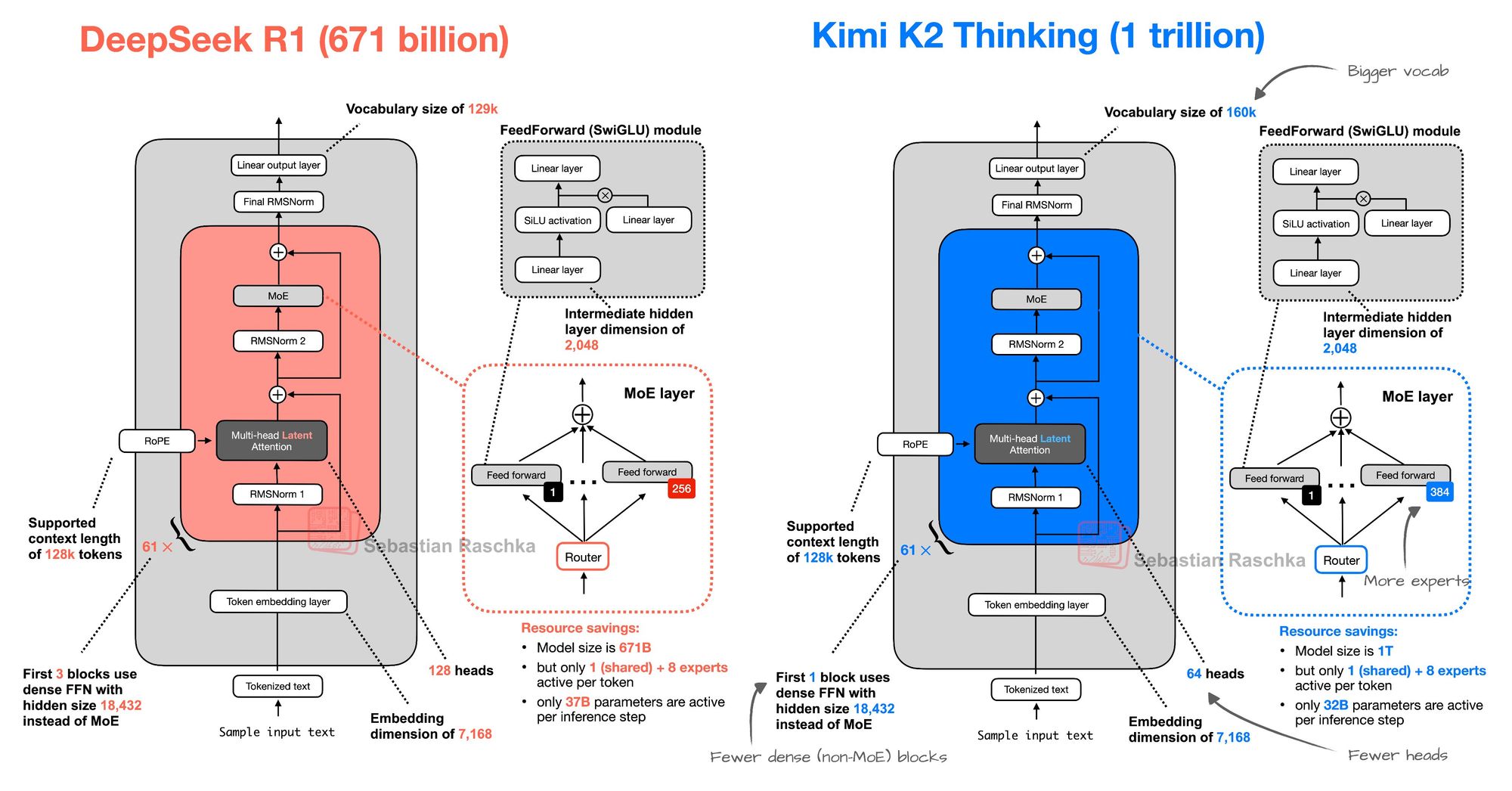

Aprofundando-nos nos fundamentos técnicos, o Kimi K2 Thinking emprega uma arquitetura de Mistura de Especialistas (MoE) que ecoa o design do DeepSeek R1, mas escala ambiciosamente para uma eficiência superior. Assim como os 671 bilhões de parâmetros do DeepSeek R1, o Kimi K2 Thinking aproveita a ativação esparsa para rotear entradas através de especialistas especializados, minimizando o desperdício de computação. No entanto, ele expande o vocabulário para 160.000 tokens — acima dos 129.000 do DeepSeek R1 — permitindo um tratamento mais rico de termos multilíngues e específicos de domínio, crucial para as aplicações globais da API do Kimi K2 Thinking.

O modelo apresenta 384 especialistas em comparação com os 256 do DeepSeek R1, permitindo uma especialização mais detalhada em tarefas como codificação ou pesquisa. No entanto, ele otimiza com menos blocos densos (não-MoE) e cabeças de atenção reduzidas (64 versus 128), otimizando a velocidade de inferência sem sacrificar a profundidade. Esse equilíbrio resulta em uma janela de contexto de 256K, suportando diálogos estendidos ou análise de documentos nas chamadas da API do Kimi K2 Thinking. Treinada em diversos conjuntos de dados que enfatizam comportamentos agentivos, a arquitetura prioriza fases de "pensamento" — monólogos internos iterativos que refinam as saídas antes da invocação de ferramentas.

Para os usuários da API, isso se traduz em um raciocínio multi-etapa confiável: uma única requisição da API do Kimi K2 Thinking pode orquestrar de 200 a 300 chamadas de ferramentas, desde web scraping até execução de código, tudo dentro de uma resposta unificada. A ênfase da Moonshot AI em pesos de código aberto significa que os desenvolvedores podem ajustar o modelo para necessidades específicas, como modelagem financeira, enquanto o baixo impacto da API se adapta a implantações de borda. No geral, a arquitetura do Kimi K2 Thinking incorpora escalabilidade eficiente, tornando a API do Kimi K2 Thinking uma escolha pragmática para equipes conscientes de recursos.

Benchmarks e Capacidades do Kimi K2 Thinking

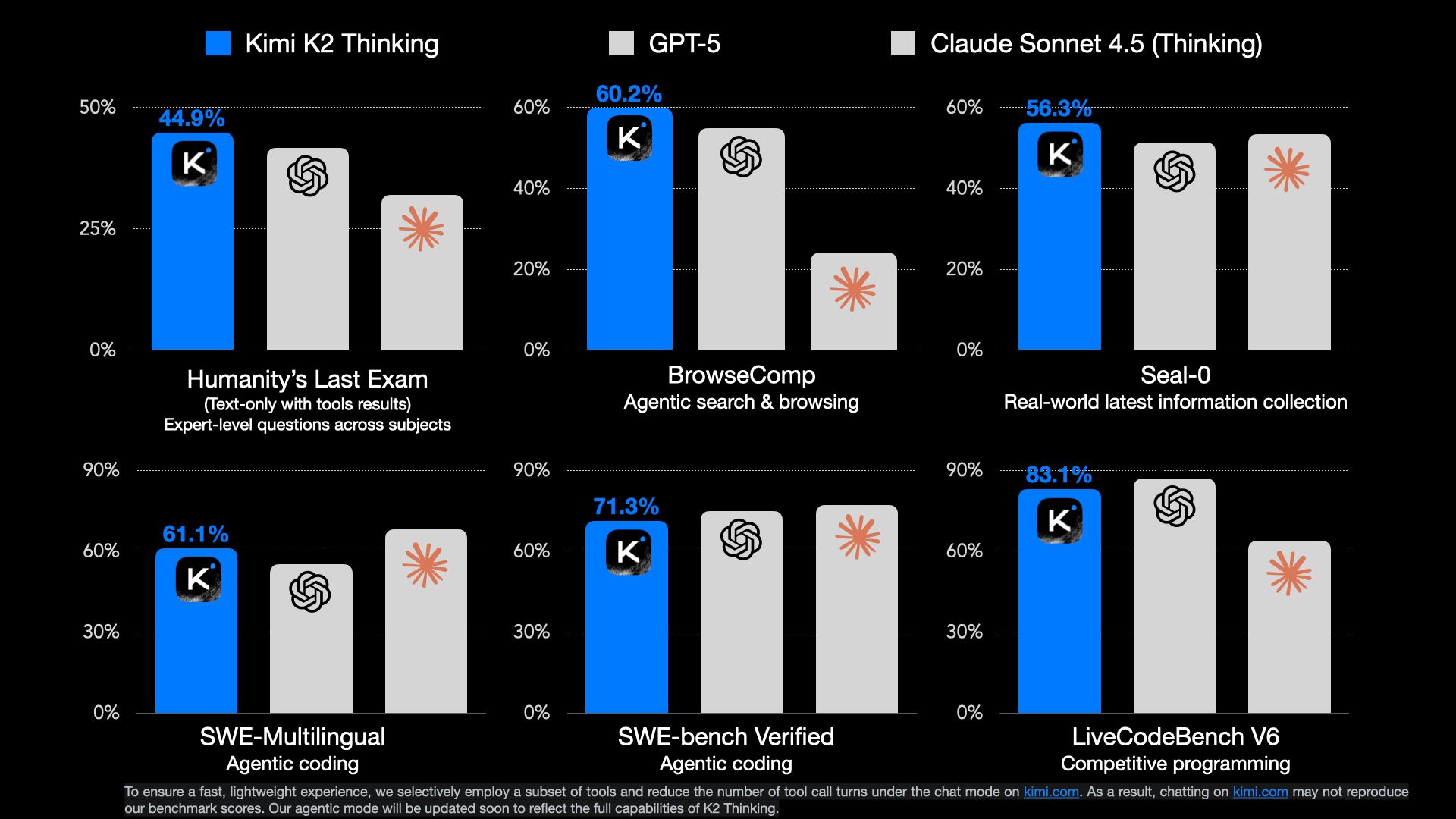

O Kimi K2 Thinking rapidamente alcançou o status de estado da arte (SOTA) em benchmarks agentivos, ressaltando sua destreza como um agente pensante de código aberto. Na Avaliação HumanEval-Like (HLE), ele atinge 44,9% — superando concorrentes na resolução de problemas complexos. Da mesma forma, o BrowseComp pontua 60,2%, destacando sua excelência em navegação na web e síntese de dados, onde modelos tradicionais falham no raciocínio multipágina.

Uma característica marcante é sua resistência: o modelo executa até 200-300 chamadas de ferramentas sequenciais autonomamente, ideal para tarefas de longo prazo como pipelines de pesquisa ou maratonas de depuração via API do Kimi K2 Thinking. Ele se destaca em raciocínio, busca agentiva e codificação, com forte desempenho no GAIA e LiveCodeBench, muitas vezes superando rivais de código fechado. A janela de contexto de 256K suporta o processamento de bases de código inteiras ou documentos extensos, permitindo saídas nuançadas.

A Moonshot AI posiciona o Kimi K2 Thinking como um pioneiro na escalabilidade em tempo de teste, amplificando "tokens de pensamento" e turnos de ferramentas para uma inferência mais profunda. Atualmente ativo no modo de chat em kimi.com, o modo agentivo completo promete interações de API ainda mais fluidas. Os primeiros usuários elogiam seu equilíbrio entre precisão e velocidade, com latência da API abaixo de 2 segundos para consultas padrão. Para desenvolvedores, esses benchmarks significam que a API do Kimi K2 Thinking entrega resultados confiáveis e de alta fidelidade, promovendo a confiança em ambientes de produção.

Preços da API do Kimi K2 Thinking

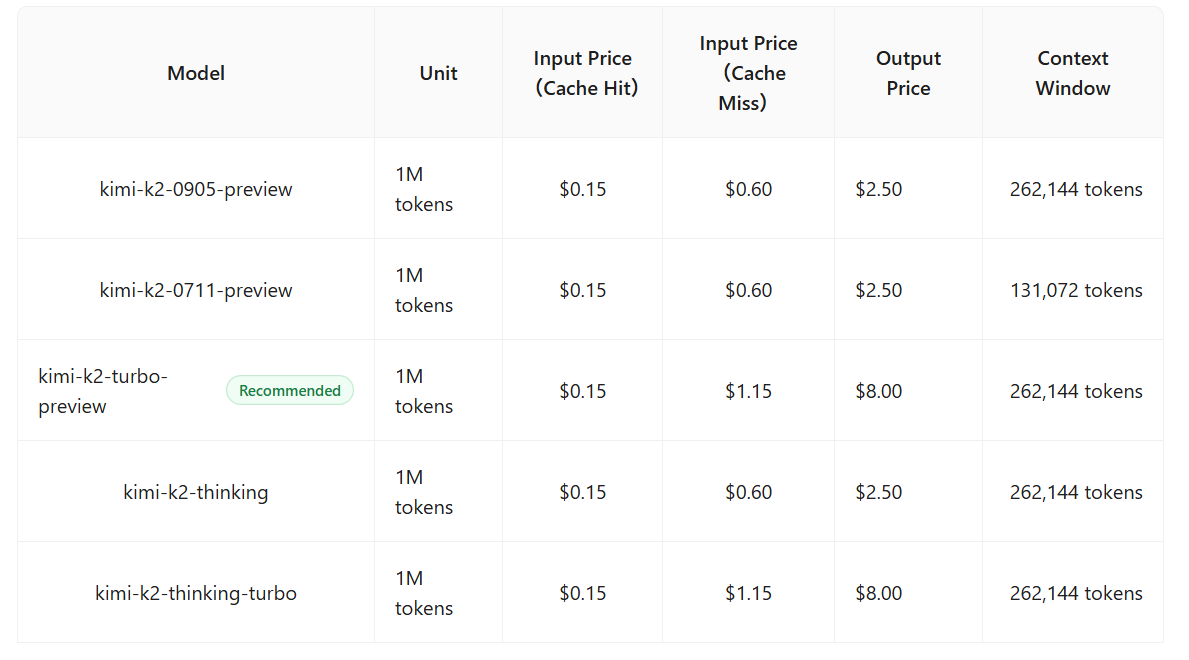

Um dos aspectos mais atraentes do Kimi K2 Thinking é seu preço competitivo, posicionando a API do Kimi K2 Thinking como uma alternativa econômica aos modelos premium. Os tokens de entrada custam US$ 0,15 por milhão, com as saídas a US$ 2,50 por milhão — significativamente mais baixos do que as taxas de US$ 3/US$ 15 do Claude 4.5 Sonnet. Isso o torna ideal para aplicações de alto volume, como chatbots ou análise de dados.

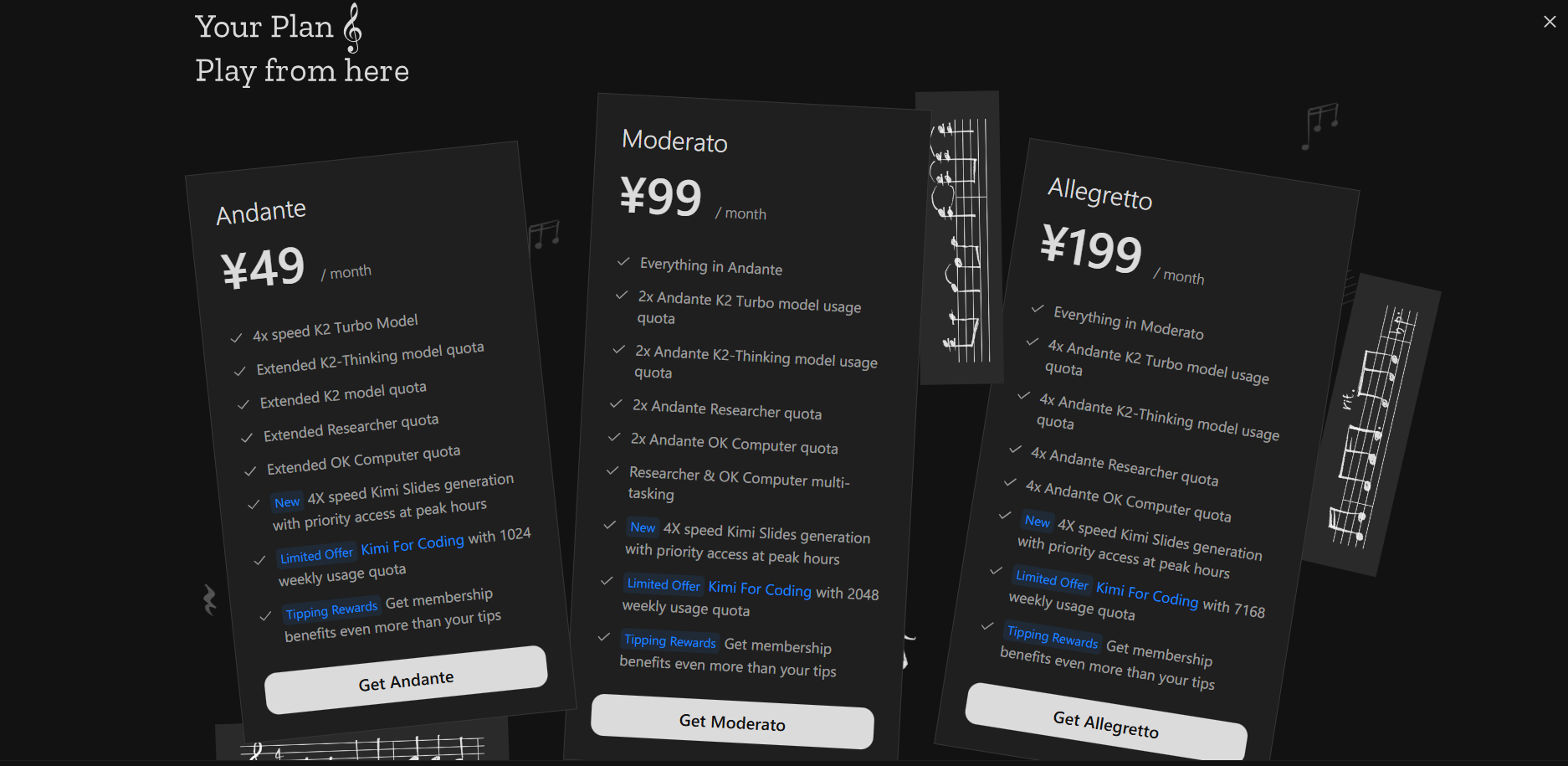

Apesar de superar o GPT-5 e o Sonnet em benchmarks como HLE e BrowseComp, o Kimi K2 Thinking mantém a acessibilidade através de um design MoE eficiente, reduzindo os custos operacionais sem comprometer a qualidade. Os níveis gratuitos oferecem chamadas de API limitadas para testes, enquanto os planos pagos começam em US$ 49/mês, escalando para volumes empresariais com descontos por volume. Nenhuma taxa oculta para chamadas de ferramentas aumenta a previsibilidade. Para startups, esse preço democratiza a IA agentiva avançada, permitindo a experimentação sem despesas proibitivas.

Casos de Uso Práticos para a API do Kimi K2 Thinking

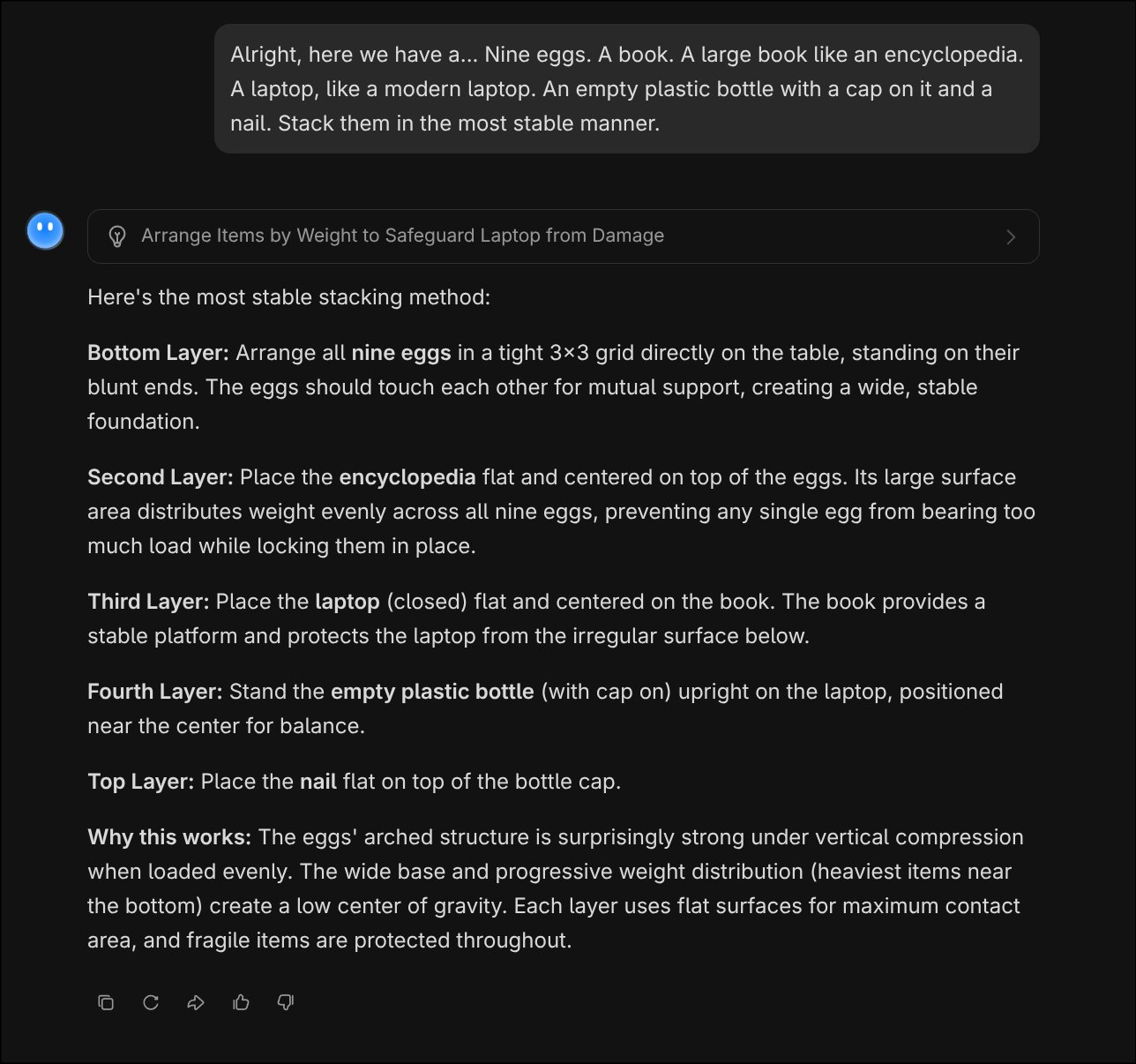

A força do Kimi K2 Thinking reside em seu raciocínio semelhante ao humano, tornando a API do Kimi K2 Thinking perfeita para problemas complexos e multi-etapas. Considere um quebra-cabeça clássico de empilhamento: "Certo, aqui temos nove ovos, um livro (grande como uma enciclopédia), um laptop (moderno), uma garrafa plástica vazia com tampa e um prego. Empilhe-os da maneira mais estável."

A API responde com dedução lógica e passo a passo. A saída demonstra a simulação física intuitiva e o planejamento sequencial do Kimi K2 Thinking, muito além das respostas decoradas.

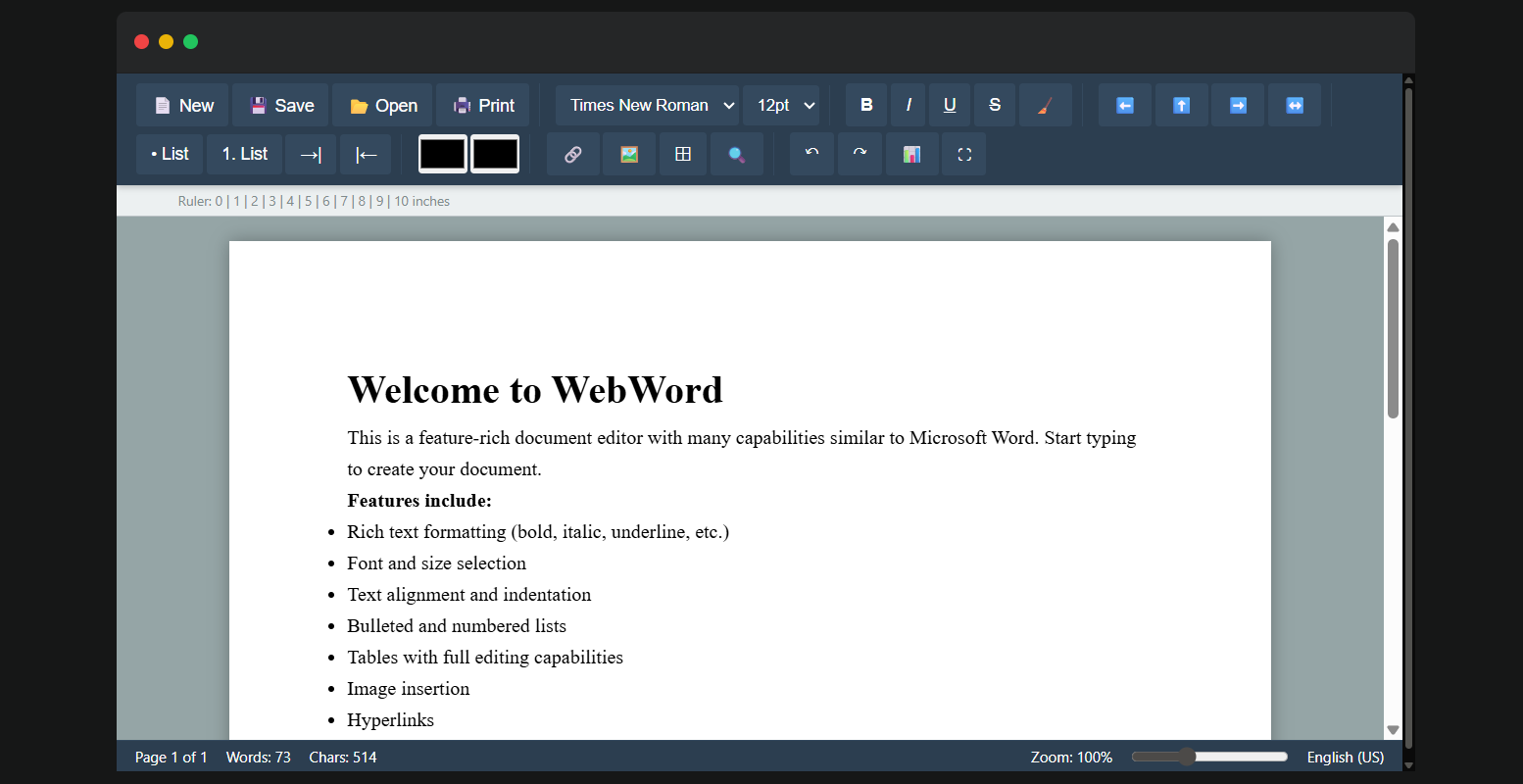

Para codificação: Considere uma tarefa de clonagem de documento, como replicar a estrutura de um relatório do Microsoft Word: Solicite à API com "Clonar o layout deste modelo do Word, incluindo tabelas, imagens, fontes personalizadas e cabeçalhos."

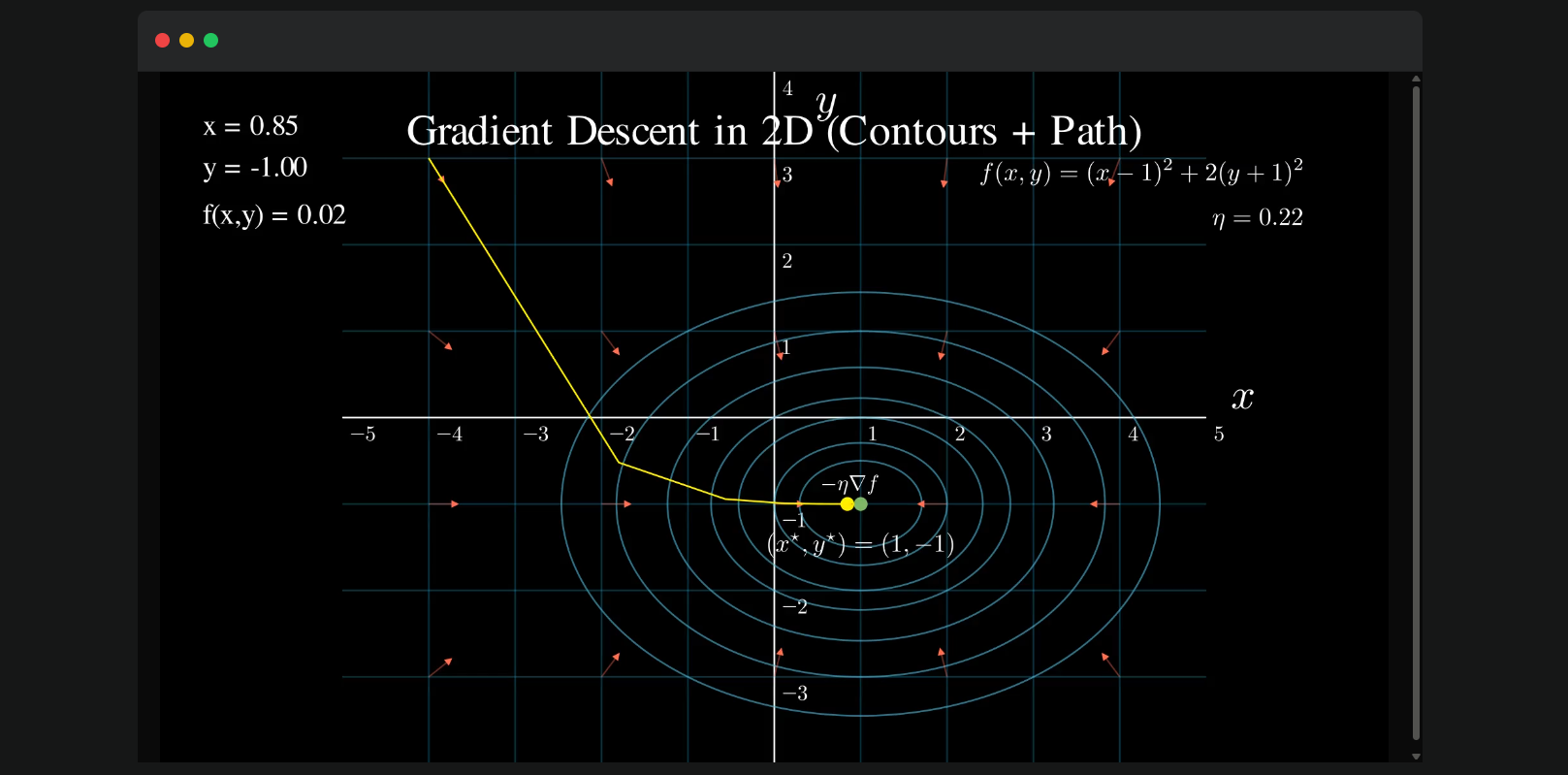

Outra aplicação fascinante é a visualização do gradiente descendente, um conceito fundamental de aprendizado de máquina. Usando a API do Kimi K2 Thinking, envie: "Visualize o gradiente descendente." O modelo raciocina através da matemática, invoca o Matplotlib via execução de código e produz um gráfico passo a passo: cada iteração traça a descida da função de custo, com anotações para a taxa de aprendizado e o ponto de convergência. A resposta inclui o trecho de código Python para reprodutibilidade, além de insights, por exemplo, "Na iteração 5, a perda cai abaixo de 0,1, confirmando a estabilidade." Isso não apenas educa, mas também permite a prototipagem rápida para tutoriais de ML ou demonstrações de otimização.

Compatibilidade da API do Kimi K2 Thinking

Um grande atrativo da API do Kimi K2 Thinking é sua compatibilidade direta com as especificações da interface da OpenAI, facilitando migrações para aplicações existentes. Desenvolvedores podem usar os SDKs de Python ou Node.js da OpenAI inalterados, simplesmente atualizando a base_url para o endpoint da Moonshot "https://api.moonshot.ai/v1" e trocando a api_key por uma credencial Kimi.

Essa compatibilidade significa que, se o seu serviço depende de endpoints GPT, a transição para o Kimi K2 Thinking exige ajustes mínimos no código — sem necessidade de refatorar chamadas de SDK ou lidar com novos esquemas. Por exemplo, uma solicitação de conclusão de chat:

from openai import OpenAI

client = OpenAI(

api_key="your_kimi_api_key",

base_url="https://api.moonshot.ai/v1"

)

response = client.chat.completions.create(

model="kimi-k2-thinking",

messages=[{"role": "user", "content": "Explain quantum entanglement."}]

)

A resposta espelha o formato da OpenAI, com o raciocínio aprimorado do Kimi K2 Thinking. Essa configuração sem atritos acelera a adoção, permitindo testes A/B ou implantações híbridas sem problemas. Para fluxos agentivos, as chamadas de ferramentas se alinham perfeitamente, suportando esquemas JSON para saídas estruturadas.

Obtendo e Usando a Chave da API do Kimi K2 Thinking

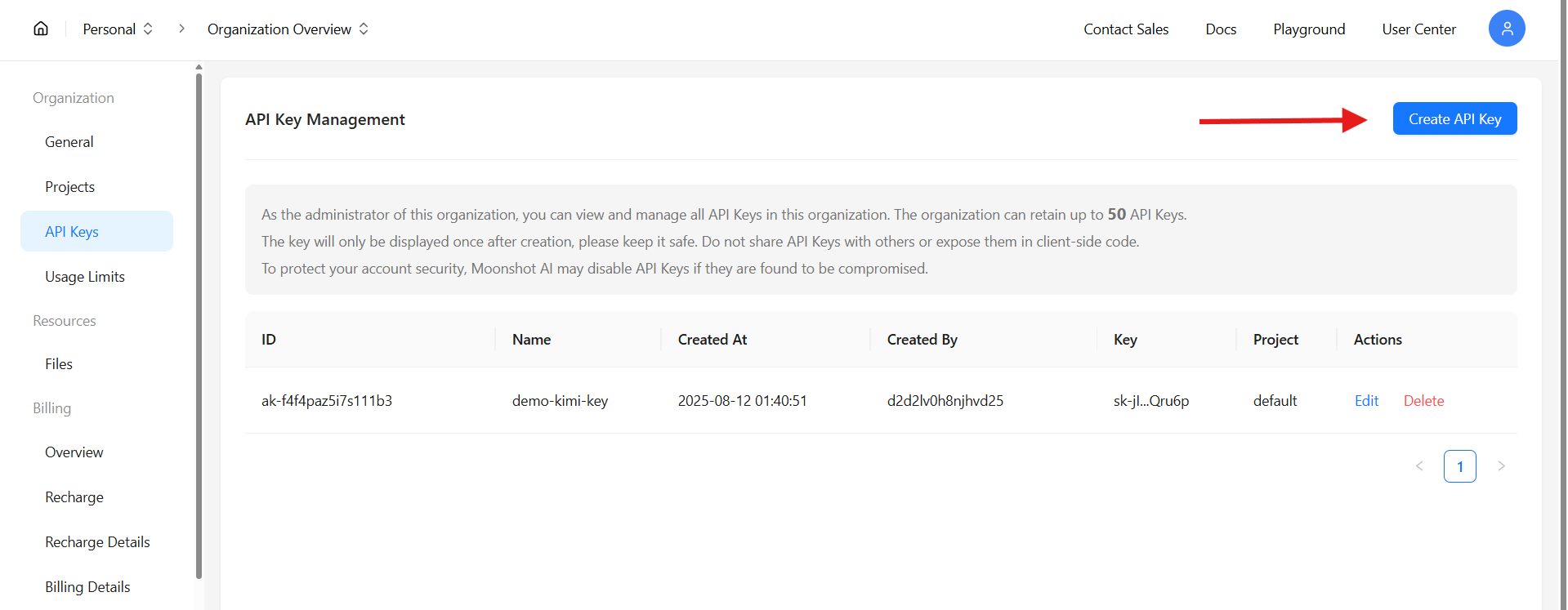

Garantir o acesso à API do Kimi K2 Thinking começa em platform.moonshot.ai. Cadastre-se ou faça login, depois navegue até o console da API em "API Keys" (Chaves de API). Clique em "Create New Key" (Criar Nova Chave), selecione as permissões (por exemplo, conclusões de chat, chamadas de ferramentas) e gere — copie a chave imediatamente, pois ela é exibida apenas uma vez.

Com a chave, configure seu SDK conforme acima. Teste com um simples curl:

curl https://api.moonshot.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $KIMI_API_KEY" \

-d '{

"model": "kimi-k2-thinking",

"messages": [{"role": "user", "content": "Hello, world!"}]

}'

Isso verifica a conectividade, retornando uma conclusão com a profundidade característica do Kimi K2 Thinking. Limites de taxa (por exemplo, 100 RPM no nível gratuito) se aplicam, escaláveis via planos pagos. A documentação no console fornece endpoints para ajuste fino ou trabalhos em lote.

Testando a API do Kimi K2 Thinking com Apidog

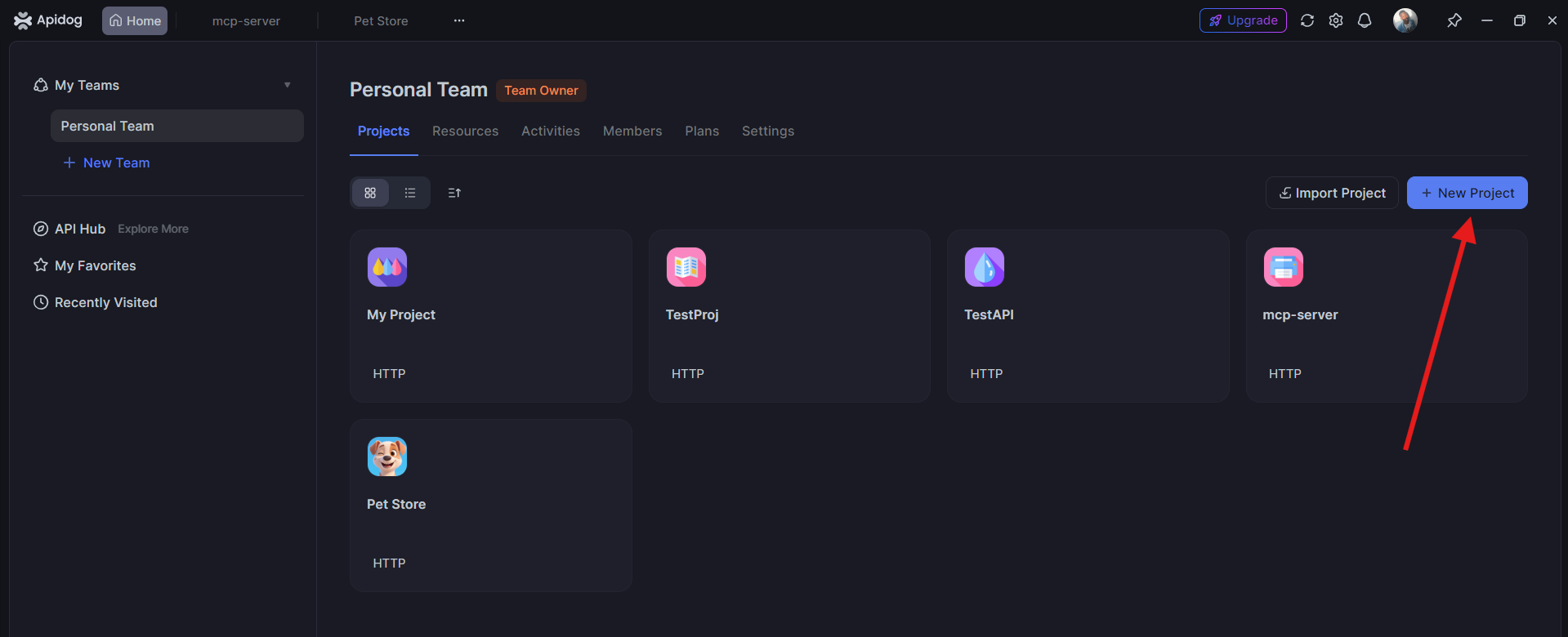

Antes de implantar, você pode facilmente testar suas requisições da API do Kimi K2 Thinking usando o Apidog, uma plataforma colaborativa de teste de API.

1. Abra o Apidog e crie um novo projeto. Adicione o endpoint da API Kimi:POST https://api.moonshot.ai/v1/chat/completions

2. Inclua sua Chave de API em Autorização > Bearer Token.

3. Adicione o corpo da requisição:

{ "model": "kimi-k2-thinking", "messages": [ {"role": "user", "content": "Write a poem about AI reasoning."} ]}

4. Clique em Enviar — você receberá uma resposta em tempo real do modelo Kimi K2 Thinking.

Testar no Apidog ajuda a verificar suas configurações e garantir que sua chave de API e endpoint estejam funcionando corretamente antes da integração.

Conclusão: Adote a API do Kimi K2 Thinking

A API do Kimi K2 Thinking se destaca como um farol de inovação de código aberto, combinando eficiência arquitetônica, domínio em benchmarks e utilidade prática a uma fração dos custos dos concorrentes. De quebra-cabeças lógicos a maratonas de codificação, sua profundidade agentiva via compatibilidade com OpenAI capacita desenvolvedores a construir sistemas mais inteligentes. Obtenha sua chave, teste com Apidog e comece a escalar — o Kimi K2 Thinking está pronto para pensar ao seu lado.