Você está ansioso para aproveitar o poder da nova API Llama 3.2? Se sim, você está no lugar certo! Este guia irá te guiar por tudo que você precisa saber sobre como usar a API Llama 3.2 de forma eficaz. Mas antes de mergulharmos, deixe-me dar uma dica rápida: baixe Apidog gratuitamente! Esta poderosa ferramenta de desenvolvimento de API tornará o trabalho com Llama 3.2 ainda mais fácil. Agora, vamos começar!

O que é Llama 3.2?

Llama 3.2 é um modelo de linguagem avançado projetado para ajudar desenvolvedores a criar aplicações que exigem compreensão e geração de linguagem natural. Ele oferece capacidades aprimoradas em relação a versões anteriores, tornando-se uma excelente escolha para qualquer um que deseje implementar recursos impulsionados por IA em seus projetos.

Por que usar a API Llama 3.2?

Usar a API Llama 3.2 proporciona várias vantagens. Antes de tudo, ela permite que você integre recursos poderosos de processamento de linguagem sem precisar construir seu próprio modelo do zero. Você pode gerar texto, entender contexto e até mesmo manter conversas — tudo com apenas algumas chamadas de API. Além disso, sua documentação amigável e suporte da comunidade a tornam acessível para desenvolvedores de todos os níveis de habilidade.

Começando com a API Llama 3.2

Antes de você começar a usar a API Llama 3.2, você precisará configurar algumas coisas. Aqui está um guia passo a passo:

Passo 1: Inscreva-se e obtenha sua chave de API

Primeiro, você precisará se inscrever para acesso à API Llama 3.2. Você pode fazer isso em poucos segundos a partir da página de API da Llama.

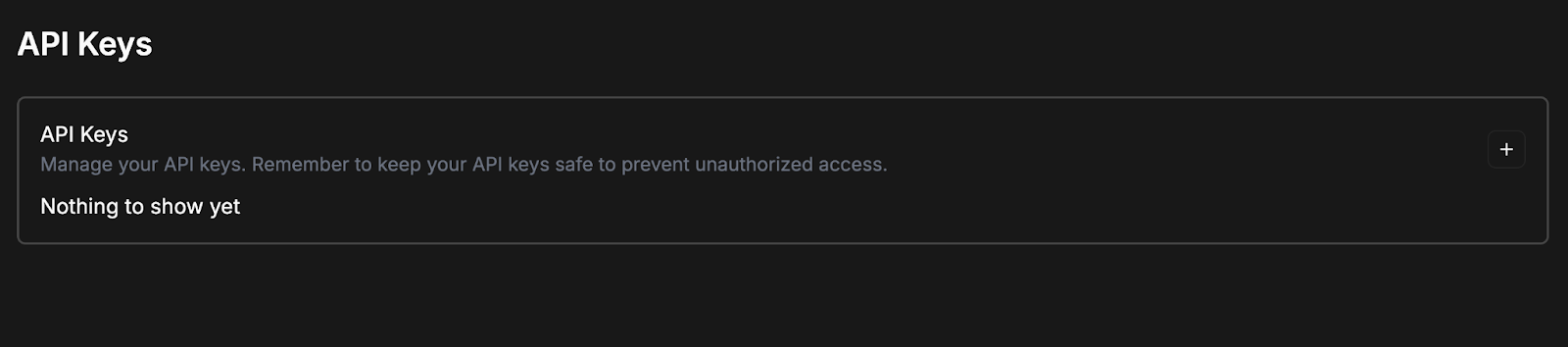

Assim que você estiver conectado, deverá ver uma tela que solicita que você crie um token de API.

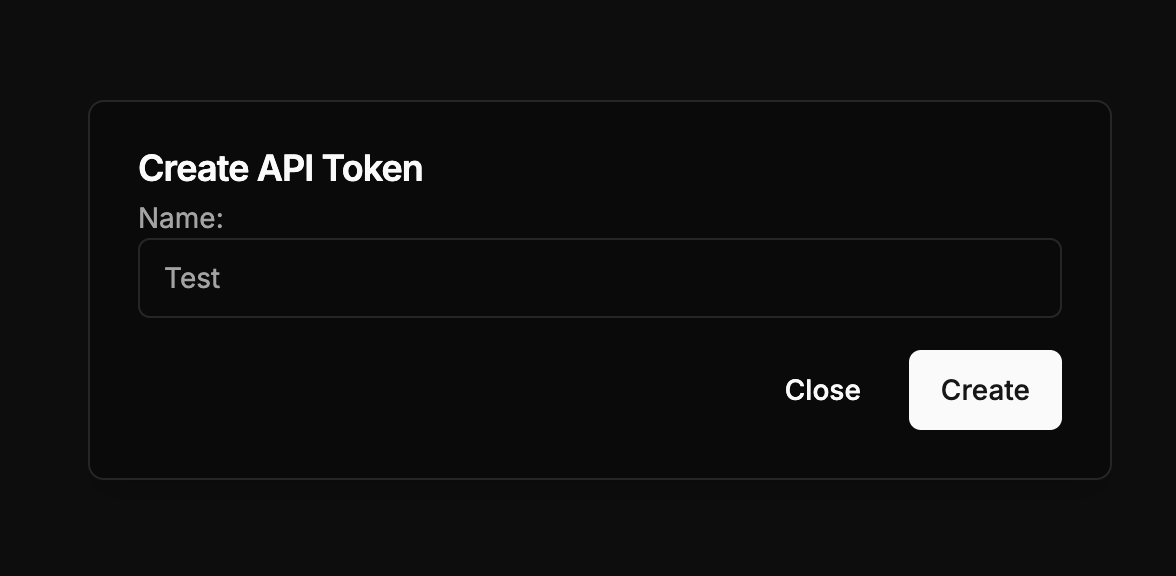

Vá em frente e clique no botão +; dê um nome ao seu token de API; e clique em “Criar”.

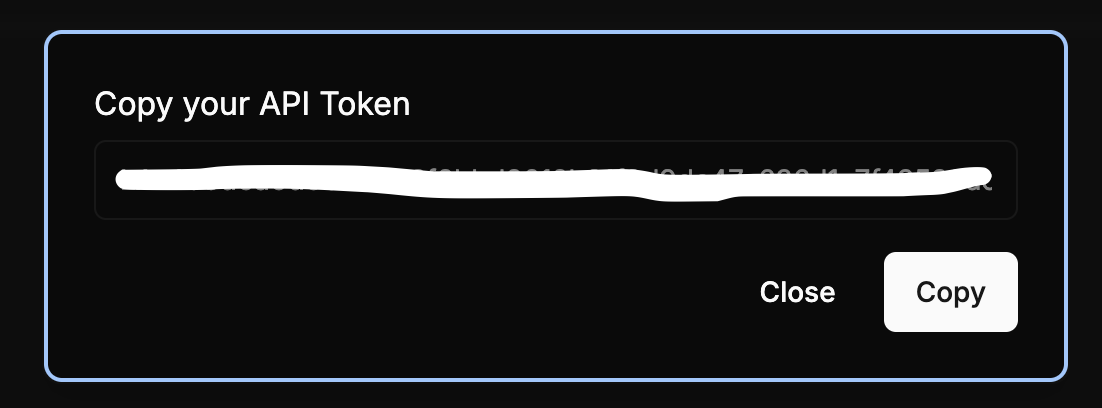

Seu token de API deve agora ser gerado automaticamente. Você deve copiá-lo e armazená-lo em um lugar seguro para evitar acesso não autorizado.

Uma vez que o token de API é criado, você pode copiá-lo, alterar o nome do token e excluí-lo. Você também pode facilmente criar tokens adicionais seguindo os passos descritos acima.

Passo 2: Instale o Apidog

Como eu mencionei anteriormente, Apidog pode ser uma mudança de jogo para o seu processo de desenvolvimento de API. Baixe-o gratuitamente e você terá acesso a uma variedade de recursos que facilitam o teste e a documentação de APIs. É particularmente útil para trabalhar com a Llama 3.2, pois pode te ajudar a formatar solicitações e analisar respostas sem esforço.

Passo 3: Compreenda a Estrutura da API

Familiarize-se com os pontos finais da API fornecidos pela Llama 3.2. Os pontos finais chave geralmente incluem:

- /generate: Para gerar texto com base em prompts.

- /analyze: Para entender contexto e intenção.

- /converse: Para manter conversas em tempo real.

Compreender esses pontos finais é vital para fazer chamadas de API eficazes.

Fazendo sua Primeira Chamada de API

Agora que você está configurado, é hora de fazer sua primeira chamada de API. Veja como fazer isso passo a passo.

Passo 1: Prepare Seu Ambiente

Assegure-se de ter um ambiente adequado para fazer solicitações HTTP. Você pode usar ferramentas como Postman, curl ou até mesmo a biblioteca HTTP da sua linguagem de programação.

Passo 2: Crie Sua Solicitação

Aqui está um exemplo de solicitação para o ponto final /generate. Usar o Apidog pode simplificar esse processo:

POST /generate

{

"api_key": "sua_chave_api_aqui",

"prompt": "Era uma vez em uma terra distante",

"max_tokens": 100

}

Passo 3: Envie a Solicitação

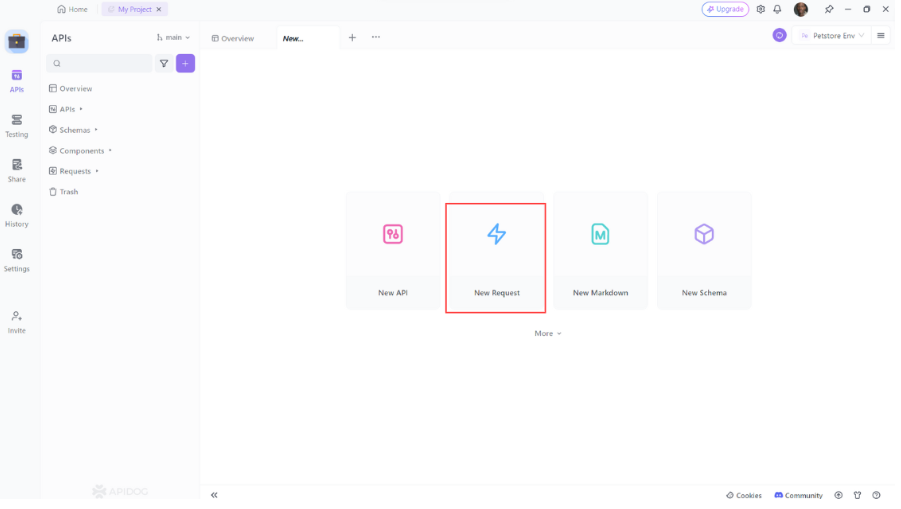

Depois de preparar sua solicitação, envie-a. Se você estiver usando o Apidog, pode simplesmente:

- Abra o Apidog: Inicie o Apidog e crie uma nova solicitação.

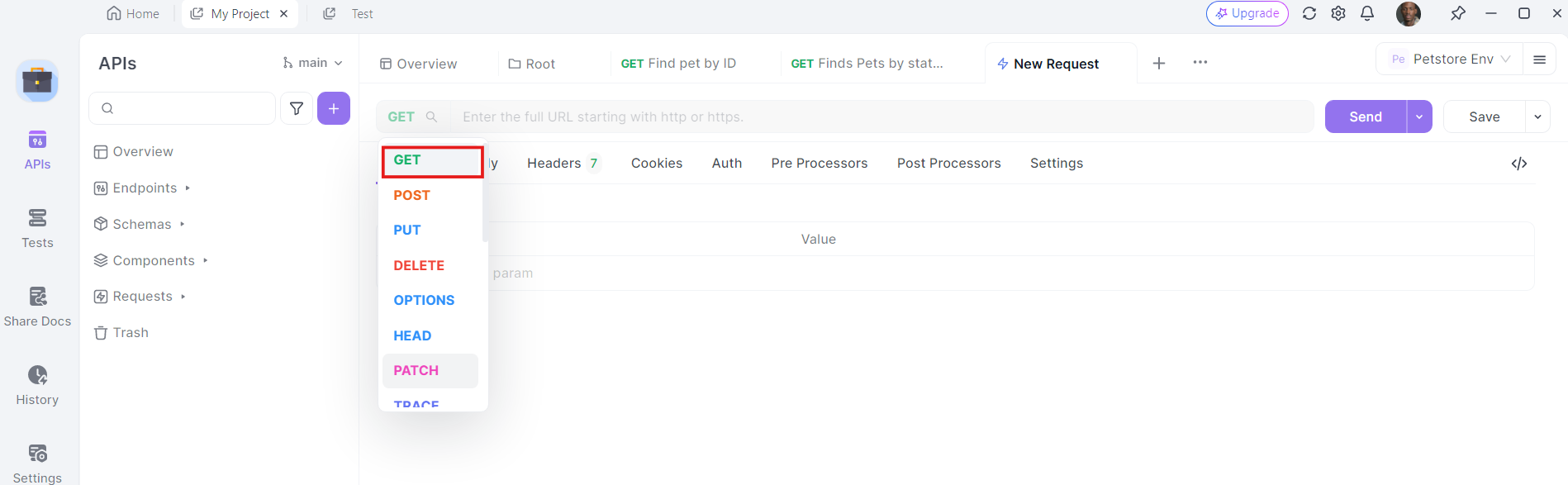

2. Selecione o Método HTTP: Escolha "GET" como método da solicitação ou "Post".

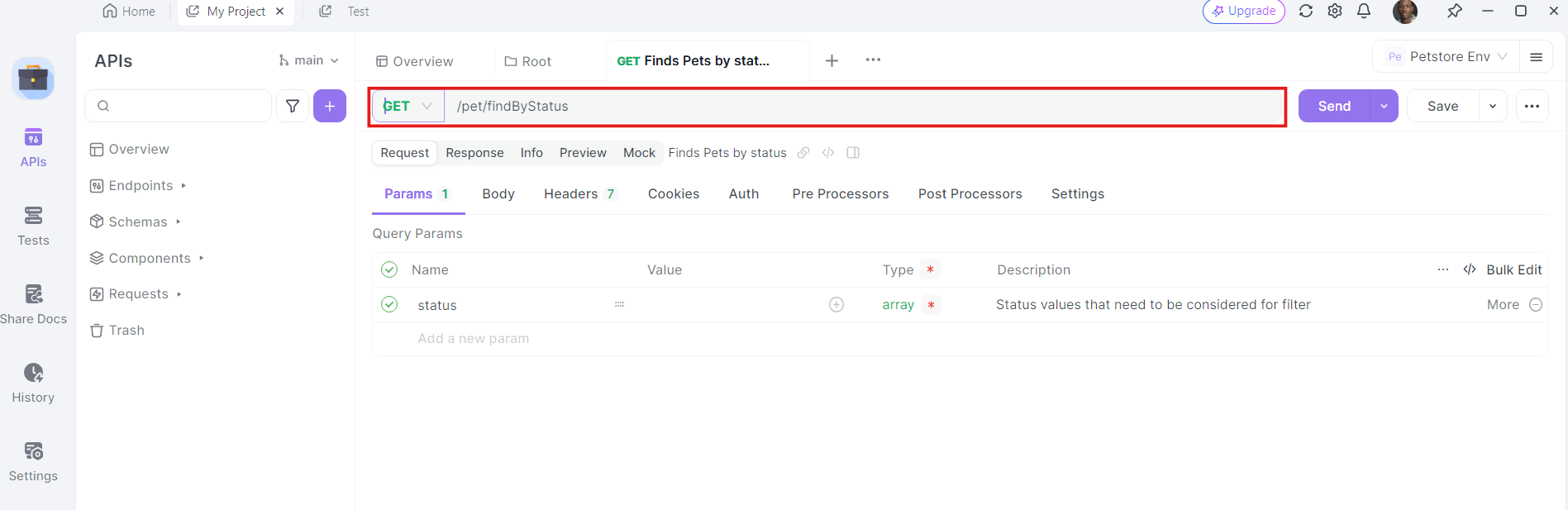

3. Insira a URL: No campo de URL, insira o ponto final para onde deseja enviar a solicitação GET.

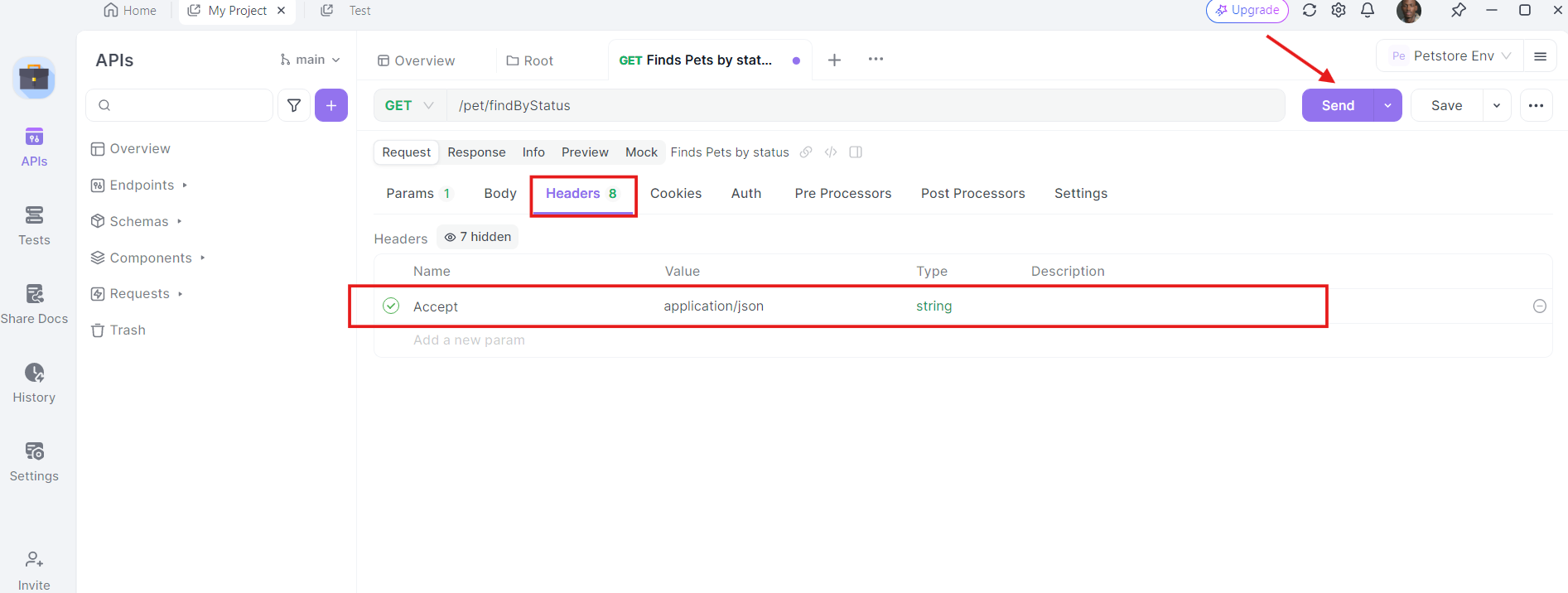

4. Adicione Cabeçalhos: Agora, é hora de adicionar os cabeçalhos necessários. Clique na aba "Headers" no Apidog. Aqui, você pode especificar quaisquer cabeçalhos necessários pela API. Cabeçalhos comuns para solicitações GET podem incluir Authorization, Accept, e User-Agent.

Por exemplo:

- Authorization:

Bearer SEU_TOKEN_DE_ACESSO - Accept:

application/json

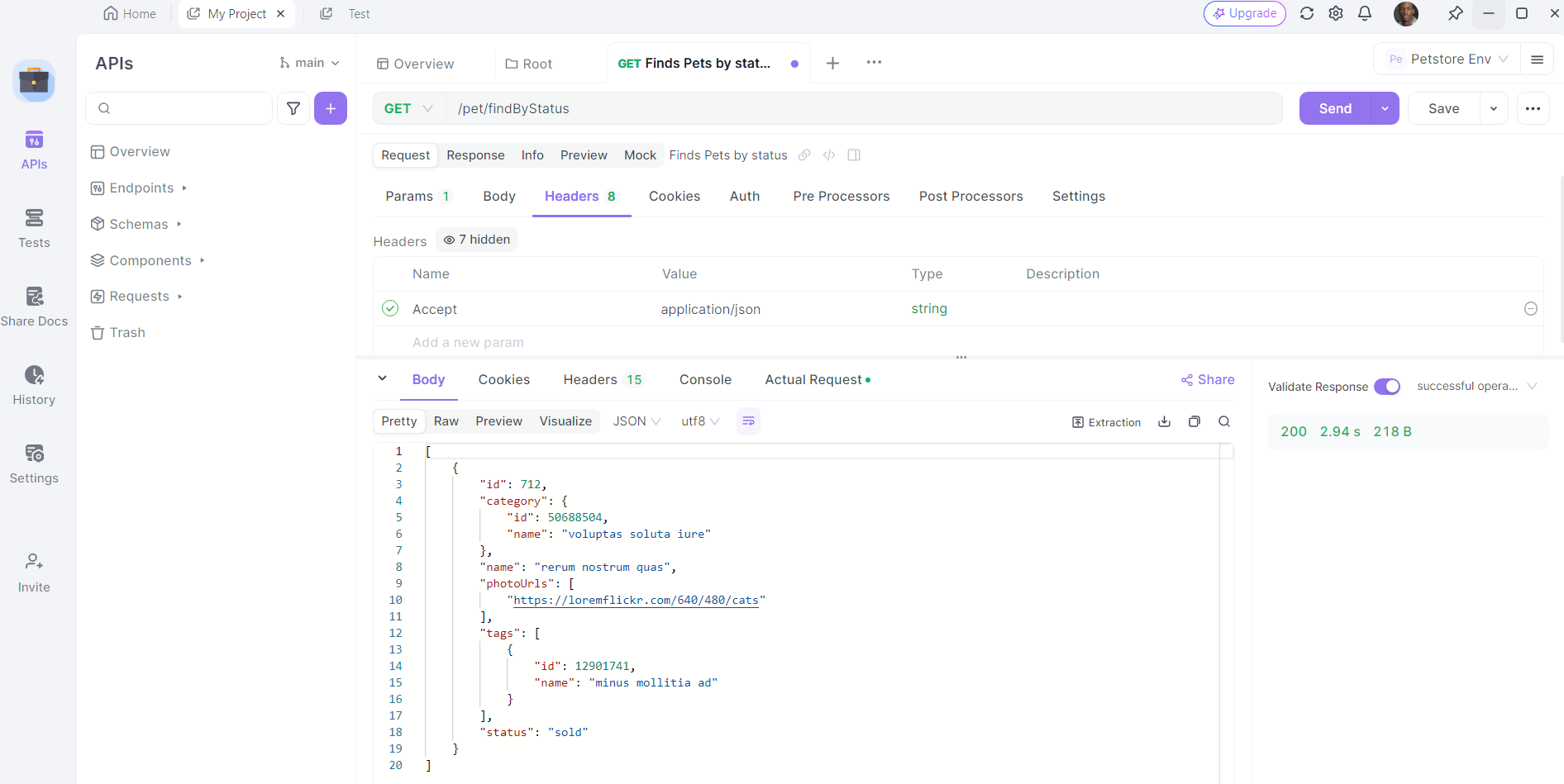

5. Envie a Solicitação e Inspecione a Resposta: Com a URL, parâmetros de consulta e cabeçalhos em ordem, você pode agora enviar a solicitação da API. Clique no botão "Enviar" e o Apidog executará a solicitação. Você verá a resposta exibida na seção de resposta.

Passo 4: Analise a Resposta

A resposta geralmente incluirá o texto gerado junto com outras metadados relevantes. Por exemplo:

{

"success": true,

"data": {

"text": "havia um valente cavaleiro que lutou contra dragões."

}

}

Essa resposta indica que sua solicitação foi bem-sucedida e fornece o texto gerado.

Recursos Avançados da API Llama 3.2

Uma vez que você esteja confortável com solicitações básicas, pode explorar recursos avançados.

Prompt Dinâmico

Um dos recursos mais interessantes da Llama 3.2 é o prompting dinâmico. Você pode elaborar solicitações mais nuançadas incluindo contexto ou fazendo perguntas específicas. Por exemplo:

{

"api_key": "sua_chave_api_aqui",

"prompt": "Quais são os principais benefícios de usar a API Llama 3.2?",

"max_tokens": 50

}

Essa abordagem permite que você personalize a saída de acordo com suas necessidades.

Conversas Contextuais

Com o ponto final /converse, você pode criar aplicativos interativos que simulam conversas reais. Isso é particularmente útil para chatbots ou assistentes virtuais. Veja como você pode implementá-lo:

POST /converse

{

"api_key": "sua_chave_api_aqui",

"message": "Olá, o que você pode fazer?"

}

A API irá responder de uma forma que parece natural, ajudando a criar experiências de usuário envolventes.

Melhores Práticas para Usar a API Llama 3.2

Para maximizar seu sucesso com a API Llama 3.2, mantenha estas melhores práticas em mente:

1. Otimize Seus Prompts

A qualidade de sua saída muitas vezes depende da clareza e especificidade de seus prompts. Dedique tempo para elaborar perguntas ou declarações bem pensadas para obter os melhores resultados.

2. Monitore o Uso

Mantenha um olho no uso da sua API para evitar cobranças inesperadas. A maioria dos provedores oferece painéis onde você pode acompanhar suas métricas de uso.

3. Implemente Tratamento de Erros

Chamadas de API podem falhar às vezes devido a várias razões, como problemas de rede ou limite de taxa excedido. Implemente tratamento de erros robusto em seu código para gerenciar essas situações de forma elegante.

4. Use Cache com Sabedoria

Se você estiver fazendo solicitações repetitivas, considere armazenar em cache as respostas para melhorar o desempenho e reduzir chamadas de API. Isso pode economizar tempo e recursos.

Conclusão

Usar a API Llama 3.2 abre um mundo de possibilidades para desenvolvedores. Com suas avançadas capacidades de processamento de linguagem, você pode criar aplicações que entendem e geram texto semelhante ao humano. Lembre-se de baixar Apidog gratuitamente para aprimorar sua experiência de desenvolvimento de API. Ao seguir os passos descritos neste guia, você estará a caminho de integrar a Llama 3.2 em seus projetos.