Recentemente, a poderosa IA da Meta Llama 3.2 foi lançada como um modelo de linguagem revolucionário, oferecendo capacidades impressionantes para processamento de texto e imagem. Para desenvolvedores e entusiastas de IA ansiosos para aproveitar o poder desse modelo avançado em suas máquinas locais, ferramentas como LM Studio se destacam. Este guia abrangente irá guiá-lo pelo processo de execução do Llama 3.2 localmente usando essas plataformas poderosas, capacitando você a aproveitar a tecnologia de IA de ponta sem depender de serviços em nuvem.

O que há de Novo com Llama 3.2: O Último em Inovação em IA

Antes de mergulhar no processo de instalação, vamos explorar brevemente o que torna Llama 3.2 especial:

- Capacidades Multimodais: Llama 3.2 pode processar tanto texto quanto imagens, abrindo novas possibilidades para aplicações de IA.

- Eficiência Melhorada: Projetado para melhor desempenho com latência reduzida, tornando-o ideal para implantação local.

- Variações de Tamanho de Modelo: Disponível em múltiplos tamanhos, desde modelos leves de 1B e 3B adequados para dispositivos de borda até versões poderosas de 11B e 90B para tarefas mais complexas.

- Contexto Ampliado: Suporta um comprimento de contexto de 128K, permitindo uma compreensão e geração de conteúdo mais abrangente.

Executar Llama 3.2 com LM Studio Localmente

LM Studio oferece uma abordagem mais amigável com uma interface gráfica. Veja como executar o Llama 3.2 localmente usando LM Studio:

Passo 1: Baixar e Instalar o LM Studio

- Acesse o site LM Studio.

- Baixe a versão compatível com seu sistema operacional.

- Siga as instruções de instalação fornecidas.

Passo 2: Inicie o LM Studio

Uma vez instalado, abra LM Studio. Você será recebido com uma interface intuitiva.

Passo 3: Encontre e Baixe o Llama 3.2

- Use a função de busca no LM Studio para encontrar Llama 3.2.

- Selecione a versão apropriada do Llama 3.2 para suas necessidades (por exemplo, 3B para aplicações leves ou 11B para tarefas mais complexas).

- Clique no botão de download para iniciar o processo de download.

Passo 4: Configure o Modelo

Após o download, você pode configurar vários parâmetros:

- Aj ajuste o comprimento do contexto se necessário (o Llama 3.2 suporta até 128K).

- Defina os valores de temperatura e amostragem top-p para controlar a aleatoriedade da saída.

- Experimente outras configurações para ajustar o comportamento do modelo.

Passo 5: Comece a Interagir com Llama 3.2

Com o modelo configurado, você agora pode:

- Usar a interface de chat para ter conversas com Llama 3.2.

- Tentar diferentes prompts para explorar as capacidades do modelo.

- Utilizar o recurso Playground para experimentar com prompts e configurações mais avançadas.

Passo 6: Configure um Servidor Local (Opcional)

Para desenvolvedores, LM Studio permite configurar um servidor local:

- Acesse a aba Servidor no LM Studio.

- Configure as configurações do servidor (porta, endpoints da API, etc.).

- Inicie o servidor para usar o Llama 3.2 através de chamadas de API em suas aplicações.

Melhores Práticas para Executar Llama 3.2 Localmente

Para aproveitar ao máximo sua configuração local do Llama 3.2, considere estas melhores práticas:

- Considerações de Hardware: Certifique-se de que sua máquina atende aos requisitos mínimos. Uma GPU dedicada pode melhorar significativamente o desempenho, especialmente para tamanhos de modelos maiores.

- Engenharia de Prompt: Elabore prompts claros e específicos para obter os melhores resultados do Llama 3.2. Experimente com diferentes formulações para otimizar a qualidade da saída.

- Atualizações Regulares: Mantenha tanto a ferramenta escolhida (LM Studio) quanto o modelo Llama 3.2 atualizados para melhor desempenho e os últimos recursos.

- Experimente com os Parâmetros: Não hesite em ajustar as configurações para encontrar o equilíbrio certo para o seu caso de uso. Valores mais baixos geralmente produzem saídas mais focadas e determinísticas, enquanto valores mais altos introduzem mais criatividade e variabilidade.

- Uso Ético: Sempre use modelos de IA de forma responsável e esteja ciente de potenciais vieses nas saídas. Considere implementar salvaguardas ou filtros adicionais se for implantar em ambientes de produção.

- Privacidade de Dados: Executar Llama 3.2 localmente aprimora a privacidade dos dados. Esteja atento aos dados que você insere e como utiliza as saídas do modelo, especialmente ao lidar com informações sensíveis.

- Gerenciamento de Recursos: Monitore os recursos do seu sistema ao executar Llama 3.2, especialmente por períodos prolongados ou com tamanhos de modelo maiores. Considere usar gerenciadores de tarefas ou ferramentas de monitoramento de recursos para garantir um desempenho ideal.

Solução de Problemas Comuns

Ao executar Llama 3.2 localmente, você pode encontrar alguns desafios. Aqui estão soluções para problemas comuns:

- :

- Certifique-se de ter RAM e poder de CPU/GPU suficientes.

- Tente usar um tamanho de modelo menor, se disponível (por exemplo, 3B em vez de 11B).

- Feche aplicativos em segundo plano desnecessários para liberar recursos do sistema.

2. Erros de Memória Insuficiente:

- Reduza o comprimento do contexto nas configurações do modelo.

- Use uma variante de modelo menor, se disponível.

- Atualize a RAM do seu sistema, se possível.

3. Problemas de Instalação:

- Verifique se seu sistema atende aos requisitos mínimos para LM Studio.

- Certifique-se de ter a versão mais recente da ferramenta que está usando.

- Tente executar a instalação com privilégios de administrador.

4. Falhas no Download do Modelo:

- Verifique a estabilidade da sua conexão com a internet.

- Desative temporariamente firewalls ou VPNs que possam estar interferindo no download.

- Tente baixar durante horários de menor movimento para melhor largura de banda.

5. Saídas Inesperadas:

- Revise e refine seus prompts para clareza e especificidade.

- Aj ajuste a temperatura e outros parâmetros para controlar a aleatoriedade da saída.

- Certifique-se de estar usando a versão e configuração corretas do modelo.

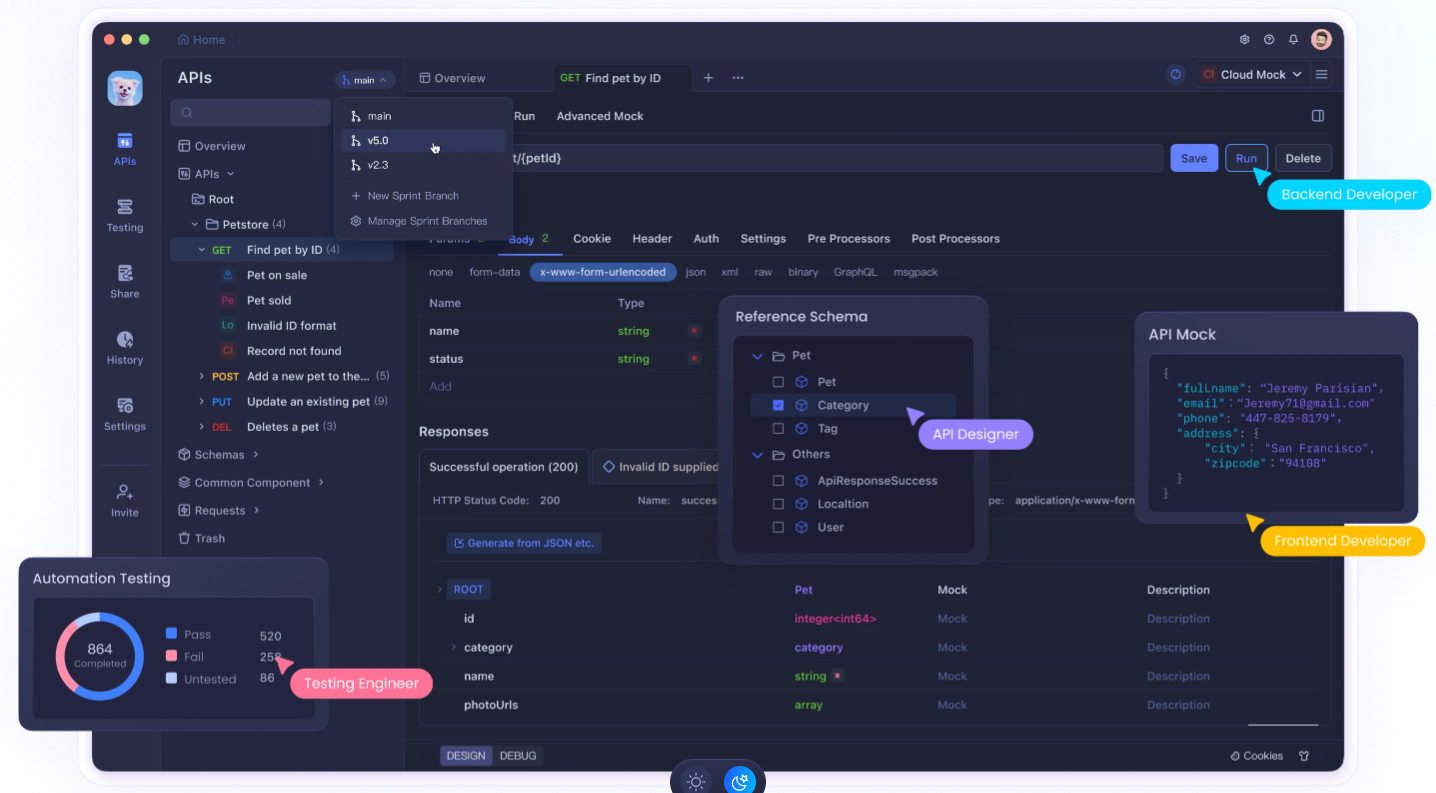

Apidog: Melhore Seu Desenvolvimento de APIs

Executar Llama 3.2 localmente é poderoso, mas integrá-lo em suas aplicações frequentemente requer um desenvolvimento e teste robustos de APIs. É aqui que Apidog entra em cena. Apidog é uma plataforma abrangente de desenvolvimento de APIs que pode melhorar significativamente seu fluxo de trabalho ao trabalhar com LLMs locais como o Llama 3.2.

Principais Recursos do Apidog para Integração de LLM Local:

- Design e Documentação de APIs: Projete e documente facilmente APIs para suas integrações com o Llama 3.2, garantindo uma comunicação clara entre seu modelo local e outras partes de sua aplicação.

- Testes Automatizados: Crie e execute testes automatizados para seus endpoints de API do Llama 3.2, garantindo confiabilidade e consistência nas respostas do seu modelo.

- Servidores Mock: Use a funcionalidade de servidor mock do Apidog para simular respostas do Llama 3.2 durante o desenvolvimento, permitindo que você avance mesmo quando não tiver acesso imediato à sua configuração local.

- Gerenciamento de Ambiente: Gerencie diferentes ambientes (por exemplo, Llama 3.2 local, API de produção) dentro do Apidog, facilitando a troca entre configurações durante desenvolvimento e testes.

- Ferramentas de Colaboração: Compartilhe os designs da API do Llama 3.2 e os resultados dos testes com os membros da equipe, promovendo uma melhor colaboração em projetos impulsionados por IA.

- Monitoramento de Desempenho: Monitore o desempenho dos endpoints da sua API do Llama 3.2, ajudando você a otimizar tempos de resposta e uso de recursos.

- Testes de Segurança: Implemente testes de segurança para suas integrações da API do Llama 3.2, garantindo que a implantação do seu modelo local não introduza vulnerabilidades.

Começando com Apidog para Desenvolvimento do Llama 3.2:

- Inscreva-se para uma conta Apidog.

- Crie um novo projeto para sua integração da API Llama 3.2.

- Projete os endpoints da sua API que irão interagir com sua instância local do Llama 3.2.

- Configure ambientes para gerenciar diferentes configurações (por exemplo, configurações do LM Studio).

- Crie testes automatizados para garantir que suas integrações do Llama 3.2 estejam funcionando corretamente.

- Use o recurso de servidor mock para simular respostas do Llama 3.2 durante as fases iniciais de desenvolvimento.

- Colabore com sua equipe compartilhando designs da API e resultados de testes.

Aproveitando o Apidog juntamente com sua configuração local do Llama 3.2, você pode criar aplicações potentes, bem documentadas e minuciosamente testadas com tecnologia de IA.

Conclusão: Abraçando o Poder da IA Local

Executar o Llama 3.2 localmente representa um passo significativo em direção à democratização da tecnologia de IA. Seja você optar pela interface amigável do LM Studio ou outra, agora você tem as ferramentas para aproveitar o poder dos modelos avançados de linguagem em sua própria máquina.

Lembre-se de que a implantação local de grandes modelos de linguagem como o Llama 3.2 é apenas o começo. Para realmente se destacar no desenvolvimento de IA, considere integrar ferramentas como o Apidog ao seu fluxo de trabalho. Esta poderosa plataforma pode ajudar você a projetar, testar e documentar APIs que interagem com sua instância local do Llama 3.2, simplificando seu processo de desenvolvimento e garantindo a confiabilidade de suas aplicações impulsionadas por IA.

À medida que você embarca em sua jornada com o Llama 3.2, continue experimentando, permaneça curioso e sempre busque usar IA de forma responsável. O futuro da IA não está apenas na nuvem – ele está bem aqui em sua máquina local, esperando ser explorado e aproveitado para aplicações inovadoras. Com as ferramentas e práticas certas, você pode desbloquear todo o potencial da IA local e criar soluções inovadoras que ampliam os limites do que é possível em tecnologia.