A OpenAI avança as capacidades da inteligência artificial ao introduzir o gpt-realtime juntamente com melhorias significativas na API Realtime. Este desenvolvimento visa desenvolvedores que criam aplicações de voz interativas, oferecendo processamento direto de fala para fala que captura nuances como tom e sinais não verbais. Engenheiros agora acessam um modelo que processa entradas de áudio e gera respostas com baixa latência, marcando uma mudança na forma como a IA lida com conversas em tempo real.

Além disso, esta atualização se alinha com a crescente demanda por sistemas de IA multimodais. Desenvolvedores integram áudio, texto e imagens de forma contínua, expandindo as possibilidades para aplicações em atendimento ao cliente, assistentes virtuais e entretenimento interativo. À medida que exploramos esses avanços, considere como pequenos refinamentos no design da API levam a melhorias substanciais na experiência do usuário.

Compreendendo o GPT-Realtime: O Modelo Central

A OpenAI lança o gpt-realtime como um modelo especializado projetado para interações de fala para fala de ponta a ponta. Este modelo elimina os pipelines tradicionais que separam o reconhecimento de fala, o processamento de linguagem e a síntese de texto para fala. Em vez disso, ele lida com tudo em uma estrutura unificada, reduzindo a latência e preservando as sutilezas da fala humana.

O gpt-realtime se destaca na geração de saídas de áudio com som natural. Por exemplo, ele responde a instruções como "falar rapidamente e profissionalmente" ou "adotar um tom empático com um sotaque francês". Esse controle granular capacita os desenvolvedores a adaptar vozes de IA a cenários específicos, aumentando o engajamento em aplicações do mundo real.

Além disso, o modelo demonstra inteligência superior no processamento de entradas de áudio nativas. Ele detecta elementos não verbais, como risadas ou pausas, e se adapta de acordo. Se um usuário muda de idioma no meio da frase, o gpt-realtime o acompanha sem interrupção.

Essa capacidade decorre de um treinamento avançado em diversos conjuntos de dados, permitindo que ele atinja 30,5% no benchmark de áudio MultiChallenge — uma melhoria notável em relação às iterações anteriores.

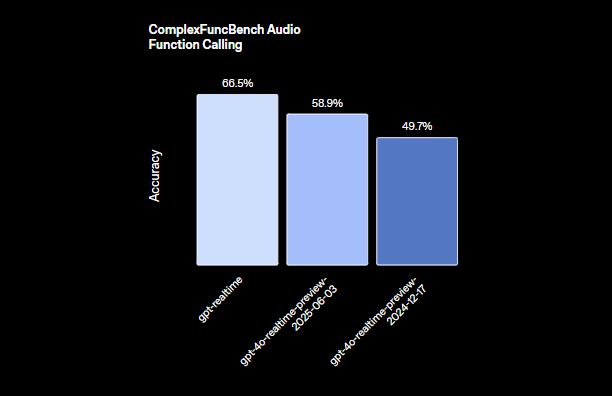

Engenheiros apreciam como o gpt-realtime integra a chamada de funções. Com uma pontuação de 66,5% no ComplexFuncBench, ele executa ferramentas de forma assíncrona, garantindo que as conversas permaneçam fluidas mesmo durante computações estendidas. Por exemplo, enquanto a IA processa uma consulta de banco de dados, ela continua interagindo com o usuário com respostas de preenchimento ou atualizações.

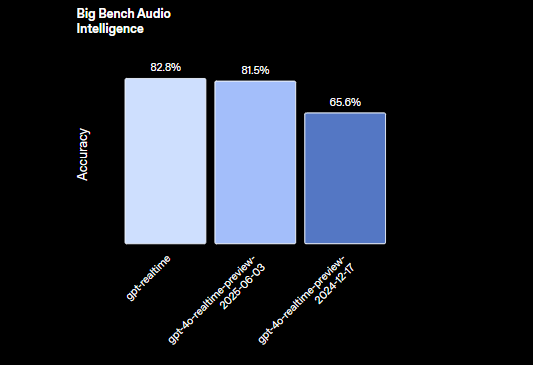

Além disso, o gpt-realtime suporta tarefas de raciocínio com 82,8% de precisão na avaliação Big Bench Audio. Isso permite que ele lide com consultas complexas que envolvem dedução lógica diretamente de entradas de áudio, ignorando completamente a conversão de texto.

A OpenAI introduz duas novas vozes, Marin e Cedar, exclusivas para este modelo, juntamente com atualizações para oito vozes existentes para saídas mais expressivas. Essas melhorias garantem que as interações de IA pareçam mais humanas, preenchendo a lacuna entre respostas roteirizadas e diálogo genuíno.

Passando para as implicações práticas, os desenvolvedores aproveitam o gpt-realtime para construir aplicações que respondem em tempo real, como serviços de tradução ao vivo ou ferramentas de narrativa interativa. A eficiência do modelo minimiza a sobrecarga computacional, tornando-o adequado para implantação em dispositivos de borda ou infraestruturas de nuvem.

Principais Recursos da API Realtime

A API Realtime recebe atualizações substanciais, complementando as capacidades do gpt-realtime. A OpenAI a equipa com recursos que facilitam agentes de voz prontos para produção, focando em confiabilidade, escalabilidade e facilidade de integração.

Primeiro, o suporte a servidores remotos MCP (Provedor Multi-Nuvem) se destaca. Desenvolvedores configuram servidores externos para chamadas de ferramentas, como a integração com o Stripe para pagamentos. Essa configuração simplifica os fluxos de trabalho ao descarregar funções específicas para serviços especializados. Você especifica a URL do servidor, tokens de autorização e requisitos de aprovação diretamente na sessão da API.

Em seguida, a funcionalidade de entrada de imagem expande o escopo multimodal da API. Aplicações adicionam imagens, fotos ou capturas de tela a sessões em andamento, permitindo conversas visualmente fundamentadas. Por exemplo, um usuário carrega um diagrama, e a IA o descreve ou responde a perguntas sobre seu conteúdo. Este recurso trata as imagens como elementos estáticos, controlados pela lógica da aplicação para manter o contexto.

Além disso, o suporte a SIP (Session Initiation Protocol) conecta a API a redes telefônicas públicas, sistemas PBX e telefones de mesa. Isso faz a ponte entre a IA digital e a telefonia tradicional, permitindo que agentes de voz lidem com chamadas de telefones fixos ou celulares de forma contínua.

Prompts reutilizáveis representam outra adição chave. Desenvolvedores salvam e reutilizam mensagens de desenvolvedor, ferramentas, variáveis e exemplos em múltiplas sessões. Isso promove a consistência e reduz o tempo de configuração para interações recorrentes, como scripts padrão de suporte ao cliente.

A API otimiza para interações de baixa latência, garantindo alta confiabilidade em ambientes de produção. Ela processa entradas multimodais — áudio e imagens — enquanto mantém o estado da sessão, o que previne a perda de contexto em conversas estendidas.

Em termos de manipulação de áudio, a API Realtime se interfaceia diretamente com o gpt-realtime para gerar fala expressiva. Ela captura nuances que sistemas tradicionais frequentemente descartam, levando a experiências de usuário mais envolventes.

Desenvolvedores também se beneficiam de recursos de nível empresarial, incluindo Residência de Dados da UE para conformidade e compromissos de privacidade que salvaguardam dados sensíveis.

Mudando o foco para métricas de desempenho, essas atualizações aprimoram coletivamente a utilidade da API. Por exemplo, a chamada de função assíncrona previne gargalos, permitindo que a IA realize múltiplas tarefas sem interromper o fluxo.

Como Usar a API GPT-Realtime: Um Guia Passo a Passo

Desenvolvedores integram a API gpt-realtime através de endpoints e configurações diretas. Comece obtendo chaves de API da plataforma OpenAI, garantindo que sua conta suporte a API Realtime.

Para iniciar uma sessão, envie uma requisição POST para criar um segredo de cliente em tempo real. Inclua parâmetros de sessão como ferramentas e tipos. Para integração MCP remota, estruture o payload da seguinte forma:

// POST /v1/realtime/client_secrets

{

"session": {

"type": "realtime",

"tools": [

{

"type": "mcp",

"server_label": "stripe",

"server_url": "https://mcp.stripe.com",

"authorization": "{access_token}",

"require_approval": "never"

}

]

}

}

Este código configura uma ferramenta para pagamentos Stripe, onde a API roteia chamadas para o servidor especificado sem precisar de aprovação do usuário a cada vez.

Uma vez iniciada a sessão, lide com interações em tempo real via conexões WebSocket. Estabeleça um WebSocket para o endpoint da API Realtime, enviando fluxos de áudio como dados binários. A API processa as entradas e retorna saídas de áudio em tempo real.

Para entrada de áudio, codifique a fala do usuário e transmita-a. O gpt-realtime analisa o áudio, gerando respostas com base no contexto da sessão. Para incorporar imagens, use o evento de criação de item de conversação:

{

"type": "conversation.item.create",

"previous_item_id": null,

"item": {

"type": "message",

"role": "user",

"content": [

{

"type": "input_image",

"image_url": "data:image/png;base64,{base64_image_data}"

}

]

}

}

Substitua {base64_image_data} pela imagem real codificada em base64. Isso adiciona contexto visual, permitindo que a IA o referencie nas respostas.

Gerencie o estado da sessão definindo limites de tokens e truncando turnos mais antigos para controlar custos. Para conversas longas, limpe periodicamente o histórico desnecessário enquanto retém detalhes chave.

Para lidar com chamadas de função, defina ferramentas na configuração da sessão. Quando a IA invoca uma função, a API a executa de forma assíncrona, enviando atualizações provisórias para manter a conversa ativa.

Para integração SIP, configure sua aplicação para rotear chamadas através de gateways compatíveis. Isso envolve a configuração de troncos SIP e a vinculação deles às sessões da API Realtime.

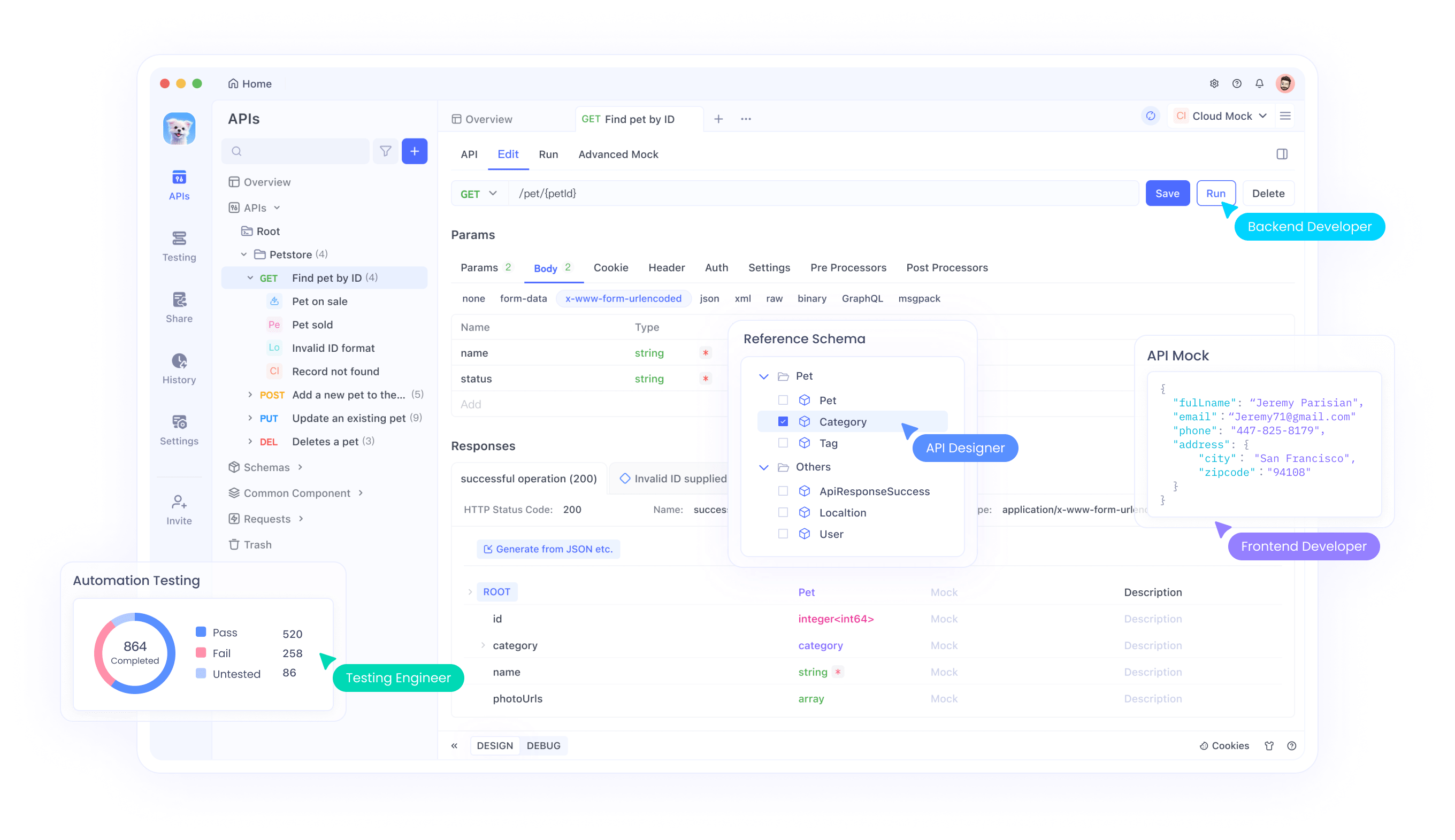

Testar essas integrações é crucial. Aqui, o Apidog se destaca como uma ferramenta de gerenciamento de API. Ele suporta testes WebSocket, permitindo simular trocas de áudio em tempo real e inspecionar respostas. Baixe o Apidog gratuitamente para simular endpoints, validar payloads e garantir conectividade perfeita com o gpt-realtime.

Na prática, construa um agente de voz simples combinando esses elementos. Capture a entrada do microfone, transmita-a para a API e reproduza o áudio gerado. Bibliotecas como WebSocket em JavaScript ou o módulo websockets do Python facilitam isso.

Monitore a latência cronometrando as respostas de ida e volta. As otimizações da OpenAI garantem atrasos de menos de um segundo na maioria dos casos, mas as condições da rede influenciam o desempenho.

Lide com erros de forma elegante, como tentar novamente conexões falhas ou recorrer a interações baseadas em texto se o processamento de áudio encontrar problemas.

Estendendo isso, incorpore prompts reutilizáveis. Armazene um template de prompt com instruções como "Sempre responda com empatia" e aplique-o a novas sessões via parâmetros da API.

Para uso avançado, combine o gpt-realtime com outros modelos da OpenAI. Encaminhe raciocínio complexo para o GPT-4o enquanto usa o gpt-realtime para E/S de áudio, criando sistemas híbridos.

Considerações de segurança incluem criptografar dados em trânsito e gerenciar tokens de acesso de forma segura. Os compromissos de privacidade da OpenAI ajudam, mas implemente salvaguardas adicionais para aplicações sensíveis.

Integrando o Apidog para Gerenciamento Eficiente de API

O Apidog surge como uma ferramenta vital para desenvolvedores que trabalham com a API gpt-realtime. Esta plataforma oferece testes de API abrangentes, documentação e recursos de colaboração, adaptados para integrações complexas como WebSockets em tempo real.

<

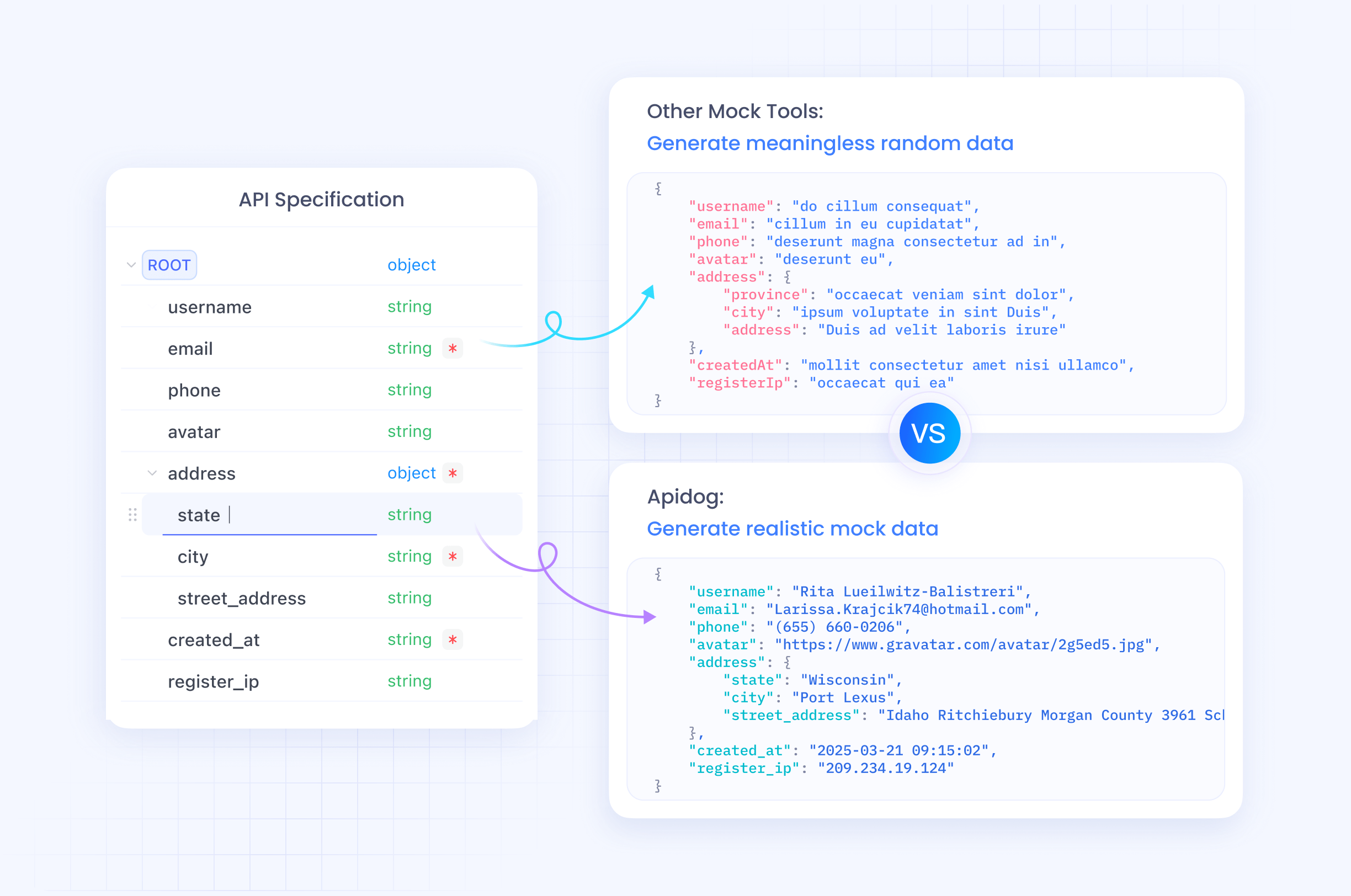

Engenheiros usam o Apidog para projetar requisições de API visualmente, importar especificações OpenAPI e executar testes automatizados. Para a API Realtime, simule fluxos de áudio e verifique entradas multimodais sem escrever código extenso.

Além disso, as capacidades de mocking do Apidog permitem a prototipagem antes da implementação completa. Crie servidores mock que mimetizam as respostas do gpt-realtime, acelerando os ciclos de desenvolvimento.

A ferramenta suporta colaboração em equipe, compartilhando casos de teste e ambientes. Isso se mostra inestimável para equipes distribuídas que constroem agentes de voz.

Como o Apidog lida com a codificação base64 para imagens e dados binários para áudio, ele simplifica a depuração. Rastreie ciclos de requisição/resposta em tempo real, identificando gargalos precocemente.

Transicionando para a implantação, use o monitoramento do Apidog para garantir o tempo de atividade e o desempenho da API pós-lançamento.

Preços, Disponibilidade e Implicações Futuras

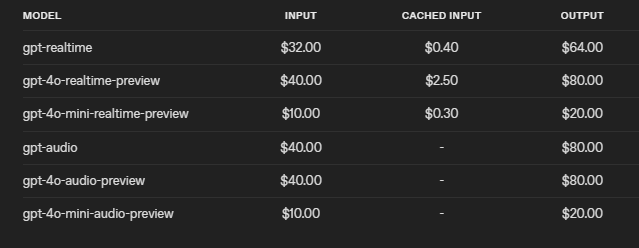

A OpenAI precifica o gpt-realtime de forma competitiva, reduzindo os custos em 20% em relação à versão de prévia. Cobra $32 por 1M de tokens de entrada de áudio ($0.40 para os em cache) e $64 por 1M de tokens de saída. Essa estrutura incentiva o uso eficiente, com controles para limitar o contexto e truncar sessões.

A API estará disponível para todos os desenvolvedores em 28 de agosto de 2025, com acesso global incluindo regiões da UE.

Olhando para o futuro, esses avanços abrem caminho para a IA de voz ubíqua. Indústrias como a de saúde a adotam para interações com pacientes, enquanto a educação a usa para tutoria interativa.

No entanto, desafios permanecem, como garantir o uso ético e mitigar vieses no processamento de áudio.

Em resumo, o gpt-realtime e a API Realtime da OpenAI redefinem a IA em tempo real, oferecendo ferramentas que os desenvolvedores aproveitam para aplicações inovadoras. Pequenos ajustes na integração rendem ganhos significativos, enfatizando a implementação precisa.