O lançamento de modelos de IA avançados como o Gemini 2.5 Pro do Google gera uma empolgação significativa dentro da comunidade de desenvolvedores. Suas capacidades aprimoradas de raciocínio, codificação e entendimento multimodal prometem revolucionar a forma como construímos aplicações. No entanto, o acesso a modelos de ponta frequentemente levanta questões sobre custo e disponibilidade. Muitos desenvolvedores se perguntam: "Como posso usar o Gemini 2.5 Pro gratuitamente?" Embora o acesso direto e ilimitado à API normalmente envolva custos, existem maneiras legítimas de interagir com esse poderoso modelo sem nenhum custo, principalmente através de sua interface web, e até mesmo programaticamente via projetos comunitários.

A Maneira Oficial de Usar o Gemini 2.5 Pro Gratuitamente: A Interface Web

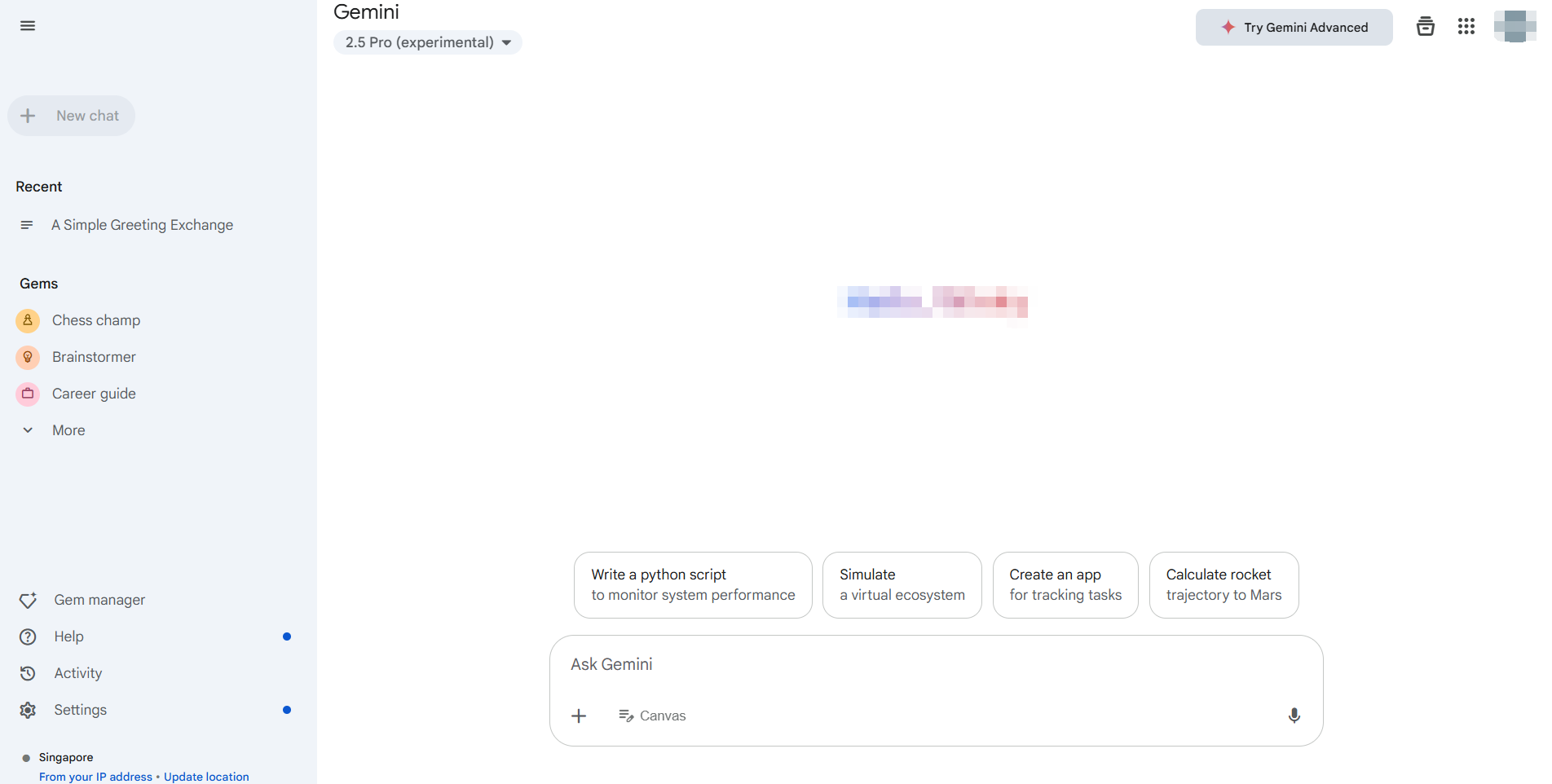

A maneira mais simples e oficialmente suportada de usar o Gemini 2.5 Pro sem nenhum custo é através de sua aplicação web dedicada, normalmente acessível em https://gemini.google.com/. O Google oferece acesso aos seus modelos mais recentes, incluindo o Gemini 2.5 Pro (a disponibilidade pode variar por região e status da conta), através dessa interface para usuários em geral.

Principais Vantagens da Interface Web:

- Custo Zero: Este é o plano gratuito padrão que oferece interação direta.

- Acesso Completo a Recursos: Você pode normalmente aproveitar as capacidades básicas do modelo, incluindo geração de texto, brainstorm, assistência de codificação e potencialmente geração de imagens (como com o Imagen3, sujeito a disponibilidade) e interações com extensões do Google Workspace (Gmail, Docs, Drive, etc.).

- Interface Amigável: A interface web é projetada para facilidade de uso, não exigindo nenhuma configuração além de fazer login na sua conta do Google.

Como Usar:

- Navegue até a aplicação web do Gemini.

- Faça login com sua Conta do Google.

- Certifique-se de que Gemini 2.5 Pro está selecionado se múltiplos modelos estiverem disponíveis (geralmente indicado nas configurações ou perto da entrada do prompt).

5. Comece a interagir! Digite seus prompts, faça upload de arquivos (se suportado) e explore suas capacidades.

Para muitos usuários e desenvolvedores que precisam avaliar o Gemini 2.5 Pro, testar prompts ou realizar tarefas não programáticas, a interface web oficial é a solução ideal e sem custo. Ela fornece acesso direto ao poder do modelo sem exigir chaves de API ou lidar com cotas de uso associadas à API paga. Este método aborda perfeitamente a necessidade de usar o Gemini 2.5 Pro gratuitamente para exploração e interação manual.

Como Usar o Gemini 2.5 Pro Programaticamente Sem Custo Direto de API

Embora a interface web seja ótima para uso manual, os desenvolvedores frequentemente precisam de acesso programático para integração, automação ou processamento em lote. A API oficial de IA Generativa do Google para modelos como o Gemini 2.5 Pro normalmente envolve custos baseados no uso de tokens. No entanto, a comunidade de desenvolvedores frequentemente cria ferramentas para preencher essa lacuna.

Uma dessas ferramentas, destacada em recursos comunitários como a biblioteca Python Gemini API, permite que os desenvolvedores interajam com a interface web gratuita do Gemini programaticamente.

Isenção de Responsabilidade Importante: É essencial entender que isso NÃO é a API oficial de IA Generativa do Google. Essas bibliotecas funcionam por meio da engenharia reversa das chamadas API privadas da aplicação web e usam cookies do navegador para autenticação.

- Não Oficial: Não suportado ou endossado pelo Google.

- Potencialmente Instável: Depende de elementos da interface web que podem mudar sem aviso prévio, quebrando a biblioteca.

- Considerações de Segurança: Requer a extração de cookies de autenticação do seu navegador, o que traz riscos de segurança inerentes se não for tratado com cuidado.

- Termos de Serviço: O uso pode violar os termos de serviço do Google para a aplicação web.

Apesar dessas advertências, tais bibliotecas oferecem uma maneira para os desenvolvedores experimentarem e usarem o Gemini 2.5 Pro sem nenhum custo além das limitações do plano gratuito da própria interface web, mas de forma automatizada.

Guia Passo a Passo:

Pré-requisitos: Certifique-se de ter o Python 3.10+ instalado.

Instalação: Instale a biblioteca usando pip:

pip install -U gemini_webapi

# Opcional: Instale browser-cookie3 para facilitar a captura de cookies

pip install -U browser-cookie3Autenticação (A Parte Difícil):

- Faça login em

gemini.google.comno seu navegador web. - Abra as Ferramentas de Desenvolvedor (F12), vá para a aba

Redee atualize a página. - Encontre uma requisição (qualquer requisição geralmente funciona).

- Nos cabeçalhos da requisição (geralmente sob "Cookies"), encontre e copie os valores de

__Secure-1PSIDe__Secure-1PSIDTS. Trate esses como senhas! - Alternativa: Se

browser-cookie3estiver instalado, a biblioteca pode ser capaz de importar cookies automaticamente se você estiver logado via um navegador suportado, simplificando essa etapa, mas ainda dependendo do estado local do navegador.

Inicialização & Uso Básico:

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # Importar constantes do Modelo

# --- Autenticação ---

# Método 1: Cole cookies manualmente (manipule com segurança!)

Secure_1PSID = "SEU_VALOR_DE_COOKIE__SECURE_1PSID"

Secure_1PSIDTS = "SEU_VALOR_DE_COOKIE__SECURE_1PSIDTS" # Pode ser opcional

async def run_gemini():

# Método 2: Use browser-cookie3 (se instalado e logado)

# client = GeminiClient(proxy=None) # Tenta a importação automática de cookies

# Inicialize com cookies manuais

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # Inicializar conexão

# --- Selecionar Modelo e Gerar Conteúdo ---

prompt = "Explique a diferença entre APIs REST e GraphQL."

# Use o identificador do modelo Gemini 2.5 Pro

print(f"Enviando prompt para o Gemini 2.5 Pro...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # Use o modelo específico

print("\nResposta:")

print(response.text)

# Feche a sessão do cliente (importante para gerenciamento de recursos)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())Confira mais detalhes de integração aqui.

Explorando Mais: Bibliotecas como essa frequentemente suportam recursos disponíveis na UI web, como chat de múltiplas interações (client.start_chat()), uploads de arquivos, solicitações de geração de imagens e uso de extensões (@Gmail, @Youtube), espelhando as capacidades da aplicação web de forma programática.

Lembre-se, esta abordagem automatiza a interação com o plano web gratuito, não com a API paga. Isso permite a experimentação programática com Gemini 2.5 Pro sem custo direto de API, mas vem com significativas advertências de segurança e confiabilidade.

O Desafio de Depuração com LLMs

Quer você interaja com o Gemini 2.5 Pro via web, API oficial ou bibliotecas não oficiais, compreender e depurar as respostas é crucial, especialmente ao lidar com saídas complexas ou em streaming. Muitos LLMs, particularmente em forma de API, utilizam Eventos Enviados pelo Servidor (SSE) para transmitir respostas token a token ou bloco a bloco. Isso proporciona uma sensação de tempo real, mas pode ser desafiador depurar usando clientes HTTP padrão.

Ferramentas tradicionais de testes de API podem simplesmente exibir dados brutos de SSE: blocos, dificultando a montagem da mensagem completa ou a compreensão do fluxo de informações, particularmente do "processo de pensamento" do modelo, se fornecido. É aqui que uma ferramenta especializada se torna inestimável.

Apresentando Apidog: Uma plataforma abrangente de desenvolvimento de API projetada para lidar com todo o ciclo de vida da API – desde design e documentação até depuração, testes automatizados e simulação. Embora poderosa em todos os aspectos, Apidog se destaca particularmente no manuseio de protocolos modernos de API, tornando-se uma excepcional ferramenta de teste de API para desenvolvedores que trabalham com LLMs. Seus recursos de depuração de SSE são especificamente construídos para abordar os desafios das respostas em streaming.

Domine Respostas LLM em Tempo Real

Trabalhar com LLMs como o Gemini 2.5 Pro frequentemente envolve Eventos Enviados pelo Servidor (SSE) para transmitir resultados. Essa tecnologia permite que o modelo de IA envie dados para seu cliente em tempo real, mostrando texto gerado ou até mesmo passos de raciocínio à medida que acontecem. Embora seja ótimo para a experiência do usuário, depurar fluxos de SSE brutos em ferramentas básicas pode ser um pesadelo de mensagens fragmentadas.

Apidog, como uma ferramenta líder de teste de API, transforma a depuração de SSE de uma tarefa em um processo claro. Aqui está como Apidog ajuda a domar fluxos de LLM:

- Detecção Automática de SSE: Quando você envia uma requisição para um endpoint LLM usando Apidog, se o cabeçalho de resposta

Content-Typefortext/event-stream, o Apidog o reconhece automaticamente como um fluxo de SSE. - Visualização de Linha do Tempo em Tempo Real: Em vez de apenas despejar linhas brutas

data:, o Apidog apresenta as mensagens recebidas cronologicamente em uma visualização dedicada de "Linha do Tempo". Isso permite que você veja o fluxo de informações exatamente como o servidor as envia. - Auto-Merge Inteligente: Isso é uma mudança de jogo para a depuração de SSE de LLM. O Apidog possui inteligência embutida para reconhecer formatos comuns de streaming usados por grandes provedores de IA, incluindo:

- Formato Compatível com a API OpenAI (usado por muitos)

- Formato Compatível com a API Gemini

- Formato Compatível com a API Claude

- Formato Compatível com a API Ollama (para modelos executados localmente, frequentemente JSON Streaming/NDJSON)

Se o fluxo corresponder a esses formatos, Apidog mescla automaticamente os fragmentos individuais de mensagens (data: blocos) na resposta final completa e coerente ou em etapas intermediárias. Nada de copiar e colar blocos manualmente! Você vê o quadro completo como a IA pretendia.

4. Visualizando o Processo de Pensamento: Para modelos que transmitem seu raciocínio ou "pensamentos" juntamente com o conteúdo principal (como algumas configurações do DeepSeek), o Apidog pode frequentemente exibir essas metainformações de forma clara dentro da linha do tempo, proporcionando uma visão inestimável do processo do modelo.

Usar Apidog para depuração de SSE significa que você obtém uma visão clara, em tempo real e frequentemente estruturada automaticamente de como seu endpoint LLM está respondendo. Isso torna a identificação de problemas, a compreensão do processo de geração e a garantia de que a saída final está correta significativamente mais fácil em comparação com clientes HTTP genéricos ou ferramentas tradicionais de teste de API que carecem de um manuseio especializado de SSE.

Conclusão: Acessando o Gemini 2.5 Pro Gratuitamente

Você pode explorar o Gemini 2.5 Pro gratuitamente através de sua interface web oficial. Desenvolvedores que procuram acesso semelhante ao de API sem taxas podem experimentar ferramentas construídas pela comunidade, embora estas venham com riscos como instabilidade e possíveis questões de termos de serviço.

Para trabalhar com LLMs como o Gemini—especialmente ao lidar com respostas em streaming—ferramentas tradicionais falham. É aí que o Apidog brilha. Com recursos como detecção automática de SSE, visualizações de linha do tempo e mesclagem inteligente de dados fragmentados, o Apidog torna a depuração de respostas em tempo real muito mais fácil. Seu suporte de parsing personalizado ainda simplifica fluxos de trabalho complexos, tornando-o uma necessidade para o desenvolvimento moderno de APIs e LLMs.