Engenheiros e desenvolvedores buscam constantemente modelos de linguagem poderosos que equilibrem desempenho, eficiência e acessibilidade. O DeepSeek-V3.2-Exp surge como um avanço significativo neste domínio, oferecendo uma solução robusta para lidar com tarefas complexas de IA. Este modelo experimental, desenvolvido pela DeepSeek-AI, baseia-se diretamente na fundação do DeepSeek-V3.1-Terminus. Ele incorpora recursos inovadores que abordam desafios-chave no processamento de linguagem em larga escala, particularmente em cenários de longo contexto.

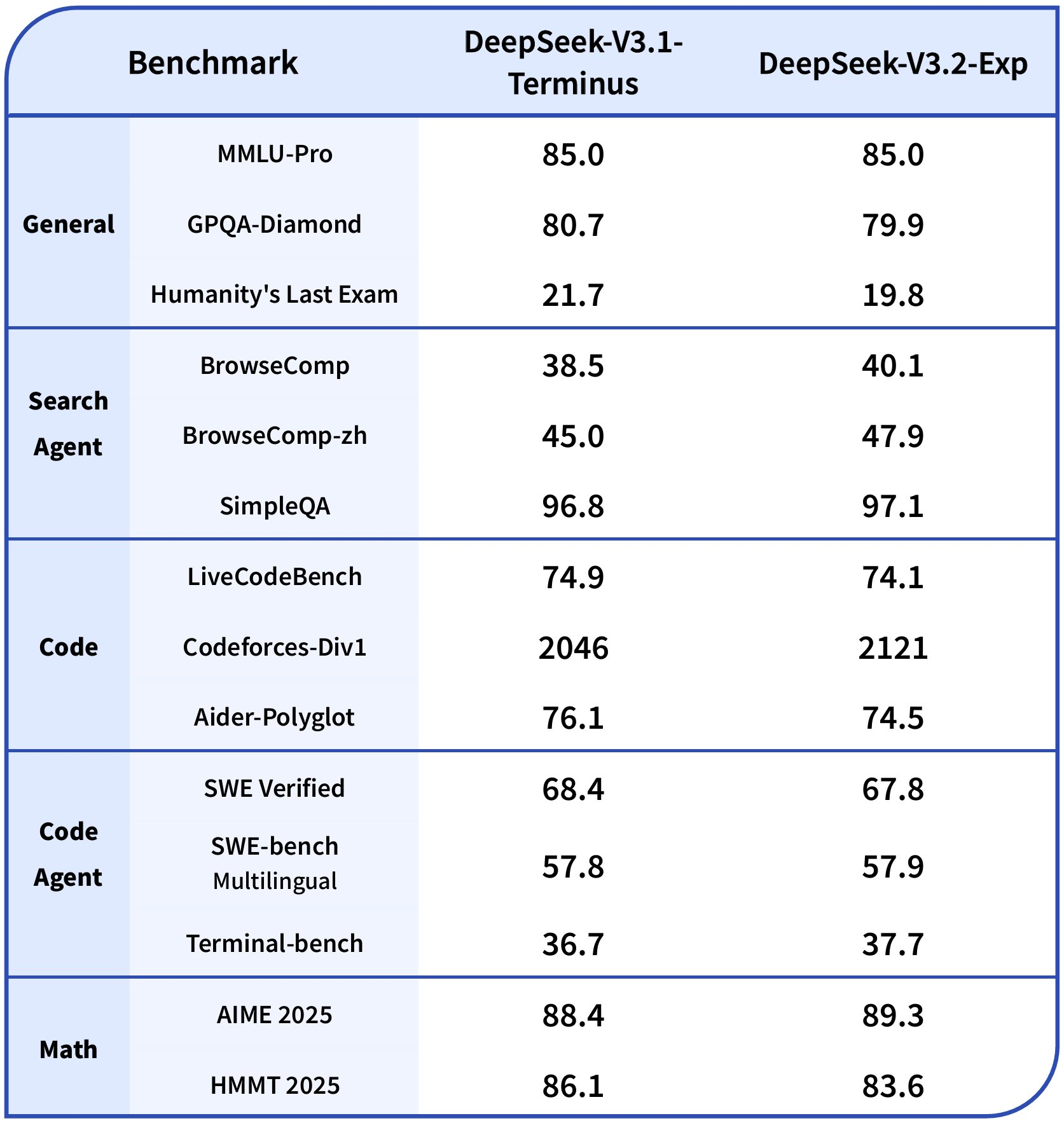

O DeepSeek-V3.2-Exp possui 685 bilhões de parâmetros, tornando-o um dos modelos de código aberto mais capazes disponíveis atualmente. Em seu cerne está o mecanismo DeepSeek Sparse Attention (DSA), que permite cálculos de atenção esparsa de granulação fina. Esta inovação reduz a sobrecarga computacional enquanto preserva a qualidade da saída, permitindo que o modelo processe contextos estendidos de forma mais eficiente do que seus predecessores. Benchmarks demonstram que o DeepSeek-V3.2-Exp tem um desempenho semelhante ao DeepSeek-V3.1-Terminus em diversas tarefas, incluindo raciocínio, codificação e uso de ferramentas agentivas.

Por exemplo, em benchmarks de raciocínio sem uso de ferramentas, o DeepSeek-V3.2-Exp atinge pontuações como 85.0 no MMLU-Pro e 89.3 no AIME 2025. Em cenários agentivos, ele se destaca com 40.1 no BrowseComp e 67.8 no SWE Verified. Esses resultados derivam de configurações de treinamento alinhadas que avaliam rigorosamente o impacto da atenção esparsa. Além disso, a natureza de código aberto do modelo, hospedado no Hugging Face, incentiva contribuições da comunidade e implantações locais.

botão

Transitando da visão geral do modelo para a implementação prática, o próximo passo envolve o acesso à própria API do DeepSeek-V3.2-Exp.

Acessando a API DeepSeek-V3.2-Exp

Uma vez que você compreenda as capacidades do DeepSeek-V3.2-Exp, você pode prosseguir para acessar sua API para aplicações no mundo real. O DeepSeek oferece uma API direta que se alinha com os padrões da indústria, facilitando a integração rápida em sistemas existentes.

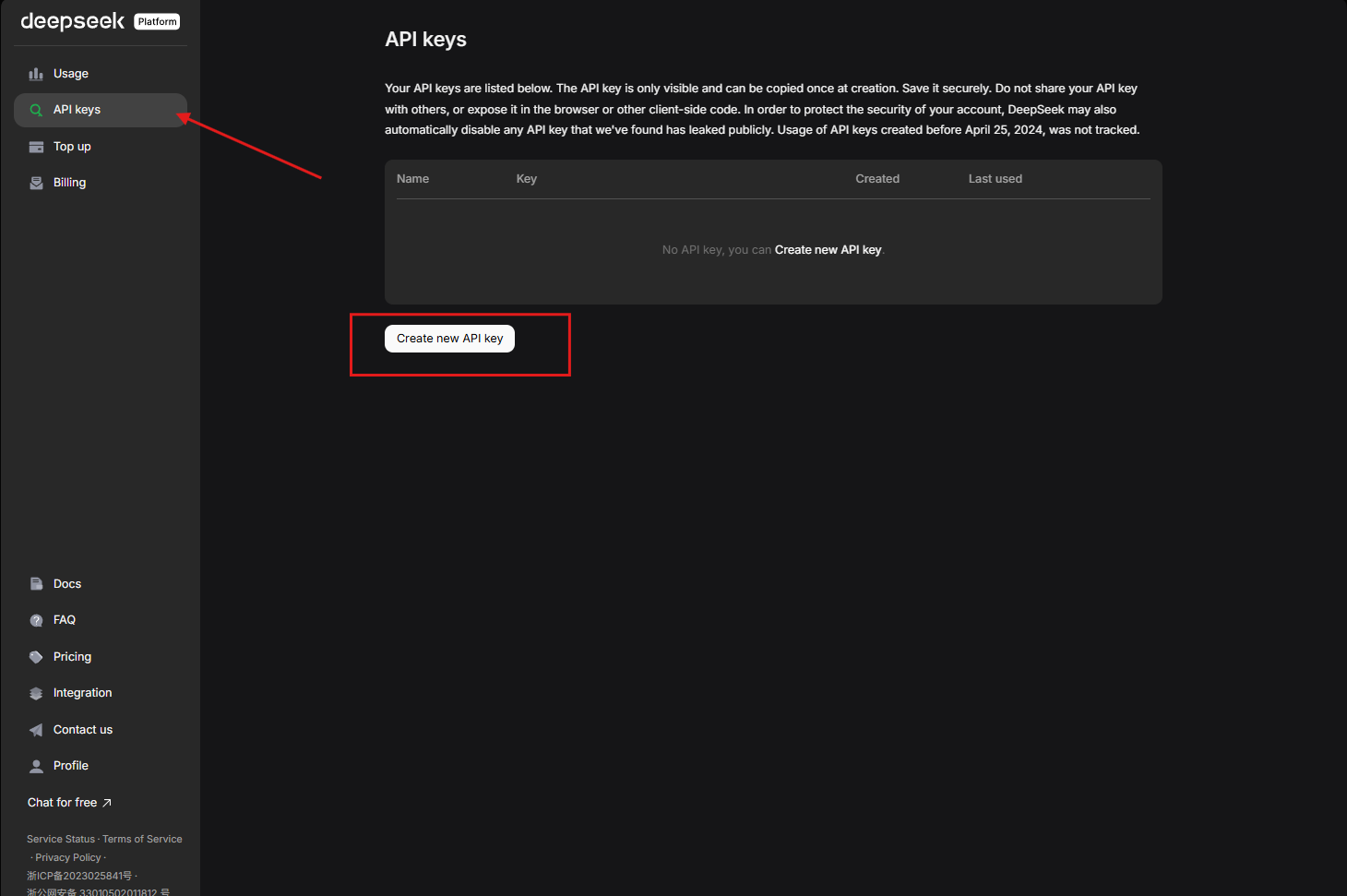

Primeiro, registre-se na plataforma DeepSeek para obter credenciais.

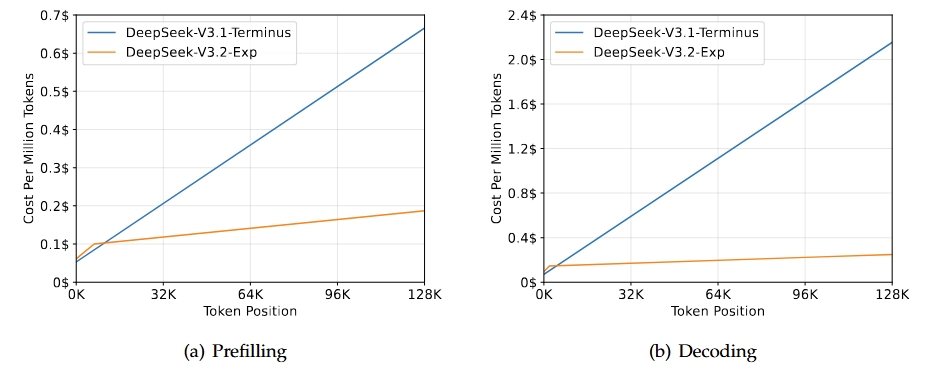

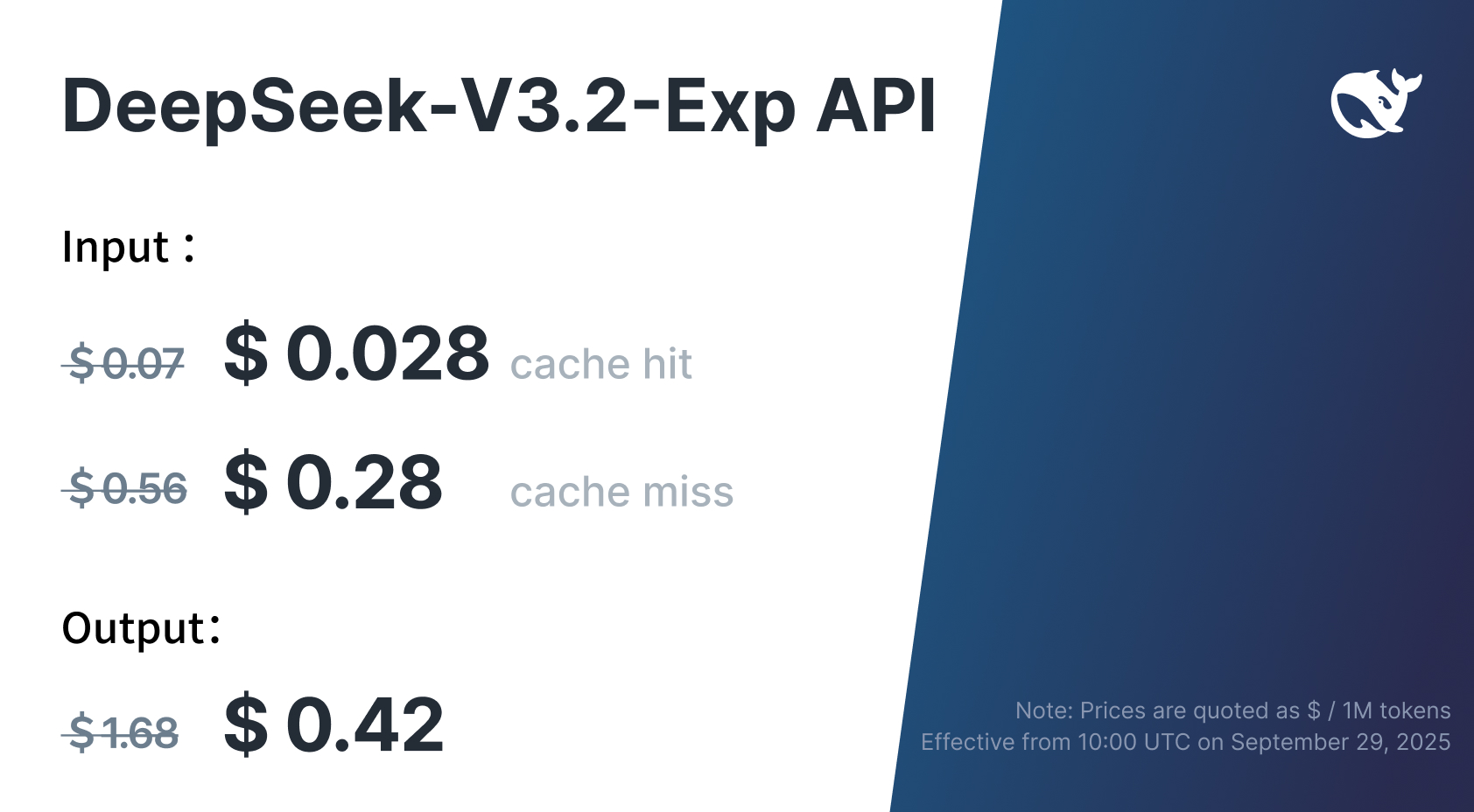

A API suporta compatibilidade com frameworks populares como o SDK da OpenAI, o que simplifica a adoção para equipes já familiarizadas com interfaces semelhantes. Defina a URL base para https://api.deepseek.com para acesso padrão, que por padrão utiliza o DeepSeek-V3.2-Exp. Essa configuração garante que você aproveite a eficiência aprimorada do modelo, incluindo a redução de mais de 50% no preço da API anunciada junto com o lançamento.

Para fins comparativos, o DeepSeek mantém temporariamente o acesso ao DeepSeek-V3.1-Terminus através de um endpoint especializado: https://api.deepseek.com/v3.1_terminus_expires_on_20251015. Isso permite que os engenheiros comparem as diferenças de desempenho, como melhorias na velocidade de inferência do DSA. No entanto, observe que este endpoint expira em 15 de outubro de 2025, às 15:59 UTC, então planeje seus testes de acordo.

Além disso, a API estende a compatibilidade ao ecossistema da Anthropic. Ajuste a URL base para https://api.deepseek.com/anthropic para interações semelhantes ao Claude, ou https://api.deepseek.com/v3.1_terminus_expires_on_20251015/anthropic para a versão anterior. Essa flexibilidade suporta diversos ambientes de desenvolvimento, desde aplicativos web até ferramentas de linha de comando.

Com o acesso estabelecido, a autenticação forma a próxima camada crítica para proteger suas interações.

Autenticação e Gerenciamento de Chaves de API

A segurança sustenta o uso confiável da API, então você autentica as requisições usando chaves de API. O DeepSeek exige que você gere uma chave no painel da plataforma. Esta chave serve como seu identificador único, concedendo acesso a modelos como o DeepSeek-V3.2-Exp.

Inclua a chave no cabeçalho Authorization de cada requisição: Bearer ${DEEPSEEK_API_KEY}. Este método se alinha às melhores práticas RESTful, garantindo a transmissão criptografada via HTTPS. Sempre armazene as chaves com segurança — use variáveis de ambiente no código ou serviços de gerenciamento de segredos como o AWS Secrets Manager para evitar exposição.

Além disso, monitore o uso através do painel da plataforma, que rastreia o consumo de tokens e a cobrança. Dadas as reduções de preço, o DeepSeek-V3.2-Exp oferece escalabilidade econômica; no entanto, implemente limitação de taxa em seus aplicativos para evitar cobranças inesperadas. Para equipes, gire as chaves periodicamente e revogue as comprometidas imediatamente.

Com base na autenticação, você agora explora os endpoints centrais que impulsionam as interações com o DeepSeek-V3.2-Exp.

Endpoints Chave e Formatos de Requisição para a API DeepSeek-V3.2-Exp

A API DeepSeek-V3.2-Exp se concentra em endpoints essenciais que lidam com conclusões de chat, raciocínio e chamada de função. Principalmente, você interage via o endpoint /chat/completions, que processa entradas conversacionais.

Construa requisições POST para https://api.deepseek.com/chat/completions com corpos JSON. Especifique o modelo como "deepseek-chat" para o modo padrão ou "deepseek-reasoner" para capacidades de raciocínio aprimoradas. O array de mensagens armazena o histórico da conversa: os prompts do sistema definem o comportamento, enquanto as funções do usuário inserem consultas.

Por exemplo, um corpo de requisição básico se parece com isto:

{

"model": "deepseek-chat",

"messages": [

{

"role": "system",

"content": "You are a technical expert."

},

{

"role": "user",

"content": "Explain sparse attention."

}

],

"stream": false

}

Defina "stream" como true para respostas em tempo real, ideal para aplicações interativas. Os cabeçalhos devem incluir Content-Type: application/json e o token bearer de Autorização.

Além disso, a API suporta conversas multi-rodada anexando respostas do assistente ao array de mensagens para chamadas subsequentes. Isso mantém o contexto em todas as interações, aproveitando os pontos fortes de longo contexto do DeepSeek-V3.2-Exp.

Além disso, incorpore a chamada de função para integrações de ferramentas. Defina as ferramentas na requisição, e o modelo seleciona as apropriadas com base na consulta. Este endpoint aprimora fluxos de trabalho agentivos, como recuperação de dados ou execução de código.

Mudando o foco para as saídas, entender as estruturas de resposta garante uma análise eficaz em seu código.

Estruturas de Resposta e Manipulação na API DeepSeek-V3.2-Exp

As respostas da API DeepSeek-V3.2-Exp seguem um formato JSON previsível, permitindo uma integração direta. Uma resposta não-stream inclui campos como id, object, created, model, choices e usage.

O array choices contém o conteúdo gerado: cada escolha tem uma mensagem com o papel "assistant" e o texto da resposta. Os detalhes de uso rastreiam prompt_tokens, completion_tokens e total_tokens, auxiliando no monitoramento de custos.

Para respostas de stream, a API envia Server-Sent Events (SSE). Cada pedaço chega como um evento de dados, com objetos JSON contendo atualizações delta para o conteúdo. Analise-os incrementalmente para construir a resposta completa, o que é adequado para interfaces de chat ao vivo.

Lide com erros de forma elegante — códigos comuns incluem 401 para falhas de autenticação e 429 para limites de taxa. Implemente retentativas com backoff exponencial para manter a confiabilidade.

Com requisições e respostas abordadas, exemplos de código práticos ilustram a implementação.

Exemplos de Código Python para Integrar a API DeepSeek-V3.2-Exp

Desenvolvedores frequentemente começam com Python devido à sua simplicidade e ricas bibliotecas. Aproveite o SDK da OpenAI para compatibilidade:

import openai

openai.api_base = "https://api.deepseek.com"

openai.api_key = "your_api_key_here"

response = openai.ChatCompletion.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a coding assistant."},

{"role": "user", "content": "Write a Python function to calculate Fibonacci numbers."}

],

stream=False

)

print(response.choices[0].message.content)

# This code generates a complete response. For streaming:

def stream_response():

stream = openai.ChatCompletion.create(

model="deepseek-chat",

messages=[...],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

# Extend this to multi-turn chats by storing and appending messages. For function calling:

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string"}

},

"required": ["location"]

}

}

}

]

Inclua ferramentas na chamada de criação e, em seguida, execute a função selecionada com base na resposta.

Além dos exemplos básicos, casos de uso avançados envolvem o modo JSON para saídas estruturadas. Defina response_format como {"type": "json_object"} para forçar respostas JSON, útil para tarefas de extração de dados.

Continuando a partir do código, a integração com ferramentas especializadas como o Apidog eleva seu processo de desenvolvimento.

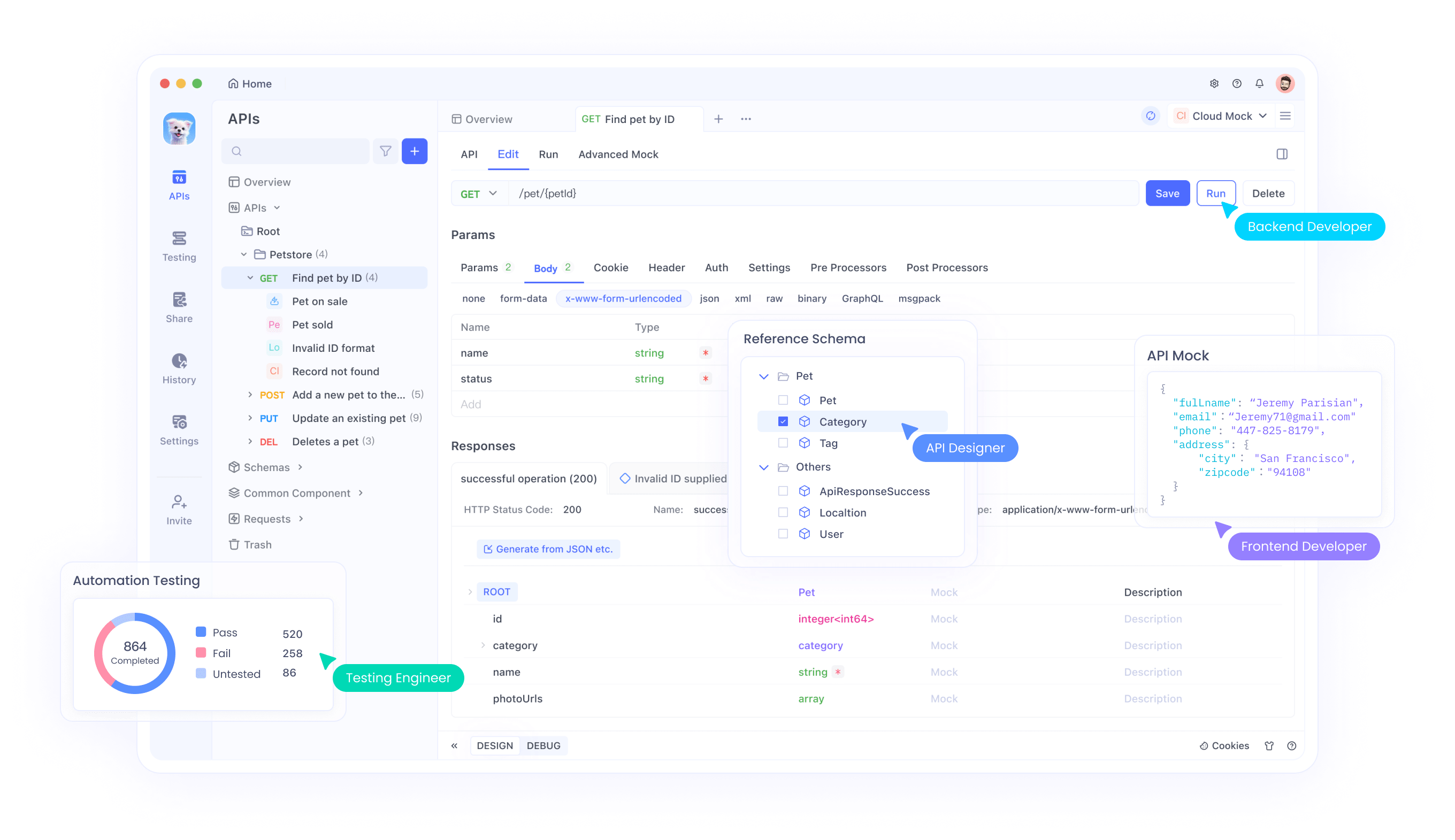

Integrando a API DeepSeek-V3.2-Exp com o Apidog

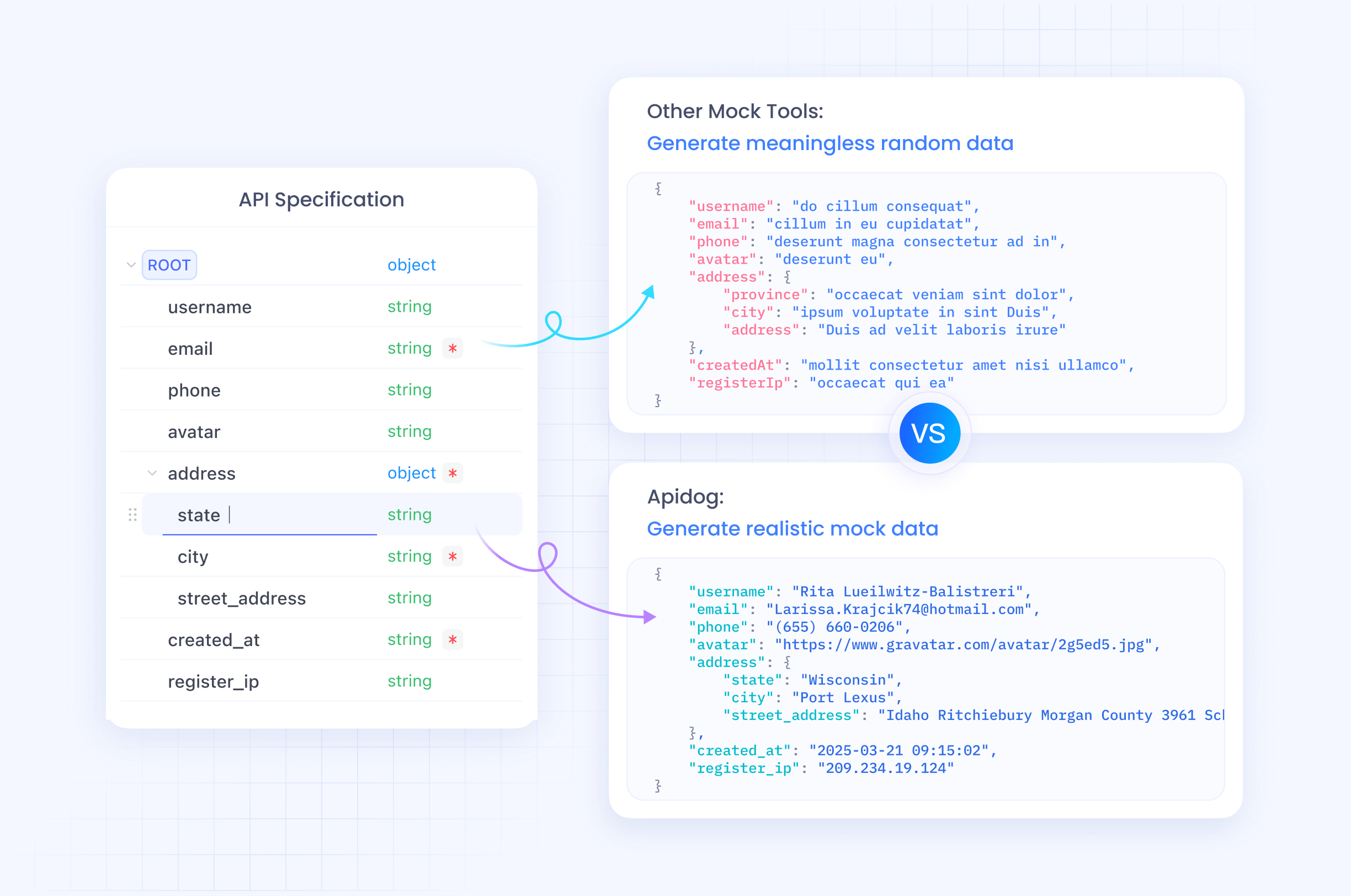

O Apidog se destaca como uma ferramenta versátil de gerenciamento de API que acelera testes e integração. Você importa as especificações da API DeepSeek-V3.2-Exp diretamente para o Apidog, criando coleções para endpoints como "chat completions".

Comece gerando uma chave de API no DeepSeek, então configure as variáveis de ambiente do Apidog para armazená-la com segurança. Use o construtor de requisições do Apidog para criar chamadas POST: defina a URL, cabeçalhos e corpo, então envie para receber respostas instantaneamente.

O Apidog se destaca na simulação de respostas para desenvolvimento offline — simule as saídas do DeepSeek-V3.2-Exp para testar casos extremos sem incorrer em custos de API. Além disso, gere trechos de código em linguagens como Python ou JavaScript a partir de requisições bem-sucedidas, acelerando a implementação.

Para depuração, a visualização da linha do tempo do Apidog rastreia os históricos de requisições, identificando problemas de autenticação ou parâmetros. Como o DeepSeek-V3.2-Exp suporta contextos longos, teste prompts estendidos no Apidog para verificar o desempenho.

Além disso, colabore com equipes compartilhando projetos do Apidog, garantindo o uso consistente da API entre os desenvolvedores. Esta integração não só economiza tempo, mas também aumenta a confiabilidade ao implantar recursos de IA.

À medida que você escala, as melhores práticas garantem resultados ótimos da API DeepSeek-V3.2-Exp.

Melhores Práticas para Usar a API DeepSeek-V3.2-Exp

Otimize os prompts para maximizar os pontos fortes do DeepSeek-V3.2-Exp. Use prompts de sistema claros e concisos para guiar o comportamento, e técnicas de cadeia de pensamento no modo "reasoner" para problemas complexos.

Monitore o uso de tokens — o DeepSeek-V3.2-Exp lida com até 128K contextos, mas a eficiência diminui com o comprimento excessivo. Trunque históricos de forma inteligente para permanecer dentro dos limites.

Implemente cache para consultas frequentes para reduzir chamadas, e requisições em lote sempre que possível para cenários de alta vazão.

Em termos de segurança, sanitize as entradas do usuário para prevenir injeções de prompt, e registre as interações para auditoria.

Para ajuste de desempenho, experimente os parâmetros temperature e top_p: valores mais baixos produzem saídas determinísticas, enquanto valores mais altos promovem a criatividade.

Além disso, conduza testes A/B entre os modos deepseek-chat e deepseek-reasoner para selecionar o mais adequado para sua aplicação.

Transitando para comparações, avalie o DeepSeek-V3.2-Exp contra modelos predecessores.

Comparando o DeepSeek-V3.2-Exp com Modelos Anteriores

O DeepSeek-V3.2-Exp avança além do DeepSeek-V3.1-Terminus principalmente através do DSA, que aumenta a velocidade de inferência em 3x em alguns casos, mantendo a paridade de benchmark.

Em tarefas de codificação, ele pontua 2121 no Codeforces contra 2046, mostrando pequenas melhorias. No entanto, em exames focados em humanidades, ocorrem pequenas quedas, como 19.8 contra 21.7 no Humanity's Last Exam, destacando áreas para refinamento.

Acesse o modelo anterior temporariamente para comparações diretas, ajustando as URLs base conforme observado. Isso revela os ganhos de eficiência do DSA no processamento de longo contexto, cruciais para aplicações como sumarização de documentos.

Use ferramentas como o Apidog para executar testes paralelos, registrando métricas para decisões informadas.

Expandindo ainda mais, explore casos de uso onde o DeepSeek-V3.2-Exp se destaca.

Solucionando Problemas Comuns com a API DeepSeek-V3.2-Exp

Encontrou erros 401? Verifique sua chave de API e o formato do cabeçalho.

Limites de taxa atingidos? Implemente lógica de backoff: espere progressivamente mais tempo entre as retentativas.

Saídas inesperadas? Refine os prompts ou ajuste parâmetros como max_tokens.

Para problemas de stream, certifique-se de que seu cliente lide com SSE corretamente, analisando os chunks sem atrasos de buffer.

Se os contextos excederem os limites, resuma as mensagens anteriores antes de anexar.

Relate problemas persistentes através do formulário de feedback do DeepSeek, contribuindo para melhorias no modelo.

Finalmente, considere implantações locais para controle aprimorado.

Implantação Local e Configurações Avançadas

Além da API, execute o DeepSeek-V3.2-Exp localmente usando os pesos do Hugging Face. Converta checkpoints com scripts fornecidos, especificando contagens de especialistas (256) e paralelismo de modelo com base em GPUs.

Lance demos de inferência para testes interativos, utilizando TileLang ou kernels CUDA para desempenho otimizado.

Esta configuração é adequada para aplicações sensíveis à privacidade ou ambientes offline.

Em resumo, a API DeepSeek-V3.2-Exp capacita desenvolvedores com capacidades de IA de ponta.

Conclusão: Aproveitando o DeepSeek-V3.2-Exp para Futuras Inovações

O DeepSeek-V3.2-Exp representa um salto na modelagem eficiente de IA, com sua API fornecendo pontos de entrada acessíveis. Da autenticação às integrações avançadas, este guia o capacita a construir aplicações robustas. Experimente, itere e ultrapasse os limites — pequenos refinamentos em prompts ou configurações frequentemente resultam em ganhos substanciais.

botão