Desenvolvedores frequentemente buscam APIs robustas para impulsionar aplicações de IA. A API DeepSeek-V3.1 se destaca como uma opção versátil. Ela oferece capacidades avançadas de modelagem de linguagem. Você acessa recursos como conclusões de chat e integrações de ferramentas. Esta postagem explica como usá-la passo a passo.

Primeiro, obtenha uma chave de API na plataforma DeepSeek. Cadastre-se no site deles e gere a chave. Com isso, você começa a fazer requisições.

Em seguida, entenda os componentes centrais. O DeepSeek-V3.1 é construído sobre modelos de larga escala. Ele suporta contextos de até 128K tokens. Você lida com consultas complexas de forma eficiente. Além disso, inclui modos de pensamento para um raciocínio mais profundo. À medida que avança, observe como esses elementos se encaixam.

O Que É DeepSeek-V3.1 e Por Que Escolhê-lo?

DeepSeek-V3.1 representa uma evolução nos modelos de IA. Engenheiros da DeepSeek-ai o desenvolveram como uma arquitetura híbrida. O modelo totaliza 671 bilhões de parâmetros, mas ativa apenas 37 bilhões durante a inferência. Este design reduz as demandas computacionais enquanto mantém alto desempenho.

Você encontra duas variantes principais: DeepSeek-V3.1-Base e o DeepSeek-V3.1 completo. A versão base serve como fundação para treinamento adicional. Ela passou por uma extensão de contexto longo em duas fases. Na primeira fase, o treinamento se expandiu para 630 bilhões de tokens para um contexto de 32K. Em seguida, a segunda fase adicionou 209 bilhões de tokens para um contexto de 128K. Documentos longos adicionais enriqueceram o conjunto de dados.

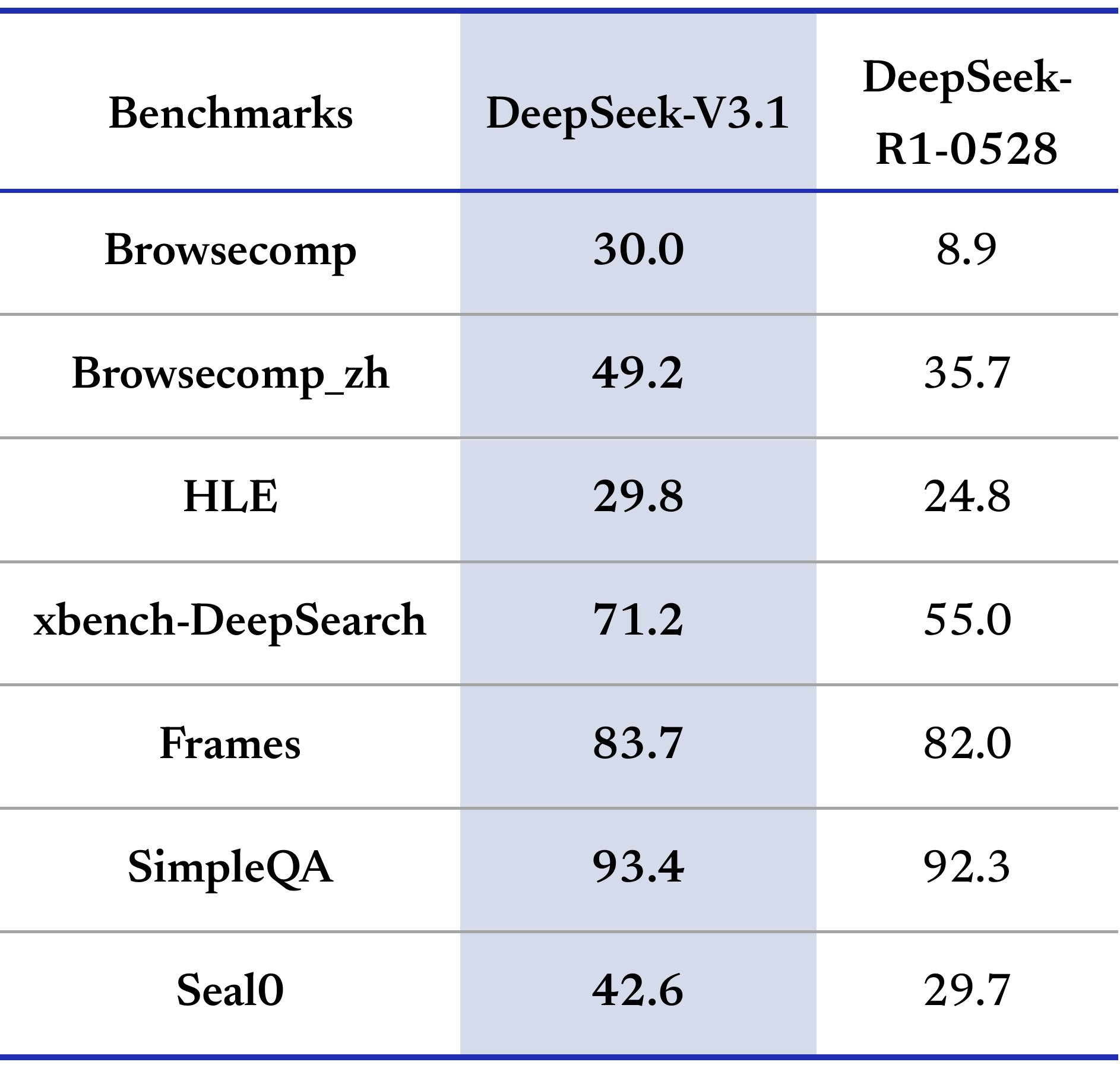

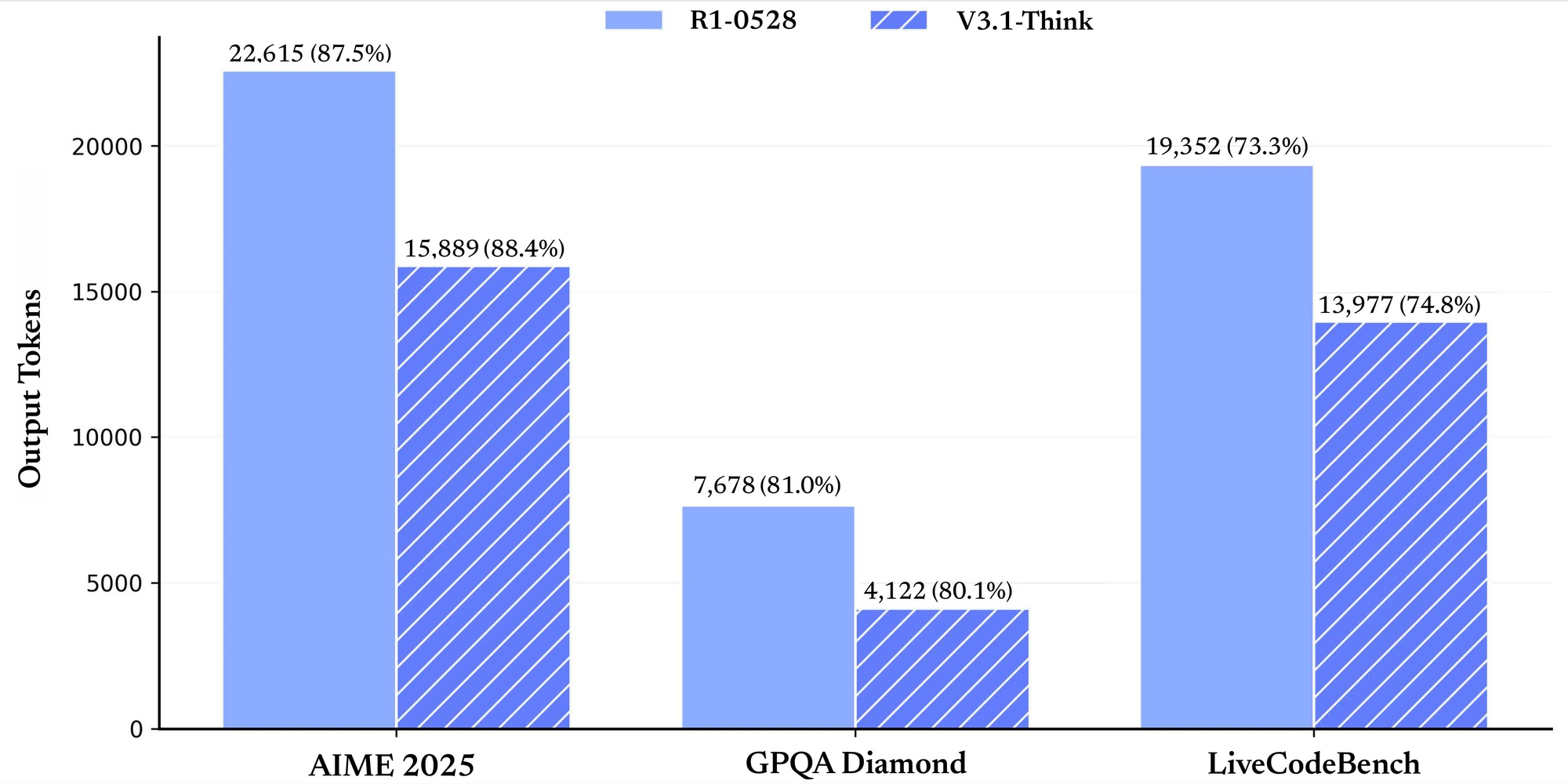

Benchmarks de desempenho destacam seus pontos fortes. Para tarefas gerais, ele pontua 91.8 no MMLU-Redux no modo não-pensamento e 93.7 no modo pensamento. No GPQA-Diamond, atinge 74.9 e 80.1, respectivamente. Em avaliações relacionadas a código, o LiveCodeBench rende 56.4 no modo não-pensamento e 74.8 no modo pensamento. Benchmarks de matemática como o AIME 2024 mostram 66.3 e 93.1. Esses números demonstram confiabilidade em diversos domínios.

Por que selecionar a API DeepSeek-V3.1? Ela se destaca em tarefas de agente e chamada de ferramenta. Você a integra para agentes de busca ou agentes de código. Comparada a outras APIs, ela oferece preços econômicos e recursos de compatibilidade. Como resultado, as equipes a adotam para soluções de IA escaláveis. Transicionando para a configuração, prepare seu ambiente cuidadosamente.

Começando com a Integração da API DeepSeek-V3.1

Você começa configurando seu ambiente de desenvolvimento. Instale as bibliotecas necessárias. Para Python, use pip para adicionar requests ou SDKs compatíveis. Os endpoints da API DeepSeek-V3.1 seguem protocolos HTTP padrão. A URL base é https://api.deepseek.com.

Gere sua chave de API no painel. Armazene-a de forma segura em variáveis de ambiente. Por exemplo, defina DEEPSEEK_API_KEY em seu shell. Agora, faça sua primeira requisição. Use o endpoint de conclusão de chat. Envie um POST para /chat/completions.

Inclua cabeçalhos com Authorization: Bearer your_key. O corpo contém o modelo como "deepseek-chat", um array de mensagens e parâmetros como max_tokens. Uma requisição simples se parece com isto:

import requests

url = "https://api.deepseek.com/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Hello, DeepSeek-V3.1!"}],

"max_tokens": 100

}

response = requests.post(url, headers=headers, json=data)

print(response.json())

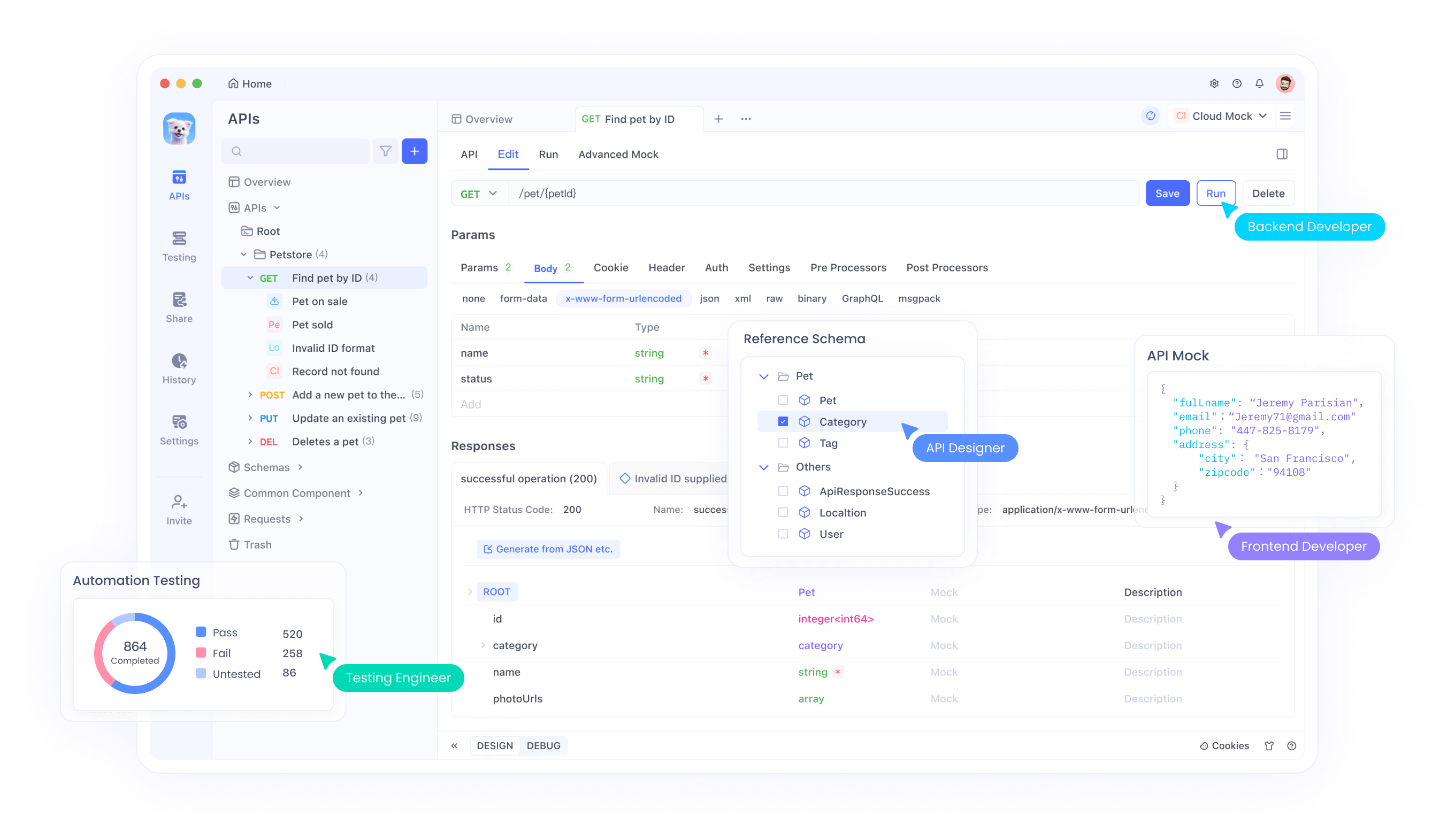

Este código busca uma resposta. Verifique o campo de conteúdo para a saída. Se ocorrerem erros, verifique a chave e o payload. Além disso, teste com o Apidog. Importe o endpoint e simule chamadas. O Apidog visualiza as respostas, auxiliando na depuração.

Explore as opções de modelo. DeepSeek-chat é adequado para chats gerais. DeepSeek-reasoner lida com tarefas de raciocínio. Selecione com base nas necessidades. À medida que avança, incorpore streaming para saídas em tempo real. Defina stream como true na requisição. Processe os chunks de acordo.

A segurança também importa. Use HTTPS sempre. Limite a exposição da chave. Gire as chaves periodicamente. Com o básico coberto, passe para recursos avançados como a chamada de função.

Dominando a Chamada de Função na API DeepSeek-V3.1

A chamada de função aprimora a API DeepSeek-V3.1. Você define ferramentas que o modelo invoca. Isso permite interações dinâmicas, como buscar dados meteorológicos.

Defina ferramentas na requisição. Cada ferramenta tem tipo "function", nome, descrição e parâmetros. Os parâmetros usam esquema JSON. Por exemplo, uma ferramenta get_weather:

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string", "description": "City name"}

},

"required": ["location"]

}

}

}

Inclua isso no array de ferramentas de sua requisição de conclusão de chat. O modelo analisa a mensagem do usuário. Se relevante, ele retorna tool_calls na resposta. Cada chamada tem id, nome e argumentos.

Lide com a chamada. Execute a função localmente. Para get_weather, consulte uma API externa ou dados simulados. Anexe o resultado como uma mensagem de ferramenta:

{

"role": "tool",

"tool_call_id": "call_id_here",

"content": "Temperature: 24°C"

}

Envie as mensagens atualizadas de volta. O modelo gera uma resposta final.

Use o modo estrito para uma melhor validação. Defina strict como true e use a URL base beta. Isso impõe a conformidade do esquema. Os tipos suportados incluem string, number, array. Evite campos não suportados como minLength.

As melhores práticas incluem descrições claras. Teste ferramentas com o Apidog para simular respostas. Monitore erros nos argumentos. Como resultado, suas aplicações se tornam mais interativas. Em seguida, examine a compatibilidade com outros ecossistemas.

Aproveitando a Compatibilidade da API Anthropic no DeepSeek-V3.1

A API DeepSeek-V3.1 suporta o formato Anthropic. Isso permite que você use os SDKs da Anthropic de forma integrada. Defina a URL base para https://api.deepseek.com/anthropic.

Instale o SDK Anthropic: pip install anthropic. Configure o ambiente:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Crie mensagens:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are helpful.",

messages=[{"role": "user", "content": [{"type": "text", "text": "Hi"}]}]

)

print(message.content)

Isso funciona como o Anthropic, mas usa modelos DeepSeek. Campos suportados: max_tokens, temperature (0-2.0), tools. Ignorados: top_k, cache_control.

Existem diferenças. Sem suporte a imagens ou documentos. Opções de escolha de ferramenta limitadas. Use isso para migrar do Anthropic. Teste com o Apidog para comparar respostas. Consequentemente, você expande seu conjunto de ferramentas sem reescrever o código.

Compreendendo a Arquitetura do Modelo e o Tokenizador DeepSeek-V3.1

DeepSeek-V3.1-Base forma o núcleo. Ele usa um design híbrido para eficiência. O comprimento do contexto atinge 128K, ideal para documentos longos.

O treinamento envolveu fases estendidas. Primeiro, 32K com 630B tokens. Em seguida, 128K com 209B. O formato FP8 garante compatibilidade.

Configuração do tokenizador: add_bos_token true, model_max_length 131072. Token BOS "<|begin of sentence|>", EOS "<|end of sentence|>". O template de chat lida com papéis como Usuário, Assistente, tags de pensamento.

Aplique templates para conversas. Para o modo de pensamento, envolva o raciocínio em tags. Isso aumenta o desempenho em tarefas complexas.

Você carrega o modelo via Hugging Face. Use from_pretrained("deepseek-ai/DeepSeek-V3.1"). Tokenize as entradas cuidadosamente. Monitore a contagem de tokens para permanecer dentro dos limites. Assim, você otimiza para precisão.

Preços e Gerenciamento de Custos para a API DeepSeek-V3.1

O preço afeta a adoção. A API DeepSeek-V3.1 cobra por milhão de tokens. Modelos: deepseek-chat e deepseek-reasoner.

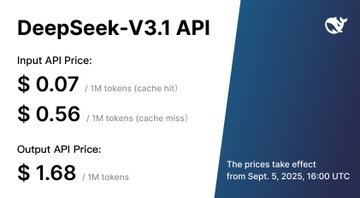

A partir de 5 de setembro de 2025, 16:00 UTC: Ambos os modelos custam $0.07 para entrada com acerto de cache, $0.56 para entrada com erro de cache, $1.68 para saída.

Antes disso, padrão (00:30-16:30 UTC): deepseek-chat $0.07 acerto, $0.27 erro, $1.10 saída; reasoner $0.14 acerto, $0.55 erro, $2.19 saída. Desconto (16:30-00:30): aproximadamente metade dos preços.

Nenhum nível gratuito mencionado. Calcule os custos: Estime os tokens por requisição. Use cache para entradas repetidas. Otimize os prompts para reduzir os tokens.

Acompanhe o uso no painel. Defina orçamentos. Com o Apidog, simule chamadas para prever custos. Portanto, gerencie as despesas de forma eficaz.

Melhores Práticas e Solução de Problemas para a API DeepSeek-V3.1

Siga as diretrizes para o sucesso. Crie prompts concisos. Forneça contexto nas mensagens.

Monitore a latência. Contextos longos atrasam as respostas. Divida as entradas em chunks, se possível.

Dados seguros: Evite enviar informações sensíveis.

Solução de problemas: Verifique os códigos de status. 401 significa chave inválida. 429 muitas requisições.

Atualize os SDKs regularmente. Leia a documentação para mudanças.

Escala: Agrupe requisições se suportado. Use assíncrono para paralelismo.

Fóruns da comunidade ajudam. Compartilhe experiências.

Ao aplicar estas práticas, você alcança integrações confiáveis.

Conclusão: Eleve Seus Projetos de IA com a API DeepSeek-V3.1

Agora você sabe como usar a API DeepSeek-V3.1 de forma eficaz. Desde a configuração até recursos avançados, ela capacita os desenvolvedores. Incorpore o Apidog para fluxos de trabalho mais suaves. Comece a construir hoje e veja o impacto.