No mundo em rápida evolução da codificação assistida por IA, entender como suas ferramentas são precificadas é crucial. O Cursor, um popular assistente de codificação com IA, oferece uma variedade de modelos e planos de preços—mas muitos usuários ficam coçando a cabeça sobre como os requests, cotas e modos realmente funcionam. Mais ainda, com a introdução do Max Mode e modelos premium, a estrutura de custos pode parecer um labirinto.

Se você é um usuário do Cursor buscando clareza—ou procurando maneiras de otimizar seu fluxo de trabalho sem esvaziar o bolso—este artigo é para você. Vamos detalhar a precificação do Cursor, explicar a diferença entre Normal e Max Mode, e mostrar como o Apidog MCP Server gratuito pode ser perfeitamente integrado ao seu fluxo de trabalho no Cursor para máximo valor.

Precificação do Cursor: Como Funciona a Precificação do Cursor?

Entender a precificação do Cursor começa com seu sistema fundamental baseado em requests. Essencialmente, a maioria das interações com os modelos de IA do Cursor consome "requests". O custo desses requests e quantos você obtém depende do seu plano de assinatura do Cursor. Vamos detalhar.

Em sua essência, um "request" padrão custa $0.04, conforme declarado em sua precificação de modelos. O Cursor oferece vários planos, cada um atendendo a diferentes níveis de uso:

- Plano Hobby: Este é um ponto de entrada gratuito, oferecendo um número limitado de completions e 50 requests por mês. É uma ótima maneira de experimentar as capacidades do Cursor.

- Plano Pro: Com preço de $20/mês, este plano aumenta significativamente suas cotas de requests no Cursor para 500 requests rápidos por mês. Ele também inclui completions ilimitados e, crucialmente, "requests lentos" ilimitados assim que seus requests rápidos se esgotarem.

- Plano Business: Por $40/usuário/mês, este plano inclui tudo do Pro, além de recursos voltados para equipes, como faturamento centralizado e painéis de administração. Cada usuário ainda recebe sua cota individual de 500 requests rápidos.

Comparação dos Planos de Assinatura do Cursor:

| Plano | Preço | Requests/Mês | Max Mode | Modelos Premium | Recursos para Equipes |

|---|---|---|---|---|---|

| Hobby | Grátis | 50 | ❌ | Limitado | ❌ |

| Pro | $20/mês | 500 | ✅ | Ilimitado | ❌ |

| Business | $40/usuário/mês | 500 | ✅ | Ilimitado | ✅ |

O Que Acontece Quando Seus Requests Rápidos Acabam?

Este é um ponto comum de preocupação, como destacado em várias discussões. Uma vez que sua cota mensal de 500 requests rápidos (nos planos Pro/Business) se esgota, você tem algumas opções:

- Requests Lentos: Sua conta muda automaticamente para usar requests lentos para operações no modo Normal. Estes ainda são modelos premium, mas são processados com menor prioridade, o que significa que você pode experimentar um período de espera. A duração dessa espera pode variar com base na carga do sistema e no seu uso recente de requests lentos. Importante: requests lentos não estão disponíveis para o Max mode.

- Precificação Baseada em Uso: Para evitar filas e continuar usando requests rápidos (ou para usar o Max mode após esgotar sua cota), você pode optar pela precificação baseada em uso a partir do seu painel. Isso significa que você será cobrado por requests adicionais além da cota do seu plano na taxa padrão (por exemplo, 0.04 por request padrão). Você pode definir limites de gastos para controlar os custos. O faturamento para este uso adicional geralmente ocorre quando você acumulou $20 em cobranças extras ou no início do próximo mês, o que ocorrer primeiro.

Coisas Chave Para Lembrar Sobre Suas Cotas de Requests no Cursor:

- Reinício da Cota: Sua cota de requests é reiniciada mensalmente, com base na data em que você se inscreveu inicialmente.

- Cotas de Equipe: Para planos Business, cada usuário recebe sua própria cota de 500 requests; elas não são compartilhadas.

- Custos dos Modelos Variam: Embora um request "padrão" possa ser a linha de base, alguns modelos ou recursos (especialmente no Max mode) podem consumir o valor de mais de um request. Você pode aprender mais detalhes em custos dos modelos do Cursor.

Compreender esses fundamentos de como funciona a precificação do Cursor é o primeiro passo para gerenciar seus gastos e garantir que você está no plano certo para suas necessidades.

Modo Normal vs. Max Mode do Cursor

O Cursor oferece dois modos operacionais principais para sua IA: Modo Normal e Max Mode. A escolha entre eles impacta significativamente tanto o desempenho quanto, crucialmente, como os modelos do Cursor custam em termos de requests. Muitos usuários expressam confusão sobre isso, particularmente em relação ao consumo potencialmente rápido das cotas de requests do Cursor no Max mode.

Modo Normal: Previsível e Eficiente para Tarefas Diárias

- Como Funciona: No Modo Normal, cada mensagem que você envia a um modelo custa um número fixo de requests, determinado unicamente pelo modelo que você está usando. O gerenciamento de contexto é otimizado pelo Cursor sem afetar sua contagem de requests por mensagem. Por exemplo, uma conversa usando o Claude 3.5 Sonnet pode custar 1 request por mensagem do usuário, enquanto as respostas do Cursor são gratuitas.

- Ideal Para: Tarefas de codificação diárias, perguntas rápidas e situações onde a previsibilidade de custos é primordial.

- Custo: Requests fixos por interação (por exemplo, 1 request para um prompt do usuário para o Claude 3.5 Sonnet).

- Prós: Custos altamente previsíveis, geralmente menor consumo de requests para interações simples.

- Contras: Pode ter limitações com contextos muito grandes ou tarefas de raciocínio altamente complexas em comparação com o Max mode.

Max Mode: Poderoso para Raciocínio Complexo e Tarefas de Agente

- Como Funciona: O Max mode opera em um sistema de precificação baseado em tokens. O Cursor cobra o preço da API do provedor do modelo mais uma margem de 20%. Isso inclui todos os tokens: suas mensagens, arquivos de código anexados, pastas, chamadas de ferramentas e qualquer outro contexto fornecido. É aqui que os custos podem escalar se não forem gerenciados cuidadosamente.

- Ideal Para: Raciocínio complexo, depuração de bugs difíceis, tarefas de agente que exigem múltiplas chamadas de ferramentas e trabalho com bases de código extensas.

- Custo: Variável, baseado no número total de tokens processados (entrada e saída). Por exemplo, um prompt complexo com 135k tokens de entrada pode custar 2.7 requests, e a resposta de 82k tokens do modelo pode custar outros 1.23 requests, totalizando quase 4 requests para uma única troca.

- Prós: Lida com janelas de contexto muito maiores (até 1M tokens para alguns modelos), permite mais chamadas de ferramentas (até 200 sem precisar de re-prompting) e geralmente oferece capacidades de raciocínio mais poderosas.

- Contras: Pode consumir cotas de requests do Cursor muito rapidamente. Requests gratuitos/lentos não estão disponíveis para o Max mode; se seus requests rápidos acabarem, você deve habilitar a precificação baseada em uso para continuar usando o Max mode.

Aqui está uma comparação simplificada:

| Recurso | Modo Normal | Max Mode |

|---|---|---|

| Base de Precificação | Requests fixos por mensagem/modelo | Por 1M tokens (MTok) - custo da API + 20% |

| Exemplo de Custo | 1 request para um prompt do Claude 3.5 Sonnet | Pode ser múltiplos requests por interação com base na contagem de tokens |

| Previsibilidade | Alta | Menor; depende do tamanho e complexidade do contexto |

| Janela de Contexto | Otimizada pelo Cursor | Significativamente maior (por exemplo, 75k a 1M+ tokens dependendo do modelo) |

| Chamadas de Ferramentas | Padrão | Até 200 sem re-prompting |

| Requests Lentos | Disponível quando requests rápidos se esgotam | Não disponível; requer precificação baseada em uso se requests rápidos acabarem |

| Melhor Para | Codificação diária, custos previsíveis | Raciocínio complexo, contextos grandes, tarefas de agente |

Escolher o modo certo para a tarefa em questão é crucial para equilibrar desempenho com suas cotas de requests no Cursor. Para a maioria das tarefas diárias, o Modo Normal oferece uma solução econômica. Reserve o Max mode para aqueles desafios verdadeiramente complexos onde suas capacidades estendidas são necessárias.

Apidog MCP Server: O Power-Up Gratuito para Usuários do Cursor

Embora os modelos e a precificação integrados do Cursor sejam robustos, você pode expandir dramaticamente seu fluxo de trabalho—a custo zero—integrando o Apidog MCP Server.

O Que é o Apidog MCP Server?

O Apidog MCP Server atua como uma ponte direta entre suas especificações de API e IDEs assistidos por IA como o Cursor. Uma vez configurado, ele permite que a IA do Cursor acesse e entenda diretamente a estrutura, endpoints, schemas e requisitos da sua API. Ele suporta várias fontes de dados:

- Seus projetos Apidog

- Documentação de API online publicada pelo Apidog

- Arquivos Swagger/OpenAPI locais ou online

O servidor lê e armazena em cache esses dados de especificação de API localmente, tornando-os instantaneamente disponíveis para o Cursor. Isso significa que você pode:

- Gerar ou modificar código com base na sua especificação de API

- Buscar e analisar conteúdo de API diretamente no seu IDE

- Automatizar tarefas de codificação repetitivas com IA

- E muito mais—tudo de graça!

Como Integrar o Apidog MCP Server com o Cursor

Integrar o Apidog MCP Server com o Cursor permite que seu assistente de IA acesse diretamente suas especificações de API. Veja como configurá-lo:

Pré-requisitos:

Antes de começar, certifique-se de que o seguinte está instalado:

✅ Node.js (versão 18+; LTS mais recente recomendado)

✅ Você está usando um IDE que suporta MCP, como: Cursor

Passo 1: Prepare Seu Arquivo OpenAPI

Você precisará de acesso à definição da sua API:

- Uma URL (por exemplo,

https://petstore.swagger.io/v2/swagger.json) - Ou um caminho de arquivo local (por exemplo,

~/projects/api-docs/openapi.yaml) - Formatos suportados:

.jsonou.yaml(OpenAPI 3.x recomendado)

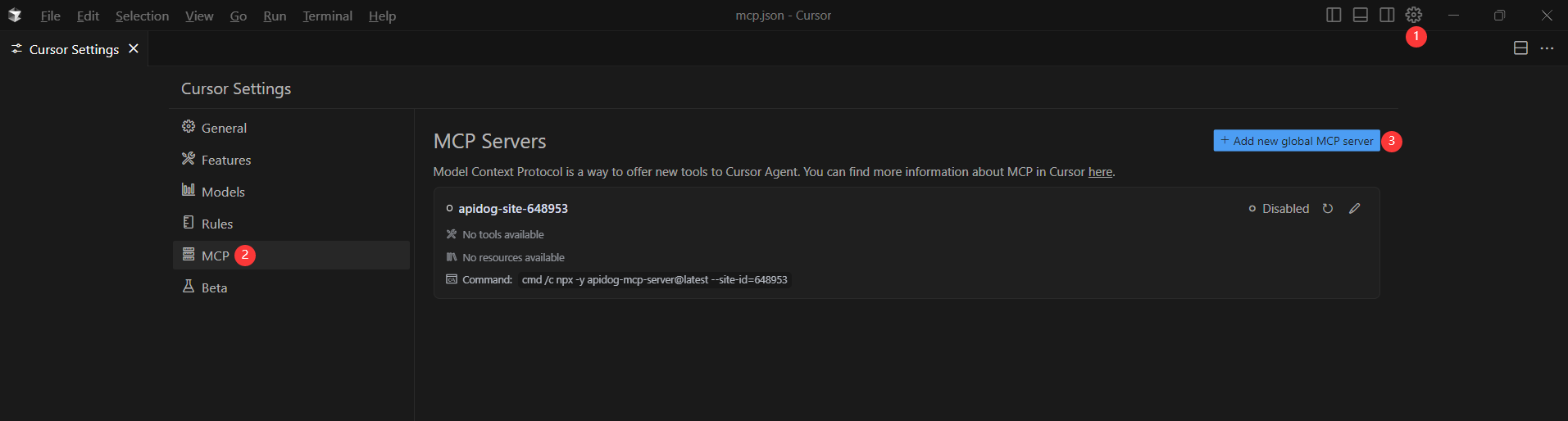

Passo 2: Adicione a Configuração MCP ao Cursor

Agora você adicionará a configuração ao arquivo mcp.json do Cursor.

Lembre-se de Substituir <oas-url-or-path> pela sua URL OpenAPI real ou caminho local.

- Para MacOS/Linux:

{

"mcpServers": {

"API specification": {

"command": "npx",

"args": [

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}- Para Windows:

{

"mcpServers": {

"API specification": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Passo 3: Verifique a Conexão

Após salvar a configuração, teste-a no IDE digitando o seguinte comando no modo Agente:

Please fetch API documentation via MCP and tell me how many endpoints exist in the project.Se funcionar, você verá uma resposta estruturada que lista os endpoints e seus detalhes. Se não funcionar, verifique novamente o caminho para o seu arquivo OpenAPI e certifique-se de que o Node.js está instalado corretamente.

Conclusão: Dominando os Custos do Cursor e Elevando Seu Fluxo de Trabalho de API

Entender a precificação, os limites de requests e a diferença entre os modos Normal e Max do Cursor é fundamental para tirar o máximo proveito deste editor de código com IA. Mas a verdadeira otimização vai além do controle de custos. O Apidog MCP Server gratuito leva seu fluxo de trabalho para o próximo nível, integrando suas especificações de API diretamente ao Cursor. Ele reduz o trabalho manual, diminui erros e mantém seu código sincronizado com o design da sua API—sem interromper seu fluxo de desenvolvimento.