Desenvolvedores buscam cada vez mais modelos de IA eficientes que equilibrem desempenho com custo e velocidade. O Claude Haiku 4.5 surge como uma opção poderosa nesse cenário, oferecendo capacidades avançadas para diversas aplicações. Este artigo oferece uma análise detalhada de como engenheiros e programadores podem implementar a API do Claude Haiku 4.5 em seus projetos. Desde a configuração inicial até integrações sofisticadas, você obtém insights para maximizar seu potencial.

Ao longo deste guia, você encontrará instruções passo a passo que se complementam. Primeiro, entenda os atributos centrais do Claude Haiku 4.5, para depois passar para a implementação prática.

Compreendendo o Claude Haiku 4.5: Principais Recursos e Melhorias

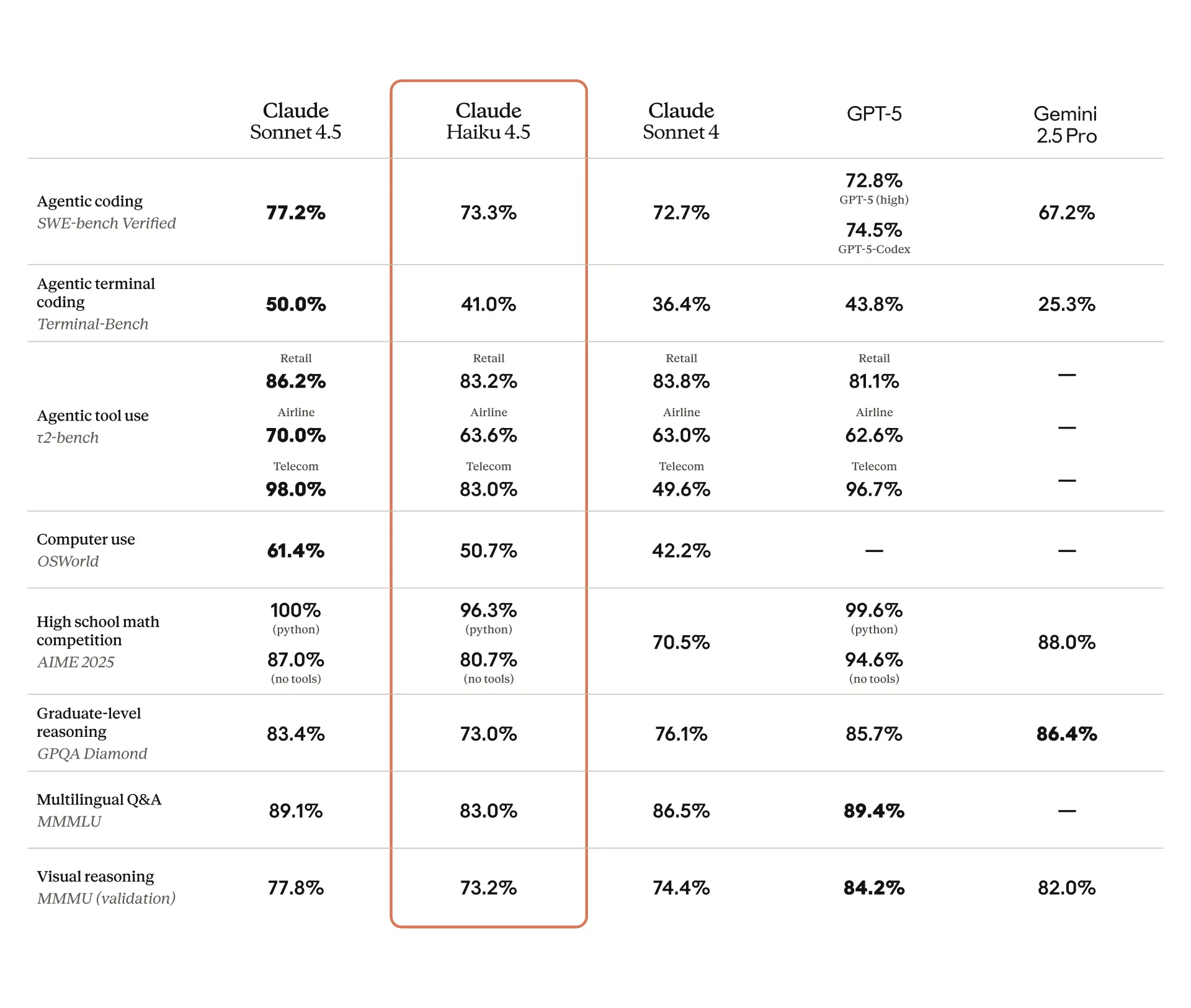

A Anthropic projetou o Claude Haiku 4.5 como um modelo compacto, porém inteligente, que prioriza velocidade e eficiência. Engenheiros apreciam como ele oferece desempenho próximo ao de ponta sem a sobrecarga de modelos maiores. Especificamente, o Claude Haiku 4.5 atinge proficiência em codificação comparável ao Claude Sonnet 4, mas opera com um terço do custo e mais que o dobro da velocidade. Essa otimização decorre de algoritmos refinados que reduzem as demandas computacionais, mantendo alta precisão.

Em transição de seu predecessor, o Claude Haiku 3.5, esta versão exibe alinhamento aprimorado e taxas reduzidas de comportamentos desalinhados em avaliações de segurança. Por exemplo, avaliações automatizadas revelam ocorrências estatisticamente menores de saídas preocupantes, tornando-o uma escolha mais segura para ambientes de produção. Além disso, o Claude Haiku 4.5 é classificado sob o Nível de Segurança de IA 2 (ASL-2), o que indica riscos mínimos em áreas como aplicações químicas, biológicas, radiológicas e nucleares (CBRN). Essa classificação permite uma implantação mais ampla em comparação com modelos ASL-3 como o Claude Sonnet 4.5.

As principais capacidades incluem processamento em tempo real para tarefas de baixa latência. Desenvolvedores o utilizam para assistentes de chat, agentes de atendimento ao cliente e cenários de programação em pares. Em tarefas de codificação, ele se destaca ao desmembrar problemas complexos, sugerir otimizações e depurar código em tempo real. Além disso, ele suporta sistemas multiagente onde um modelo coordenador como o Claude Sonnet 4.5 delega subtarefas para múltiplas instâncias do Claude Haiku 4.5 para execução paralela. Essa abordagem acelera fluxos de trabalho em prototipagem de software, análise de dados e aplicações interativas.

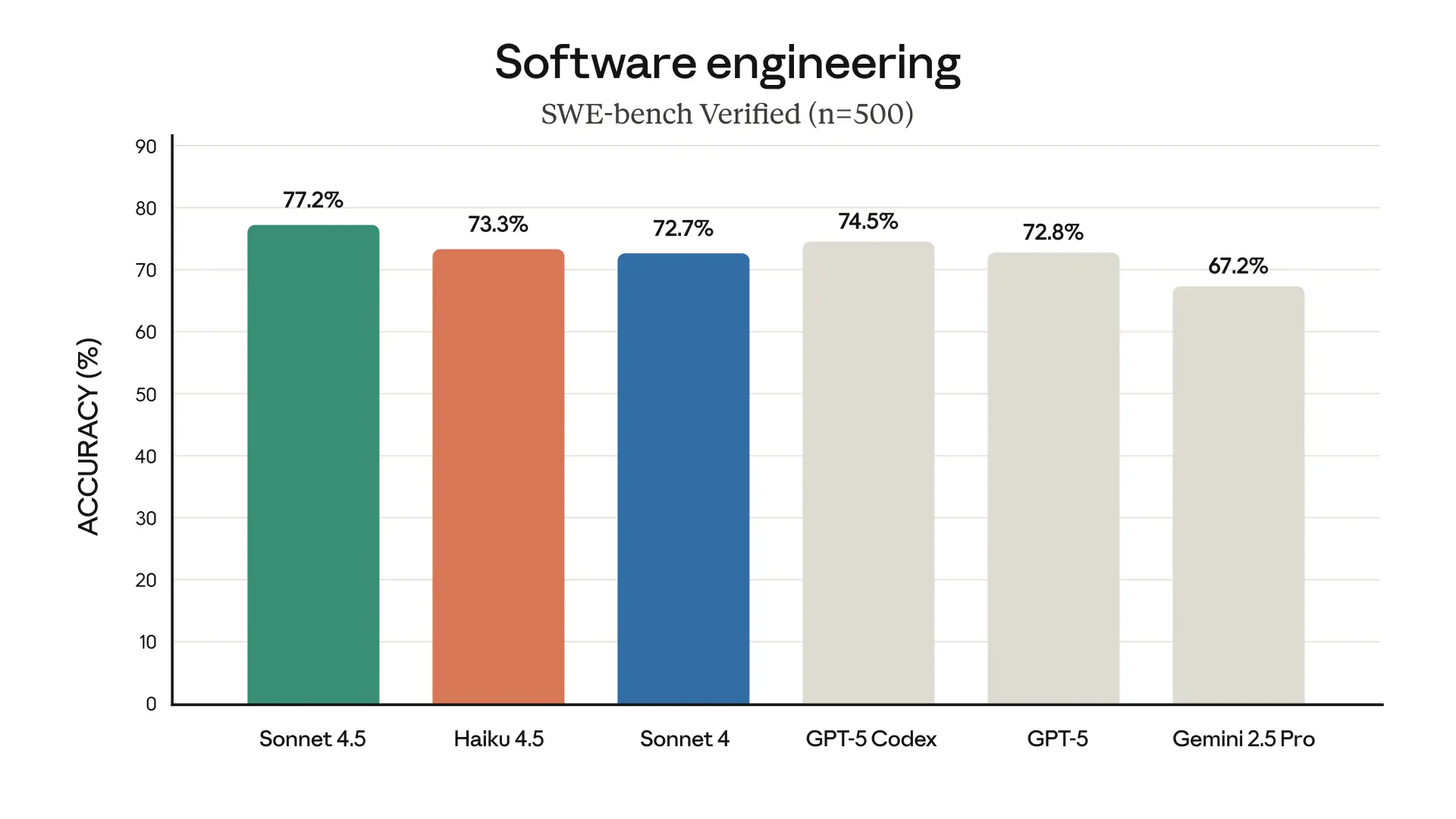

Benchmarks validam ainda mais suas forças. No SWE-bench Verified, o Claude Haiku 4.5 atinge 73,3%, uma média de 50 testes em um ambiente Dockerizado com um orçamento de pensamento de 128K. Ele emprega um andaime simples incluindo ferramentas bash e de edição de arquivos, incentivando o uso extensivo de ferramentas — frequentemente mais de 100 vezes por tarefa. Comparado a concorrentes como o GPT-5 da OpenAI, ele demonstra desempenho superior em depuração e implementação de recursos. Outras avaliações, como Terminal-Bench (média de 40,21% sem pensar e 41,75% com um orçamento de 32K) e OSWorld (com 100 passos máximos em quatro execuções), destacam sua confiabilidade em interações baseadas em agentes e sistemas operacionais.

Além disso, o Claude Haiku 4.5 se integra perfeitamente com plataformas como Amazon Bedrock e Vertex AI do Google Cloud. Desenvolvedores podem substituir modelos mais antigos como Haiku 3.5 ou Sonnet 4 diretamente, beneficiando-se de sua estrutura de preços econômica. Ao explorar esses recursos, considere como eles se alinham aos requisitos do seu projeto antes de avançar para os procedimentos de configuração.

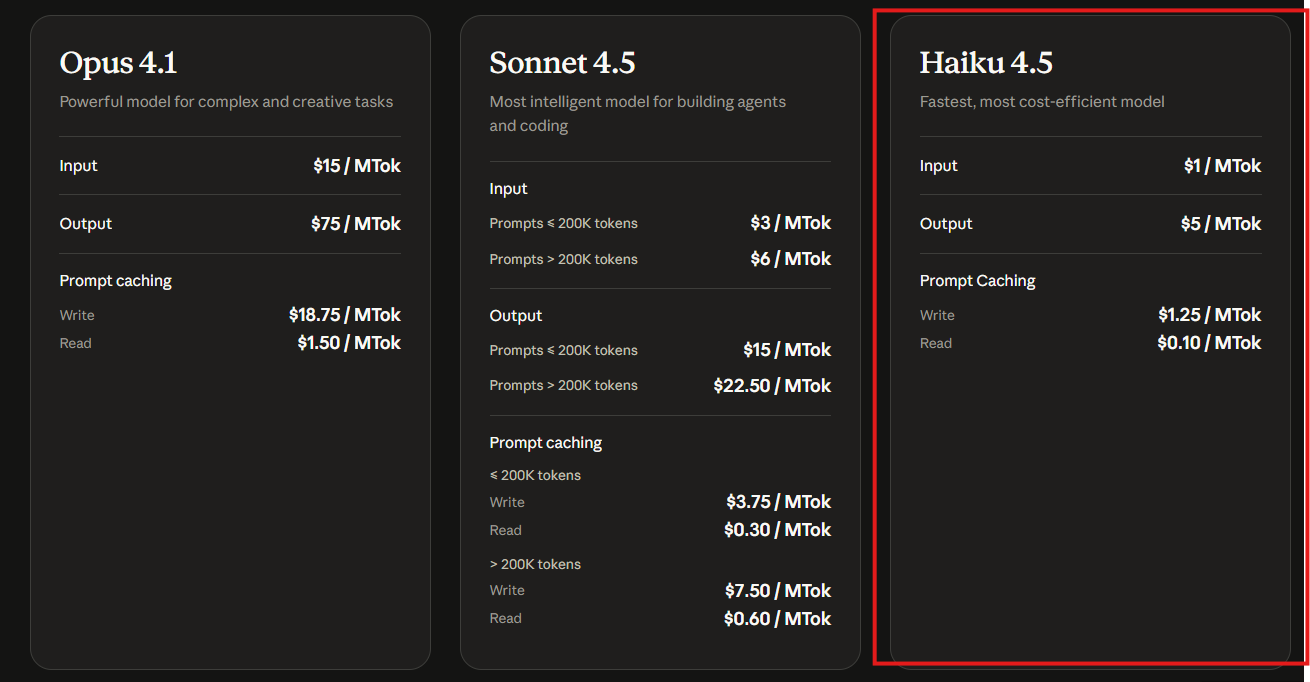

Detalhes de Preços para a API do Claude Haiku 4.5

A eficiência de custo é um aspecto crítico na adoção de qualquer modelo de IA. A Anthropic precifica o Claude Haiku 4.5 em US$ 1 por milhão de tokens de entrada e US$ 5 por milhão de tokens de saída. Essa estrutura o posiciona como a opção mais acessível na família Claude, permitindo uso de alto volume sem despesas excessivas. Para comparação, o Claude Haiku 3.5 custa US$ 0,80 por milhão de tokens de entrada e US$ 1,60 por milhão de tokens de saída, mas a versão mais recente oferece desempenho superior a uma taxa competitiva.

Recursos adicionais, como o cache de prompts, custam US$ 1,25 por milhão de tokens de escrita e US$ 0,10 por milhão de tokens de leitura, o que otimiza consultas repetidas em aplicações. Desenvolvedores que acessam o modelo através de plataformas de terceiros, como Amazon Bedrock ou Google Vertex AI, podem encontrar pequenas variações na cobrança com base nas taxas do provedor, mas as taxas base permanecem consistentes.

Organizações que escalam integrações de IA consideram essa precificação vantajosa para protótipos e produção. Por exemplo, em um bot de atendimento ao cliente que lida com milhares de interações diariamente, os custos de entrada mais baixos reduzem as despesas operacionais gerais. No entanto, monitore de perto o uso de tokens, pois tarefas complexas com orçamentos de pensamento extensos podem acumular cobranças. Ferramentas como o Apidog auxiliam na simulação e estimativa de custos durante as fases de teste, garantindo a adesão ao orçamento.

Com a precificação em mente, mude o foco para adquirir acesso e configurar seu ambiente para o uso da API do Claude Haiku 4.5.

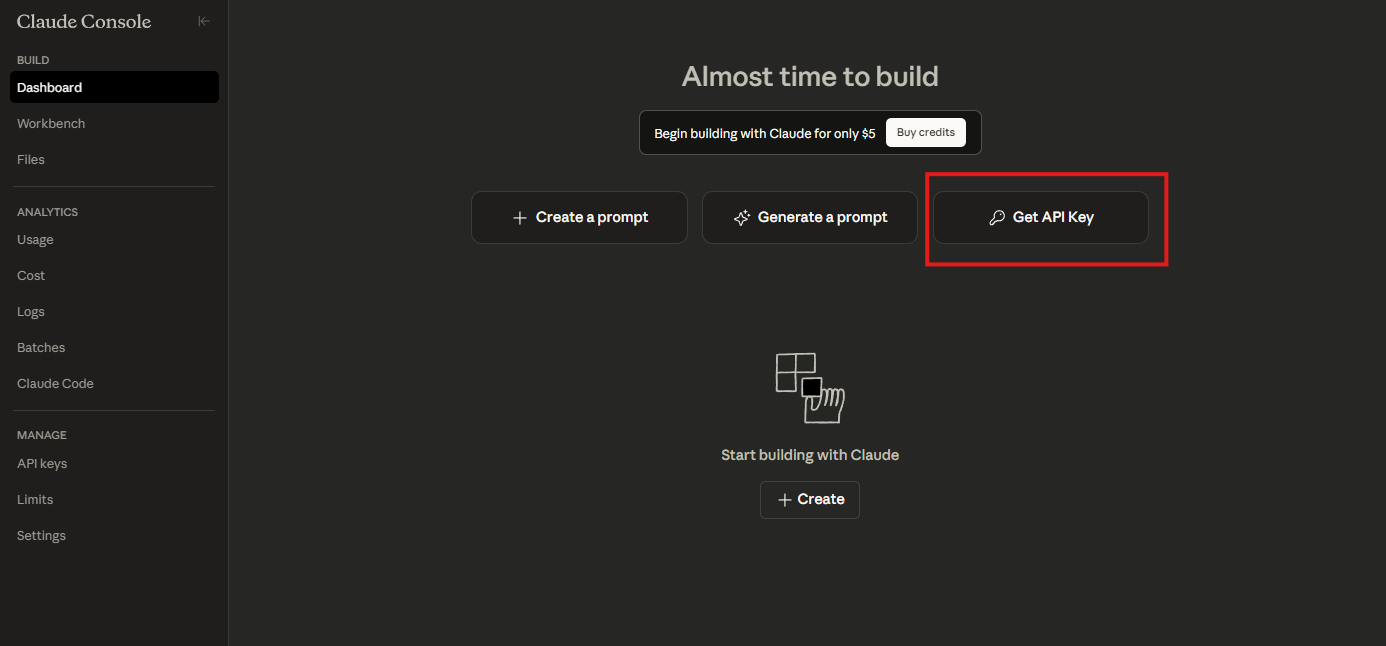

Configurando o Acesso à API do Claude Haiku 4.5

Para começar a trabalhar com o Claude Haiku 4.5, obtenha uma chave de API da Anthropic. Visite o console do desenvolvedor da Anthropic e crie uma conta, caso não tenha uma. Uma vez logado, gere uma nova chave de API na seção API. Armazene esta chave com segurança, pois ela autentica todas as requisições.

Em seguida, instale as bibliotecas necessárias. Para desenvolvedores Python, use o SDK oficial da Anthropic. Execute pip install anthropic em seu terminal. Este pacote simplifica as interações, lidando com autenticação, formatação de requisições e análise de respostas.

Configure seu ambiente definindo a chave de API como uma variável de ambiente: export ANTHROPIC_API_KEY='sua-chave-api-aqui'. Alternativamente, passe-a diretamente no código para fins de teste, embora evite isso em produção para prevenir exposição.

Para aqueles que usam o Amazon Bedrock, navegue até o console da AWS, habilite os modelos Anthropic e selecione Claude Haiku 4.5. O Bedrock oferece um serviço gerenciado, abstraindo o gerenciamento de infraestrutura. Da mesma forma, usuários do Google Vertex AI acessam-no através do Model Garden, onde você seleciona o modelo e integra via APIs REST ou SDKs.

Verifique a configuração com uma requisição de teste simples. Em Python, importe o cliente e envie uma mensagem básica:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

temperature=0.7,

messages=[

{"role": "user", "content": "Hello, Claude Haiku 4.5!"}

]

)

print(message.content)

Este código inicializa o cliente, especifica o modelo e processa uma mensagem do usuário. Espere uma resposta confirmando a operação do modelo. Se ocorrerem erros, verifique a validade da sua chave ou a conectividade da rede.

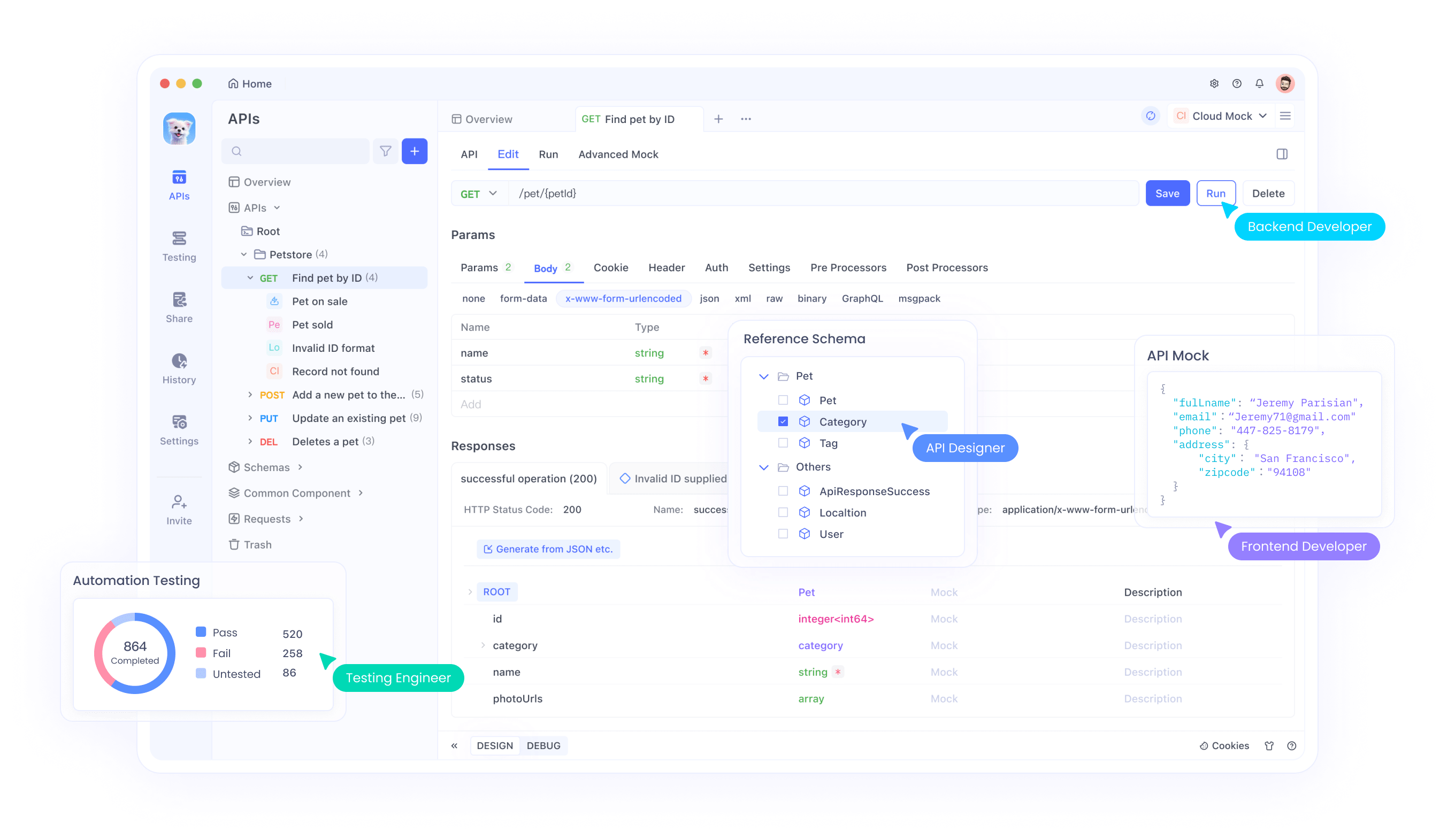

O Apidog aprimora essa configuração permitindo que você importe especificações OpenAPI para a API do Claude. Baixe o Apidog, crie um novo projeto e adicione o endpoint da Anthropic. Isso facilita a simulação de respostas para desenvolvimento offline, garantindo que sua integração prossiga sem problemas.

Uma vez configurado, prossiga para explorar as chamadas básicas da API e seus parâmetros.

Uso Básico da API do Claude Haiku 4.5

A API do Claude Haiku 4.5 se concentra no endpoint de mensagens, que lida com interações conversacionais. Desenvolvedores constroem requisições com uma lista de mensagens, cada uma contendo uma função (usuário ou assistente) e conteúdo. O modelo gera completudes com base neste contexto.

Controle a saída com parâmetros como max_tokens, que limita o comprimento da resposta para evitar geração excessiva. Defina temperature entre 0 e 1 para ajustar a aleatoriedade — valores mais baixos produzem saídas determinísticas adequadas para tarefas técnicas. Além disso, top_p influencia a diversidade ao amostrar da massa de probabilidade superior.

Para um exemplo de codificação, consulte o modelo para uma função Python:

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=500,

messages=[

{"role": "user", "content": "Write a Python function to calculate Fibonacci numbers recursively."}

]

)

print(message.content[0].text)

A resposta fornece o código da função, frequentemente com explicações. A velocidade do Claude Haiku 4.5 garante iterações rápidas, ideal para sessões de depuração.

Lide com erros de forma elegante. Problemas comuns incluem limites de taxa ou parâmetros inválidos. Implemente retentativas com backoff exponencial:

import time

def send_message_with_retry(client, params, max_retries=3):

for attempt in range(max_retries):

try:

return client.messages.create(**params)

except anthropic.APIError as e:

if attempt < max_retries - 1:

time.sleep(2 ** attempt)

else:

raise e

Esta função tenta a requisição várias vezes, aumentando os períodos de espera. Tais técnicas mantêm a confiabilidade em produção.

Com base nos fundamentos, integre o Apidog para testar essas chamadas. No Apidog, crie uma nova requisição de API, defina a URL para https://api.anthropic.com/v1/messages, adicione cabeçalhos como x-api-key com sua chave e defina o corpo JSON. Envie a requisição e inspecione as respostas, que o Apidog formata para fácil análise.

À medida que você domina interações simples, avance para cenários mais complexos envolvendo ferramentas e agentes.

Uso Avançado: Integração de Ferramentas e Sistemas Multiagente

O Claude Haiku 4.5 suporta a chamada de ferramentas, permitindo que o modelo interaja com funções externas. Defina ferramentas em sua requisição, e o modelo decide quando usá-las. Por exemplo, crie uma ferramenta para cálculos matemáticos:

tools = [

{

"name": "calculator",

"description": "Perform arithmetic operations",

"input_schema": {

"type": "object",

"properties": {

"expression": {"type": "string"}

},

"required": ["expression"]

}

}

]

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

tools=tools,

messages=[

{"role": "user", "content": "What is 15 * 23?"}

]

)

Se o modelo invocar a ferramenta, processe a entrada e forneça os resultados em mensagens subsequentes. Isso estende as capacidades além da geração de texto.

Em configurações multiagente, empregue o Claude Sonnet 4.5 para planejamento e o Claude Haiku 4.5 para execução. O coordenador divide as tarefas em subtarefas, despachando-as para instâncias do Haiku. Para desenvolvimento de software, um agente lida com a busca de dados, outro com o design da interface do usuário, tudo em paralelo.

Implemente isso com chamadas assíncronas:

import asyncio

async def execute_subtask(client, subtask):

return await asyncio.to_thread(client.messages.create,

model="claude-haiku-4-5",

max_tokens=500,

messages=[{"role": "user", "content": subtask}]

)

async def main():

subtasks = ["Fetch user data", "Design login page"]

results = await asyncio.gather(*(execute_subtask(client, task) for task in subtasks))

# Aggregate results

Este código executa subtarefas concorrentemente, aproveitando a velocidade do Haiku.

Para testar tais sistemas, os servidores de mock do Apidog simulam respostas de ferramentas, permitindo validação offline. Configure os mocks para retornar saídas esperadas, refinando seus agentes antes da implantação em produção.

Além disso, otimize para pensamento estendido alocando orçamentos de até 128K tokens. Em benchmarks, isso aprimora o desempenho em problemas complexos como AIME (média de 10 execuções) ou MMMLU em diferentes idiomas.

Transitando para aplicações práticas, examine casos de uso do mundo real onde esses recursos se destacam.

Casos de Uso para a API do Claude Haiku 4.5

Organizações aplicam o Claude Haiku 4.5 em diversos cenários. No atendimento ao cliente, ele alimenta bots que respondem instantaneamente a consultas, reduzindo tempos de espera. Por exemplo, integre-o a uma plataforma de mensagens:

# Pseudocódigo para integração de bot

def handle_message(user_input):

response = client.messages.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": user_input}]

)

return response.content[0].text

Essa configuração escala para lidar com alto tráfego de forma eficiente.

Em ambientes de codificação como GitHub Copilot ou Cursor, o Claude Haiku 4.5 fornece sugestões via API. Desenvolvedores o habilitam em prévias públicas, inserindo chaves para acesso.

Para automação de navegador, suas capacidades de uso de computador superam as dos predecessores. Crie extensões onde o modelo navega por páginas, extrai dados ou automatiza formulários.

Plataformas educacionais o utilizam para tutoria interativa, gerando explicações e questionários sob demanda. Analistas de dados o empregam para geração de consultas contra bancos de dados, combinando linguagem natural com ferramentas SQL.

Em cada caso, o Apidog facilita os testes automatizando cenários, garantindo robustez. Por exemplo, crie conjuntos de testes que verifiquem os tempos de resposta sob carga.

Ao implementar isso, adira às melhores práticas para maximizar a eficiência.

Melhores Práticas e Técnicas de Otimização

Mantenha a consistência do contexto gerenciando os históricos de mensagens de forma eficaz. Limite as conversas a trocas essenciais para evitar o desperdício de tokens.

Monitore as métricas de uso através do painel da Anthropic, ajustando parâmetros para equilibrar custo e qualidade. Para aplicações de alto rendimento, agrupe requisições sempre que possível.

Proteja suas integrações rotacionando chaves de API regularmente e usando princípios de menor privilégio. Implemente o registro (logging) para rastrear anomalias.

Aproveite o cache para prompts frequentes, reduzindo computações redundantes. No código:

cache = {} # Simple in-memory cache

def cached_message(client, prompt):

if prompt in cache:

return cache[prompt]

response = client.messages.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": prompt}]

)

cache[prompt] = response

return response

Isso armazena os resultados para reutilização.

Ao testar com o Apidog, defina asserções para as respostas, como verificar palavras-chave específicas ou códigos de status.

Além disso, experimente com parâmetros de amostragem. As configurações padrão funcionam bem, mas ajuste a temperatura para tarefas criativas ou `top_p` para saídas focadas.

Aborde possíveis armadilhas, como a dependência excessiva de ferramentas, solicitando ao modelo que pense passo a passo.

Ao seguir estas práticas, você garante implantações confiáveis e escaláveis.

Integrando o Apidog para Testes de API Aprimorados

O Apidog se destaca como uma plataforma abrangente para desenvolvimento e teste de API, particularmente útil com o Claude Haiku 4.5. Ele suporta a importação de especificações, geração de casos de teste e simulação de endpoints.

Para integrar, instale o Apidog e crie um projeto. Adicione o endpoint da API do Claude, autentique com sua chave e defina as requisições. Os recursos de IA do Apidog podem até gerar casos de teste a partir das especificações.

Para o Claude Haiku 4.5, teste aplicações sensíveis à latência simulando respostas em tempo real. Use suas ferramentas de depuração para inspecionar payloads JSON e identificar problemas.

Em cenários multiagente, o Apidog encadeia requisições, mimetizando orquestrações.

Essa integração não apenas acelera o desenvolvimento, mas também garante a conformidade com as melhores práticas.

Considerações de Segurança e Ética

A Anthropic enfatiza a segurança no Claude Haiku 4.5, com baixas taxas de comportamento desalinhado. Desenvolvedores ainda devem implementar salvaguardas, como filtros de conteúdo para entradas de usuário.

Cumpra as regulamentações de privacidade de dados, evitando informações sensíveis em prompts.

Eticamente, use o modelo de forma transparente, informando os usuários sobre o envolvimento da IA.

Essas medidas promovem a adoção responsável.

Solução de Problemas Comuns

Encontrou limites de taxa? Implemente backoffs conforme mostrado anteriormente.

Respostas inválidas? Ajuste max_tokens ou refine os prompts.

Falhas de autenticação? Verifique o formato e as permissões da chave.

O Apidog auxilia registrando interações completas para análise.

Desenvolvimentos Futuros e Atualizações

A Anthropic continua a evoluir a linha Claude. Monitore os anúncios para melhorias no Haiku 4.5, como suporte multimodal.

Integre as atualizações de forma contínua, pois a API mantém a compatibilidade retroativa.

Conclusão

A API do Claude Haiku 4.5 oferece aos desenvolvedores uma ferramenta versátil para construir aplicações inteligentes e eficientes. Ao seguir este guia, você se equipa para aproveitar todo o seu potencial, desde configurações básicas até integrações avançadas. Lembre-se, ferramentas como o Apidog amplificam seus esforços, fornecendo recursos gratuitos para testar e refinar.

À medida que a tecnologia avança, pequenas eficiências se acumulam em vantagens significativas. Aplique esses insights em seus projetos e observe o impacto.