No mundo das aplicações impulsionadas por IA, a API Claude da Anthropic tornou-se uma solução popular para muitos desenvolvedores que buscam capacidades avançadas de processamento de linguagem. No entanto, como acontece com qualquer serviço popular, é provável que você encontre limites de taxa que podem interromper temporariamente a funcionalidade da sua aplicação. Compreender esses limites e implementar estratégias para trabalhar dentro deles é crucial para manter uma experiência suave para o usuário.

No desenvolvimento de IA, Claude emergiu como um assistente poderoso tanto para usuários casuais quanto para desenvolvedores. No entanto, muitos usuários enfrentam uma frustração comum: os limites de taxa.

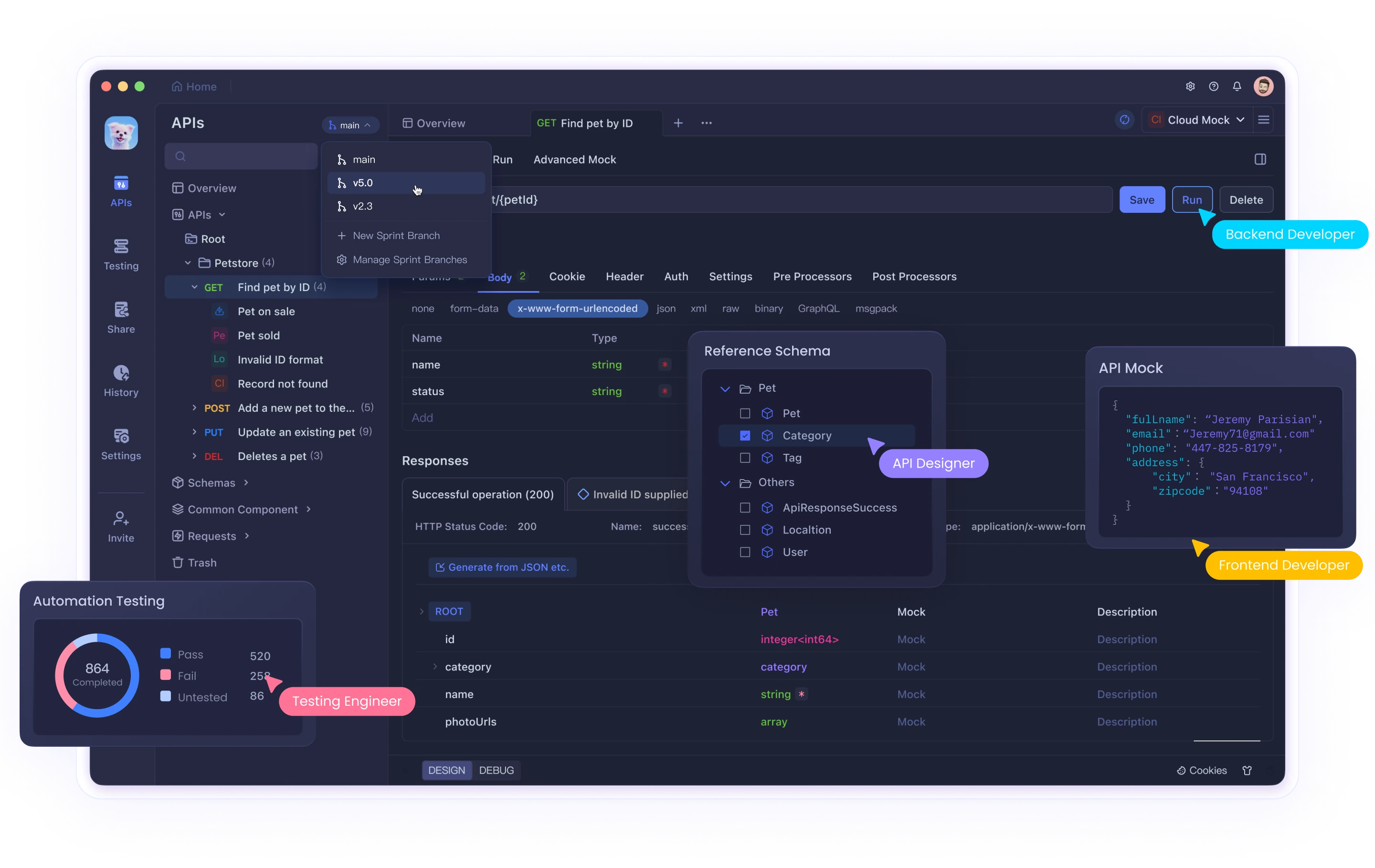

Seja usando a interface web do Claude ou integrando com sua API através de ferramentas como Cursor ou Cline, atingir esses limites pode interromper seu fluxo de trabalho e produtividade. Enquanto ferramentas como Claude fornecem capacidades poderosas de IA, gerenciar efetivamente as interações da API requer ferramentas adequadas de teste e depuração. Apidog ajuda os desenvolvedores a navegar por essas complexidades ao trabalhar com IA e outras APIs.

Este guia abrangente explorará por que os limites de taxa da API Claude existem, como identificar quando você os atinge e fornecerá três soluções detalhadas para ajudá-lo a superar esses desafios de forma eficaz.

Quais São os Limites de Taxa da API Claude e Por Que Existem?

Limites de taxa são restrições impostas pelos provedores de API para controlar o volume de requisições que um usuário pode fazer em um determinado período de tempo. A Anthropic implementa esses limites por várias razões importantes:

- Gerenciamento de Recursos do Servidor: Impedir que um único usuário consuma muitos recursos computacionais

- Acesso Equitativo: Garantir a distribuição justa do acesso à API entre todos os usuários

- Prevenção de Abuso: Proteger contra atividades maliciosas como scraping ou ataques DDoS

- Estabilidade do Serviço: Manter a performance geral do sistema durante os períodos de pico de uso

Limites Específicos de Taxa da API Claude

Os limites de taxa do Claude variam com base no tipo da sua conta:

- Usuários Gratuitos: Aproximadamente 100 mensagens por dia, com a quota sendo redefinida à meia-noite

- Usuários Pro: Aproximadamente cinco vezes o limite dos usuários gratuitos (aproximadamente 500 mensagens diárias)

- Usuários da API: Limites personalizados com base no seu plano específico e acordos com a Anthropic

Além disso, durante períodos de pico de uso, esses limites podem ser aplicados de forma mais rigorosa, e você pode experimentar redução temporária da taxa mesmo antes de atingir sua alocação máxima.

Identificando Problemas de Limite de Taxa

Você provavelmente atingiu um limite de taxa quando sua aplicação recebe um 429 Too Many Requests código de status HTTP. A resposta normalmente inclui cabeçalhos com informações sobre:

- Quando você pode retomar suas requisições

- Suas estatísticas de uso atuais

- Informações sobre a quota restante

Solução 1: Implementar Limite de Taxa Correto no Seu Código

A abordagem mais fundamental para lidar com limites de taxa da API é implementar limites de taxa do lado do cliente. Isso previne proativamente que sua aplicação exceda o volume de requisições permitido.

Usando um Algoritmo de Balde de Tokens

O balde de tokens é um algoritmo popular para limite de taxa que funciona da seguinte maneira:

- Manter um "balde" que se enche com tokens a uma taxa constante

- Consumir um token para cada requisição da API

- Bloquear requisições quando não houver tokens disponíveis

Aqui está uma implementação em Python:

import time

import threading

class TokenBucket:

def __init__(self, tokens_per_second, max_tokens):

self.tokens_per_second = tokens_per_second

self.max_tokens = max_tokens

self.tokens = max_tokens

self.last_refill = time.time()

self.lock = threading.Lock()

def _refill_tokens(self):

now = time.time()

elapsed = now - self.last_refill

new_tokens = elapsed * self.tokens_per_second

self.tokens = min(self.max_tokens, self.tokens + new_tokens)

self.last_refill = now

def get_token(self):

with self.lock:

self._refill_tokens()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def wait_for_token(self, timeout=None):

start_time = time.time()

while True:

if self.get_token():

return True

if timeout is not None and time.time() - start_time > timeout:

return False

time.sleep(0.1) # Sleep to avoid busy waiting

# Exemplo de uso com a API Claude

import anthropic

# Criar um limitador de taxa (5 requisições por segundo, burst máximo de 10)

rate_limiter = TokenBucket(tokens_per_second=5, max_tokens=10)

client = anthropic.Anthropic(api_key="sua_chave_api")

def generate_with_claude(prompt):

# Esperar por um token ficar disponível

if not rate_limiter.wait_for_token(timeout=30):

raise Exception("Tempo de espera excedido aguardando o token de limite de taxa")

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

print("Limite de taxa atingido apesar do nosso limite de taxa! Aguardando...")

time.sleep(10) # Aguardo adicional

return generate_with_claude(prompt) # Tentativa

raise

Esta implementação:

- Criou um balde de tokens que se reabastece a uma taxa constante

- Esperou tokens ficarem disponíveis antes de fazer requisições

- Implementou uma espera adicional caso limites de taxa ainda sejam encontrados

Lidando com Respostas 429 com Retorno Exponencial

Mesmo com um limite de taxa proativo, você pode ocasionalmente atingir limites. Implementar um retorno exponencial ajuda sua aplicação a se recuperar de forma elegante:

import time

import random

def call_claude_api_with_backoff(prompt, max_retries=5, base_delay=1):

retries = 0

while retries <= max_retries:

try:

# Esperar pelo token do limitador de taxa

rate_limiter.wait_for_token()

# Fazer a chamada da API

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e) and retries < max_retries:

# Calcular atraso com retorno exponencial e jitter

delay = base_delay * (2 ** retries) + random.uniform(0, 0.5)

print(f"Limite de taxa. Tentando novamente em {delay:.2f} segundos...")

time.sleep(delay)

retries += 1

else:

raise

raise Exception("Número máximo de tentativas excedido")

Essa função:

- Tenta fazer a chamada da API

- Se ocorrer um erro 429, espera um tempo exponencialmente crescente

- Adiciona jitter aleatório para evitar sincronização de requisições

Solução 2: Implementar Cola de Requisições e Priorização

Para aplicações com níveis variados de importância das requisições, implementar uma fila de requisições com tratamento de prioridade pode otimizar seu uso da API.

Construindo um Sistema de Fila de Prioridade

import heapq

import threading

import time

from dataclasses import dataclass, field

from typing import Any, Callable, Optional

@dataclass(order=True)

class PrioritizedRequest:

priority: int

execute_time: float = field(compare=False)

callback: Callable = field(compare=False)

args: tuple = field(default_factory=tuple, compare=False)

kwargs: dict = field(default_factory=dict, compare=False)

class ClaudeRequestQueue:

def __init__(self, requests_per_minute=60):

self.queue = []

self.lock = threading.Lock()

self.processing = False

self.requests_per_minute = requests_per_minute

self.interval = 60 / requests_per_minute

def add_request(self, callback, priority=0, delay=0, *args, **kwargs):

"""Adicionar uma requisição à fila com a prioridade dada."""

with self.lock:

execute_time = time.time() + delay

request = PrioritizedRequest(

priority=-priority, # Negar para que valores maiores tenham maior prioridade

execute_time=execute_time,

callback=callback,

args=args,

kwargs=kwargs

)

heapq.heappush(self.queue, request)

if not self.processing:

self.processing = True

threading.Thread(target=self._process_queue, daemon=True).start()

def _process_queue(self):

"""Processar requisições da fila, respeitando os limites de taxa."""

while True:

with self.lock:

if not self.queue:

self.processing = False

return

# Obter a requisição de maior prioridade que está pronta para executar

request = self.queue[0]

now = time.time()

if request.execute_time > now:

# Esperar até que a requisição esteja pronta

wait_time = request.execute_time - now

time.sleep(wait_time)

continue

# Remover a requisição da fila

heapq.heappop(self.queue)

# Executar a requisição fora do bloqueio

try:

request.callback(*request.args, **request.kwargs)

except Exception as e:

print(f"Erro ao executar a requisição: {e}")

# Aguardar o intervalo do limite de taxa

time.sleep(self.interval)

# Exemplo de uso

queue = ClaudeRequestQueue(requests_per_minute=60)

def process_result(result, callback):

print(f"Recebido resultado: {result[:50]}...")

if callback:

callback(result)

def make_claude_request(prompt, callback=None, priority=0):

def execute():

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

process_result(response.content, callback)

except Exception as e:

if "429" in str(e):

# Re-colocar na fila com um atraso se estiver com limite de taxa

print("Limite de taxa, re-colocando na fila...")

queue.add_request(

make_claude_request,

priority=priority-1, # Prioridade menor para tentativas

delay=10, # Esperar 10 segundos antes de tentar novamente

prompt=prompt,

callback=callback,

priority=priority

)

else:

print(f"Erro: {e}")

queue.add_request(execute, priority=priority)

# Fazer algumas requisições com prioridades diferentes

make_claude_request("Pergunta de alta prioridade", priority=10)

make_claude_request("Pergunta de prioridade média", priority=5)

make_claude_request("Pergunta de baixa prioridade", priority=1)

Esta implementação:

- Criou uma fila de prioridade para requisições da API

- Processou requisições com base na prioridade e tempo de execução programado

- Limitou automaticamente as requisições para manter-se dentro dos limites de taxa

- Tratou repetições com prioridade decrescente

Solução 3: Distribuir Requisições em Múltiplas Instâncias

Para aplicações de alto volume, distribuir as requisições da API Claude entre várias instâncias pode ajudá-lo a escalar além dos limites de uma única conta.

Balanceamento de Carga Entre Múltiplas Chaves de API

import random

import threading

from datetime import datetime, timedelta

class APIKeyManager:

def __init__(self, api_keys, requests_per_day_per_key):

self.api_keys = {}

self.lock = threading.Lock()

# Inicializar o rastreamento de uso de cada chave API

for key in api_keys:

self.api_keys[key] = {

'key': key,

'daily_limit': requests_per_day_per_key,

'used_today': 0,

'last_reset': datetime.now().date(),

'available': True

}

def _reset_daily_counters(self):

"""Reiniciar os contadores diários se for um novo dia."""

today = datetime.now().date()

for key_info in self.api_keys.values():

if key_info['last_reset'] < today:

key_info['used_today'] = 0

key_info['last_reset'] = today

key_info['available'] = True

def get_available_key(self):

"""Obter uma chave API disponível que não excedeu seu limite diário."""

with self.lock:

self._reset_daily_counters()

available_keys = [

key_info for key_info in self.api_keys.values()

if key_info['available'] and key_info['used_today'] < key_info['daily_limit']

]

if not available_keys:

return None

# Escolher uma chave com o menor número de requisições usadas hoje

selected_key = min(available_keys, key=lambda k: k['used_today'])

selected_key['used_today'] += 1

# Se a chave atingiu seu limite, marcar como indisponível

if selected_key['used_today'] >= selected_key['daily_limit']:

selected_key['available'] = False

return selected_key['key']

def mark_key_used(self, api_key):

"""Marcar que uma requisição foi feita com esta chave."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['used_today'] += 1

if self.api_keys[api_key]['used_today'] >= self.api_keys[api_key]['daily_limit']:

self.api_keys[api_key]['available'] = False

def mark_key_rate_limited(self, api_key, retry_after=60):

"""Marcar uma chave como temporariamente indisponível devido a limite de taxa."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = False

# Iniciar um temporizador para marcar a chave disponível novamente após o período de espera

def make_available_again():

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = True

timer = threading.Timer(retry_after, make_available_again)

timer.daemon = True

timer.start()

# Exemplo de uso

api_keys = [

"key1_abc123",

"key2_def456",

"key3_ghi789"

]

key_manager = APIKeyManager(api_keys, requests_per_day_per_key=100)

def call_claude_api_distributed(prompt):

api_key = key_manager.get_available_key()

if not api_key:

raise Exception("Sem chaves de API disponíveis - todas atingiram seus limites diários")

client = anthropic.Anthropic(api_key=api_key)

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

# Analisar cabeçalho retry-after se disponível, senão usar o padrão

retry_after = 60 # Padrão

key_manager.mark_key_rate_limited(api_key, retry_after)

# Tentar novamente recursivamente com uma chave diferente

return call_claude_api_distributed(prompt)

else:

raise

Essa abordagem:

- Gerencia múltiplas chaves de API e rastreia seu uso

- Distribui requisições para ficar dentro dos limites de taxa por chave

- Trata respostas de limite de taxa ao remover temporariamente as chaves afetadas da rotação

- Reinicia automaticamente os contadores de uso diariamente

Melhores Práticas para Gerenciar Limites de Taxa da API Claude

Além das três soluções acima, aqui estão algumas melhores práticas adicionais:

Monitore Seu Uso Proativamente

- Implemente painéis para rastrear seu uso da API

- Configure alertas para quando você se aproximar dos limites de taxa

- Revise regularmente padrões de uso para identificar oportunidades de otimização

Implemente Degradação Graciosa

- Projete sua aplicação para fornecer respostas alternativas quando estiver com limite de taxa

- Considere armazenar em cache respostas anteriores para consultas similares

- Forneça feedback transparente aos usuários ao enfrentar limites de taxa

Otimize Seus Prompts

- Reduza chamadas desnecessárias à API elaborando prompts mais eficazes

- Combine consultas relacionadas em uma única requisição quando possível

- Pré-processar entradas para eliminar a necessidade de requisições de esclarecimento

Comunique-se com a Anthropic

- Para aplicações em produção, considere fazer upgrade para planos de nível superior

- Entre em contato com a Anthropic sobre limites de taxa personalizados para seu caso de uso específico

- Mantenha-se informado sobre atualizações da plataforma e mudanças nas políticas de limites de taxa

Conclusão

Limites de taxa são uma parte inevitável do trabalho com qualquer API poderosa como a Claude. Ao implementar as soluções descritas neste artigo—código de limite de taxa apropriado, enfileiramento de requisições e manuseio distribuído de requisições—você pode construir aplicações robustas que lidam elegantemente com essas limitações.

Lembre-se de que os limites de taxa existem para garantir acesso justo e estabilidade do sistema para todos os usuários. Trabalhar dentro dessas restrições não apenas melhora a confiabilidade da sua aplicação, mas também contribui para a saúde geral do ecossistema.

Com planejamento cuidadoso e implementação dessas estratégias, você pode maximizar o uso das poderosas capacidades de IA do Claude enquanto mantém uma experiência suave para seus usuários, mesmo à medida que sua aplicação escala.