MetaStone AIが2025年8月1日にリリースしたXBai o4は、第4世代のオープンソース言語モデルであり、複雑な推論タスクにおいてOpenAI-o3-miniを上回る性能を発揮します。この中国で開発されたモデルは、高度なトレーニング技術と最適化された推論を導入し、AI開発において画期的な存在となっています。GitHubとHugging Faceで利用可能なXBai o4は、透明性と協業を促進します。

XBai o4の台頭:技術概要

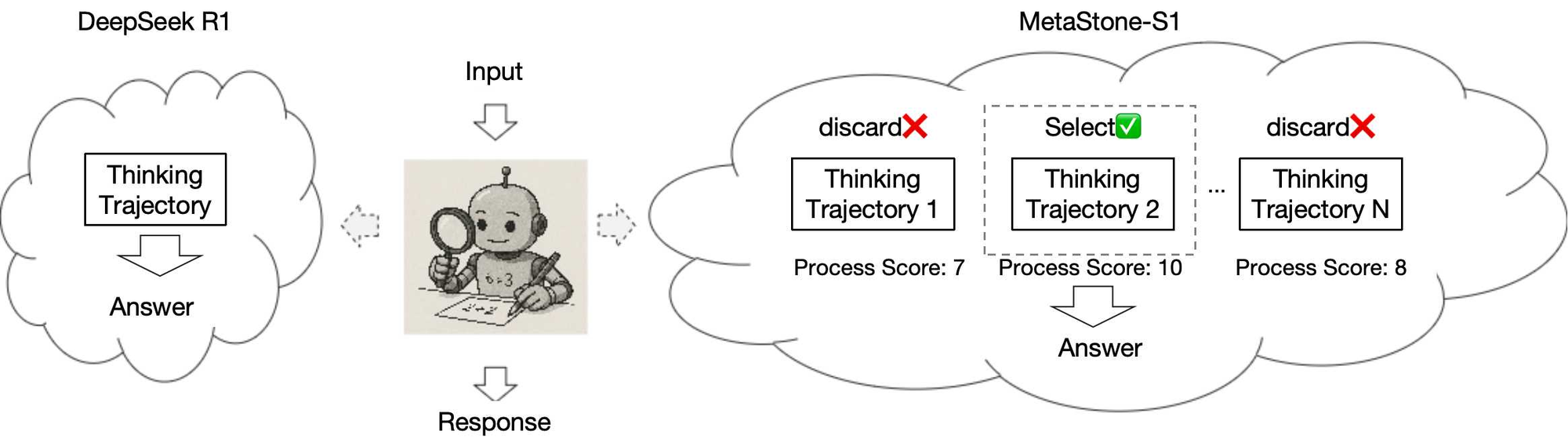

XBai o4はMetaStone AIによって開発され、オープンソースAI技術における飛躍的な進歩を象徴しています。プロプライエタリモデルとは異なり、XBai o4のコードベースとウェイトはGitHubとHugging Faceで公開されており、透明性と協業を促進しています。具体的には、このモデルは「反射的生成形式」と呼ばれる画期的なトレーニングアプローチを活用しており、Long-CoT強化学習とプロセス報酬学習を統合しています。その結果、この統合されたフレームワークにより、XBai o4は深い推論と高品質な推論軌跡の選択において優れており、OpenAI-o3-miniのような前身や競合他社とは一線を画しています。

さらに、XBai o4はポリシー報酬モデル(PRM)とポリシーモデルの間でバックボーンネットワークを共有することで、推論効率を最適化しています。このアーキテクチャの選択により、PRMの推論コストが驚異的な99%削減され、応答時間の短縮と高品質な出力が実現しています。例えば、モデルのパラメータは2つの異なるファイルに保存されます。ポリシーモデルのチェックポイント用のmodel.safetensorsと、Hugging Faceリポジトリで詳細に説明されているSPRMヘッド用の別のファイルです。

反射的生成形式の理解

XBai o4の成功の基礎は、その反射的生成形式にあります。このトレーニングパラダイムは、2つの高度な技術を組み合わせています。

- Long-CoT強化学習:この手法は、Chain-of-Thought(CoT)プロンプティングを拡張し、強化学習を組み込むことで、拡張されたコンテキスト全体でモデルの推論プロセスを洗練します。その結果、XBai o4は複雑な多段階の問題をより高い精度で解決できます。

- プロセス報酬学習:このアプローチは、トレーニング中に高品質な推論軌跡を選択したモデルに報酬を与えます。その結果、XBai o4は最適な推論パスを優先することを学習し、微妙な意思決定を必要とするタスクでのパフォーマンスを向上させます。

これらの手法を統合することで、XBai o4は深い推論と計算効率のバランスを実現しています。さらに、共有されたバックボーンネットワークは冗長性を最小限に抑え、品質を犠牲にすることなく、モデルが入力データをより速く処理できるようにします。このイノベーションは、効率的でありながら同レベルのオープンソースのアクセシビリティと最適化された推論能力を欠いているOpenAI-o3-miniと比較すると、特に重要です。

XBai o4とOpenAI-o3-miniの比較

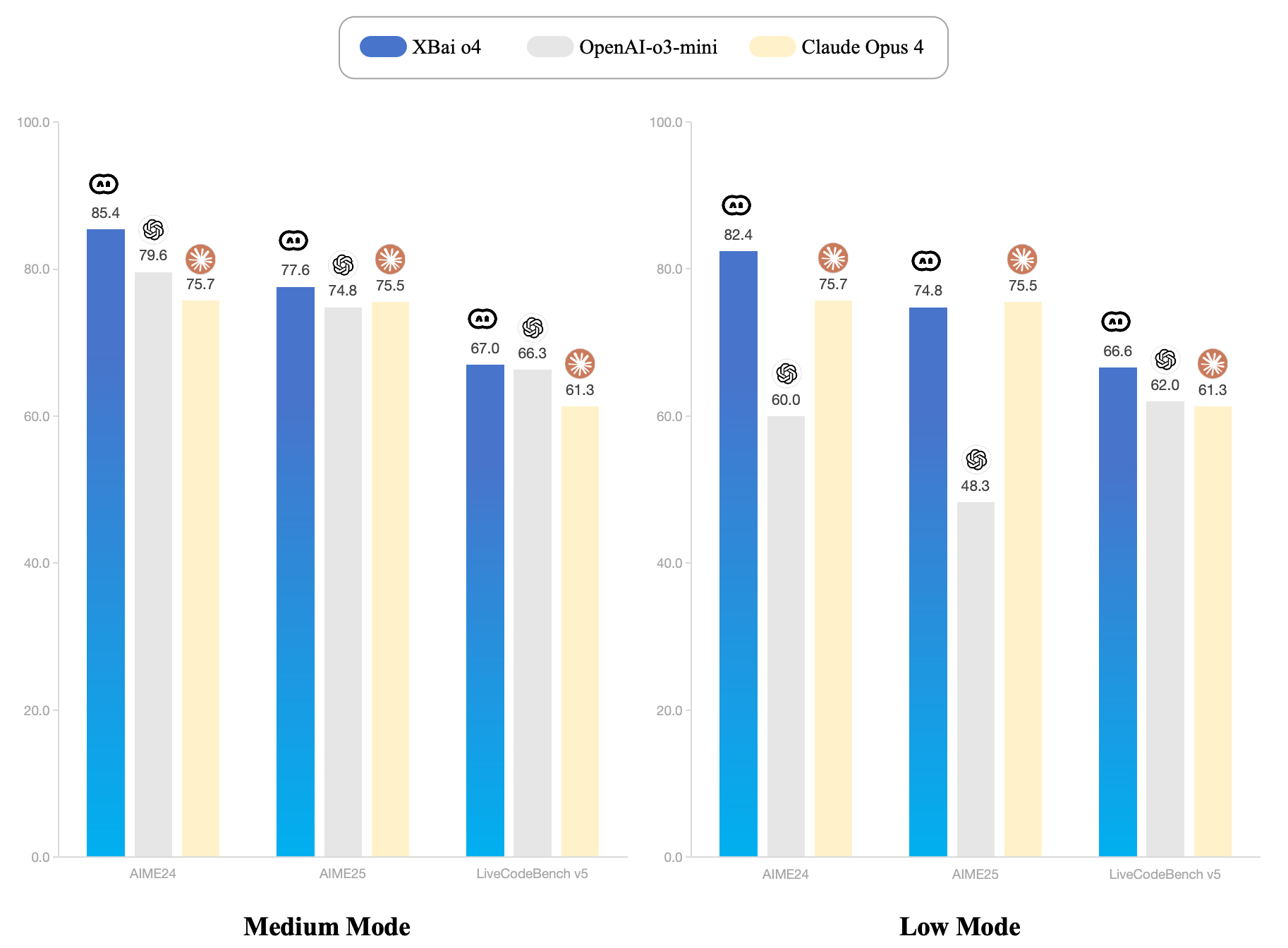

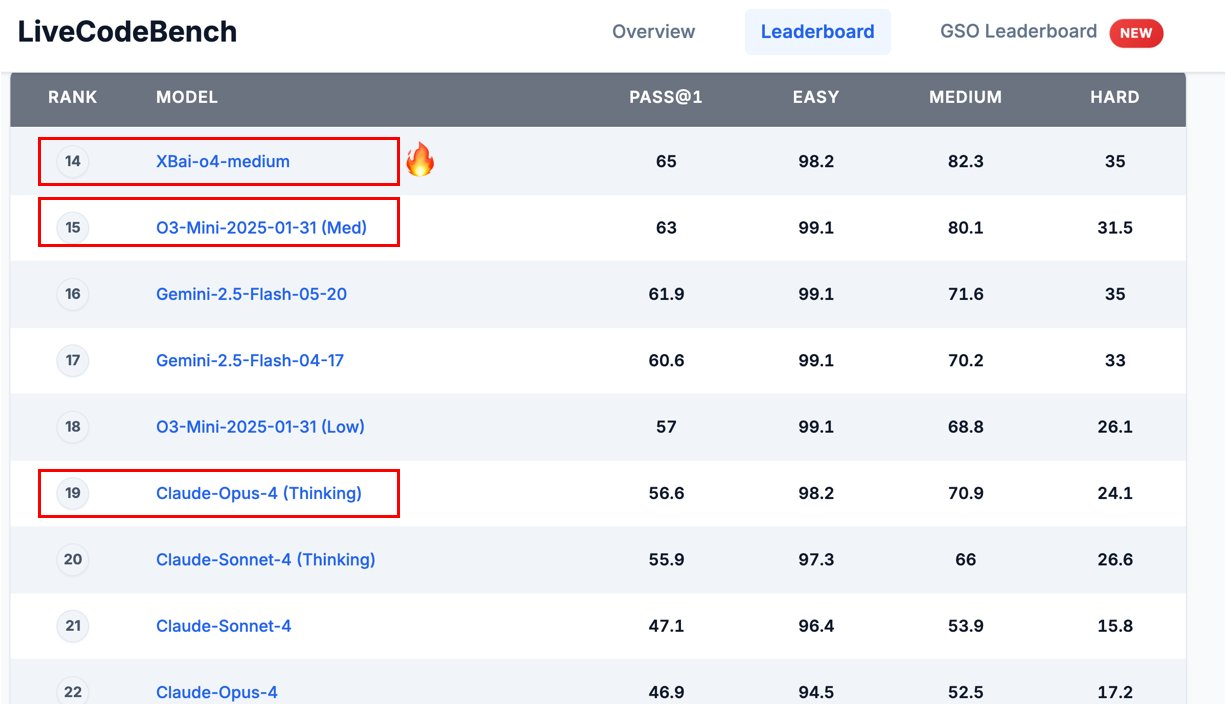

OpenAI-o3-miniは、OpenAIの広範なo3シリーズのコンパクトバージョンであり、中程度の複雑さのタスクにおける効率のために設計されています。しかし、MetaStone AIのGitHub発表によると、XBai o4はMediumモードでOpenAI-o3-miniを「完全に凌駕する」と主張しています。

この主張を理解するために、主要なパフォーマンス指標を検証しましょう。

- 複雑な推論:XBai o4の反射的生成形式により、数学ベンチマーク(例:AIME24)のような複雑な推論タスクを優れた精度で処理できます。対照的に、OpenAI-o3-miniは有能ではあるものの、拡張された推論チェーンを必要とするタスクに苦戦します。

- 推論速度:PRMの推論コストを99%削減することで、XBai o4はより速い応答を提供し、リアルタイムアプリケーションに最適です。OpenAI-o3-miniは速度のために最適化されていますが、オープンソースのコンテキストではこのレベルの効率には及びません。

- オープンソースのアクセシビリティ:XBai o4がGitHubやHugging Faceのようなプラットフォームで利用可能であるため、開発者はモデルを自由にカスタマイズしてデプロイできます。一方、OpenAI-o3-miniはプロプライエタリのままであり、研究開発への適応性を制限しています。

例えば、MetaStone AIのGitHubリポジトリで概説されている数学ベンチマークのテストパイプラインは、AIME24のようなタスクを高い精度で処理するXBai o4の能力を示しています。このパイプラインは、score_model_queue.pyやpolicy_model_queue.pyのようなスクリプトを使用してパフォーマンスを評価し、最適化されたアテンションメカニズムのためにXFORMERSのようなツールを活用しています。

XBai o4の技術的な実装

XBai o4をデプロイするには、GitHubリポジトリで概説されているように、堅牢なセットアップが必要です。以下は、提供された指示に基づいた簡略化されたセットアップガイドです。

環境設定:

- Python 3.10でConda環境を作成します:

conda create -n xbai_o4 python==3.10。 - 環境をアクティブ化します:

conda activate xbai_o4。 - 依存関係をインストールします:

pip install -e verl、pip install -r requirements.txt、およびpip install flash_attn==2.7.4.post1。

トレーニングと評価:

- 分散コンピューティングのためにRayを開始します:

bash ./verl/examples/ray/run_worker_n.sh。 - マルチノードトレーニングを開始します:

bash ./scripts/run_multi_node.sh。 - 数学ベンチマークのテストパイプラインを実行します:

python test/inference.py --task 'aime24' --input_file data/aime24.jsonl --output_file path/to/result。

API統合:

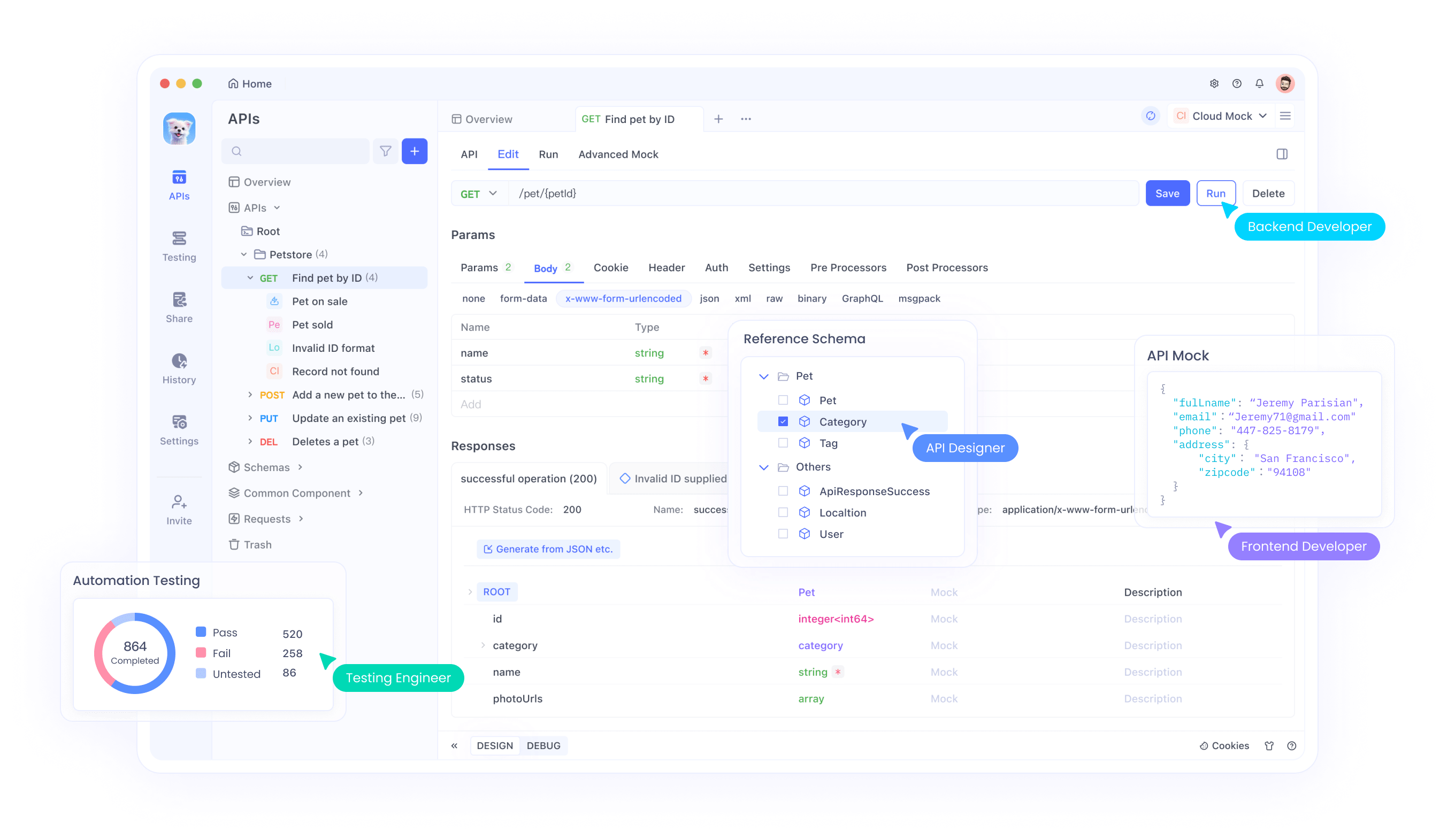

- 高速評価のためにポリシーモデルAPIを起動します:

CUDA_VISIBLE_DEVICES=0 python test/policy_model_queue.py --model_path path/to/huggingface/model --ip '0.0.0.0' --port '8000'。 - Apidogのようなツールを使用してこれらのAPIをテストおよび管理し、より大規模なシステムへのシームレスな統合を保証します。

このセットアップは、研究環境と本番環境の両方におけるXBai o4の柔軟性を強調しています。さらに、Apidogのようなツールとのモデルの互換性により、APIテストが簡素化され、開発者はエンドポイントを効率的に検証できます。

ベンチマーク性能と評価

MetaStone AIのリリースノートは、AIME24のような数学ベンチマークにおけるXBai o4の優れたパフォーマンスを強調しています。GitHubリポジトリで詳細に説明されているテストパイプラインは、ポリシーモデルとスコアモデルAPIの組み合わせを使用して、モデルの推論能力を評価します。例えば、inference.pyスクリプトは、aime24.jsonlのような入力ファイルを処理し、16個のサンプルで結果を生成し、速度のために複数のAPIエンドポイントを活用しています。

さらに、モデルのパフォーマンスはXFORMERSアテンションバックエンドによって強化されており、メモリ使用量と計算速度を最適化します。これは、GPU対応システムでの効率的な処理を保証するVLLM_ATTENTION_BACKEND=XFORMERS構成で特に顕著です。

対照的に、OpenAI-o3-miniは一般的なタスクには効果的であるものの、その評価プロセスにおいて同レベルの透明性を提供しません。XBai o4のオープンソースの性質により、研究者はそのベンチマークを精査し、再現することが可能になり、そのパフォーマンスの主張に対する信頼が育まれます。

コミュニティの反応と懐疑論

AIコミュニティは、XBai o4のリリースに対し、興奮と懐疑が入り混じった反応を示しています。例えば、r/accelerateのReddit投稿では、モデルの可能性を強調しつつも、Llama-4のようなモデルの過去の問題を参照しながら、ベンチマークの過剰適合に関する懸念を提起しています。一部のユーザーは、Qwenのような確立された組織と比較して比較的新しいプレイヤーであるMetaStone AIの信頼性に疑問を呈しています。しかし、XBai o4のウェイトとコードがオープンソースで利用可能であるため、独立した検証が奨励され、時間とともに疑念が払拭される可能性があります。

例えば、Threadsのユーザーは、M4 Maxでmlx-lmバックエンドを使用してXBai o4をテストしたと報告しており、推論タスクで「1+1バイブテスト」に合格したと述べています。しかし、複雑な視覚化(例:逆運動学)のレンダリングのような課題は、改善の余地があることを示唆しています。

APIテストのためのApidogとの統合

XBai o4をワークフローに統合する開発者にとって、Apidogのようなツールは非常に貴重です。Apidogは、XBai o4の評価パイプラインで使用されるようなAPIのテストと管理のプロセスを簡素化します。http://ip:port/scoreのようなエンドポイントにリクエストを送信するためのユーザーフレンドリーなインターフェースを提供することで、Apidogは開発者が複雑な手動設定なしにモデルのパフォーマンスを検証できるようにします。さらに、無料でダウンロードできるため、研究者や愛好家にも利用可能であり、XBai o4のオープンソースの精神と一致しています。

例として、開発者がApidogを使用してXBai o4のポリシーモデルAPIをテストするシナリオを考えてみましょう。エンドポイントURLとパラメータ(例:--model_pathと--port)を設定することで、Apidogはテストリクエストを送信し、応答を分析できるため、デバッグプロセスが効率化されます。この統合は、GitHubのセットアップ手順で推奨されているように、複数のノード間で評価を拡張するのに特に役立ちます。

オープンソースAIの将来への影響

XBai o4のリリースは、先進技術へのアクセスを民主化するオープンソースAIの重要性の高まりを強調しています。OpenAI-o3-miniのようなプロプライエタリモデルとは異なり、XBai o4は開発者が特定のユースケースに合わせてモデルをカスタマイズおよび拡張することを可能にします。例えば、その反射的生成形式は、科学研究、金融モデリング、自動コード生成などの分野に適応させることができます。

さらに、モデルの効率の改善は、リソースが制約された環境での大規模言語モデルのデプロイへの道を開きます。推論コストを削減することで、XBai o4は消費者向けハードウェアで高度なAIを実行することを可能にし、その潜在的なアプリケーションを広げます。

しかし、課題は残っています。AIコミュニティの懐疑論は、性能の主張を検証するための厳格で透明性の高いベンチマークの必要性を浮き彫りにしています。さらに、XBai o4は推論に優れているものの、コミュニティのフィードバックで指摘されているように、その視覚化機能(例:逆運動学)はさらなる改善が必要です。

結論:AIエコシステムにおけるXBai o4の立ち位置

要約すると、XBai o4はオープンソースAIにおける重要な進歩を象徴しており、OpenAI-o3-miniと比較して優れた推論能力と効率性を提供します。Long-CoT強化学習とプロセス報酬学習を組み合わせたその反射的生成形式は、複雑な問題解決の新しい基準を確立します。さらに、GitHubとHugging Faceでのオープンソースでの利用可能性は、協業とイノベーションを促進し、開発者と研究者にとって貴重なリソースとなっています。

XBai o4の機能を探索したい方にとって、Apidogのようなツールは、そのAPIをテストおよび統合する効率的な方法を提供し、実際のアプリケーションでのシームレスなデプロイを保証します。AIの状況が進化し続ける中、XBai o4はオープンソースイノベーションの力の証として、プロプライエタリモデルに挑戦し、AIが達成できることの限界を押し広げています。