Vercelは、v0-1.0-mdモデルを搭載したv0 APIでAI分野に参入しました。このAPIは、最新のウェブアプリケーション開発において開発者を支援するために設計されており、速度、効率、統合の容易さを考慮した一連の機能を提供します。この記事では、Vercel v0-1.0-md APIの包括的な概要として、その機能、価格、利用開始方法、そしてAPIdogのようなAPI開発ツールでどのように活用できるかを紹介します。

最大限の生産性で開発チームが共同作業できる統合されたオールインワンプラットフォームをお探しですか?

Apidogは、あなたのすべての要望に応え、Postmanをはるかに手頃な価格で置き換えます!

Vercel v0-1.0-md APIの機能

v0-1.0-mdモデルはv0 APIの中核をなし、現代のウェブ開発の課題に対応するために調整された堅牢な機能群をもたらします。

フレームワーク対応補完機能:際立った機能の一つは、最新のウェブ開発スタックを認識していることです。このモデルは、Next.jsのような人気フレームワークや、当然ながらVercel独自のプラットフォーム向けに評価・最適化されています。これは、これらのエコシステム内で作業する際に、開発者がより関連性が高く文脈に沿ったコード補完や提案を期待できることを意味します。

自動修正機能:最初の試みで完璧なコードを書くことは稀です。v0-1.0-mdモデルは、生成プロセス中に一般的なコーディングの問題を特定し、自動的に修正することでこれを支援します。これにより、デバッグ時間を大幅に削減し、コード全体の品質を向上させることができます。

クイック編集機能:速度はv0 APIの繰り返し現れるテーマです。クイック編集機能は、インライン編集が利用可能になり次第、ストリーム配信します。このリアルタイムのフィードバックループにより、開発者は変更を即座に確認でき、よりダイナミックでインタラクティブな開発体験を促進します。

OpenAI互換性:OpenAIのAPI標準が広く採用されていることを認識し、Vercelはv0-1.0-mdモデルがOpenAI Chat Completions API形式と互換性があることを保証しています。これは大きな利点であり、開発者はOpenAIの構造を既にサポートしている既存のツール、SDK、またはライブラリでv0 APIを使用できます。この相互運用性により、参入障壁が低くなり、既存のワークフローへの統合が容易になります。

マルチモーダル入力:このAPIはテキストベースのインタラクションに限定されません。マルチモーダル入力をサポートしており、テキストデータと画像データの両方を処理できます。画像はbase64エンコードされたデータとして提供する必要があります。これにより、テキストプロンプトと並行して視覚情報に基づいてコンテンツを理解または生成する必要があるアプリケーションの可能性が広がります。

関数/ツール呼び出し:現代のAIアプリケーションは、外部システムとのインタラクションや特定の関数の実行を必要とすることがよくあります。v0-1.0-mdモデルは関数およびツール呼び出しをサポートしており、開発者はAIが呼び出すことができるカスタムツールを定義できます。これにより、モデルの機能は単純なテキスト生成を超え、応答生成の一部としてアクションを実行したり、他のAPIからデータを取得したり、他のサービスとインタラクションしたりすることが可能になります。

低遅延ストリーミング応答:チャットボットやライブコーディングアシスタントなど、リアルタイムのインタラクションを必要とするアプリケーションにとって、遅延は重要な要素です。v0 APIは、高速なストリーミング応答を提供するように設計されています。これは、応答全体が生成されるのを待つのではなく、データが利用可能になり次第チャンクで送信されることを意味し、はるかに応答性が高く魅力的なユーザーエクスペリエンスにつながります。

ウェブ開発向け最適化:このモデルは、フロントエンドおよびフルスタックのウェブ開発タスク向けに特別に最適化されています。この焦点により、UIコンポーネントの生成からサーバーサイドロジックの記述まで、最新のウェブアプリケーション構築における一般的な課題や要件とトレーニングおよび機能が一致します。

開発者は、Vercelが提供するAI Playgroundでv0-1.0-mdモデルを直接試すことができます。これにより、プロジェクトに統合する前に、さまざまなプロンプトをテストしたり、モデルの応答を観察したり、その機能を把握したりすることができます。

Vercel v0 APIの価格とアクセス

Vercel v0 API、ひいてはv0-1.0-mdモデルへのアクセスは、現在ベータ版です。APIを利用するには、ユーザーは従量課金が有効なPremiumまたはTeamプランに加入している必要があります。価格体系に関する詳細情報は、通常、Vercelの公式価格ページで確認できます。多くのベータプログラムと同様に、最新の利用規約はVercelから直接確認することをお勧めします。

APIの使用を開始するには、まずv0.devでAPIキーを作成します。このキーは、APIへのリクエストを認証するために使用されます。

利用制限

ほとんどのAPIサービスと同様に、Vercel v0 APIには公平な利用を確保し、サービスの安定性を維持するための利用制限が設けられています。v0-1.0-mdモデルの現在の文書化されている制限は以下の通りです。

- 1日あたりの最大メッセージ数:200

- 最大コンテキストウィンドウサイズ:128,000トークン

- 最大出力コンテキストサイズ:32,000トークン

これらの制限は、特にAPIがベータ版から移行するにつれて変更される可能性があります。より高い制限を必要とするユーザーまたはアプリケーション向けに、Vercelは潜在的な増加について話し合うための連絡先(support@v0.dev)を提供しています。また、APIを使用することにより、開発者はVercelのAPI利用規約に同意することに注意することが重要です。

Vercel v0 APIの使用方法

Vercel v0 APIをプロジェクトに統合することは、特にOpenAI API形式に慣れている開発者やVercelのエコシステムを使用している開発者にとって、簡単になるように設計されています。

AI SDKとの統合:Vercelは、<V0Text />やその他のOpenAI互換モデルとの連携のために特別に設計されたTypeScriptライブラリであるAI SDKの使用を推奨しています。このSDKは、API呼び出しの作成、応答の処理、およびアプリケーションへのAI機能の統合プロセスを簡素化します。

開始するには、通常、必要なパッケージをインストールします。

npm install ai @ai-sdk/openai

使用例(JavaScript/TypeScript):

次の例は、AI SDKのgenerateText関数を使用してv0-1.0-mdモデルとインタラクションする方法を示しています。

import { generateText } from 'ai';

import { createOpenAI } from '@ai-sdk/openai';

// Configure the Vercel v0 API client

const vercel = createOpenAI({

baseURL: 'https://api.v0.dev/v1', // The v0 API endpoint

apiKey: process.env.VERCEL_V0_API_KEY, // Your Vercel v0 API key

});

async function getAIChatbotResponse() {

try {

const { text } = await generateText({

model: vercel('v0-1.0-md'), // Specify the Vercel model

prompt: 'Create a Next.js AI chatbot with authentication',

});

console.log(text);

return text;

} catch (error) {

console.error("Error generating text:", error);

// Handle the error appropriately

}

}

getAIChatbotResponse();

この例では:

aiライブラリからgenerateTextを、@ai-sdk/openaiからcreateOpenAIをインポートしています。createOpenAIを使用してOpenAI互換クライアントを作成し、v0 APIのベースURL(https://api.v0.dev/v1)とVercel v0 APIキー(環境変数として安全に保存するなど)で構成しています。- 構成された

vercelクライアント(v0-1.0-mdモデルを指定)と目的のプロンプトを渡して、generateText関数を呼び出しています。 - APIからの応答(生成されたテキストを含む)は、

text変数で利用可能になります。

APIリファレンス:

SDKを使用せずに直接APIとインタラクションする場合や、基盤となるメカニズムを理解する場合、APIリファレンスが重要です。

エンドポイント:POST https://api.v0.dev/v1/chat/completions

この単一のエンドポイントは、会話履歴に基づいてモデルの応答を生成するために使用されます。

ヘッダー:

Authorization:必須。Bearer $V0_API_KEYの形式のベアートークン。Content-Type:必須。application/jsonである必要があります。

リクエストボディ:リクエストボディは、以下の主要フィールドを持つJSONオブジェクトです。

model(文字列、必須):モデルの名前。このAPIでは、"v0-1.0-md"である必要があります。messages(配列、必須):会話履歴を形成するメッセージオブジェクトのリスト。各メッセージオブジェクトには以下が必要です。role(文字列、必須):送信者を識別します。"user"、"assistant"、または"system"です。content(文字列または配列、必須):実際のメッセージコンテンツ。単純な文字列、またはマルチモーダル入力用のテキストブロックと画像ブロックの配列にすることができます。stream(ブール値、オプション):trueに設定すると、APIはServer-Sent Events (SSE) のストリームとして応答を返します。デフォルトはfalseです。tools(配列、オプション):モデルが呼び出すことができるカスタムツール(例:関数)の定義。tool_choice(文字列またはオブジェクト、オプション):ツールが提供されている場合、モデルが呼び出すべきツールを指定します。

リクエスト例 (cURL):

cURLを使用して直接API呼び出しを行う方法は以下の通りです。

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Create a Next.js AI chatbot" }

]

}'

ストリーミングを使用した例 (cURL):

ストリーム応答を受信するには:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"stream": true,

"messages": [

{ "role": "user", "content": "Add login to my Next.js app" }

]

}'

応答形式:

非ストリーミング(stream: false):APIは完全な応答を含む単一のJSONオブジェクトを返します。このオブジェクトには、id、model名、objectタイプ(例:chat.completion)、createdタイムスタンプ、およびchoices配列が含まれます。配列内の各選択肢には、message(role: "assistant"と応答のcontentを含む)およびfinish_reason(例:"stop")が含まれます。

{

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion",

"created": 1715620000,

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Here's how to add login to your Next.js app..."

},

"finish_reason": "stop"

}

]

}

ストリーミング(stream: true):サーバーはServer-Sent Events (SSE) としてフォーマットされた一連のデータチャンクを送信します。各イベントはdata: で始まり、その後に応答の部分的な差分を表すJSONオブジェクトが続きます。これにより、クライアントは応答を段階的に処理できます。

data: {

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion.chunk",

"choices": [

{

"delta": {

"role": "assistant",

"content": "Here's how"

},

"index": 0,

"finish_reason": null

}

]

}

最後のチャンクには、通常、null以外のfinish_reasonが含まれます。

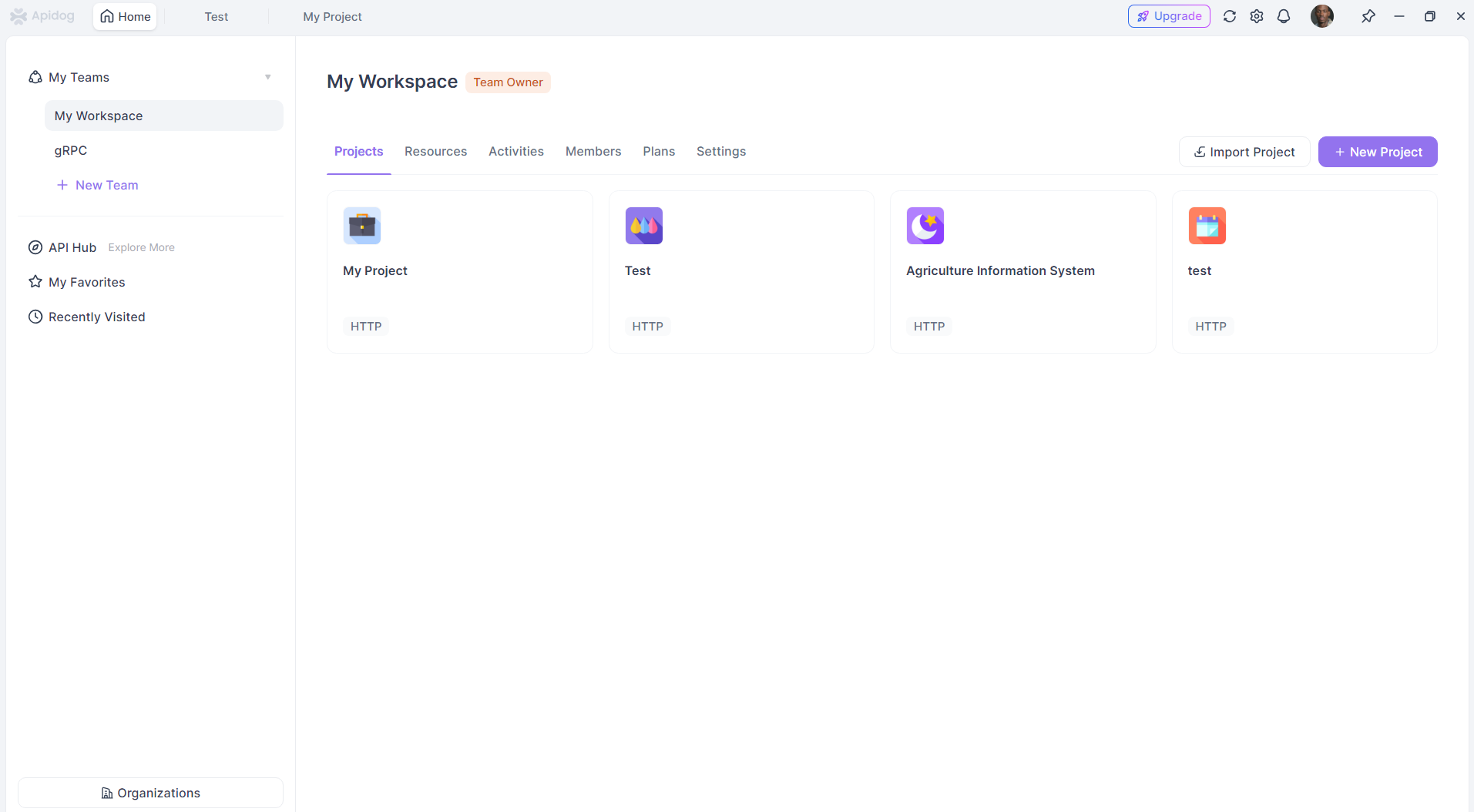

APIdogでVercel v0 APIを使用する

APIdogは、APIの設計、開発、テスト、ドキュメント作成のために設計された包括的なAPIプラットフォームです。その強みは、APIライフサイクルのこれらの異なる段階を統合することにあります。他のHTTPベースのAPIと同様に、APIdogを使用してVercel v0 APIとインタラクションできます。

APIdogでVercel v0 APIを使用するための一般的なアプローチは以下の通りです。

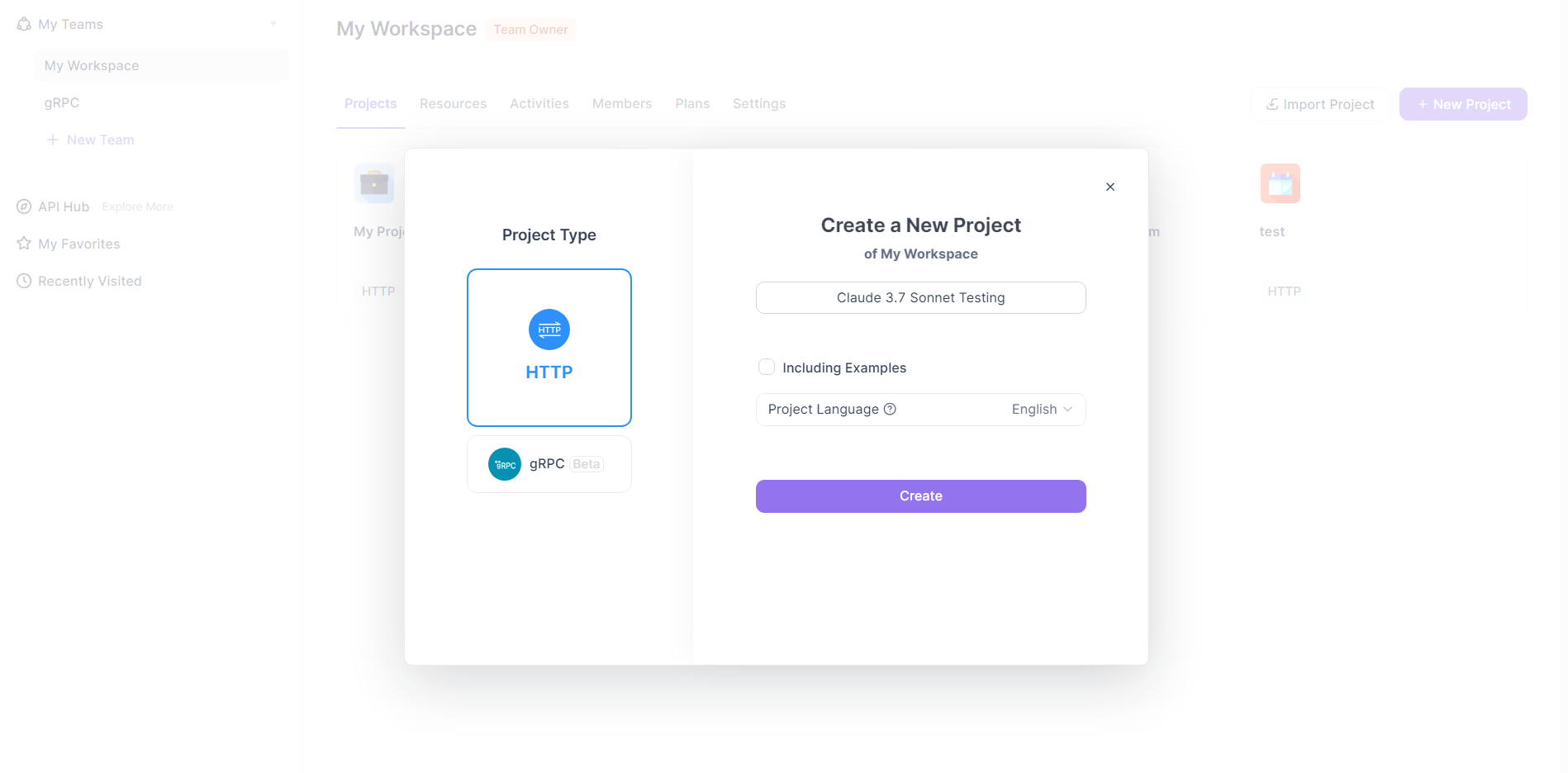

APIdogで新しいリクエストを作成する:

- APIdogプロジェクト内で、新しいリクエストの作成を開始します。これは通常、「+」アイコンをクリックし、「New Request」または同様のオプションを選択することで行われます。

- APIdogはさまざまなリクエストタイプをサポートしています。Vercel v0 APIの場合は、HTTPリクエストを作成します。

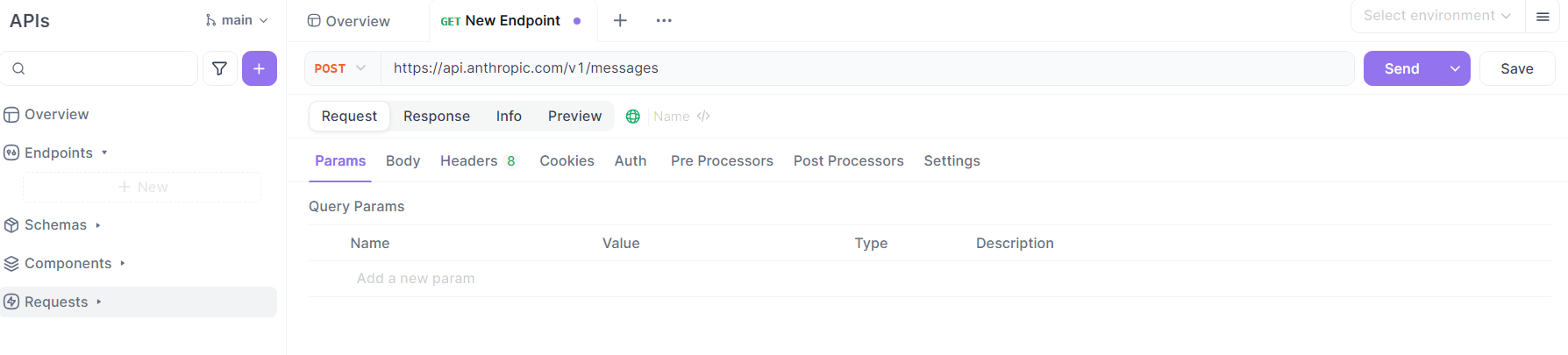

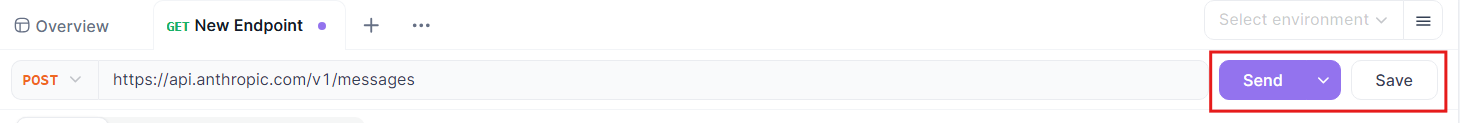

リクエストの詳細を構成する:

- メソッド:Vercel v0 APIドキュメントで指定されているように、HTTPメソッドとして

POSTを選択します。 - URL:Vercel v0 APIエンドポイントを入力します:

https://api.v0.dev/v1/chat/completions。 - ヘッダー:

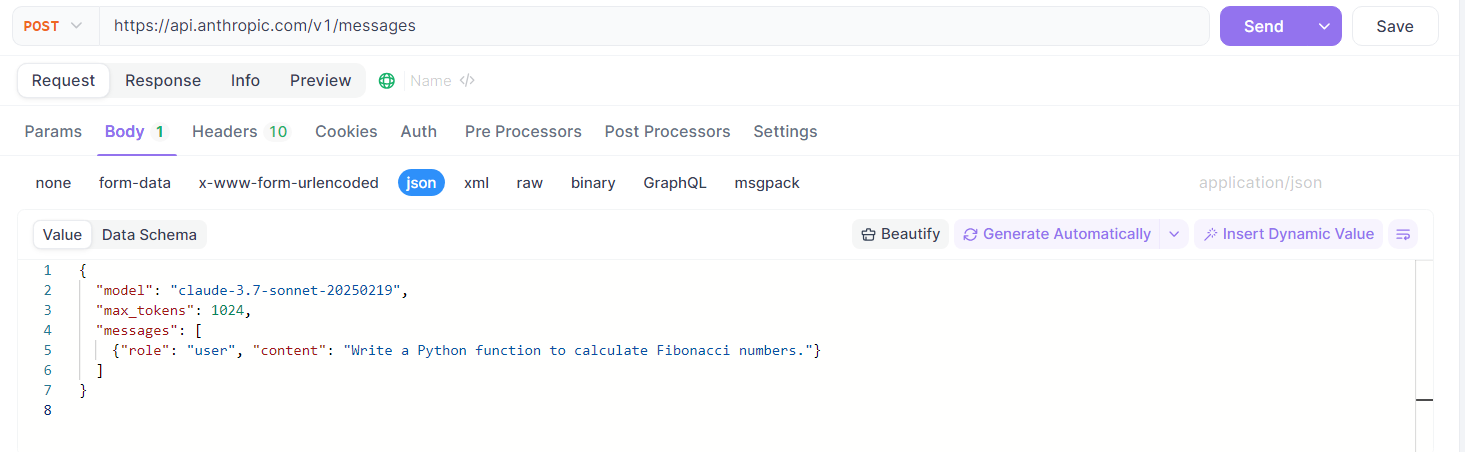

Authorizationヘッダーを追加します。値はBearer YOUR_VERCEL_V0_API_KEYとし、YOUR_VERCEL_V0_API_KEYをv0.devで取得した実際のAPIキーに置き換えます。Content-Typeヘッダーを値application/jsonで追加します。- ボディ:

APIdogで「Body」タブに切り替え、「raw」入力タイプを選択し、形式として「JSON」を選択します。

Vercel v0 APIの仕様に従ってJSONペイロードを構築します。例:

{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Generate a React component for a loading spinner." }

],

"stream": false // or true, depending on your needs

}

messages配列は、希望する会話履歴とプロンプトでカスタマイズできます。必要に応じて、stream、tools、またはtool_choiceなどのオプションフィールドを含めることもできます。

リクエストを送信する:

- すべての詳細が構成されたら、APIdogの「Send」ボタンをクリックします。

応答を確認する:

- APIdogは、応答パネルにサーバーの応答を表示します。

streamがfalseだった場合、完全なJSON応答が表示されます。streamがtrueだった場合、APIdogのSSEの処理は異なる場合があります。- チャンクが到着するたびに表示したり、蓄積したりする可能性があります。

- ストリーム応答の処理に関する詳細は、APIdogのドキュメントを参照してください。

- より高度なストリーム処理には、APIdogのスクリプト機能やテストシナリオを使用する必要がある場合があります。

APIdog機能の活用(オプション):

- 環境:

V0_API_KEYとベースURL(https://api.v0.dev)をAPIdogの環境変数として保存し、異なるリクエストやプロジェクト間での管理を容易にします。 - エンドポイント保存:この構成されたリクエストをAPIdogで「Endpoint Case」として、またはAPI定義内に保存します。これにより、Vercel v0 APIとのインタラクションを簡単に再利用およびバージョン管理できます。

- テストシナリオ:一連の呼び出しを行う必要がある場合や、Vercel v0 APIをより大きなテストワークフローに組み込む必要がある場合は、APIdogでテストシナリオを作成します。

- 自動検証:APIdog内でVercel v0 APIのAPI仕様を定義(または利用可能であればインポート)すると、APIdogはこのスキーマに対して応答を自動的に検証できます。

これらの手順に従うことで、APIdogをクライアントとして効果的に使用し、Vercel v0 APIにリクエストを送信し、応答を検査し、APIインタラクションを構造化された方法で管理できます。これは、開発およびテスト段階で、プロンプトのテスト、API機能の探索、およびAI生成コンテンツまたはロジックのアプリケーションへの統合に特に役立ちます。

まとめ

Vercel v0-1.0-md APIは、VercelがAI支援開発の領域に踏み出した重要な一歩です。最新のウェブフレームワークへの焦点、OpenAI互換性、および自動修正やマルチモーダル入力などの機能は、次世代のウェブアプリケーション構築を目指す開発者にとって魅力的な選択肢となります。現在ベータ版であり、特定のプラン要件に左右されますが、APIの設計とサポートするAI SDKは、強力でありながらアクセスしやすいツールを提供するというコミットメントを示唆しています。REST APIを介して直接使用する場合でも、AI SDKを介して使用する場合でも、APIdogのようなツールで管理する場合でも、v0-1.0-mdモデルは、高度なAI機能をウェブ開発ワークフローに統合し、タスクを効率化し、新しい創造的な可能性を解き放つ有望な道を提供します。APIが成熟し、提供内容が拡大するにつれて、プロジェクトでAIを活用したい開発者にとって間違いなく注目すべき分野となるでしょう。