AIコーディングエージェントの力を、予期せぬ請求なしで手に入れたいとお考えですか?朗報です。2025年には、バンドルされたクレジットの利用から、パートナーモデルの活用、さらには有能な代替モデルのローカル実行まで、Codexを無料で(またはほぼ無料で)使用できるいくつかの正当な方法があります。このガイドでは、開発者が日々実際に使用している実績のある方法を、明確な手順とともにご紹介します。

Codexとは?

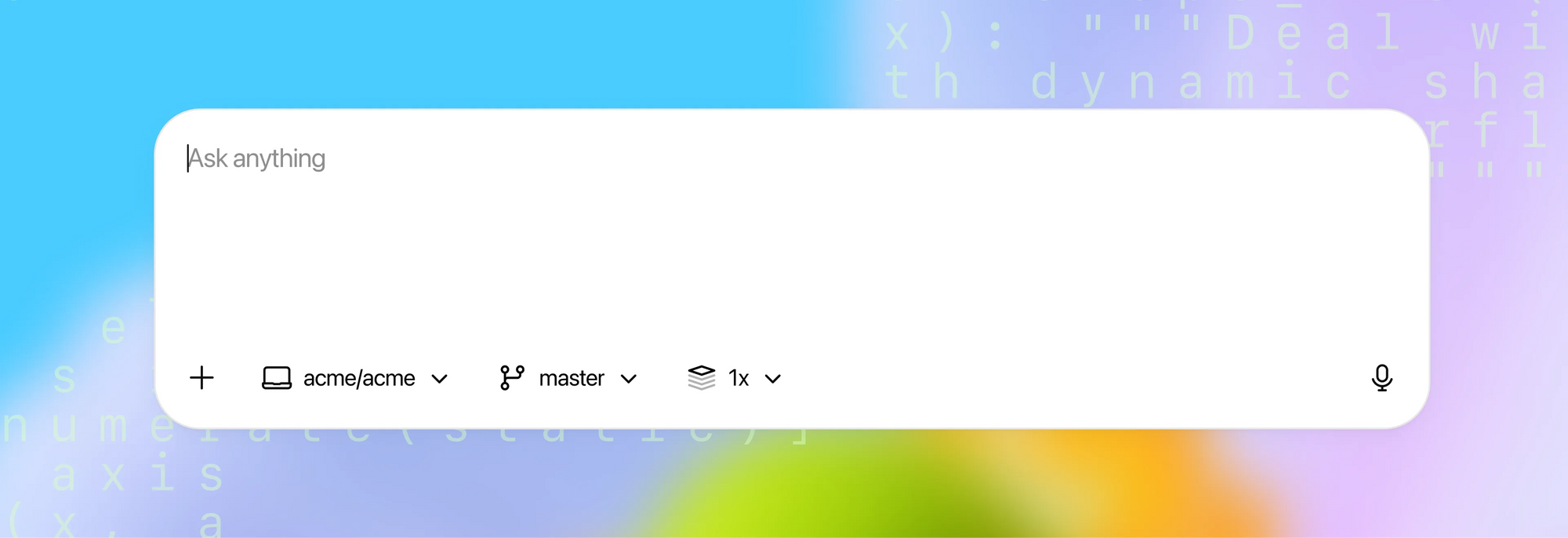

Codexは、OpenAIのエージェント型コーディングシステムで、コードの読み書き、実行を通じて、より迅速な開発、バグの解消、慣れないリポジトリの理解を支援します。ローカルおよびクラウド環境で動作し、リファクタリング、テストの追加、ドキュメントの生成、プルリクエストの準備といった複雑なタスクを委任できます。

Codexの仕組みの概要:

- リポジトリと指示を分析し、ツール支援ループ(例: ターミナル/CLI)を実行して変更を実装します。

- 差分を提案し、テストを実行し、チェックが合格するまで繰り返し、変更内容の明確な要約を生成できます。

- 複数のクライアント(Web、IDE拡張機能、iOS)で利用でき、GitHubと統合してPRワークフローをサポートします。

デプロイオプション:

- クラウド「委任」は、コードと依存関係を含むサンドボックスコンテナを起動し、バックグラウンド作業と並行タスクを可能にします。

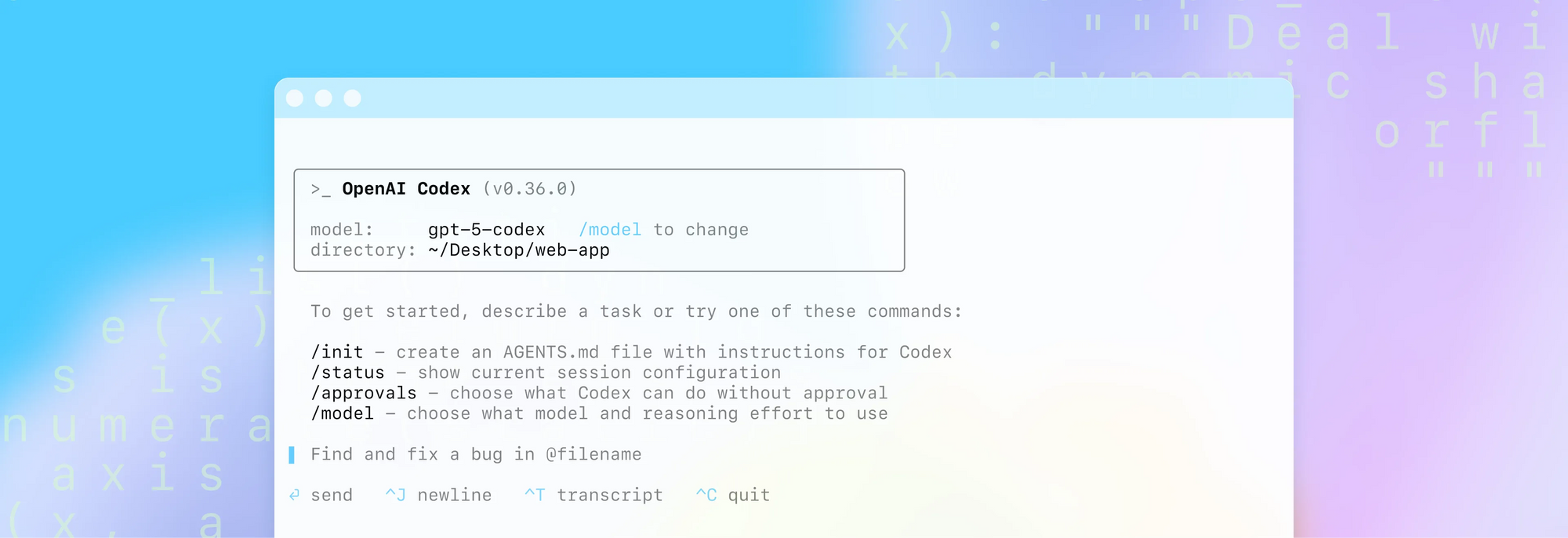

- ローカルでの使用はCodex CLIを通じてサポートされており、オフラインワークフローのためにローカルモデルプロバイダーと組み合わせることもできます。

セキュリティに関する注意点:

- MFA/SSOおよび組織ポリシーがサポートされており、クラウド実行ではシークレットと環境変数は追加の暗号化で処理されます。

- 管理者は、予測可能な動作とコンプライアンスのために、環境(依存関係、インターネットアクセスレベル)を設定できます。

方法1 — Codex CLIでChatGPTサブスクリプションを使用する

すでにChatGPTを購読している場合、Codex CLI内でそのサブスクリプションを使用でき、トランザクションごとのAPI料金を支払う必要はありません。つまり、使用量がサブスクリプション特典に含まれているため、各呼び出しにAPIキーを提供することなく、CLIを通じてCodexの機能にアクセスできます。

実践的なヒント:

- ChatGPTアカウントを使用してCodex CLIにサインインします。

- サインインやトークンの問題を避けるため、最新のCLIビルドを使用していることを確認します。

- 組織のセキュリティポリシーがCLIの使用を許可していることを確認します。

多くの開発者は、ヘルパー関数の生成、差分のレビュー、テストの作成といった反復的なタスクで、「Codexを無料で利用」したいと考えており、トークンごとの課金を心配したくありません。既存のサブスクリプションを活用することで、コストを安定させることができます。

方法2 — Codex CLIで無料クレジットを利用する

ChatGPT PlusまたはProユーザーの場合、Codex CLI内で無料APIクレジットを利用できます。公式ガイダンスによると、ChatGPTアカウントでCodex CLIにサインインしたPlusおよびProユーザーは、それぞれ30日間で5ドルと50ドルの無料APIクレジットを利用できます。問題が発生した場合は、最新のCLIバージョンを使用していることを確認してください。

クイックスタート(CLIコマンド):

npm i -g @openai/codex@latest

codex --freeクレジットの利用で問題が発生した場合は、Codex CLIをアップグレードして再試行してください。

方法3 — モデルプロバイダーを切り替える

Codex CLIはプロバイダーを切り替えることができ、利用可能な無料モデル(例: Mistral経由)をターゲットにできます。これは、探索的なタスクでCodexを無料で利用する必要がある場合に実用的な方法です。

例(概念):

[model_providers.mistral]

name = "Mistral"

base_url = "https://api.mistral.ai/v1"

env_key = "MISTRAL_API_KEY"ヒント:

- 「無料」モデルでフィルタリングし、「ツール」がサポートされていることを確認してください。そうでない場合、エージェントフローは失敗します。

- 無料モデルのカタログは頻繁に変更されます。安定したオプションを見つけるためにいくつか試してください。

方法4 — Ollamaでモデルをローカルで実行する

モデルをローカルで実行することは、Codexを無料で利用するための最も独立した方法です。Ollamaを使用すると、モデル(例えばMistralのバリアント)をプルし、ローカルサーバーを実行し、Codex CLIをローカルプロバイダーに指定します。これにより、外部のトークンごとのコストが不要になり、ディスクスペースと計算要件を犠牲にするものの、オフラインでも動作可能です。

主な手順(概念):

- Ollamaをインストールし、

ollamaコマンドがローカルで実行されることを確認します。 - ツールをサポートするモデル(例: Mistralのバリアント)をプルし、サイズとリソースの要件に注意します。

ollama serveを開始し、Codex CLIがローカルプロバイダーを使用するように設定します。

[model_providers.ollama]

name = "Ollama"

base_url = "http://localhost:11434/v1"モデルプロバイダーの設定方法はこちらをご覧ください。

考慮事項:

- 大規模なダウンロード(数GB)と高いローカルリソース使用量

- 控えめなハードウェアでは生成が遅くなる可能性

- データローカリティとネットワーク露出に対する完全な制御

結論 — 最適な無料パスを選び、Apidogでより迅速に出荷する

Codexを無料で利用する「最善」の方法は一つではありません。代わりに、無料クレジットの利用、Codex CLI内でのChatGPTサブスクリプションの活用、Mistralでプロバイダーを切り替えて無料ティアを利用する、またはOllamaでモデルをローカルで実行するなど、いくつかの正当なアプローチがあります。それぞれの方法には、利便性、パフォーマンス、制御、コストの異なるバランスがあります。最も賢い方法は、現在の段階と制約に合ったものを選択し、その後ApidogでAPIライフサイクルを標準化することです。

Apidogは、AIコーディングによるメリットを最大限に引き出すのに役立ちます。明確な設計、自信を持ったデバッグ、きめ細かな制御による応答の検証、AIによるテストケースの生成、そして消費者が真に利用できるドキュメントの公開を実現します。

よりスムーズなエンドツーエンドのAPIワークフローを体験する準備はできていますか?無料のApidogワークスペースを作成し、既存のOpenAPI/Swaggerをインポートして、AIで加速されたアイデアが、いかに迅速に堅牢で十分に文書化されたサービスになるかを体験してください。