OpenAIのSora 2は、テキストプロンプトと高度な音声同期を組み合わせてリアルなクリップを生成する強力なツールとして際立っています。開発者は、プロフェッショナルなアプリケーションの妨げとなるウォーターマークのような視覚的な邪魔を避けつつ、このテクノロジーを活用する方法を頻繁に模索しています。幸いなことに、Sora 2 APIを使用すると、特に堅牢なAPI管理ツールと統合した場合に、よりクリーンな出力を得ることができます。

この記事では、Sora 2の技術的側面を探り、APIの利用方法とウォーターマークを排除する戦略に焦点を当てます。環境のセットアップ方法、APIコールの実行方法、後処理方法の適用方法を学びます。さらに、このガイドには、プロジェクトを強化するための実践的な例と最適化のヒントが含まれています。

Sora 2とその機能の理解

OpenAIは2025年9月30日にSora 2をリリースし、動画生成技術における大きな進歩を遂げました。このモデルは、より正確な物理シミュレーション、リアルなアニメーション、同期されたオーディオを組み込むことで、オリジナルのSoraを基盤としています。例えば、Sora 2は、バスケットボールがバックボードから跳ね返る様子や、体操選手が複雑なルーティンを演じる様子など、複雑なシナリオを正確にレンダリングします。開発者はこれらの機能を活用して、エンターテイメント、教育、マーケティングアプリケーション向けのダイナミックなコンテンツを作成しています。

Sora 2は、テキストプロンプトを最大20秒の動画に変換する拡散ベースのモデルとして動作し、上位ティアでは1080pの解像度に達します。映画のようなリアリズムからアニメの美学まで、幅広いスタイルをサポートしています。しかし、Soraアプリやウェブサイトからの公式出力には、OpenAIの責任あるAIポリシーに従い、AI生成であることを示す視覚的なウォーターマークが含まれることがよくあります。これらのウォーターマークは、動くオーバーレイまたは埋め込みメタデータとして表示され、商用環境での使いやすさを制限する可能性があります。

APIバージョンに移行すると、Sora 2はより大きな柔軟性を提供します。開発者向けにプレビューで提供されているAPIは、消費者向けアプリの制約なしに、生成エンドポイントへのプログラムによるアクセスを可能にします。OpenAIのプラットフォームを通じてアクセスし、APIキーと、特定の構成で高解像度や組み込みのウォーターマークなしなどの強化された機能を利用するためのProサブスクリプションが必要になる場合があります。開発者向けドキュメントによると、APIエンドポイントはテキストから動画へのリクエストに焦点を当てており、プロンプト、期間、スタイルなどのパラメーターを指定します。

ReplicateやComfyUIのようなプラットフォームは、Sora 2 APIのホストバージョンを提供しており、それらのインターフェースを通じてウォーターマークなしの出力を可能にします。これらの代替手段は、認証とリクエストのフォーマットを処理するApidogのようなツールとシームレスに統合されます。APIを使用することで、無料アプリティアで適用されるデフォルトのウォーターマークを回避できますが、一部の実装では依然としてメタデータが埋め込まれています。それでも、このアプローチにより、ニーズに合わせてクリーンな動画を生成することができます。

Sora 2 APIへのアクセス:前提条件とセットアップ

動画を生成する前に、Sora 2 APIへのアクセスを確保する必要があります。OpenAIは、アクティブなアカウントを持つ開発者にAPIの利用を順次提供しており、多くの場合、Proまたはエンタープライズサブスクリプションを持つユーザーを優先します。まず、platform.openai.comのOpenAI開発者プラットフォームにログインしてください。そこで、「API keys」セクションでAPIキーを作成します。Sora 2プレビューアクセス要件(ウェイティングリストへの参加やユースケースの確認など)をアカウントが満たしていることを確認してください。

承認されたら、開発環境を構成します。pipを使用して、OpenAI Python SDKなどの必要なライブラリをインストールします: pip install openai。このライブラリはAPIとのやり取りを簡素化します。JavaScriptユーザー向けには、Node.jsパッケージが同様の機能を提供します。さらに、Replicateのようなサードパーティホストを選択する場合は、そのサイトでサインアップしてAPIトークンを取得してください。

ここではセキュリティが重要な役割を果たします。APIキーをハードコードするのではなく、環境変数に保存して漏洩を防ぐようにしてください。例えば、Pythonでは os.environ['OPENAI_API_KEY'] = 'your-key' を使用します。この方法は、共同プロジェクト中に資格情報を保護します。

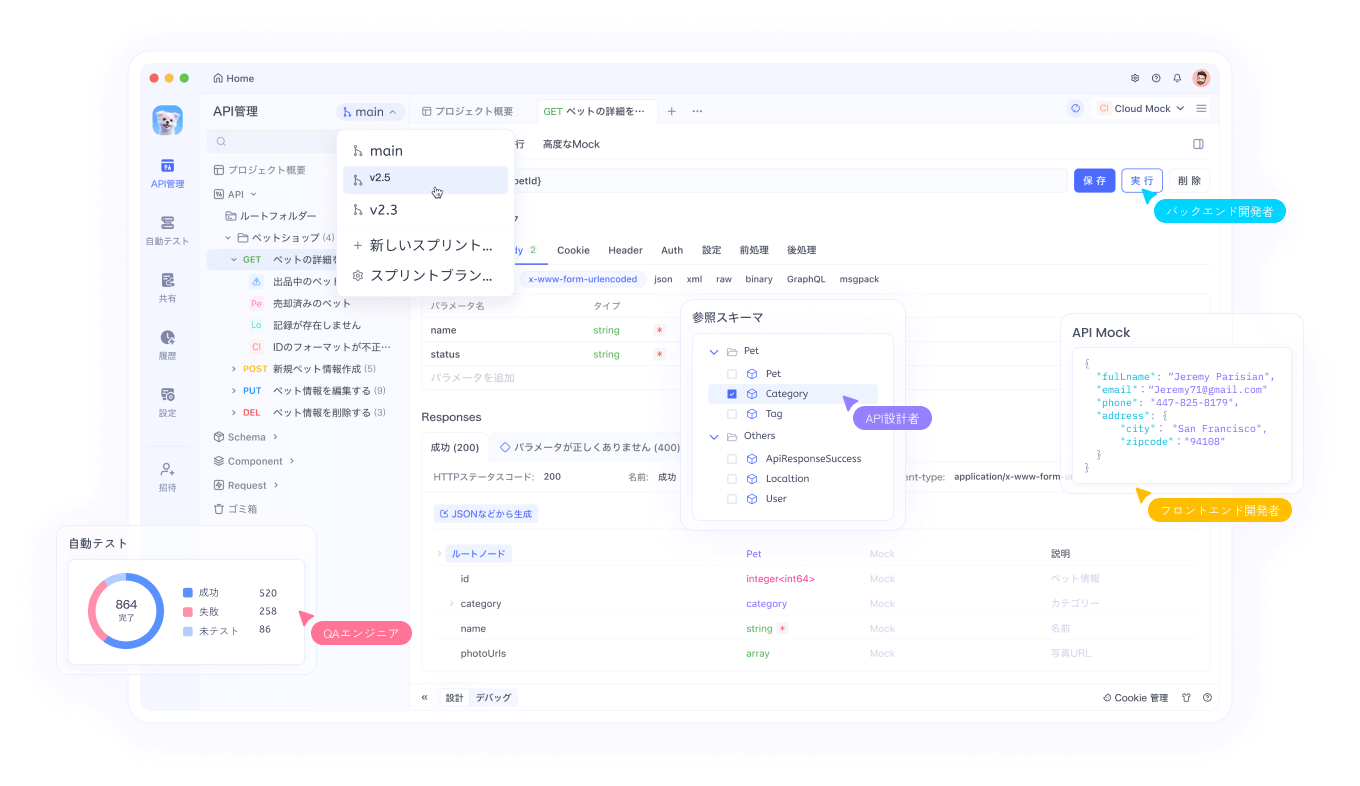

次に、Apidogをセットアップに統合します。包括的なAPIクライアントとして、ApidogはSora 2を含むOpenAIエンドポイントのテストとドキュメント作成に優れています。Apidogを公式ウェブサイトからダウンロードしてインストールしてください。起動後、新しいプロジェクトを作成し、OpenAPIスキーマURLを貼り付けるかJSONファイルをアップロードしてOpenAI API仕様をインポートします。ApidogはSora 2のようなモデルのエンドポイントを自動的に生成し、モデル名(「sora-2」)や入力プロンプトなどのパラメーターでリクエストをカスタマイズできます。

ApidogのインターフェースはPostmanに似ていますが、自動テストやモックなどの高度な機能を提供します。APIキーは通常Bearerトークンとして認証ヘッダーに追加します。接続性を確認するために、モデルリストのような簡単なエンドポイントをテストします。/v1/models にGETリクエストを送信し、Sora 2が応答に表示されることを確認してください。このステップは、動画生成に進む前にセットアップが正しく機能していることを保証します。

Sora 2 APIリクエストのためのApidogの設定

環境が整ったら、ApidogのSora 2向け機能を活用します。動画生成専用の新しいAPIコレクションを作成します。その中に、OpenAIのドキュメントに基づいて、通常 /v1/video/generations または類似のSora 2エンドポイントへのPOSTリクエストを追加します。リクエストボディをJSON形式に設定します。

主なパラメーターは次のとおりです。

model: 最新バージョンを呼び出すために「sora-2」を指定します。prompt: 詳細なテキスト記述。例:「氷上でトリプルアクセルを演技し、鳴き声が同期した猫。」duration: 秒単位で、最大20秒。resolution: Proユーザー向けに「720p」または「1080p」などのオプション。style: 「realistic」(リアル)、「cinematic」(シネマティック)、または「anime」(アニメ)。

Apidogでは、これらを再利用のためにパラメーター化できます。例えば、{{prompt}}のような変数を使用して、複数のシナリオを迅速にテストできます。さらに、テスト用と本番用のAPIキーを切り替えるために環境変数を有効にします。

動画生成には数分かかる場合があるため、非同期応答を処理するには、ApidogでWebhookまたはポーリングを設定します。ジョブIDエンドポイントへのGETリクエストを介して生成ステータスを確認するスクリプトを設定します。この自動化により時間を節約し、完了した動画を効率的に取得できます。

さらに、Apidogはリクエスト前後のアクションのためにJavaScriptによるスクリプト作成をサポートしています。エラーを防ぐために、送信前にプロンプトの長さを検証するスクリプトを作成します。例えば:

if (pm.variables.get('prompt').length > 1000) {

throw new Error('プロンプトが長すぎます');

}

この技術的な安全策は信頼性を高めます。設定が完了したら、最初のリクエストを送信し、通常は動画URLまたはbase64エンコードされたファイルを含む応答を監視します。

Sora 2 APIで動画を生成する:ステップバイステップの例

これで実際の生成を実行します。まず、基本的なプロンプトから始めて試してみましょう。Apidogで、ボディに以下を入力します。

{

"model": "sora-2",

"prompt": "A bustling city street at dusk with pedestrians and cars, ambient street sounds included.",

"duration": 10,

"resolution": "720p"

}

リクエストを送信します。APIはそれを処理し、ジョブIDを返します。「completed」(完了)になるまで10秒ごとにステータスエンドポイントをポーリングします。応答から動画URLを取得します。

高度な使用法として、人物の肖像などの現実世界の要素を組み込む機能であるカメオを導入します。Apidogでマルチパートフォームリクエストを介して参照動画をアップロードします。ボディは次のようになるかもしれません。

{

"model": "sora-2",

"prompt": "The uploaded person giving a TED talk on AI.",

"cameo_video": "base64-encoded-video",

"audio_sync": true

}

Apidogはファイルアップロードをネイティブで処理するため、シームレスです。

ただし、標準ティアを使用している場合、出力にウォーターマークが含まれる可能性があります。ChatGPT Proサブスクライバーが利用できるPro APIアクセスでは、ウォーターマークなしのダウンロードオプションが提供されることがよくあります。サブスクリプションレベルを確認してください。アップグレードするとこれが解除されます。

プロンプトを最適化するには、詳細を試してください。「重力に逆らう跳躍」のような物理記述子を追加して、Sora 2のシミュレーションの強みを活用します。Apidogのアナリティクスで利用状況の指標を追跡し、レート制限内にとどまるようにします。優先アクセスの場合、通常は月あたり500世代です。

Sora 2動画からウォーターマークを削除する戦略

APIアクセスがあっても、一部の動画にはウォーターマークが含まれています。これは後処理によって対処します。まず、ウォーターマークの種類を理解してください。可視オーバーレイ(動くロゴ)と不可視メタデータ(C2PA標準)です。

可視ウォーターマークの削除には、AIベースのツールを使用します。無料のオンラインサービスであるVmake AIは、ディープラーニングを使用して動くウォーターマークを検出し、消去します。Sora 2動画をアップロードし、ウォーターマーク領域を選択して処理します。このツールは、削除されたセクションを文脈に応じたピクセルでインペインティングすることにより、品質を維持します。

あるいは、PythonのOpenCVのようなオープンソースライブラリを使用します。動画をロードします。

import cv2

cap = cv2.VideoCapture('sora_video.mp4')

width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH))

height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT))

fps = cap.get(cv2.CAP_PROP_FPS)

out = cv2.VideoWriter('clean_video.mp4', cv2.VideoWriter_fourcc(*'mp4v'), fps, (width, height))

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# ウォーターマークを検出しマスクする (カスタムロジック、例: ROIクロッピングやMLモデル)

clean_frame = remove_watermark(frame) # 関数を実装

out.write(clean_frame)

cap.release()

out.release()

ウォーターマークデータセットで訓練されたセグメンテーションネットワークなど、Hugging Faceの事前学習済みモデルを使用して remove_watermark を実装します。

メタデータについては、FFmpegでC2PAタグを削除します: ffmpeg -i input.mp4 -codec copy -bsf:v "filter_units=remove_types=6" output.mp4。このコマンドは、再エンコードせずに特定のビットストリームフィルターを削除します。

ただし、法的な意味合いを考慮してください。OpenAIの規約は、来歴信号の改ざんを禁止していますが、内部使用や許可されている場合は、これらの方法が適用されます。AI生成コンテンツは常に倫理的に帰属表示してください。

これをApidogワークフローに統合し、スクリプトを介して後処理を自動化します。動画URLを取得した後、削除コードをダウンロードして実行します。

Sora 2 API最適化のための高度なテクニック

利用度を高めるには、複数のAPIコールを連鎖させます。ベースとなる動画を生成し、その後「前のシーンに劇的なひねりを加えて延長する」という追加のプロンプトでリミックスします。後続のリクエストでは、ジョブIDを参照として使用します。

さらに、オーディオの強化も組み込みます。Sora 2は効果音を自動的に同期しますが、プロンプトで「オーケストラのBGMを含める」と指定することで微調整できます。

パフォーマンスチューニングには、リクエストのバッチ処理が含まれます。Apidogは、複数のテストを同時に実行するためのコレクションをサポートしており、A/Bプロンプト実験に最適です。

さらに、コストを監視します。Sora 2 APIの料金は、標準で動画1秒あたり0.05ドルから始まり、Proはプレミアム機能のために高額な料金設定となっています。OpenAIのダッシュボードで追跡し、Apidogでアラートを設定してください。

スケーラビリティのためには、本番環境にデプロイします。AWS Lambdaのようなクラウド関数を使用して、ユーザー入力によってトリガーされるAPIコールを処理します。APIゲートウェイでセキュリティを確保します。

Apidogを使用したSora 2のベストプラクティスとトラブルシューティング

効率を最大化するために、これらのプラクティスを採用してください。まず、入力を厳密に検証します。不適切なプロンプトは質の低い動画を生み出します。Apidogのアサーションテストを使用して、応答ステータスコード(成功の場合は200)を確認します。

一般的な問題をトラブルシューティングします。認証が失敗した場合は、キーを再生成してください。レート制限については、スクリプトで指数バックオフを実装します。

import time

def api_call_with_retry(func, max_retries=5):

for attempt in range(max_retries):

try:

return func()

except Exception as e:

if 'rate_limit' in str(e):

time.sleep(2 ** attempt)

else:

raise

ネットワークエラーですか?Apidogのプロキシ設定に切り替えてください。

さらに、Apidogプロジェクトをリンク経由で共有することで共同作業を行い、Sora 2の構成についてチームの連携を確保します。

ケーススタディ:ウォーターマークなしSora 2の実際の応用例

Sora 2 APIを使用して広告クリップを作成するマーケティング会社を考えてみましょう。彼らは、クライアントプレゼンテーション用にウォーターマークなしの動画を生成し、迅速なイテレーションのためにApidogを統合しています。

教育分野では、教師がアニメーションの授業を作成します。ウォーターマーク削除後、動画はYouTubeのようなプラットフォームにきれいに埋め込むことができます。

これらの例は、ウォーターマークに邪魔されないSora 2の多用途性を示しています。

Sora 2 APIの将来展望とアップデート

OpenAIはSora 2の進化を続けており、より長い期間の生成やより良い統合などの拡張が計画されています。彼らのブログを通じて最新情報を入手してください。

Apidogは、AIアシストによるリクエスト生成など、Sora 2の進歩を補完する機能を定期的に追加しています。

要約すると、ウォーターマークなしでSora 2を使いこなすには、APIアクセス、Apidogの活用、およびターゲットを絞った削除技術が必要です。これらの手順を実行して、プロフェッショナル品質の動画を効率的に作成してください。