大規模言語モデル(LLM)をローカルで実行することで、開発者はプライバシー、制御、コスト削減を実現できます。OpenAIのオープンウェイトモデル、総称してGPT-OSS(gpt-oss-120bおよびgpt-oss-20b)は、コーディング、エージェントワークフロー、データ分析などのタスクに強力な推論機能を提供します。オープンソースプラットフォームであるOllamaを使用すると、クラウドに依存することなく、これらのモデルを自身のハードウェアにデプロイできます。この技術ガイドでは、Ollamaのインストール、GPT-OSSモデルの設定、およびローカルLLMのAPIテストを簡素化するツールであるApidogを使用したデバッグについて説明します。

なぜOllamaでGPT-OSSをローカルで実行するのか?

Ollamaを使用してGPT-OSSをローカルで実行することは、開発者や研究者にとって明確な利点をもたらします。まず、入力と出力が自身のマシン上に留まるため、データプライバシーが確保されます。次に、クラウドAPIの継続的なコストが不要になるため、大量処理や実験的なユースケースに最適です。第三に、OllamaはOpenAIのAPI構造との互換性があるため、既存のツールとシームレスに統合でき、gpt-oss-20bのような量子化モデル(16GBのメモリのみを必要とする)をサポートすることで、控えめなハードウェアでも利用可能です。

さらに、OllamaはLLMデプロイの複雑さを簡素化します。AIのためのDockerコンテナのように、単一のModelfileを通じてモデルの重み、依存関係、構成を処理します。ストリーミングAI応答のリアルタイム視覚化を提供するApidogと組み合わせることで、ローカルAI開発のための堅牢なエコシステムが得られます。次に、この環境をセットアップするための前提条件を見ていきましょう。

GPT-OSSをローカルで実行するための前提条件

進む前に、システムが以下の要件を満たしていることを確認してください。

- ハードウェア:

- gpt-oss-20bの場合: 最小16GBのRAM、理想的にはGPU(例: NVIDIA 1060 4GB)を搭載。

- gpt-oss-120bの場合: 80GBのGPUメモリ(例: 単一の80GB GPUまたはハイエンドデータセンター設定)。

- モデルの重みと依存関係のために20-50GBの空きストレージ。

- ソフトウェア:

- オペレーティングシステム: LinuxまたはmacOSを推奨。Windowsも追加設定でサポート。

- Ollama: ollama.comからダウンロード。

- オプション: Open WebUIを実行するためのDocker、またはAPIテストのためのApidog。

- インターネット: 初期モデルダウンロードのための安定した接続。

- 依存関係: GPUアクセラレーションを使用する場合はNVIDIA/AMD GPUドライバー。CPUのみのモードでも動作するが、遅い。

これらが揃っていれば、OllamaをインストールしてGPT-OSSをデプロイする準備ができています。インストールプロセスに進みましょう。

ステップ1: システムにOllamaをインストールする

Ollamaのインストールは簡単で、macOS、Linux、Windowsをサポートしています。以下の手順でセットアップしてください。

Ollamaをダウンロードする:

- ollama.comにアクセスし、お使いのOS用のインストーラーをダウンロードします。

- Linux/macOSの場合、ターミナルコマンドを使用します:

curl -fsSL https://ollama.com/install.sh | sh

このスクリプトはダウンロードとセットアッププロセスを自動化します。

インストールを確認する:

- ターミナルで

ollama --versionを実行します。バージョン番号(例: 0.1.44)が表示されるはずです。表示されない場合は、トラブルシューティングのためにOllama GitHubを確認してください。

Ollamaサーバーを起動する:

ollama serveを実行してサーバーを起動します。サーバーはhttp://localhost:11434でリッスンします。このターミナルを開いたままにするか、Ollamaをバックグラウンドサービスとして設定して継続的に使用してください。

インストールが完了すると、OllamaはGPT-OSSモデルをダウンロードして実行する準備が整います。モデルのダウンロードに進みましょう。

ステップ2: GPT-OSSモデルをダウンロードする

OpenAIのGPT-OSSモデル(gpt-oss-120bおよびgpt-oss-20b)はHugging Faceで利用可能であり、MXFP4量子化によりOllama向けに最適化され、メモリ要件が削減されています。以下の手順でダウンロードしてください。

モデルを選択する:

- gpt-oss-20b: 16GB RAMを搭載したデスクトップ/ラップトップに最適です。トークンあたり3.6Bのパラメータをアクティブ化し、エッジデバイスに適しています。

- gpt-oss-120b: 80GBのメモリを持つデータセンターまたはハイエンドGPU向けに設計されており、トークンあたり5.1Bのパラメータをアクティブ化します。

Ollama経由でダウンロードする:

- ターミナルで、以下を実行します:

ollama pull gpt-oss-20b

または

ollama pull gpt-oss-120b

お使いのハードウェアによっては、ダウンロード(20-50GB)に時間がかかる場合があります。安定したインターネット接続を確保してください。

ダウンロードを確認する:

- インストールされているモデルを以下でリスト表示します:

ollama list

gpt-oss-20b:latestまたはgpt-oss-120b:latestを探してください。

モデルがダウンロードされたので、ローカルで実行できるようになりました。GPT-OSSとの対話方法を見ていきましょう。

ステップ3: OllamaでGPT-OSSモデルを実行する

OllamaはGPT-OSSモデルと対話するための複数の方法を提供します: コマンドラインインターフェース(CLI)、API、またはOpen WebUIのようなグラフィカルインターフェースです。ここでは簡潔にするためにCLIから始めましょう。

インタラクティブセッションを起動する:

- 実行します:

ollama run gpt-oss-20b

これにより、リアルタイムのチャットセッションが開きます。クエリ(例: 「二分探索のPython関数を書いてください」)を入力してEnterキーを押します。特殊なコマンドについては/helpを使用してください。

ワンオフクエリ:

- インタラクティブモードなしで素早く応答を得るには、以下を使用します:

ollama run gpt-oss-20b "Explain quantum computing in simple terms"

パラメータを調整する:

- temperature(創造性)やtop-p(応答の多様性)などのパラメータでモデルの動作を変更します。例:

ollama run gpt-oss-20b --temperature 0.1 --top-p 1.0 "Write a factual summary of blockchain technology"

低いtemperature(例: 0.1)は、決定的で事実に基づいた出力を保証し、技術的なタスクに理想的です。

次に、特定のユースケースのためにModelfilesを使用してモデルの動作をカスタマイズしましょう。

ステップ4: Ollama ModelfilesでGPT-OSSをカスタマイズする

OllamaのModelfilesを使用すると、再トレーニングなしでGPT-OSSの動作を調整できます。システムプロンプトを設定したり、コンテキストサイズを調整したり、パラメータを微調整したりできます。カスタムモデルを作成する方法は次のとおりです。

Modelfileを作成する:

Modelfileという名前のファイルを以下のように作成します:

FROM gpt-oss-20b

SYSTEM "You are a technical assistant specializing in Python programming. Provide concise, accurate code with comments."

PARAMETER temperature 0.5

PARAMETER num_ctx 4096

これにより、モデルはPythonに特化したアシスタントとして、適度な創造性と4kトークンのコンテキストウィンドウで構成されます。

カスタムモデルをビルドする:

- Modelfileを含むディレクトリに移動し、以下を実行します:

ollama create python-gpt-oss -f Modelfile

カスタムモデルを実行する:

- 以下で起動します:

ollama run python-gpt-oss

これで、モデルは指定された動作でPython関連の応答を優先します。

このカスタマイズにより、コーディングや技術文書作成など、特定のドメイン向けにGPT-OSSが強化されます。次に、OllamaのAPIを使用してモデルをアプリケーションに統合しましょう。

ステップ5: OllamaのAPIでGPT-OSSを統合する

http://localhost:11434で動作するOllamaのAPIは、GPT-OSSへのプログラムによるアクセスを可能にします。これはAI搭載アプリケーションを構築する開発者にとって理想的です。使用方法は次のとおりです。

APIエンドポイント:

- POST /api/generate: 単一のプロンプトに対してテキストを生成します。例:

curl http://localhost:11434/api/generate -H "Content-Type: application/json" -d '{"model": "gpt-oss-20b", "prompt": "Write a Python script for a REST API"}'

- POST /api/chat: メッセージ履歴を伴う会話型インタラクションをサポートします:

curl http://localhost:11434/v1/chat/completions -H "Content-Type: application/json" -d '{"model": "gpt-oss-20b", "messages": [{"role": "user", "content": "Explain neural networks"}]}'

- POST /api/embeddings: 検索や分類などのセマンティックタスクのためのベクトル埋め込みを生成します。

OpenAI互換性:

- OllamaはOpenAIのChat Completions API形式をサポートしています。OpenAIライブラリを使ってPythonで使用します:

from openai import OpenAI

client = OpenAI(base_url="http://localhost:11434/v1", api_key="ollama")

response = client.chat.completions.create(

model="gpt-oss-20b",

messages=[{"role": "user", "content": "What is machine learning?"}]

)

print(response.choices[0].message.content)

このAPI統合により、GPT-OSSはチャットボット、コードジェネレーター、またはデータ分析ツールを動かすことができます。しかし、ストリーミング応答のデバッグは困難な場合があります。Apidogがこれをどのように簡素化するか見てみましょう。

ステップ6: ApidogでGPT-OSSをデバッグする

Apidogは、Ollamaのエンドポイントからのストリーミング応答を視覚化する強力なAPIテストツールであり、GPT-OSSの出力をデバッグするのを容易にします。使用方法は次のとおりです。

Apidogをインストールする:

- apidog.comからApidogをダウンロードし、システムにインストールします。

ApidogでOllama APIを設定する:

- Apidogで新しいAPIリクエストを作成します。

- URLを

http://localhost:11434/api/generateに設定します。 - 以下のようなJSONボディを使用します:

{

"model": "gpt-oss-20b",

"prompt": "Generate a Python function for sorting",

"stream": true

}

応答を視覚化する:

- Apidogは、ストリーミングされたトークンを生のJSON出力とは異なり、読みやすい形式にマージします。これにより、モデルの推論における書式設定の問題や論理エラーを特定するのに役立ちます。

- Apidogの推論分析を使用して、特にコーディングや問題解決のような複雑なタスクにおいて、GPT-OSSの段階的な思考プロセスを検査します。

比較テスト:

- Apidogでプロンプトコレクションを作成し、異なるパラメータ(例: temperature、top-p)がGPT-OSSの出力にどのように影響するかをテストします。これにより、ユースケースに最適なモデルパフォーマンスが保証されます。

Apidogの視覚化は、デバッグを退屈な作業から明確で実行可能なプロセスへと変え、開発ワークフローを向上させます。次に、遭遇する可能性のある一般的な問題に対処しましょう。

ステップ7: 一般的な問題のトラブルシューティング

GPT-OSSをローカルで実行すると、課題が生じる可能性があります。よくある問題の解決策を以下に示します。

GPUメモリエラー:

- 問題: GPUメモリ不足のためgpt-oss-120bが失敗する。

- 解決策: gpt-oss-20bに切り替えるか、システムに80GBのGPUがあることを確認します。

nvidia-smiでメモリ使用量を確認してください。

モデルが起動しない:

- 問題:

ollama runがエラーで失敗する。 - 解決策: モデルがダウンロードされていること(

ollama list)、およびOllamaサーバーが実行されていること(ollama serve)を確認します。~/.ollama/logsのログを確認してください。

APIが応答しない:

- 問題:

localhost:11434へのAPIリクエストが失敗する。 - 解決策:

ollama serveがアクティブであり、ポート11434が開いていることを確認します。netstat -tuln | grep 11434を使用して確認してください。

パフォーマンスが遅い:

- 問題: CPUベースの推論が遅い。

- 解決策: 適切なドライバーでGPUアクセラレーションを有効にするか、gpt-oss-20bのようなより小さいモデルを使用します。

解決しない問題については、Ollama GitHubまたはHugging FaceコミュニティでGPT-OSSのサポートを参照してください。

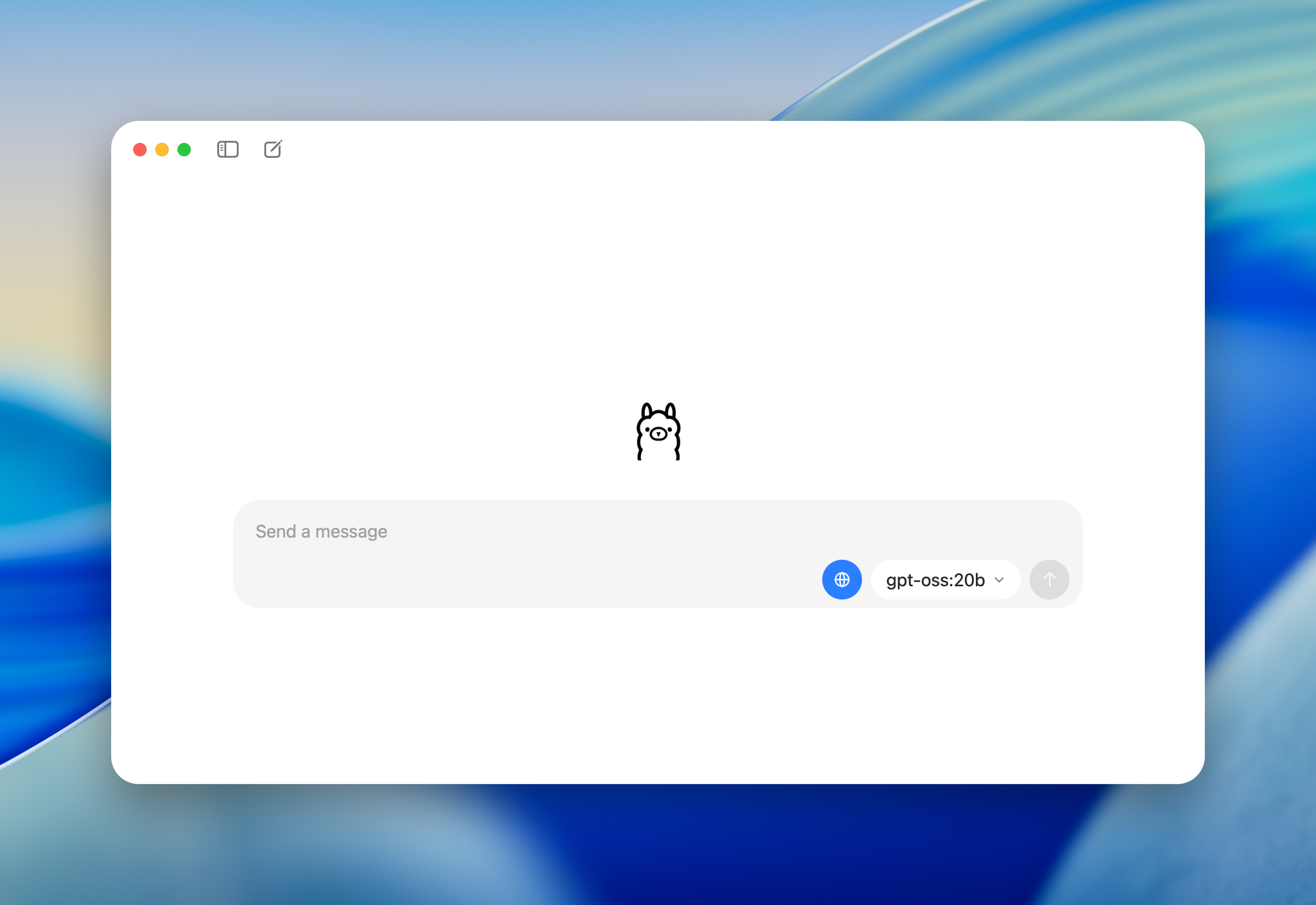

ステップ8: Open WebUIでGPT-OSSを強化する

ユーザーフレンドリーなインターフェースのために、OllamaとOpen WebUI(GPT-OSS用のブラウザベースのダッシュボード)を組み合わせてください。

Open WebUIをインストールする:

- Dockerを使用します:

docker run -d -p 3000:8080 --name open-webui ghcr.io/open-webui/open-webui:main

インターフェースにアクセスする:

- ブラウザで

http://localhost:3000を開きます。 gpt-oss-20bまたはgpt-oss-120bを選択してチャットを開始します。機能にはチャット履歴、プロンプト保存、モデル切り替えが含まれます。

ドキュメントのアップロード:

- 文脈に応じた応答(例: コードレビューやデータ分析)のために、Retrieval-Augmented Generation(RAG)を使用してファイルをアップロードします。

Open WebUIは非技術的なユーザーの操作を簡素化し、Apidogの技術的なデバッグ機能を補完します。

結論: OllamaとApidogでGPT-OSSを解き放つ

Ollamaを使用してGPT-OSSをローカルで実行することで、OpenAIのオープンウェイトモデルを無料で、プライバシーとカスタマイズを完全に制御して活用できます。このガイドに従うことで、Ollamaのインストール、GPT-OSSモデルのダウンロード、動作のカスタマイズ、API経由での統合、そしてApidogを使用したデバッグを学びました。AI搭載アプリケーションを構築している場合でも、推論タスクを実験している場合でも、このセットアップは比類のない柔軟性を提供します。パラメータの調整やApidogの視覚化の使用など、小さな調整でもワークフローを大幅に向上させることができます。今日からローカルAIの探求を始め、GPT-OSSの可能性を解き放ちましょう!